Amor romántico

“Sin el animal que habita dentro de nosotros somos ángeles castrados.”

Hermann Hesse.

“Amor: un juego en el cual hay dos que pierden, el hombre y la mujer, y uno sólo que gana: la especie.”

Abate Prévost.

“El enamoramiento es un estado de miseria mental en que la vida de nuestra conciencia se estrecha, empobrece y paraliza.”

José Ortega y Gasset.

El amor romántico no es fácil de definir. Nada menos que catorce acepciones aparecen en el Diccionario de la Lengua (por cierto, la última afirma que así se conoce el cadillo, una planta que se considera mala hierba). Quizá nos ayude la definición que ha publicado Tiffany Field, de la Universidad de Miami:

“Amor es un sentimiento profundo de afecto y cuidado que implica intimidad, compromiso y pasión, que nutre como el aire, el agua, las palabras y el tacto, y que tiene características típicas en la conducta, la fisiología y la bioquímica de las personas.”

El amor integra, por tanto, conductas, pensamientos, emociones y moléculas asociadas con el deseo de iniciar y mantener una relación con otra persona.

Parece que el amor incluye tres componentes: sexo, unión emocional e intimidad, y compromiso en el cuidado mutuo y de los hijos. Podemos resumir y concretar que el amor romántico es un compromiso para formar pareja con pasión, intimidad y cuidados. Es universal y aparece en todas las culturas. De manera inmediata suspende, en los que forman la pareja, la búsqueda de otras parejas. Tiene características propias en las emociones, en las conductas, en hormonas como la oxitocina o la testosterona, y en las respuestas neuropsicológicas de las zonas del cerebro relacionadas, ante todo, con los circuitos cerebrales de recompensa.

El amor tiene efectos beneficiosos para los individuos, con emociones positivas, felicidad y satisfacción vital, aunque también supone estrés, celos, a veces ruptura con tristeza y sensación de vergüenza, incluso depresión. Golpea a todos por lo menos una vez en la vida. En encuestas publicadas en Estados Unidos, Sandra Langeslag y Jan van Strien, de las universidades de Missouri y de Maryland, afirman que el porcentaje de individuos que padecen, o gozan, del amor romántico casi llega al 100%.

Hay varias hipótesis sobre el amor romántico. Garth Fletcher y sus colegas, de la Universidad Victoria de Wellington, en Nueva Zelanda, plantean tres propuestas conectadas entre sí. En primer lugar, el amor romántico es una conducta de compromiso para motivar la formación de la pareja en nuestra especie. En segundo lugar, la formación de la pareja facilita el peculiar ciclo vital de homínidos que implica dedicar una enorme y duradera inversión en tiempo y recursos para criar los hijos nacidos con un desarrollo muy temprano. Y, finalmente, el amor romántico ayuda a gestionar la pareja a largo plazo, incluyendo las relaciones familiares, y facilita la evolución de la inteligencia social y de las herramientas de cooperación dentro del grupo, clan o familia tan típicos en nuestra especie.

Según la revisión que hacen Fletcher y su grupo, los datos que se conocen son coherentes con la propuesta de que el amor romántico es una conducta de compromiso para formar la pareja. Hay referencias específicas de este objetivo en la conducta de ambos sexos, en la presencia de hormonas y en la aparición de mecanismos psicológicos peculiares del amor. Además, el amor romántico supone una ventaja pues da mejor salud y mayor supervivencia en los adultos y en las crías, o sea, en los niños.

Sin embargo, también hay conductas contrarias para el mantenimiento de la pareja y el cuidado de los hijos. Son, por ejemplo, los matrimonios arreglados y obligatorios, la poligamia, la separación, el divorcio y, en general, la infidelidad. Por el contrario, también hay mecanismos que regulan y controlan la relación y, sobre todo, la fidelidad por lo que implica de evitar la crianza de los genes de otro. Algunos autores sugieren que cada vez hay más evidencias de que, cuando nuestra especie surgió hace unos 150000 años, la conducta habitual en la reproducción era la monogamia. Cuando aparecieron los cazadores recolectores, la relación se complicó con la formación de clanes familiares, aunque siempre a partir de parejas.

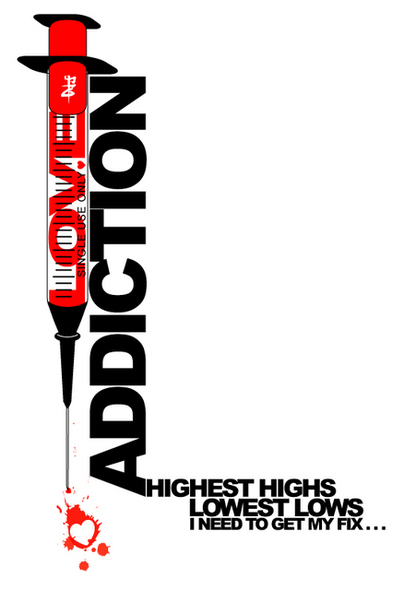

En las primeras fases del amor romántico aparecen los síntomas típicos de las adicciones, sean a sustancias o a conductas. Hay euforia, deseo, tolerancia, dependencia física y emocional, abandonos, desintoxicaciones y recaídas. Helen Fisher y su grupo, de la Universidad de Indiana en Bloomington, proponen que el amor romántico es una adicción natural, y resultado de la selección natural pues es, casi siempre, positiva para la reproducción. Fisher afirma que ha evolucionado desde hace miles de años como mecanismo de supervivencia para buscar pareja y para el éxito reproductor.

El escaneo del cerebro de las personas enamoradas revela que se activan las zonas relacionadas con la recompensa y, en concreto, lugares con dopamina, el neurotransmisor conocido como recompensa química cerebral. Son las mismas zonas que funcionan con varias adiciones hacia sustancias o conductas como, por ejemplo, las armas de fuego en Estados Unidos, las autocaravanas en sus dueños, los pastelitos, la cocaína, las anfetaminas o el fútbol en los hinchas. O, en este último caso, es así para los seguidores del Oporto o del Coimbra, de la Primera División de Portugal, como declaran los 56 voluntarios del estudio de Isabel Duarte y su grupo, de la Universidad de Coimbra. Como definen los autores, este apego a un equipo de fútbol es un amor no romántico, pero con una atracción específica a su equipo y una motivación para seguirlo que se sienten premiadas por los circuitos cerebrales de recompensa. En concreto, los autores lo llaman amor tribal. O sea, al grupo, al clan, a la familia.

También el grupo de Zhiling Zou, de la Universidad del Sudoeste en Chongqing, en China, estudia el amor romántico como adicción en su primera fase y relatan que, cuando la relación amorosa progresa, los síntomas de adicción se atenúan y, poco a poco, desaparecen. Se pasa de una conducta de adicción a una conducta prosocial no adictiva.

De nuevo, como en el estudio de Helen Fisher (y en la afición al fútbol), el escaneo del cerebro revela la activación del área de recompensa y, además, de la red de emociones entre personas y con el entorno social. De nuevo, están la oxitocina y la dopamina.

Esta profunda implicación de hormonas, determinadas áreas del cerebro y neurotransmisores en el amor ha llevado a proponer que no es una emoción sino una necesidad fisiológica como el hambre, la sed, el sueño o el sexo. Así lo escribe Enrique Burunat, de la Universidad de La Laguna, cuando afirma que el amor es una conducta resultado de la selección natural para conseguir un mayor éxito en la reproducción. Los que desarrollan amor y, por tanto, compromiso para la cría de los hijos, tienen más descendencia y transmiten los genes de esa conducta a las siguientes generaciones. Los que no tienen amor, tienen menos descendencia y van desapareciendo. Así, después de miles de años, sea seleccionado la mejor conducta para el éxito en la reproducción. Y es una necesidad fisiológica y conductual inevitable. Por ello, el 100% de los humanos sienten o han sentido el amor en algún momento de su vida.

Por cierto, esta adicción al amor romántico es un poco especial. Los estudios del grupo de Jordane Boudesseul, de la Universidad de Grenoble, en Francia, demuestran que quien está enamorado cree más en el amor romántico, lo que se antoja coherente, pero, además, quien está enamorado cree en el libre albedrío aunque, también, acepta que la vida, quizá su enamoramiento en concreto, tiene un fuerte sentido determinista. Está, a la vez y sin ser consciente de ello, convencido de que se enamora obligatoriamente de quien quiere.

Para terminar, el amor romántico también tiene, a veces, un final, una ruptura que, como se dice, rompe el corazón. Nos cuenta Tiffany Field, aquella que nos definió el amor, que existe un síndrome del corazón roto. Una ruptura sentimental reproduce algo parecido a un ataque al corazón, aunque sin arterias ocluidas ni daños permanentes. Estas rupturas provocan hasta el mal funcionamiento del sistema inmune, con aumento general de la inflamación, lo que también influye en el corazón, y disminución de las defensas.

Referencias:

Boudesseul, J. et al. 2016. Free love? On the relation between belief in free will, determinism, and passionate love. Conciousness and Cognition 46: 47-59.

Burunat, E. 2016. Love is not an emotion. Psychology 7: 1883-1910.

Buss, D.M. 1996. La evolución del deseo. Alianza Ed. Madrid. 417 pp.

Duarte, I.C. et al. 2017. Tribal love: the neural correlates of passionate engagement in football fans. Social Cognitive and Affective Neuroscience doi: 10.1093/scan/nsx003

Field, T. 2016. Romantic love. International Journal of Behavioral Research & Psychology 4: 185-190.

*Fisher, H. 2004. Por qué amamos. Naturaleza y química del amor romántico. Santillana Ed. Madrid. 348 pp.

Fisher, H.E. et al. 2016. Intense, passionate, romantic love: A natural addiction? How the fields that investigate romance and substance abuse can inform each other. Frontiers in Psychology doi: 10.3389/fpsyg.2016.00687

Fletcher, G.J.O. et al. 2015. Pair-bonding, romantic love, and evolution: The curious case of Homo sapiens. Perspectives in Psychological Science 10: 20-36.

Langeslag, S.J.E. & J.W. van Strien. 2016. Regulations of romantic love feelings: preconceptions, strategies, and feasibility. PLOS ONE 11: e01611087

Song, S. et al. 2016. Romantic love is associated with enhanced inhibitory control in an emotional stop-signal task. Frontiers in Psychology doi: 10.3389/fpsyg.2016.01574

Zou, Z. et al. 2016. Romantic love vs. drug addiction may inspire a new treatment for addiction. Frontiers in Psychology doi: 10.3389/fpsyg.2016.01436

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Amor romántico se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Naukas Bilbao 2017 – Carolina Jiménez: Ciencia y cine, avanzando de la mano

En #Naukas17 nadie tuvo que hacer cola desde el día anterior para poder conseguir asiento. Ni nadie se quedó fuera… 2017 fue el año de la mudanza al gran Auditorium del Palacio Euskalduna, con más de 2000 plazas. Los días 15 y 16 de septiembre la gente lo llenó para un maratón de ciencia y humor.

El cine no es más que la combinación del arte de la narrativa y el avance tecnológico. Lo sabe y lo explica como nadie Carolina Jiménez, artista de efectos especiales digitales para el cine que ha participado y participa en algunas de las superproducciones más conocidas de los últimos años.

Carolina Jiménez: Ciencia y cine, avanzando de la manoEdición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Bilbao 2017 – Carolina Jiménez: Ciencia y cine, avanzando de la mano se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Bilbao 2017 – Álex Méndez: Luz de luna

- Naukas Bilbao 2017 – Teresa Valdés-Solís: Limpia, fija y da esplendor

- Naukas Bilbao 2017 – Ignacio López-Goñi: Las bacterias también se vacunan

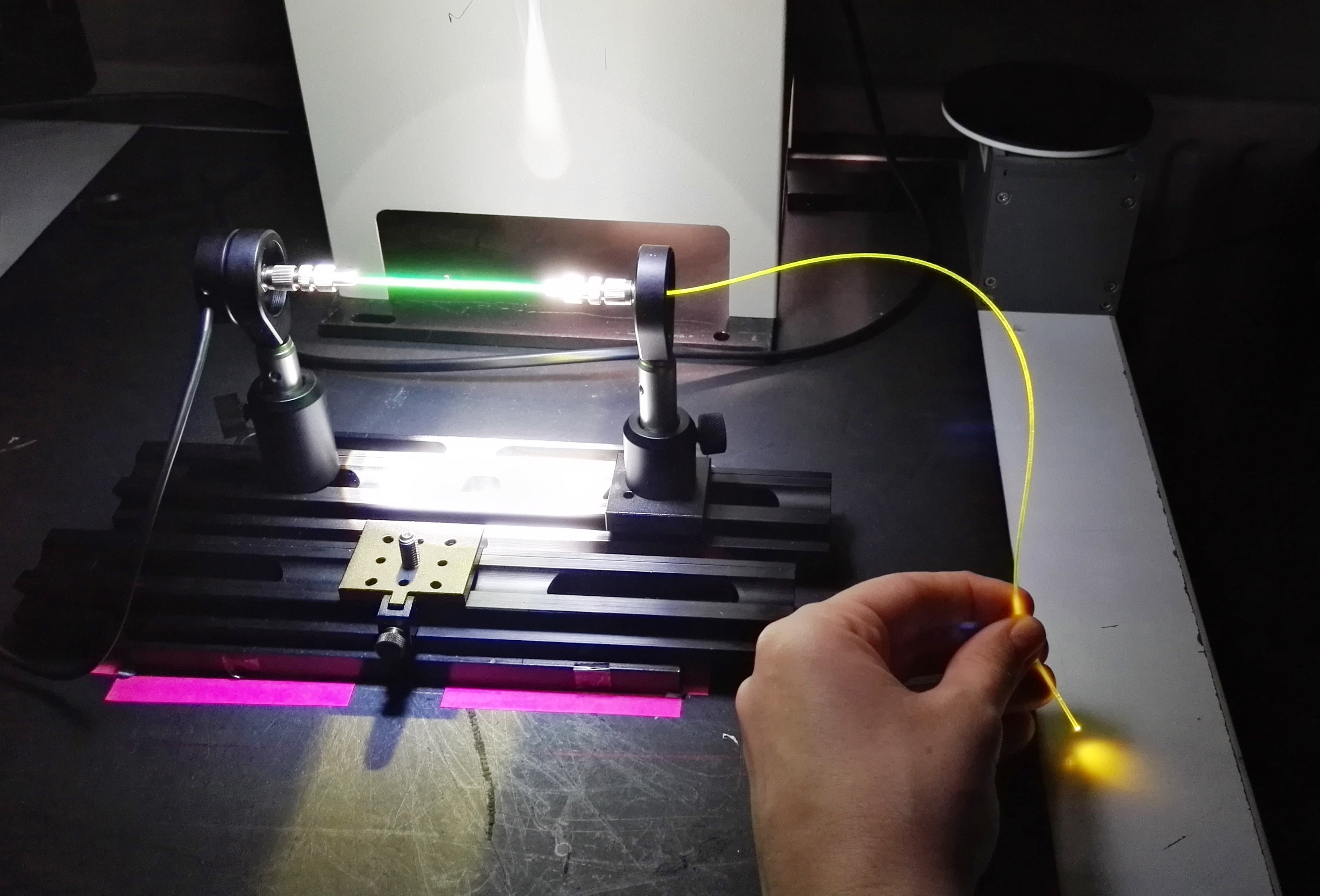

Una fibra óptica de plástico actúa como concentrador solar luminiscence

Un equipo de investigación de la UPV/EHU ha desarrollado un fibra óptica con dopantes híbridos que concentra la luz solar con un rendimiento alto y un coste bajo. Hasta ahora nunca se había utilizado como concentrador solar una fibra óptica de plástico que combina componentes orgánicos e inorgánicos.

Imagen: Itxaso Parola / UPV/EHU

Los resultados muestran que el rendimiento de la fibra al concentrar y transportar luz solar es alto, y que, conectado a células fotovoltaicas, resulta ser un sistema muy apropiado para suministrar electricidad a pequeños dispositivos.

Tan solo un 3 % de la energía consumida en 2017 proviene de sistemas eólicos, solares y de biomasa; los expertos, sin embargo, creen que actualmente la obtención de energía solar tiene las mayores perspectivas de crecimiento. No cabe duda de que siempre dispondremos de energía solar, y además de aprovecharla utilizando huertos solares, también se pueden utilizar sistemas más pequeños integrados en diversos espacios (en casas, tejados, etc.).

A nivel mundial se están llevando a cabo muchos estudios de mejora de células solares fotovoltaicas. Las células fotovoltaicas más avanzadas hasta el momento son las de silicio, pero son muchos los aspectos que necesitan ser mejorados: las fuentes de silicio son limitadas; las instalaciones requieren de grandes superficies; son necesarios sistemas de seguimiento solar, así como luz solar directa; su rendimiento disminuye mucho en días nublados o con luz difusa, etc. En definitiva, todavía resulta caro disponer de la energía solar.

Precisamente, en una investigación llevada a cabo por los departamentos de Física Aplicada I e Ingeniería de Comunicaciones de la UPV/EHU, en colaboración con el grupo Applied Organic Materials de la Universidad Técnica de Brunswick, han conseguido una fibra óptica de plástico con dopante híbrido que servirá para producir energía a pequeña escala. Para mejorar las características de la fibra óptica han añadido al polímero un dopante compuesto por substancias tanto orgánicas como inorgánicas. “Podrá utilizarse con células fotovoltaicas que alimenten pequeños dispositivos o sensores, y podría tener una gran potencialidad en el mercado de la fotovoltaica integrada en edificios o edificación verde —explica Itxaso Parola, autora de la investigación—. Además, conectada a fibras pasivas, se puede transportar la luz desde un extremo al otro de la fibra, y así, servir para alimentar dispositivos alejados de la fuente de energía”.

“La fibra óptica de plástico con dopante híbrido funciona como un concentrador solar luminiscente: absorbe la luz solar y la emite a una mayor longitud de onda; transporta la luz al extremo de la fibra, por reflexión interna total, y en el extremo de la fibra se coloca la célula fotovoltaica —explica Parola—. Es la primera vez que se utilizan para ese fin fibras ópticas de plástico que combinan componentes orgánicos e inorgánicos”. Asimismo, la investigadora de la UPV/EHU ha destacado que, como otros concentradores luminiscentes, este también resulta muy apropiado para obtener energía solar en espacios situados en sombra y en días nublados.

Según los resultados de las medidas llevadas a cabo, una fibra de 6 cm de longitud puede llegar a concentrar un tercio de la luz que emite el sol un día soleado de verano, y en opinión de la investigadora “ese resultado es muy bueno”. Han medido el rendimiento de la fibra en diversas condiciones ambientales y de iluminación, y “hemos observado que tiene un buen rendimiento en todos los casos, aunque el rendimiento es incluso algo mayor cuando la luz no incide directamente en la fibra. Esa característica es muy positiva teniendo en cuenta que el rendimiento de las células de silicio es muy pequeño en días nublados o de luz difusa”, comenta. Aunque la investigadora ha reconocido que cuando la fibra es muy larga la luz que se transporta por el interior se debilita, “con una sola fibra de 6 m de longitud hemos conseguido concentrar una intensidad de luz 1,3 veces mayor que la luz directa del sol”, detalla.

Tal como afirma la investigadora, es mucho más barato preparar sistemas como este que utilizar mayores superficies de células de silicio. De todas formas, Parola reconoce que es necesario investigar más en este campo para arrojar luz sobre varios aspectos: “Nosotros hemos realizado experimentos utilizando una única fibra, pero se necesitarían haces de fibras para poder cubrir el área activa de una célula fotovoltaica. Por otra parte, la superficie de las células fotovoltaicas es cuadrada, y al cubrir esa superficie con fibras cilíndricas siempre quedarán pequeñas zonas que no obtendrán luz. Ahora, estamos probando con diferentes diámetros de fibra; cuando la fibra es más gruesa pierde flexibilidad, pero, al mismo tiempo, absorbe más luz. Todavía tenemos mucho que investigar, pero los resultados son muy prometedores”.

Referencia:

I. Parola, D. Zaremba, R. Evert, J. Kielhorn, F. Jakobs, M. A. Illarramendi, J. Zubia, W. Kowalsky, Hans-Hermann Johannes (2018) “High performance fluorescent fiber solar concentrators employing double‐doped polymer optical fibers” Solar Energy Materials and Solar Cells. DOI: 10.1016/j.solmat.2018.01.013

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Una fibra óptica de plástico actúa como concentrador solar luminiscence se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Hidrógeno a partir de composites de fibra de carbono

- Cómo incorporar nanotubos de carbono a un plástico de aviación

- La óptica se hace atómica: la lente más pequeña del mundo

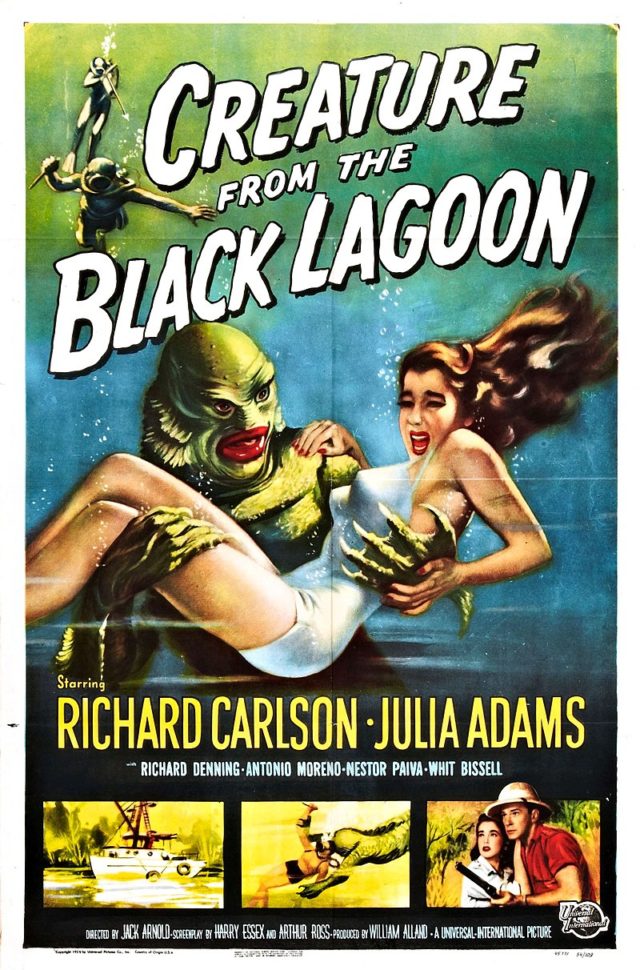

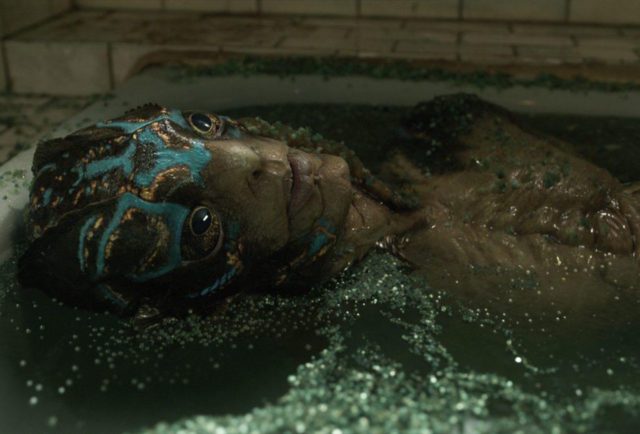

La Criatura de “La forma del agua”

Usar el cine para hablar de ciencia es algo que suelo hacer habitualmente, y muchas películas se prestan a ser analizadas desde un punto de vista biológico, y eso es lo que vamos a hacer hoy con La forma del agua. Lo primero que me gustaría comentar sobre ella es que he quedado maravillado con esta nueva película del director mexicano Guillermo del Toro, y me ha recordado a lo mucho que disfruté con su obra El laberinto del fauno. Y es que como se oye mucho por ahí, los monstruos de este cineasta son maravillosos. Si encima me dan la excusa para poder hablar de biología, pues ya tenemos la película perfecta. Pocos Premios de la Academia para mi gusto ha ganado. Cabe recordar que La forma del agua se ha llevado el Oscar a la mejor película, al mejor director, a la mejor banda sonora y al mejor diseño de dirección; un total de cuatro estatuillas de las trece nominaciones que tenía.

Cartel de la forma del agua

Pero empecemos por el principio. ¿De qué trata está película? Si hay que hacer un resumen, tenemos que decir que va sobre el amor, el amor en sus múltiples facetas. Es una oda al amor, claramente. Un precioso cuento de amor en el que uno queda atrapado desde que empiezan las primeras palabras a narrar la historia, acompañadas de unas bellas imágenes cuidadas al máximo. Y es que está claro que ese es otro de los puntos fuertes de la película, la fotografía, que junto con la magnífica banda sonora, terminan de conformar esta maravillosa historia que ha cautivado a tanta gente.

El inicio de la película

Intentaremos que no haya spoilers en el post, pero está claro que tengo que contar algunos detalles, así que si alguien no quiere que le adelante algún detalle tiene que dejar de leer aquí, aunque me voy a centrar solo en la parte biológica que concierne a la criatura y no en la historia que se relata. Y es que esta criatura me ha cautivado a muchos niveles, y nos va a dar pie para que hablemos de detalles biológicos interesantes, que podemos conocer a lo largo del metraje de la película.

La criatura de La forma del agua

Muchos, al verla la primera vez, no hemos podido evitar acordarnos de otro de los monstruos clásicos del cine, La criatura de la Laguna Negra, de la película homónima de 1954 (Creature from the Black Lagoon), que fue titulada en español La mujer y el monstruo. Y es que el propio director, Guillermo del Toro, ha reconocido que esta película marcó su vida cuando la vio de pequeño.

“Tenía seis años cuando vi El Monstruo de la Laguna Negra en la televisión y hubo tres cosas que despertó en mí, la primera que no revelaré; la segunda fue la imagen más hermosa que había visto, me sentí abrumado por la belleza; y la tercera cosa fue que en realidad esperaba que terminaran juntos y no lo hicieron…”

La Criatura de la Laguna Negra

Tengo que reconocer que la primera frase que se nos puede pasar a la mayoría por la cabeza cuando vemos a la criatura es: – Vaya bicho más feo -, pero yo tuve la sensación contraria, me parecía una criatura de gran belleza, magnífica, digna de admiración, por lo que ahí coincido con las palabras de Del Toro, que no había leído hasta que me he puesto a buscar información para escribir esta reseña. Y es que el monstruo está perfectamente diseñado, con un cuidado extremo de todos los detalles, para que nos guste; lo que contrasta muchísimo con el disfraz, mas bien cutre, de la película de 1954, cosa que por otro lado es normal. Los monstruos de las películas antiguas nos suelen parecer mas feos casi siempre.

Comparativa

Según se narra al inicio de la película, cuando traen al monstruo a un laboratorio secreto del Gobierno, se habla de que lo encontraron en Sudamérica, del mismo modo que la Criatura de la Laguna Negra fue encontrado por un paleontólogo en el Amazonas, por lo que ambas tienen el mismo origen. El ser tiene aspecto de anfibio, y desde el primer momento se deja ver su piel húmeda y suave, aunque en algunas partes de la película se pueden intuir algo parecido a escamas, más o menos de gran tamaño que me hicieron dudar de la naturaleza de dicha criatura. Es más, atendiendo a ciertas características, podemos dudar de si estamos ante un anfibio estricto o si es un paso intermedio en la escala evolutiva entre este grupo y el de los reptiles. O incluso un espécimen intermedio entre anfibios y peces, todo ello complicado por la forma claramente antropomórfica del ser.

¿Pez, anfibio o reptil?

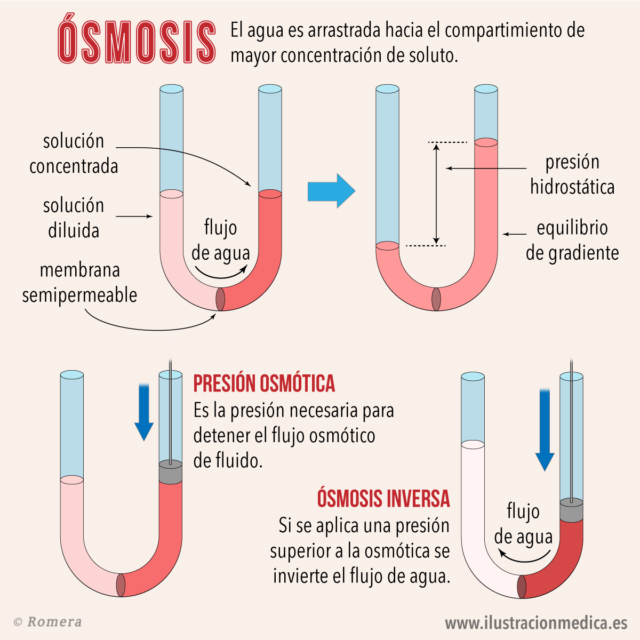

Desde el principio de la película nos dejan muy claro que la criatura necesita agua salada, por lo que tenemos que empezar hablando de ósmosis, que es un fenómeno físico que ocurre cuando tenemos dos disoluciones separadas por una membrana semipermeable, es decir una superficie que permite el paso de ciertas sustancias de forma selectiva. En el caso que nos interesa vamos a considerar que la membrana semipermeable permite el paso del agua, pero no de las sustancias que lleve disuelta, esto es, permite el paso del disolvente, pero no de los solutos. La ósmosis, se produce cuando dos disoluciones de diferentes concentraciones se encuentran separadas por una membrana de este tipo.

En este caso, el agua atravesará la membrana desde donde hay menor concentración de solutos hasta donde hay mayor concentración. La lógica y la experiencia nos dice que esto ocurre hasta que las dos disoluciones se igualan, y ambas presenten la misma concentración. A la disolución que tiene mayor concentración de solutos se le llama hipertónica, mientras que a la que tiene menos se le llama hipotónica. Cuando las dos se igualan, tras pasar el líquido desde el medio hipotónico al hipertónico, los dos medios pasan a convertirse en isotónicos, es decir, tienen la misma concentración. A partir de esto se define por ejemplo, la presión osmótica, pero no vamos a entrar en más conceptos físicos, sino que nos vamos a quedar en la aplicación biológica de este proceso. Sobre ósmosis y criaturas de este tipo nos habló magistralmente mi admirado Sergio Palacios en este post.

Ósmosis

Al igual que los peces, nuestra criatura cuenta con adaptaciones que le permiten sobrevivir a determinada concentración de sales en el agua, y debido a ello pueden vivir en el océano. Pero aquí nos encontramos el primer problema, que ahora comentaremos mientras repasamos algunas escenas de diálogo de la película, en las que se habla del origen de la criatura en los siguientes términos:

“… Sí, y lo sé bien. Yo saqué a esa bestia inmunda del fango de un río en Sudamérica y la arrastré hasta aquí. Y por el camino no congeniamos mucho.

Bien, esa criatura puede parecerles humana, porque se yergue sobre dos piernas, pero Dios nos creó a su imagen y semejanza. No creerán que Dios se parece a eso, ¿no?”

(Lo dice el Coronel Strickland hablando con las limpiadoras del laboratorio).

El actor Michael Shannon interpretando magistralmente a Strickland

Vale, tenemos una criatura marina, que dice que fue sacada del fango de un río sudamericano… No cuadra mucho, pero sigamos buscando pistas, a ver si podemos averiguar qué río era. El mismo Strickland, suelta más adelante la siguiente frase:

“Los indígenas del Amazonas lo veneraban como un Dios.”

Se trata del río Amazonas, que por cierto es el mismo río donde se hallaba la criatura de la película de 1954. Pero, ¿es el Amazonas un río de agua salada? Nada más lejos de la realidad. La consideración de agua dulce, que es como se entiende que es la de los ríos, se hace teniendo en cuenta que la salinidad esté entre un 0 y un 0,05 %, por lo que no parece muy lógico que esta criatura pueda vivir en el río Amazonas, excepto que lo haga en su desembocadura. En esa zona se mezclan los dos tipos de agua, dulce y salada, por lo que no sería extraño que los encuentros entre la criatura y los indígenas, y el lugar donde atraparon a este ser fuera la desembocadura del río Amazonas.

Delta del Amazonas

La concentración salina en los mares es de entre 33 y 35 g/l, es decir, de aproximadamente un 3,5 %, a causa de la sal común, el cloruro sódico, que hay disuelta en este medio. Sin embargo, la concentración de los fluidos corporales de los peces teleósteos, que son la mayoría de los peces que viven en medios marinos, es mucho menor, por lo que estos animales nadan en un medio hipertónico o hiperosmótico. Debido a esto, el agua tenderá a salir desde el interior de las células hacia dicho medio, por lo que corren el riesgo de morir, literalmente, deshidratados a pesar de vivir rodeados del líquido elemento. Para compensarlo no tienen mas remedio que beber.

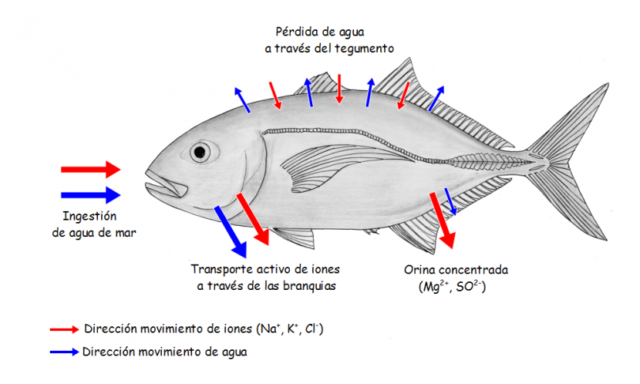

Cabe suponer que nuestra criatura tenga las adaptaciones que los peces marinos: Al beber agua salada, está introduciendo en sus cuerpos una gran cantidad de sales que van disueltas en el agua, por lo que necesita algún mecanismo para expulsar este exceso salino. Y este mecanismo consiste en eliminar las sales mediante unas células especializadas de las branquias, y mediante una orina escasa, pero muy concentrada.

Osmorregulación en peces de agua salada

Existen peces que pueden vivir en los dos medios, es decir, los llamados peces diádromos, que viajan entre los ríos y los mares o viceversa. Hay peces que se aparean y nacen en los ríos, pero que pasan la mayor parte de su vida adulta en el mar, son los llamados peces anádromos, cuyo ejemplo más conocido quizás sean los salmones, entre los que destaca la especie Salmo salar, el salmón común o salmón del Atlántico. Entre los peces catádromos, también uno de los ejemplos más conocidos es el de las anguilas, Anguilla anguilla. Estos curiosos peces con forma alargada, nacen en el Océano Atlántico, en el conocido mar de los Sargazos, donde pasaran unos meses en forma de larva, llamadas larvas leptocéfalas, que arrastradas por las corrientes llegan hasta las costas de Europa, donde remontan los ríos para crecer y vivir en ellos durante muchos años. De adultos viajan río abajo para volver al mar de los Sargazos, donde nacieron, y reproducirse, llevando a cabo la puesta en dicho lugar.

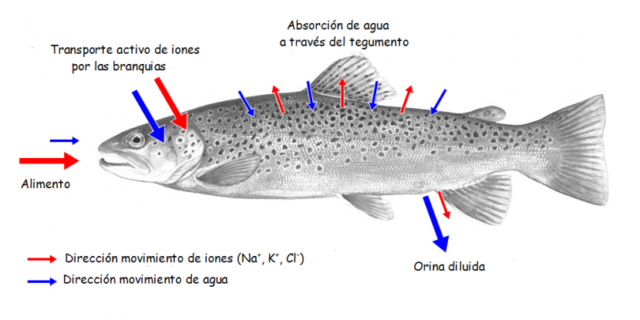

En ambos casos, el problema está en que la osmorregulación debe adaptarse al medio en el que se encuentran en cada momento y para ello las estructuras celulares de las branquias deben cambiar acomodándose a la salinidad del medio. Cuando están en agua dulce, medio hipotónico, el epitelio branquial es capaz de absorber sales, mientras que en agua salada, medio hipertónico, las células de las branquias expulsan sal activamente. El control de la diferenciación y de la actividad de estas células se realiza mediante hormonas, así por ejemplo, el cortisol y la hormona del crecimiento activan este epitelio en la transición de los ríos al mar, mientras que la prolactina lo hace cuando ocurre el paso contrario.

Osmorregulación en peces de agua dulce

Y para complicar aún más el asunto existen algunas especies de peces llamados anfídromos, que se mueven entre el mar y el agua dulce, o entre los ríos y el agua salada, aunque no lo hacen por causas reproductivas, como los anteriores, sino para alimentarse o a causa de cambios estacionales. Un ejemplo de ellos son las lisas, Mugil cephalus, un pez carroñero muy habitual en las desembocaduras de los ríos, ya que es muy adaptable a distintas condiciones de salinidad e incluso a la contaminación. Creo que en un caso parecido a éste nos encontraríamos a nuestra criatura, que vive en el océano y que sube a la desembocadura de los ríos en busca de alimentos, más aún cuando en la película se cita que los indígenas le lanzaban flores, frutas y otros presentes. En varias escenas vemos como le encanta comer huevos cocidos, una fuente de proteína, ofrecidos por personajes humanos.

Los huevos, fuente de proteínas…

De nuevo nos encontramos otro problema de coherencia en los diálogos de la película que llegué a pensar que era un error cuando lo escuché la primera vez, y que me ha hecho buscar la versión original para ver si era un fallo de traducción. Se trata de lo que el Dr. Robert Hoffstetler le dice a Elisa, una de las limpiadoras, durante uno de los momentos más importantes del metraje:

“El agua debe tener entre un 5 y un 8 % de salinidad. Vale con sal común.”

El actor Michael Stuhlbarg con el doctor Robert Hoffstetler

¿Cómo? una salinidad mucho mayor que la media del agua del mar… ¿pero no habíamos quedado en que era una criatura marina que podía moverse a la desembocadura del río Amazonas? En un principio pensé que ahí se habían pasado con el porcentaje, quizás para enfatizar el problema de sacar a la criatura del laboratorio y hacer ver una necesidad o dependencia mayor del agua salada. Uno de los sitios más salados de nuestro planeta es el mar Muerto, cuya salinidad es variable, pero puede rondar entre un 22 y un 28 % de salinidad. El Gran Lago Salado norteamericano tiene una salinidad entre un 5 y un 22 % y muchos lagos salados sudamericanos tienen una salinidad variable entre el 3 y el 25 %. Pero nuestra criatura no vive en un lago, ni en el Mar Muerto.

Podemos aceptar que la criatura puede adaptarse a rangos variables de salinidad, lo que sumado a que también vemos que el agua del tanque del laboratorio y la bañera tienen que tener un producto (que no se menciona qué es), que le da un aspecto verdoso, y que me recordaba en todo momento a las aguas eutrofizadas. Todo ello nos da las pistas necesarias para que podamos concluir que su hábitat es una zona en la desembocadura de un río que está sufriendo este proceso de eutrofización. Esto consiste en que en un cuerpo de agua cerrado o casi cerrado, con poca corriente, los nutrientes que ingresan masivamente al sistema generan una gran biomasa de organismos de vida efímera. Al morir, toda esta masa biológica se acumula sobre el fondo al no ser totalmente consumidos por organismos descomponedores, sobre todo bacterias. Estos procesos naturales de eutrofización se pueden observar en las lagunas formadas por los cauces antiguos de ríos que se transforman en pantanos y posteriormente se cubren de vegetación. En el Amazonas, por supuesto, también ocurre esto. Por fin dimos con la clave del posible sitio de origen de nuestra misteriosa criatura.

Tanque de agua de la criatura

Cuando la criatura sale del laboratorio y tiene que pasar un tiempo en una bañera, además de lo que supone un espacio tan pequeño para un ser más alto que un humano medio, lo pasa muy mal suponemos que por no haber controlado exactamente la concentración salina del agua de la bañera, que seguramente se haya quedado corta. Gran parte de los problemas que tiene en esos momentos se deben a la necesidad de un hábitat natural amplio y acondicionado para que sobreviva, con una concentración salina adecuada.

La criatura en una bañera “eutrofizada” artificialmente

Hasta ahora, en todo momento hemos hablado de peces, pero dijimos al principio que nuestra criatura protagonista posiblemente se tratara de un anfibio, por lo que pasemos ahora a hablar de por qué pensamos esto, teniendo en cuenta las adaptaciones a la vida acuática y terrestre que vemos en la criatura, que son las típicas de este tipo de seres en la ficción.

En primer lugar atendamos a su aspecto general, con un color verdoso muy habitual en muchos grupos de anfibios, como ranas, sapos y tritones. El patrón de colores ondulado es muy característico y llamativo visto así, pero en el medio acuático eutrofizado que comentábamos antes debe significar un buen camuflaje para la criatura. La piel del tritón jaspeado, Triturus marmoratus, o las escamas del pez león, Pterois antennata, presenta patrones parecidos.

Tritón jaspeado y pez león

Es cierto que en el nuevo monstruo de Del Toro nos encontramos con la producción de luz en algunas células de la piel, lo que es una novedad frente a monstruos más clásicos. La bioluminiscencia es la producción de luz por parte de organismos vivos. Bioquímicamente hablando, se trata de una reacción en la que interviene una enzima llamada luciferasa, que hace que el oxígeno oxide a la proteína llamada luciferina, que da lugar a la oxiluciferina, produciéndose también agua y luz. Se trata de una transformación directa de energía química en energía lumínica. En la vida real las funciones de esta bioluminiscencia pueden ser múltiples, desde atraer a posibles presas, servir para comunicación entre individuos, camuflaje o distracción o como señal de advertencia. Para nuestra criatura no sabemos cual es la función en libertad, pero en la película vemos que está asociada con la regeneración de tejidos.

Bioluminiscencia

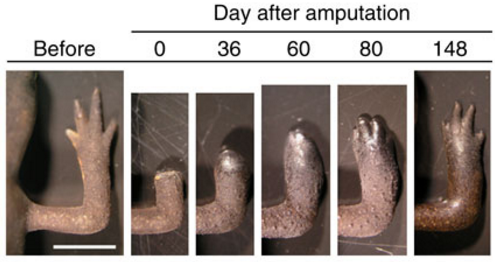

No hay anfibios bioluminiscentes que conozcamos, aunque recientemente se encontró una rana que brilla en la oscuridad, pero lo hace por fluorescencia que es diferente a la bioluminiscencia. Se trata de una rana sudamericana, la rana puntuada, o Hypsiboas punctatus, una especie que vive en montañas, pantanos, marismas y bosques tropicales y subtropicales, de varios países de Sudamérica, como Argentina, Bolivia, Brasil o Colombia, y que es capaz de brillar en la oscuridad. Lo que si tienen los anfibios es una capacidad increíble para regenerar los tejidos, así que la capacidad del monstruo para hacerlo también tiene su punto de justificación científica.

Hypsiboas punctatus

El ajolote mexicano y otras especies de salamandras y tritones presentan la capacidad de regenerar sus tejidos. Si se lesionan una extremidad o la cola son capaces de regenerarla, pero lo más asombroso es que también pueden hacerlo con partes de sus órganos vitales, como el corazón o el cerebro. Básicamente, lo que hacen estos animales es revertir sus células hasta el estado de células madre, para poder reparar los tejidos renovando todas las células que hagan falta. Al igual que nuestra bestia protagonista tiene esta capacidad para curar, estos anfibios están siendo usados para investigar posibles tratamientos de regeneración en pacientes amputados y curación de algunas enfermedades.

Regeneración en anfibios

Otra característica evidente en la criatura es su modo de respiración. Desde el principio se ven unas agallas grandes en el cuello entre las que suponemos entrever varias hendiduras branquiales, que dan acceso a las branquias que usa para respirar dentro del agua. Así mismo parece claro que cuenta con pulmones, que le permiten respirar en tierra. Hay varias referencias a ello en la película:

“Absorción de oxígeno e intercambio de dióxido de carbono. ¿Qué demonios es esto hijo?”

(Lo dice el general Hoyt hablando con el coronel Strickland)

“Esta criatura puede alternar entre dos mecanismos de respiración totalmente diferentes.”

(La intervención del Dr. Robert Hoffstetler matiza datos sobre la respiración de la criatura)

Detalle de diseño de la criatura. Se ven los repliegues branquiales en la cara y el cuello

Detalle del tórax de la criatura durante una sesión de maquillaje

Strickland apostilla a la intervención anterior con una frase que dice: – “El pez del fango también.”-, en referencia a los peces del género Periophthalmus, también llamados saltarines del fango. Estos fascinantes seres viven en manglares tropicales y tienen la capacidad de respirar aire en un modo de vida anfibio. Tienen capacidad para respirar a través de la piel, su mucosa bucal y faringe. Esto solo es posible en condiciones de mucha humedad, limitándolos a permanecer en el área fangosa. Éste tipo de respiración cutánea es muy similar al de los anfibios, por lo que el comentario de Strickland no está tan fuera de lugar.

Otra importante adaptación para ayudar a respirar aire es la existencia de grandes cámaras branquiales que actúan como un depósito de oxígeno, lo cual les sirve mientras están en tierra. La habilidad de enterrarse en profundos hoyos de sedimentos fangosos, les ayuda en su termorregulación, y también a evitar depredadores. Además, pueden utilizar esta capacidad para desovar en estos agujeros en el fango. Gracias a la cámara branquial pueden respirar cuando están enterrados y el agua tiene poca concentración de oxígeno.

Periophthalmus barbarus

Volviendo a la película, el propio Strickland vuelve a hacer otro comentario en referencia a los pulmones de la criatura:

“¿Ve eso que tiene a lo largo del pecho? Esta criatura tiene un cartílago articulado que separa los pulmones primarios de los secundarios. (…)”

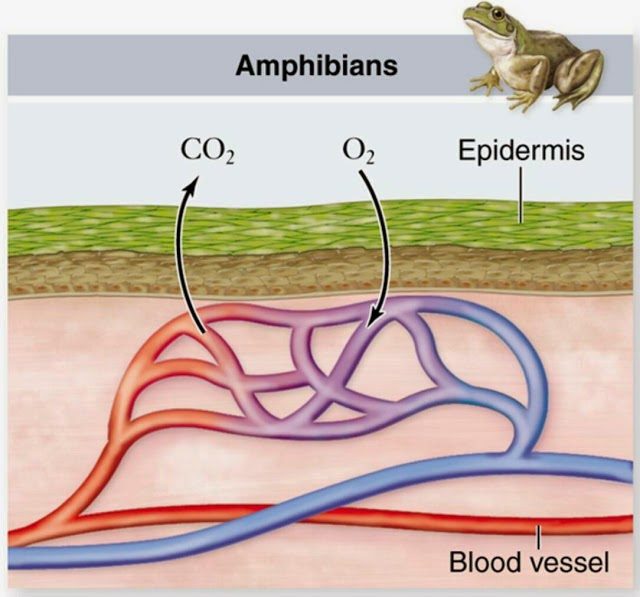

En nuestro mundo real, los anfibios usan varios sistemas de respiración, como son la cutánea, la branquial, la pulmonar y la respiración a través de la cavidad oral. La respiración cutánea la utilizan cuando están sumergidos, por ejemplo para reproducirse, y de esta manera pueden respirar también a través de la piel mientras ésta se mantenga húmeda en el exterior. Tengamos en cuenta que los anfibios fueron los primeros vertebrados que salieron del agua para llevar a cabo gran parte de su vida fuera del agua, aunque no se independizaron totalmente de ella. Su reproducción los ata al agua, ya que sus huevos, sin cáscara, necesitan ser depositado en lugares muy húmedos o masas de agua para que no se desequen.

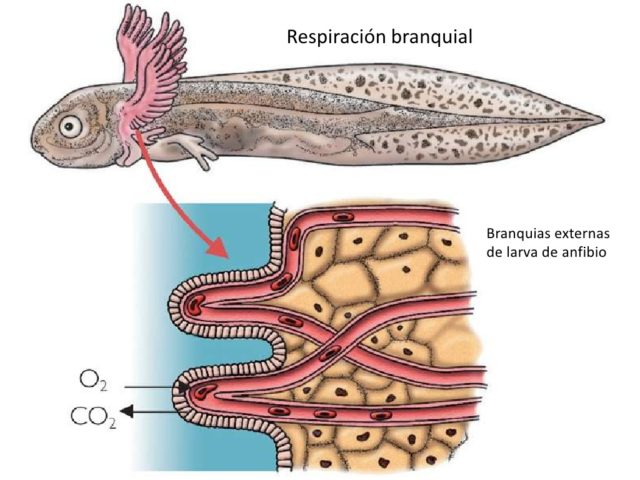

Respiración branquial en renacuajos

Respiración cutánea en anfibios adultos

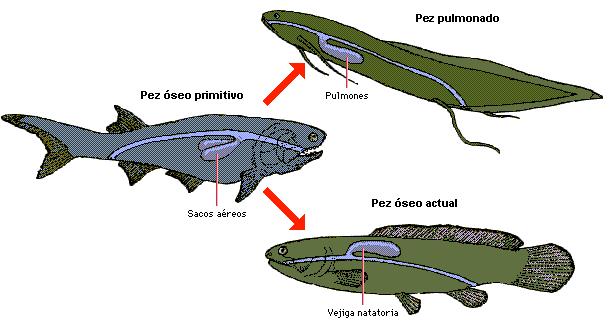

Los primeros peces que desarrollaron la capacidad de salir del agua para sobrevivir cierto tiempo en tierra, la adquirieron gracias al desarrollo de pulmones, aunque estos fueran rudimentarios y menos efectivos que los de reptiles, aves y mamíferos. Los pulmones de las salamandras y tritones son unos simples sacos de paredes lisas bien vascularizadas, mientras que los de ranas y sapos son un poco más complejos con pliegues y cámaras, lo que aumenta la capacidad respiratoria. Estos primeros pulmones que tuvieron los anfibios derivan de la vejiga natatoria de los peces.

Vejiga natatoria

En cuanto a la respiración branquial, en los renacuajos y larvas de los anfibios es la forma más usual de respirar, y, normalmente, tras la metamorfosis, al llegar a adultos, sustituyen estas estructuras por los pulmones y pasan de tener respiración branquial a tener respiración pulmonar. De todas maneras, el tipo de respiración depende de la especie. Por ejemplo los ajolotes adultos pueden conservar la respiración branquial, mientras algunos tipos de salamandras, como las del género Bolitoglossa, carecen de respiración pulmonar y lo hacen exclusivamente por respiración cutánea.

Bolitoglossa mexicana

Nuestra criatura, es un ser alto y galante, para este papel, Guillermo del Toro ha utilizado al actor Doug Jones, que también hizo del Fauno en su famosa película. Este actor no es la primera vez que se mente en la piel de un hombre-anfibio, bastante parecido a éste, puesto que ya lo hizo en otra de las películas del cineasta mexicano. En Hellboy hacía el papel Abe Sapien, aunque este personaje es descrito más como un hombre-pez. En cualquier caso el parecido de ambas criaturas es más que razonable.

Abe Sapien

El propio Guillermo Del Toro dice que para los movimientos del monstruo quería la fluidez del Silver Surfer de los 4 Fantásticos, al que por cierto también interpretó Jones en su versión cinematográfica. Para que el diseño de la criatura fuera atractivo, el director se llevaba frecuentemente el traje a su casa para pedir opinión femenina en cuestiones como el abdomen más o menos marcado, el trasero o la anchura del pecho y los hombros. Doug Jones necesitaba cuatro horas de preparación y maquillaje para terminar teniendo el aspecto de la criatura. El resultado era una piel con todas las imperfecciones y detalles que un híbrido entre humano y anfibio debería tener: en el cuello y repliegues de la piel hay imperfecciones, hoyuelos, líneas, arrugas, cicatrices, vasos sanguíneos y pliegues. En cuanto a los colores también se ven diferentes tonos y variaciones según el ángulo de observación, la sombra, el medio en el que esté y la iluminación.

Doug Jones durante una sesión de preparación del traje y el maquillaje

Se pueden ver en las extremidades de la criatura estructuras a modo de aletas, aunque no demasiado grande para primar el aspecto antropomórfico sobre el anfibio. Llama poderosamente la atención la creta dorsal que presenta a lo largo de su espalda, siguiendo la línea de la columna vertebral, que puede ser una referencia a su condición de macho. Los machos de los tritones desarrollan este tipo de crestas dorsales en su espalda y en su cola como un signo de dimorfismo sexual que se usa para hacerlos más llamativos en el cortejo.

La cresta en la espalda de la criatura

La condición de macho de nuestro espécimen queda clara desde el principio, pero se hace referencia varias veces a su entrepierna, que se observa bastante plana, sin señal de la presencia de ningún pene u órgano copulador. Es la protagonista de la película, Elisa, la que en un momento dado explica a su amiga si la criatura tiene pene o no, y es aquí donde, debido a su condición de muda, lo hace mediante gestos. Atendiendo a como lo explica, la imagen que me hice de como era la estructura del pene de la criatura me recordó a la de un animal acuático, pero que precisamente no es un anfibio, ya que la mayoría de ellos carecen de pene, sino a la de los cocodrilos, que son reptiles.

Detalle del cuerpo completo de la criatura

Un juguete sexual inspirado en el supuesto órgano copulador de la criatura

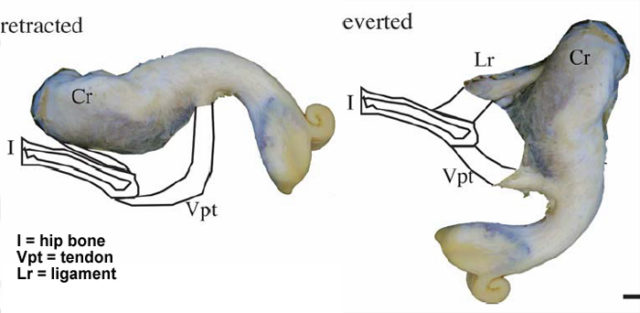

El aligátor americano, también conocido como caimán americano, Alligator mississipiensis, es un tipo de cocodrilo que habita en Estados Unidos. Estos animales tienen un extraño pene blancuzco y con aspecto blando, que está continuamente en erección pero retraído en el interior de la cloaca, y que solo es impulsado al exterior por un reflejo muscular, al estimularse los nervios adecuados. En nuestra criatura el pene también se mantiene en el interior del cuerpo de ésta, hasta que no es necesaria su presencia, lo que coincide un poco con la explicación de Elisa y con la entrepierna plana que vemos en pantalla. Al no depender de sangre ni de ningún tipo de mecanismo hidráulico para su funcionamiento son los músculos los que se encargan de producir su salida, y la estructura elástica de un tendón es la que hace que se retraiga de nuevo, como si de una goma elástica se tratara.

En cuanto la musculatura de la cloaca se relaja y se abre, éste se libera. Los propios científicos encargados de su estudio comparan la eyección del pene del aligátor con la salida del contenido de un tubo de pasta de dientes, para que nos hagamos una idea. Si esto es así con la criatura de La forma del agua no lo sabemos, pero a mí es lo que se me vino a la mente. De esta característica reptiliana hablaba al principio del post, cuando dudábamos de su naturaleza.

El pene siempre erecto de un aligátor

Otro de los aspectos importantes es el rostro, pues Doug Jones se tiene que expresar, y una máscara habría sido un estorbo para ello. El rostro de la criatura está conseguido con prótesis para las agallas y repliegues, que se manipulaban externamente y se movían por control remoto. Se esforzaron por crear un rostro no demasiado extraño y una boca que fuera besable, por lo que los labios son bastante humanos. Su nariz es casi inexistente, reduciéndose a dos pequeñas fosas nasales y son sus grandes ojos lo que más destaca en su rostro. Estos parpadean de una curiosa forma, en horizontal en vez de en vertical, y es debido a que posee una membrana nictitante o tercer párpado, que es transparente y sirve para protegerlo del agua cuando se sumerge. De hecho vemos como estos párpados se le cierran en algunas escenas justo cuando se está hundiendo en el agua.

Los ojos de la criatura

Son muchos los detalles que hemos analizado de esta criatura, y aún así estoy seguro de que podríamos profundizar mucho más en cada uno de ellos o en otros que se nos hayan pasado, como por ejemplo la forma de alimentación, pero queda claro que disfrutar del cine añadiendo un punto de vista científico hace que una película, ya de por sí magnífica, mejore aún más.

Este post ha sido realizado por Carlos Lobato (@BiogeoCarlos) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

Referencias científicas y más información:

Kelly, D. A. (2013). Penile anatomy and hypotheses of erectile function in the American alligator (Alligator mississippiensis): muscular eversion and elastic retraction. The Anatomical Record, 296(3), 488-494.

Salas, R., Cruz, S. J. M., Castillo, E. B., & Guzmán, C. T. (2018). Análisis morfométrico y batimétrico de la laguna de Huamanpata, región Amazonas. INDES Revista de Investigación para el Desarrollo Sustentable, 2(2), 30-38.

Jackson, D. C. (1987). HOW DO AMPHIBIANS BREATHE BOTH. Comparative physiology: Life in water and on land, 9, 49.

Daniels, C. B., & Orgeig, S. (2003). Pulmonary surfactant: the key to the evolution of air breathing. Physiology, 18(4), 151-157.

España, M. D. C. M., Martinez, J. M., Moreira-Turcq, P., Bonnet, M. P., Villar, R. E., de Gamundi, A. V., … & Seyler, P. Monitoreo espacial y temporal del estado trófico de los lagos de planicies de inundación en la Amazonía central mediante sensores remotos.

Brainerd, E. L., & Owerkowicz, T. (2006). Functional morphology and evolution of aspiration breathing in tetrapods. Respiratory physiology & neurobiology, 154(1-2), 73-88.

La “osmótica” criatura de la Laguna Negra

Pero mira como osmorregulan los peces en el río

Descubrieron un arrecife de coral en el río Amazonas

Descubren inmenso arrecife en la desembocadura del río Amazonas

Wikipedia: Ósmosis

Wikipedia: Osmorregulación

La salinización de los ríos es un problema medioambiental en todo el planeta

El artículo La Criatura de “La forma del agua” se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Los animales que respiran en agua

- La distribución del agua animal y el curioso caso del potasio

- La forma de las hojas

Crónica de la 2ª jornada “Las pruebas de la educación”

Después el éxito de la primera edición de la jornada “Las pruebas de la educación”, el pasado 2 de febrero tuvo lugar la segunda edición de ésta jornada que nuevamente completó aforo.

La jornada busca generar debate sobre cuestiones que afectan a la educación, desde el sistema educativo hasta los métodos de aprendizaje en auge, pasando por los problemas de aplicación de los distintos programas o las técnicas y herramientas con los que hacer frente a los problemas cognitivos de los alumnos. Y todo ello basándose en la evidencia científica disponible al respecto.

Problemas de aprendizaje

El encargado de abrir la jornada fue José Ramón Alonso, quien trató el tema del autismo en la educación. Tras explicar que el déficit de la interacción social y los patrones de comportamiento restringidos y repetitivos son las principales características de los trastornos del espectro autista, el ponente pasó a dar una serie de consejos para los profesores de estos alumnos.

Entre ellos, ayudar al niño a desarrollar estrategias y habilidades para comunicarse o adaptar la enseñanza a las peculiaridades del aprendizaje del niño. Dirigirse al niño en primera persona e individualmente o hacer preguntas cerradas en lugar de abiertas son algunas de las adaptaciones que el profesorado puede aplicar para facilitar el día a día a los alumnos con trastorno del espectro autista.

Por otro lado, un trastorno de aprendizaje común en el aula es la dislexia, que crea dificultades de lectura en los alumnos que lo padecen. Joana Acha describió la base fonológica del trastorno acreditada por la neurociencia. En la actualidad hay muchos métodos que aseguran ayudar con la dislexia: el método Tomatis, el Brain Gym, el método Doman o la kinesiología. Ninguno de ellos está avalado por la evidencia científica.

En el caso de la dislexia lo probado científicamente es de base fonológica, ya que se ha demostrado que trabajar habilidades como el conocimiento fonológico, la asociación sonido-letra o la adquisición del léxico visual, entre otras, tienen un efecto positivo.

Deberes, evaluación y eficacia

¿Sirven para algo los deberes? ¿Qué utilidad tienen las evaluaciones? Son dos de las cuestiones a la orden del día en el ámbito educativo y que han provocado posturas muy encontradas, hasta llegar a la huelga de deberes. La psicóloga Marta Ferrero fue la encargada de presentar las pruebas científicas al respecto.

Y lo cierto es que, pese a la mala fama que tienen últimamente, las pruebas científicas avalan tanto los deberes como las evaluaciones. Según las investigaciones, la evaluación no solo sirve para valorar, sino que favorece el aprendizaje y fomenta el estudio: cuantas más evaluaciones (recuperación de información, no solo exámenes con nota) más sesiones de estudio. No solo eso, también ayuda a detectar las lagunas de conocimiento en el aprendizaje.

En el caso de los deberes la conclusión es clara: los deberes aportan beneficios a todos los alumnos. Pero no cualquier tipo de deberes. Según explicó la ponente, los deberes han de mandarse con un propósito y también es importante que en los hogares se cree un espacio y una rutina para hacerlos. Finalmente, Ferrero presentó las dificultades deseables1 (concepto enmarcado en la Teoría del Desuso, de Bjork y Bjork2) como método de enseñanza.

Este método está basado en el funcionamiento de la memoria, que es precisamente el tema que trató el psicólogo Joaquín Morís. Al principio de su ponencia el psicólogo sentó la base de que todo aprendizaje implica memoria y que memoria no es igual a aprender de memoria.

Según explicó Moris, cuanto más accesible una habilidad, menor aprendizaje. Y es que entra en juego la ilusión de la fluidez: “si estoy haciendo bien la tarea, cómo no voy a estar aprendiendo”. De ahí que las dificultades deseables sean un método para mejorar el aprendizaje.

Por supuesto, el aprendizaje se da en el contexto de un sistema educativo concreto que también influye. La filóloga Inger Enkvist presentó el caso del sistema educativo sueco, que instauró la escuela educativa única o de base. En ella los profesores tenían 5 consignas: motivación, actividad, concreción, individualización y colaboración. El sistema concatenó reformas y leyes educativas y en la década de los ochenta prácticamente desaparecieron las notas, un alumno recibía su primera nota a los 15 años. Se trata de un sistema que, según la ponente, además de no contar con el beneplácito del profesorado, no obtuvo los resultados esperados.

Además del sistema educativo, los distintos centros también tienen un gran impacto en la educación. Es de lo que trató la ponencia de Beronika Azpillaga, quien forma parte de un grupo que investiga la eficacia de distintos centros escolares en el País Vasco y analiza las características de aquellos con mejores resultados.

Entre las claves de los centros eficaces destacó el seguimiento y las tutorías fuertes, la atención a la diversidad y la importancia de un buen equipo humano. En esta ocasión trajo la segunda parte de la investigación que junto a Luis Lizasoain presentó en la anterior edición de la jornada.

En la charla-coloquio final se pusieron de manifiesto algunos de los problemas a los que se enfrenta la educación en la actualidad. Entre ellos destacó la distancia existente entre la investigación y la docencia y la dificultad del profesorado para acceder e interpretar correctamente investigaciones científicas relevantes de su campo. Debido a este cisma, es frecuente que los profesores se dejen llevar por metodologías que se ponen de moda a pesar de carecer de base científica y que, preocupantemente, en muchas ocasiones provienen de fuentes fiables.

De ahí que se subrayase la importancia de dotar a los profesores de las aptitudes y herramientas adecuadas para que puedan discernir entre metodologías eficaces y científicamente probadas y metodologías sin base alguna.

Referencias:

1Bjork, R.A. (1994) Memory and metamemory considerations in the training of human beings. In J. Metcalfe &A. Shimamura (Eds.), Metacognition: Knowing about Knowing (pp. 185-205) Cambridge, MA:MIT Press.

2 Bjork, E. L., & Bjork, R. A. (2014). Making things hard on yourself, but in a good way: Creating desirable difficulties to enhance learning. In M. A. Gernsbacher and J. Pomerantz (Eds.), Psychology and the real world: Essays illustrating fundamental contributions to society (2nd edition). (pp. 59-68). New York: Worth.

Sobre la autora: Ziortza Guezuraga, periodista, es colaboradora de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Crónica de la 2ª jornada “Las pruebas de la educación” se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Crónica de la 1ª jornada “Las pruebas de la educación”

- Las pruebas de la educación 2018: El coloquio

- Cómo destruir un buen sistema de educación. El ejemplo sueco

La ciencia y la tentación de la narrativa

La publicación en 1610 del “Sidereus nuncius” de Gaileo contenía mapas de la Luna con montañas y planicies que echaban por tierra la visión del universo aristotélica y las narrativas asociadas. En 1651 Franceso Grimaldi dibujaba este mapa a las órdenes de Giovanni Battista Riccioli, sacerdote jesuita, en el que éste bautizaba los accidentes geográficos lunares con nombres que aún se usan hoy día.

La gran tragedia de la ciencia, decía Thomas Henry Huxley con considerable ironía, es el asesinato de una hermosa hipótesis a manos de un repugnante dato. Y es algo mucho más común de lo que imaginamos: innumerales, intrincadas, preciosas y espectacularmente explicativas hipótesis resultan cada día dañadas, heridas o destruidas por la súbita aparición en escena de un feo y aparentemente insignificante dato que sin embargo se convierte en su victimario y ejecutor. Porque no importa lo atractiva que pueda parecer una hipótesis ni la potencia de su capacidad explicativa, no hay explicación o teoría de funcionamiento de un fenómeno natural que pueda resistir a la imposibilidad de explicar un dato fehaciente.

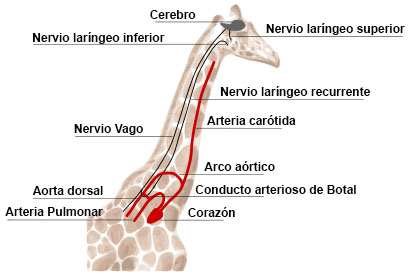

El fenómeno está especialmente extendido en biología por culpa de la inagotable y feroz creatividad chapucera de la evolución por selección natural. Es común que un intrincado y complejo fenómeno que se podría explicar por la elegante interacción de un puñado de reglas comprensibles y sencillas resulte funcionar a base de ad hocs, como una sucesión de parches colocados unos sobre otros empleando los materiales menos convenientes y usando las combinaciones menos elegantes. La naturaleza suele utilizar lo que funciona y tiene a mano aunque la solución no sea la más económica o racional, y así es común que las redes genéticas que controlan un fenómeno usen absurdas combinaciones y extraños ciclos de control, o que una adaptación morfológica provoque situaciones carentes de lógica como el nervio faríngeo recurrente de la jirafa, que llega a alcanzar los 5 m de longitud para cubrir una distancia mucho menor. Ante este tipo de datos y hechos reales cualquier hipótesis alambicada y hermosa puede resultar más que perjudicada.

En el fondo se trata de uno de los muchos problemas que traen ’de fábrica’ los cerebros humanos a la hora de entender el universo que nos rodea; esos defectos del intelecto que tanto nos dificultan pensar con absoluta claridad. Porque para nuestra forma de pensar no hay nada más intoxicador y atrayente que una buena historia; nos gusta tanto una narrativa clara, elegante y sencilla que somos incapaces de resistirnos a la tentación y no sólo creemos en ella, sino que si es necesario la ‘ajustamos’ un poco si no encaja con los datos.

Las narrativas, las buenas historias, actúan sobre la mente humana como un virus: la colonizan, la invaden y la emplean para reproducirse transmitiéndose a otras mentes. Los cuentos y las narraciones nos gustan tanto que existen industrias multimillonarias dedicadas a ellos, desde los medios al cine, y la creación y mantenimiento de narrativas forma parte clave de nuestra política y de nuestra sociedad. El periplo del héroe, también llamado el monomito, es el arquetipo básico de buena parte de nuestras historias y su ubicuidad y persistencia demuestra la potencia que la narración tiene sobre nosotros. Las buenas historias, que cuanto están bien narradas son capaces de esconder sus propios fallos y debilidades, ejercen tan poderosa influencia sobre nuestra mente como para resultar peligrosas.

Este peligro se refiere sobre todo a la interacción entre las historias y la realidad, algo que ocurre en ciencia todo el tiempo. Los científicos son humanos por tanto sus mentes funcionan con historias; una buena teoría o una buena hipótesis no es más que una buena historia que explica una serie de fenómenos y los integra en un todo comprensible. Cualquier estudiosos de la realidad tenderá a construir una narrativa con lo que contempla, una historia que le ayude a comprender de qué manera aspectos aparentemente diferentes son en realidad facetas distintas de un fenómeno subyacente más fácil de comprender. En ese sentido la emisión de hipótesis y la creación de teorías no se diferencia en exceso de la creación de mitos o de narraciones; teorizar no está tan lejos de la literatura o del arte como pudiésemos imaginar.

Pero en la ciencia hay un paso más que resulta vital: confrontar nuestras preciosas narrativas hipotéticas, esas creaciones del intelecto cargadas de lógica y elegancia, con la cruda realidad. Donde a menudo las bellas hipótesis que podrían explicarlo todo de un modo sencillo y elegante resultan evisceradas porque a pesar de todo su poder explicativo resultan ser incapaces de explicar un simple dato. Toda la creatividad humana, toda la estructura del viaje heroico, todo el afán de simplicidad belleza de una hermosa hipótesis quedan en nada cuando esa explicación no es capaz de enfrentarse a un hecho. La narración nada tiene que hacer si la historia que estamos contando no puede explicar lo que de verdad sucede en ese experimento, en ese detalle anatómico, en ese detector.

Y de este modo las más bellas narrativas de la ciencia se pierden y desaparecen, y carreras científicas enteras llegan a un brusco final cuando aparecen datos que masacran sin piedad su capacidad explicativa. Porque los cerebros de los humano somos muy vulnerables al poder de las historias, pero en ciencia una buena narración no es suficiente.

Sobre el autor: José Cervera (@Retiario) es periodista especializado en ciencia y tecnología y da clases de periodismo digital.

El artículo La ciencia y la tentación de la narrativa se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Los vacíos cósmicos y la estructura del universo

Imagen en infrarrojo del espacio profundo tomada por el Telescopio Espacial Hubble

Cuando pensamos en el universo en su conjunto imaginamos una cantidad enorme de galaxias. De hecho, las galaxias son lo más estudiado por los astrónomos para comprender el universo en su conjunto. Sin embargo, los investigadores están descubriendo que hay mucho que aprender de los vacíos cósmicos: franjas de espacio mayormente vacío, tan grandes que la luz tarda cientos de millones de años en atravesarlos.

La temperatura y la presión del gas presente en los huecos podría, por ejemplo, proporcionar pistas sobre cómo la energía circula a través del cosmos. Un equipo de investigadores encabezado por David Alonso, de la Universidad de Oxford (Reino Unido), han dado uno de los primeros pasos para determinar estas propiedades del gas mediante el análisis de cómo el gas distorsiona la luz del Universo primitivo.

El fondo cósmico de microondas (FCM) es la primera luz que se libera en el universo, aproximadamente 380,000 años después del Big Bang. El gas intergaláctico aumenta la energía de los fotones del FCM, y esta distorsión es una poderosa herramienta para estudiar los cúmulos de galaxias. Pero nadie la ha usado para estudiar los vacíos cósmicos. El equipo de Alonso combinó mapas del FCM con imágenes de 774 vacíos cósmicos. A partir de ahí los investigadores dedujeron las propiedades del gas en cada vacío comparando de la energía medida de los fotones del FCM con modelos de la presión electrónica en los vacíos.

De esta forma los astrofísicos descubrieron que la presión es menor que el promedio cósmico. Este resultado no es sorprendente, dado que poco se puede esperar que suceda en un vacío, y puede significar que los vacíos evolucionaron pasivamente conforme aumentaba la edad del Universo.

Pero hay indicios en los datos de que el gas podría estar más caliente de lo esperado. Si este hallazgo se confirmase, podría ser una señal de que los poderosos chorros emitidos por los agujeros negros supermasivos bombeen energía al gas intergaláctico y ayuden de esta manera a dar forma al universo. La resolución de este problema tendrá que esperar varios años hasta que se disponga de telescopios más potentes, como el Observatorio Simons en Chile.

Referencia:

David Alonso, J. Colin Hill, Renée Hložek, and David N. Spergel (2018) Measurement of the thermal Sunyaev-Zel’dovich effect around cosmic voids Physical Review D doi: 10.1103/PhysRevD.97.063514

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo Los vacíos cósmicos y la estructura del universo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Los vacíos cósmicos y la relatividad general

- La estructura del universo como una interferencia cuántica

- La estructura en común de estrellas de neutrones y aparcamientos

Alexandre Grothendieck, el genio rebelde

En una conversación matemática, alguien sugirió a Grothendieck que debería considerar un número primo particular. “¿Te refieres a un número concreto?”, contestó Grothendieck. La otra persona replicó “Sí, un número primo concreto”. Grotendieck sugirió: “De acuerdo, tomemos el 57”.

Allyn Jackson en [2], página 1196.

El 57 se conoce desde entonces como “el número primo de Grothendieck”: por cierto, no es primo, ya que 57 = 3 x 19…

Alexandre Grothendieck. Fuente: Wikimedia Commons.

Alexandre Grothendieck nació el 28 de marzo de 1928. Su madre, Hanka Grothendieck (1900-1957), era periodista, y su padre, Sascha Schapiro (1889-1942), un fotógrafo ruso, judío y militante anarquista.

Entre 1934 y 1939, Hanka y Sascha se unieron a los anarquistas en la Guerra Civil Española, dejando a su hijo a cargo de unos conocidos en Hamburgo. Tras reunirse con sus padres en el sur de Francia, Sascha fue recluido en el campo de internamiento de Vernet y transferido después al de Auschwitz, en el que fue asesinado. Hanka y Alexandre fueron enviados al campo de internamiento de Rieucros, después al de Brens en 1942. Con ayuda de una asociación protestante cuya misión era la de salvar niños judíos, se evadieron para evitar la deportación y la muerte.

Al acabar la guerra, Alexandre comenzó sus estudios de matemáticas en Montpellier. Laurent Schwartz (1915-2002) y Jean Dieudonné (1906-1992) fueron sus directores de tesis (Produits tensoriels topologiques et espaces nucleaires, 1953). Al conocerle, entregaron a su nuevo alumno un listado de catorce problemas que consideraban como un vasto programa de trabajo para varios años, y le pidieron que eligiera uno de ellos. Algunos meses más tarde, Alexandre fue a ver a sus directores habiendo resuelto los catorce problemas: la leyenda acababa de comenzar.

En la primera parte de su carrera, Grothendieck trabajó en análisis funcional y, a pesar de los grandes aportes en esta área, sus posteriores trabajos en geometría algebraica, teoría K y álgebra homológica son los que le dieron la fama.

En 1966 fue galardonado con la Medalla Fields, pero por razones políticas se negó a acudir a Moscú a recoger su premio. Fue el primero de una serie de reconocimientos y posicionamientos políticos que le alejaron sin remedio de la comunidad científica. En 1977 se le concedió la Medalla Émile Picard de la Academia de Ciencias de París, que subastó para donar el dinero al gobierno de Vietnam del Norte. En 1988 se le concedió el Premio Crafoord de la Real Academia Sueca de Ciencias (junto a su alumno Pierre Deligne) y lo rechazó, argumentando que no necesitaba ni el dinero ni los honores.

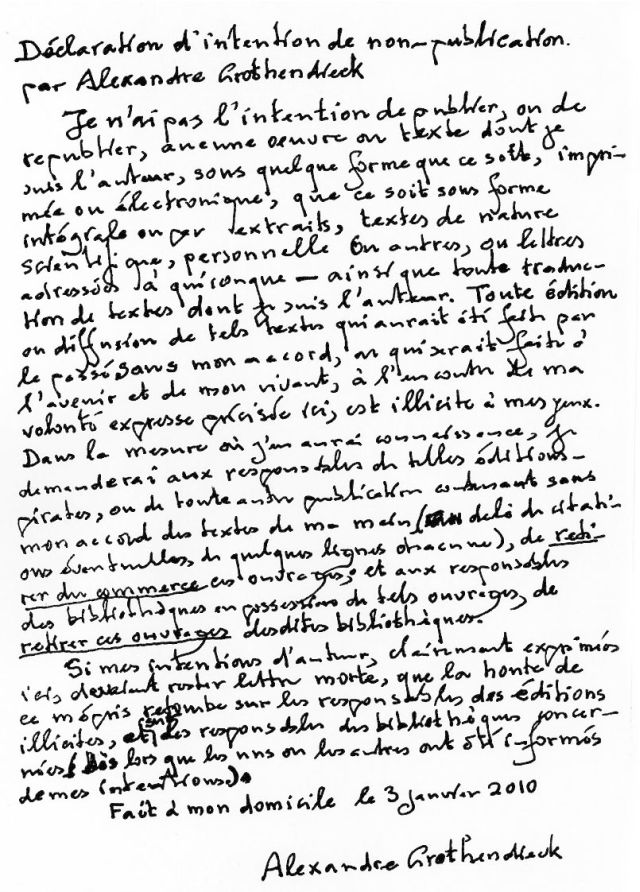

Carta en la que Grothendieck renuncia a toda utilización comercial de sus obras, 2010. Fuemte: Secret Blogging Seminar

Apátrida, pacifista, ecologista, y muy influenciado por el movimiento hippy, Alexandre Grothendieck fue un genio de las matemáticas, con una personalidad indomable. Falleció el 13 de noviembre de 2014. En las referencias recomendadas puede conocerse más sobre su vida y su obra.

Como topóloga, no he podido resistirme a reproducir estas palabras de Alexandre Grothendieck extraídas de su Récoltes et Semailles, Réflexions et témoignage sur un passé de mathématicien. Eneste largo texto, producto de profundas meditaciones realizadas durante años y nunca publicado, el matemático pasaba revista a su obra científica y analizaba el entorno matemático con, en algunas ocasiones, una mirada muy crítica.

La noción de “espacio” es sin duda uno de las más antiguas en matemáticas. Es tan fundamental en nuestra aprehensión “geométrica” del mundo que ha permanecido más o menos tácita durante más de dos milenios. Es a lo largo del pasado siglo cuando esta noción ha conseguido desprenderse, gradualmente, del dominio tiránico de la percepción inmediata (de un único y mismo “espacio” que nos rodea), y de su teorización tradicional (“euclidiana”) para adquirir su autonomía y su dinámica propias. Hoy en día, es una de las pocas nociones universales y más comúnmente utilizadas en matemáticas, sin duda familiar para cualquier matemático sin excepción. Además, es una noción proteiforme donde las haya, con cientos y miles de caras, dependiendo del tipo de estructuras que se incorporen a estos espacios, desde las más ricas (como las venerables estructuras “euclidianas” o las estructuras “afines” y “proyectivas”, o también las estructuras “algebraicas” de las “variedades” del mismo nombre, que las generalizan y suavizan) hasta las más simples: aquellas en las que cualquier elemento de información “cuantitativo” de cualquier tipo parece haber desaparecido sin posibilidad de retorno, y donde solo queda la quintaesencia cualitativa de la noción de “proximidad” o la de “límite”, y la versión más elusiva de la intuición de la forma (llamada “topológica”). La más pobre de todas estas nociones, la que hasta ahora, y durante el último medio siglo, había tomado el lugar de una especie de amplio marco conceptual común para abarcar a todas las demás, era la del espacio topológico. El estudio de estos espacios constituye una de las ramas más fascinantes, la más persistente, de la geometría: la topología.

Récoltes et Semailles, La topologie ou l’arpentage des brumes, 51-52.

Más información:

[1] Philippe Douroux, Alexandre Grothendieck. Un voyage à la poursuite des choses évidentes, Images des Mathématiques, CNRS, 2012

[2] Allyn Jackson, Comme Appelé du Néant-As If Summoned from the Void. The Life of Alexandre Grothendieck (parte 1 y parte 2), Notices AMS, vol. 51 (9) (2004) 1038-1056 y vol. 51 (10) (2004) 1196-1212

[3] Winfried Scharlau, Who Is Alexander Grothendieck?, Notices AMS, vol. 55 (8) (2008) 930-941

[4] Javier Fresán, Un congreso de geometría algebraica celebra la figura de Grothendieck, genio, apátrida y ermitaño, Público, 2009

[5] Francisco R. Villatoro, La obra de Alexander Grothendieck (1928-2014),La ciencia de la mula Francis, 16 noviembre 2014

[6] Textos de Alexandre Grothendieck, recopilación de Juan Antonio Navarro González

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Alexandre Grothendieck, el genio rebelde se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Wolfgang Döblin, un genio perdido

- Alexandre Yersin: el rango que otorga la ciencia

- El genio de Ampère

Relaciones hídricas y salinas de los animales: fundamentos

Los líquidos corporales de los animales se distribuyen en tres espacios o compartimentos, principalmente: celular (líquido intracelular), espacios entre las células (líquido intersticial) y, de haberlas, cavidad general del cuerpo y sistema vascular (líquido celómico, plasma sanguíneo, hemolinfa o equivalente). Como vimos aquí, el líquido intersticial y el plasma pueden ser considerados conjuntamente líquido extracelular (o medio interno). En los animales sin sistema vascular la razón de esa identidad es obvia. En los animales con sistema circulatorio abierto no hay discontinuidad alguna entre la hemolinfa y el líquido que baña las células. Y en los de sistema cerrado, los capilares tienen poros (entre las células endoteliales o, incluso, atravesando tales células) a través de los cuales se establece una continuidad casi absoluta entre ambos sistemas; las únicas sustancias que no atraviesan la barrera que representa el endotelio capilar son ciertas moléculas, como proteínas plasmáticas, cuyo gran tamaño impide su salida del capilar hacia los espacios intercelulares. Por lo tanto, el líquido intersticial y el plasma (o equivalente) tienen la misma concentración osmótica y casi idéntica composición iónica. Sin embargo, aunque los líquidos extra e intracelular tengan también la misma concentración osmótica, la composición de iones y de ciertas moléculas orgánicas es muy diferente en ambos fluidos.

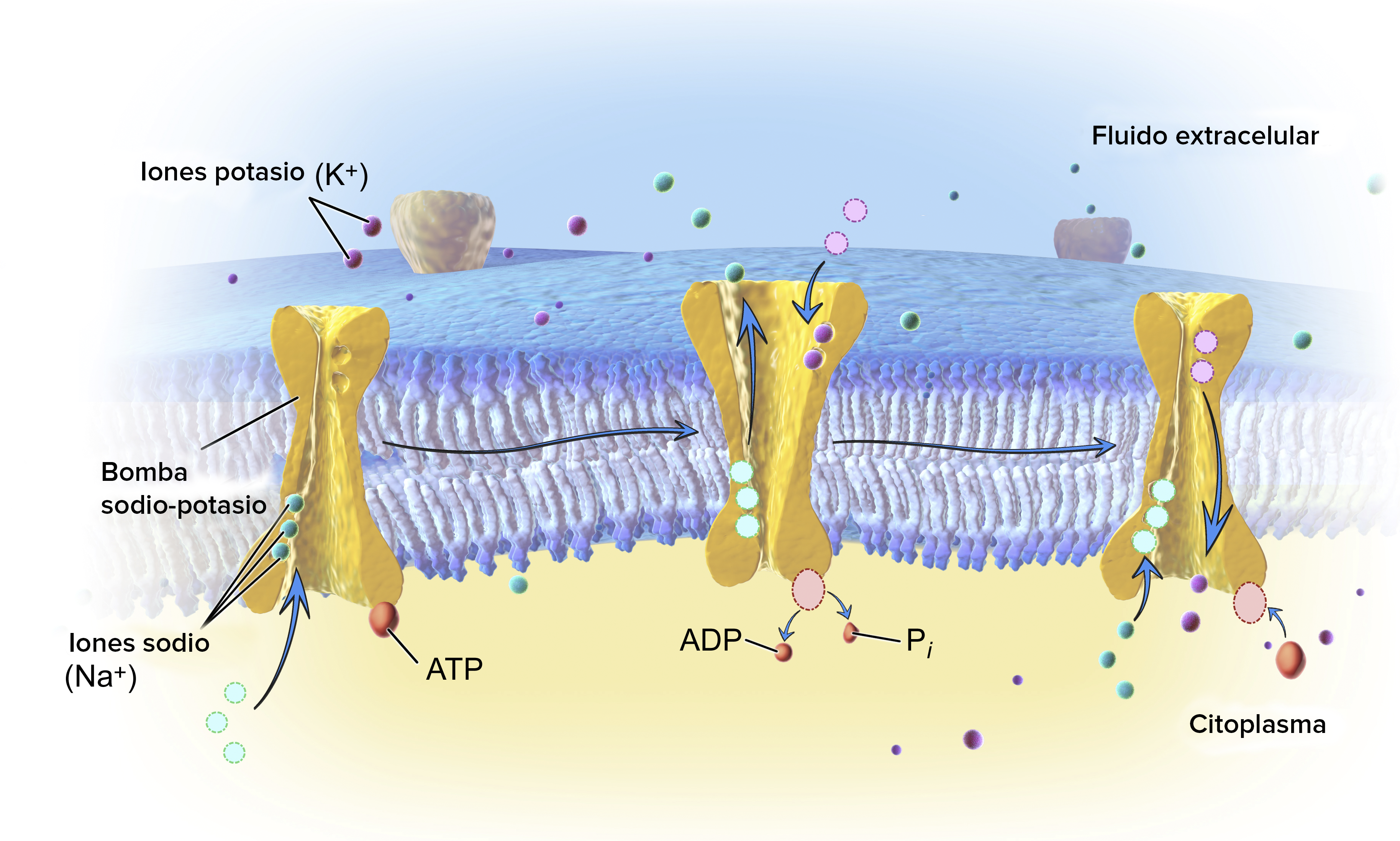

Por las razones dadas, desde un punto de vista funcional, resulta útil reducir las subdivisiones anteriores a dos: medio intracelular y medio interno. Ambos medios se encuentran separados por la membrana celular que, dada su carácter semipermeable, ejerce de barrera para con ciertos solutos (Na+, Cl–, sustancias orgánicas) pero no para con el K+ ni para con el agua. Y por otro lado, el medio interno y el medio exterior también se encuentran separados por el tegumento, que normalmente hace función de barrera.

Los animales han de preservar su contenido hídrico dentro de ciertos márgenes, porque de ese contenido depende la existencia de los fluidos corporales y que esos fluidos tengan características compatibles con las funciones animales. Al fin y al cabo, todas las estructuras internas se hallan bañadas por fluidos, que son el ambiente inmediato de células, orgánulos celulares y moléculas. Su composición es el contexto en el que funcionan aquellas. Las concentraciones de los iones a los que nos referiremos enseguida dependen del volumen de los fluidos en los que se encuentran disueltos. Y además, de ese volumen depende el de las células y tejidos.

Los animales también han de mantener en un rango restringido de valores la concentración intracelular de los iones inorgánicos. El K+, principal catión intracelular, ha de mantener una concentración relativamente alta, pues así lo requiere la estabilidad e integridad funcional de las proteínas. Del mismo modo, han de mantener a niveles reducidos la concentración de Na+ y Cl– dentro de las células, porque incluso concentraciones moderadas de esos iones desestabilizan las proteínas celulares. Además, las concentraciones intra y extracelulares de esos tres iones puede determinar (dependiendo de la permeabilidad relativa de la membrana celular para con cada uno de ellos) la diferencia de potencial eléctrico entre los lados interno y externo de la membrana, lo que resulta crucial desde el punto de vista de la transmisión del impulso nervioso en las neuronas y de la contracción muscular.

Por todo lo apuntado hasta aquí, desde el punto de vista de los equilibrios que han de mantener los animales en materia de contenido hídrico y concentración interna de solutos, la capacidad para ejercer un cierto control sobre los movimientos de agua y sales a través de esas barreras es esencial en la mayor parte de las especies. Aunque ese control se ejerce de forma diferente en las dos barreras mencionadas (membrana celular y tegumento corporal) dependiendo del tipo de relación que cada especie mantiene con el medio en el que se encuentra.

Los animales, como es sabido, ocupan medios acuáticos y el medio terrestre. En lo relativo a los medios acuáticos, estos pueden tener muy diferentes concentraciones salinas. No obstante, la división fundamental es la que existe entre el agua de mar y las aguas dulces. El agua marina tiene una concentración osmótica de 1000 mOsm (miliosmolar), que corresponde a unos 35 g kg-1 (g de sales por kg de agua). Las aguas dulces varían dentro de un rango relativamente estrecho, de entre 0,15 y 15 mOsm; en términos de masas, su concentración de sales se encuentra entre 0,1 y 0,2 g kg-1, aunque se consideran aguas dulces todas aquellas cuya concentración gravimétrica es inferior a 0,5 g kg-1. Los iones principales del agua de mar son Na+ (470 mM), Cl– (548 mM), Mg+2 (54 mM), SO4-2 (28 mM), Ca+2 (10 mM) y K+ (10 mM). Las concentraciones de esas sustancias en aguas dulces, aunque muy bajas, pueden variar considerablemente entre unas masas de aguas y otras. No obstante, las siguientes pueden considerarse típicas del agua dulce: Na+ (0,35 mM), Cl– (0,23 mM), Mg+2 (0,21 mM), SO4-2 (0,19 mM), Ca+2 (0,75 mM) y K+ (0,08 mM).

Por otra parte, también hay importantes volúmenes de agua cuya concentración salina se encuentra entre la del mar y la del agua dulce: son las aguas salobres. Son relativamente normales en zonas costeras en las que el aporte de agua dulce continental diluye el agua marina, especialmente en los estuarios. Y también hay aguas hipersalinas, normalmente en lagos que experimentan una fuerte evaporación; son las aguas cuya concentración supera claramente la del agua de mar.

Flamencos en el lago salino y alcalino de Bogoria (Kenya). En primer plano emergencia de agua caliente.

En lo que se refiere a los medios terrestres, no existen medios que puedan ser diferenciados de forma tan nítida como las aguas saladas y las aguas dulces. La variable relevante en este caso es la presión parcial de vapor de agua en la atmósfera, porque esa variable, como veremos, afecta directamente a la pérdida de agua de un animal por evaporación. La presión de vapor de agua es la porción de la presión atmosférica que es debida al gas vapor de agua y tiene la peculiaridad, por comparación con otros gases, de que tiene un valor límite que no puede superar. Ese valor, que es la presión de saturación, varía con la temperatura: cuanto más alta es esta, mayor es la presión de vapor de saturación: a 0ºC, la presión de saturación del vapor de agua es 4,6 mmHg (0,61 kPa) y a 40ºC es 55,3 mmHg (7,37 kPa).

El agua que puede perder por evaporación un animal depende (1) de la presión parcial de vapor de agua en la atmósfera en la que se encuentra y de lo próxima o alejada que se encuentre esa presión de la de saturación (cuanto mayor sea la diferencia entre la presión de saturación y la presión parcial de vapor de agua, mayor será la pérdida), (2) de la renovación del aire en la proximidad del tegumento, (3) de la temperatura corporal del animal (por razones que no detallaremos aquí), (4) del grosor de la barrera que separa de la atmósfera el fluido corporal que se evapora y (5) de la permeabilidad del tegumento para con el agua. Por lo tanto, los factores ambientales que más inciden en la pérdida potencial de agua por evaporación son la presión parcial de vapor del agua, el viento, la temperatura del ambiente (porque de ella depende la presión de saturación) y la temperatura del animal. El agua se puede perder por otras vías, pero no nos ocuparemos aquí de ellas pues no guardan relación directa con los factores ambientales, que son los que ahora nos interesan. Por lo mismo, tampoco nos ocuparemos de los mecanismos para adquirir agua.

Los animales pueden desarrollar tres tipos de regulación: osmótica, iónica y de volumen. La regulación osmótica (osmorregulación) consiste en el mantenimiento en niveles constantes o casi constantes la concentración osmótica del medio interno. Cuando se define de esta forma la osmorregulación, normalmente se asume que tal capacidad se ejercita en el contexto de variaciones ambientales en la concentración osmótica del medio externo. Pero eso no tiene por qué ser así. También cabe hablar de osmorregulación en aquellos casos en que los animales mantienen concentraciones osmóticas internas constantes (o casi constantes) y diferentes de la del medio externo. Incluso si nos referimos a un animal terrestre que vive en un medio no acuático y que, por tanto, no puede ser caracterizado en términos de concentración osmótica, también podemos considerarlo osmorregulador si es capaz de mantener constante la concentración osmótica del medio interno en un contexto, por ejemplo, de variaciones en la disponibilidad de agua o bajo regímenes alimenticios de variables contenidos salinos.

Los animales que no regulan la concentración osmótica de su medio interno son osmoconformadores, lo que quiere decir que, si ocupan medios acuáticos la concentración osmótica de su medio interno se asemeja a la del medio externo y que si se trata de animales terrestres, varía en función de las condiciones ambientales.

La regulación iónica, por su parte, consiste en la capacidad para mantener constante la concentración de iones inorgánicos en el medio interno. En este caso no cabe hablar de una capacidad de regulación iónica general, sino que tal capacidad siempre se refiere a un ión concreto puesto que cada ión cuya concentración está regulada está sujeto a procesos específicos. También en relación con los iones inorgánicos recurrimos al término conformador para denominar al animal que no regula la composición de alguno de ellos; como en el caso de la regulación, también aquí la incapacidad para regular la concentración de un ión es específica para ese ión.