El descubrimiento de los rayos X

Fuente: Wikimedia Commons.

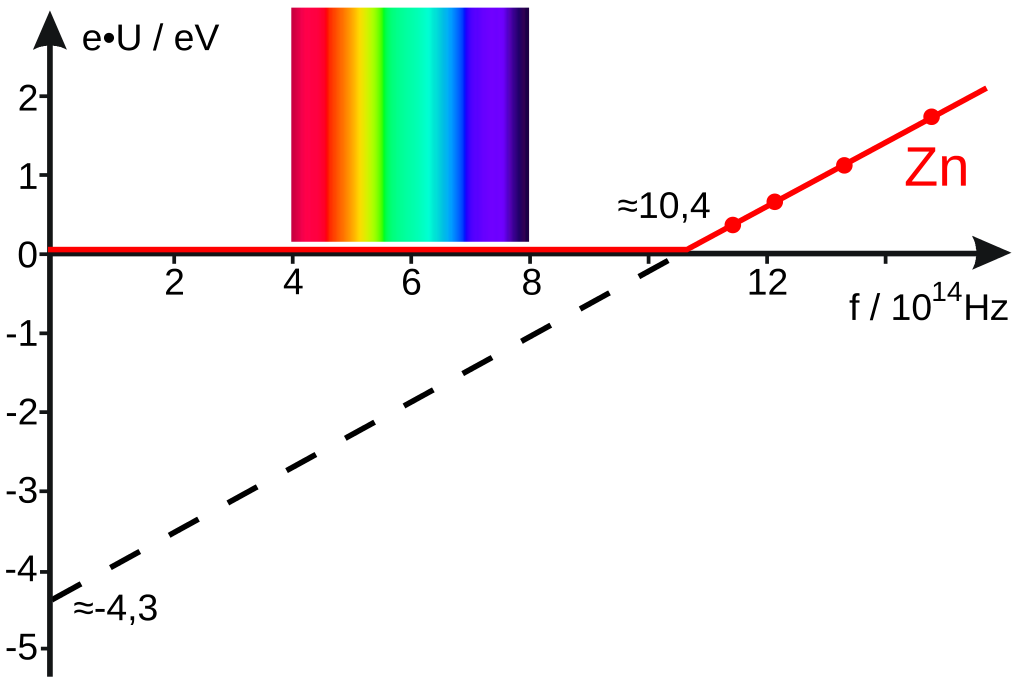

Fuente: Wikimedia Commons.En 1895, Wilhelm Konrad Röntgen hizo un descubrimiento que lo sorprendió primero a él y luego a todo el mundo. Al igual que el efecto fotoeléctrico, no encajaba con las ideas aceptadas sobre las ondas electromagnéticas y, finalmente, también requirió la introducción de los cuantos para una explicación completa. Las consecuencias del descubrimiento de los rayos X para la física atómica, la medicina y la tecnología fueron enormes.

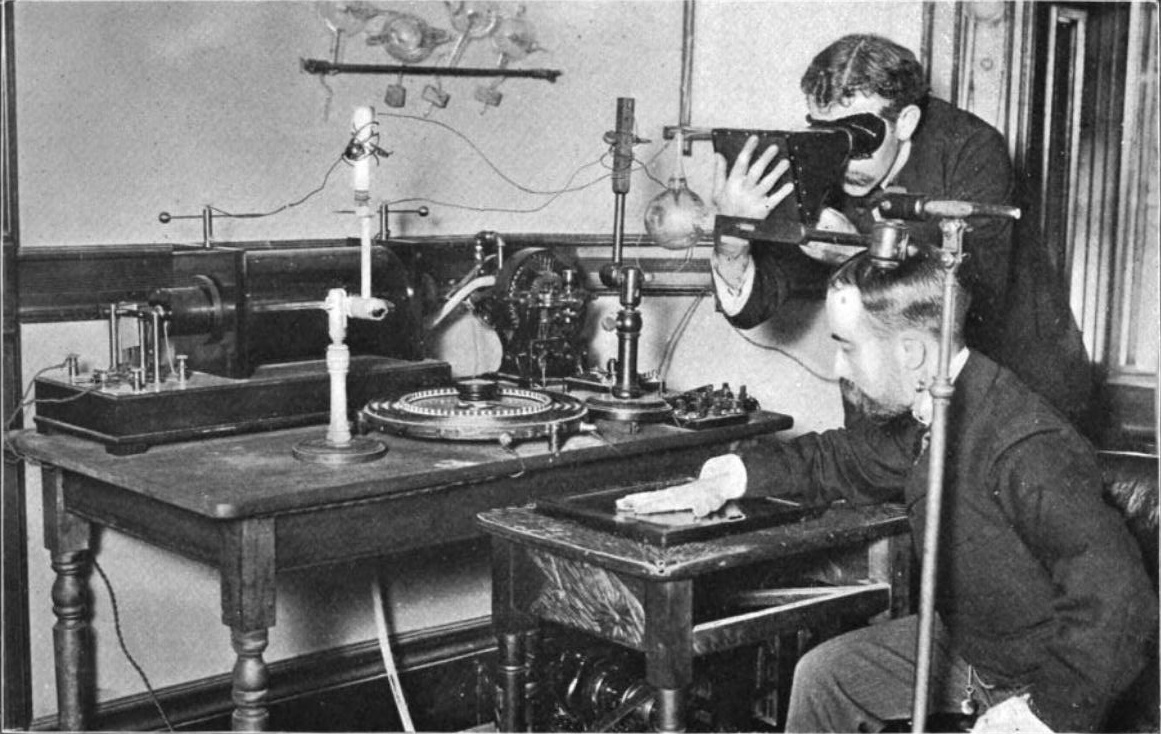

El 8 de noviembre de 1895, Rontgen estaba experimentando con los nuevos rayos catódicos, al igual que muchos físicos de todo el mundo. Según un biógrafo [*]:

. . . había cubierto el tubo de cristal en forma de pera [un tubo de Crookes] con trozos de cartón negro, y había oscurecido la habitación para probar la opacidad de la cubierta de papel negro. De repente, a aproximadamente un metro del tubo, vio una débil luz que brillaba en un pequeño banco que sabía que estaba cerca. Muy emocionado, Rontgen encendió una cerilla y, para su sorpresa, descubrió que la fuente de la misteriosa luz era una pequeña pantalla de platino-cianuro de bario depositada en el banco.

El platino-cianuro de bario, un mineral, es uno de los muchos productos químicos que se sabe que producen fluorescencia (emiten luz visible cuando se ilumina con luz ultravioleta). Pero no había ninguna fuente de luz ultravioleta en el experimento de Röntgen. Se sabía además que los rayos catódicos viajan solo unos pocos centímetros en el aire. Por lo tanto, ni la luz ultravioleta ni los propios rayos catódicos podrían haber causado la fluorescencia. Röntgen dedujo que la fluorescencia involucraba la presencia de rayos de un nuevo tipo. Los llamó rayos X, ya que los rayos eran de naturaleza desconocida.

En una intensa serie de experimentos sistemáticos durante las siguientes 7 semanas Röntgen determinó las propiedades de esta nueva radiación. Informó de sus resultados el 28 de diciembre de 1895 en un artículo cuyo título (traducido) es «Sobre un nuevo tipo de rayos». El artículo de Röntgen describía casi todas las propiedades de los rayos X que se conocen.

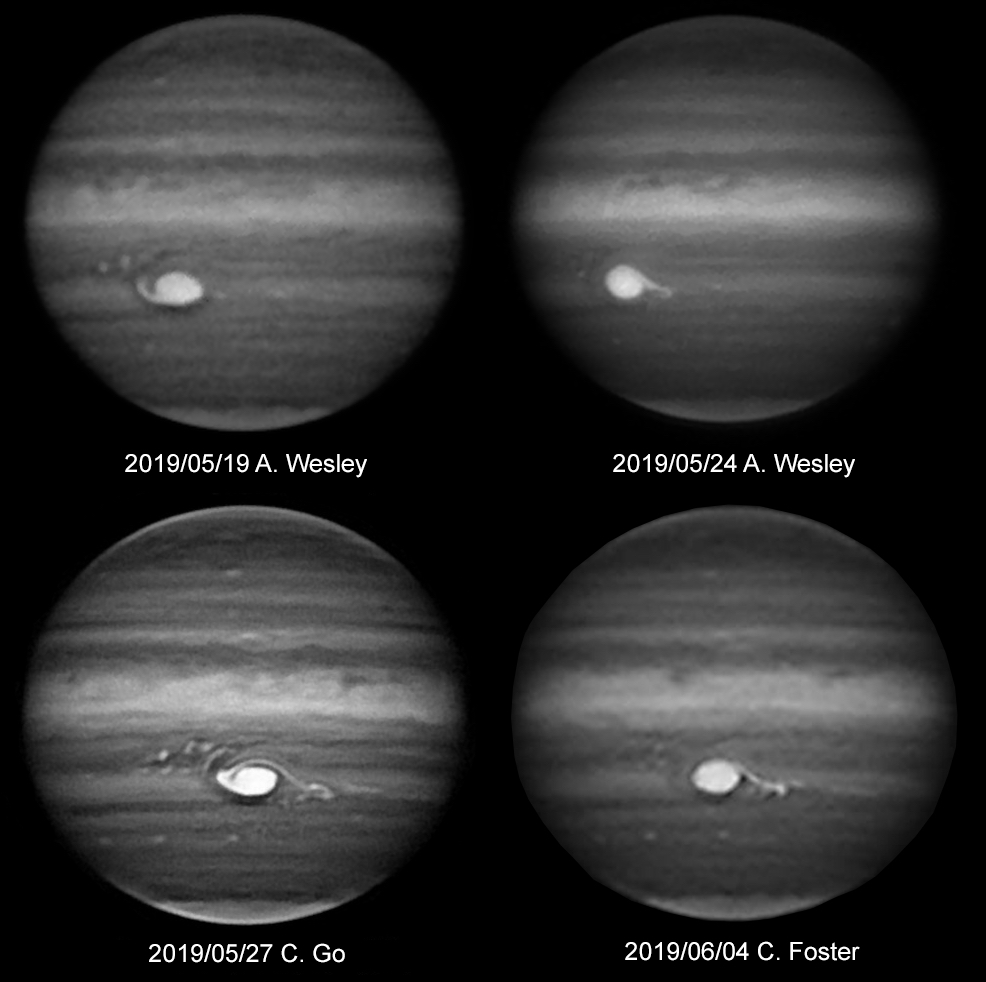

Hand mit Ringen (mano con anillos). Impresión de la primera radiografía médica tomada por Wilhelm Röntgen usando rayos X. Corresponde a la mano de su mujer y fue tomada el 22 de diciembre de 1895. Röntgen se la regaló a Ludwig Zehnder del Physik Institut de la Freiburg Universität el 1 de enero de 1896.

Hand mit Ringen (mano con anillos). Impresión de la primera radiografía médica tomada por Wilhelm Röntgen usando rayos X. Corresponde a la mano de su mujer y fue tomada el 22 de diciembre de 1895. Röntgen se la regaló a Ludwig Zehnder del Physik Institut de la Freiburg Universität el 1 de enero de 1896.Röntgen describió el método para producir los rayos y probó que se originan en la pared de vidrio del tubo, donde los rayos catódicos lo golpean. Demostró que los rayos X viajan en línea recta desde su lugar de origen y que oscurecen una placa fotográfica. Informó detalladamente de la capacidad variable de los rayos X para penetrar en diversas sustancias como el papel, la madera, el aluminio, el platino y el plomo. Su poder de penetración era mayor en los materiales “ligeros” (papel, madera, carne) que en los materiales “densos” (platino, plomo, hueso). Describió y exhibió fotografías que mostraban «las sombras de los huesos de la mano, de un conjunto de pesas dentro de una pequeña caja, y de un pedazo de metal cuya inhomogeneidad se hace evidente con los rayos X.» Dio una descripción clara de las sombras proyectadas por los huesos de la mano sobre la pantalla fluorescente. Röntgen también informó que los rayos X no se desviaban por la presencia de un campo magnético. Tampoco constató reflexión, refracción o interferencia usando aparatos ópticos ordinarios.

Experimentando con rayos X. Fuente: William J. Morton & Edwin W. Hammer (1896) «The X-ray, or Photography of the Invisible and its value in Surgery», American Technical Book Co., New York, fig. 54 / Wikimedia Commons

Experimentando con rayos X. Fuente: William J. Morton & Edwin W. Hammer (1896) «The X-ray, or Photography of the Invisible and its value in Surgery», American Technical Book Co., New York, fig. 54 / Wikimedia CommonsJ.J. Thomson descubrió una de las propiedades más importantes de los rayos X uno o dos meses después de que los rayos se diesen a conocer. Encontró que cuando los rayos pasan a través de un gas, lo convierten en un conductor de electricidad. Thomson atribuyó este efecto a «una especie de electrólisis, la molécula se divide o casi se divide por los rayos de Röntgen». Hoy sabemos que los rayos X, al pasar a través del gas, liberan electrones de algunos de los átomos o moléculas del gas. Los átomos o moléculas que pierden estos electrones se cargan positivamente. Siguiendo con el símil electrolítico a estas moléculas cargadas se las llamó iones porque se parecen a los iones positivos de la electrólisis, y de ahí que se diga que el gas está “ionizado”. Además, los electrones liberados pueden unirse a átomos o moléculas previamente neutros, cargándolos negativamente.

Röntgen y Thomson descubrieron, independientemente que los cuerpos electrificados pierden sus cargas cuando el aire a su alrededor se ionizado por los rayos X. (Ahora es fácil ver por qué: el cuerpo electrificado atrae iones de la carga opuesta presentes en el aire ionizado). La velocidad de descarga depende de la intensidad de los rayos (ya que de ella depende la cantidad de ionización). Por lo tanto, esta propiedad se usó, y se sigue usando, como un medio cuantitativo conveniente para medir la intensidad de un haz de rayos X. Este descubrimiento implicaba, pues, que se podían realizar mediciones cuantitativas cuidadosas de las propiedades y efectos de los rayos X.

Nota:

* Hay varias versiones del descubrimiento. Incluso existe una de consenso que no es más válida que la que ofrecemos. Lo cierto es que la única persona presente era Röntgen, él no lo contó a nadie que tomase notas de ello de forma fidedigna y fiable y dejó dicho que sus notas de laboratorio, que podrían haber arrojado algo de luz [nótese el ingeniosísimo juego de palabras], se destruyesen a su muerte. La cuestión es que los elementos fundamentales de todas las narraciones (tubo de Crookes, cartón negro y pantalla de platino-cianuro de bario) están presentes.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo El descubrimiento de los rayos X se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La luz se propaga en línea recta pero los rayos de luz no existen

- Rayos X y gamma

- El tubo de rayos catódicos, auge y caída de una pieza clave del siglo XX

Oscarretarako bide matematikoa

Star Wars, Karibeko piratak, Toy Story, Frozen eta beste film asko ikusita, sumatzen dugu ordenagailuak zeregin handia izan duela haien atzean dagoen lan teknikoan. Zer ote da, baina, ordenagailuaren lana? Baten batek eman behar dizkio aginduak…

Elurra, ura, ilea, haizea eta abarAleka McAdamsek 2011n aurkeztu zuen tesia UCLAn, Joseph Teran irakaslearen zuzendaritzapean. Matematika aplikatuko tesia zen eta izenburuan efektu berezietako erabilera aipatzen zuen (applications to physical simulation in visual effects). Walt Disney estudioetan eman zioten lana. Alexey Stomakhinek urte bi geroago amaitu zuen bere tesia, zuzendari berarekin lan eginda, eta hura ere Walt Disneyra joan zen lanera. Hirurak, Teran, McAdams eta Stomakhin, agertzen dira Frozen eta Moana filmen arrakastaren atzean, beste zenbait lankiderekin batera, haietariko batzuk UCLAko ikasleak.

1. irudia: Stomakhin, Teran eta UCLAko beste ikasle bi, Frozen filmaren amaiera ospatzen. (Argazkia: UCLA Newsroom)

Animaziozko film onenaren Oscar saria lortu zuen Frozen filmak 2014an. Izotza eta elurra ziren protagonista eta haien diseinu egokia lortzea, ahalik eta irudi errealena ematea, nahi izan zuten zuzendari artistikoek. Teranen taldeak, Stomakhin barne zela, eredu matematiko berri bat proposatu zuen elurraren mugimenduen simulaziorako eta hortik sortu zen programa erabili zuten filmean. McAdamsen lantaldeak beste eginkizun bat izan zuen film berean: haizearen eragina jantzietan eta ilean simulatu zuten.

2. irudia: Aleka McAdams Frozen filmak irabazitako Oscarrarekin. (Argazkia: TigerBands)

Moana filma (Vaiana, hemengo aretoetan) Polinesiako itsasoetan kokatzen da. Urari protagonismo berezia eman nahi izan zioten, filmeko beste pertsonaia bat bailitzan. Zaila da uraren simulazioa egitea, masa osoaren mugimenduaz gain, olatuen talkak eta baita zipriztinak ere erakutsi behar baitira, itxura erreala lortzeko. Ordurako beste film batzuetan ere agertu zen uraren mugimendua, baina hobetu nahi izan zuten. Stomakhinek garatu zuen simulazio berriaren kodea, talde baten barruan, eta bertan zen berriro Teran irakaslea ere. McAdamsek ere hartu zuen parte filmean, oraingoan ilearen simulazio berri bat proposatu zuen taldean.

Joseph Teranen tesi-zuzendaria Stanford Unibertsitateko Ronald Fedkiw izan zen, entzutetsua eta saritua zinemarako egin duen lanagatik. Fedkiwren zuzendaria izan zena, berriz, ospe handiko matematikaria da: Stanley Osher, UCLAko irakaslea. Besteak beste, matematika arloko sari garrantzitsu bat eman zioten Osher jaunari 2014n, Gauss saria. Berak sortu zuen, James Sethianekin batera, maila-multzoen metodoa (level-set method) gainazalen irudikapenerako eta horrekin gainazalen mugimendua, nahastea edo bateratzea deskribatzeko tresna bat. Fedkiwk tresna matematikoa zena zinearen teknologiara egokitu zuen eta hainbat filmetan erabili da.

Sci-Tech (Oscar) sariakZinemako Arte eta Zientzien Akademiak ematen ditu Oscar sariak mundu guztian ikus daitekeen zeremonia arranditsu batean. Askok ez dute jakingo, ordea, glamour gutxiagoko beste zeremonia batean Sci-Tech sariak banatzen dituela. Horien bidez Akademiak ohoratzen ditu “gizon, emakume eta enpresak, zeinen aurkikuntza eta berrikuntzek modu garrantzitsu eta iraunkorrean lagundu baitioten zinemari”. Ohiko da matematikariak, fisikariak eta informatikariak saritzea. Aurtengo adibidea aipatzearren, 2019ko Zientzia eta Ingeniaritza alorreko saridunen artean Edwin Catmull, Tony DeRose eta Jos Stam izan dira, hiru dimentsioko geometriaren eredu digitaletarako gainazalen zatitze-metodoa sortu eta garatzeagatik. Irudi poligonal edo poliedriko batetik abiatuta, forma leunak lortzen dituzte iterazio bidez.

3. irudia: Jos Stam, Edwin Catmull eta Tony DeRose saria jasotzen. (Argazkia: Todd Wawrychuk / ©A.M.P.A.S)

Edwin Catmull aitzindaria izan zen animazioa ordenagailuz egiten, 1970eko hamarkadan hasi baitzen, informatika eta fisikako ikasketak amaitu berritan. Laster kontratatu zuen George Lucas zinegile ospetsuak bere enpresetan lan egiteko, zinemaren industrian konputazioa sartzearen beharraz konbentzituta. Catmullek ekarpen tekniko asko egin ditu eta, gainera, Pixar eta Walt Disney Animation Studios enpresen presidentea izan da. Bost bider irabazi ditu Zinemako Akademiaren sariak, haietako bat Gordon E. Sawyer sari berezia (2009).

Tony DeRose Pixar enpresaren ikerketa taldeko burua izan da denbora luzez, unibertsitateko irakasle izan eta gero. Gazteen artean matematika, fisika eta ingeniaritza bultzatzeko Pixar in a box programa abiatu zuen Pixar eta Khan Academy elkartuta. Bertan bideo laburren bidez azaltzen da Pixarren animazio lana (bideo-sorta honetan, adibidez, aipatu dugun zatitze-metodo saritua).

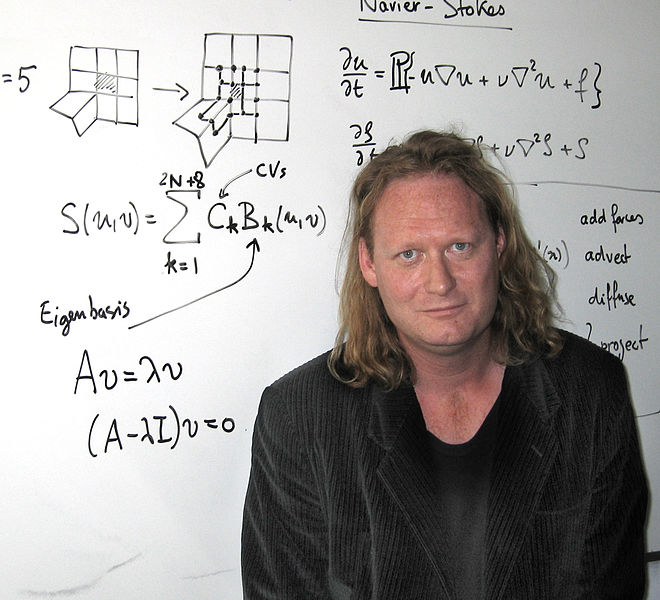

Jos Stam, holandarra jaiotzez, Suitzan hazi zen eta informatika eta matematika ikasi zituen Genevan. Gero Toronton egin zuen tesia informatikan eta fenomeno fisikoen animazioan hasi zen lanean. Fluidoen simulazioan arrakasta handiko Maya Fluid Effects programaren sortzaileetako bat da. Bere lana aurkezteko hala dio: “nire ikerketan atsegin dut konbinatzea artea, matematika, zientzia, ordenagailuak eta beste zenbait gauza exotiko”.

4. irudia: Jos Stam, konputazio grafikoan aditua, zenbait ekuazio matematikoren aurrean. (Argazkia: Azam Khan / Wikipedia – CC BY 3.0 lizentziapean)

Aurtengo hiru hauen moduan, hainbat zientzialari agertzen dira beste urte batzuetako sarituen artean.

Kirurgia birtualaJosep Teranek zinemarako lan egiteaz gain, badu beste ikerketa-ildo interesgarri bat: kirurgia birtuala. Ez du berak sortu, lehenago ere egiten zen, baina bereziki interesatzen zaion alor bat da. Medikuak ordenagailuan egiten du ebakuntza, trebatzeko edo ondorioak probatzeko, eta ez du gorpurik behar. “Pazientea” hiltzen bazaio, berriro has daiteke ebakuntza egiten.

Garrantzitsua da horretarako ordenagailuen kalkuluak denbora errealean egitea, esan nahi baita, medikuaren mugimendu bakoitzaren erantzuna berehala agertu behar da pantailan, benetako ebakuntza bat simulatuz. Horrek esan nahi du atzean dauden ekuazio matematikoak ebazteko denbora oso txikia izan behar dela. Esandako horrek zinemarako ere balio du, komenigarria baita talde artistikoarentzat irudien segida jarraitua ikustea. Hortaz, segundoko 30 fotograma hartzeko, beste horrenbeste bider ebatzi beharko dira ekuazioak, aldi bakoitzean lortutako datuetatik abiatuz hurrengoen kalkulua.

Azken hitzak McAdams, Osher eta Teranen artikulu batetik (2010) hartuko ditugu:

“konputazio zientziaren teknikak duela gutxi bihurtu dira praktikoak zineman eskala handian, beraz, oraindik ez dakigu zein izango den haien eraginkortasuna eta tokia zinemagintzan. Ahaleginak egingo dira hurrengo urteetan erabat ulertzeko matematika aplikatuaren gaitasuna industrian, eta hori bakarrik egin dezakete matematikan, konputazio zientzian eta fisikan oinarri sendoa duten ikertzaileek”.

Gehiago jakiteko:

- McAdams, S. Osher eta J. Teran, (201). Crashing waves, awesome explosions, turbulent smoke, and beyond: applied mathematics and scientific computing in the visual effects industry, Notices of the American Matematical Society 57(5).

- Khan Academyren Pixar in a box: Pixarreko langileek zer egiten duten azaltzen dute bideo laburretan, erabiltzen dituzten teknika matematikoak barne.

- Tony DeRose: The math behind the movies, TedEd hitzaldia; eta artikulu bat.

- Jos Stam: elkarrizketa bat.

- Joseph Teran eta Ronald Fedkiw irakasleen webguneetan informazio ugari aurki daiteke egin duten eta egiten ari diren lanari buruz, irudi eta bideoekin hornituta. Gomendagarriak dira, era berean, Alexey Stomakhin eta Jos Stamen webguneak.

——————————————-

Egileaz: Javier Duoandikoetxea Analisi Matematikoko Katedraduna da UPV/EHUn.

——————————————-

The post Oscarretarako bide matematikoa appeared first on Zientzia Kaiera.

La certeza de la incertidumbre en los informes del IPCC

El año 2018 fue el más caluroso de la historia moderna de la Tierra. Batió el récord de temperatura media global desbancando al año 2017, el cual había superado la espectacular marca del año 2016. El listón de temperaturas elevadas en nuestro planeta está llegando a límites, paradójicamente, escalofriantes. Los que seguimos – con preocupación – la evolución del clima global hemos observado cómo la Organización Meteorológica Mundial (OMM) ha ido informando que durante los últimos 22 años se han batido 20 récords de temperatura media. Y que esta tendencia va en aumento: la Tierra acumula 400 meses seguidos de temperaturas superiores a la media histórica, sumando más de 33 años consecutivos por encima de la referencia del siglo XX.

El cambio climático puede considerarse una certeza y ello supone una verdadera amenaza para el mundo que conocemos. Una amenaza que, además, todo indica que ha sido generada principalmente por la actividad industrial humana. El informe especial “Global Warming of 1,5 ºC” del IPCC, publicado a finales de 2018, no da lugar a dudas: estima que esta actividad ha aumentado la temperatura del planeta en aproximadamente 1ºC con respecto a los niveles preindustriales. En unos pocos decenios, la concentración de CO2 en la atmósfera ha aumentado más del 30%, superando los 400 ppm y batiendo el récord datado hace 3 millones de años. No se trata de una evolución natural del clima: la evidencia es abrumadora y el consenso de la comunidad científica es prácticamente unánime.

Sin embargo, así como el cambio climático pasado es avalado por el histórico de datos recogidos a lo largo del último siglo, para conocer el futuro de este no hay observación posible. Si queremos estimar los posibles escenarios a los que se enfrenta nuestro planeta, dependemos casi exclusivamente de modelos de simulación compleja, los cuales están compuestos por un conjunto de submodelos en continuo desarrollo por centros como la NASA, la UK Met Office, o el Beijing Climate Center.

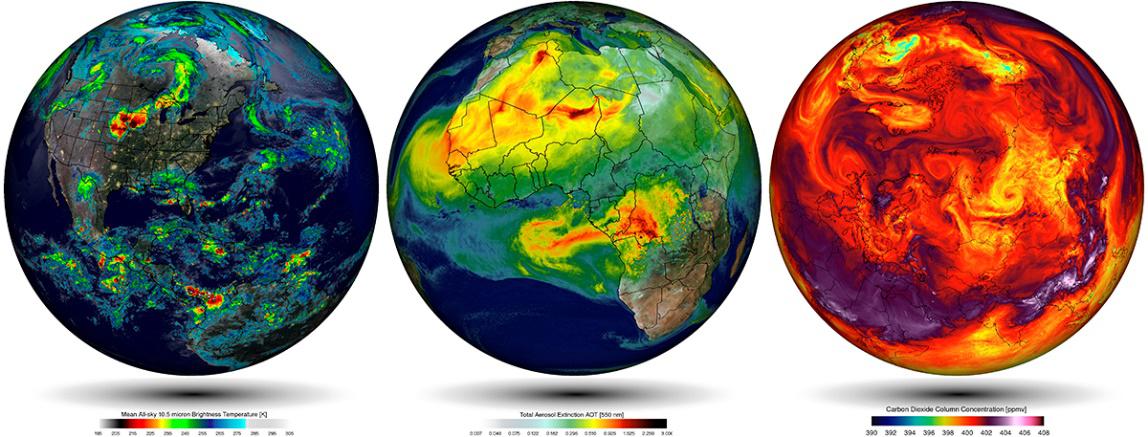

Simulaciones empleando el modelo climático del Goddard Earth Observing System (GEOS-5) de la NASA. Fuente: William Putman, NASA/Goddard

Simulaciones empleando el modelo climático del Goddard Earth Observing System (GEOS-5) de la NASA. Fuente: William Putman, NASA/GoddardEstas simulaciones se rigen por un corpus teórico introducido previamente. Por ejemplo, en el caso de las simulaciones atmosféricas este corpus es construido con (i) las leyes de movimiento de Newton aplicadas en elementos finitos de fluidos, (ii) la ley de la conservación de la masa, y (iii) ecuaciones termodinámicas que permiten calcular el efecto calorífico en cada parcela de aire a través de valores parametrizados de la radiación solar. Estas tres componentes se traducen en ecuaciones diferenciales parciales no-lineales de solución analítica irresoluble, por lo que se aplican métodos numéricos que discretizan las ecuaciones continuas y permiten determinar una aproximación a la solución de estas a través técnicas de modelización y simulación computacional.

En conjunto con otros submodelos, como la simulación del ciclo del carbono o el movimiento tectónico, estas simulaciones se utilizan para construir posibles escenarios futuros, que son una herramienta utilizada para la toma de decisiones en política de mitigación o de adaptación medioambiental, ya sea en forma de monetización del carbón o de aplicación de estrategias de geoingeniería, por ejemplo. Sin embargo, a pesar de que los mecanismos que gobiernan el cambio climático antropogénico son bien entendidos, estas proyecciones presentan incertidumbre en la precisión de sus resultados. Su cuantificación es, precisamente, la principal herramienta para comunicar el (des)conocimiento de expertos a políticos.

La literatura especializada establece hasta siete fuentes de inseguridad epistémica que determinan el grado de incertidumbre: (a) la estructura de los modelos que sólo permiten describir un subconjunto de componentes e interacciones existentes, (b) aproximaciones numéricas, (c) resolución limitada que implica que los procesos de microescala tengan que ser parametrizados y, por tanto, tengan que describir su efecto − sin resolver realmente el proceso− en términos de cuantificaciones disponibles a gran escala, (d) variabilidad natural interna, (e) observación de datos, (f) condiciones iniciales y de contorno, y (g) escenario económico futuro. Todas estas fuentes de incertidumbre se derivan de la existencia de diferentes representaciones del clima para cada uno de los distintos modelos.

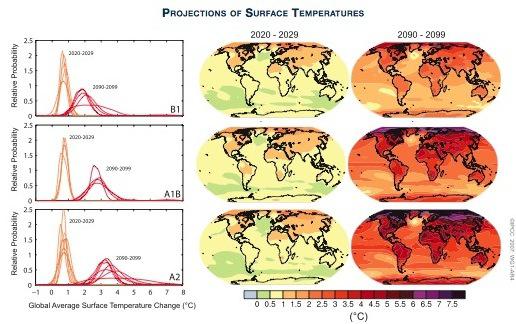

Fuente: Policymaker Summary of The Phisical Science Basis (4th IPCC Report)

Fuente: Policymaker Summary of The Phisical Science Basis (4th IPCC Report)

La primera impresión que genera esta incertidumbre en el público general es que el cambio climático es una hipótesis, de algún modo, incierta. Sin embargo, los modelos de incertidumbre presentados en los sucesivos informes del Grupo I del IPCC no se presentan para dilucidar si el cambio climático es incierto o no, sino para informar de la calidad de los modelos obtenidos y trasladar la toma de decisiones políticas fuera del proceso de obtención de resultados por parte de decenas de miles de científicos.

Parece claro que el futuro no podemos conocerlo a ciencia cierta y, como diría Zygmunt Bauman, la única certeza que tenemos es la incertidumbre. Ello no impide, sin embargo, que podamos estimar de forma más o menos robusta el futuro plausible que nos espera. Por ello, acompañar los resultados de las simulaciones con modelos probabilísticos de incertidumbre no es una muestra de debilidad, sino un instrumento que permite comunicar esas estimaciones de manera transparente, sin comprometer la investigación científica con cuestiones políticas, sociales o éticas. Se trata de una actividad que los científicos y el IPCC consideran como un ejemplo de rigor, a pesar de que haya mercaderes de la duda que la exploten como una debilidad. Y es que la certeza de la incertidumbre en los informes del IPCC consiste, paradójicamente, en que es la única forma disponible para hacer que las proyecciones del clima que nos espera sean lo más certeras posible.

Para saber más:

Winsberg, Eric (2018), Philosophy and Climate Science, New York: Cambridge University Press.

Sobre el autor: José Luis Granados Mateo es investigador predoctoral en Historia y Filosofía de la Ciencia en UPV/EHU.

El artículo La certeza de la incertidumbre en los informes del IPCC se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El clima, los informes y la política

- Migraciones…¿vegetales?

- ¿Una charla? ¿de ciencia?, prefiero el bar…

Zelan eragiten digu klima-aldaketak?

Aspaldi honetan denok sumatu dugu beroaldiak, hezeagoak, luzeagoak eta larriagoak direla. Hauek, klima-aldaketaren ondorioak dira. Beroaldi horiek are eta larriago eragiten diete aire zabalen lan egiten dutenei, kirolariei, haurrei, adinduei eta bihotzeko arazoak dituztenei ere. Baina, zehazki, zein arazo dakar muturreko beroak osasunarentzat?

Maiz egiten diren galderak ataleko bideoek labur eta modu entretenigarrian aurkeztu nahi dituzte, agian, noizbait egin ditugun galderak eta hauen erantzunak. Bideoak UPV/EHUko Kultura Zientifikoko Katedrak eginak daude eta zientzia jorratzen duen Órbita Laika (@orbitalaika_tve) telebista-programan eman dira gaztelaniaz.

The post Zelan eragiten digu klima-aldaketak? appeared first on Zientzia Kaiera.

La enfermedad del hígado graso no alcohólico, una gran desconocida

Jenifer Trepiana, Saioa Gómez-Zorita, María P. Portillo, Maitane González-Arceo

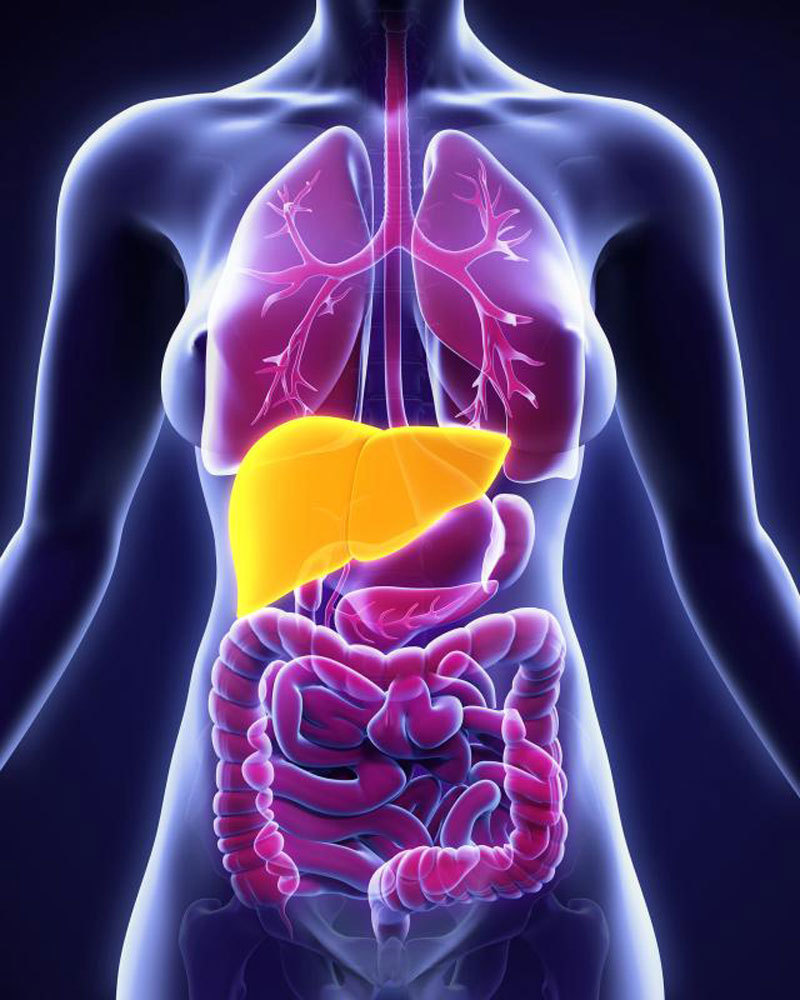

La enfermedad del hígado graso no alcohólico (EHGNA) consiste en una acumulación excesiva de grasa en las células del hígado o hepatocitos (más del 5% del peso del hígado sería grasa) sin un consumo excesivo de alcohol, siendo en la actualidad la causa más frecuente de enfermedad hepática (Ahmed, 2015). Puede presentarse como esteatosis (acumulación de grasa) simple o como esteatohepatitis, situación de mayor gravedad que comporta ya inflamación y un inicio de fibrosis.

La prevalencia de la esteatosis simple oscila entre un 14% y un 30% en la sociedad occidental, aunque es probable que sea mayor ya que como muchos pacientes son asintomáticos, en ocasiones no son diagnosticados (Abd El-Kader SM y El-Den Ashmawy EM, 2015).

¿Cómo se desarrolla la EHGNA?

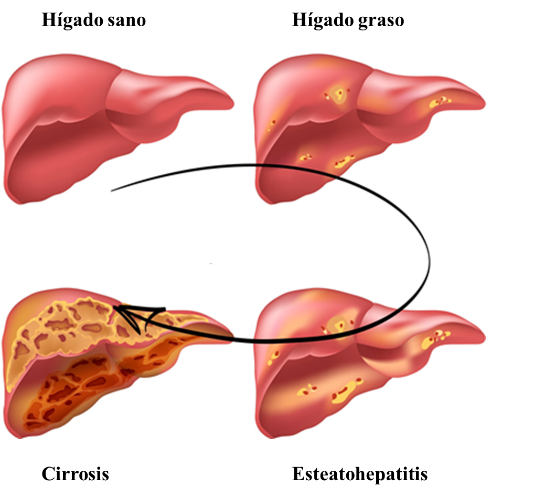

El hígado graso no alcohólico comprende numerosas lesiones hepáticas, comenzando con la esteatosis simple, que supone el 80-90% de los casos. Hay que destacar que el hígado graso no alcohólico se desarrolla de una manera progresiva y lenta, siendo la esteatosis simple reversible, y pudiendo dejar de progresar. Sin embargo, en el 10-20% de los pacientes avanza hasta la siguiente etapa llamada esteatohepatitis o inflamación del hígado. De la misma manera, la esteatohepatitis puede no seguir progresando o, por el contrario, puede evolucionar mediante la aparición de fibrosis a su etapa final, llamada cirrosis, con riesgo de desarrollar carcinoma de hígado en el peor de los casos (Hashimoto et al., 2013).

Lo que ocurre en la esteatosis simple, es que la excesiva acumulación de lípidos en el hígado lo hace vulnerable a otras agresiones como el estrés oxidativo, provocado por un desequilibrio entre los radicales libres y la disponibilidad de antioxidantes, además de promover la liberación de moléculas que producen inflamación provocando esteatohepatitis. En la esteatohepatitis, aparece inflamación y daño en las células de manera crónica que puede cursar con fibrosis (formación excesiva de un tejido llamado tejido conectivo para intentar reparar la víscera). Según estudios científicos, un 41% de los pacientes que sufren la EHGNA desarrollan fibrosis (Ekstedt et al., 2006). Por otra parte, el riesgo de padecer hepatocarcinoma en los pacientes con EHGNA que no sufren cirrosis es mínimo (de 0-3% en 20 años), mientras que en pacientes con cirrosis el riesgo asciende a 12,8% en 3 años (White et al., 2012).

Figura 1. Esquema de los estadios de la enfermedad del hígado graso. Modificado de: Non Alcoholic Fatty Liver Disease NAFLD. Preventicum (2016).

Figura 1. Esquema de los estadios de la enfermedad del hígado graso. Modificado de: Non Alcoholic Fatty Liver Disease NAFLD. Preventicum (2016).Al analizar la morfología del hígado de pacientes que sufren EHGNA tras una biopsia, se observa una acumulación de grasa en las células del hígado (hepatocitos) en forma de triglicéridos. Se ha aceptado que el criterio mínimo para diagnosticar la EHGNA mediante el estudio con microscopía de este órgano, es que el hígado contenga una cantidad mayor al 5% de hepatocitos esteatóticos (Neuschwander-Tetri y Caldwell, 2003), es decir que más de un 5% de las células del hígado contengan una gran cantidad de grasa en su interior. Así, mediante estas técnicas de imagen, se puede clasificar la EHGNA en diferentes tipos, desde una esteatosis simple, hasta esteatohepatitis con o sin fibrosis.

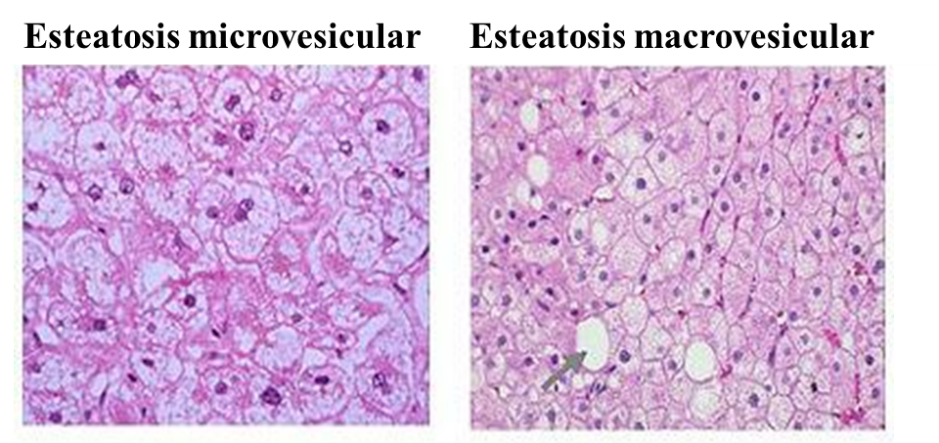

Centrándonos más en lo que le ocurre al hepatocito, podemos decir que normalmente, la esteatosis en el hígado graso no alcohólico, es de tipo macrovesicular. Esto es, que el hepatocito contiene una única gota grande de grasa, o varias gotas de grasa algo más pequeñas, lo que provoca el desplazamiento del núcleo de la célula a la periferia (extremos) del hepatocito. Sin embargo, en la esteatosis de tipo microvesicular, el núcleo se mantiene en el centro del hepatocito con diminutas gotículas de grasa presentes en la célula (Brunt y Tiniakos, 2010). Este último tipo, no suele ser la forma más típica de esteatosis, encontrándose sobre todo en los hepatocitos más pequeños o en los que no se encuentran en las zonas donde la esteatosis es más prominente. Cuando se da esta situación, el paciente suele tener peor pronóstico. En alguna ocasión, también puede ocurrir que se produzca una esteatosis mixta, donde se encuentran hepatocitos con una esteatosis macrovesicular, a la vez que encontramos grupos de hepatocitos con esteatosis microvesicular.

Figura 2. Esteatosis microvesicular y macrovesicular. Análisis mediante técnicas de imagen. Mofrad P, Sanyal, A. Nonalcoholic Fatty Liver Disease. Medscape (2003).

Figura 2. Esteatosis microvesicular y macrovesicular. Análisis mediante técnicas de imagen. Mofrad P, Sanyal, A. Nonalcoholic Fatty Liver Disease. Medscape (2003).

¿Qué factores influyen en el desarrollo de esta enfermedad?

El origen de la EHGNA no está claro, aunque probablemente sea la resistencia a la insulina la causa principal. Otros factores de riesgo asociados con el hígado graso son el sobrepeso y la obesidad, la dislipemia (altos niveles de colesterol y/o triglicéridos en sangre), y la diabetes mellitus tipo 2. Hay que tener en cuenta que la EHGNA afecta a todos los segmentos de la población, no solo a los adultos, y también a la mayoría de los grupos raciales. Se estima que entre el 74% y el 80% de los individuos obesos presentan hígado graso. Además de la obesidad, la presencia de diabetes mellitus tipo 2 incrementa no solo el riesgo, sino también la severidad de la EHGNA (Angulo, 2002). Esto quiere decir, que la diabetes mellitus tipo 2 constituye un perfil metabólicamente desfavorable para los pacientes que presentan EHGNA, aumentando el riesgo de sufrir enfermedades cardiovasculares.

¿Cómo se detecta la EHGNA?

Como hemos indicado al inicio, con mucha frecuencia, la EHGNA cursa de manera asintomática, y cuando produce síntomas estos son bastante inespecíficos. Por ello, muchas veces pasa desapercibida, tanto para los médicos como para los pacientes. El síntoma más frecuente es dolor en la zona abdominal derecha y fatiga.

Para la detección de la EHGNA, primeramente se suelen valorar las transaminasas hepáticas (AST, aspartatoaminotransferasa y ALT, alaninaaminotransferasa), que se suelen encontrar aumentadas. No obstante, aunque los niveles de transaminasas son lo primero que se analiza mediante una extracción de sangre del paciente, no son consideradas buenos marcadores ya que en algunos individuos con esteatosis los niveles de transaminasas en sangre no están elevados, incluso en algunos pacientes con cirrosis tampoco lo están. Además, solo pueden indicar daño hepático en general, no siempre teniendo que ir asociado a la EHGNA. Por otro lado, la AST aparece en otros tejidos como el corazón o el músculo esquelético, por lo que en caso de que se eleve, también puede deberse a una alteración en otros órganos o tejidos. También se recurre a técnicas de imagen para ayudar en el diagnóstico de la enfermedad o para la detección de hepatomegalia (hígado más grande de lo normal), como son la ecografía, TAC (Tomografía Axial Computarizada) o RMN (Resonancia Magnética), siendo esta última la más eficaz en su diagnóstico. Estas pruebas de imagen son útiles para saber si hay infiltración de grasa en el hígado, pero presentan la limitación de que no muestran si el hígado presenta inflamación o fibrosis.

Por ello, el mejor método de diagnóstico es la biopsia, que además permite conocer el grado de EHGNA del paciente. No obstante, dado que se trata de una técnica invasiva, únicamente se suele realizar en aquellos pacientes que muestran signos de estar en un estadio avanzado de enfermedad hepática (por ejemplo, cirrosis) o en aquellos pacientes que presentan mayor probabilidad de esteatohepatitis. Una limitación de esta técnica es que las lesiones hepáticas sufridas no son uniformes en todo el hígado, lo que dificulta el análisis de las biopsias. Es decir, según de qué zona del hígado se tome la muestra, el diagnóstico puede variar.

Ante la necesidad de detectar la EHGNA sin tener que recurrir a la biopsia hepática, se está profundizando en el estudio de biomarcadores para analizar la función hepática de una manera no agresiva para el organismo. Entre ellos encontramos marcadores específicos para la fibrosis, como la medición de concentraciones de proteínas implicadas en la fibrolisis o rotura del tejido fibrótico (colagenasas, α2-macoglobulina, MMPs, C3M) o de proteínas que participan en la fibrogénesis o generación del tejido fibrótico (colágeno tipo IV, pro-C3/C5). En la práctica clínica se suelen utilizar diversos test como el SteatoTest que calcula el grado de esteatosis hepática en pacientes con riesgo metabólico elevado, el FibroTest que valora los niveles de fibrosis y cirrosis, así como el grado de inflamación del hígado, y el NashTest que predice la presencia o ausencia de esteatohepatitis. Los marcadores que se analizan mediante estos tests son la α2-macroglobulina, haptoglobina, apolipoproteína A1, bilirrubina total, ALT, GGT, glucosa en ayunas, triglicéridos, y colesterol. Estos parámetros se ajustan a la edad, sexo, peso y tamaño del paciente. Estos índices y biomarcadores pueden ser útiles no solo para el diagnóstico de la enfermedad, sino también para estudiar la evolución de esta y los efectos del tratamiento.

¿Qué se puede hacer para prevenir la EHGNA?

Es importante remarcar que para la prevención de la EHGNA la principal medida es evitar los factores de riesgo asociados a la enfermedad (obesidad, dislipemia, resistencia a la insulina). Para ello son esenciales una rutina de ejercicio físico en nuestro día a día y llevar una dieta equilibrada.

Tratamientos en la actualidad

Actualmente, no existe un tratamiento específico para la EHGNA. Por ello, lo que se suele hacer es tratar los factores causales, es decir, la obesidad, y otros componentes del síndrome metabólico, como son la hipertensión (mediante el tratamiento farmacológico con estatinas), la diabetes mellitus y la dislipemia. Al igual que en el caso de la prevención, una dieta equilibrada y la actividad física serán los pilares básicos para tratar el hígado graso no alcohólico.

Además, se ha comprobado que seguir un patrón de alimentación mediterráneo se asocia con una menor probabilidad de presentar esteatosis y esteatohepatitis (Aller et al., 2015).

Recomendaciones en el estilo de vida

-

Pérdida de peso: 3-5% en la esteatosis simple y 7-10% en la esteatohepatitis (Jeznach-Steinhagen et al., 2019).

-

Reducción del consumo de hidratos de carbono simples (

-

Reducción de la grasa saturada de la dieta. Una dieta rica en grasas saturadas, intensifica el estrés oxidativo en el organismo, aumentando la inflamación en la zona afectada por la esteatosis. Sin embargo, el consumo de ácidos grasos poliinsaturados del grupo n-3 (omega 3) mejora la esteatosis hepática (Dasarathy et al., 2015).

-

Aumento del consumo de antioxidantes, presentes en altas cantidades en frutas y verduras.

-

Evitar la cantidad de alcohol ingerida. Dado que un abuso del alcohol provoca un desarrollo rápido de la enfermedad, se recomienda la abstinencia del alcohol.

Tratamientos farmacológicos

Como se ha mencionado anteriormente, algunos tratamientos farmacológicos están dirigidos a reducir las enfermedades asociadas al hígado graso, como son la diabetes, obesidad, y desordenes lipídicos.

-

Suplementación con vitaminas, especialmente aquellas que son antioxidantes como la vitamina E (precaución con las dosis elevadas ya que pueden tener efectos secundarios graves). Debido a la dosis empleada la vitamina E o α-tocoferol se incluye dentro de los tratamientos farmacológicos para tratar esta enfermedad.

-

Fármacos antidiabéticos: pioglitazone, rosiglitazona, liraglutide, metformina, etc. (al igual que en el caso anterior pueden tener efectos secundarios).

En la actualidad están siendo probados en diversos ensayos clínicos fármacos novedosos como el agonista del receptor Farnesoil X, o el agonista de PPARα y PPARδ (estudios en fase 2).

Referencias bibliográficas

Ahmed M. Non-alcoholic fatty liver disease in 2015. World J Hepatol. 18;7(11):1450-9 (2015).

Abd El-Kader SM, El-Den Ashmawy EM. Non-alcoholic fatty liver disease: The diagnosis and management. World J Hepatol. 28;7 (6):846-58 (2015).

Hashimoto E, Taniai M, Tokushige K. Characteristics and diagnosis of NAFLD/NASH. J Gastroenterol Hepatol. 28 Suppl 4:64-70 (2013).

Non Alcoholic Fatty Liver Disease NAFLD. Preventicum (2016).

Ekstedt M, Franzén LE, Mathiesen UL, Thorelius L, Holmqvist M, Bodemar G, Kechagias S. Long-term follow-up of patients with NAFLD and elevated liver enzymes. Hepatology. 44(4):865-73 (2006).

White DL, Kanwal F, El-Serag HB. Association between nonalcoholic fatty liver disease and risk for hepatocellular cancer, based on systematic review. Clin Gastroenterol Hepatol. 10(12):1342-1359 (2012).

Neuschwander-Tetri BA, Caldwell SH. Nonalcoholic steatohepatitis: summary of an AASLD Single Topic Conference. Hepatology. 37(5):1202-19 (2003).

Brunt EM, Tiniakos, DG. Histopathology of nonalcoholic fatty liver disease. World J Gastroenterol. 14;16(42):5286-96 (2010).

Mofrad P, Sanyal, A. Nonalcoholic Fatty Liver Disease. Medscape (2003).

Angulo P. Nonalcoholic fatty liver disease. New Engl. J. Med. 346:1221-1231 (2002).

Aller R, Izaola O, Luis DD. La dieta mediterránea se asocia con la histología hepática en pacientes con enfermedad del hígado graso no alcohólico. Nutrición Hospitalaria, 32: 2518-2524 (2015).

Jeznach-Steinhagen A, Ostrowska J, Czerwonogrodzka-Senczyna A, Boniecka I, Shahnazaryan U, Kuryłowicz A. Dietary and Pharmacological Treatment of Nonalcoholic Fatty Liver Disease. Medicina 55, 166 (2019).

Mager D, Iñiguez I, Gilmour S, Yap J, The effect of a low fructose and low glycemic index/load (FRAGILE) dietary intervention on indices of liver function, cardiometabolic risk factors, and body composition in children and adolescents with nonalcoholic fatty liver disease (NAFLD). J. Parenter. Enteral. Nutr. 39, 73–84 (2015).

Dasarathy S, Dasarathy J, Khiyami A, Yerian L, Hawkins C, Sargent R, McCullough A.J. Double-blind randomized placebo-controlled clinical trial of omega 3 fatty acids for the treatment of diabetic patients with nonalcoholic steatohepatitis. J. Clin. Gastroenterol. 49, 137–144 (2015).

Sobre las autoras:

Jenifer Trepiana1, Saioa Gómez-Zorita1,2, María P. Portillo1,2, Maitane González-Arceo1

1 Grupo de Nutrición y Obesidad. Departamento de Farmacia y Ciencias de los Alimentos. Facultad de Farmacia. Universidad del País Vasco (UPV/EHU)

2 Centro de Investigación Biomédica en Red de la Fisiopatología de la Obesidad y Nutrición (CiberObn)

El artículo La enfermedad del hígado graso no alcohólico, una gran desconocida se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Avances contra la enfermedad de hígado graso no alcohólica

- Una ecuación para determinar la grasa en el hígado a partir de una resonancia

- Consolider-Gran Telescopio Canarias: Cómo comunicar Astrofísica

Asteon zientzia begi-bistan #263

Eurasiako sapiens zaharrena identifikatu dute. Grezian, leku berean aurkitutako bi garezur aztertuta, bata duela 210.000 urteko sapiensa, eta bestea 170.000 urteko neandertala direla ondorioztatu dute. Elhuyar aldizkariak azaltzen digunez, lehena, Eurasian aurkitu den sapiensik zaharrena litzateke. Horrek adierazten du modu berean gizaki modernoa uste baino askoz lehenago atera zela Afrikatik. Ikerketa honek zalantzak piztu ditu.

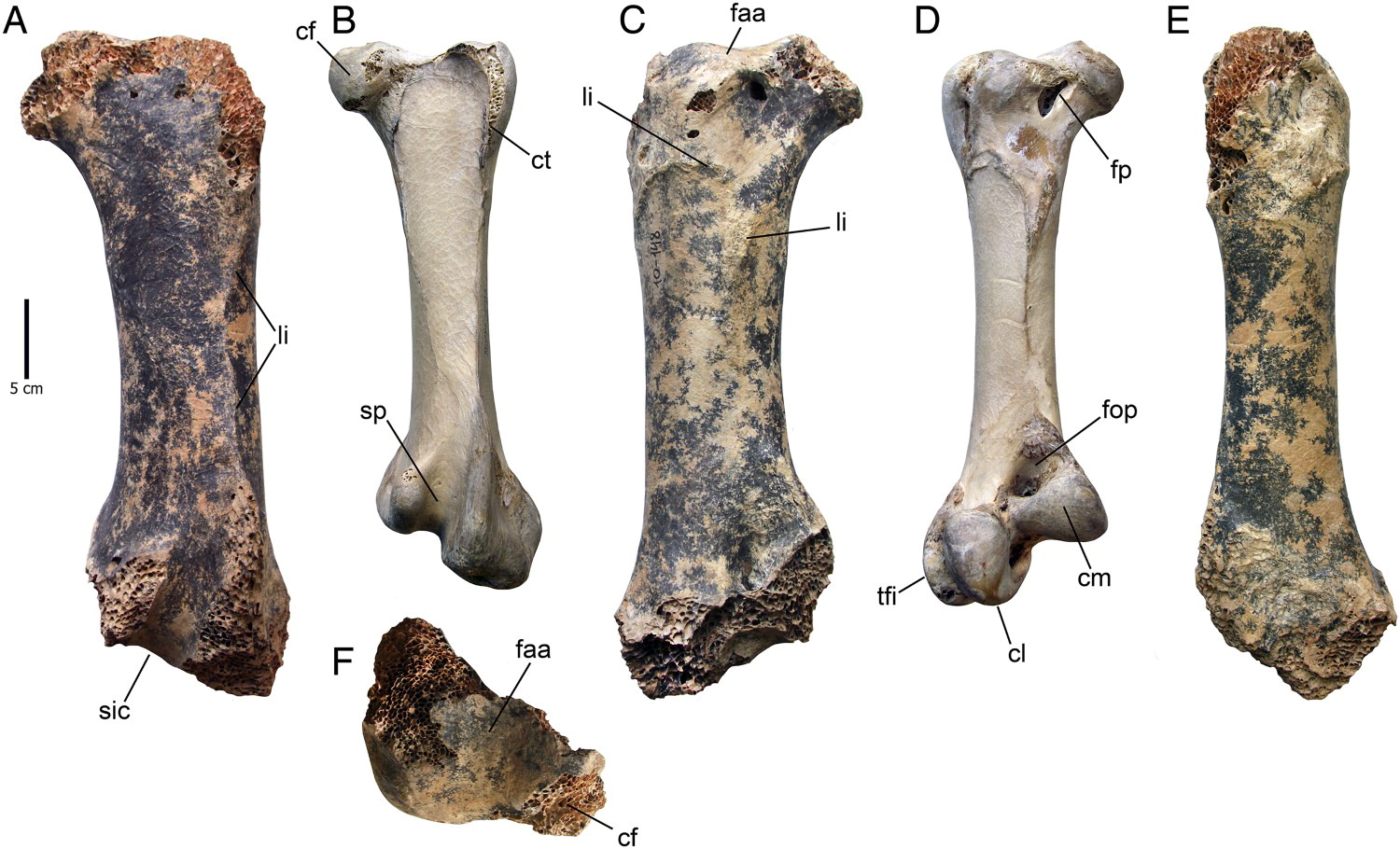

Beste aurkikuntza bat ere izan dugu asteon: Europan inoiz aurkitutako hegazti fosilik handienaren berri eman dute. Paleontologo talde batek ostruka bat baino hiru handil handiagoa zen hegazti bat aurkitu dute; duela 1,5 eta 1,8 milioi urte bitartean kokatu dute fosila, Krimean, eta Europara sartu ziren Homo erectus espezieko lehen hominidoak iritsi zirenean hegazti hori kontinentean zegoela iradoki dute. Aurkitutako fosilean oinarrituta, hegaztia nolakoa izan zen azaldu digute. Juanma Gallego kazetariak eman dizkigu xehetasunak artikulu honetan. Ez galdu!

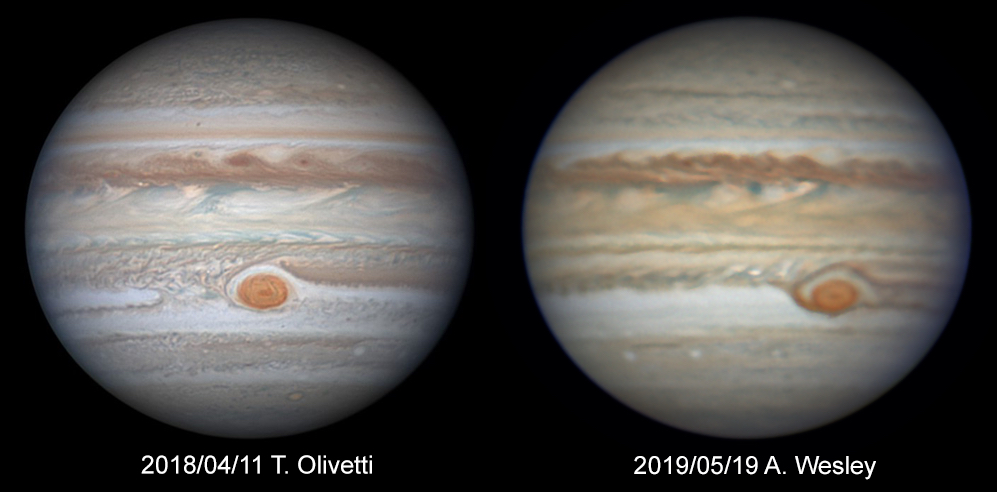

AstrofisikaBadirudi azken asteotan Jupiterren Orban Gorri Handia materia galtzen eta, ondorioz, tamainaz txikitzen ari dela, hau da, orbana desagertzen ari da. Artikuluan azaltzen denez, Orbana oso gune dinamikoan dago. Jupiterren bandak eta zonak korronte atmosferikoen mugak dira, ia denak ekialderanzkoak. Jupiterrerantz begira jarraitu beharko dugu. Zer gertatuko da etorkizunean?

Artikulu honen bidez egileek azaldu dute nola aplikatzen zaien termodinamikaren legeak zulo beltzei. Hasteko zer da termodinamika? Beroaren dinamika aztertzen duen fisikaren adarra da eta lau lege ditu oinarri, XIX.mendean zehar garatu zirenak. Duela 50 bat urte, Einsteinen erlatibitate orokorraren teoriaren arabera, zulo beltzek termodinamikaren legeen pareko legeak betetzen dituztela ondorioztatu zen.

OsasunaFrantziako Osasunaren Goi Agintaritzak argitaratutako txosten batean homeopatia diru publikoz ez laguntzea aholkatu zuen agintaritzak, ez dagoelakoan produktu horiek eraginkorrak direla frogatzen duen oinarri sendorik, eta gobernuak kasu egingo dio. Hortaz, 2021etik aurrera, produktu homeopatikoak diru publikoz ordaintzeari utziko diote. Adierazi dutenaren arabera, prozesua progresiboa izango da: 2020an, kostuen %15 ordainduko ditu estatuak. Berrian informazio guztia.

———————————————————————–

Egileaz: Uxue Razkin kazetaria da.

——————————————————————

The post Asteon zientzia begi-bistan #263 appeared first on Zientzia Kaiera.

El problema de Josefo o cómo las matemáticas pueden salvarte la vida

Imagina que sois 41 soldados, que estáis rodeados y que todo el mundo menos el jefe quiere suicidarse antes que rendirse. En esta tesitura se encontraba Josefo cuando se le ocurrió una forma matemática de salvar su vida. La Ikerbasque Research Fellow Luz Roncal, del BCAM, te lo explica usando magia.

Quizás sea el número más famoso de la historia. Lo cierto es que el número Pi, representado por la letra griega π, es una de las constantes matemáticas más importantes que existen en el mundo, estudiada por el ser humano desde hace más de 4.000 años. La fascinación que ha suscitado durante siglos es tal que el popular número cuenta con su propio día en el calendario, así el mes de marzo se celebra el Día de Pi en todo el planeta.

Este evento internacional vino de la mano del físico estadounidense Larry Shaw, quien lanzó en 1988 la propuesta de celebrar esta efeméride. La forma en la que se escribe el 14 de marzo en inglés y euskera coincide con los tres primeros dígitos de la famosa constante matemática. (3-14 martxoaren 14 en euskara / 3-14 march, 14th en inglés) y además, la celebración coincide con la fecha del nacimiento de Albert Einstein. En 2009, el congreso de EEUU declaró oficialmente el 14 de marzo como el Día Nacional de Pi.

Actualmente, el Día de Pi es una celebración mundialmente conocida que sobrepasa el ámbito de las matemáticas. Este número irracional, que determina la relación entre la longitud de una circunferencia y su diámetro, concierne a múltiples disciplinas científicas como la física, la ingeniería y la geología, y tiene aplicaciones prácticas sorprendentes en nuestro día a día.

Este 2019 nos unimos de nuevo al festejo con el evento BCAM–NAUKAS, que se desarrolló a lo largo del 13 de marzo en el Bizkaia Aretoa de UPV/EHU. BCAM-NAUKAS contó durante la mañana con talleres matemáticos para estudiantes de primaria y secundaria y durante la tarde con una serie de conferencias cortas dirigidas al público en general.

Este evento es una iniciativa del Basque Center for Applied Mathematics -BCAM, enmarcada en la celebración de su décimo aniversario, y de la Cátedra de Cultura Científica de la Universidad el País Vasco.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo El problema de Josefo o cómo las matemáticas pueden salvarte la vida se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Ezjakintasunaren kartografia #270

Harreman sozialak ez dira errazak autismoa duten pertsonentzat. Estimulu sentsorial jakin batzuekin lotuta egon liteke hau. Pertsonen usaina barne. José Ramón Alonsoren Altered responses to social chemosignals in autism

Fermioi astunen egitura kristalinoak ulertzeko efektu garrantzitsua ikustea lortu dute DIPCn. Oso gauza arraroak, baina oso interesgarriak gertatzen dira. First direct visualization by photoemision of how the Luttinger theorem works for Kondo lattices

–—–

Mapping Ignorance bloga lanean diharduten ikertzaileek eta hainbat arlotako profesionalek lantzen dute. Zientziaren edozein arlotako ikerketen azken emaitzen berri ematen duen gunea da. UPV/EHUko Kultura Zientifikoko Katedraren eta Nazioarteko Bikaintasun Campusaren ekimena da eta bertan parte hartu nahi izanez gero, idatzi iezaguzu.

The post Ezjakintasunaren kartografia #270 appeared first on Zientzia Kaiera.

Dinosaurios

La Facultad de Ciencias de Bilbao comenzó su andadura en el curso 1968/69. 50 años después la Facultad de Ciencia y Tecnología de la UPV/EHU celebra dicho acontecimiento dando a conocer el impacto que la Facultad ha tenido en nuestra sociedad. Publicamos en el Cuaderno de Cultura Científica y en Zientzia Kaiera una serie de artículos que narran algunas de las contribuciones más significativas realizadas a lo largo de estas cinco décadas.

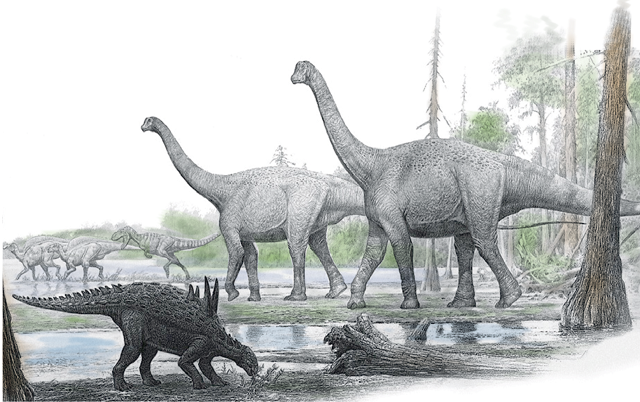

Imagen: Pixabay

Imagen: PixabayLos dinosaurios son un grupo natural de organismos ( o clado), lo que significa que todos ellos comparten un antecesor común. Poseen un conjunto de caracteres anatómicos que permite reconocerlos y diferenciarlos de otros grupos de vertebrados. Por ejemplo, los dinosaurios se caracterizan por presentar un acetábulo perforado, es decir, una cavidad en la pelvis donde se articula la cabeza del fémur (hueso del muslo).

A diferencia de los reptiles actuales, como cocodrilos y lagartos, los dinosaurios no reptaban. Sus miembros estaban dispuestos en posición vertical, de manera similar a los mamíferos. Esto les confería una locomoción más eficaz. Además, poseían un metabolismo elevado y eran animales adaptados a un modo de vida activo.

Gracias a los fósiles conservados en las rocas sabemos que los primeros dinosaurios aparecieron hace unos 230 millones de años, durante el Triásico. A inicios del Jurásico, los dinosaurios pasaron a ser los reptiles dominantes sobre la tierra firme. Se diversificaron durante el Jurásico y el Cretácico [Triásico, Jurásico y Cretácico son las tres divisiones o periodos geológicos que componen la Era Secundaria o Mesozoico]. A finales del Cretácico, hace 66 millones de años, los dinosaurios se extinguieron, junto con otros organismos tanto terrestres como marinos, durante una de las mayores crisis biológicas que ha sufrido la vida en la Tierra. Solo las aves sobrevivieron a la extinción en masa de finales del Cretácico.

Tyrannosaurus, Triceratops, Stegosaurus y Diplodocus son algunos de los dinosaurios más conocidos. Todos ellos eran terrestres. Ningún dinosaurio vivió en el mar. Sólo las aves, que son dinosaurios muy especializados, han adquirido la capacidad de volar. Los dinosaurios desarrollaron una sorprendente diversidad de tamaños, así como una gran disparidad morfológica. Los dinosaurios terrestres más pequeños eran del tamaño de una paloma, mientras que algunos de los saurópodos más grandes medían 30 metros de longitud y se estima que su masa corporal superaba las 50 toneladas, lo que los convierte en los mayores animales que han existido sobre la tierra firme. Había dinosaurios carnívoros, vegetarianos, omnívoros, e incluso insectívoros. Muchos de ellos eran bípedos, otros cuadrúpedos, y algunos podían incluso adoptar ambos tipos de locomoción.

Sin contar las aves, se han descrito más de mil especies de dinosaurios en el registro fósil (conjunto de evidencias conservadas en las rocas) del Mesozoico. Gracias a la labor que realizan los paleontólogos (trabajos de campo, laboratorio y gabinete), cada año se describen de 30 a 40 especies nuevas. Es probable que aún no conozcamos ni la mitad de las especies de dinosaurios que realmente existieron.

Desde que se definieron los primeros dinosaurios hace casi dos siglos hasta la actualidad, su imagen científica ha ido evolucionando con el tiempo. En un principio fueron considerados lagartos gigantescos, más tarde reptiles cuadrúpedos similares a grandes mamíferos, y a finales del siglo XIX se los imaginaba como reptiles-canguros saltadores. Este cambio conceptual en el conocimiento científico sobre los dinosaurios ha tenido reflejo en la iconografía paleontología, así como en la literatura y el cine. Durante mucho tiempo se pensó que eran animales lentos, torpes y estúpidos condenados a extinguirse. El renovado interés por los dinosaurios (“Dinosaur Rennaissance” en inglés), que se inició a finales de la década de 1960 y continúa en nuestros días, se ha materializado en profundos cambios en las ideas sobre su biología, léase anatomía, metabolismo, comportamiento, relaciones de parentesco y pseudoextinción a finales del Cretácico.

Jurassic Park, saga cinematográfica iniciada en 1993, supone el punto álgido de lo que se ha dado en llamar “dinomanía” o pasión popular por los dinosaurios. La película aumentó el interés por los dinosaurios y su investigación científica, despertando muchas vocaciones paleontológicas entre los niños que la vieron, por lo que cabe hablar de una generación “Parque Jurásico”. Hoy en día, la paleontología de los dinosaurios es una disciplina en pleno desarrollo, con muchos especialistas trabajando en el tema, y donde se aplican nuevas tecnologías (por ejemplo, escaneado y modelización en tres dimensiones) que permiten abordar aspectos novedosos de la biología de los dinosaurios. Cabe destacar el carácter multidisciplinar de la investigación actual y la presencia cada vez mayor de mujeres paleontólogas, particularmente en áreas que están experimentando un rápido crecimiento, como la paleohistología (estudio de la microestructura ósea de los organismos del pasado) o la paleontología molecular (estudio de restos orgánicos fósiles). Los resultados de la investigación paleontológica sobre los dinosaurios están a la orden del día. Los debates científicos sobre su origen, su apariencia, el color de su piel o sus plumas, su termofisiología, la causa o causas de su extinción (con excepción de las aves), el origen del vuelo, etc., son temas fascinantes que interesan al público y tienen amplio eco en los medios de comunicación.

Los dinosaurios no solo tuvieron un tremendo éxito evolutivo durante el Jurásico y el Cretácico, sino que algunas formas adaptadas al vuelo como las aves son, con algo más de 10.000 especies, el grupo más diversificado de tetrápodos en la naturaleza actual.

Reconstrucción de un paisaje de finales del Cretácico con la fauna de dinosaurios de Laño (Condado de Treviño). En primer plano, el anquilosaurio enano Struthiosaurus. Detrás, una pareja de Lirainosaurus, titanosaurio definido a partir de los fósiles hallados en este yacimiento. Al fondo, un terópodo persigue a dos ornitópodos. Esta asociación es típica de los yacimientos de dinosaurios del sur de Europa de hace unos 70 millones de años. Ilustración original del paleoartista Raúl Martín coloreada por Gonzalo De las Heras (Diario El Correo), usada con permiso.

Reconstrucción de un paisaje de finales del Cretácico con la fauna de dinosaurios de Laño (Condado de Treviño). En primer plano, el anquilosaurio enano Struthiosaurus. Detrás, una pareja de Lirainosaurus, titanosaurio definido a partir de los fósiles hallados en este yacimiento. Al fondo, un terópodo persigue a dos ornitópodos. Esta asociación es típica de los yacimientos de dinosaurios del sur de Europa de hace unos 70 millones de años. Ilustración original del paleoartista Raúl Martín coloreada por Gonzalo De las Heras (Diario El Correo), usada con permiso.Por último, solemos pensar que el descubrimiento de dinosaurios solo se da en tierras exóticas, cuando en nuestro entorno cercano hay yacimientos paleontológicos de gran relevancia, como es el caso de la cantera de Laño (Condado de Treviño). Este yacimiento es una ventana abierta al mundo de finales del Cretácico, cuando Europa era un archipiélago formado por islas de diferentes tamaños separadas por mares cálidos poco profundos. En Laño se han hallado fósiles pertenecientes a una decena de especies de dinosaurios (incluyendo un nuevo titanosaurio: Lirainosaurus astibiae), junto con otros vertebrados continentales, como peces óseos, anfibios, lagartos, serpientes, tortugas, cocodrilos, pterosaurios y mamíferos. El estudio del yacimiento ofrece información de primera mano sobre cómo eran las faunas de dinosaurios y otros vertebrados continentales hace aproximadamente 70 millones de años.

Para saber más:

S.L. Brusatte, “Dinosaur Paleobiology”, Wiley-Blackwell (2012).

X. Pereda Suberbiola (2018) “Dinosaurios y otros vertebrados continentales del Cretácico final de la Región Vasco-Cantábrica: cambios faunísticos previos a la extinción finicretácica”, en A. Badiola, A, Gómez-Olivencia & X. Pereda Suberbiola, “Registro fósil de los Pirineos occidentales. Bienes de interés paleontológico y geológico. Proyección social”, Servicio Central de Publicaciones del Gobierno Vasco, Vitoria-Gasteiz, pp. 83-98.

Sobre el autor: Xabier Pereda Suberbiola es Doctor en Ciencias Geológicas e investigador del Departamento de Estratigrafía y Paleontología de la Facultad de Ciencia y Tecnología de la UPV/EHU.

El artículo Dinosaurios se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Dinosaurios quijotescos o con nombre de princesa

- Las plumas estaban en los dinosaurios desde el principio

- ¿Se podrían recuperar los dinosaurios como en Parque Jurásico?

Andone Estonba: “Erlerik gabe landareen ugalketa oztopatuta egongo litzateke” #Zientzialari (119)

Gaur egun erleen gainbehera bizitzen ari gara; izan ere, beren habitat naturala murriztuta dago eta beren dibertsitate genetikoa ere galtzen ari da zenbait faktore direla eta. Gure planetan erlerik ez izateak galera handiak ekarriko lituzke ekosistemara eta, nagusiki, landareen ugalketa oztopatuko litzateke.

Egoera horri aurre egiteko bi proiektu jarri dira martxan azken hilabeteotan Europa mailan, bien helburu nagusia bertako erlea kontserbatzea izanik. Proiektu horien baitan, txip bat ere garatu da Europako subespezieak bereizteko.

Europako bi proiektu horietan parte hartu du Andone Estobak, UPV/EHUn Genetikan Katedradunak, eta berarekin hitz egin dugu egungo erleen egoera ezagutzeko eta ikerketa esparru honen erronkak ezagutzeko.

“Zientzialari” izeneko atal honen bitartez zientziaren oinarrizko kontzeptuak azaldu nahi ditugu euskal ikertzaileen laguntzarekin.

The post Andone Estonba: “Erlerik gabe landareen ugalketa oztopatuta egongo litzateke” #Zientzialari (119) appeared first on Zientzia Kaiera.

Ha llegado el final de la cosmética «sin»

Foto: Pixabay

Foto: PixabayDesde el 1 de julio de 2019 ha entrado en vigor una nueva normativa en cosmética que se ha propuesto acabar con la desafortunada estrategia del «sin».

Hay consumidores que no saben qué son los parabenos, pero no los quieren. Desconocen la historia que ha llevado a algunos laboratorios cosméticos a utilizar como reclamo el ‘sin parabenos’, y la consecuencia de esto es que estas sustancias cuyo uso está permitido y es seguro, se perciben como sustancias perjudiciales para la salud. Esto ocurre también con las sales de aluminio de los desodorantes, los sulfatos o con los conservantes, entre otros.

La estrategia publicitaria del «sin» se fundamenta en el miedo. Es lo que los científicos hemos convenido en denominar ‘quimiofobia’, miedo a la química. Funciona porque se sirve de grandes males de la sociedad: la desinformación y la incultura.

La libertad de elegir solo nos la garantiza el conocimiento. Pero cuando el conocimiento requerido es suficientemente profundo, y el caso que nos ocupa lo es, la mejor forma de afrontarlo es tomando medidas que faciliten las elecciones. O al menos, que garanticen que estas elecciones se basan en criterios acertados.

Esa es la razón por la que se ha decidido regular las reivindicaciones de los productos cosméticos. Una historia de reglamentos, informes y documentos técnicos que comenzó en 2009 y que ha llegado hasta nuestros días.

- La historia de cómo se regulan las reivindicaciones de los productos cosméticos

En 2009 se publicó el Reglamento (CE) No 1223/2009. En el artículo 20 sobre «reivindicaciones de producto» es donde por primera vez figuran dos puntos referidos en exclusiva a este asunto:

En el primer punto se dice que en el etiquetado, en la comercialización y en la publicidad de los productos cosméticos no se utilizarán textos, denominaciones, marcas, imágenes o cualquier otro símbolo figurativo o no, con el fin de atribuir a estos productos características o funciones de las que carecen.

En el segundo punto se dice que la Comisión adoptará una lista de criterios comunes para las reivindicaciones que podrán utilizarse en los productos cosméticos. Como muy tarde, el 11 de julio de 2016 la Comisión presentaría al Parlamento Europeo y al Consejo un informe sobre el uso de las reivindicaciones con arreglo a los criterios comunes adoptados. En función de ese informe se crearía un grupo de trabajo para afrontar los problemas observados. Y ese fue el plan que seguimos.

En 2013 se publicó el Reglamento (UE) No 655/2013. Este reglamento tenía como objetivo desarrollar el artículo 20 del R 1223/2009. Aquí se estableció un marco legal con unos criterios comunes basados en la honradez, veracidad e imparcialidad, entre otros.

Finalmente en 2016 se publicó el Informe de la Comisión al Parlamento Europeo y al Consejo sobre las reivindicaciones relativas a los productos basadas en criterios comunes en el ámbito de los cosméticos. El resultado de este informe fue que el 10% de las reivindicaciones sobre productos cosméticos analizadas no se consideraron conformes con los criterios comunes establecidos en el R 655/2013.

Como consecuencia de esto, en 2017 el grupo de trabajo presentó un Documento técnico sobre reivindicaciones de productos cosméticos que incluye 4 anexos. El anexo III se refiere exclusivamente a los cosméticos «sin».

La aplicación de estos criterios sobre los cosméticos «sin» entró en vigor el 1 de julio de 2019. A partir de ese momento está prohibido introducir en el mercado nuevos productos y lotes antiguos que no cumplan con los criterios actuales. Aun así, los lotes de producto que ya estuviesen en el mercado antes del 1 de julio, no serán retirados. Por este motivo, durante un tiempo podremos encontrar productos comercializados que no cumplan la nueva norma. Serán de lotes distribuidos antes del 1 de julio.

Foto: Pixabay

Foto: Pixabay-

Cuáles son los nuevos criterios sobre las reivindicaciones de cosméticos «sin»

Las reivindicaciones «sin» o reivindicaciones con significado similar no deberán de efectuarse en ingredientes cuyo uso está prohibido en productos cosméticos por el R 1223/2009. Por ejemplo, la reivindicación ‘sin corticosteroides’ no debe de estar permitida ya que la legislación de productos cosméticos de la UE prohíbe los corticosteroides.

En caso de reivindicaciones sobre la ausencia de grupos de ingredientes con funciones definidas en el R 1223/2009, como conservantes y colorantes, el producto no debe de contener ningún ingrediente que pertenezca a ese grupo. Si se sostiene como reivindicación que el producto no contiene un ingrediente específico, el ingrediente no debe de estar presente ni liberarse. Por ejemplo, la reivindicación ‘sin formaldehído’ no debe de estar permitida si el producto contiene un ingrediente que libera formaldehído, como por ejemplo la diazolidinil urea.

Las reivindicaciones «sin» no deberán de permitirse cuando se refieran a un ingrediente que no suele usarse en el tipo concreto de producto cosmético. Por ejemplo, ciertas fragancias suelen contener una cantidad de alcohol tan elevada que no es necesario usar conservantes adicionales. En este caso, sería deshonesto resaltar en publicidad el hecho de que cierta fragancia no contiene conservantes.

Las reivindicaciones «sin» tampoco deben de permitirse cuando impliquen propiedades garantizadas del producto, en función de la ausencia de ingredientes, que no pueden darse. Por ejemplo, no está permitida la reivindicación ‘sin sustancias alergénicas/sensibilizadoras’ porque no puede garantizarse la ausencia completa del riesgo de una reacción alérgica y el producto no debe de dar la impresión de que sí.

Las reivindicaciones «sin» dirigidas a grupos de ingredientes no deben de permitirse si el producto contiene ingredientes con funciones múltiples y entre ellas está la función mencionada en la reivindicación «sin». Por ejemplo, no puede usarse la reivindicación ‘sin perfume’ cuando un producto contenga un ingrediente que ejerza función aromatizante en el producto, sin importar sus otras posibles funciones en el producto.

Otro ejemplo de este punto es la reivindicación ‘sin conservantes’. Esta no debe de usarse cuando un producto contenga ingredientes con efecto protector frente a microorganismos, aunque estos no estén incluidos en el anexo V de la lista de conservantes del Reglamento 1223/2009. Este es el caso del alcohol, que puede tener actividad conservante aunque no esté contemplado como tal en la lista del anexo V. Así que, si el alcohol es el que actúa como conservante, está prohibida la reivindicación ‘sin conservantes’.

Con respecto al ‘sin conservantes’ hay alguna excepción demostrable. Si hay pruebas de que el ingrediente concreto o la combinación de dichos ingredientes no contribuye a la protección del producto, podría ser adecuado usar la reivindicación, como por ejemplo, resultados de un challenge test de la fórmula sin el ingrediente concreto.

Las reivindicaciones «sin» no deberán de permitirse cuando impliquen un mensaje denigrante, sobre todo cuando se basan principalmente en una presunta percepción negativa sobre la seguridad del ingrediente o grupo de ingredientes. Por ejemplo, el uso de parabenos es seguro y está permitido. Si se considera el hecho de que todos los productos cosméticos deben de ser seguros, la reivindicación ‘sin parabenos’ no debe de aceptarse, ya que es denigrante para el grupo total de parabenos. Otro ejemplo similar es el del fenoxietanol y el triclosán. Ambos son seguros y su uso está permitido. Por ello, la reivindicación ‘sin’ en dichas sustancias no debe de aceptarse ya que denigra sustancias autorizadas.

Las reivindicaciones «sin» solo deben de estar permitidas cuando facilitan una elección informada para un grupo específico de usuarios. Por ejemplo, está permitido el ‘sin alcohol’ en un enjuague bucal diseñado como producto para la familia. También puede usarse el ‘sin ingredientes de origen animal’ para productos diseñados para veganos. O ‘sin acetona’, por ejemplo en esmalte de uñas, para usuarios que quieren evitar este olor concreto porque les resulta molesto.

-

Conclusión

A partir del 1 de julio de 2019, que es cuando entró en vigor la aplicación de estos nuevos criterios, estará prohibido distribuir los clásicos cosméticos «sin», como el ‘sin parabenos’, el ‘sin sulfatos’, el ‘sin sales de aluminio’ o el ‘sin conservantes’. Ya no se podrá denigrar ingredientes de curso legal, insinuar que son perjudiciales o que hay productos inseguros en el mercado. Es cuestión de semanas que todos estos productos desaparezcan. Que por fin los lineales estén ocupados por productos que se vendan por lo que tienen, no por lo que no tienen.

Si esto pone fin a esa clase de publicidad, a algunos se les acabará el negocio. Quien no tiene nada mejor que vender, venderá miedo. A los que no necesitaban de esa publicidad, ha llegado el momento de vender virtudes.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo Ha llegado el final de la cosmética «sin» se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Los parabenos usados en cosmética son seguros

- Los cosméticos no se testan en animales

- Estimada OCU: recuerda que NO se pueden utilizar las cremas solares del año pasado

Zulo beltzen termodinamika

Termodinamika, bere izenak dioen moduan, beroaren dinamika aztertzen duen fisikaren adarra da. Bere oinarriak lau lege edo printzipio oso bakunetan labur daitezke. Lege hauek zenbakiturik izendatzen ohi dira, zerotik hasita. Zero printzipioak bi gorputzen arteko oreka termikoa definitzen du: tenperatura desberdinetara dauden bi gorputz kontaktuan jarriz gero, euren artean beroa trukatuko dute, biek tenperatura berdina izan arte.

1. irudia: Termodinamikak beroaren transferentzia aztertzen du. Unibertsala denez, edozein sistemari aplika diezaiokegu: bai irakiten

dagoen ur lapiko bati, bai zulo beltzei. (Argazkia: Stanford University)

Lehenengo legea energiaren kontserbazioari dagokio. Beroa, izatez, energia transferitzeko modu bat da. Aurreko adibideko bi gorputz horiek energia trukatuko dute, baina energia osoa konstante mantenduko da prozesu osoan zehar.

Bigarren legea formulatzeko modu ugari daude, baina horretarako entropia (desordena neurtzen duen magnitude fisikoa) erabiltzen da askotan. Bere esanahi fisikoa sistema isolatu batean desordena (entropia) beti handiagotzen doala da. Horrela, aditzera ematen digu espontaneoki zer prozesu gertatzen diren eta zeintzuk ez. Esate baterako, kontaktu termikoa ezarri ondoren, gorputz berotik gorputz hotzera igaroko da beroa beti, eta ez alderantziz. Bestalde, kafeari azukrea botatzen diogunean, pixka bat irabiatu ondoren, disoluzio homogeneo bat eratzen da; nahiz eta denbora asko itxaron, bat batean azukrea ez da kristalduko eta hasierako egoerara itzuliko.

Azkenik, hirugarren printzipioa dugu eta, horren arabera, ezinezkoa da prozesu finituen bidez 0 Kelvin graduko (-273,15 Celsius graduko) tenperaturara iristea.

Lege horiek era enpirikoan garatu ziren batez ere XIX. mendean zehar. Zentzu batean ez dira oinarrizko legeak, ezin baitzaizkie banakako partikula bati aplikatu. Hala ere, fisikaren legeen artean termodinamikaren printzipioek estatus berezia dute, oinarrizkoak ez badira ere. Portaera estatistiko baten ondorioz betetzen direnez, ez dute oinarrizko elkarrekintza partikularrekiko menpekotasunik eta, beraz, euren formulazioa ez da aldatu (eta ustez ez da aldatuko), nahiz eta fisikaren oinarrizko teoriak zeharo aldatu diren azken mendean zehar.

Horrez gain, printzipio horiek unibertsalak direla esaten da oso aplikazio zabalekoa direlako eta izatez, edozein sistema makroskopikoren portaera deskribatzen dutelako. Sistema makroskopiko bat, osagai askoz osaturik dago: banakako elementuak oinarrizko partikulak, atomoak edo molekulak izan ohi dira. Adibidez, lege horiek betetzen dituzte laborategian prestatzen den edozein disoluziok, eguzkiaren barneak edo argiak berak (fotoi askoz osaturiko sistema bezala).

Hala ere, joan den mendeko 70. hamarkadan zulo beltzen termodinamika aztertzen saiatzen ari zirela, zailtasun larriak aurkitu ziren. Zulo beltzak deritzen gorputz astrofisikoak, izarrak kolapsatzean eratzen dira. Bi indarrek eragiten diote izar bati. Alde batetik, bere masak eragindako grabitateak barneranzko indar bat sortzen du, eta bestalde, izarraren barneko presio hidrostatikoak kanporanzko indar bat eragiten du.

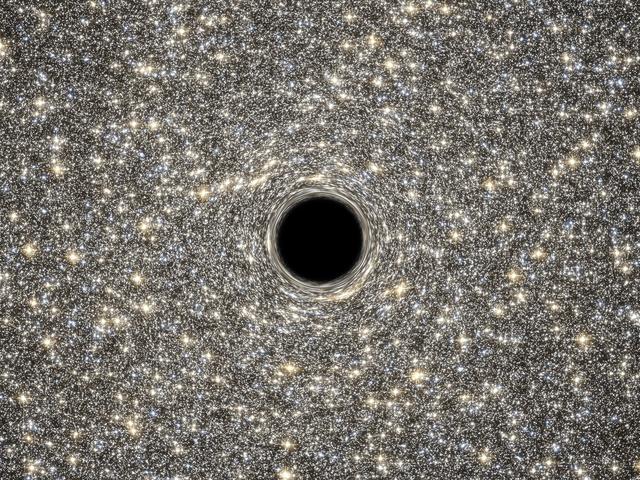

2. irudia: Zulo beltz baten irudikapen artistiko bat. (Argazkia: NASA / Goddard Space Flight Center)

Orekan dagoen bitartean, gaur egun gure eguzkiaren moduan, izarraren barnean erreakzio nuklearrak gertatzen dira, barneko tenperatura oso altu mantentzen da eta ondorioz oso presio handia ekoizten da. Presio horrek grabitatearen indarra deuseztatzen duelarik, izarra egonkor mantentzen da.

Izarren barneko erreakzio nuklear horietan hidrogenoa edo helioa bezalako elementu arinak, astunagoak bihurtzen dira eta soberan dagoen energia argi moduan igortzen dute. Elementu arin horiek agortzen direnean ordea, erreakzio nuklearrak amaitu egiten dira eta izarraren barneko tenperatura eta presioa murriztu egiten dira. Hori gertatzen denean, presioak ezin dio izarraren pisuari eutsi eta izarrak kolapsatu egiten du, eta kanpoko geruza guztiak zentrorantz erortzen dira.

Izarraren masaren arabera, kolapso horretan zehar presio berriak ager litezke (elektroien edo neutroien degenerazioak sortuta). Presio horiek aurka egingo liokete grabitateari, eta ondorioz, kolapsoa gelditu eta izar berri bat (nano zuri edo neutroi-izar izenekoak) eratzen dira.

Izarraren masa oso handia bada ordea, ez dago kolapso hori geldi dezakeen presio ezagunik eta materia guztia zentrora iristen delarik, dentsitate infinituko puntu bat sortzen da. Objektu astrofisiko berri hau zulo beltz bat da. “Zulo” deitzen zaio, zentroko dentsitate infinitu horrek espazio-denbora jarraia zulatzen duelako. “Beltza” esaten zaio bestetik, bere barnean dagoen ezerk ezin duelako ihes egin, ezta argiak ere.

Bere inguruan horizontea deitzen den geruza irudikari bat dago, eta ezinezkoa da kanpotik geruza horren barnean dagoen ezer ikustea. Izatez, geruza hori zeharkatuz gero, ezin izango ginateke kanpora itzuli eta, nahi eta nahi ez, zentroko singularitatean amaituko genuke.

Duela 50 bat urte, Einsteinen erlatibitate orokorraren teoriaren arabera, objektu astrofisiko horiek termodinamikaren legeen pareko legeak betetzen dituztela ondorioztatu zen. Lege horietan grabitatearen azelerazioak tenperaturaren funtzio bera betetzen du, zulo beltzaren masak energiarena eta horizontearen azalerak entropiarena.

Beraz, honela labur ditzakegu zulo beltzek betetzen dituzten printzipioak:

- 0. printzipioa: Grabitatearen azelerazioa horizontean zehar konstantea da.

- 1. printzipioa: Energia kontserbatzen da. Hau da, zulo beltzera zerbait erortzen bada, bere masa eta azalera handituko dira.

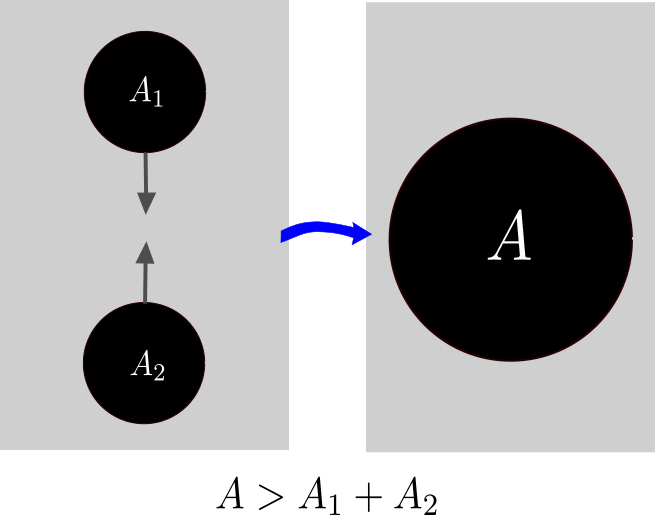

- 2. printzipioa: Edozein prozesutan zehar horizontearen azalera handitzen joango da. Adibidez bi zulo beltzek talka egin eta beste zulo beltz berri bat eratzen badute, amaierako zulo beltzaren azalera hasierako bien azaleren batura baino handiagoa izango da.

- 3. printzipioa: Ezinezkoa da horizonteko grabitatearen azelerazioa zero izateraino murriztea. Alegia, ez dago modurik zulo beltza desagerrarazteko.

3. irudia: Termodinamikaren bigarren printzipioaren arabera, bi zulo beltz elkartzen direnean eratzen duten zulo beltz berriaren azalera hasierako bien azaleren batura baino handiagoa da. (Grafikoa: David Brizuela eta Iñaki Garay)

Orain arte esandakoa analogia bat baino ez da: lege multzo batetik beste batera igaro gaitezke objektuak berrizendatuz. Hurrengo galdera beraz zuzena da: analogia hori soilik matematikoa da edo zentzu fisiko sakonagoa dauka? Hau da, horizonteko grabitatearen azelerazioa eta bere azalera, hurrenez hurren, benetako tenperatura eta entropia bezala uler ditzakegu? Hala balitz, zulo beltzek, erradiazio elektromagnetikoa igorri beharko lukete tenperatura jakin batean dagoen edozein gorputzen moduan.

Izatez, 1974. urtean Hawkingek argudio teoriko bat plazaratu zuen zulo beltzen erradiazioa kalkulatzeko. Hawkingen kalkuluak zentzu fisikoa ematen dio aurreko analogiari. Alegia, jadanik ez da analogia matematiko bat, erlazio fisiko erreala baizik.

Hawkingen erradiazioa kalkulatzeko prozesu zehatza nahiko korapilatsua da eta teoria kuantikoaren oinarriak erabili behar dira. Haatik, era intuitibo batean uler daiteke nola izan daitekeen zulo beltzek erradiatzea. Lehenengo eta behin, esan behar da erradiazioa ez dela zulo beltzetik irteten, espero genuen bezala. Baina zulo beltzak eragiten dio erradiazio prozesu horri. Teoria kuantikoaren arabera hutsa ez dago guztiz hutsik. Heisenbergen ziurgabetasunaren printzipioaren arabera (oinarrizko printzipio kuantiko bat) energiaren kontserbazioaren legea urra daiteke denbora tarte labur batean zehar. Horren ondorioz, partikula bikoteak sortzen eta azkar elkar deuseztatzen ari dira hutsean eten gabe. Prozesu hori zulo beltz baten horizontearen aldean gertatzen bada, partikula bat zulo beltzera eror liteke eta besteak ihes egin lezake. Hori dela eta, zulo beltzaren kanpoan partikula berriak agertuko dira eta, hain zuzen ere, partikula horiek Hawkingen erradiazioa sortuko dute.

Hawkingen erradiazioa azaltzeko, kontuan hartu behar izan ditugu, bai teoria kuantikoa bai teoria grabitatorioa. Beraz, zulo beltz bat ondo ulertzeko bi teoria horiek bateratu beharko genituzke, ondorioz grabitate kuantikoaren teoriari bide emanda. Teoria hori gauzatzea ordea, arazo itzela da. Izan ere, erlatibitate orokorra eta teoria kuantikoa oso formalismo matematiko desberdinekin formulaturik daude eta gainera, euren oinarri fisikoen artean kontraesanak daude. Horren ondorioz, oraindik ez daukagu eskura grabitate kuantikoaren teoria osorik. Azken 50 urteotan proposamen batzuk jorratu dira elkarrekintza grabitatorioa eskala kuantikoan deskribatzeko; esate baterako, soken teoria (string theory) edo kiribilen grabitate kuantikoa (loop quantum gravity). Dena dela, teoria horiek ez daude osorik gauzatuta eta egungo ezagutzaren mugak topatzen ditugu arlo honetan.

———————————————————————————-

Egileez: David Brizuela eta Iñaki Garay UPV/EHUko Zientzia eta Teknologia Fakultateko Fisika Teorikoa eta Zientziaren Historia Saileko ikertzaileak dira.

———————————————————————————-

The post Zulo beltzen termodinamika appeared first on Zientzia Kaiera.

Los ritmos primos de Anthony Hill

El pasado mes de mayo, aprovechando la exposición de la artista Esther Ferrer en Tabakalera (Donostia), Esther Ferrer, 2, 3, 5, 7, 11, 13, 17, 19, 23…, dedicamos dos entradas del Cuaderno de Cultura Científica a su serie de obras Poema de los números primos, en la cual utiliza los números primos como herramienta en el proceso de creación artística:

i) Poema de los números primos

ii) Poema de los números primos (2)

En la entrada de hoy vamos a hablar de otro artista que también ha utilizado los números primos en la creación de una de sus obras de arte, es el artista británico Anthony Hill.

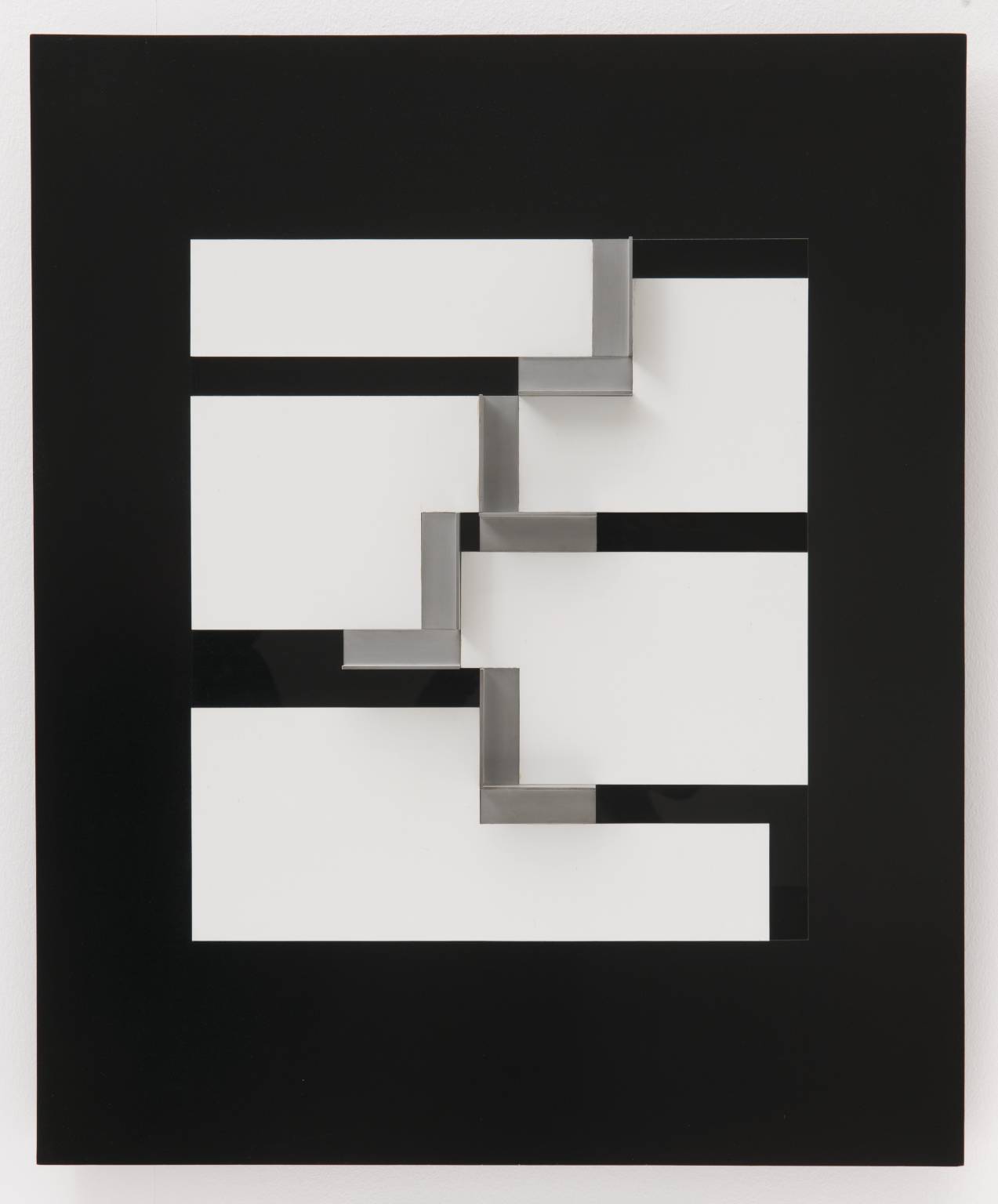

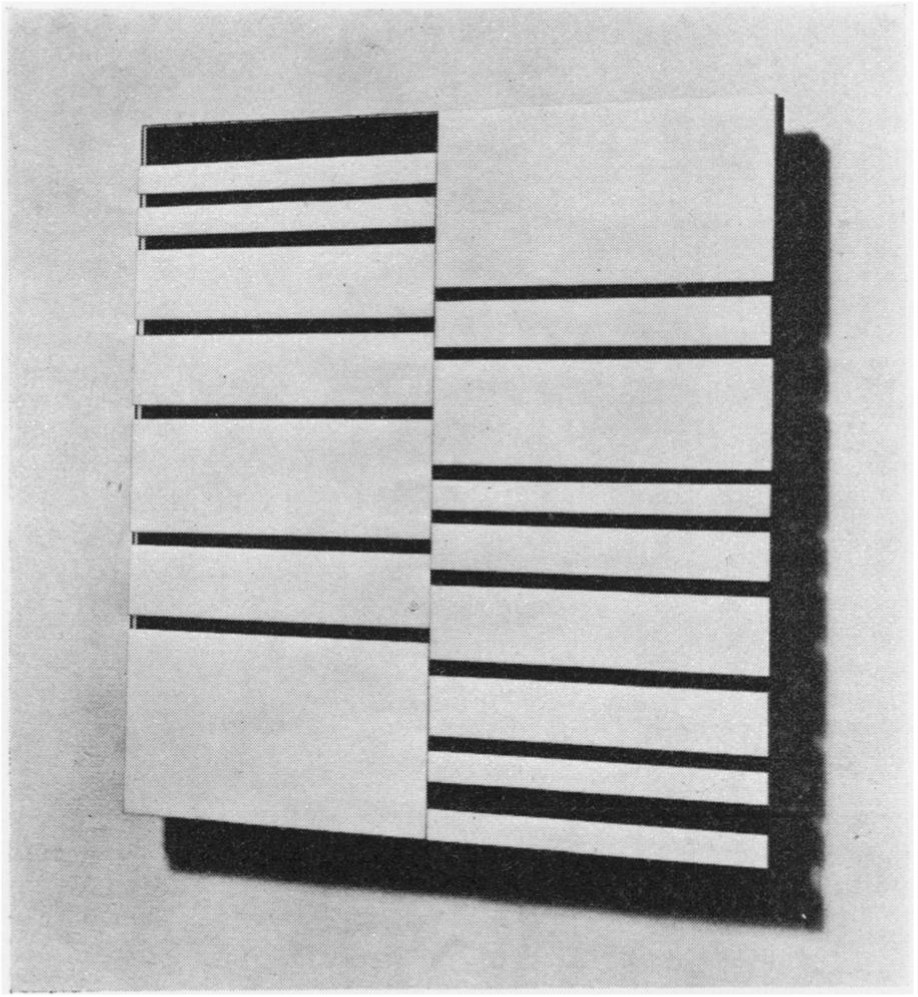

Relief construction (1960-62), de Anthony Hill, obra realizada en aluminio y plástico sobre un tablero de madera, de dimensiones 110 x 91 x 5 cm. Obra e imagen de la Tate Gallery

Relief construction (1960-62), de Anthony Hill, obra realizada en aluminio y plástico sobre un tablero de madera, de dimensiones 110 x 91 x 5 cm. Obra e imagen de la Tate Gallery

Anthony Hill nació en Londres en 1930, formó parte del movimiento artístico de los constructivistas británicos y estuvo relacionado con el Grupo Sistemas. Heredero del arte concreto, Anthony Hill utiliza las matemáticas en el proceso creativo artístico. Tiene un profundo conocimiento de esta ciencia, publicando incluso algunos artículos de investigación matemática, como el artículo On the number of crossings in a complete graph (Proceedings of the Edinburgh Mathematical Society 13, n. 4, p. 333-338, 1963), junto al matemático Frank Harary, o siendo elegido Honorary Research Fellow en el Departamento de Matemáticas del University College de Londres.

La obra que vamos a analizar en esta entrada es Prime Rhythms / Ritmos primos (1959 -1962).

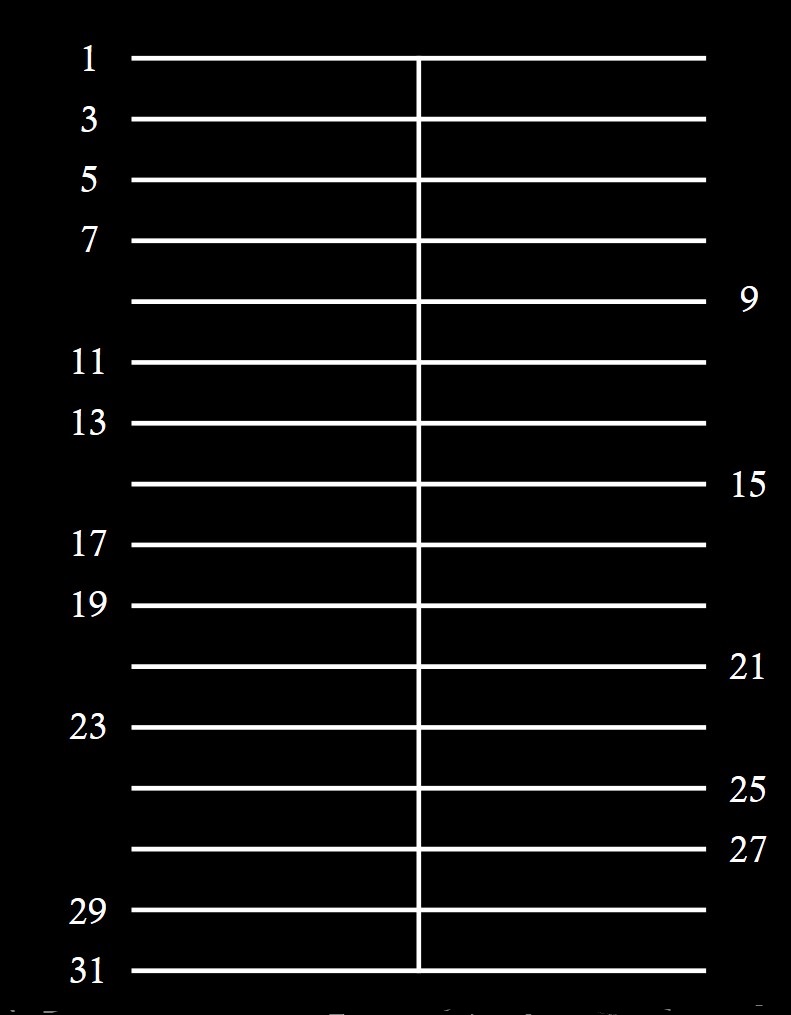

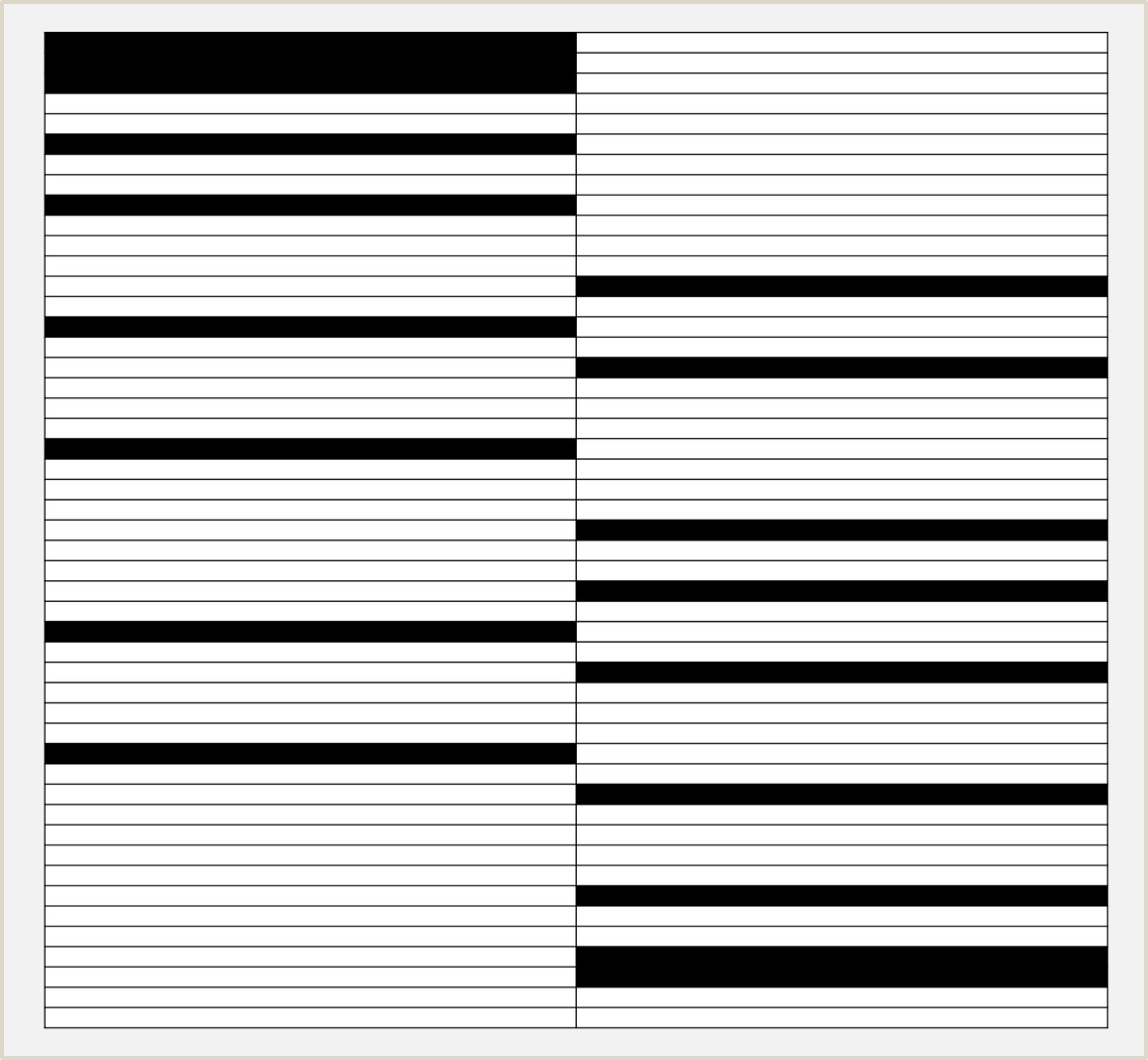

Rhythms / Ritmos primos (1959 -1962), de Anthony Hill, realizada en plástico laminado y de unas dimensiones de 91.5 x 91.5 x 1.9 cm. Imagen del artículo del artista A View of Non-Figurative Art and Mathematics and an Analysis of a Structural Relief

Rhythms / Ritmos primos (1959 -1962), de Anthony Hill, realizada en plástico laminado y de unas dimensiones de 91.5 x 91.5 x 1.9 cm. Imagen del artículo del artista A View of Non-Figurative Art and Mathematics and an Analysis of a Structural ReliefEsta obra está inspirada en los números primos y, más concretamente, en los números primos gemelos. Recordemos que los números primos son aquellos números que solamente se pueden dividir por 1 y por ellos mismos. Así, por ejemplo, el número 30 no es un número primo ya que se puede dividir por 2, 3, 5, 6, 10 y 15, además de por 1 y 30, o tampoco el 33, divisible por 3 y 11, mientras que el número 13 sí es primo, ya que solamente es divisible por el 1 y él mismo, al igual que los números 2, 3, 5, 7, 11, 17 o 19. Por motivos formales el número 1 es considerado no primo en matemáticas, aunque en esta obra Anthony Hill lo va a incluir el en grupo de los números primos.

Lo primero que hace el artista británico es considerar todos los números impares menores que 100 (tengamos en cuenta que los números pares, con la excepción del 2, son siempre compuestos, es decir, no primos) y dividir este grupo en dos subgrupos, los primos y los compuestos. Resulta que hay exactamente la misma cantidad de elementos en cada subgrupo, en concreto, veinticinco.

Números primos impares menores que 100:

1, 3, 5, 7, 11, 13, 17, 19, 23, 29, 31, 37, 41, 43, 47, 53, 59, 61, 67, 71, 73, 79, 83, 89, 97.

Números compuestos impares menores que 100:

9, 15, 21, 25, 27, 33, 35, 39, 45, 49, 51, 55, 57, 63, 65, 69, 75, 77, 81, 85, 87, 91, 93, 95.

A continuación, Anthony Hill toma un cuadrado, considera la línea intermedia y marca 50 líneas horizontales, igualmente espaciadas, de forma que cada una de ellas es un número impar menor que 100, desde el 1 hasta el 99. Aunque cada línea es un número impar, los números impares primos los considera a la izquierda y los números impares no primos a la derecha, como se muestra en la siguiente imagen esquemática de los primeros números.

El siguiente paso fue considerar los números primos gemelos, que son aquellos números primos que están lo más cerca posible (con la excepción del 2 y el 3), es decir, con tan solo un número par entre ellos, como las parejas 11 y 13, 17 y 19, 41 y 43, 59 y 61, 71 y 73. Anthony Hill considera los números primos (impares) gemelos, que además son menores de 100, como se ve en la siguiente imagen, en la parte de la izquierda. Observemos que, al considerar solo números impares, los números primos gemelos son números consecutivos, 1 y 3, 3 y 5, 5 y 7, 11 y 13, 17 y 19, y 29 y 31, en la siguiente imagen.

Por otra parte, Anthony Hill considera los números no primos impares consecutivos, que podríamos denominar ahora “números compuestos impares gemelos”. Como por ejemplo el par 25 y 27, que se puede ver en la parte de la derecha de la imagen, aunque hay más, como 33 y 35.

La siguiente acción es pintar de negro las zonas, o bandas entre líneas paralelas, que se corresponden a números gemelos, para los números primos, a la izquierda, y para los números impares no primos, a la derecha, y las demás bandas de color blanco. Podemos apreciar la construcción en la siguiente imagen.

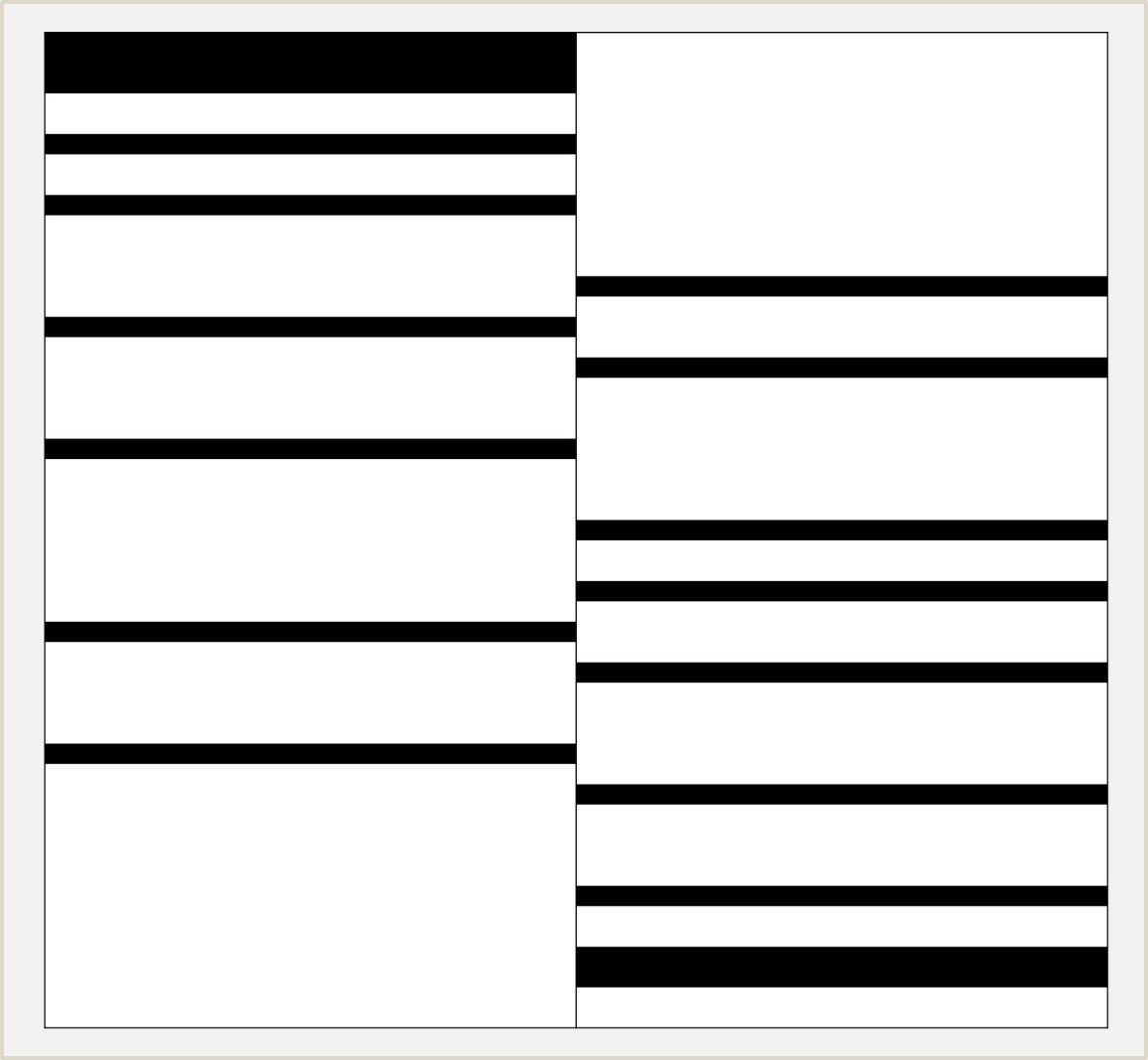

Por lo tanto, sin marcar la separación entre las zonas que hemos realizado en el anterior esquema explicativo, podemos realizar la siguiente recreación de la obra Prime Rhythms / Ritmos primos de Anthony Hill.

Recreación de la obra Prime Rhythms / Ritmos primos (1959 – 1962), de Anthony Hill, realizada por mí mismo, Raúl Ibáñez

Recreación de la obra Prime Rhythms / Ritmos primos (1959 – 1962), de Anthony Hill, realizada por mí mismo, Raúl IbáñezTerminamos la entrada mostrando una obra de Anthony Hill relacionada con los grafos, The Nine – Hommage à Khlebnikov / El nueve, homenaje a Khlebnikov (1976).

The Nine – Hommage à Khlebnikov / El nueve, homenaje a Khlebnikov (1976), de Anthony Hill, realizada en plástico laminado, con un tamaño de 91.5 x 91.5 x 1.9 cm. Imagen del artículo del artista A View of Non-Figurative Art and Mathematics and an Analysis of a Structural Relief

The Nine – Hommage à Khlebnikov / El nueve, homenaje a Khlebnikov (1976), de Anthony Hill, realizada en plástico laminado, con un tamaño de 91.5 x 91.5 x 1.9 cm. Imagen del artículo del artista A View of Non-Figurative Art and Mathematics and an Analysis of a Structural ReliefBibliografía

1.- Anthony Hill, A View of Non-Figurative Art and Mathematics and an Analysis of a Structural Relief, Leonardo, Vol. 10, No. 1, pp. 7-12, 1977.

2.- Alan Fowler, A Rational Aesthetic. The Systems group and associated artists, Southampton City Art Gallery, 2008.

3.- Michael Holt, Mathematics in Art, Littlehampton Book Services, 1971.

4.- Raúl Ibáñez, Las Matemáticas como herramienta en la creación artística (conferencia), Curso de verano de la UPV/EHU, “Cultura con M de matemáticas, una visión matemática del arte y la cultura”, 2019.