Dietas de adelgazamiento

La Facultad de Ciencias de Bilbao comenzó su andadura en el curso 1968/69. 50 años después la Facultad de Ciencia y Tecnología de la UPV/EHU celebra dicho acontecimiento dando a conocer el impacto que la Facultad ha tenido en nuestra sociedad. Publicamos en el Cuaderno de Cultura Científica y en Zientzia Kaiera una serie de artículos que narran algunas de las contribuciones más significativas realizadas a lo largo de estas cinco décadas.

Todos hemos oído hablar de ellas. La del Dr. X, la del Dr. Y, la del pomelo, la del pepino… La lista sería interminable. Todas garantizan una rápida pérdida de peso sin ningún sacrificio. Por supuesto, el que haya tantas “dietas milagro” tiene una explicación sencilla: son todas falsas.

Foto: Jan Sedivy / Unsplash

Foto: Jan Sedivy / Unsplash

¿Por qué fallan? Hay dos motivos por los cuales las “dietas milagro” no funcionan nunca. Uno es que, muchas veces, las dietas no tienen ningún fundamento racional: es como si quisiéramos curarnos el dolor de muelas subiendo en el ascensor tres veces al tercer piso, en jueves. El segundo es que, otras tantas veces, aun cuando a largo plazo pudieran funcionar, son tan poco apetecibles que nadie es capaz de mantenerlas por mucho tiempo.

El negocio del sobrepeso. El abandono de las dietas estrafalarias me lleva a otro tema muy relacionado: el negocio (fraudulento) del adelgazamiento. Vivimos en una sociedad en la que uno puede ser cualquier cosa… menos gordo. La publicidad, dirigida sobre todo a adolescentes, se encarga de recordárselo a todas horas. Se forma así un círculo diabólico en el que: (a) con razón o sin ella, uno se ve gordo, (b) comienza una dieta que no la soportaría Robinson Crusoe aunque no tuviera otra comida en su isla, (c) la abandona, por razones obvias, y (d) se culpabiliza por su “falta de voluntad”. Hemos pasado de tener un supuesto sobrepeso a tener una bonita combinación de sobrepeso y falta de autoestima: gran éxito. Pero, claro está, ésta es la base, más bien el círculo vicioso, en el que se apoya el mercado multimillonario derivado de supuestas obesidades y muy humanas debilidades.

¿Es malo estar gordo? Desgraciadamente, el negocio fraudulento del adelgazamiento tiene bastante razón en una cosa: la obesidad es una enfermedad, y es un agente que causa o empeora otras enfermedades. Ahora bien, todo es cuestión de grados, no es lo mismo un sobrepeso ligero que una obesidad mórbida, y cuál sea nuestro problema concreto lo podemos averiguar fácilmente midiéndonos en casa y pesándonos en una farmacia. Y el principal problema de la obesidad no es que nos vaya a quedar mal el traje de baño en la playa.

¿Por qué hay tantos gordos? Los biólogos suelen decir que en biología nada se entiende si no es a la luz de la teoría de la evolución. La obesidad no es una excepción. Desde que la vida existe sobre la tierra (unos 4.000 millones de años) el alimento ha sido la principal limitación para el crecimiento de las especies. En otras palabras, de toda la vida, lo normal ha sido pasar hambre. Sólo hace unas pocas generaciones (¿100 años?) en una región privilegiada del planeta, el llamado primer mundo, se da el fenómeno inaudito de una población que, en el caso de los humanos, tiene asegurada una comida caliente tres veces al día. Hasta ahora, se comía cuando había, que eran pocas veces. En esas condiciones sobrevivían los que, por azar, llevaban los genes que les permitían almacenar energía en forma de grasa cuando comían. Hoy, la inmensa mayoría de los miembros de nuestra sociedad actual son herederos de aquéllos supervivientes, y mantienen intactos sus genes almacenadores de grasa. Ésta es la sencilla verdad, no hay que darle más vueltas al asunto y, sobre todo, no hay que culpabilizarse.

Cambiar de vida. Si, primero, objetivamente necesitamos adelgazar, y, segundo, queremos hacerlo, no nos basta con seguir una u otra dieta. Nuestra tarea es mucho más difícil: tenemos que luchar contra nuestros genes. Tenemos que corregir una deriva de millones y millones de años de evolución. ¿Es imposible? No, pero hay que acertar con la dieta. Para los antiguos griegos, la dieta no era sólo un régimen de comidas, sino todo un sistema de vida. Eso es lo que tenemos que hacer para adelgazar, seguir la dieta adecuada, y no solo la de comidas. Y así, no esperaremos adelgazar en un mes, ni en tres. Todo esto es un proceso a largo plazo. Un objetivo razonable es perder un kilo al mes. Al cabo de un año, serán doce kilos, que no está mal.

Adelgazamiento y termodinámica. La termodinámica es una parte importante de la física, pero la verdad es que se puede entender bastante bien si uno se la imagina como una especie de contabilidad, solo que, en vez de ser una contabilidad de euros, es una contabilidad de calorías. Para entender esta analogía, hay que imaginar nuestro cuerpo como una libreta de ahorros, solo que la cuenta no está en euros, sino en calorías. Y, cosa rara, queremos tener cada vez más euros, pero cada vez menos calorías. Salvando esto, el mecanismo es el mismo. Para tener muchos euros, debemos ingresar mucho, y/o sacar poco. Para tener pocas calorías, debemos sacar muchas, y/o meter pocas. Es igual que metamos cien euros por la mañana o por la noche. En billetes de veinte, o de diez. Es igual que los saquemos en día par o impar. A fin de mes, el estado de nuestra cuenta dependerá de la suma de los ingresos menos la suma de los gastos. Y de nada más. En física, esto se llama el “primer principio de la termodinámica”, y es una ley que no conoce excepción alguna. Así pues, olvídese el lector de desayunar mucho o poco, comer más que cenar o viceversa, una comida o cinco, etc. Solo cuenta el saldo de la libreta a fin de mes.

La dieta. No digo “una dieta”, ni “las dietas”, digo “la dieta”. Con pequeños ajustes, como es natural, pero “la dieta”. Y, ¿en qué consiste esa dieta tan universal? Pues, en comer menos. Bastante menos, e incluso mucho menos. Ojo: aquí no se engaña a nadie, ya hemos dicho que para adelgazar (permanentemente, aquí no estamos hablando de la Operación Bikini), hay que CAMBIAR DE VIDA. Y lo esencial en esa nueva vida es comer significativamente menos. Por poner una cifra, variable según los casos, un 40% menos. No menos de unas cosas, o de otras, sino menos de todo. Bueno, dirá el lector, también podré seguir empapuzándome si de una vez me pongo a hacer ejercicio. Pues, no señor. No tenemos hueco aquí para explicar los detalles, o más bien para hacer las cuentas de la termodinámica del ejercicio, pero algo así como una hora diaria de ejercicio moderado (que es el objetivo realista cuando es para toda la vida) no va a aumentar significativamente el número de calorías que salen de la hucha. Paradójicamente, los buenos dietistas saben que el ejercicio es esencial en el adelgazamiento, pero no tanto por la energía que consume sino por los efectos relajantes sobre el organismo, que compensan el stress de la restricción calórica. En fin, por si no quedaba claro, comer menos y hacer más ejercicio. No queda otra.

A mí no me funciona. Pues algo falla con Vd., y ese algo no es el primer principio de la termodinámica. A ver si lo hemos entendido. Si Vd. come menos (no un poco menos) y hace ejercicio (nada del otro jueves), va a adelgazar. Y si no adelgaza, tendrá que comer aún menos. Tenga la completa seguridad de que su sobrepeso, no digamos obesidad, se debe exclusivamente a que come mucho más de lo que necesita.

Por supuesto que el procedimiento es costoso. Pero piense en dos cosas. La primera, es el ÚNICO modo de adelgazar. Y la segunda, mucho antes de lo que se piensa, quizá en unas pocas semanas, Vd. se habrá habituado a su nueva vida, y no le costará nada mantenerla. Y al cabo de seis meses, o de un año, comprobará que el esfuerzo ha valido la pena. ¡ÁNIMO!

Pues Fulanito come como una lima, y no engorda. La vida es injusta, a veces. El pobre Fulanito carece de los genes de almacenamiento de grasas. Si se embarcan Fulanito y Vd., y su balsa se extravía en el océano, y se pasan dos meses a la deriva, lo probable es que sólo sobreviva uno de los dos, y, créame, salvo antropofagia, el superviviente no será Fulanito, sino Vd., y sin sus lorcitas.

Sobre el autor: Félix M. Goñi es catedrático en el Departamento de Bioquímica y Biología Molecular de la Facultad de Ciencia y Tecnología de la UPV/EHU.

El artículo Dietas de adelgazamiento se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La adherencia, clave en el seguimiento de las dietas

- Las dietas detox ni desintoxican ni adelgazan

- 50 años de secretos: la era de la criptografía moderna

Donna Strickland (1959): Magia egin zuen laser-zalea

Strickland zientzian murgildu zen zerbait “dibertigarria” egin nahi zuelako eta orain laserren fisikaren arloan aitzindaria da. Aipatu moduan, iaz irabazi zuen Fisikako Nobel saria, Arthur Ashkin eta Gérard Mourourekin batera “egindako aurrerapen iraultzaileengatik”. Suediako Akademiak jakinarazi zuenez, zehazki intentsitate handiko pultsu ultramotzak sortzeko teknika asmatzeagatik saritu zituzten Monrou eta Strickland. Egun, teknika hori baliagarria da medikuntzan eta zientzia ikerketa askotan; ikusmena hobetzeko laser bidezko ebakuntzetan erabili ohi da, esaterako.

1. irudia: (CC BY-SA 4.0 lizentziapean)

1985ean argitaratu zuen Nobel sarira eraman zuen artikulua, bere doktore tesiaren oinarria izan zena –Mourou haren tesi-zuzendaria izan zen–. Laserraren munduan lan egin duten ikertzaileek beti izan dute jomuga intentsitate handiagoko pultsuak lortzea eta bazirudien 80ko hamarkadan mugara iritsi zirela. Izan ere, intentsitatea handitzen saiatzen zirenean, material anplifikatzailea suntsitzen zen. Arazo hori konpontzeko asmoz, Stricklandek eta Mourouk teknika berri bat garatu zuten, CPA (ingelesez Chirped Pulse Amplification) izenekoa. Zertan zetzan, baina? Teknologia berri horrek pultsua denboran laburtu egiten zuen –potentzia maximoa murrizteko–, geroxeago anplifikatzen zuen eta, azkenik, konprimitzen zuen. Badirudi ideia Mourourena izan zela baina Stricklandek bihurtu zuen errealitate. Publikatutako bere lehenengo artikulu zientifikoa izan zen.

Gabonetako zuhaitzaren antzeraDonna Strickland fisikariari (1959, Kanada) txikitatik interesatu zitzaizkion laserra eta elektrooptika alorrak eta horregatik ikasi zuen Ingeniaritza Fisikoa, McMaster Unibertsitatean. Bere klasean, 25 ikasletik soilik hiru ziren emakumeak. Strickland matematiketan eta, oro har, zientzietan ona zen. Behin baino gehiagotan bere aitak galdetu zion ea astronauta izan nahi zuen, baina Donnak ezetz erantzuten zion, klaustrofobikoa baitzen: espaziora joatea amesgaiztoa izango zen harentzat. Orduantxe ikusi zuen laserrak izango zituela bidelagun. Hala, Strickalndek kontatzen du laserrak ikertzen dituen laborategi batean lehen aldiz sartu zenean, Gabonetako zuhaitz bat imajinatu zuela, hainbeste kolore ikusi zituenean: “Beti liluratu nau koloretako laserrekin jolasteko aukera izateak”. Harentzat, laserraren munduan lan egitea magia egitea bezalakoa zen.

Gradua amaitu zuenean, doktoregoa egin zuen Rochesterko Unibertsitatean. Mourou fisikaria izan zuen gidari bere tesian eta, Stricklandek gogoratzen duen moduan, ez zen lan erraza izan. Ikerketak arazo handiak planteatzen zituen, hainbeste galdera oraindik erantzun gabe, baina bakarra zuen buruan bueltaka: nola anplifikatu dezakegu laserraren potentzia material anplifikatzailea suntsitu gabe? Lanak berak (Development of an ultra-bright laser and an application to multi-photon ionization) eman zion erantzun iraultzailea: CPA teknika.

2. irudia: Fortune Global Forum 2018 October 15th, 2018 Toronto, Canada (Argazkia: Stuart Isett/Fortune – CC BY-NC-ND 2.0 lizentziapean)

Doktoregoaren ondotik, hainbat lan izan zituen: lehenik, ikertzaile laguntzailea izan zen Kanadako Ikerkuntza Nazioarteko Batzordean, Fenomeno Ultrabizkorren Sailean. Ondoren, Lawrence Livermore Nazioarteko Laborategian aritu zen. Horretaz gain, Princeton Unibertsitatean lan egin zuen eta egun irakaskuntzan zein ikerkuntzan dabil lanean, Waterlooko Unibertsitateko Fisika eta Astronomia Departamentuan. Bertan, irakaslea eta ikerketa-talde baten zuzendaria ere bada; Ultrafast Laser Group Laborategia gidatzen du, hain zuzen. Bertan, intentsitate handiko laser ultrabizkorren teknika desberdinak ikertzen ditu. Gainera, laserrek lente mota desberdinei nola elkar eragiten dieten ikertzen du.

Zenbait sari zientzialariarentzatIrabazi dituen sarien artean, Nobelaz gain, aipagarriak dira Premier’s Research Excellence saria (1999) eta urtebete geroago lortutako Cottrell Scholars saria. Horretaz gain, Estatu Batuetako Optika Elkarteko (OSA ingelesez) kide izendatu zuten 2008an. 2011n bertako lehendakariordea izan zen, eta 2013an, lehendakaria. Elkarteko Optics Letter aldizkariko gai-editore ere izan zen. Gaur egun, Aholkularitza Batzordeko burua da bertan.

Urte asko igaro dira emakume batek Fisika arloan halako sari garrantzitsu bat lortu zuenetik, 117 zehazki. Oso albiste pozgarria izan zen guztiontzat Akademiak saridunak jakinarazi zituenean, baina Donna Stricklandek ez dio generoari begiratu nahi kasu honetan, izan ere, eta askotan azaldu duen moduan, “nik zientzialari gisa ikusten dut nire burua eta ez Zientzian dabilen emakume gisa”.

Iturriak:

- BBC: Quién es Donna Strickland, la primera mujer en ganar el Nobel de Física en 55 años.

- Elhuyar aldizkaria: Fisikako Nobel saria, laserraren fisikan ekarpen iraultzaileak egin zituztenentzat.

- El Mundo: Donna Strickland, tercera científica que gana el Nobel de Física en 117 años

- The Globe and Mail: Canada’s newest Nobel Prize winner, Donna Strickland, ‘just wanted to do something fun’.

- The Nobel Prize: Donna Strickland.

———————————————————————–

Egileaz: Uxue Razkin (@UxueRazkin) kazetaria da.

———————————————————————–

The post Donna Strickland (1959): Magia egin zuen laser-zalea appeared first on Zientzia Kaiera.

Cómo nos ayuda la ciencia a tomar decisiones correctas

![]()

Jose Luis Arroyo Barrigüete y Francisco Borrás Palá

Unsplash, CC BY-SA

Unsplash, CC BY-SAImaginemos que, tras diez años trabajando en una empresa, otra compañía nos llama y nos hace una oferta de trabajo. Esta tiene ventajas respecto a nuestras condiciones actuales pero, como en toda decisión, hay riesgos asociados a la incertidumbre. ¿Me llevaré bien con los compañeros? ¿Tendré una buena relación con mi nuevo jefe? ¿Encajaré en la cultura corporativa de esta compañía?

Ahora supongamos que alguien nos dijera cuál es la probabilidad que tenemos de equivocarnos. Por ejemplo que, en caso de aceptar la oferta, tenemos una probabilidad del 0,7 % de estar tomando la decisión incorrecta. Dicho de otra forma: tenemos un 99,3 % de probabilidad de tomar la decisión adecuada. En estadística, a esto lo llamamos p-valor.

En ciencia es muy frecuente utilizar el contraste de hipótesis. La idea es partir de una hipótesis nula (H₀), que no es sino el statu quo, la situación actual. En nuestro ejemplo, permanecer en la empresa en la que estamos. Frente a ella se contrasta la hipótesis alternativa (H₁), es decir, una idea contraria a la anterior. En nuestro caso, cambiar de trabajo.

Si encontramos una fuerte evidencia empírica en contra de la hipótesis nula, decimos que la rechazamos y, por tanto, aceptamos la alternativa. Siguiendo con nuestro ejemplo, esta evidencia sería lo que yo pudiera llegar a saber, después de investigarlo, sobre las mejores condiciones de trabajo que nos ofrecen.

Pero, ¿qué significa “fuerte evidencia empírica”? Para responder a esa pregunta, tenemos un concepto muy útil llamado p-valor. Este es la probabilidad que tenemos de equivocarnos si rechazamos la hipótesis nula con la información (evidencia empírica) de la que disponemos.

Cuanto más pequeño sea el p-valor, más improbable es que nos estemos equivocando al rechazar la hipótesis nula. Dicho de otro modo, más probable es que estemos acertando. En nuestro ejemplo, cuanto más pequeño sea el p-valor, más probable es que cambiar de trabajo sea una decisión adecuada.

Entonces, ¿qué p-valor necesitaría yo para cambiar de trabajo? ¿Cuánto riesgo estaría dispuesto a asumir? ¿Un 10 %? ¿Quizá un 5 %? ¿O se sentiría más cómodo con un 1 %? Estos son, de hecho, valores típicos usados en ciencia. Usaremos uno u otro en función del riesgo que estemos dispuestos a asumir.

Estos porcentajes son valores subjetivos que dependen del individuo que toma la decisión y de las consecuencias de la misma. En cambio, el p-valor es un dato objetivo que calculan todos los programas informáticos de estadística a partir de los datos de una muestra. Aparece de forma mágica como un resultado, aunque detrás hay un proceso de cálculo.

Si el p-valor se encuentra por debajo del nivel de riesgo, rechazaremos H₁. De hecho, los ordenadores habitualmente facilitan todavía más la decisión poniendo un asterisco al lado del p-valor si es menor que el 10 %, dos si es menor que el 5 % y tres si es menor que el 1 %.

En nuestro ejemplo de la oferta de trabajo, con un p-valor del 0,7 % los tres asteriscos nos dejarían bastante tranquilos respecto a aceptar la propuesta, salvo que seamos de esas personas que no se arriesgan nunca.

En el año 2314…

Ana sale de casa con sus gafas cuantrónicas de realidad aumentada, y tras llegar a la oficina en su aerodeportivo, se plantea si tomar un segundo café antes de entrar, o bien subir directamente a su despacho para comenzar la jornada. Sus gafas captan el pensamiento, y tras apenas unos microsegundos de cálculo, proyectan en el visor tridimensional el siguiente mensaje:

H₀ : subir directamente al despacho, como es habitual.

H₁ : tomar un segundo café.

P-valor: 0.841

Ana, sorprendida por un p-valor tan alto, decide subir directamente y olvidar la idea del café, pero se pregunta a qué se deberá tal cifra. Solo mientras asciende hasta la planta 159 en el ascensor gravítico cae en la cuenta de que, apenas en media hora, tiene una importante reunión que debe preparar. De haber tomado ese café, probablemente no habría tenido el tiempo suficiente para hacerlo. Esa es la información de que disponían sus gafas cuantrónicas, que no se olvidan de nada.

Shutterstock

ShutterstockTras una intensa jornada, Ana recibe una holo-llamada de Bernardo, que la invita a cenar esta noche. Ana, tras haber terminado una relación previa hace varios meses, tiene dudas sobre si está interesada en la proposición. Las gafas, captando sus pensamientos, proyectan un nuevo mensaje:

H₀ : cenar sola en casa, como es habitual.

H₁ : aceptar la proposición de Bernardo y cenar con él.

P-valor: 0.053

Por segunda vez en el día, Ana queda sorprendida por la información que le proporcionan sus gafas. ¿A qué se debe un p-valor tan bajo? ¿Tan seguro está su micro-ordenador de que debe aceptar la propuesta de Bernardo? ¿Solo una probabilidad del 5,3 % de equivocarse si la acepta? Ana reflexiona unos segundos y recuerda que las gafas han sido capaces de buscar todo el rastro que ha ido dejando Bernardo en las redes sociales en un instante, muchísimo menos tiempo que el que hubiera empleado ella. Entonces le responde…

Volviendo al presente

¿Qué sucedería si dispusiésemos de las gafas cuantrónicas de Ana? Ante cualquier pequeña decisión, estas procesarían toda la información disponible y nos facilitarían de inmediato la probabilidad de equivocarnos. No cabe duda de que, por una parte, nos equivocaríamos mucho menos. Por otra, ¡la vida sería mucho más aburrida!

Como, afortunadamente, aún estamos muy lejos de que tales gafas existan, de momento el p-valor queda restringido a la experimentación científica, donde nos dará una idea de cuán probable es que estemos equivocados. En el resto de casos, deberemos seguir utilizando un análisis DAFO.

La próxima vez que lea algún estudio en el que se menciona el p-valor, ya sabe a qué se refieren los autores: al riesgo que tienen de equivocarse en sus afirmaciones con la evidencia empírica de los datos de una muestra. Como la muestra es solo una parte de la población, es una información imperfecta. Por ello el p-valor no podrá ser nunca 100 % o 0 %, que supondría una seguridad absoluta a la hora decidir.![]()

Sobre los autores: Jose Luis Arroyo Barrigüete y Francisco Borrás Palá son profesores de métodos cuantitativos en ICADE – Universidad Pontificia Comillas

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Cómo nos ayuda la ciencia a tomar decisiones correctas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Fórmulas matemáticas y números: cómo ayuda la economía al fútbol

- Cómo hacer ciencia en un periódico: la experiencia de ‘Público’

- Cómo descubrimos tres libros venenosos en la biblioteca de nuestra universidad

La eterna promesa del ‘blockchain’

Este año se cumple una década de la aparición del famoso paper que planteó el sistema Bitcoin, dando así pistoletazo de salida a la proliferación del “dinero electrónico”. Esta y otras criptomonedas se sustentan en una tecnología denominada blockchain que, de acuerdo con muchos analistas, está llamada a ser una revolución en el ámbito de la llamada Industria 4.0. Pero ¿qué es el blockchain y qué capacidad transformadora tiene?

Foto: Hitesh Choudhary / Unsplash

Foto: Hitesh Choudhary / Unsplash

El blockchain surge en 2009 como solución a un problema clásico de sistemas de moneda virtual descentralizados: el problema del doble gasto. Las divisas tradicionales funcionan porque hay una entidad central que se encarga de su buen funcionamiento, y por ende donde el sistema económico y financiero deposita la confianza (e.g., el Banco Central Europeo). Con la adopción de Internet y los sistemas distribuidos, surge un interés en el desarrollo de divisas digitales que no dependan de un mediador de confianza, pero todos los planteamientos chocan frontalmente con el problema del doble gasto: que una misma moneda (en el sentido de “unidad básica” de la divisa) pueda ser falsificada y gastada más de una vez. Hasta 2009, cuando el creador del Bitcoin (bajo el pseudónimo Satoshi Nakamoto) propone una solución basada en un triple enfoque: todas las transacciones se comparten públicamente; las transacciones válidas se determinan por un sistema de prueba de trabajo (proof of work); y se incentiva económicamente la contribución a este sistema (por los llamados mineros).

Estos tres pilares se integran en la tecnología blockchain, que no es más que la unión de dos técnicas bien conocidas y desarrolladas: los árboles Merkle y la criptografía (en forma de firma digital de clave pública y funciones hash). El árbol Merkle es una estructura de datos ideada y patentada en 1979 por Ralph Merkle, diseñada para concatenar información de forma que un nodo dado permite verificar de forma segura y eficiente toda la información que cuelga de él. Tiene muchas aplicaciones, como en el intercambio de archivos en redes P2P o en software de control de versiones como Git. Blockchain es básicamente una cadena de bloques (tipo Merkle, pero, en principio, sin ramificaciones) a la que se añade la firma digital para verificar los participantes en las transacciones.

Bitcoin funciona como una red distribuida de forma que las transacciones se propagan por todos los nodos de la red. Estas transacciones se validan y, en un primer momento, se encuentran sin confirmar. Los mineros recolectan transacciones y tratan de añadirlas en forma de nuevo bloque al blockchain en un proceso que requiere gran capacidad de computación. El incentivo principal por conseguirlo es una fracción de Bitcoin (proporcional a la dificultad en términos de cómputo, que es variable, en ese momento), que no es otra cosa que crear dinero de la nada (de ahí lo de minero…), aunque también se puede llevar un impuesto sobre las transacciones que agrega el bloque. Por supuesto, puede suceder que varios bloques diferentes sean añadidos al blockchain más o menos simultáneamente por diferentes mineros. Lo que sucede es que, al no haber una autoridad central, la propia red “decide” qué rama es la válida, y es simplemente la que la mayoría acepta y sigue utilizando para poner nuevos bloques con transacciones. Los bloques de las ramas que no se continúan quedan huérfanos y dejan de tener validez.

Como consecuencia, este sistema ha dado lugar a una carrera “armamentística” para acumular capacidad de cómputo hasta un límite en el que el gasto energético para minar un bloque es mayor en muchas partes del mundo que el rédito que se obtiene. El Bitcoin, la gran promesa de las monedas libres, ha sido básicamente absorbido por el mercado y se ha convertido en un instrumento financiero más de especulación (recordemos la gran burbuja de finales de 2017), y es susceptible de quedar controlado por las grandes granjas de minado que se han establecido en países donde la energía es barata. El llamado “ataque del 51%” es una sombra que planea sobre este tipo de divisas, y que se hace más fácil a medida que la capacidad para minar se centraliza.

En definitiva, el Bitcoin (y demás criptodivisas) no ha triunfado ni triunfará en los términos que sus proponentes imaginaban. Los problemas no son meramente técnicos, sino fundamentales a la tecnología: es un sistema donde las transacciones son costosas, irreversibles y lentas; es un sistema que solo merece la pena para personas que operan fuera de la ley, o bien, como decíamos, como producto de especulación. Una criptomoneda puede ser 1) descentralizada, 2) barata, 3) segura; y solo podemos elegir dos. Para evitar la necesidad de una autoridad central, se necesitan mecanismos que son computacionalmente costosos de falsificar; para que sea segura, el coste económico del minado tiene que ser alto para que se desincentiven los ataques al sistema. Cualquier intento de arreglar un aspecto compromete el resto.

What are some industries where #blockchain would be useful?

✔️ #voting#CyberSecurity #HealthIT #education #Insurtech #Retail #SupplyChain #WEFLIVE pic.twitter.com/aEtz1J23Q2

— Michael Fisher (@Fisher85M) January 22, 2018

A partir del surgimiento de las criptomonedas, se ha propuesto a lo largo de esta década una infinidad de aplicaciones del blockchain, donde es usado como contenedor genérico de otros tipos de dato, en lugar de transacciones monetarias. Aquí, cabe destacar que poner información en un blockchain simplemente asegura que no se puede cambiar sin mucho esfuerzo y dinero, pero no dice nada de la validez de esa información. A pesar de ello, año tras año, hemos venido asistiendo a un desfile interminable de analistas y gurús de toda índole donde se nos promete que el blockchain es la nueva revolución en todo tipo de campos, pero esa revolución sigue sin llegar, ni siquiera en su aplicación original. En efecto, ¿cómo podría una base de datos lenta y costosa transformar nuestra industria?

Sobre el autor: Iñaki Úcar es doctor en telemática por la Universidad Carlos III de Madrid e investigador postdoctoral del UC3M-Santander Big Data Institute.

El artículo La eterna promesa del ‘blockchain’ se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Gene-aplikazioak, fidagarriak al dira?

1. irudia: Telefono adimenduetan aplikazio anitz aurki daitezke, genetikarekin harremana dutenak barne. (Argazkia: Pexels – Pixabay lizentzia. Iturria: pixabay.com)

Ikertzaile talde batek aztertu ditu Apple Store eta Google Play zerbitzuetan eskuragarri dauden gene-aplikazioak. Horretarako, zerbitzu horietako bakoitzean bilatu zituzten “gene”, “genetika”, “genomika” edota “familia-historia” bezalako hitzak. Guztira, 616 aplikazio Apple Store zerbitzuan aurkitu zituzten, eta 678 aplikazio Google Play zerbitzuan. 1.294 aplikazio horietatik alde batera utzi ziren bikoiztuta zeudenak, informazio klinikorik ez zutenak, gizakien informaziorik ez zutenak eta ingelesez ez zirenak. Aplikazio batek baldin bazuen ordainpeko bertsioa eta dohaineko bertsioa, kasu horietan ordainpekoa aztertu zuten. Azkenik, bakarrik aztertu zituzten telefono adimendunen sistema eragilearen azken bertsioan funtzionatzen zuten aplikazioak. Irizpide horiek erabilita, 88 aplikazio aztertu ziren azkenean.

Aplikazio horien ezaugarri nagusiak aztertu ziren aplikazio haien deskribapenetan oinarrituta. Aplikazioen erdia baino gehiago, entrepresa pribatukoak ziren; laurden bat inguru garatu zituzten fidagarriak diren erakundeek (adibidez, unibertsitateek, ospitaleek edota gobernu-agentziek), eta beste laurden bat ingururen jatorria ezezaguna zen. Aplikazio horiek eskaintzen zituzten funtzioen artean, ia guztiak ziren informazio-iturri bezala erabiltzekoak. Aplikazio hauetako batzuek ere honelakoak eskaintzen zituzten:

- Klinikan erabiltzeko aukera. Adibidez, aplikazio batek azter ditzake aurpegiko ezaugarriak dismorfologia-nahasmenduak baloratzeko.

- Jolasak eta galdera-erantzunak. Adibidez, aplikazio batek badu Mendelen legeak ikasteko joko bat.

- Bizimoduan aldaketak egiteko gomendioak. Aplikazio hauek lotuta daude norberak egiteko gene-testekin eta test horien emaitzen arabera egiten ditu bizimoduari buruzko gomendioak.

- Gene-testak egiteko aukera. Aplikazio horien bidez eros daitezke etxe-komertzial baten gene-testak eta aztertu testen emaitzak.

2. irudia: Gene-aplikazioen ezaugarriak beste edozein aplikazioren ezaugarriak bezala azter daitezke. (Argazkia: Pixelkult – Pixabay lizentzia. Iturria: pixabay.com)

Aplikazio gehienek funtzionatzeko behar zuten Interneterako sarrera. Aplikazioen laurden batek informazioa pasahitzaz babesteko aukera ematen zuten eta hainbatek informazioa gizarte-sareetan partekatzeko; adibidez, aplikazio batek aukera ematen du Twitterren nahasmendu kardiobaskularrak izateko gene-arriskua txiotzeko. Aplikazio gehienak osasun-ikasleentzat eta osasun-langileentzat zuzenduta bazeuden ere, aplikazioen heren batek publiko orokorra zuen helburu. Aplikazio horiek Apple Store eta Google Play zerbitzuetan zuten ebaluaziori dagokiola, batez beste, lau izarreko balorazioa zuten, baina aplikazioen heren batek ez zuen ebaluaziorik. Azkenik, aplikazio horien salneurria 2,18$ da batez beste, baina aplikazioen hiru laurden dohainik dira eta ordainpekoen salneurriaren heina 2,99$ eta 50$ artekoa da.

Aplikazio horien kalitatea aztertzeko, MARS (Mobile App Rating Scale, aplikazio mugikorren ebaluazio-eskala) irizpidea erabili zen. Irizpide hori garatu zen Queensland University of Technology-n osasun-aplikazioen kalitatea neurtzeko. Irizpide horien arabera aztertu ziren aplikazioen lau alderdi:

- konpromisoa, hau da, ea aplikazioa interesgarria, interaktiboa edota egokia den,

- funtzionaltasuna, hau da, aplikazioa erabiltzeko edo nabigatzeko erraza ote den,

- estetika, hau da, diseinua, erabilitako grafikoak eta erakargarritasuna,

- eta informazioa, hau da, eskainitako informazioaren zuzentasuna, sinesgarritasuna eta kalitatea.

Alderdi horiek erabilita kalkulatu zen gene-aplikazio bakoitzaren osoko kalifikazioa. Alderdi guztiek eta osoko kalifikazioak zero eta bost arteko balioak izan zituzten. Bi ikertzaileek aplikazio bakoitza aztertu eta baloratu zuten, eta, desadostasunak egotekotan, kontsentsu batera heldu ziren.

MARS irizpidearen arabera, hauek izan ziren balorazio handiena izan zuten gene-aplikazioak: My Genetics Compass (4,79), Prader Willi World (4,78), Invitae Family History Tool (4,75), Power of Minus Ten – Cells and Genetics (4,64), Gene Tutor (4,63) eta DNA Play (4,63); balorazio kaxkarrena aldiz, hauek izan zuten: Genetic Disorder (2,42), All about Genes and Genetics (2,73), Genetics (2,73), GenCode (2,85), AP Biology Hardy-Weinberg Spreadsheet Tutorial (2,86) eta Genome Genius (2,88).

3. irudia: Gene-informazioa eskura dugu eta edonon kontsulta dezakegu. (Argazkia: Peggy und Marco Lachmann-Anke – Pixabay lizentzia. Iturria: pixabay.com)

Egileek aditzera ematen dute bere lanak hainbat muga dituela:

- Aplikazioak etengabe eguneratzen direnez, zaharkituta gelditzen da aplikazio batzuen balorazioa.

- Bakarrik ingelesez dauden aplikazioak aztertu dira.

- Ez dira aztertu beste sistema eragile batzuetako aplikazioak.

- MARS irizpideetan ez dago erreferentzia bibliografikoari buruzko atalik.

Edonola ere, egileek gene-aplikazioei buruz egiten dituzten gogoetak baliagarriak izan daitezke. Lan honen egileek, kontuan hartu dute fidagarriak diren erakundeek aplikazioen laurden bat bakarrik garatu dituztela, eta erabiltzaileek baloratu gabe utzi dutela aplikazioen heren bat. Ondorioz, uste dute gene-aplikazioak jaisterako orduan tentuz ibili behar dela, bai osasun esparruko langileak, bai eta oro har hiritar guztiak ere. Egileek ere azpimarratzen dute bizimodua aldatzeko gomendioen kasuan, ez daudela argi gomendio horien zuzentasuna eta oinarria. Hortaz, haien ustez hobe da emaitza horiek profesional batekin partekatzea, gomendioak balioztatzeko eta gene-aholkularitza jasotzeko. Azkenik, egileek bere ardura azaltzen dute aplikazioek informazio atalak duten balorazio urria dela eta. Izan ere, MARS irizpideetan aztertzen diren atalen artean berak hartu zuen balorazio txikiena. Egile hauen iritziz, beharbada aplikazioak ez dira behar bezala aztertu, eta ematen duten informazioa ez da zientzia-aldizkarietan argitaratu edota informazio-iturria ez da guztiz fidagarria. Hori dela eta, bi proposamen egin dituzte: batetik, osasun-langileei gomendatzen diete aplikazio hauek erabili baino lehen sakon aztertzea; bestetik, erakundeei eskatzen diete mota honetako aplikazioak egiaztatzeko erregulazio eta arauak garatzea. Oro har, egile hauen ustez, gene-aplikazioak asko hobetu behar dira bere funtzioa behar bezala betetzeko.

Laburbilduz, zure telefono adimenduan aplikazioak jaisteko zerbitzua erabiltzen zaudela, gene-aplikazioekin topo egiten baduzu, tentuz ibili: oraindik gene-aplikazioak ez dira izan beharko luketen bezain egokiak.

Erreferentzia bibliografikoa:

Talwar et al. (2019). Characteristics and quality of genetics and genomics mobile apps: a systematic review. European Journal of Human Genetics, 27, 833-840. DOI: https://doi.org/10.1038/s41431-019-0360-2

—————————————————–

Egileaz: Koldo Garcia (@koldotxu) Biodonostia OIIko ikertzailea da. Biologian lizentziatua eta genetikan doktorea da eta Edonola gunean genetika eta genomika jorratzen ditu.

—————————————————–

The post Gene-aplikazioak, fidagarriak al dira? appeared first on Zientzia Kaiera.

Sumas y sucesiones alícuotas

Elige un número entero positivo n. Encuentra los números positivos que lo dividen (es decir, el resto de la división es cero). Súmalos y resta a la cantidad obtenida el entero de partida n. A esa cantidad, s(n), se le llama suma alícuota de n. Por ejemplo, n=10, es divisible por 1, 2, 5 y 10. Así que s(10)=8.

Imagen: Pixabay

Imagen: Pixabay

Esta suma sirve para caracterizar ciertas clases notables de números. Por ejemplo,

-

1 es el único número cuya suma alícuota es 0.

-

Un número n es primo si y solo si s(n)=1.

-

Un número n es perfecto si coincide con su suma alícuota, es decir, s(n)=n. Por ejemplo, 6 es un número perfecto (sus divisores son 1, 2, 3 y 6).

-

Un número n es deficiente si es mayor que su suma alícuota, es decir, s(n)<n. El 1 es el primer número deficiente. Y, obviamente, todos los números primos son también deficientes.

-

Un número n es abundante si es menor que su suma alícuota, es decir, s(n)>n. El primer número abundante es el 12 ya que s(12)=16. Los números abundantes son los que no son ni perfectos ni deficientes.

-

Un número n es quasiperfecto si s(n)=n+1. Aun no se ha encontrado ninguno de estos números…

-

Un número n es casi perfecto si s(n)=n-1. Los únicos números casi perfectos conocidos (de momento) son las potencias de 2.

-

Un número n se llama intocable si no existe ningún entero m de modo que s(m)=n. Abu Mansur al-Baghdadi demostró que 2 y 5 son intocables. Paul Erdős demostró que existen infinitos números intocables. Y aún se desconoce si 5 es el único número intocable impar.

¿Y qué sucede si se calcula la suma alícuota manera iterada? Es decir, ¿qué se obtiene al computar s(n), s2(n), s3(n),… y así sucesivamente? A {s(n), s2(n), s3(n),…} se le llama sucesión alícuota de n.

Por ejemplo, la sucesión alícuota de 10 es {10, 8, 7, 1} ya que:

- 10 es divisible por 1, 2, 5 y 10, con lo que s(10)=8.

- 8 es divisible por 1, 2, 4 y 8, con lo que s(8)=s2(10)=7.

- 7 es divisible por 1 y 7, con lo que s(7)=s3(10)=1.

- 1 es divisible solo por 1, con lo que a partir de este punto ya no puede repetirse el proceso.

Solo existen cuatro posibilidades para la sucesión alícuota de un número entero (a priori, porque se desconoce si existen ejemplos de todas ellas):

-

que sea finita y termine en 1 (en este caso, el anteúltimo número de la sucesión es un primo). Un ejemplo es n=10;

-

que sea finita y termine en un número perfecto. Un ejemplo es n=6, para el que sk(6)=6 para todo entero positivo k;

-

que sea finita y termine en un par de números amigos (como 220 y 284) o en un ciclo (como el caso de los números sociables);

- que sea infinita.

Para n=276 no se sabe si su sucesión alícuota es finita o infinita. De momento se ha calculado hasta el término 469 de la sucesión:

s469(276)=149 384 846 598 254 844 243 905 695 992 651 412 919 855 640.

¿Volverá a descender esa cantidad para algún sk(276) con k mayor que 469? Se desconoce en este momento. Pero podría suceder porque, por ejemplo, para n=138, existe un k en el que se alcanza un “pico”, sk(138)= 179 931 895 322, y la sucesión empieza a descender a partir de ese momento hasta llegar a un 1.

Aunque esto parece un mero juego, existen muchas conjeturas alrededor de sumas y sucesiones alícuotas que mantienen a muchas personas ocupadas y ¡haciendo matemáticas serias!

Referencias

- Aliquot sequences, Futility Closet, 12 junio 2019

- Jean Luc Garambois, Aliquot sequences

- Wolfgang.Creyaufmueller, Aliquot sequences,

- Juan Luis Varona, Aliquot sequences

- Aliquot sequences, OEIS

-

Richard K. Guy and J. L. Selfridge, What Drives an Aliquot Sequence ?, Maths of Computation 29 (1975) 101-110

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Sumas y sucesiones alícuotas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Construye tu propia calculadora de sumas y restas

- La magia de los números (el teorema de Moessner)

- La magia del teorema de Zeckendorf

Adimen artifizialak kolaboratzen ikasi du; momentuz, jokoetan

1. irudia: Orain arte xake eta go jokoetan garaile atera da adimen artifiziala, baina oraingoan elkarlanaren beharra duen bideo-joko partida batean eskuratu du garaipena. (Argazkia: Sean Do / Unsplash)

Bigarren partidaren 37. mugimenduan, ordenagailuak zentzurik gabeko mugimendua egin du. Komentaristak zur eta lur geratu dira. “Hori oso arraroa da”, esan du batek. Barre bakar batzuk ere entzun dira aretoan. “Hau akats bat da”, besteak. Go partidan ordenagailuaren aurkaria den Lee Sedol aretotik atera da, eta itzuli denean, jarri duen aurpegia ere ikustekoa da. AlphaGo programak aukeratu du bosgarren lerroan fitxa bat jartzea, baina milaka urtetan zehar gizateriak bildutako esperientziak dio horrek ez duela zentzurik, hasierako mugimenduetan bederen. Hirugarren lerroan, bai; laugarrenean, ere. Hirugarrenak epe motzera “lurraldea” eskuratzeko aukerak biderkatzen ditu; eta laugarrenak, berriz, erdialdearen gaineko eragina izateko estrategian laguntzen du. Hori diote, bederen, go jokoan aditu direnek.

2016ko martxoan izan zen Google AlphaGo eta orduko munduko txapeldun Lee Sedol hegokorearraren aurkako partida hori. Garaile atera zen adimen artifiziala, eta, hein handi batean, adituen buruan sartzen ez zen mugimendu horri esker izan zen garaipena. Iraultza txikia egon zen adimen artifizialaren munduan, eta bereziki, go zaletuen artean.

Makina gizakiaren aurka aritzea ez zen kontu berria, xake-jokoan ordenagailuek aspaldi gainditu zituztelako gizakiak. Baina Go jokoa oso bestelakoa da. Kasu honetan, ezinezkoa da “indar konputazional” hutsa erabiltzea aukeran dauden mugimendurik hoberenak aurreikusteko. Go jokoan aukeran dauden posizioak izugarri handiak direlako. Horregatik, AlphaGo sistemaren arrakastaz hitz egitean, horren sortzaileek “intuizioa” edota “kreatibitatea” bezalako hitzak erabili dituzte. Horrelako planteamenduek, noski, eztabaida asko eragin dute mundu akademikoan, kontzeptu horiek, momentuz, gizakiei mugatuta daudelako, eta gizakien artean ere horiek zer diren edo horiek kuantifikatzea ez delako batere erraza.

Eztabaida hori bere horretan dagoela, go jokoan trebatutako adimen artifiziala garatu duen DeepMind enpresako ikertzaileek beste kontzeptu bat atera dute plazara: “kolaborazioa”. Science aldizkarian aurkeztu duten proposamenaren arabera kolaborazioan oinarritzen den bideo-joko batean ere gizakiei aurrea hartu die adimen artifizialak.

Elkarlanaren beharraQuake III Arena Capture the Flag jokoan trebatu da ordenagailua, “harrapa ezazu bandera” motako jokoa, hain zuzen. Hiru dimentsioko bideo-jokoa da. Erabili duten joko nagusiaren aldaeran, bi talde bata bestearen kontra aritu behar dira arerioaren base batean banderak eskuratzeko eta haien basea babesteko. Dena dela, helburua lortzeko bi talde horiek elkarlana behar dute. Ikertzaileen esanetan, adimen artifizialak maila altuko partidak egin ditu, gizakiak egiten dituen partiden parekoak, baina harago joan da kontua: gizakiekin batera egindako partidetan garaile atera dira makinak. 40 jokalari trebatuen aurkako partidetan, algoritmoak partiden %21 baino ez du galdu, kontuan izanda, gainera, ikertzaileek erabakiak hartzeko algoritmoaren abiadura moteldu zutela, gizakien erritmora eta erreflexuetara egokitu aldera. Bai gizakiekin zein beste algoritmoekin ondo moldatu da adimen artifiziala, partida horietan jokalariak modu aleatorioan banandu direlako, makina edo gizaki ziren kontuan hartu gabe.

2. irudia: Quake III Arena Capture the Flag izeneko jokoan trebatu dute adimen artifiziala, eta ederki moldatu dela ikusi dute, zerotik hasita. (Irudia: Deep Mind)

Ikerketaren egileen arabera, emaitzek adierazten dute adimen artifiziala gai dela kooperazio-estrategia garatuak abiatzeko. Gizakiek garatu ohi dituzten estrategia berdinak garatu ditu algoritmoak. Talde lana egin beharra dago jokoan aurrera egiteko, eta noiz eraso eta noiz babestu ondo jakin behar da ere. Adibidez, arerioaren basetik gertu itxarotea, bandera berriak ateratzeko zain edota norberaren basean geratzea, hura defendatzeko.

For The Win izena eman diote erabilitako algoritmoari, eta ausaz sortutako milaka partidatan egin du ikasketa: bere buruaren kontra 450.000 partidetan jokatuz trebatu da algoritmoa. Orotara, adimen artifizialean oinarritutako 30 agente sortu dituzte, haien artean lankidetzan edota lehian aritzeko.

Aurreko saiakeretan adimen artifizialari jokoaren arauak edota hainbat argibide eman dizkiete, baina hau ez da izan oraingoan egin dutena. Aitzitik, adimen artifizialaren esku utzi dute pantailan gertatzen denaren inguruan ikasketa bere kabuz egitea, egindako esku-hartze bakoitzaren ondoren lortutako puntuazioaren arabera. Zentzu horretan, psikologia konduktistaren alorrean izaten den irakaspen prozesu berdina izan da: zerbait ondo egitean sari bat irabazten da, eta egoera horrek egindakoa errepikatzeko aukerak biderkatzen ditu, saio eta hutsegite bidez. Ikasketa automatikoaren alorrean, errefortzu bidezko ikasketa sakona deitzen diote ikaskuntza mota honi.

DeepMind enpresaren blogean ere azaldu dute, luze eta zabal, joko horretan makinak aurrera egin dezan erabili duten estrategia. Esanguratsua da blogean egindako sarrerari eman dioten titulua: “Agente kooperatibo konplexuen gorakada”. Bertan azaldu dute testuingurua. Agente anitzen ikasketan oinarritzen da adimen kolektiboa: bakoitzak bere kabuz ikasi arren, hainbat lagunen artean elkarlanean aritzeko gaitasuna dute gizakiek, eta orain makinak gaitasun horretan trebatzen saiatu dira ikertzaileak. Makinak trebatu baino, bidea eman diete haien kabuz trebatu daitezen. “Gure agenteei jarri diegun erronka izan da ikas dezaten zuzenean pixel hutsetatik ekintzak sortzen”, azaldu dute.

Gauzak zaildu dizkiete algoritmoei. Partida batetik bestera jokoaren mapa aldatzen duen aldaera erabili dute. Modu horretan sustatu nahi izan dute agente horiek estrategia orokorrak ikas ditzaten, joko zelaia oroimenean gorde beharrean. Hala eta guztiz ere, ederki moldatu dira eta, lehenago azaldu dugun moduan, kolaborazioan aritu dira. “Parte-hartzaileen artean egindako inkesta batean, agenteak gizakiak baino elkarlan handiagoa egin dutela ikusi da”.

Agenteek partida bakoitza nola adierazten duten ulertu aldera, algoritmoen sare neuronalen mapetan azaltzen diren aktibazio patroiei erreparatu diete. Modu horretan, joko egoera bakoitzaren arabera kolore jarri duen aurpegiadesberdina erakusten dute patroiek. –Aipatu ez badute ere, neurologoek antzeko estrategia erabiltzen duten giza burmuinean gertatzen diren prozesuak ulertu nahi dutenean–. “Agenteei inoiz ez zaie ezer adierazi joko-arauei buruz, baina jokoaren funtsezko kontzeptuen inguruan ikasi dute, eta Capture The Flag jokorako intuizioa garatu dute”. Intuizioa. Ez da hitz xumea, makina bati aplikatuta. Zirraragarriena da agian arrazoia izan dezaketela.

Erreferentzia bibliografikoa:

Max Jaderberg et al., (2019). Human-level performance in 3D multiplayer games with population-based reinforcement learning. Science, 364(6443), 859-865. DOI: 10.1126/science.aau6249.

———————————————————————————-

Egileaz: Juanma Gallego (@juanmagallego) zientzia kazetaria da.

———————————————————————————-

The post Adimen artifizialak kolaboratzen ikasi du; momentuz, jokoetan appeared first on Zientzia Kaiera.

El desconcertante efecto fotoeléctrico

El Museo Guggenheim de Bilbao está recubierto por planchas de titanio, un metal. «El gran árbol y el ojo» la escultura de bolas es de acero. ¿Emiten fotoelectrones? Fuente: Jon del Rivero / Unsplash

El Museo Guggenheim de Bilbao está recubierto por planchas de titanio, un metal. «El gran árbol y el ojo» la escultura de bolas es de acero. ¿Emiten fotoelectrones? Fuente: Jon del Rivero / Unsplash

En 1887, Heinrich Hertz estaba comprobando la teoría de las ondas electromagnéticas de Maxwell. Se dio cuenta de que una superficie metálica puede emitir cargas eléctricas cuando incide sobre ella una luz de longitud de onda muy corta. Debido a que intervienen la luz y la electricidad este fenómeno pasó a conocerse como efecto fotoeléctrico.

Cuando las cargas eléctricas producidas de esta manera se hacía pasar a través de campos eléctricos y magnéticos, sus trayectorias se veían afectadas de la misma manera que las de los rayos catódicos. Por el mismo razonamiento empleado con ellos se dedujo que las cargas eléctricas emitidas por el efecto fotoeléctrico consisten en partículas cargadas negativamente. En 1898, J.J. Thomson midió el valor de la relación q / m para estas partículas. Utilizando el mismo método que había usado para las partículas de los rayos catódicos Thomson obtuvo el mismo valor para las partículas fotoeléctricas que para las partículas de los rayos catódicos.

Estos experimentos (y otros) demostraron que las partículas fotoeléctricas tenían las mismas propiedades que los electrones. De hecho, los físicos ahora consideran que estas partículas son electrones, aunque a menudo se les llama fotoelectrones, para indicar su origen. Trabajos posteriores demostraron que todas las sustancias (sólidos, líquidos y gases) exhiben el efecto fotoeléctrico en condiciones apropiadas. Para comprender bien en qué consiste y sus implicaciones nos será más conveniente centrarnos en el efecto en las superficies metálicas.

Quizás convenga señalar ahora que el efecto fotoeléctrico tuvo un lugar muy importante en el desarrollo de la física atómica básicamente porque el efecto no se puede explicar en términos de física clásica. Fue necesario introducir nuevas ideas para dar cuenta de los resultados experimentales. En concreto, la introducción del concepto revolucionario de cuanto inició una nueva rama de la física llamada teoría cuántica. Esta teoría y el concepto físico de cuanto surgen, en buena medida, debido a la explicación proporcionada para el efecto fotoeléctrico [1].

Veamos que es lo que se observó. La información básica para estudiar el efecto fotoeléctrico proviene de dos tipos de medidas:

1. Mediciones de la corriente fotoeléctrica (el número de fotoelectrones emitido por unidad de tiempo); y

2. Mediciones de las energías cinéticas de los fotoelectrones emitidos.

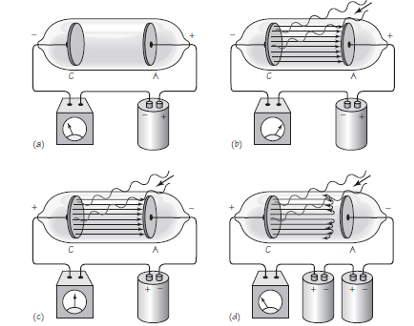

Figura 1. Fuente: Cassidy Physics Library

Figura 1. Fuente: Cassidy Physics Library

La corriente fotoeléctrica se puede estudiar con un aparato como el que se muestra en la Figura 1 (a). Dos placas de metal, C y A, están selladas dentro de un tubo de cuarzo [2] en el que se ha hecho el vacío. Las dos placas están conectadas a una fuente de diferencia de potencial (por ejemplo, una batería de alto voltaje). En el circuito también hay un amperímetro, que mide la corriente eléctrica. Mientras la luz incide en la placa C, como en Figura 1 (b), se emiten electrones con un rango de energías cinéticas (velocidades). Si el potencial de la placa A es positivo en relación con la placa C, estos fotoelectrones emitidos se acelerarán hacia la placa A [3]. La corriente eléctrica resultante la indica el amperímetro. .

Los primeros resultados del experimento son: cuanto más fuerte (o más intenso) sea el haz de luz de un color (frecuencia) dado, mayor será la corriente fotoeléctrica. Cualquier metal utilizado como placa C muestra un efecto fotoeléctrico, pero solo si la luz tiene una frecuencia mayor que un cierto valor. Este valor de la frecuencia se denomina frecuencia umbral para ese metal. Diferentes metales tienen diferentes frecuencias umbral. Pero si la luz incidente tiene una frecuencia inferior a la umbral, no se emiten fotoelectrones, ¡sin importar lo grande que sea la intensidad de la luz o cuánto tiempo permanezca encendida! Este es el primer conjunto de descubrimientos sorprendentes.

Las energías cinéticas de los electrones se pueden medir en una versión ligeramente modificada del aparato, que vemos en la Figura 1(c). La batería se invierte, de modo que la placa A ahora tiende a repeler los fotoelectrones. El voltaje puede cambiarse de cero a un valor lo suficientemente grande para evitar que los electrones alcancen la placa A, como se indica en la Figura 1(d).

Cuando el voltaje entre las placas es cero, el medidor indicará una corriente [3]. Esta lectura muestra que los fotoelectrones, que emergen con energía cinética de la superficie metálica, pueden alcanzar la placa A. A medida que aumenta el voltaje de repulsión, la corriente fotoeléctrica disminuye. Finalmente, se alcanza un cierto voltaje en el que incluso los electrones más rápidos se repelen y, por lo tanto, la corriente se vuelve cero, como se indica en en la Figura 1(d). Este voltaje, llamado voltaje de parada, es una medida de la energía cinética máxima de los fotoelectrones emitidos (Ecmax). Si llamamos Vp para al voltaje de parada, entonces la energía cinética máxima viene dada por la relación Ecmáx = e ·Vp , donde e es la magnitud de la carga del electrón. Se encontró que la energía cinética máxima medida de los electrones emitidos era proporcional a la frecuencia de la luz incidente.

En nuestro camino hacia poder explicar la tabla periódica y la estructura de los átomos, continuaremos discutiendo estos resultados, cómo la física clásica no puede explicarlos y qué solución propuso Einstein.

Nota:

[1] El concepto de cuanto fue introducido por Planck a finales de 1899. Pero en ese momento era poco más que un artificio matemático. El verdadero uso útil del mismo se lo dio Einstein en 1905 para explicar el efecto fotoeléctrico. Ya llegaremos a eso.

[2] El cuarzo es transparente a la luz ultravioleta, así como a la luz visible, no como el vidrio común a base de sílice, que es opaco en mayor o menor medida a la ultravioleta.

[3] Por la naturaleza del fenómeno existe una probabilidad no nula de que algunos electrones emitidos lleguen a la placa A, incluso si no es positiva en relación con C.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo El desconcertante efecto fotoeléctrico se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La estructura 3D de la cota de malla invierte el efecto Hall

- Una nueva cosmoquímica por descubrir gracias al efecto túnel cuántico

- El sistema de la difusión social de la ciencia: Efecto de las actividades de difusión científica

Zer gertatzen zaigu hiltzen garenean?

Irudia: Hil ondoren hainbat prozesu kimiko eta biologiko gertatzen dira gorpua deskonposatzen den bitartean. (Argazkia: Manfred Kain – domeinu publikoko irudia. Iturria: pixabay.com)

Hil ondoren bihotzak odola punpatzeari uzten dio eta, pixkanaka, odola koagulatu egiten da eta lodiagoa egiten da. Odola ez denez zirkulatzen ari, grabitateak berak gorputzaren beheko aldeetara eramaten du odola postmortem hipostasia edo livor mortis deritzon prozesuan. Bihotzak odola punpatzen ez duen bezala, biriken jarduera ere eten egiten da. Hil ostean arnasteari uzten zaionean, zelulek ez dute oxigenorik jasotzen. Oxigenorik gabe, zeluletan dauden mitokondriek ezin dute ATPa ekoiztu. ATPrik gabe, zelulak ez dauka energiarik eta bere jarduera guztiak eten egiten dira. Hala ere, heriotza klinikoaren ondoren, denbora batez -hainbat minutu, ordutara iritsi daiteke- zelulek bizirik jarraitzen dute geratzen zaien oxigenoarekin eta zeluletan karbono dioxidoa ekoizten da -mitokondriek martxan jarraitzen dutelako tarte batez-. Era berean, heriotza klinikoaren hurrengo bizpahiru orduetan rigor mortis delakoa hasten da. Muskuluak gogortu egiten dira eta malgutasuna galtzen dute. Fenomeno horrek ez du asko irauten; izan ere, zelulak bizirik jarraitzen dute beste tarte batez eta haien metabolismoak ATPa azido laktiko bihurtzen du muskuluak deskonposatzen hasten direlarik -eta horrekin bigundu egiten dira-.

Zeluletan ekoizten den karbono dioxidoa azidoa da eta, denboraren poderioz, zeluletan dauden organuluak eta zakutxoak apurtu egiten dira. Horren ondorioz, babestuta eta zelulatik bereizita egon behar ziren entzimak askatu egiten dira eta zelula bera digeritzen hasten dira. Nolabait, zelula bere burua jaten hasten da. Prozesu hori zelula barrutik kanpora gertatzen denez, zelulak nutrientez beteriko poltsatxoak bihurtzen dira. Nutriente guzti horiek erakarrita, hainbat bakterio eta onddo gorpura hurbiltzen dira eta hildako zelulen nutrienteak hartzen dituzte. Pixkanaka, muskulu eta organoak likidotzen hasten dira. Putrefakzioa hasi da. Giza-ehunak erasotzen dituzten mikroorganismoen metabolismoaren ondorioz, hainbat eta hainbat substantzia ekoizten dira -horietako batzuk gas egoeran-.

Askatzen diren gasen artean, freona legoke, adibidez. Freona likido hozgarria da, hozkailuetan erabiltzen dena, hain zuzen ere eta klorofluorokarbonoen taldekoa da -ozono geruza kaltetzen duten gasak-. Bentzenoa ere askatzen da, hain zuzen ere, gasolinan dagoen hidrokarburo minbizi-sortzailea. Igortzen diren beste gasen artean sufredun konposatuak daude -ustel-usainaren erantzule nagusiak- eta baita metanoa eta karbono tetrakloruroa ere. Karbono tetrakloruroa, esaterako, su-itzalgailuetan erabiltzen zen toxikoa dela ezagutu zen arte. Fase honetan askatzen diren molekula nagusiak putreszina eta kadaberina dira. Putreszina eta kadaberina, beste 400 bat konposaturekin batera, gorpuen usain txarraren erantzuleak dira. Esan behar da, halere, putreszina ez dela gorpuen deskonposizioarekin bakarrik lortzen eta, besteak beste, gernuak eta semenak ere putreszina dute.

Mikroorganismoen lanaren ondoren, haragi gehiena desagertzen doa eta geroz eta bigunagoa da, usteltzen ari den seinale. Horrekin batera animalia handiagoak gerturatzen dira, besteak beste, zizareak eta kakalardoak. Intsektuek gainerako haragi ustela erabiltzen dute elikatzeko eta, horrela, hezurrak bakarrik geratzen dira. Denboraren poderioz hezurretan dauden proteinak ere deskonposatu egiten dira eta hezurraren mineralak bakarrik geratzen dira -nagusiki hidroxiapatita, alegia, kaltzio fosfatoa-. Denbora luzea pasata, hidroxiapatita ere hauts bihurtuko da eta horrela, gorputza osatzen zuen materia guztia, organikoa eta ez-organikoa, Naturako beste elementuen parte izatera pasatzen da. Horrela, hautsa bizigai bilakatu zen bezala, bizigaia hauts bilakatuko da. Zikloari berriro hasiera emateko, noski; izan ere, hauts bilakatu diren nutriente guzti horiek beste animalientzat elikagai izan dira eta landareentzat ongarri ona izan dira.

Informazio osagarria:

- ¿Qué ocurre después de la muerte?, Moheb Costadi, elpais.com, 2015.

- Biología de la muerte, ecofuneral.es

- ¿Qué hay después de la muerte?, naukas.com, 2014 (bideoa).

—————————————————–

Egileaz: Josu Lopez-Gazpio (@Josu_lg) Kimikan doktorea, irakaslea eta zientzia dibulgatzailea da. Tolosaldeko Atarian Zientziaren Talaia atalean idazten du eta UEUko Kimika sailburua da.

—————————————————–

The post Zer gertatzen zaigu hiltzen garenean? appeared first on Zientzia Kaiera.

Anisakis

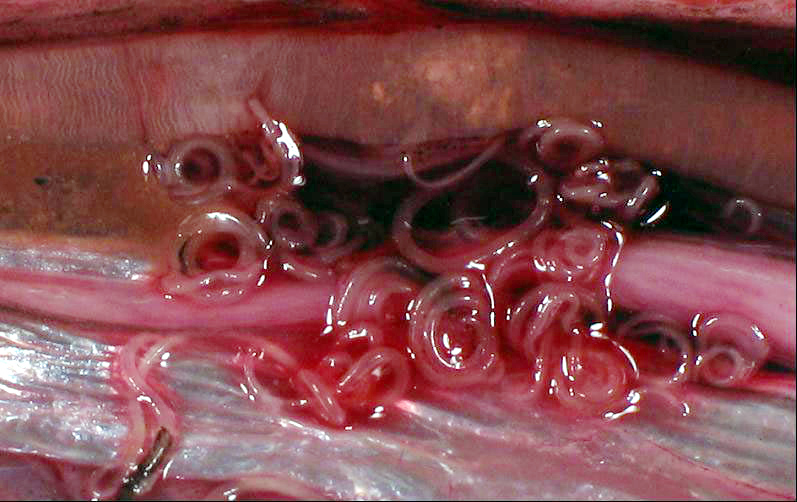

Larvas de anisakis en el interior de un arenque. Imagen: Wikimedia Commons

Larvas de anisakis en el interior de un arenque. Imagen: Wikimedia Commons

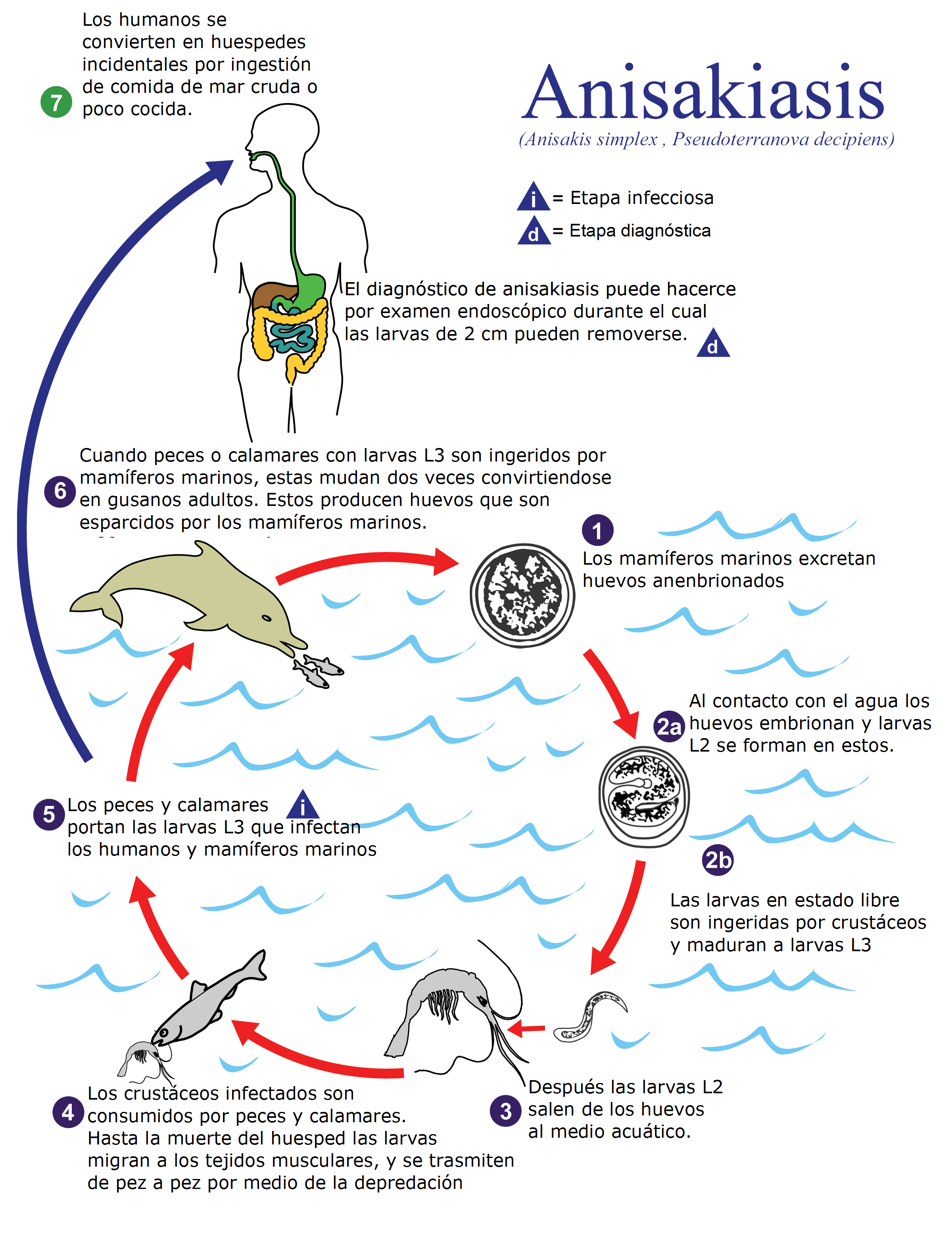

Los nematodos parásitos de animales marinos pueden hospedarse en nuestra especie y provocar la enfermedad llamada anisakidosis son las especies Anisakis simplex y Pseudoterranova decipiens, antes conocida como Phocaneura decipiens, tal como revisan Natasha Hochberg y Davidson Hamer, de la Universidad de Boston. La especie Anisakis simplex fue descrita en 1845 por el zoólogo francés Félix Dujardin, como parásito de tiburones, en su monumental obra Histoire naturelle des helminthes ou Vers intestinaux. Anisakidosis es la enfermedad resultado de la infección accidental con las fases larvarias de varios nematodos que se encuentran en peces o cefalópodos marinos y que se ingieren crudos o poco cocinados. Según la reunión de expertos celebrada en 1988, la anisakidosis es la enfermedad provocada por parásitos de la familia Anisakidae, y anisakiosis es la enfermedad provocada por parásitos del género Anisakis. Los nematodos se conocen vulgarmente como gusanos redondos o gusanos cilíndricos debido a la forma redondeada de su cuerpo en un corte transversal. Son organismos esencialmente acuáticos, aunque aparecen también en ambientes terrestres. Existen especies de vida libre, marinas, en el suelo, y especies parásitas de plantas y animales, incluyendo el hombre. Son agentes causales de enfermedades de transmisión por alimentos y provocan enfermedades como la triquinosis, la filariasis y, entre otras más, la anisakidosis. El número de especies que parasitan directamente al hombre son un grupo muy pequeño en comparación al número total de especies de nematodos.

El primer caso de anisakidosis documentado en la bibliografía científica fue conocido en 1876 con un niño vomitando un gusano, pero la primera descripción completa llegó en 1960, cuando Van Thiel, del Instituto de Medicina Tropical de Leiden, en Holanda, identificó al parásito como un nematodo cuya fase larvaria se localizó en el arenque, el bacalao, la merluza y la caballa, y el adulto en el tiburón y la raya. El paciente de Van Thiel lo había ingerido de arenque. También menciona en su artículo otros diez casos, con parecidos síntomas y diagnosticados entre 1955 y 1959.

El primer caso de infección con anisakis en España lo publicó el equipo de Juan José Arenal, en 1991, en el Hospital Pío Del Río Hortega de Valladolid, en un varón de 41 años en el que no se pudo establecer cómo se contagió con el nematodo.

Las infecciones con anisakis provocan síntomas en el tracto digestivo, con dolores abdominales, incluso hay algún caso de apendicitis aguda, y, además, reacciones alérgicas. En personas sensibles a estos nematodos, pueden darse solo reacciones alérgicas sin molestias digestivas. En España, se han descrito reacciones alérgicas a anisakis en merluza, anchoa, bacalao, atún, sardina, sepia, caballa y gallo. Más en concreto, en Vitoria-Gasteiz, se han encontrado reacciones alérgicas después de consumir merluza cocinada o anchoas cocinadas o crudas, y el equipo de Luis Fernández Corres ha diagnosticado 100 casos de reacción alérgica, una cifra que destaca en la literatura médica sobre este parásito.

De los, más o menos, 20000 casos de anisakidosis que se detectan cada año en todo el mundo, más del 90% ocurren en el Japón, sobre todo en hombres y en las zonas costeras. El 10% restante se diagnosticó sobre todo en Europa y, en concreto, en Holanda, Reino Unido, Alemania, Italia, Francia y España; y también en Asia, en Corea; en Norteamérica, en Estados Unidos y Canadá; en los países del Pacífico en Sudamérica; y en Nueva Zelanda. En resumen, en todos los continentes y todos los océanos.

El aumento de casos en el reciente medio siglo, más en concreto en los últimos veinte años y según la revisión, publicada en 2008, de Audicana y Kennedy, del Hospital Santiago de Vitoria-Gasteiz y la Universidad de Glasgow, respectivamente, se debe a que es una enfermedad mal diagnosticada, con falta de información incluso en los ambientes médicos y con buenos métodos de detección recientes. Y, también, por la moda gastronómica de los últimos años de consumir pescado crudo o poco cocinado según la tendencia culinaria creciente de no cocinarlo en exceso. O, si se quiere, de no cocinarlo adecuadamente. Es indudable que, a causa de la moda de la dieta mediterránea, ha crecido la demanda de pescado por los consumidores. También se ha propuesto un aumento reciente de la presencia de estos parásitos en las especies de pescado que se comercializan.

En una revisión sobre parasitosis con anisakis en España, publicada en 2018, Zaida Herrador y su grupo, del Instituto de Salud Carlos III de Madrid, revisan los datos de hospitalización desde 1977 a 2015, con un total de 2471 ingresos con síntomas y diagnóstico de anisakidosis. Ya en 2017 y con datos de 2013, Miguel Bao había colocado en cabeza de número de casos a Cantabria seguida del País Vasco.

El grupo de Zaida Herrador detecta un aumento constante de casos en los 19 años revisados y, además, con dos picos muy altos en 2002 y 2014. La media es de 2.93 casos por millón de habitantes, con la tasa más alta en Madrid, con 9.17 casos por millón, seguida de Castilla-León y La Rioja. En el País Vasco, la tasa es de 4.62 casos por millón de habitantes. Los autores proponen que el número de enfermos no diagnosticados por año en España está entre 10000 y 20000.

Se conoce como anisakidosis a la infección por cualquier miembro de la familia Anisakidae y anisakiasis a la infección por algún gusano en concreto del género Anisakis. Imagen: Wikimedia Commons

Se conoce como anisakidosis a la infección por cualquier miembro de la familia Anisakidae y anisakiasis a la infección por algún gusano en concreto del género Anisakis. Imagen: Wikimedia Commons

El contagio depende de la cultura de cada país respecto a la alimentación con pescado. En el Japón son el sushi y el sashimi la mayor fuente de pescado crudo, aunque los cocineros profesionales detectan la infección con anisakis con rapidez. Pero hay peces y cefalópodos que se consumen por particulares en sus domicilios y que también pueden estar infectados. En Estados Unidos es el salmón, en Holanda el arenque salado o ahumado, en Sudamérica es el ceviche y en España, los boquerones.

Las especies marinas portadoras de anisakis y especies cercanas de nematodos están en todos los mares del planeta. Como ejemplo para comenzar a entender el problema sanitario que suponen estos parásitos, nos sirve que, en un mercado de venta de pescado del Japón, el 98% de la caballa o el 94% del bacalao lleva anisakis. En un mercado en España, en Granada, el 39.4% de la caballa lleva anisakis. Parecidas cifras se han encontrado en Escocia, Italia, Francia o Estados Unidos. Más en concreto, en España se han encontrado larvas de anisakis en más de 35 especies de pescado de consumo habitual. En merluza hay anisakis en el 88% de los ejemplares; en bacaladilla, hasta el 85%; en jurel, hasta el 60%, en anchoa es el 5.6%, y en sardina hasta el 9%. Hay variantes curiosas cuya causa no se conoce y, así, según Adroher y sus colegas, de la Universidad de Granada, en 1990 el 49.5% de las caballas del Cantábrico tenían anisakis, el 36% de las del Atlántico y solo el 6.3% de las caballas del Mediterráneo.

Boquerones crudos en vinagre. Imagen: Wikimedia Commons

Boquerones crudos en vinagre. Imagen: Wikimedia Commons

La mejor protección contra la anisakidosis es la educación del público sobre el peligro de consumir pescado crudo o poco cocinado o si proviene de pescado salado o ahumado. Sin embargo, tal como escribe Ignacio Ferre, de la Universidad Cardenal Herrera-CEU de Valencia, es difícil cambiar las costumbres alimentarias de países con culturas de consumir pescado crudo, tal como ocurre, por ejemplo, con el Japón, el Perú y el ceviche o España con los boquerones. Hay que aplicar, en lo posible, las medidas de prevención que se pueda ya que, en muchos lugares, el combustible para cocinar o el congelador son lujos inalcanzables por ser países en desarrollo.

Y, también, hay que aplicar los métodos de destrucción de las larvas en el pescado. Mueren si pasan por temperaturas superiores a 60ºC durante más de un minuto, y mejor llegar a entre 5 y 10 minutos. El pescado ahumado necesita que el proceso tenga una temperatura alta, y el pescado en salazón debe alcanzar una concentración muy alta de sal durante un tiempo largo. Con el microondas se debe cocinar a 74ºC o más a potencia máxima más de dos minutos. Para el pescado que se quiere consumir crudo, se debe congelar a -20ºC como poco durante 24 horas y, mejor, de dos a tres días y hasta siete días.

En general, preparar pescado con sal, secado, marinado, con vinagre o ahumado hasta 40ºC, esteriliza otros patógenos pero no lo consigue con el anisakis. Así, el grupo de Pilar Puente, de la Universidad Complutense, detectó que la presencia de anisakis es mayor en los consumidores habituales de pescado crudo o poco cocido que en los que antes lo congelan y después lo cocinan.

La relación entre aumento de casos de anisakis y nuevas modas culinarias se puede ilustrar con lo que menciona Oscar Caballero en su historia cultural del mar. En 1965 y en París, se empezaron a servir en los restaurantes filetes de salmón salteados solo 15 segundos por cada lado. O también se empieza a conocer el carpaccio de lubina, es decir, la lubina cruda. Caballero escribe que “el pescado crudo entra de rondón en el restaurante un cuarto de siglo antes de que irrumpan sashimis y luego ceviches”. Fue hacia 1970 cuando el restaurante L’Arête, en Montparnasse, comenzó a servir su primer pescado “rosé à l’arête”, con la carne rosada contra la espina. Es el pescado casi crudo, es la nouvelle cuisine, la cocina que se impondrá en todo el mundo.

En España y a principios de los ochenta, José Carlos Capel reivindicaba los asados “en rosa”, que venían de Francia, con la carne poco hecha y la espina del pescado sonrosada, “una técnica que pretende respetar las cualidades gastronómicas de los alimentos, evidenciando al mismo tiempo su verdadera calidad, Una moda que se nos antoja definitiva, porque representa el único método válido para conservar en toda su pureza los impagables sabores del mar”. Es evidente que la nouvelle cuisine ignora una de las más importantes funciones del fuego para nuestra especie: esterilizar los alimentos durante el cocinado y eliminar parásitos y, entre ellos, el anisakis y otros nematodos en el pescado.

Y, para terminar, unos ejemplos de estos cambios culinarios. En 1930 y en el restaurante Amparo cocinaban la merluza durante media hora. En 1973, en la Sociedad Beztartxo de Villarreal de Urretxua lo hacían en 45 minutos. Pero en 1976, Ana María Calera recomienda quince minutos, y Arguiñano en 1996 recomienda 10-12 minutos, pero Arzak lo pone en 6 minutos, y en 2018 y en Internet, la compañía de alimentación Pescanova recomienda cuatro minutos. En 90 años hemos pasado de media hora a 4 minutos.

Referencias:

Adroher, F.J. et al. 1996. Larval anisakids (Nematoda: Ascardoidea) in horse mackerel (Trachurus trachurus) from the fish market in Granada (Spain). Parasitology Research 82: 253-256.

Arenal Vera, J.J. et al. 1991. Anisakiasis como causa de apendicitis aguda y cuadro reumatológico: primer caso en la literatura médica. Revista Española de Enfermedades Digestivas 79: 355-358.

Audicana, M.T. & M.W. Kennedy. 2008. Anisakis simplex: from obscure infections worm to inducer of immune hypersensitivity. Clinical Microbiology Reviews 21: 360-379.

Bao, M. et al. 2017. Assessing the risk of an emerging zoonosis of worldwide concern: anisakiasis. Scientific Reports 7: 43699.

Caballero, O. 2018. Océanos, peces, platos. Una historia cultural del mar. Arpa y Alfil Eds. Barcelona. 379 pp.

Capel, J.C. 1997. Manual del pescado. R & B Eds. Bilbao. 366 pp.

del Pozo, M.D. et al. 1997. Anisakis simplex, a relevant ethologic factor in acute urticaria. Allergy 52: 576-579.

Ferre, I. 2001. Anisakiosis y otras zoonosis parasitarias transmitidas por consumo de pescado. AquaTIC 14: 20 pp.

Herrador, Z. et al. 2018. Epidemiological scenario of anisakidosis in Spain base don associated hospitalizations: The tip of the iceberg. Clinical Infectious Diseases doi: 10.1093/cid/ciy853

Hochberg, N.S. & D.H. Hamer. 2010. Anisakidosis: Perils of the deep. Clinical Infectious Diseases 51: 806-812.

Nawa, Y. et al. 2000. Sushi delights and parasites: The risk of fish borne and food borne parasitic zoonoses in Asia. Clinical Infectious Diseases 41: 1297-1303.

Puente, P. et al. 2008. Anisakis simplex: The high prevalence in Madrid (Spain) and its relation with fish consumption. Experimental Parasitology 118: 271-274.

Terán-Ángel, G. & J. Rojas. 2012. Anisakidosis, inflamación e hipersensibilidad. Avances en Biomedicina 1: 30-37.

Van Thiel, P.H. et al. 1960. A nematode parasitic to herring, causing acute abdominal syndromes in man. Tropical and Geographical Medicine 12: 97-111.

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Anisakis se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El caso de los enfermos de Minamata

- El petróleo, los desastres y la prensa

- El caso de la mujer barbuda

Bizi ote liteke gizakia itsasoan?

Bajau laut herria Filipina, Indonesia, Malaysia eta Bruneiko kostaldean bizi da. “Itsasoko nomadak” bezala ezagunak dira mundu osoan bajautarrak. Izendapenak badu arrazoia, izan ere, literalki itsasoan bizi dira gutxienez duela 1.000 urtetik hona. Baina, nola da hori posible?

Maiz egiten diren galderak ataleko bideoek labur eta modu entretenigarrian aurkeztu nahi dituzte, agian, noizbait egin ditugun galderak eta hauen erantzunak. Bideoak UPV/EHUko Kultura Zientifikoko Katedrak eginak daude eta zientzia jorratzen duen Órbita Laika (@orbitalaika_tve) telebista-programan eman dira gaztelaniaz.

The post Bizi ote liteke gizakia itsasoan? appeared first on Zientzia Kaiera.

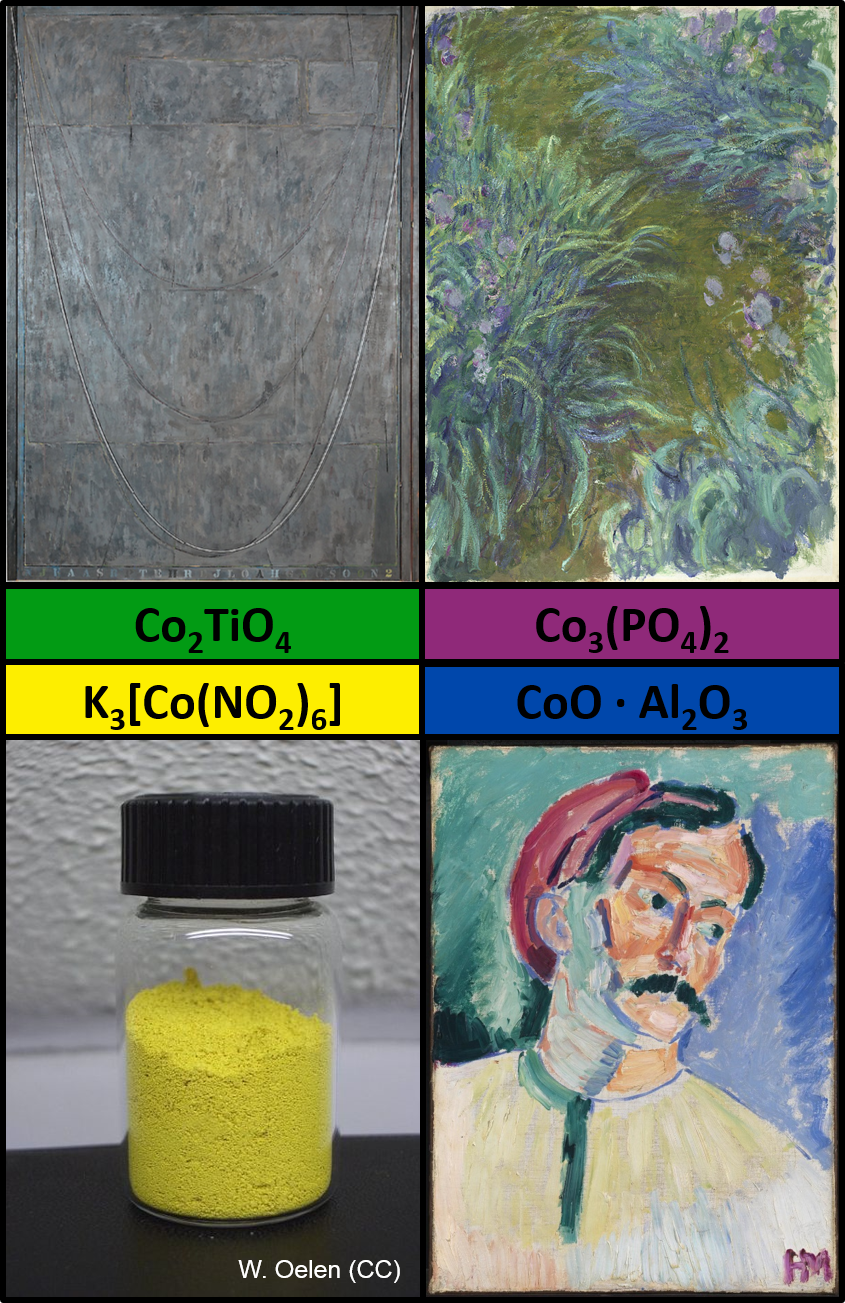

La tabla periódica en el arte: Cobalto

El cobalto no es un elemento químico tan conocido como el oro, el hierro o el cobre. Sin embargo, desde una posición más humilde ha jugado un papel fundamental en la Historia del Arte. En muchísimas ocasiones lo ha hecho desde el más absoluto de los anonimatos, ya que artistas y artesanos lo emplearon sin conocer su existencia hasta que Georg Brandt lo aisló en 1735. El elemento tomó el nombre de los kobolds, seres mitológicos a los que se acusaba de reemplazar los preciados minerales de los mineros sajones por otros que aparentemente no tenían ningún valor. De esos minerales sin valor es de donde Brandt había extraído el cobalto.

Ladrillos de colores: el vidriado.

Pese a que los egipcios fueron pioneros en el uso del cobalto, empezaremos nuestro viaje en Babilonia. Más concretamente en la puerta de Isthar, ese acceso monumental que ordenó construir Nabucodonosor II en el s. VI a.e.c. para impresionar e intimidar a cuantos entrasen a la vía procesional de la ciudad. Dragones, toros y leones dorados nos aguardan sobre un fondo de un color azul intenso. Si nos acercásemos a la puerta, veríamos que ese azul es irregular. En la pared destacan rectángulos de diferentes tonalidades que podrían ser píxeles de una pantalla de televisión. Esas formas rectangulares no son otra cosa que ladrillos, sólo que en lugar de presentar el color anodino de la cerámica cocida fueron coloreados mediante la técnica del vidriado. El vidriado consiste en aplicar sobre la cerámica una pasta que en el proceso de cocción se funde y adquiere aspecto cristalino. Podemos decir que vidriar una cerámica es como vestir a una persona: cuestión de estética y funcionalidad. No sólo se aumenta la belleza de la pieza, sino que se reduce la porosidad del objeto, haciendo que sirva para albergar líquidos.

Imagen 1. Puerta de Ishtar. Museo de Pérgamo (Berlín). Fuente: flickr / youngrobv

Imagen 1. Puerta de Ishtar. Museo de Pérgamo (Berlín). Fuente: flickr / youngrobv

La receta de la pasta empleada en el proceso de vidriado es simple: una fuente de sílice (arena), un fundente para reducir el punto de fusión de la mezcla y alúmina para controlar la viscosidad. A esa receta básica se le pueden añadir otros ingredientes, ya sea para lograr un aspecto opaco o para darle color. Y es en este último punto donde entra en juego nuestro protagonista, ya que el óxido de cobalto se caracteriza por otorgar color azul al vidriado.

Lo cierto es que no hace falta viajar tantos siglos en el tiempo para disfrutar del color que ofrece el cobalto. La loza de Delft, esa cerámica blanca y azul que abarrota las tiendas de suvenires holandesas, adquiere su bicromía gracias al óxido de estaño (opacificante blanco) y al óxido de cobalto (azul).

Imagen 2. Cerámica de Delft en el interior de la Tienda Tártara del castillo de Groussay.

Imagen 2. Cerámica de Delft en el interior de la Tienda Tártara del castillo de Groussay.

Bleu de Chartres: cuando la luz se convierte en azul

El azul es un color esquivo. La naturaleza nos regala pocas substancias de este color, lo que ha conducido al ser humano a una lucha sin cuartel para poder plasmarlo en obras de arte. Una de esas batallas se venció en la Francia del s. XII, cuna de un nuevo estilo artístico y nuestra próxima parada en este viaje por la historia del cobalto.

En Sant-Denis el abad Suger supervisa la construcción de un templo que sentará las bases de un nuevo estilo arquitectónico y cuya protagonista absoluta será la luz: el gótico. Los techos de los edificios se elevarán hasta el cielo y gracias a los avances técnicos se abrirán ventanales enormes que, cubiertos con vitrales de colores, permitirán crear una atmósfera mística. El uso de vitrales ya se documenta en Bizancio en el s. VII, pero es en el gótico donde alcanzó su máximo esplendor. Sin embargo, los artesanos tenían dificultades enormes para obtener vidrios azules. Tanto es así que los que tenían el conocimiento para lograr este color mantenían un secreto que se transmitía de generación en generación. Guardaban con celo absoluto una substancia procedente de minas desconocidas que, añadida durante la elaboración del vidrio, proporcionaba el ansiado azul. Se trataba, obviamente, de óxidos de cobalto. El azul de las vidrieras se hizo tan célebre que adquirió nombre propio. Lo tomó de la catedral gótica donde este arte alcanzó su cenit: Chartres.

Imagen 3. La Virgen Azul de Chartres (ca. 1180). Fuente: flickr / Walwyn

Imagen 3. La Virgen Azul de Chartres (ca. 1180). Fuente: flickr / Walwyn

Pese a la falta de conocimientos, aquella gente con su metodología de prueba y error estaba realizando algo que bien podría ser investigación puntera de nuestro siglo: el uso de nanopartículas. Efectivamente, el azul de Chartres debe su color a la interacción de partículas de escala nanométrica con la luz. Como la longitud de onda de la luz y la de las partículas de cobalto son similares, suceden ciertos fenómenos físicos que explican la aparición del color azul.

Esmalte: de los vitrales a la paleta

Al oír la palabra esmalte es muy posible que te venga a la cabeza un producto cosmético empleado como pintauñas. Pero en este caso nos referimos a la pasta de vidrio coloreado que se aplica a una superficie metálica o de vidrio. Eso sí, también tiene fines decorativos. Triturando el esmalte coloreado con óxidos de cobalto podemos lograr un pigmento muy empleado a lo largo de la historia: el azul esmalte. En resumidas cuentas, este pigmento no es otra cosa que vidrio azul pulverizado. El polvo se puede juntar con un aglutinante (óleo, tempera, etc.) para formar una pintura que resulta más pálida cuanto más pequeños sean los cristalitos.

Como sucede con el azul de Chartres el origen del azul esmalte está sumido en el misterio. Tendríamos que viajar hasta la Bohemia de 1540 para ver como Christopher Schurer lograba el pigmento empleando minerales de cobalto extraídos en las cercanas minas sajonas. El método consistiría en obtener una substancia llamada zaffre o zaffer mediante un proceso de combustión en el que se eliminaba el arsénico. Esa substancia se podría añadir al vidrio para otorgarle color azul, igual que sucedía con el polvo que unos siglos antes los artesanos medievales pasaban de padres a hijos para teñir las vidrieras. Eso es por lo menos la historia que cuentan los textos del s. XVII, aunque hoy en día sabemos que tanto en Europa como en China el azul esmalte se había empleado antes de 1540.

Imagen 4. La Venus del Espejo (122 x 177 cm), de Velázquez (1647-51) fue pintada con azul esmalte. Fuente: National Gallery.

Imagen 4. La Venus del Espejo (122 x 177 cm), de Velázquez (1647-51) fue pintada con azul esmalte. Fuente: National Gallery.

Más azules, más cobalto