Catástrofe Ultravioleta #30 INMERSIÓN

Catástrofe Ultravioleta #30 INMERSIÓN

Catástrofe Ultravioleta #30 INMERSIÓNEstamos sumergidos en el océano observando una maniobra de rescate a 30 m de profundidad y envueltos en la más completa oscuridad.

Nos movemos en el interior de los restos de un barco hundido hace tres días, los carteles que vemos están al revés porque la embarcación se ha dado la vuelta al caer al fondo. Buscamos el cuerpo de los 12 tripulantes de un barco que se hundió en el Golfo de Guinea…

Puedes escucharnos en:

– Podium Podcast

– iVoox

– Spotify

– Apple Podcasts

Agradecimientos: Manuel Salvador, Ramón Carreño, Salvamento Marítimo y Lucía Perlado

** Catástrofe Ultravioleta es un proyecto realizado por Javier Peláez (@Irreductible) y Antonio Martínez Ron (@aberron) para PODIUM PODCAST con el patrocinio parcial de la Cátedra de Cultura Científica de la Universidad del País Vasco y la Fundación Euskampus. La edición, música y ambientación obra de Javi Álvarez y han sido compuestas expresamente para cada capítulo.

El artículo Catástrofe Ultravioleta #30 INMERSIÓN se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Catástrofe Ultravioleta #26 VOZ 1

- Catástrofe Ultravioleta #27 VOZ 2

- Preparados para una Catástrofe Ultravioleta

Más psicofármacos a las mujeres para el mismo estado de salud mental

Foto: Krists Luhaers / Unsplash

Foto: Krists Luhaers / UnsplashEl Grupo de Investigación en Determinantes Sociales de la Salud y Cambio Demográfico OPIK de la UPV/EHU es un grupo multidisciplinar compuesto por personal investigador del campo de las ciencias sociales y de la salud, que estudia los factores sociales que influyen sobre la salud y la enfermedad de la población, las desigualdades sociales en salud y las políticas que pueden modificar tales determinantes sociales para la mejora de la salud poblacional.

Recientes análisis realizados por este grupo basados en las encuestas de salud de la comunidad autónoma del País Vasco (2018), de España (2017) y de la muestra española correspondiente a la Encuesta de Salud Europea (2014) muestran que el género es un importante determinante de la salud mental y de la gestión que se realiza de esta en los servicios sanitarios. En los análisis de esas tres bases de datos destacan las mayores prevalencias de mala salud mental en las mujeres de todas las edades y de todos los grupos sociales, y además existe un efecto multiplicativo por la acumulación de experiencias de desigualdad. Esta realidad, además, parece ser desigual en función de la edad y del nivel socioeconómico de los/las pacientes.

La doctora en Salud Pública Amaia Bacigalupe, una de las autoras del trabajo, afirma que “los diagnósticos de depresión y ansiedad son más frecuentes entre las mujeres, y el consumo de psicofármacos prescritos también es significativamente mayor, a igualdad de salud mental, de diagnósticos y de frecuencia de visitas a los centros sanitarios. Todo ello podría estar indicando la existencia de un proceso de medicalización de la salud mental de las mujeres, pero la interpretación de su origen resulta compleja, ya que sin duda operan procesos de sobrediagnóstico y sobreprescricpión entre ellas, pero quizás también de infradiagnóstico e infraprescripción en los hombres”. Bacigalupe, además, añade que futuros estudios deberían profundizar en estos aspectos.

El grupo de investigación pone en evidencia que disminuir las desigualdades de género en la salud mental deberá ser el resultado de la intervención política a diferentes niveles. “Existe una clara relación entre el nivel de desigualdad de género en la sociedad y las desigualdades de género en la salud mental —afirma Bacigalupe—, de modo que todas aquellas políticas de lucha contra la discriminación que sufren las mujeres en el mercado laboral, en la responsabilidad sobre el trabajo doméstico y de cuidados, en el uso del tiempo y, en términos generales, aquellas que empoderen a las mujeres a partir de su mayor representación política y visibilización social, repercutirán positivamente en la disminución de las desigualdades en salud mental entre hombres y mujeres”.

Otro de los aspectos que destacan en el estudio es la necesidad que desde un nivel institucional se adopten compromisos orientados a frenar la medicalización de los malestares cotidianos desde una clara perspectiva de género: “En el campo de la salud mental, en el que la medicalización del malestar es especialmente habitual, algunos problemas que tienen un origen social acaban recibiendo atención psiquiátrica o psicológica, lejos de abordar la etiología del problema”, afirma la investigadora del departamento de Sociología 2 de la UPV/EHU.

Además, según el estudio, sería necesario impulsar espacios de reflexión en el ámbito clínico que ayuden a deconstruir colectivamente algunas naturalizaciones basadas en el binarismo de género que han sostenido las definiciones de la psicopatología y su tratamiento en la actualidad. Asimismo, Bacigalupe afirma que “la incorporación real a la práctica clínica del modelo biopsicosocial, así como la implementación de estrategias de promoción de la salud y el bienestar emocional desde un enfoque de salud comunitaria basada en activos, podrían evitar la excesiva patologización y medicalización de los malestares cotidianos al adquirir una visión global sobre la influencia que el contexto social ejerce sobre la salud”.

Referencias:

Amaia Bacigalupe, Unai Martin (2020) Gender inequalities in depression/anxiety and the consumption of psychotropic drugs: Are we medicalising women’s mental health? Scandinavian Journal of Public Health doi: 10.1177/1403494820944736

Amaia Bacigalupe, Andrea Cabezas, Mikel Baza Bueno & Unai Martín (2020) El género como determinante de la salud mental y su medicalización. Informe SESPAS 2020 Gaceta Sanitaria doi: 10.1016/j.gaceta.2020.06.013

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Más psicofármacos a las mujeres para el mismo estado de salud mental se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La gestión de la salud y seguridad en el trabajo de las mujeres

- Salud ósea en estudiantes universitarios

- Consumo de carnes rojas y ubicación del cáncer en mujeres

La historia de Cruz Gallastegui y el maíz híbrido

“Para mantener puras las variedades de maíz deben ser plantadas separadas para que no se crucen.”

Charles Darwin, La variación de los animales y las plantas bajo domesticación, 1875.

.

“En cada campo de maíz hay tanta variedad como en una manada de vacas.”

Mr. Marshall, citado por Charles Darwin. En The rural economy of Yorkshire, Vol. II, London. 1796.

Foto: Markus Winkler / Unsplash

Foto: Markus Winkler / UnsplashEl maíz llegó a Europa en el primer viaje de Colón y , para el 1500, ya había plantaciones en Sevilla. Y el maíz híbrido vino de Estados Unidos a finales de la década de los años veinte del siglo pasado. El maíz, Zea mays, es una planta monoica. Cada pie tiene flores masculinas y femeninas y, en la reproducción, el polen de un pie fecunda los óvulos de la flores femeninas de otros pies. Las flores masculinas, en el ápice de la planta, forman el penacho, y las femeninas, en la mitad del tallo, son la mazorca, con las barbas características que captan el polen.

Una de las variedades híbridas con más éxito es la Corn Belt, del Medio Oeste de Estados Unidos, y se siembra sobre todo en Illinois y Iowa. En esta variedad se basan muchos de los híbridos actuales. Su origen, en el siglo XIX, sigue una historia curiosa, quizá algo novelesca. En esos años, Robert Reid, del sur de Ohio, se instaló en la zona central de Illinois y sembró una variedad de maíz habitual en su lugar de origen, la Southern Dent. En 1846, la semilla maduró mal y la cosecha fue pobre. Resembró la poca semilla que había obtenido para 1847, pero nació mal, con muchos huecos, y en ellos sembró una variedad local, la Northern Flint. Ambas florecieron a la vez, se fecundaron y apareció la nueva variedad híbrida, la Corn Belt.

Pero fue a principios del siglo XX cuando comenzó la búsqueda científica y sistemática de variedades híbridas del maíz para conseguir mayores rendimientos en los cultivos. Ya Darwin había detectado el vigor híbrido, la llamada heterosis o mayor robustez y rendimiento de los híbridos. Uno de los precursores fue William James Beal que publicó en 1880 sus investigaciones sobre maíz híbrido. Consiguió variedades híbridas a partir de semillas de orígenes separados por 150 kilómetros. Las sembró en conjunto y separó la panocha de una de las variedades originales. En el híbrido resultante la mejora en el rendimiento fue del 10% al 21%.

En 1908, con la publicación de los estudios de Edward East, y en 1909, con los de George Shull, se iniciaron los estudios sobre el maíz híbrido. Esta primera fase de estudios llegó a 1925 y los híbridos llegaron a los agricultores y se extendieron por Estados Unidos a partir de 1930.

Foto: Waldemar Brandt / Unsplash

Foto: Waldemar Brandt / UnsplashEl rendimiento de los cultivos de maíz en Estados Unidos se mantuvo estable desde 1830 a 1930, durante en siglo. Se conseguía algo más de una tonelada por hectárea de media. Desde el comienzo de la Segunda Guerra Mundial hasta la década de los cincuenta, el rendimiento se elevó lentamente hasta las 2.5 toneladas por hectárea. En esos años y hasta los sesenta hubo docenas de investigadores trabajando en la teoría y en la práctica, en el uso de la estadística y de la genética cuantitativa para conseguir mejores y más adaptadas variedades híbridas de maíz. En los sesenta y con la llegada al mercado de una gran cantidad de variedades de maíz híbrido, la producción dio un salto hasta más de 10 toneladas por hectárea en 2016, siempre como media.

Se consiguió porque los principales objetivos de estas investigaciones eran abaratar los costes de las semillas y del cultivo, dedicar menos tiempo a los cultivos, impedir los daños de las plagas de insectos, reducir la utilización de insecticidas, buscar semillas estándar y aumentar la tolerancia al estrés.

Los primeros híbridos del maíz llegaron a España con el regreso del agrónomo Cruz Gallastegui Unamuno. En Estados Unidos había trabajado con científicos pioneros como East o Shull y, ya en Galicia, organizó y dirigió la Misión Biológica de Galicia, y uno de sus objetivos era conseguir nuevas variedades de maíz híbrido.

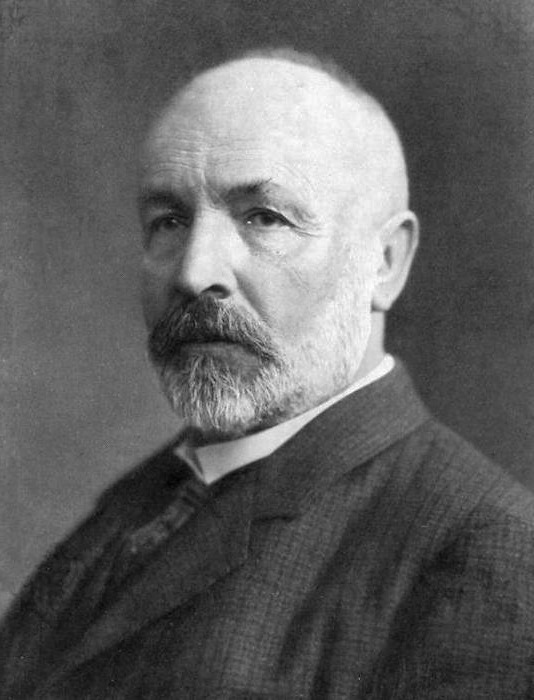

Cruz Gallastequi Unamuno. Foto: Vida Gallega (1932)

Cruz Gallastequi Unamuno. Foto: Vida Gallega (1932)Nacido en Vergara, Guipúzcoa, en 1891, murió en Pazo de Salcedo, Pontevedra, en 1960. Estudió agronomía en Francia y Alemania y, para completar su preparación, visitó centros y universidades de Dinamarca, Suecia, Noruega, México y, finalmente, Estados Unidos, en concreto en Nueva York. Se interesó por las investigaciones en Estados Unidos sobre la genética aplicada a la agricultura y la ganadería. Conoció a Thomas Hunt Morgan, uno de los genetistas más prestigiosos del momento y futuro Premio Nobel en 1933, que le envió a Boston, al laboratorio de Edward East, uno de los primeros científicos que trabajó con maíz híbrido. Conoció los estudios de otro pionero, George Shull, y contactó con William Castle, con el que trabajó durante su estancia en Estados Unidos.

En 1921 volvió a España y, de inmediato, le proponen organizar un centro de investigación en Galicia que, poco después, se llamaría Misión Biológica de Galicia, y que iniciaría sus trabajos en la Escuela de Veterinaria de Santiago de Compostela. Y en ese centro, Cruz Gallastegui comienza a investigar el maíz híbrido.

Cultivó los primeros híbridos de maíz en España y, también, los primeros en Europa, aplicando los métodos que había aprendido y manejado en Estados Unidos. Consiguió híbridos que se utilizaron con éxito en cultivos de Galicia. Ensayó, entre 1921 y 1929, hasta 184 clases de maíz, tanto de Galicia como traídas de Estados Unidos, y seleccionó nueve, de un total de 400 líneas puras, para obtener los híbridos. Consiguió variedades híbridas de maíz con rendimientos de hasta ocho toneladas por hectárea.

Los primeros cultivos de siembra en Galicia y con datos ciertos son de 1929, aunque hay testigos que adelantan la fecha a 1928. Además, en 1918, y durante los estudios de Gallastegui en Estados Unidos, se siembra maíz híbrido, en un entorno familiar, en Galicia y en la huerta de su padre en Vergara.

Las semillas de maíz híbrido producidas en la Misión Biológica se distribuían a los agricultores. Pasaron de 16 toneladas de semillas, en 1930, a 70 toneladas en 1935. Eran de las variedades Pepita de Oro y Reina Blanca.

Una pregunta interesante es saber cuántas semillas de las líneas puras de Gallastegui se conservan. Según Armando Ordás, de la Misión Biológica de Galicia, en 2010 se conservaban semillas de seis variedades: una de origen vasco; una de León que quizá es la Lancaster de la Corn Belt de Estados Unidos; otra es una variedad enigmática etiquetada “H”; dos líneas de la variedad Longfellow; y otra de la variedad Northern White. El resto de las variedades de Gallastegui, simplemente, se han perdido.

Foto: Konyvesotto / Pixabay

Foto: Konyvesotto / PixabayLos híbridos llegaron en cantidad a Europa en la década de los cincuenta, después de la Segunda Guerra Mundial y 20 años después de las investigaciones de Cruz Gallastegui en Galicia. En principio, las variedades híbridas de Estados Unidos no se adaptaron bien a Europa, pero los trabajos de Galicia y en Francia encontraron que los híbridos conseguidos de las variedades lisas locales y las dentadas de Estados Unidos se cultivaron con éxito en Europa. Son las variedades de liso más dentado las más cultivadas en la actualidad.

Como escribía Marshall en el siglo XVIII, las variedades de maíz en un campo de cultivo son tantas como las de vacas en una manada, pero el maíz híbrido se consigue a partir del cruce de las variedades locales, las mejor adaptadas al entorno. Por ello, el Gobierno Vasco, en los años noventa, buscó las variedades locales de maíz en Guipúzcoa. Después de muestrear 3000 caseríos y ensayar el cultivo de 100 poblaciones de maíz, se detectaron siete grupos de variedades locales.

Cuando en los cincuenta llegan las variedades de Estados Unidos, en la siembra se van sustituyendo las semillas tradicionales por las nuevas. En 1950, el maíz se sembraba en casi 400000 hectáreas pero, para 1965, las semillas tradicionales bajaron a 250000 hectáreas y el maíz híbrido ya se siembra en la misma superficie. Y en los noventa, el maíz híbrido sobrepasa las 400000 hectáreas mientras que el tradicional no llegaba a las 100000 hectáreas. En el País Vasco en su conjunto, el rendimiento en 1950 era de 1.5 toneladas por hectárea, en 1985 subía a 2.2 toneladas por hectárea y en los noventa llegaba a 2.9 toneladas por hectárea.

Referencias:

Alvárez, A. & J.I. Ruiz de Galarreta. 1990. Caracterización agronómica de poblaciones locales guipuzcoanas de maíz. Sustrai 21: 43-45.

Beal, W.J. 1880. Indian corn. Report Michigan State Board Agriculture 19: 279-289.

Esperante, B. et al. 2020. Old and new plants from the Americasto Europe: potatoes, corn and the genetics of double hybrid corn (1800-1940). Rural History 31: 53-62.

Etxaniz Makazaga, J.M. 2004. Cruz Gallastegui Unamuno. Un veterinario guipuzcoano en Galicia 1891-1960. Boletín de la Real Sociedad Bascongada de Amigos del País 60: 223-257.

Etxaniz Makazaga, J.M. et al. 2001. Un ilustre veterinario guipuzcoano en Galicia: Cruz Gallastegui Unamuno. VI Jornadas Nacionales de Historia de la Veterinario, Valencia, 16 y 17 de noviembre. 5 pp.

MacRobert, J.F. et al. 2015. Manual de producción de semilla de maíz híbrido. CIMMYT. México, DF. 26 pp.

Ordás, A. 2010. Gallástegui: El nacimiento de la Genética en España. Revista de la Real Academia Galega de Ciencias 29: 207-230.

Ruiz de Galarreta, J.I. et al. 1993. Variedades locales de maíz de Guipúzcoa. Sustrai 28: 29-31.

Wikipedia. 2020. Cruz Gallástegui. 20 septiembre.

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo La historia de Cruz Gallastegui y el maíz híbrido se ha escrito en Cuaderno de Cultura Científica.

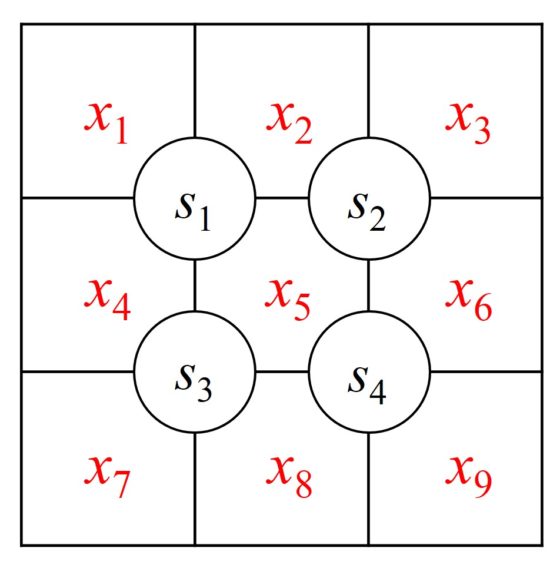

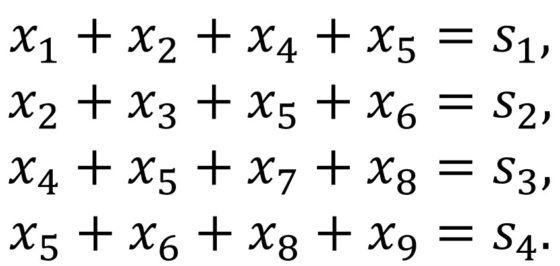

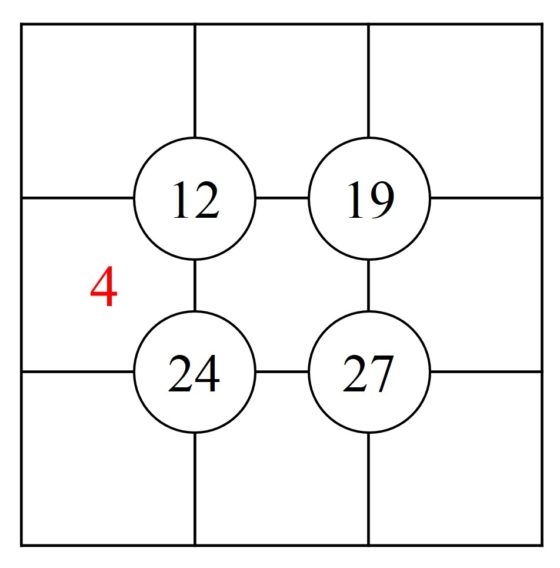

Entradas relacionadas:Más rompecabezas matemáticos con números

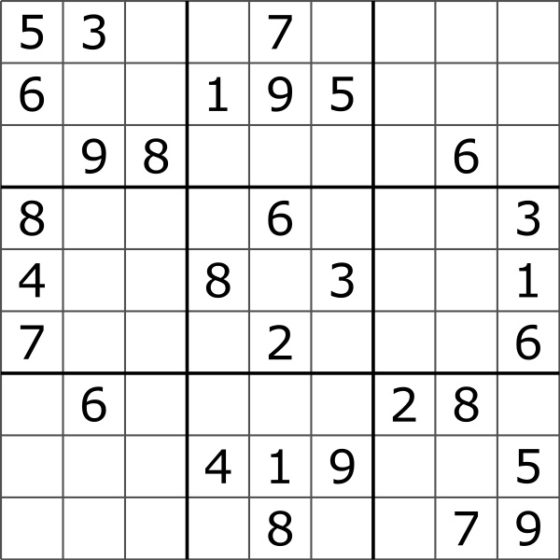

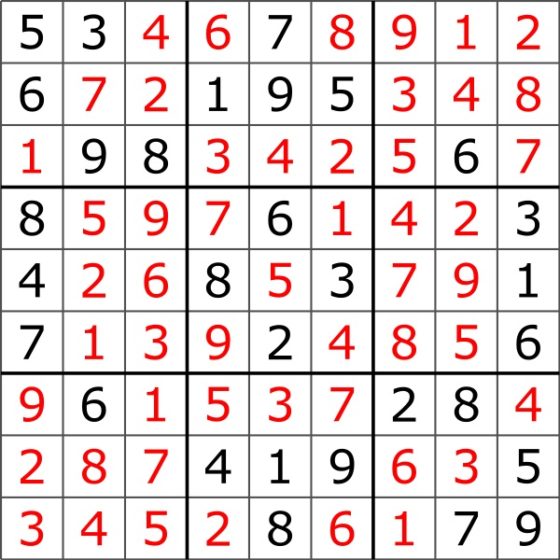

En mi anterior entrada del Cuaderno de Cultura Científica Rompecabezas matemáticos con números presentamos una serie de pasatiempos matemáticos con números relacionados con el sudoku, algunos de los cuales implicaban también las operaciones aritméticas básicas. Estos eran el sujiko, el suko, el KenKen, el Hitori y el conecta los números (o Numberlink).

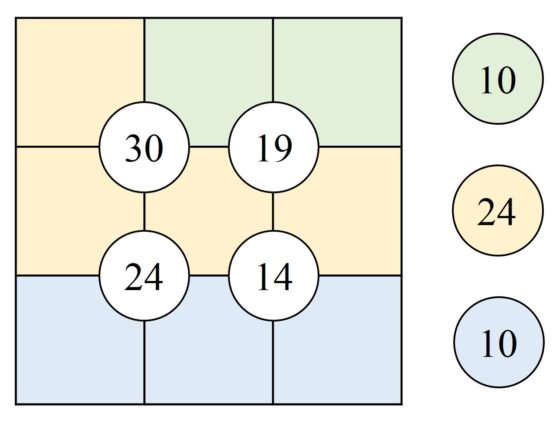

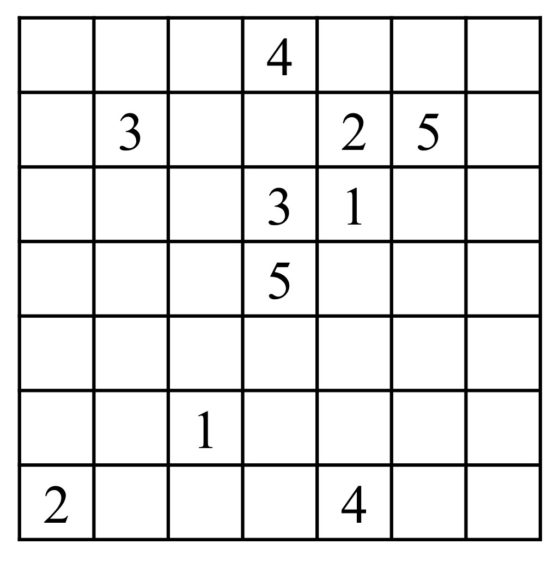

Antes de empezar con esta entrada, os dejo con uno de los rompecabezas que vimos en la anterior, por si queréis pasar un rato agradable resolviéndolo.

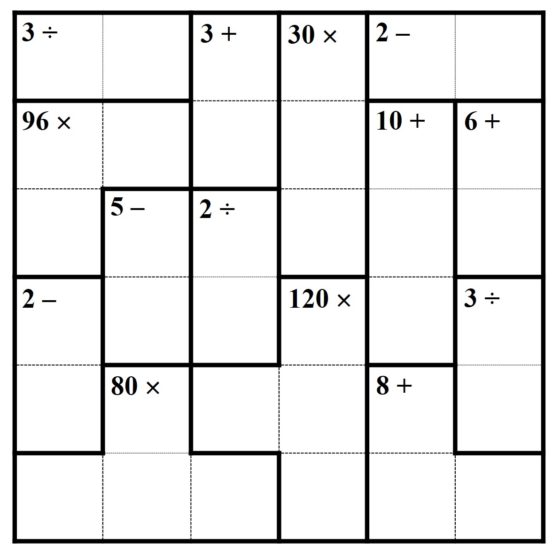

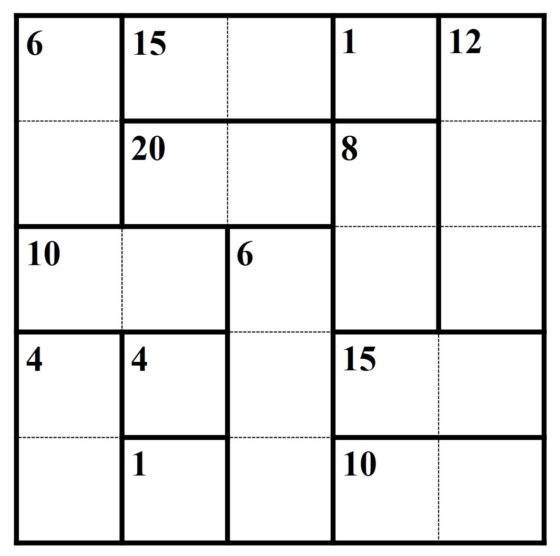

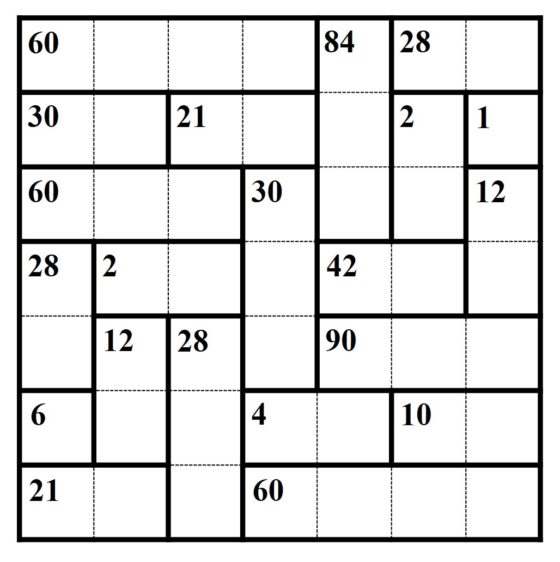

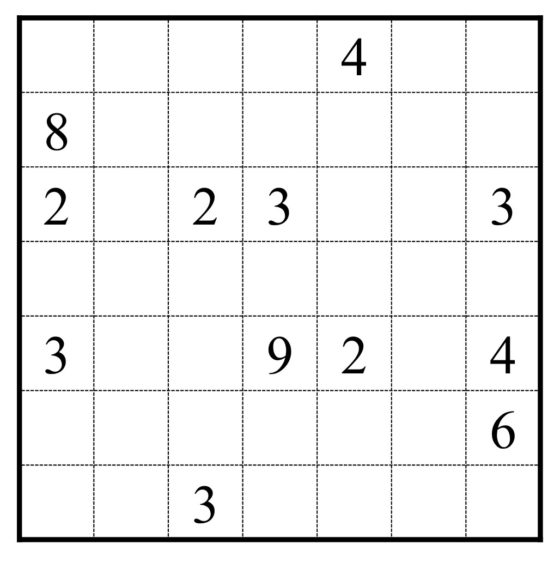

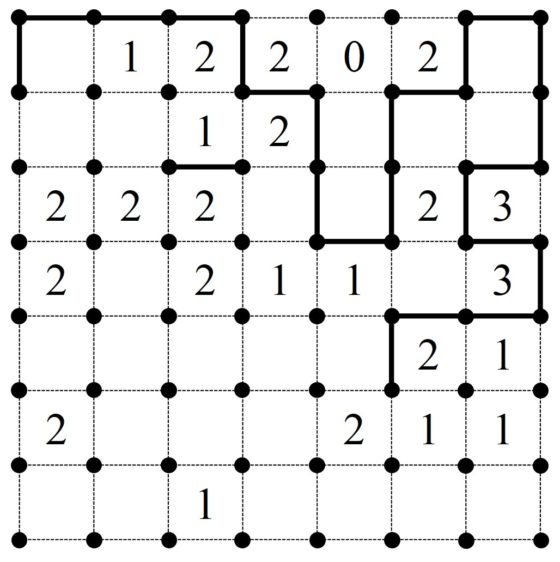

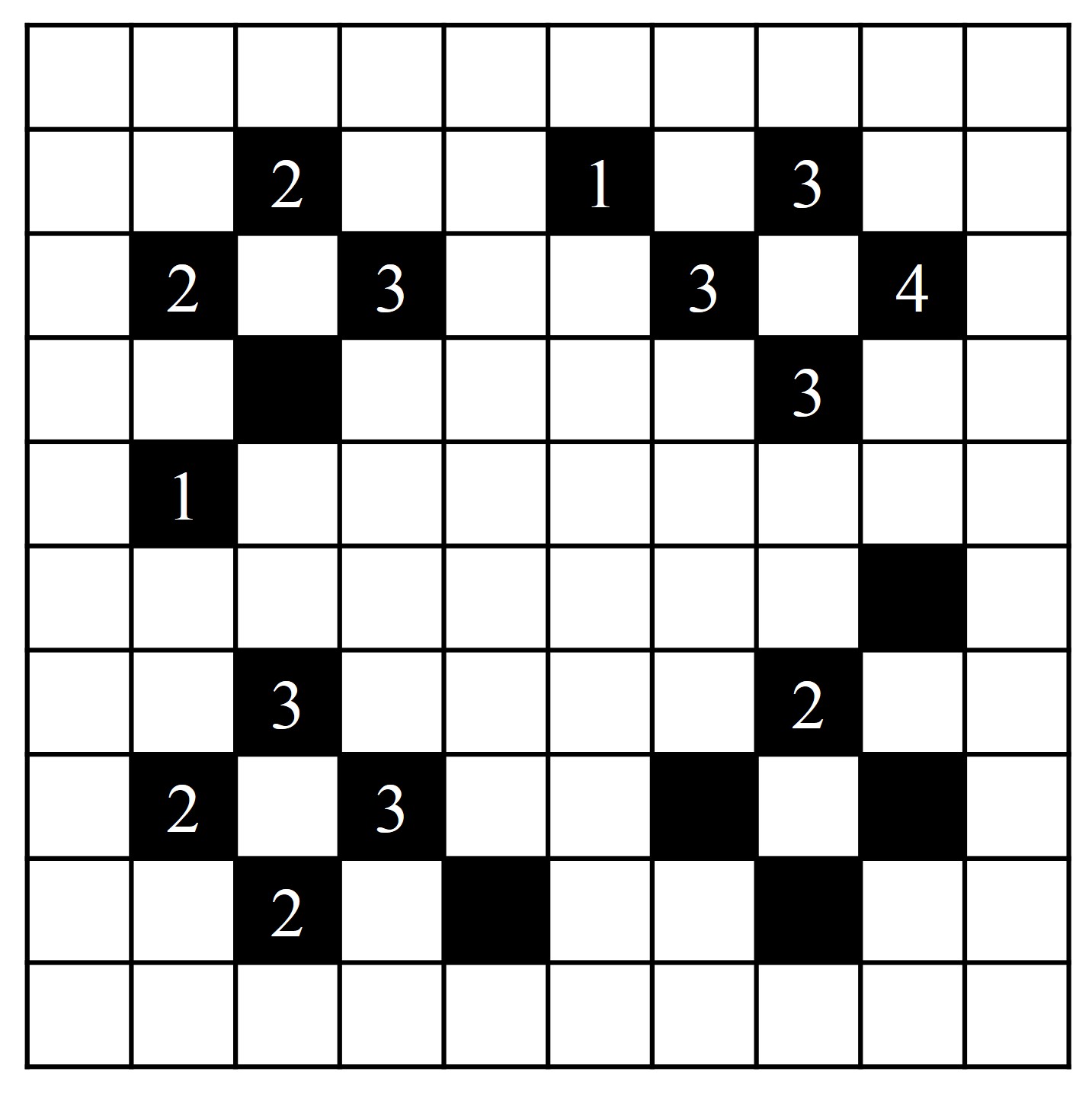

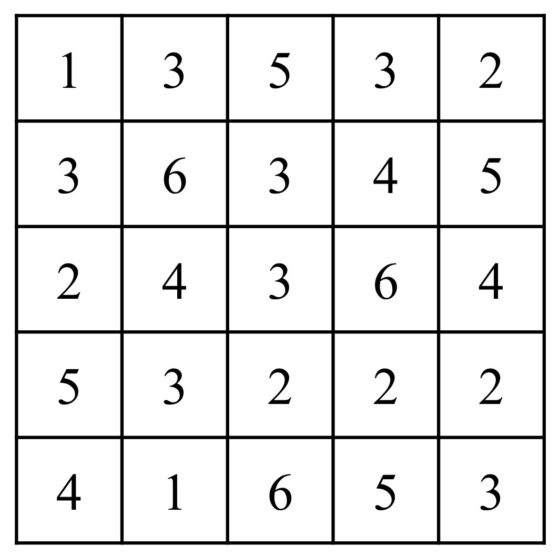

Rompecabezas KenKen: colocar los números de 1 a 6 en las celdas de la retícula de forma que en cada fila y cada columna estén los seis números y no se repita ninguno, pero, además, en cada región se debe obtener el resultado indicado al realizar la operación aritmética dada sobre los números de las celdas de la misma

Rompecabezas KenKen: colocar los números de 1 a 6 en las celdas de la retícula de forma que en cada fila y cada columna estén los seis números y no se repita ninguno, pero, además, en cada región se debe obtener el resultado indicado al realizar la operación aritmética dada sobre los números de las celdas de la misma

En esta entrada vamos a seguir presentando interesantes pasatiempos matemáticos con números. En particular, vamos a centrarnos en algunos de los rompecabezas lógicos de la editorial japonesa Nikoli, especializada en juegos y pasatiempos, de la que ya mostramos algunos en la anterior entrada, el sudoku, el Hitori y el conecta los números. Esta editorial tiene una revista de rompecabezas lógicos, que fue publicada por vez primera en agosto de 1980, llamada también Nikoli, aunque su nombre completo es Puzzle Communication Nikoli, que es una revista de pasatiempos muy importante en Japón, pero que adquirió fama mundial por el sudoku. Además, los rompecabezas de la editorial Nikoli son famosos en todo el mundo.

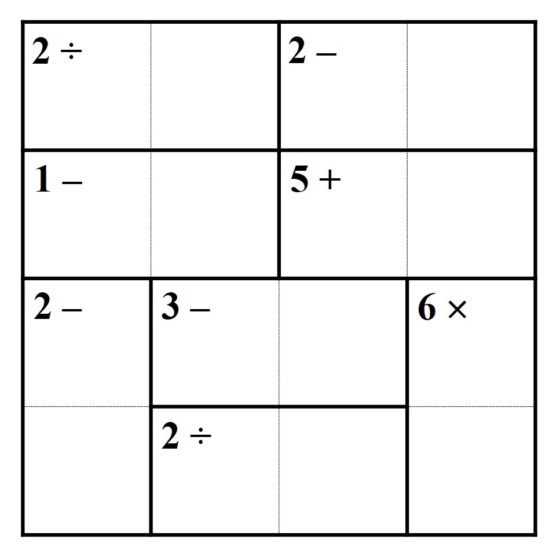

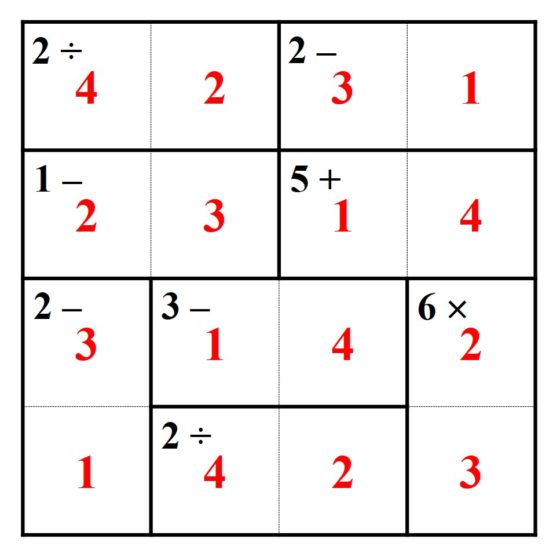

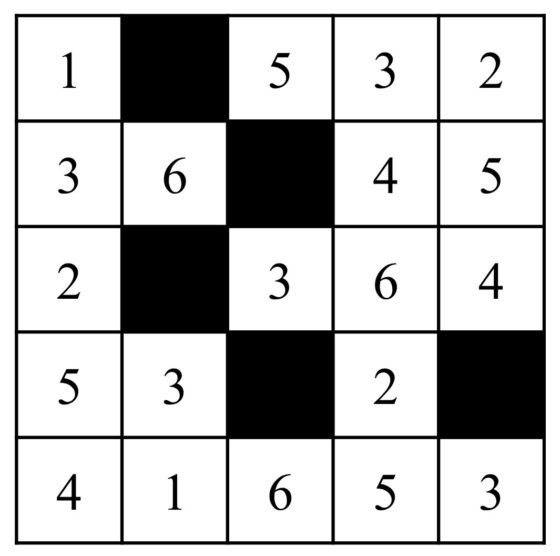

El primero de los juegos que vamos a presentar, denominado inshi no heya (que puede traducirse como Cajas de factorización), es una versión multiplicativa del KenKen, es decir, en todas las regiones que aparecen se considera la multiplicación. Este pasatiempo apareció por primera vez en el número 92 de la revista Puzzle Communication Nikoli.

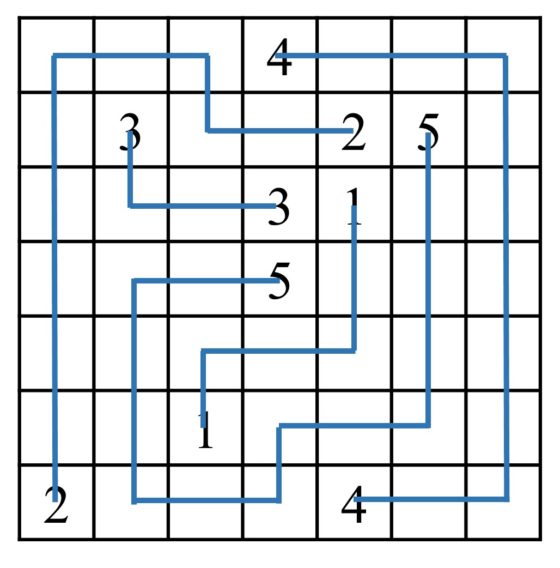

Por ejemplo, tomemos el pasatiempo inshi no heva anterior, que es el que aparece en la página web de la editorial Nikoli, entonces la solución, muy sencilla, es la que vemos a continuación.

Observemos que el nombre “cajas de factorización” viene del hecho de que el número de cada región hay que factorizarlo y las entradas de las cajas son descomposiciones en producto de ese número. Por ejemplo, el 15 en una región con solo dos cajas nos dice que la factorización es 3 x 5 o el 10 es 2 x 5, mientras que en la región con un 8 y dos cajas las posibles factorizaciones son 1 x 8 y 2 x 4. Aunque con retículos más grandes la cosa se complica.

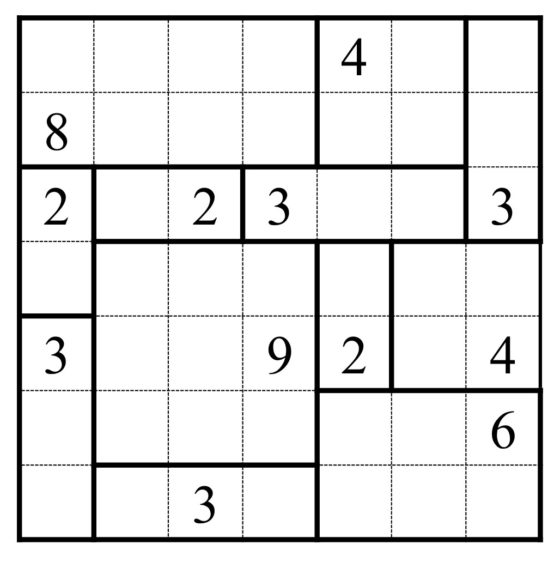

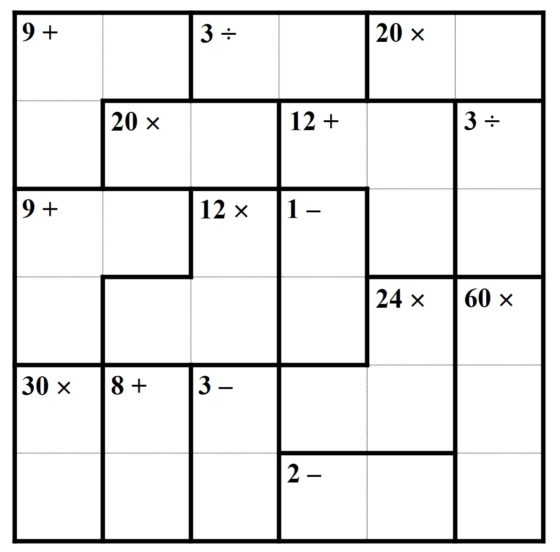

Como hemos hecho con los rompecabezas en la entrada anterior, os dejamos un inshi no heva un poco más grande para que lo resolváis. Tened en cuenta que el objetivo es disfrutar mientras lo resolvéis y sentir el placer del solitario resuelto. En algunas aplicaciones móviles con el juego KenKen se le puede pedir que solo aparezcan multiplicaciones en el rompecabezas, generando así un Inshi no heva.

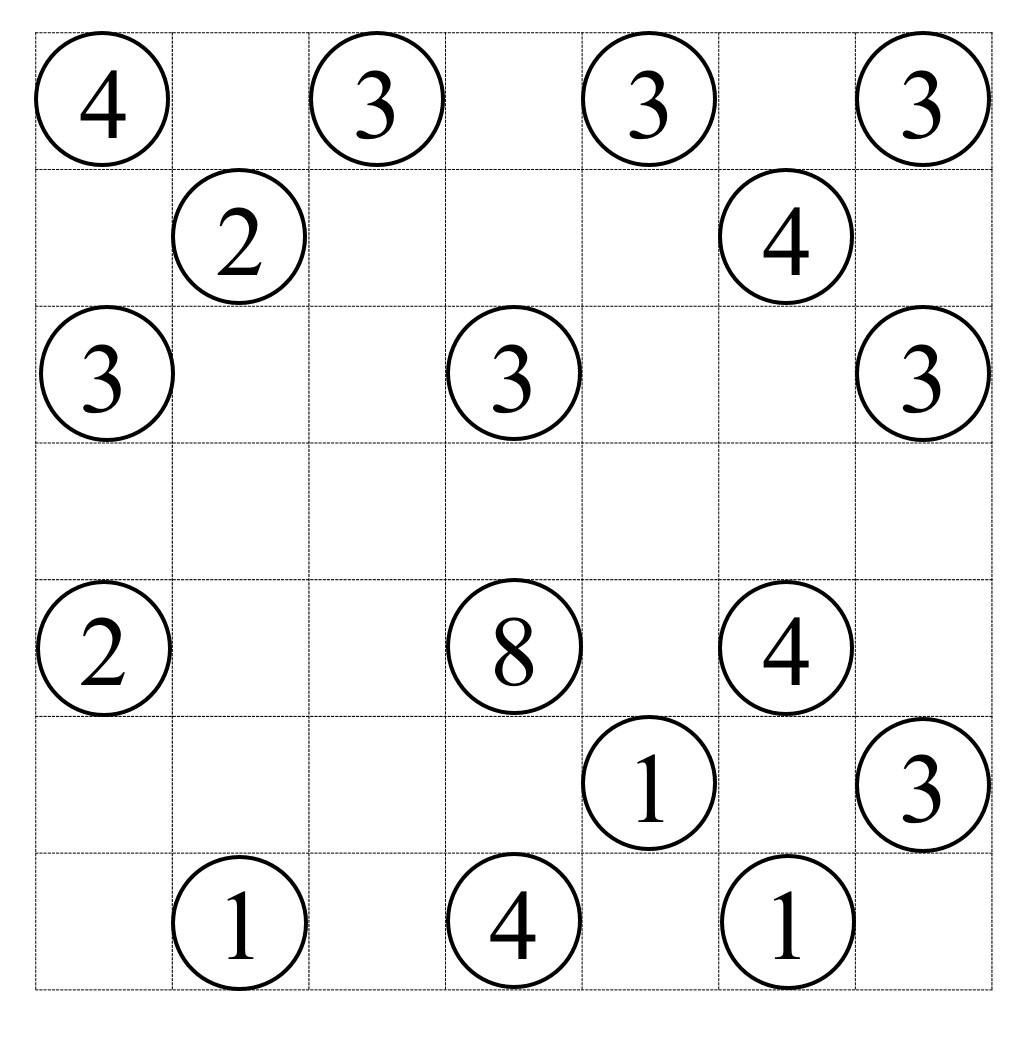

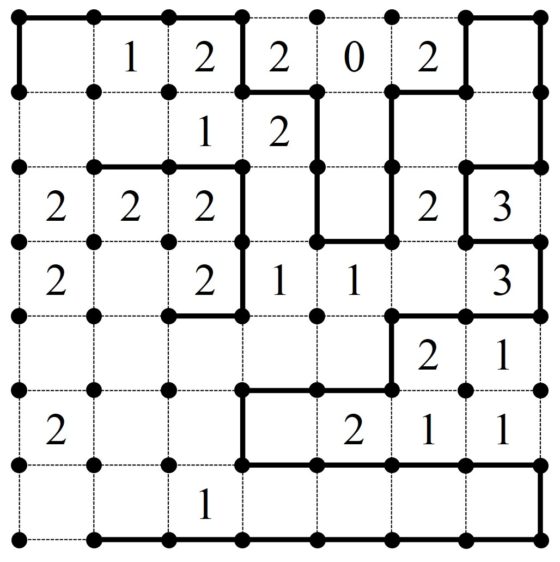

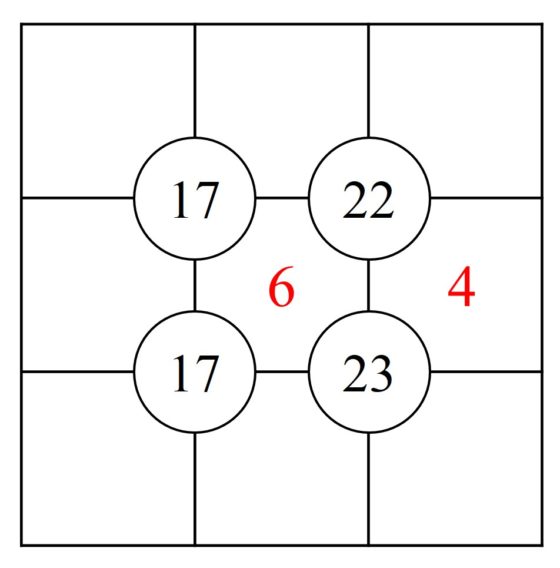

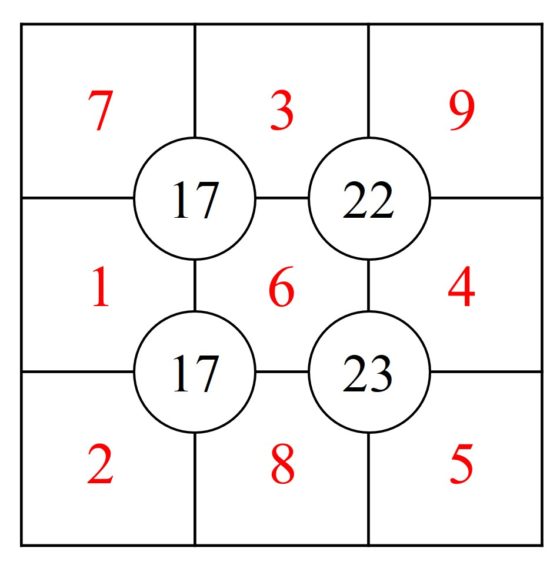

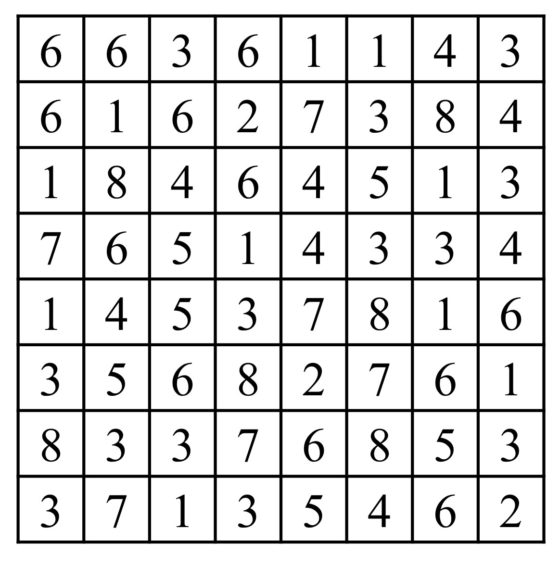

El siguiente pasatiempo de la editorial Nikoli está relacionado con el rompecabezas matemático conecta los números. Es el hashiwokakero (que puede traducirse como ¡construye puentes!), que suele denominarse en inglés bridges (puentes) o chopsticks (palillos). El hashiwokakero apareció por primera vez en el número 31 (septiembre de 1990) de la revista Puzzle Communication Nikoli.

Este pasatiempo está formado por una retícula rectangular, donde algunas celdas tienen números, del 1 al 8, que normalmente están en un círculo y que reciben el nombre de islas, y el resto de celdas están vacías (como se observa en la imagen de abajo). El rompecabezas consiste en conectar las islas mediante una serie de líneas rectas (puentes) que satisfacen las siguientes condiciones:

1.- cada línea recta (puente) conecta dos islas distintas, esto es, empieza y termina en islas diferentes;

2.- cada puente no puede cruzar otro puente o pasar por encima de una isla;

3.- los puentes son horizontales o verticales, pero no diagonales;

4.- dos islas pueden estar conectadas por uno o dos puentes, pero no más;

5.- el número total de puentes que sale de cada isla es igual al número que se indica en la isla;

6.- todas las islas están conectadas en global, es decir, dadas dos islas cualesquiera se puede pasar de una a otra a través de distintos puentes e islas.

Para resolver este ejemplo podemos empezar por la isla de arriba a la izquierda que, al contener el número 4, debe tener dos puentes en horizontal (hacia la derecha) y dos puentes en vertical (hacia abajo). Por lo tanto, las islas que conectan esos puentes, que tienen ambas el número 3, deben de tener otro puente cada una. Claramente la isla con un 3 de arriba tiene que estar conectada con la siguiente isla en horizontal con un puente, ya que en vertical no hay opción. Sin embargo, la isla con un 3 que está a la izquierda, debajo del 4, puede conectarse a priori con un puente tanto en vertical (con otra isla con un 3), como en horizontal (con una isla con un 2), aunque esto último no va a ser posible porque esa isla con un 2 va a estar conectada con la isla con el 8, como vamos a comentar a continuación. Efectivamente, otra pista sencilla es la isla con un 8, que implica que tendrá dos puentes en cada una de las cuatro direcciones posibles. Y si seguimos poco a poco este razonamiento se obtiene la solución.

Una vez más, os dejo un pasatiempo de puentes para que lo disfrutéis, pero podéis encontrar más en algunas de las aplicaciones móviles que hay sobre rompecabezas matemáticos con números.

Más pasatiempos puentes, con diferentes tamaños y dificultades, los podéis encontrar en la página Puentes/Bridges.

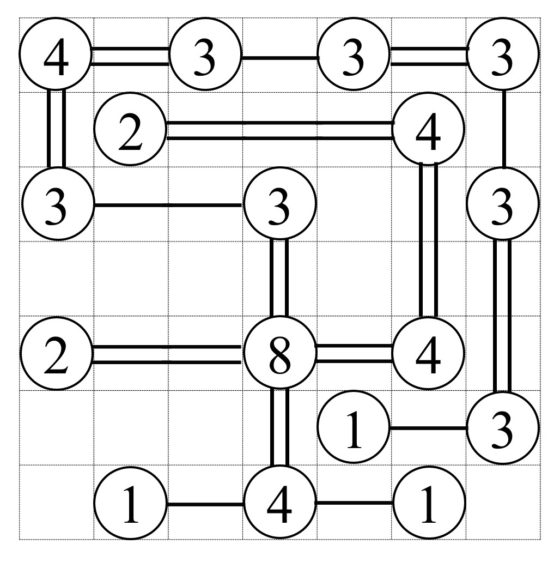

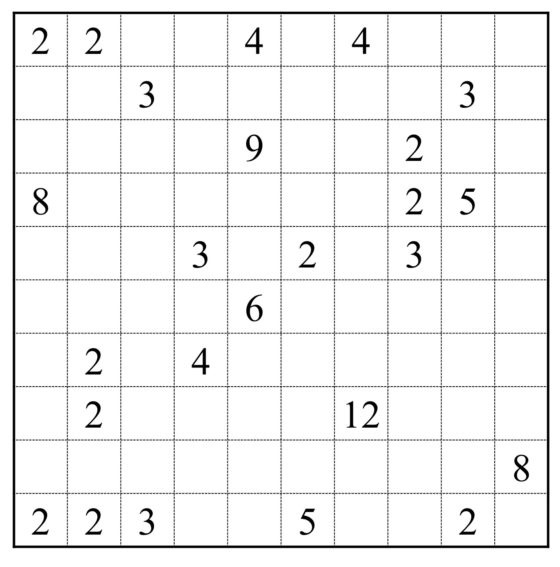

Otro pasatiempo lógico muy interesante tanto para disfrutar resolviéndolo, como para utilizarlo en educación, como todos los que estoy presentando en estas dos entradas, es el Shikaku o divide por cajas. Por ejemplo, con el anterior pasatiempo, puentes, se trabaja tanto la parte lógica, de resolución de problemas, como la parte de factorización de números naturales, mientras que en el divide por cajas se puede trabajar además de la parte lógica, la cuestión de las áreas, pero realmente también trabaja la cuestión de la factorización, aunque más sencilla, ya que el área de un rectángulo es igual a la longitud de la base (número de cubitos de la base) por la de la altura (número de cubitos de la altura).

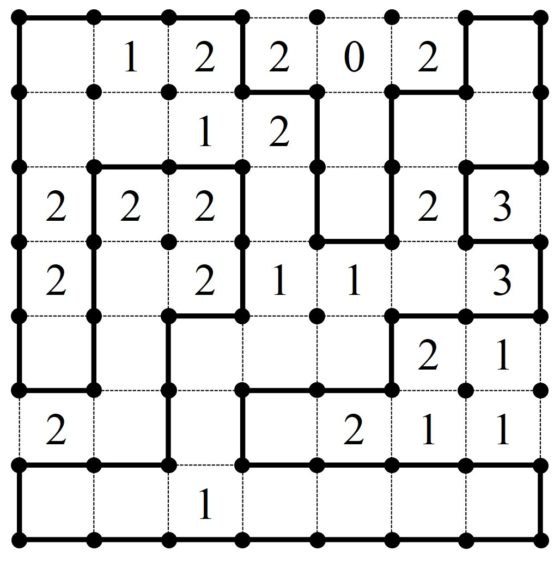

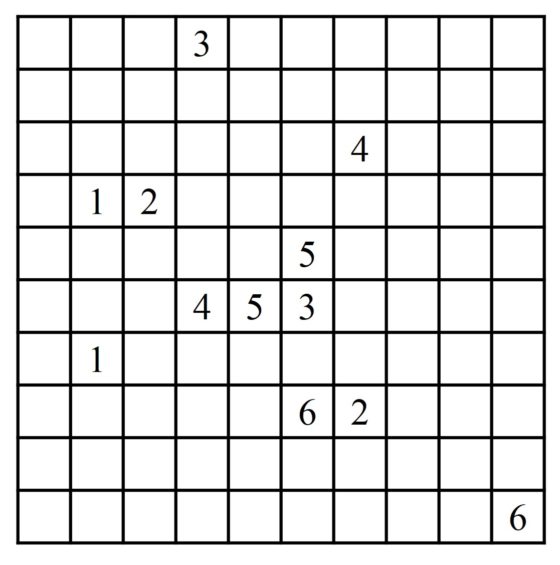

El rompecabezas shikaku está formado por una retícula, con números en algunas de sus celdas, de manera que hay que dividir la retícula en rectángulos de forma que cada rectángulo encierre un número y que la cantidad de celdas del rectángulo (su área) sea igual a ese número. En la imagen de abajo mostramos un ejemplo.

Veamos cómo resolver este sencillo ejemplo, que nos da una idea de qué tipo de razonamiento lógico hay que realizar. Por ejemplo, el 8 que está arriba a la izquierda debe de encerrar un rectángulo con 8 casillas, pero no hay más opción que el rectángulo 4 x 2 apoyado en la esquina superior izquierda, o el nueve que aparece tiene que corresponderse con un cuadrado de lado 3 casillas, pero solo hay un cuadrado posible con 9 casillas que contenga el número 9. Y poco a poco vamos obteniendo todos los rectángulos, como se ve en la siguiente imagen.

Os dejo un nuevo rompecabezas Shikaku, extraído de la página Shikaku.

Otro de los rompecabezas lógicos de la editorial Nikoli es el Slitherlink, también conocido como Loop, es decir, lazo. Una vez más el pasatiempo consiste en una retícula en la que están marcados todos los vértices, como se ve en el siguiente ejemplo, y aparecen números en algunas casillas. Las reglas de este solitario son:

1.- el objetivo es construir un camino continuo y cerrado, un lazo, conectando los vértices adyacentes con líneas verticales y horizontales;

2.- los números indican la cantidad de segmentos pintados que hay alrededor del mismo y cuando no hay números puede ser cualquier cantidad, desde ninguna a cuatro líneas;

3.- el lazo no contiene intersecciones, ni ramificaciones.

El punto de inicio nos lo da la casilla con un 0, ya que no solo no está ninguna de las cuatro líneas alrededor del mismo, sino que tampoco están la línea de encima del 2 de la izquierda, que al continuarla nos daría lugar a una línea alrededor del 0, ni la línea de encima del 2 de la derecha. Por lo tanto, las dos líneas alrededor de esos dos 2s están claras, y las pintamos. A partir de ahí se puede seguir un poco más de una forma lógica y sencilla, teniendo en cuenta que el lazo es un camino continuo. Por ejemplo, un punto intermedio al que se llega fácilmente es el que mostramos en la siguiente imagen.

En este punto, podríamos razonar cómo seguir la línea vertical que está alrededor del 2, abajo a la derecha. No se puede seguir con una línea horizontal hacia la derecha ya que en ese caso el 2 de arriba tendría tres líneas a su alrededor y no se puede continuar con una línea vertical hacia abajo porque ese movimiento dejaría al 1 de la derecha sin líneas o a la línea encerrada en esa esquina sin poder continuarse, luego se continúa con una línea horizontal hacia la izquierda. Esa línea se debe de seguir hacia delante, horizontalmente, para que el 2 no tenga tres líneas a su alrededor, en esa casilla blanca tendremos tres segmentos pintamos y volveremos hacia la derecha para poder pasar por las dos casillas con un 1 en su interior.

Además, el 1 de la casilla central también nos da información para seguir. Para empezar la única línea que puede estar pintada a su alrededor es la vertical de la izquierda y podemos seguir un poco más. En este punto estaremos como se muestra en la siguiente imagen.

Y con un poco más de lógica, teniendo en cuenta las reglas del juego se concluye la solución.

A continuación, os dejo un pasatiempo lazo más complicado que el anterior, que he cogido de la colección de rompecabezas de Simon Tatham.

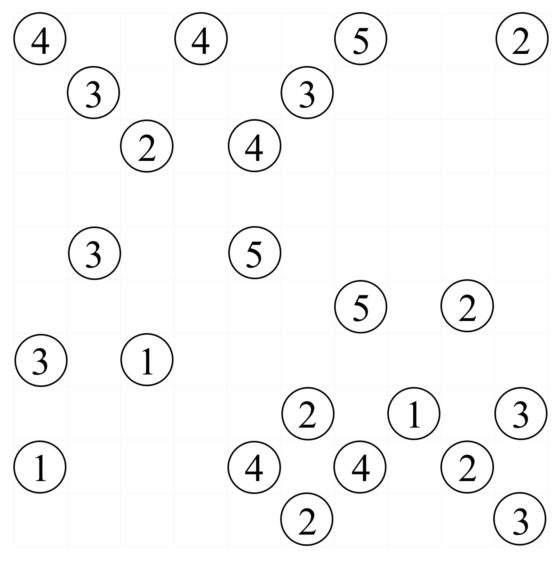

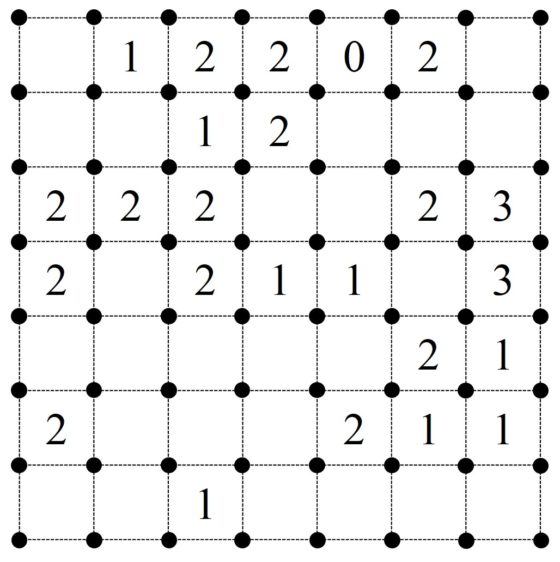

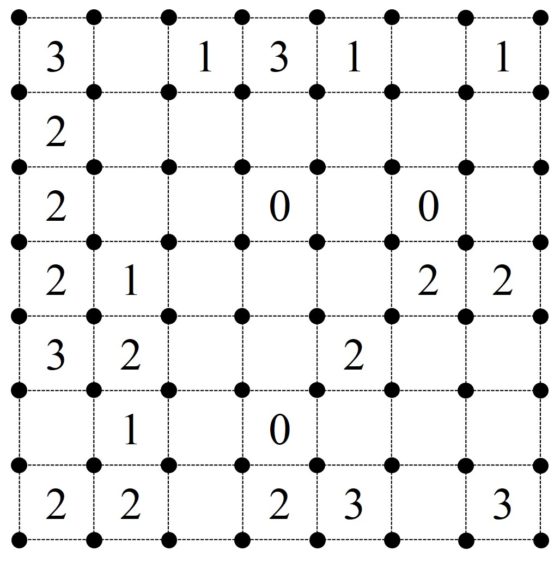

Otro juego solitario de tipo lógico muy interesante, que fue desarrollado por la editorial Nikoli en 2001, es el akari, que en inglés se conoce como Light up, y en castellano, iluminar.

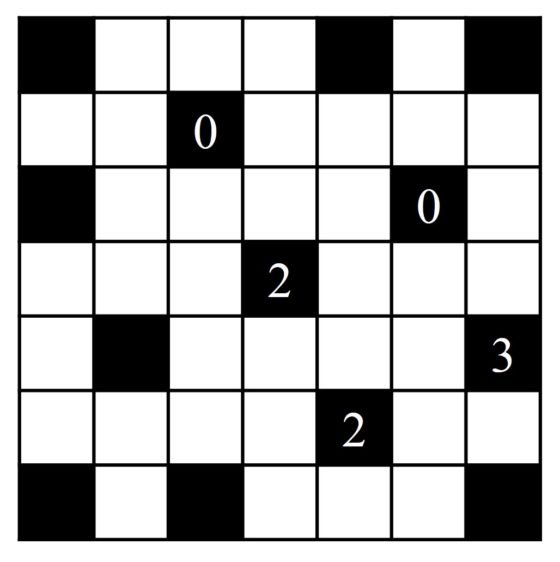

El pasatiempo iluminar consiste en una retícula rectangular con algunas celdas negras y el resto blancas; además, en algunas de las celdas negras hay números. El objetivo del solitario es colocar bombillas (circunferencias) en algunas de las casillas blancas respetando las siguientes reglas:

1.- el número de las casillas negras indica cuantas bombillas están en contacto, horizontal y verticalmente, con esa casilla negra;

2.- cada bombilla ilumina, en horizontal y vertical, todas las casillas que hay desde la bombilla hasta una casilla negra o el límite de la retícula;

3.- todas las casillas blancas tienen que estar iluminadas, pero ninguna bombilla puede iluminar a otra bombilla.

A continuación, mostramos un sencillo ejemplo, extraído de la página Light up, que nos permita entender mejor las reglas de este juego de ingenio.

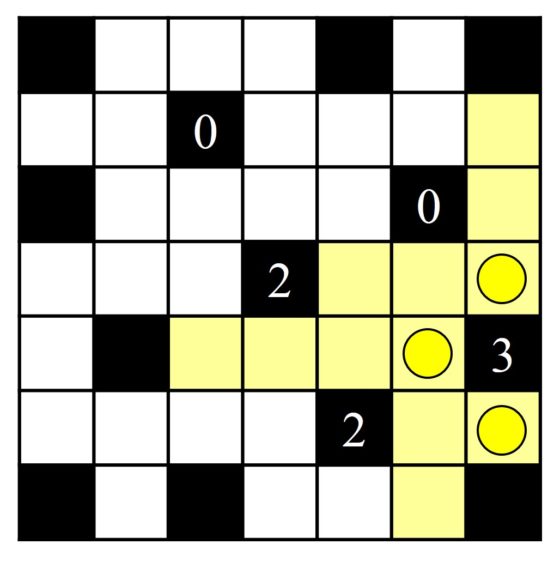

Veamos cómo podemos resolverlo. Para empezar el número 3 de la casilla negra que está a la derecha, hacia abajo, nos dice que tres bombillas están en contacto, horizontal y verticalmente, con ella, pero solo hay tres opciones, luego colocamos esas tres bombillas. En la siguiente imagen mostramos las tres bombillas y las casillas blancas iluminadas por ellas.

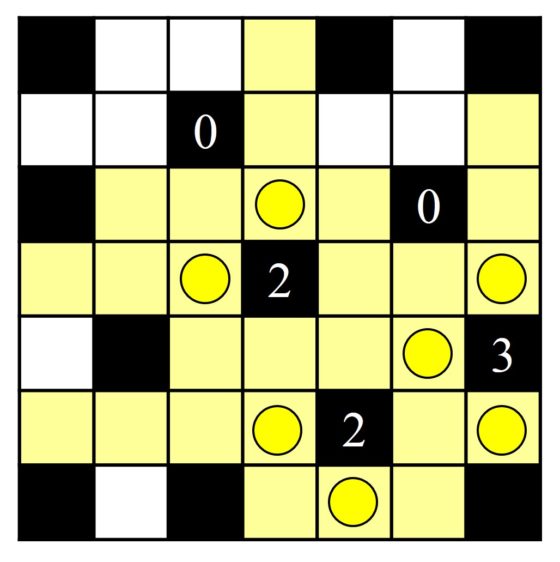

Como las bombillas no pueden iluminarse unas a otras no podemos colocar bombillas en las casillas iluminadas por las anteriores bombillas, por lo tanto, como las dos casillas negras con el número 2 solo tienen dos casillas blancas adyacentes en las que se pueden colocar las bombillas, entonces está claro que debemos colocarlas en esas casillas. La situación entonces, teniendo en cuenta las casillas blancas que iluminan esas nuevas bombillas, es la siguiente.

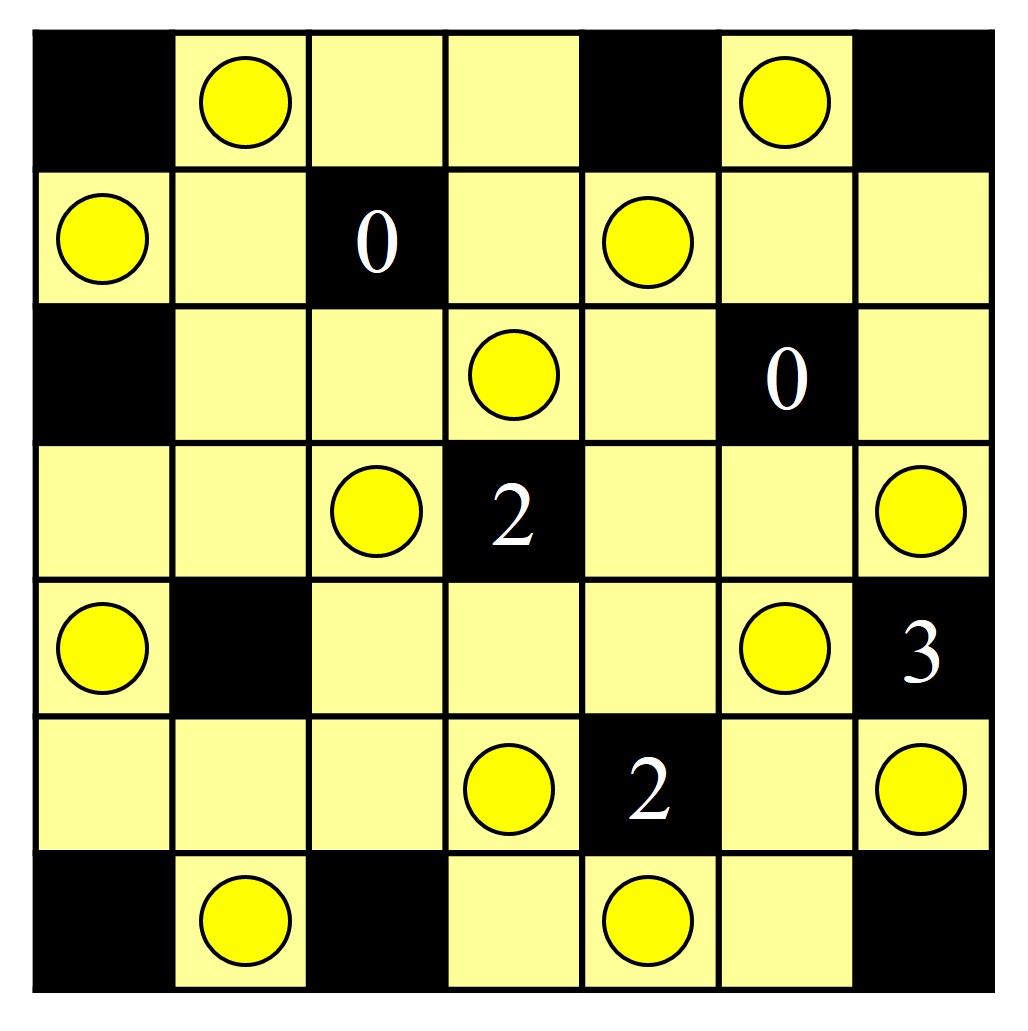

Ahora ya solo nos queda concluir el pasatiempo teniendo en cuenta además que alrededor de las casillas negras con un 0 no puede haber ninguna bombilla, en horizontal y vertical. La solución por lo tanto es la que mostramos.

Y una propuesta para que os divirtáis, también de la página Light up.

Parafraseando a un matemático inglés que ha recibido el premio Abel de matemáticas por la demostración del teorema de Fermat, “creo que lo dejaré aquí”, aunque hay más rompecabezas matemáticos con números muy interesantes de la editorial Nikoli.

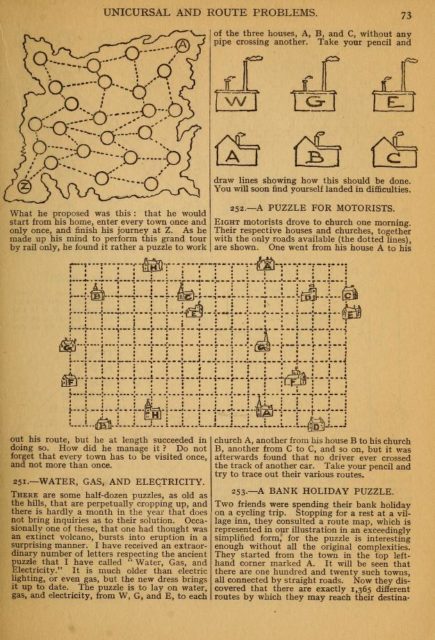

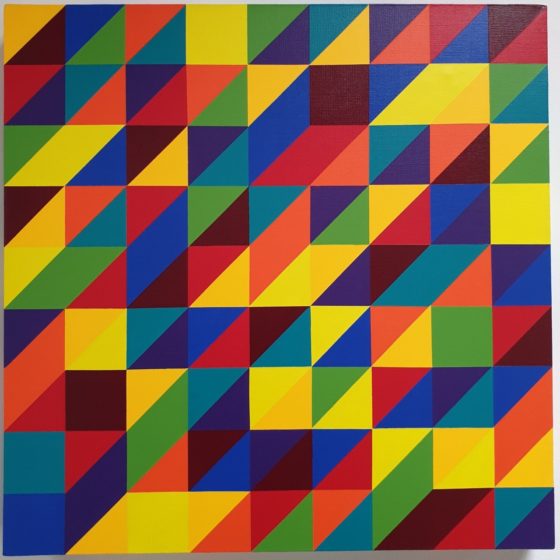

Los tres últimos números de la revista Puzzle Communication Nikoli, de este año 2.020

Los tres últimos números de la revista Puzzle Communication Nikoli, de este año 2.020Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Más rompecabezas matemáticos con números se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Rompecabezas matemáticos con números

- Locura instantánea, un rompecabezas con cubos de colores

- Números errores de impresión

Historia del nailon

En los años 40 del pasado siglo se incluyeron materiales como el rayón, el poliéster y el nailon en la composición del neumático. Curioso, ¿verdad? Los neumáticos no fueron los únicos que integraron este tipo de materiales. Por ejemplo, el nailon está presente en cepillos de dientes, medias, paracaídas, tornillos o cuerdas de guitarra. Este material, una poliamida puramente sintética, fue desarrollado por el equipo del químico Wallace Carothers en los laboratorios DuPont y su descubrimiento supuso una revolución comercial a mediados del siglo XX.

Los vídeos de Historias de la Ciencia presentan de forma breve y amena pasajes de la nuestra historia científica y tecnológica. Los vídeos, realizados para la Cátedra de Cultura Científica de la UPV/EHU, se estrenan en el programa de ciencia Órbita Laika (@orbitalaika_tve), los lunes a las 22:00 en la 2 de RTVE.

El artículo Historia del nailon se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Datación radiométrica

Foto: Aron Visuals / Unsplash

Foto: Aron Visuals / UnsplashUna de las aplicaciones más conocidas de la radiactividad es la determinación de la edad de distintos tipos de materiales, tanto orgánicos como inorgánicos. Es la datación radiométrica o por radioisótopos.

Un isótopo minoritario del carbono conocido como carbono-14 se utiliza a menudo para este propósito. Este isótopo tiene un periodo de semidesintegración de 5.730 años. El isótopo de carbono más abundante es el carbono-12, que es estable. Todos los seres vivos contienen el elemento carbono y todos absorben carbono de su entorno mientras están vivos. La mayor parte del carbono está en forma estable, pero una porcentaje conocido se encuentra en forma de carbono-14 [1]. Cuando un ser vivo, como un músculo o un árbol, muere, deja de absorber carbono nuevo, mientras que el carbono 14 de sus células sufre una desintegración radiactiva. A medida que avanza el tiempo, la cantidad de carbono-14 en el árbol muerto, o un trozo de madera del árbol, disminuye debido a su desintegración radiactiva. Al comparar la cantidad de carbono-14 restante con la cantidad que normalmente se encuentra en los árboles vivos de esa especie, los científicos pueden determinar su edad aproximada usando su periodo de semidesintegración. Por ejemplo, si solo queda la mitad de la cantidad original de carbono 14, entonces el árbol tiene aproximadamente 5.730 años.

Este fue el método utilizado para determinar la edad de Ötzi, el hombre de Similaun, un hombre prehistórico que fue encontrado tras haber estado congelado durante siglos en el hielo de un glaciar de los Alpes. El glaciar se derritió, poniendo al descubierto el cuerpo del hombre muerto. Los científicos determinaron que la cantidad de carbono-14 que quedaba en su cuerpo y en los objetos encontrados con él era un poco más de la mitad de lo que sería si estuviera vivo. Así situaron el momento de su muerte hace unos 5.300 años; es el cuerpo humano conservado [1] más antiguo jamás encontrado.

El carbono-14 radiactivo se ha utilizado con gran éxito hasta la fecha en materiales que alguna vez estuvieron vivos, pero está limitado a períodos de tiempo de miles de años. Esto se debe a que cuantas más vidas medias pasan, menor es la cantidad de átomos de carbono-14 que quedan. El error estadístico aumenta enormemente, por tanto, para periodos extremadamente largos de tiempo.

Para escalas de tiempo mucho más largas, del orden de millones o incluso miles de millones de años, los científicos han recurrido a la propia serie de desintegración del uranio-238. El isótopo que da inicio a la serie, el uranio-238, tiene una vida media de aproximadamente 4.500 millones de años. Esta es también la edad aproximada de la Tierra, por lo que todavía queda en el planeta aproximadamente la mitad del uranio que había cuando se formó la Tierra hace unos 4.500 millones de años [2].

Ha pasado suficiente tiempo para que toda la serie del uranio-238 se haya activado y se acumule una cantidad sustancial del producto final, el isótopo estable de plomo, el plomo-206. Sin embargo, el isótopo más común del plomo es el plomo-208, mientras que el plomo-206 surge solo de la serie de desintegración. De ahí que las cantidades de uranio-238 y plomo-206 presentes en rocas antiguas en las que se encuentran asociados los restos de criaturas prehistóricas, como los dinosaurios, se pueden usar para determinar la edad aproximada de estas rocas, y a partir de ella la edad aproximada de los fósiles de dinosaurios.

Notas:

[1] Exacto: respiras radiactividad e incorporas isótopos radiactivos a tu cuerpo continuamente.

[2] Vulgo, momia.

[3] Gran parte del uranio original contribuyó a la temperatura de la Tierra desde el inicio y, de hecho, la cantidad total de materiales radiactivos total en la Tierra ha evitado que esta esté mucho más fría de lo que hubiera estado después de su formación. Existe la vida en el planeta gracias a la radiactividad.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Datación radiométrica se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Los nuevos ‘elementos’ de las series radiactivas

- El concepto de isótopo

- Las series de desintegración radiactiva

¿Cómo mejorar la comunicación entre las matemáticas y las ciencias de la vida?

Pablo Rodríguez Sánchez

A modo de preámbulo

Durante el periodo 2015-2019, trabajé como matemático para un departamento de biología. Mi tarea era llevar a cabo una investigación que acabaría convirtiéndose en mi tesis doctoral. Este texto es una adaptación y traducción al castellano de parte del último capítulo de dicha tesis. La tesis completa, “Cycles and interactions. A mathematician among biologists”, está disponible aquí.

Esta simbiosis entre biólogos y matemáticos, aunque pueda parecer exótica a primera vista, tiene una larga historia. El matemático Leonardo Pisano, más conocido como Fibonacci, creó su famosa secuencia (), muy popular entre los matemáticos aficionados, para describir un problema de cría de conejos. Esto sucedía en una fecha tan temprana como 1202.

El conocimiento matemático ha evolucionado mucho desde el siglo XIII. El corazón de las herramientas matemáticas utilizadas por los biólogos modernos, esto es, el cálculo infinitesimal, fue desarrollado en el siglo XVII por Isaac Newton y Gottfried Leibniz, con el propósito de resolver problemas mecánicos. El gran matemático Leonhard Euler y el economista y demógrafo Thomas R. Malthus, dos de los pioneros en el uso de las ecuaciones diferenciales para arrojar luz sobre problemas biológicos, ya habían publicado sus obras de dinámica de poblaciones antes de que el siglo XIX viera la luz.

La colaboración interdisciplinar entre matemáticas y ciencias de la vida goza, a día de hoy, de una excelente salud. Algunos de los nombres más influyentes de la ecología de los siglos XX y XXI tienen formación en matemáticas (como Robert MacArthur, Simon Levin o Alan Hastings) o física (como Robert May).

El acceso cada vez más fácil y barato a los supercomputadores, sumado a la necesidad cada vez mayor de añadir técnicas como la programación y el análisis de datos a los currículos investigadores, anuncian un futuro en el que las habilidades técnicas necesarias en un laboratorio biológico difieren cada vez menos de las que uno encontraría en un departamento de físicos o matemáticos aplicados. Cabe esperar, pues, que esta simbiosis entre matemáticos y biólogos se mantenga sólida, e incluso se vuelva más estrecha, en el futuro cercano.

El presente texto ofrece algunos consejos para biólogos y matemáticos (entendidos aquí como profesionales con afinidad por las matemáticas, incluyendo por ejemplo a físicos e ingenieros) interesados en explorar “el otro lado”. Contiene la clase de consejos que me hubieran venido bien en 2015, cuando me sumergí en el mundo de la biología con esa suicida candidez tan habitual en los físicos novatos como el que yo era entonces.

Las matemáticas se perciben a menudo como un tema árido y difícil, tanto por los profesionales de la ciencia como por el público general. Por otro lado, independientemente de si nos gustan o no, las matemáticas se utilizan en prácticamente cualquier rama del conocimiento humano, y nunca faltan en los proyectos multidisciplinares.

Disciplinas diferentes llevan asociadas no sólo un conjunto de conocimientos de base distintos, sino también una cultura académica diferente. Cuando uno cruza las fronteras entre disciplinas académicas, aprender los nuevos datos y protocolos requiere ni más ni menos que tiempo y estudio, pero aceptar y adaptarse a una cultura diferente puede ser mucho más difícil y no se aprende en los libros.

Como sucede con cualquier cultura, los matemáticos y los biólogos difieren ligeramente en lenguaje, valores, normas e intereses. Como suele suceder en la comunicación intercultural, es muy fácil caer en malentendidos, y cada subgrupo posee mitos y prejuicios respecto al otro.

Foto: Michael Dziedzic / UnsplashConsejos para biólogos trabajando con matemáticos

Foto: Michael Dziedzic / UnsplashConsejos para biólogos trabajando con matemáticos

Invierte en matemáticas aplicadas

Cuando hablamos de matemáticas aplicadas no nos referimos necesariamente a matemáticas sencillas. El adjetivo “aplicadas” o “puras”, acompañando a la palabra “matemáticas”, nos habla del objeto que queremos estudiar, pero no nos dice nada sobre su dificultad. De hecho, el arsenal matemático necesario será tan complejo como lo sea su objeto de estudio.

Veamos un ejemplo. Puede ser frustrante darse cuenta de que es necesario familiarizarse con los tensores de segundo orden (una herramienta matemática particularmente complicada) si uno quiere estudiar mecánica de fluidos. Los matemáticos no utilizan esta herramienta por perversidad ni para torturar a los recién llegados, sino porque los tensores son la herramienta más sencilla posible para estudiar un fenómeno complejo que no podemos esquivar si queremos estudiar fluidos: la deformación.

La dificultad nos la da el fenómeno que estemos estudiando, no la herramienta que usemos.

Las ecuaciones y el rigor no son instrumentos de tortura

Según la célebre frase del prefacio de “Breve historia del tiempo”, de Stephen Hawking, por cada ecuación impresa en un libro la audiencia potencial se divide entre dos.

Nos gusten o no, las ecuaciones y el lenguaje matemático son a menudo la mejor manera de comunicar y compartir información compleja de una manera práctica y compacta. Es una buena idea invertir algo de tiempo en aprender a leerlas. Los análisis detallados y rigurosos, por otra parte, a menudo hacen falta para dar con detalles difíciles de abordar desde la intuición.

Es importante saber también que la misma ecuación puede ser escrita de diferentes maneras, siendo todas ellas correctas. Eso sí, algunas serán más claras que otras. Un uso consistente de mayúsculas o minúsculas (por ejemplo, mayúsculas para variables de estado, minúsculas para parámetros), subíndices y superíndices, la definición de funciones auxiliares, una alineación lógica de ecuaciones relacionadas y otras reglas sencillas pueden incrementar enormemente la legibilidad de una publicación.

La clave del modelado es la simplificación

La simplificación es el corazón del modelado matemático. Y no es fácil. En la fase de diseño de un modelo matemático de un sistema biológico la comunicación es clave. Quizá a algunos les sorprenda saber que, a la mayoría de matemáticos, la forma de hablar de los biólogos a menudo les resulta abrumadora. Los biólogos tienden a proporcionar demasiada información.

Al tratar con matemáticos es aconsejable centrarse más en las ideas que en los detalles. Es fácil minusvalorar la dificultad de la biología. Como regla general, los detalles experimentales pueden omitirse: un matemático simplemente dará por sentado que los resultados experimentales son correctos.

Otra idea recomendable es tratar de resumir el proceso de investigación en términos de entradas, procesos y salidas. Esto es muy práctico no sólo para mejorar la comunicación interdisciplinar, sino también para diseñar experimentos o incluso para estructurar un texto.

Foto: Markus Spiske / UnsplashConsejos para matemáticos trabajando con biólogos

Foto: Markus Spiske / UnsplashConsejos para matemáticos trabajando con biólogos

Haz las paces con la incertidumbre

Debido a la complejidad del objeto de estudio, es un error esperar la misma precisión de un modelo biológico que de un modelo físico. Olvida todo lo que aprendiste en la escuela de matemáticas, física o ingeniería. Los tiempos dorados en los que descartabas cualquier resultado con un inferior a han pasado. Ahora trabajas con sistemas biológicos y, por lo tanto, complejos. Los modelos funcionan lo mejor posible, ni más ni menos. Además, estos modelos rara vez permiten ser formulados de manera elegante o resueltos de forma analítica.

Explica tus motivaciones

Cuando estés explicando un método matemático, jamás comiences introduciendo una idea de forma genérica. En su lugar, comienza siempre por explicar la utilidad de lo que va a venir a continuación, a ser posible usando ejemplos concretos. Tu audiencia perderá rápidamente la motivación si no les convences rápido de que lo que vas a explicar les servirá de algo.

Una experiencia particularmente elocuente me sucedió explicando el producto matricial a un grupo de biólogos. Es un tema especialmente aburrido que normalmente se presenta como una regla que hay que memorizar. En su lugar, decidí abordarlo de una forma diferente: primero, provoqué que los estudiantes comprendieran la necesidad de utilizar una notación compacta para uno de sus problemas prácticos. Hice esto pidiéndoles que escribieran, línea a línea, varios modelos de competición de especies de plancton con cada vez mayor número de especies. Posteriormente, les mostré cómo las aparentemente arbitrarias reglas del producto matricial resuelven precisamente esta necesidad.

Al presentarlo de esta manera, los estudiantes entendieron que la herramienta matemática tratada en la clase resolvía un problema que ya tenían, en lugar de crear uno nuevo (el de tener que aprenderla). Además, las explicaciones acerca de por qué la regla es como es ayudó a fijar sus conocimientos.

Las demostraciones asustan

Quizá pienses que las demostraciones no deberían asustar a nadie, pero el hecho es que lo hacen. Una demostración es una suerte de viaje, un viaje desde un conjunto de ideas de partida hasta una conclusión, y es importante que tus colaboradores disfruten del camino.

A menudo, las demostraciones pueden ser sustituidas usando un enfoque gráfico o intuitivo. Algunos detalles podrían caerse por el camino, pero normalmente la simplificación vale la pena. Podrían, pero no tienen por qué: piensa que los Elementos de Euclides, probablemente el libro de matemáticas más influyente de la historia, contiene principalmente demostraciones geométricas y, por tanto, visuales.

En caso de que una demostración sea realmente necesaria, es importante esforzarse en explicar la notación y todos los pasos. La forma más rápida de frustrar a la audiencia es usando la palabra trivial, que debe ser evitada a toda costa. Cuando se escriba para una revista científica no especializada en matemáticas, es buena idea relegar las demostraciones al apéndice y simplemente mencionarlas en el cuerpo. Del mismo modo que los matemáticos no pondrán en duda los métodos experimentales de los biólogos, los biólogos rara vez pondrán en duda la corrección de las demostraciones.

Usa la visualización todo lo posible

Aprovéchate del sistema de adquisición de información más avanzado de la naturaleza: la visión. Ilustra tus ideas con gráficas, o incluso con películas o animaciones cuando sea posible. Si son buenas, pueden incluso reemplazar a una ecuación.

Foto: Jacinto Román / UnsplashConsejo para ambos

Foto: Jacinto Román / UnsplashConsejo para ambos

Comunica tu ciencia

Si te parece que la comunicación entre disciplinas es complicada, intenta comunicar tu disciplina a un público general. No solamente te darás cuenta de que es aún más difícil, sino que además mejorará sustancialmente tus habilidades comunicativas.

A día de hoy existen multitud de posibilidades, desde blogs a eventos, en los que poner en práctica esta habilidad. La práctica de la comunicación científica nos obliga a familiarizarnos de una manera muy profunda el contenido a comunicar. Nos fuerza a eliminar lo superfluo, identificar qué partes son complicadas para la audiencia y por qué, además de adelantarnos a sus preguntas y dudas. Hacer comunicación científica requiere, en una palabra, comprender.

Sobre el autor: Pablo Rodríguez Sánchez es doctor en matemáticas aplicadas e ingeniero de software de investigación en el Netherlands eScience Center (Amsterdam, Países Bajos)

El artículo ¿Cómo mejorar la comunicación entre las matemáticas y las ciencias de la vida? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El problema de Josefo o cómo las matemáticas pueden salvarte la vida

- Las matemáticas como herramienta (IV): De la grandeur a las matemáticas puras

- El límite entre la vida y la muerte en las neuronas

Los animales entienden la muerte más de lo que se pensaba

Antonio José Osuna Mascaró y Susana Monsó

Unsplash/Tandem X Visuals

Unsplash/Tandem X Visuals

Dorothy había tenido una vida durísima, una que no desearíamos a nadie. Mataron a su madre cuando ella era muy joven, y a ella se la llevaron para venderla a un parque de atracciones en Camerún. Pasó 25 años de su vida entre cadenas, burlas, alcohol y tabaco. Finalmente fue rescatada y llevada al centro de rescate Sanaga-Yong, y allí pudo hacer las paces con el mundo. Por fin ocho años de calma, se había acabado el sufrimiento. Estos años le sirvieron para reconstruirse, entablar fuertes amistades y acabar por convertirse en una figura respetada y amada por su nueva comunidad de chimpancés.

Dorothy, una chimpancé que se aproximaba a los 50 años de edad, murió de un paro cardiaco el 23 de Septiembre de 2008, pero falleció entre sus seres queridos. Monica Szczupider, una voluntaria del centro de rescate, inmortalizó aquel momento con una fotografía que en 2009 daría la vuelta al mundo gracias a National Geographic.

Los chimpancés de aquella comunidad se amontonaban tras una verja de metal, cada uno de ellos protagonista de una historia terrible con final agridulce. Contemplaban emocionados, manos sobre los hombros de sus compañeros, cómo los cuidadores del centro se llevaban para siempre el cuerpo sin vida de Dorothy.

El éxito de aquella fotografía era quizás predecible. Era muy fácil conectar con la escena. Un individuo querido y respetado era retirado para siempre, ante la impotencia de una sociedad que observaba con las emociones a flor de piel.

Cuidado con el antropocentrismo

El estudio de las reacciones de otras especies ante la muerte es una especialidad a la que llamamos “tanatología comparada”, y tiene una historia muy reciente. Desde las detalladas y conmovedoras descripciones de Jane Goodall, hasta rocambolescas propuestas experimentales actuales con las que se pretenden estudiar las reacciones de los animales ante situaciones extrañas e inesperadas, como altavoces que emiten la voz de elefantes muertos y cabezas animatrónicas.

La tanatología comparada es un campo muy centrado en los primates, y lo es por varios motivos que pueden resumirse en uno: nosotros somos primates.

La muerte tiene una importancia enorme para nosotros y, si vamos a estudiar la forma en la que otras especies reaccionan ante ella, es esperable que nos centremos en aquellas que están lo más cerca posible. Esto obedece a cierta parsimonia evolutiva, pero también a un sesgo que empapa profundamente nuestro pensamiento: el antropocentrismo, una suerte de egocentrismo extendido a todo lo que nos recuerda a nosotros.

En nuestro reciente artículo defendemos que existen dos formas de antropocentrismo que se han interpuesto en el desarrollo de la tanatología comparada. Nos hemos estado equivocando por el efecto distorsionador de dos prismas a través de los cuales observamos el mundo natural: un antropocentrismo intelectual y otro emocional.

La muerte es de una importancia máxima para cada uno de nosotros. El dolor que acompaña la pérdida de un ser querido solo es comparable al terror que despierta el silencio absoluto que nos espera a todos. El miedo resultante ha dado lugar a toda clase de creencias para sofocarlo, con las que nos sentimos fuertemente identificados. Algo tan cargado de emociones, tan humano, es fácilmente sobreestimable. La tanatología comparada no ha quedado exenta de este sesgo.

Tendemos a intelectualizar en exceso la muerte. Ese es probablemente el motivo por el que muchos autores consideran este concepto como algo inalcanzable para otras especies: o la entienden como nosotros, o no lo hacen en absoluto.

A esto se une la forma en la que la muerte encaja en nuestra peculiar cultura WEIRD (acrónimo anglosajón para sociedades occidentales, educadas, industrializadas, ricas y democráticas), en la que los muertos son personas que se desvanecen de nuestra vida y nuestros planes. Esto ha llevado a propuestas teóricas absolutamente faltas de perspectiva.

Algunos de los requerimientos teóricos que se han propuesto como necesarios para entender la muerte son altísimos. Desorbitados. Por ejemplo, la necesidad de una teoría de la mente (la capacidad de crear modelos mentales que representan la mente de otros individuos) o de un concepto de ausencia. Pero la muerte en la naturaleza es mucho más sencilla y mucho más común de lo que es para nosotros. En nuestro mundo urbanita corremos el riesgo de olvidar que los muertos son esencialmente cuerpos rotos sin arreglo.

Esto es algo que Susana Monsó defendió al proponer el concepto mínimo de la muerte. Si liberamos nuestra elaboradísima concepción de la muerte de toda la carga innecesaria, nos queda lo esencial para entenderla: cuerpos que dejan de comportarse como solían y pierden sus funciones para siempre. Entender esto no requiere de mentes privilegiadas, y probablemente muchas especies puedan alcanzarlo, aunque haya diferencias en su manera de concebirla.

Como ya hemos comentado, la muerte no solo es importante para los humanos, también suele ser una tragedia. Si cometemos el error de esperar que otras especies reaccionen como nosotros ante ella, caemos en un antropocentrismo emocional. Este es uno de los motivos por los cuales la tanatología comparada se ha centrado tanto en los primates, pues nos recuerdan a nosotros no solo en el aspecto físico e intelectual, sino también en sus relaciones.

Las reacciones ante la muerte pueden ser muy distintas a la pena o al duelo (aunque hay buenas evidencias de ambos en la naturaleza). El concepto de la muerte es compatible con una infinidad de reacciones emocionales, y el duelo es solo una de ellas.

Pensemos en los depredadores y su relación con la muerte. Imaginemos el leopardo que, tras años abatiendo antílopes, ha aprendido a distinguir el momento exacto en que, tras aplicar el mordisco letal, su presa pierde las funciones vitales. En los cadáveres no solo se desvanecen para siempre las funciones típicas de la vida, también aparecen otras nuevas. Un cadáver es diferente a todos los sentidos. Esto favorece el aprendizaje en animales a los que les puede ir la vida en ello.

No siempre es fácil ser un depredador (los leones solo tienen un 26 % de probabilidades de atrapar a una gacela), y sabemos que el éxito o el fracaso dependen en gran medida de ese aprendizaje. Por ello, los depredadores prestan especial atención a cualquier pista que las presas les puedan proporcionar. Esta atención no solo es evidencia de la capacidad de atender a la funcionalidad, también puede ser el origen de lo que podría ser una evidencia ignorada de la existencia del concepto de la muerte en los depredadores.

¡Hazte el muerto!

Entre los biólogos evolutivos se suele repetir la sugestiva idea de que los machos de pavo real están moldeados por la mente de las hembras. Las preferencias de las hembras han dado forma, con el paso de las generaciones, a las ostentosas colas de los machos. Conociendo la forma y el comportamiento de los machos podemos conocer la mente de esas hembras de pavo real.

Con los depredadores y algunas de sus presas podríamos tener un caso similar.

Nos estamos refiriendo a un fenómeno relativamente extendido en el reino animal: la llamada “tanatosis”. Muchos animales, cuando se ven en peligro, pueden quedar completamente paralizados (desde arañas a tiburones, pasando por gallinas y seres humanos). Esto, en ocasiones, les salva la vida.

En algunos casos, como ocurre con la muerte, no solo desaparece el movimiento, también se añaden funciones nuevas, propias de los cadáveres. Es esa similitud con la muerte a la que la tanatosis debe su nombre. En algunas especies, el mimetismo con la muerte es absolutamente fantástico: adoptan una expresión facial propia de un cadáver y bajan su temperatura corporal. Algunas incluso expulsan sangre por la boca.

Las especies mejor adaptadas a la tanatosis no tienen nada que envidiar al mimetismo de un insecto con forma de hoja y, como dicho insecto, no tienen por qué tener conocimiento alguno de estar imitando algo. Las formas más elaboradas se desencadenan probablemente de forma automática.

La importancia de la tanatosis surge cuando nos preguntamos por la evolución de la misma, pues es la mente de los depredadores la que ha dado forma a dicha imitación de la muerte. Como la cola del pavo real, esta estrategia defensiva nos abre una ventana a la mente de los depredadores, su capacidad para entender la muerte y lo que esperan de ella.

La tanatología comparada es una rama muy reciente de la ciencia, y probablemente nos guarde aún muchas sorpresas. El verdadero interés científico en esta rama de la ciencia comenzó en 2010, justo después de la publicación de aquella fotografía en la que los chimpancés del centro de rescate Sanaga-Yong se despedían de Dorothy.

Aquella fotografía supuso un revulsivo enorme para la sociedad y para la comunidad científica. Tenía todo lo necesario para encajar con nuestro antropocentrismo intelectual y emocional. Ahora es momento de que la tanatología comparada se libere de esas limitaciones y explore por sí misma un mundo mucho más rico y complejo de lo que cualquiera habría esperado. La muerte es común en la naturaleza, y el concepto de la muerte también parece serlo.

Sobre los autores: Antonio José Osuna Mascaró, es doctor en paleontología y biología evolutiva por la Universidad de Granada y actualmente está realizando otro doctorado en cognición comparada en la University of Veterinary Medicine, Vienna; Susana Monsó es investigadora postdoctoral en ética animal y filosofía de la mente animal en la University of Veterinary Medicine, Vienna

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Los animales entienden la muerte más de lo que se pensaba se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Almudena M. Castro – Naukas P4K 2019: Música, guerra y paz

Imagen de Ute Friesen en Pixabay

Imagen de Ute Friesen en PixabayDar palmadas al ritmo de la música es tan difícil que computacionalmente hemos sido incapaces de reproducirlo. Es una cuestión de reconocer patrones regulares de tiempo.

Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y colaboradora del Cuaderno de Cultura Científica.

La conferencia se impartió dentro del marco del festival Passion for Knowledge 2019 (P4K) organizado por el Donostia International Physics Center (DIPC).

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Almudena M. Castro – Naukas P4K 2019: Música, guerra y paz se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- César Tomé López – Naukas P4K 2019: ¿Eureka?¿En serio?

- Ambrosio Liceaga – Naukas P4K 2019: Nunca quisimos coches voladores

- Joaquín Sevilla – Naukas P4K 2019: Lo que esconden unos champiñones al ajillo

Un catálogo de estructuras magnéticas topológicas

El sistema de periodos original ordenaba los elementos químicos por sus propiedades químicas. Esta clasificación en su día condujo a Dmitri Ivanóvich Mendeléyev a la predicción – y al posterior descubrimiento – de nuevos elementos. Análogamente, los sólidos cristalinos no magnéticos se han podido clasificar recientemente mediante una “tabla periódica topológica” basada en una nueva teoría llamada Química Cuántica Topológica (TQC, por sus siglas en inglés) e indicadores de simetría. A partir de esta clasificación se han identificado decenas de miles de materiales no magnéticos potencialmente topológicos, lo que ha llevado ya al descubrimiento de un número considerable de aislantes topológicos.

Foto: Gustavo Candido da Silva / Unsplash

Foto: Gustavo Candido da Silva / UnsplashSin embargo, a diferencia de los materiales no magnéticos, hasta ahora los compuestos magnéticos no podían clasificarse aplicando una metodología similar, principalmente por la inexistencia de una química cuántica topológica para los materiales magnéticos. En su lugar, las investigaciones sobre materiales magnéticos topológicos se venían realizando caso por caso, motivadas por posibles aplicaciones como conversores termoeléctricos eficaces, componentes de dispositivos microelectrónicos energéticamente eficientes que podrían constituir el núcleo de los ordenadores cuánticos, o soportes de almacenamiento magnético mejorados.

Aunque los primeros estudios teóricos de los materiales topológicos y sus propiedades a principios de la década de 1980 se concibieron en sistemas magnéticos (esfuerzos que fueron premiados con el Premio Nobel de Física en 2016), paradójicamente los avances en los últimos 40 años en el descubrimiento de materiales topológicos se han producido en gran medida en aislantes y semimetales topológicos no magnéticos.

La relativa ausencia de candidatos a materiales magnéticos topológicos puede atribuirse a dos causas principales. Por una parte a las complicadas simetrías de los cristales magnéticos: las estructuras no magnéticas se clasifican en 230 grupos espaciales, los materiales magnéticos en 1.421. Por otra a las dificultades teóricas y experimentales que conlleva la simulación y medición de los imanes cuánticos; así, mientras que en las bases de datos existentes se pueden buscar cientos de miles de compuestos cristalinos, en las mayores de materiales magnéticos solo hay unos cientos de estructuras magnéticas medidas experimentalmente. “Además de esto, en todos los sistemas magnéticos también debemos tener en cuenta otras interacciones, que son mucho más difíciles de simular. Esto hace que la tarea de predecir materiales topológicos magnéticos sea significativamente más complicada, incluso aunque los números fueran más favorables”, afirma B. Andrei Bernevig, profesor de física de la Universidad de Princeton.

El trabajo del grupo de Bernevig, publicado en la revista Nature, ha dado un gran paso hacia el descubrimiento de materiales magnéticos con propiedades electrónicas topológicas no triviales.

Previamente, en 2017, este mismo equipo desarrolló un completo y novedoso enfoque para entender la estructura de bandas en materiales no magnéticos. “En esta teoría, llamada TQC, vinculamos las características topológicas de un material con su química subyacente. Esto convirtió la búsqueda de materiales topológicos no magnéticos en una tarea que podía ser automatizada de manera efectiva”, señala Luis Elcoro, profesor de la Facultad de Ciencia y Tecnología de la UPV/EHU y coautor de ambos estudios. La TQC representa un marco universal para predecir y caracterizar todas las posibles estructuras de bandas en materiales cristalinos. La TQC se aplicó a 35.000 compuestos no magnéticos conocidos experimentalmente y condujo al descubrimiento de 15.000 nuevos materiales topológicos.

“En los últimos dos años hemos identificado miles de materiales topológicos, mientras que en las últimas dos décadas sólo se habían identificado unos pocos cientos de ellos. Antes de la aplicación de estas novedosas herramientas, la búsqueda de nuevos materiales con estas sorprendentes propiedades era como buscar una aguja en un pajar al anochecer. Ahora, la búsqueda de materiales topológicos no magnéticos es casi un ejercicio rutinario” dice Maia G. Vergniory, investigadora asociada Ikerbasque en el DIPC, y coautora también de ambos estudios.

Para reproducir el éxito logrado con los materiales no magnéticos los investigadores se enfrentaban a dos obstáculos principales: por un lado, la maquinaria teórica que hay que dilucidar para analizar estructura de bandas de un material magnético determinado es muy compleja. Y, por otro, el número de materiales magnéticos cuya estructura magnética se conoce con detalle de forma fiable es bastante pequeño. “Mientras que teníamos 200.000 compuestos no magnéticos para analizar, la mayor base de datos de estructuras magnéticas medidas experimentalmente tiene aproximadamente 1.000 registros”, aclara el profesor Elcoro.

“Afortunadamente, contábamos con el minucioso trabajo de las personas que están detrás de la base de datos de estructuras magnéticas del Bilbao Crystallographic Server, lo que nos permitió introducir los parámetros iniciales correctos en nuestros modelos teóricos”, dice Yuanfeng Xu, investigador postdoctoral del Instituto Max Planck de Halle, y primer autor del estudio. La información magnética está alojada en el Bilbao Crystallographic Server (www.cryst.ehu.es), que ha sido en parte desarrollado por el profesor Elcoro.

Tras una selección de los mejores candidatos potenciales, el equipo analizó 549 estructuras magnéticas aplicando primero simulaciones a partir de primeros principios que no usan parámetros iniciales empíricos para obtener las simetrías magnéticas de las funciones de onda electrónicas, y luego, construyendo una extensión magnética de la TQC para determinar qué estructuras magnéticas albergaban una topología de banda electrónica no trivial.

Como resultado en el estudio se predice la existencia de 130 materiales magnéticos topológicos. Asimismo, han encontrado que la proporción de materiales magnéticos topológicos (130 de 549) en la naturaleza parece ser similar a la proporción en los compuestos no magnéticos.

Los autores se muestran optimistas con los resultados, ya que, a pesar del reducido número absoluto de compuestos magnéticos en comparación con los miles de materiales no magnéticos estudiados hasta la fecha, han encontrado una mayor diversidad de características fascinantes que los hacen muy interesantes para diseñar futuros experimentos. “Ahora que hemos predicho nuevos materiales magnéticos topológicos, el siguiente paso es verificar experimentalmente sus propiedades topológicas”, dice G. Vergniory.

Los investigadores también han creado una base de datos en línea para acceder libremente a los resultados del presente estudio: www.topologicalquantumchemistry.fr/magnetic. Utilizando diferentes herramientas de búsqueda, los usuarios pueden explorar las propiedades topológicas de las más de 500 estructuras magnéticas analizadas. “Hemos sentado las bases de un catálogo de estructuras magnéticas topológicas”, afirma Elcoro. Es de esperar que la estandarización del uso de la simetría magnética en entornos experimentales y teóricos, acompañada de la adopción generalizada de las herramientas desarrolladas en este trabajo, conduzca en los próximos años a una gran explosión de descubrimientos en materiales magnéticos.

Referencia:

Yuanfeng Xu, Luis Elcoro, Zhida Song, Benjamin J. Wieder, M. G. Vergniory, Nicolas Regnault, Yulin Chen, Claudia Felser, and B. Andrei Bernevig (2020) High-throughput calculations of magnetic topological materials Nature doi:10.1038/s41586-020-2837-0

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Un catálogo de estructuras magnéticas topológicas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La teoría de bandas de los sólidos se hace topológica

- Nanopartículas magnéticas contra células tumorales

- Aislantes topológicos en sólidos amorfos

Fanfarria

La autora hace sonar una Charonia tritonis, que ocupa el lugar central de Fanfare. Fuente: Sound the Trumpets (and a Conch)! / The MET

En el Museo Metropolitano de Arte de Nueva York (el MET) puede visitarse una preciosa instalación titulada Fanfarria. En ella, una humilde caracola se sitúa en el centro de una explosión imaginaria que da lugar a todos los instrumentos de viento metal de la historia. La caracola es el punto de partida. A su alrededor las formas y materiales divergen, se tuercen, se ramifican… pero todas tienen un origen común. El título de la instalación hace referencia a una forma musical, de corta duración y sonoridad rimbombante, que solía utilizarse para anunciar la llegada de alguna personalidad importante. Las fanfarrias eran interpretadas por trompetas u otros instrumentos de viento metal, con el acompañamiento ocasional de la percusión. Su nombre procede del mozárabe farfar y comparte su raíz, probablemente, con la palabra fanfarrón. Desde entonces, el timbre del viento metal y las trompetas en particular se han asociado a la realeza y al poder, a las marchas militares, la pompa y la circunstancia. El motivo último de esta asociación se encuentra probablemente en una de sus propiedades acústicas más destacadas. Al igual que las caracolas, los demás instrumentos de viento metal destacan por su gran potencia sonora, lo que los hace ideales para comunicar señales en el campo de batalla.

En el ámbito musical, esa gran sonoridad ha marcado también el uso de estos instrumentos. Existen incluso chistes al respecto. Según una cita atribuida a Richard Strauss (o alternativamente, a Richard Wagner), un buen director de orquesta no debe “nunca mirar a los trombones: solo los alienta”. El trombón es, de hecho, el instrumento con mayor potencia sonora dentro de la orquesta, con picos que alcanzan los 115 decibelios. Un sonido así puede dañar el oído en 30 segundos de exposición: es más intenso que el de una sierra eléctrica o el de una sirena de ambulancia. La cita de Strauss, por otra parte, es ligeramente apócrifa. Pero solo ligeramente. Se trata de una exageración basada en la cuarta de sus “10 reglas de oro para el joven director de orquesta”. Allí Strauss recomienda: “no mirar nunca de manera alentadora al viento metal, salvo con un leve vistazo para dar alguna indicación importante”. Por otra parte, tampoco parece que Strauss dirigiese “miradas alentadoras” a ningún miembro de la orquesta en absoluto.

Richard Strauss dirigiendo.

Richard Strauss dirigiendo.Debido a su potencia y brillo, el timbre de estos instrumentos, especialmente cuando tocan en una dinámica forte, se ha calificado a menudo también como “metálico” o, en inglés, “brassy”. Sin embargo, esta sonoridad no tiene nada que ver con el material con que están hechos. Resulta paradójico que siempre se utilicen nombres de materiales para calificar a los instrumentos de viento ¡justo los instrumentos en los que el material tiene menos relevancia! Varios estudios123 muestran que el característico sonido brassy se debe en realidad a la amplitud de las ondas sonoras, que provoca efectos no lineales en la propagación del sonido dentro del tubo. Dichos efectos dan lugar a ondas de choque (una variación de la presión que se mueve más rápido que el propio sonido en ese medio) y hacen que la energía sonora se concentre en frecuencias más agudas, donde nuestro oído es más sensible. Cuanto más largo es el tubo, más probable es que se produzca este fenómeno, lo cual explica por qué el trombón, con sus casi tres metros de longitud, es especialmente “brassy”.

El resultado es una sonoridad brillante y áspera, algo estridente incluso. Gracias a ella, los instrumentos de viento metal tienden a sobresalir por encima de los demás en la orquesta. No se trata solo de decibelios: su timbre “metálico” también ayuda a ello. Probablemente por eso, el mismo Richard Strauss que evitaba dirigirles la mirada a los trombones también recomienda a los jóvenes directores: “si crees que los instrumentos de viento metal no están sonando lo suficiente, haz que bajen el volumen un grado o dos más”.

Referencias:

1Beauchamp, J. (1980) ‘‘Analysis of simultaneous mouthpiece and output waveforms,’ Audio Engineering Society preprint No. 1626.

2Hirschberg, A., Gilbert, J., Msallam, R., Wijnands, A.P.J. (1996). “Shock waves in trombones,“ J. Acoust. Soc. Am. 99, 1754-1758.

3Rendón, Pablo & Orduña-Bustamante, Felipe & Narezo Guzman, Daniela & Pérez-López, Antonio & Sorrentini, Jacques. (2010). Nonlinear progressive waves in a slide trombone resonator. The Journal of the Acoustical Society of America. 127. 1096-103. 10.1121/1.3277221.

Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica

El artículo Fanfarria se ha escrito en Cuaderno de Cultura Científica.

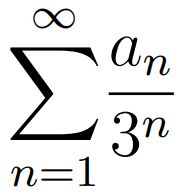

Entradas relacionadas:Una mirada topológica al conjunto de Cantor

No es la primera vez que aludo a Georg Cantor (1845-1918) en este Cuaderno de Cultura Científica. Su figura y su obra matemática me fascinan. He tenido la suerte de tener muy presentes sus matemáticas en mi investigación y mi docencia. Probablemente Cantor fue una de esas pocas personas que es capaz de “pensar” las cosas de otra manera. Esa mirada distinta, genial y osada, provocó grandes cambios en la manera de entender y abordar las matemáticas.

Georg Cantor. Fuente: Wikimedia Commons.

Georg Cantor. Fuente: Wikimedia Commons.

Uno de los más bellos ejemplos que nos ha proporcionado es el conocido como conjunto de Cantor.

En realidad –al menos como registro publicado conocido– fue el matemático Henry J. Stephen Smith quien introdujo este tipo de conjunto en 1874, en el artículo On the Integration of Discontinuous Functions(Proc. London Math. Soc. 1 (6): 140-153): tras una exposición sobre la integración de funciones discontinuas, presentaba un método para construir conjuntos densos en ninguna parte:

Sea m un número entero mayor que 2. Se divide el intervalo [0,1] en m partes iguales y se suprime el último segmento de cualquier división posterior. Se dividen cada uno de los m-1 segmentos restantes en m partes iguales y se eliminan los últimos segmentos de cualquier división posterior. Si esta operación se continúa ad infinitum, se obtiene una cantidad infinita de puntos de división P en el intervalo [0,1]. Estos puntos forman un conjunto denso en ninguna parte…

Aunque no se dice explícitamente en el enunciado, los intervalos eliminados son abiertos, con lo que el conjunto resultante P es cerrado. En el momento actual, el conjunto descrito por Smith se llamaría conjunto de Cantor generalizado.

Entre 1879 y 1884, Cantor escribió una serie de cinco artículos que contienen, entre otros, el primer tratamiento sistemático de la topología de la recta real. En el quinto artículo de esta serie, Cantor discute las particiones de un conjunto en dos componentes que llama reducible y perfecta, y define lo que es un conjunto

perfecto. Muestra que un conjunto perfecto no es necesariamente denso, y en un pie de página introduce su famoso conjunto ternario, el conjunto de los puntos que pueden expresarse de la forma (*):

donde an=0 ó 2.

Cantor prueba que este conjunto es infinito, perfecto y que no es denso en ningún intervalo (es totalmente disconexo, es decir, sus componentes conexas son sus puntos).

Puede darse una construcción geométrica alternativa (pueden verse los detalles en [3]) y fácil de entender. Se toma el intervalo [0,1], se divide en tres partes iguales de longitud 1/3 y se elimina el intervalo abierto central (1/3,2/3). Con los dos intervalos cerrados restantes se repite la misma operación: cada uno de los intervalos [0,1/3] y [2/3,1] se divide en tres intervalos de la misma amplitud (en este caso 1/9) y se eliminan los intervalos centrales (1/9,2/9) y (7/9,8/9). Quedan entonces cuatro intervalos cerrados: [0,1/9], [2/9,1/3], [2/3,7/9] y [8/9,1], con los que se repetirá el mismo proceso, y así de manera indefinida. El conjunto resultante es el conjunto ternario de Cantor. Es fácil probar que los puntos del ternario de Cantor son precisamente los elementos del intervalo [0,1] que se pueden expresar de la forma (*) con an=0,2.

De izquierda a derecha, sucesivos pasos de la construcción geométrica del conjunto de Cantor. Fuente: Wikimedia Commons

De izquierda a derecha, sucesivos pasos de la construcción geométrica del conjunto de Cantor. Fuente: Wikimedia CommonsDe hecho, los elementos del primer intervalo abierto eliminado en la construcción, (1/3,2/3), son los que tienen en la expresión (*) el coeficiente a1=1. Los puntos de los intervalos abiertos eliminados en el segundo paso de la construcción –(1/9,2/9) y (7/9,8/9)– tienen el coeficiente a2=1 en la suma (*). De hecho, los puntos de (1/9,2/9) tienen como primeros coeficientes en (*) a1=0 y a2=1; y los de (7/9,8/9) a1=2 y a2=1. En el paso n de esta iteración, los intervalos abiertos eliminados corresponden a los puntos con an=1 en la expresión (*). Por eso, al final del proceso de construcción, los puntos que quedan, los del ternario de Cantor, son los que se escriben según la expresión (*) con coeficientes an=0 ó 2.

La suma de las longitudes de los intervalos abiertos eliminados en este proceso es 1, dicho de otra manera, el conjunto de Cantor es de medida 0. Es uno de los primeros ejemplos de conjunto de medida nula que se dan en un curso de Análisis. Pero para mí, como topóloga, la propiedad más importante del conjunto de Cantor es que es un modelo topológico de cierto tipo de espacios métricos, los expresados en el siguiente teorema (ver [4]):

Todo espacio métrico totalmente disconexo, perfecto y compacto es homeomorfo al conjunto ternario de Cantor.

Un hermoso ejemplo de conjunto que cumple las propiedades del anterior teorema es el collar de Antoine, del que hablamos en este blog: es un conjunto topológicamente equivalente al conjunto de Cantor, que parte de una construcción sobre un sólido de dimensión tres.

Se puede realizar la misma construcción que la del ternario de Cantor eliminando de [0,1] un intervalo abierto (por ejemplo, el central) de longitud 1/4. De los dos intervalos cerrados restantes se elimina el intervalo abierto central de longitud 1/16, y así sucesivamente. Al final del proceso, la suma de las longitudes de los intervalos abiertos eliminados es 1/2. Es decir, el conjunto restante –que es homeomorfo al conjunto de Cantor, según el teorema anterior– mide 1/2. Es una manera de comprobar que la medida no es una propiedad topológica.

El conjunto ternario de Cantor tiene otras muchas propiedades sorprendentes… pero esa es otra historia.

Referencias:

[1] La biografía Georg Cantor: his Mathematics and Phylosophy of the infinite(1990), escrita por Joseph Warren Dauben, es probablemente una de las mejores maneras de aprender sobre la vida del matemático.

[2] Recomiendo también la bellísima biografía novelada Villa del hommes (2007) de Denis Guedj, en la que se reconoce a Georg Cantor en la figura del viejo matemático Hans Singer, recluido en un manicomio.

[3] Marta Macho Stadler, Curiosidades sobre el conjunto de Cantor, Un Paseo por la Geometría 1999/2000 (2001) 97-116

[4] Stephen Willard, General Topology, Addison Wesley, 1970

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad

El artículo Una mirada topológica al conjunto de Cantor se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cuando las palabras no son suficientes: conjunto vacío

- Una visión topológica de la Odisea

- Fractus, arte y matemáticas

Historia del cura rompecristales

El descubrimiento de la estructura cristalina fue un paso de gigante en el descubrimiento de lo diminuto. René Just Haüy fue uno de los padres de la cristalografía como ciencia y el descubridor de que los cristales pueden romperse en estructuras geométricas elementales.

Tenemos que aclarar, porque hemos recibido algún comentario en este sentido, que los mineralogistas distinguen dos formas de romper: fracturar y exfoliar. En el vídeo no hacemos esa distinción y usamos romper de forma genérica. Tampoco Haüy iba usando el martillo a la ligera. ¿Por qué esto es importante? Porque, por ejemplo, la pirita se exfolia en cubos (como se menciona en el vídeo) pero se fractura irregularmente (lo que en jerga se llama fractura concoidea).