Subastas en el análisis económico

José María Usategui Díaz de Otalora

Las subastas y licitaciones se utilizan cada vez más para la asignación o compraventa de bienes, servicios, obras y suministros. El análisis económico de las subastas ha tenido bastante éxito explicando aspectos fundamentales del comportamiento de los que participan en ellas.

El premio Nobel de Economía 2020 ha sido concedido a los profesores Paul R. Milgrom y Robert B. Wilson, de la Universidad de Stanford, por sus aportaciones en Teoría de Subastas y por las propuestas de diseño de nuevos formatos de subastas. Sus aportaciones en Teoría de Subastas ayudan a entender el comportamiento de los participantes en las mismas. Los diseños que han creado permiten realizar subastas complejas eliminando ineficiencias y atendiendo a criterios de bienestar social o de maximización del ingreso del subastador.

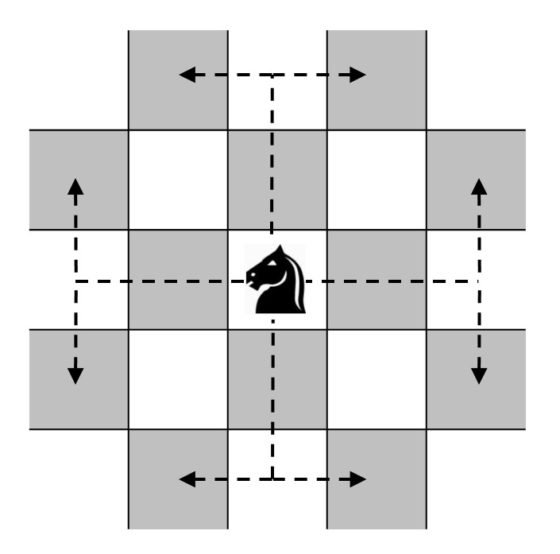

Una subasta consiste en un mecanismo con un conjunto explícito de reglas que determina, en base a las ofertas o pujas de los licitadores, quién es el ganador y cuál es el precio que paga (o cobra) ese ganador. El subastador debe elegir el tipo de subasta a realizar, con sus reglas correspondientes, teniendo en cuenta cómo afecta el diseño de la subasta a las estrategias de puja de los licitadores.

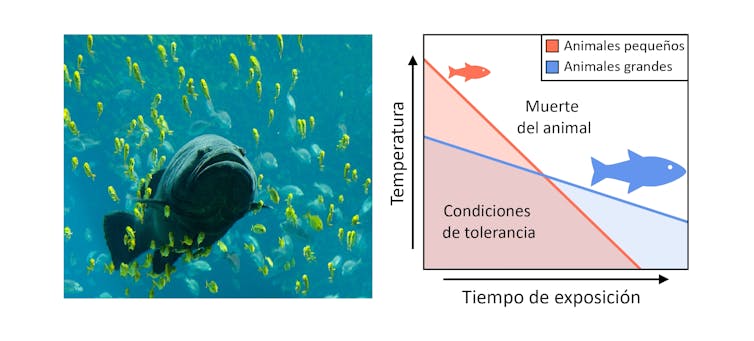

Las subastas permiten determinar rápidamente el precio de mercado de algunos productos, como el pescado, cuya oferta y demanda cambian diariamente. Una subasta puede servir también para averiguar el precio de un bien o servicio que no se intercambia en el mercado con regularidad. Por ejemplo, la subasta de una obra de arte que no se ha vendido nunca o que no se ha vendido desde hace mucho tiempo determina su precio actual.

Muchas subastas de un bien o servicio son subastas ascendentes. En esas subastas los licitadores van realizando pujas cada vez más altas a partir de un precio mínimo aceptable (o precio de salida). La subasta termina cuando ningún licitador desea realizar una puja más elevada. El ganador de la subasta es el licitador que ha realizado la última puja, que ha sido la más alta, y tiene que pagar un precio igual a esa puja. Hay subastas ascendentes en las que también se puede pujar por teléfono y mediante medios electrónicos. Se utilizan subastas ascendentes en las subastas de arte y antigüedades, y también en las subastas de muchos otros bienes y servicios.

Cada vez hay más subastas que se realizan en Internet. En muchas de ellas hay una empresa que administra una página web que puede ser utilizada por distintos vendedores para subastar sus productos. La accesibilidad para los licitadores y las comisiones relativamente bajas que se cobran a los vendedores explican el uso creciente de este sistema. Esas subastas son también ascendentes, aunque en algunas hay un plazo prefijado para pujar. La subasta termina cuando concluye ese plazo. En las subastas de Internet se utilizan índices de reputación de los participantes y otros mecanismos para asegurar su buen funcionamiento.

En las lonjas de pescado se realizan subastas descendentes. Para cada especie de pescado se realiza una subasta. Hay una pantalla en la que el subastador propone inicialmente un precio relativamente alto que, previsiblemente, ningún licitador querrá pagar. A continuación, el precio indicado en la pantalla empieza a bajar. La subasta concluye cuando algún licitador decide aceptar el precio indicado en la pantalla apretando un botón o utilizando algún procedimiento electrónico. Ese licitador es el ganador de la subasta y tiene que pagar el precio mostrado en la pantalla cuando ha parado la subasta. Si se subastan varios lotes de la misma especie el licitador que ha parado la subasta debe indicar cuántos lotes desea al precio por unidad indicado en la pantalla. Si quedan más lotes por vender se reanuda la subasta y empieza a bajar de nuevo el precio mostrado en la pantalla hasta que otro licitador vuelve a parar la subasta. Ese licitador compra las unidades que desea al precio que indique entonces la pantalla y la subasta prosigue hasta que se venden todas las unidades disponibles.

Las subastas de flores recién cortadas en Holanda también son subastas descendentes. Esta modalidad es muy útil para vender rápidamente, sin que se estropeen, muchos lotes distintos de productos perecederos. Cada subasta dura poco, ya que los licitadores que participan son asiduos y evalúan rápidamente los atributos y calidad de cada lote. Todavía existen subastas descendentes en las que el subastador propone precios cada vez más bajos de viva voz y el licitador que para la subasta lo hace mediante voz y seña (alzando la mano, por ejemplo).

A veces se subastan múltiples unidades de un bien o servicio en una subasta. Esto ocurre, por ejemplo, en las subastas de deuda pública, en las subastas de electricidad y en las subastas de permisos de contaminación. El objetivo de las subastas de permisos de emisiones es alcanzar el nivel de emisiones contaminantes deseado con el menor coste posible. Para ello se exige a las empresas que realizan emisiones contaminantes la posesión de un número de permisos de emisiones igual al número de unidades de contaminación que emitan. Los licitadores pueden realizar en esas subastas una puja por cada permiso que deseen y tienen que hacerlo en sobre cerrado (sin observar las pujas que hacen los demás licitadores). Esas pujas se ordenan de mayor a menor y se van asignando permisos empezando por la puja más alta hasta que se terminan los permisos disponibles. La Unión Europea tiene un programa de permisos de emisiones de gases de efecto invernadero (EU ETS) en el que se utilizan cada vez más las subastas.

Hay subastas en las que el valor o el coste de lo que se subasta es el mismo, o similar, para todos los licitadores, pero ninguno conoce ese valor común. Eso podría ocurrir, por ejemplo, en las subastas de derechos de retransmisión de una olimpiada o de un campeonato deportivo importante. Considérese que se realiza una subasta en sobre cerrado al primer precio (cada licitante hace una única puja y. cuando termina el plazo durante el que se puede pujar. se abren los sobres y el ganador es el que ha realizado la puja más alta). En ese caso, cada licitador decide su puja en función de su estimación de ese valor común. El ganador es el que realiza la más alta, pero puede ocurrir que su puja sea demasiado alta (mayor que lo que puede recuperarse mediante ingresos publicitarios durante las retransmisiones). Esto se conoce como la “maldición del ganador”. Robert Wilson fue el primero que realizó un análisis riguroso sobre la estrategia óptima de puja de los licitadores en una subasta en sobre cerrado al primer precio que sea de valor común y demostró cuánto debe reducir su puja un licitador para tener en cuenta el efecto “maldición del ganador” y cómo las asimetrías de información entre los licitadores afectan a sus pujas.

En muchas subastas ocurre que se combinan elementos de valor común y elementos de valor específicos de cada licitador. Considérese, por ejemplo, la subasta de una vivienda. Cada licitador tendrá en cuenta, al decidir su puja, cómo se adaptan el tamaño y la localización de la vivienda a sus necesidades actuales, pero también sus expectativas sobre el valor futuro de la vivienda por si necesitara venderla. Ese valor futuro es común a todos los licitantes y existe en todas las subastas en las que es posible revender lo que se subasta. Paul Milgrom (junto con Robert Weber) estableció las bases para el análisis de estas subastas que combinan elementos de valor común y elementos de valor privado. Demostró cómo afectan las reglas de la subasta al efecto de la “maldición del ganador” sobre las pujas de los licitadores y al ingreso esperado del subastador.

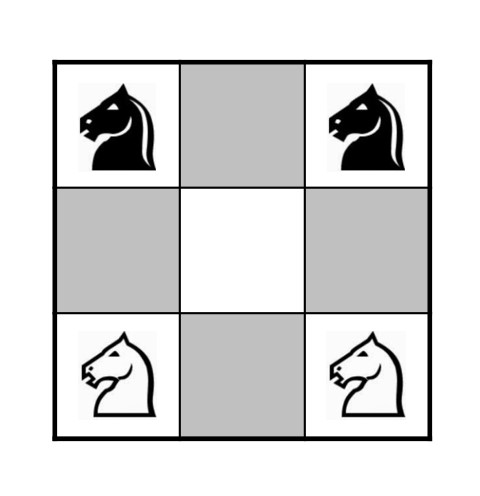

En los primeros años 90 del siglo pasado se planteó la necesidad de diseñar subastas para la asignación de varios bienes o servicios heterogéneos, sobre todo para la adjudicación de licencias de uso de bandas del espectro radioeléctrico (que pueden utilizarse para la provisión de servicios de televisión, radio, telefonía móvil, internet-WIFI y otros). El diseño de esas subastas se complicaba porque un licitador puede valorar mucho obtener dos licencias que considere complementarias, pero no valorar apenas la obtención de solo una de esas licencias. Paul Milgrom propuso varios diseños de las subastas para tener en cuenta ese aspecto. Junto con Robert Wilson diseñó un sistema de subastas ascendentes simultáneas, con una subasta para cada bien o servicio, que se desarrollan mediante rondas de pujas. En cada ronda todo licitador puede pujar en varias de esas subastas. Al final de cada ronda, se indica cuál es la puja más alta en cada subasta y se establece un precio mínimo aceptable para la siguiente ronda, que es superior a esa puja. Las subastas simultáneas terminan cuando se llega a una ronda en la que no hay pujas en ninguna de esas subastas. Estas subastas se han realizado en varios países (el diseño ha utilizado también una propuesta de Preston McAfee). Posteriormente, Paul Milgrom ha sido uno de los economistas que han diseñado una propuesta de subasta combinatoria en la que se puede pujar sobre lotes de licencias y no solo sobre licencias individuales. En las subastas de licencias de uso de bandas del espectro radioeléctrico es importante elegir con cuidado el precio mínimo aceptable en cada subasta y el número de licencias a subastar, así como establecer reglas de actividad de los licitadores y mecanismos para evitar que coludan.

Paul Milgrom y Robert Wilson han realizado tanto la investigación básica como la aplicación de los resultados de esa investigación al diseño de mecanismos de asignación valiosos socialmente. Su trabajo es un buen ejemplo sobre la utilidad de la investigación básica.

Sobre el autor: José María Usategui Díaz de Otalora es catedrático del Departamento de Análisis Económico de la UPV/EHU

Una versión de este artículo se publicó en Campusa. Original.

El artículo Subastas en el análisis económico se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El territorio económico de los cazadores-recolectores del Paleolítico Superior

- Análisis de redes de la esclerosis múltiple

- El análisis del supercúmulo «El Gordo» limita qué puede ser la materia oscura

El torpe baile de los monos

Siempre me ha encantado esta escena de El Libro de la Selva. El rey Loui de los monos quiere convencer a Mowgli de que le revele el secreto del fuego y para eso, le canta una canción:

—Yo soy el rey del jazz a gogo, el más mono rey del swing…

—Oye primo Loui, ¡qué ritmo tienes! —contesta Mowgli sorprendido.

Y no es para menos su sorpresa. En realidad, y a pesar de las promesas de Disney, ¡los monos no pueden bailar! (Vale que tampoco hablan, pero digamos que es un detalle menor). De hecho, nuestra capacidad para dar palmas al ritmo de la música no solo no tiene rival entre las máquinas, también parece ser una rareza en el reino animal.

Resulta difícil encontrar especies capaces de sincronizarse con una señal sonora. Según se ha observado, solo algunas bastante alejadas filogenéticamente de la nuestra pueden moverse con el ritmo de la música y solo hasta cierto punto. Es el caso de la famosa cacatúa Snowball, que se hizo viral con sus coreografías hace algunos años y de la que hablaremos en otro post. Sin embargo, esta capacidad se encuentra sorprendentemente ausente (o apenas desarrollada) en nuestros parientes evolutivos más cercanos123.

En la última década, se ha intentado entrenar a bonobos4 y chimpancés5 para que sincronicen sus movimientos con un pulso sonoro, pero los resultados son poco concluyentes y parecen depender de claves visuales más que auditivas. En diciembre de 2019, Yuko Hattori and Masaki Tomonaga publicaron un artículo en PNAS6 donde analizaban el comportamiento de un grupo de chimpancés en respuesta a una serie de sonidos (más bien estridentes) de piano. Lo interesante es que, sin haber sido entrenados para ello, los chimpancés tendían a balancearse, a dar palmas y mover sus pies de manera periódica. También parecía haber cierta relación entre el tempo de la música y la velocidad de sus movimientos. Sin embargo, no podemos decir que su “baile” fuese sincrónico con el sonido, en realidad. El periodo de los balanceos no coincidía con el de la música y los chimpancés se movieron durante menos del 10% del tiempo que duró la canción. De hecho, bailaron por igual al escuchar una señal con pulsos aleatorios.

Pese a ello, su comportamiento constituye una pista clave para entender los orígenes de la musicalidad humana. El estudio sugiere que el origen de nuestra percepción del tempo podría datar de hace seis millones de años (donde se sitúa el ancestro común entre humanos y chimpancés) y avala la hipótesis GAE (gradual audiomotor evolution) según la cual, la red neuronal que conecta nuestros sistema auditivo y motor evolucionó gradualmente. Esta red es la responsable de que podamos dar palmas cada año al escuchar el Concierto de año nuevo o movernos al ritmo de la música. Como cuenta el investigador Henkjan Honing7 “en humanos, […] controla los movimientos de nuestras extremidades y boca en actividades como dar palmas, bailar o cantar. Incluso si dejas a los sujetos tumbados, quietos, en un escáner de resonancia magnética funcional, mientras escuchan sonidos rítmicos, se registra actividad en el córtex motor […] Claramente, existe un intercambio de información entre los sistemas auditivo y motor”. El hecho de que ese mismo sistema se encuentra bastante menos desarrollado (o incluso ausente) en otros primates no humanos, ha llevado a buscar relaciones con el desarrollo del lenguaje o la imitación vocal (una característica que compartiríamos con la cacatúa Snowball).

Por otra parte, si bien los chimpancés del estudio de Yuko Hattori respondieron al sonido con movimientos más o menos periódicos, no puede decirse que bailasen «juntos»: en ningún momento intentaron coordinar sus movimientos con los de los demás simios. Esto es justo lo contrario que sucedió con Holly y Bahkahri, las dos chimpancés del zoo de Saint Louis que recientemente saltaron a los medios con su curiosa (y silenciosa) «conga».

Como explica Adriano Lameira, primatólogo y uno de los autores del estudio publicado recientemente en Scientific Reports8, «hasta ahora, no había evidencia de que los grandes simios pudieran hacer esto, especialmente en ausencia de entrenamiento». Cuando las dos chimpancés inician su marcha, ambas se coordinan totalmente, adoptando la misma posición, convirtiéndose una en un espejo desplazado de la otra. Nunca pierden la sincronía a pesar de las irregularidades del terreno. Para conseguirlo, se mueven, cómo no, en base a periodos regulares de tiempo.

El hallazgo nos indica que la danza humana podría ser más antigua de lo que pensábamos. Y nos sugiere también que quizás empezó así: siendo un baile de solo dos. Como cuenta Javier Salas, en Materia, “Holly y Bakhari nacieron en 1998 con solo un par de semanas de diferencia, en zoos distintos, y fueron trasladadas al de San Luis […]. Solas y de la misma edad, las chimpancés tejieron una fuerte relación”. Puede que esa curiosa conga sincónica fuese solo una forma de reforzar sus lazos, o un simple pasatiempo reconfortante en algún sentido… El triste hecho es que Holly murió de cáncer en 2018 y desde entonces Bahkahri no ha vuelto a bailar.

Referencias:

1Merker, Bjorn & Madison, Guy & Eckerdal, Patricia. (2008). On the role and origin of isochrony in human rhythmic entrainment. Cortex; a journal devoted to the study of the nervous system and behavior.

2Merchant, H., & Honing, H. (2014). Are non-human primates capable of rhythmic entrainment? Evidence for the gradual audiomotor evolution hypothesis. Frontiers in Neuroscience, 7

3Honing, H., & Merchant, H. (2014). Differences in auditory timing between human and non-human primates. Behavioral and Brain Sciences

4Large, E., & Gray, P. (2015). Spontaneous tempo and rhythmic entrainment in a bonobo (Pan paniscus). Journal of Comparative Psychology, 129

5Hattori, Y., Tomonaga, M., & Matsuzawa, T. (2013). Spontaneous synchronized tapping to an auditory rhythm in a chimpanzee. Scientific Reports, 3

6Yuko Hattori, Masaki Tomonaga (2019). Rhythmic swaying induced by sound in chimpanzees. Proceedings of the National Academy of Sciences

7Henkjan Honing. The Evolving Animal Orchestra, 2019, MIT Press.

8A.R. Lameira, T. Eerola, & A. Ravignani (2019). Coupled whole-body rhythmic entrainment between two chimpanzees. Scientific Reports

Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica

El artículo El torpe baile de los monos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Los monos mecanógrafos contra la evolución

- El libro de las caras de los monos

- #Naukas16 Dedos de zinc para el baile de San Vito

Una pequeña joya geométrica: el teorema de van Aubel

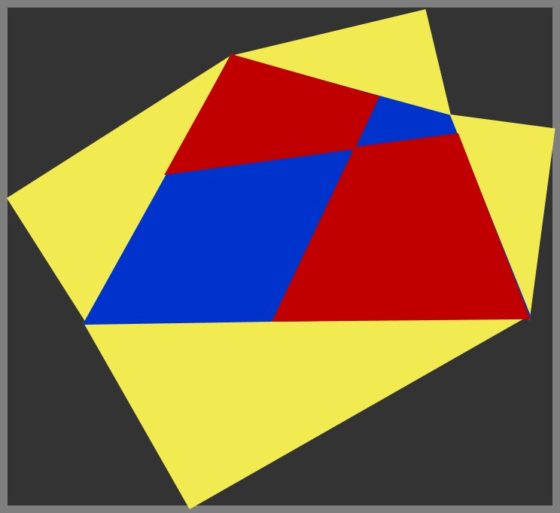

Más allá del hermoso, sugerente y conocido teorema de Pitágoras (véanse, por ejemplo, las entradas Pitágoras sin Palabras, Cultura pitagórica: arte o El teorema de Pitágoras en el arte), la geometría plana está repleta de interesantes y atractivos teoremas, que suelen venir acompañados de diagramas con mucho encanto.

En el Cuaderno de Cultura Científica ya hemos hablado de algunos de esos bonitos resultados de la geometría plana, como el teorema de Napoleón, que además ha inspirado a la artista minimalista vasca Esther Ferrer en su obra artística, como puede leerse en la entrada Variaciones artísticas del teorema de Napoleón. Este resultado geométrico dice lo siguiente.

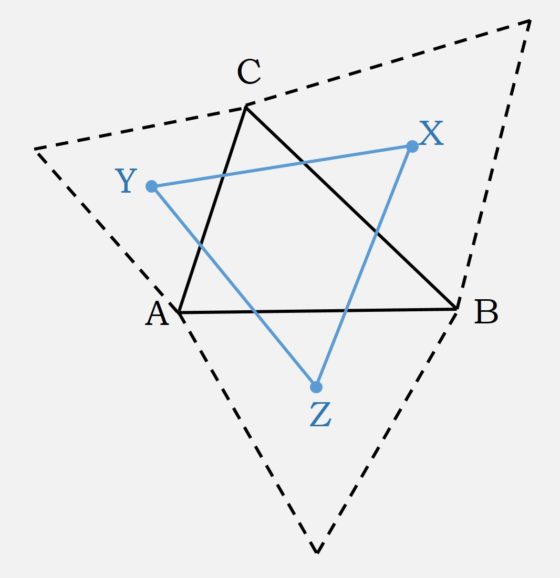

Teorema de Napoleón: Si sobre los tres lados de un triángulo cualquiera ABC se construyen tres triángulos equiláteros exteriores (respectivamente, interiores), los centros de estos tres triángulos equiláteros forman un nuevo triángulo XYZ, que es equilátero, al que se denomina triángulo exterior (respectivamente, interior) de Napoleón.

En esta entrada vamos a hablar de otro de esos resultados geométricos, aunque menos conocido que los dos anteriores, el teorema de van Aubel. Este resultado fue publicado por el matemático holandés Henricus (Henri) Hubertus van Aubel (1830-1906) en el artículo de 1878, Note concernant les centres de carrés construits sur les côtés d’un polygon quelconque (algo así como Nota sobre los centros de los cuadrados construidos en los lados de cualquier polígono). El teorema dice lo siguiente.

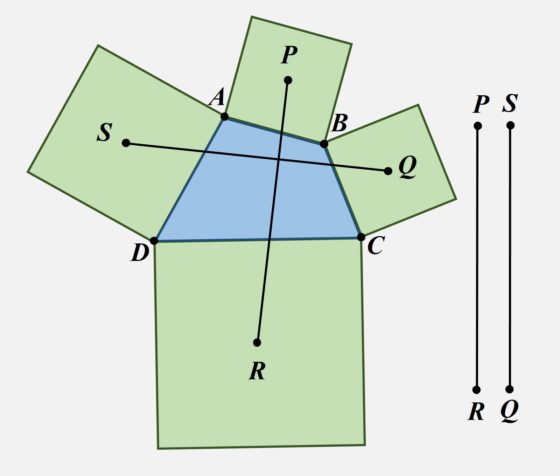

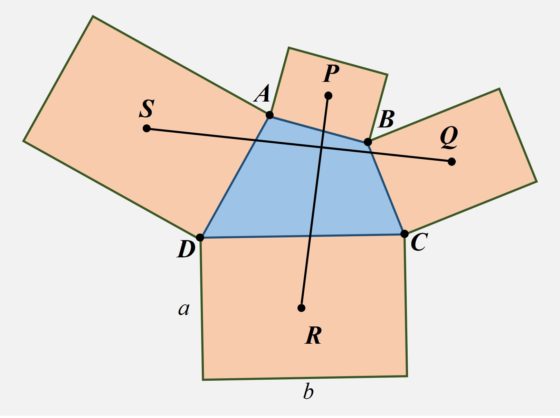

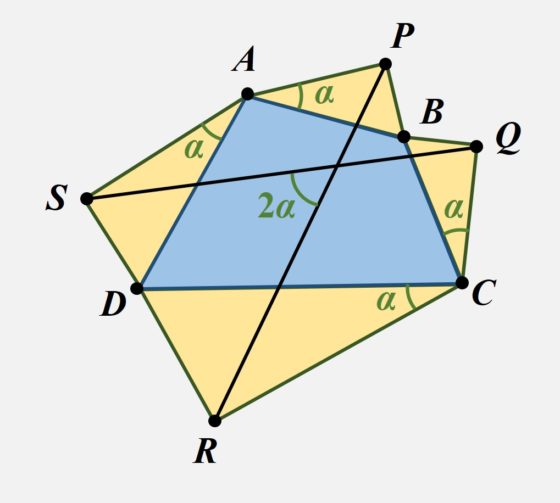

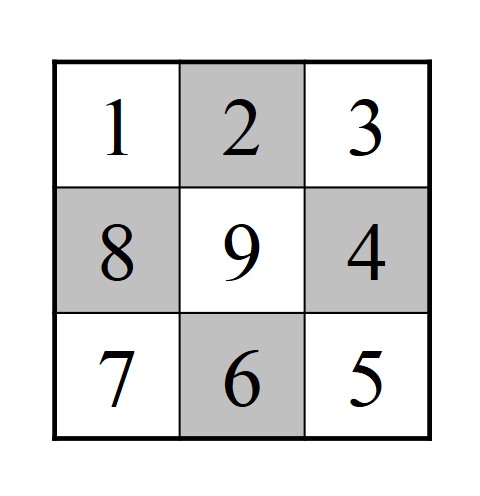

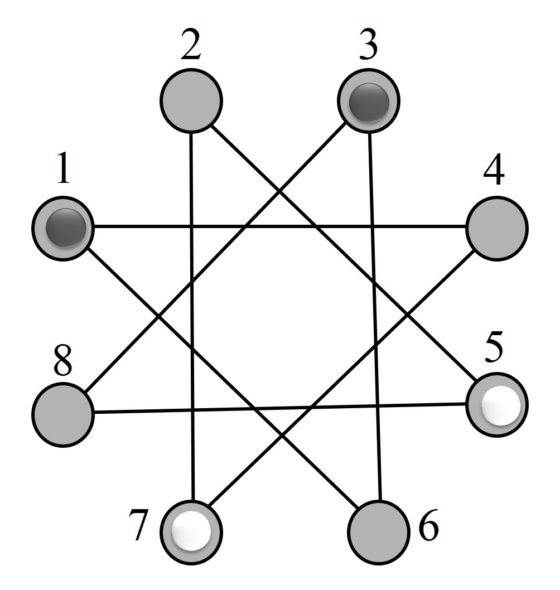

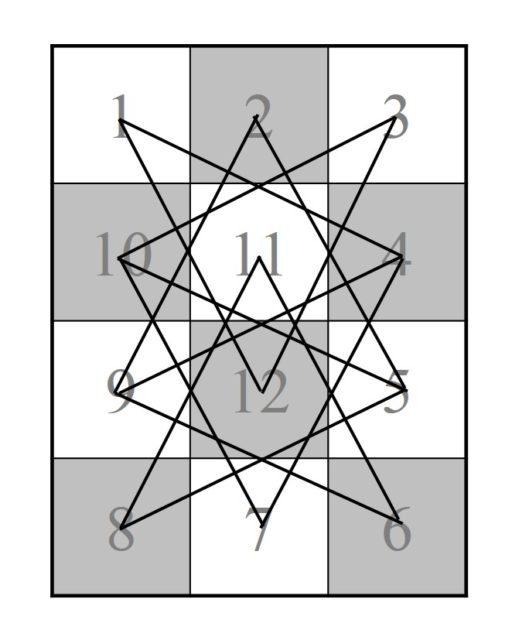

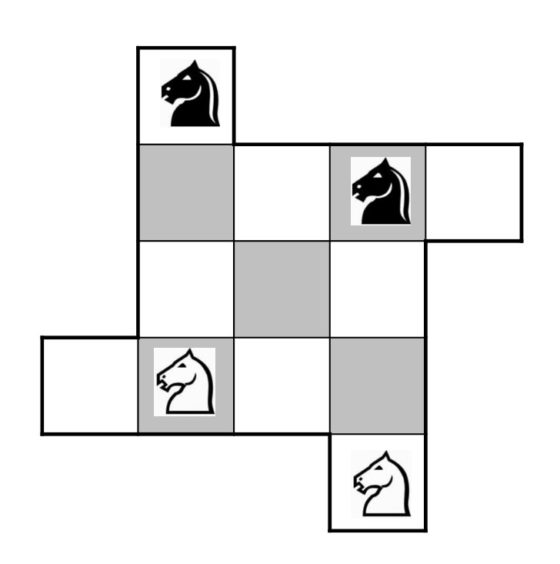

Teorema de van Aubel: Dado un cuadrilátero cualquiera ABCD, se construye un cuadrado sobre cada uno de los lados del mismo, AB, BC, CD y DA, y se consideran sus centros, P, Q, R y S, respectivamente. Entonces, los segmentos PR y SQ (salvo que P coincida con R, o S con Q) son perpendiculares y de la misma longitud.

Cuando se presenta el teorema de van Aubel se suele dibujar un cuadrilátero convexo como el anterior, pero el resultado sigue siendo válido, aunque el cuadrilátero no sea convexo, como en la siguiente imagen. Recordemos que un polígono convexo es un polígono cuyos ángulos interiores miden menos de 180º, es decir, no hay zonas que externas metidas hacia dentro. En general, en matemáticas, se dice que un conjunto es convexo, si dados dos puntos cualesquiera del conjunto se verifica que los puntos del segmento que une esos dos puntos está también dentro del conjunto.

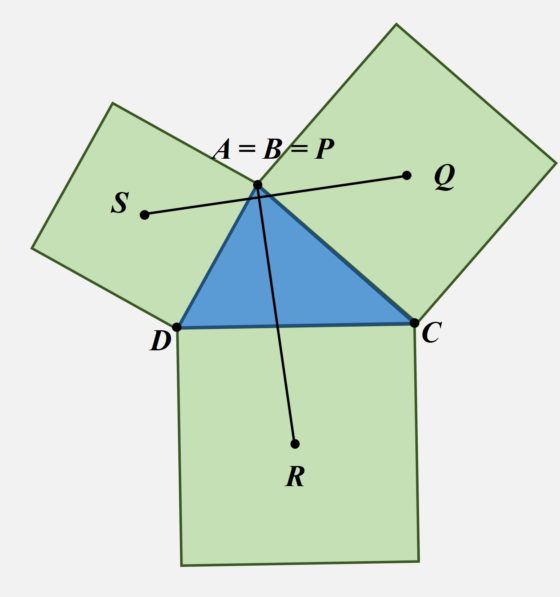

Más aún, el resultado sigue siendo válido, aunque uno de los lados del cuadrilátero tenga longitud cero (es decir, tendríamos un triángulo), en cuyo caso el centro del correspondiente cuadrado sería el vértice. Por ejemplo, si el segmento AB es de longitud cero, es decir, los vértices A y B son el mismo, entonces el centro P del que sería el cuadrado de lado AB es el vértice A (esto es, A = B = P).

En esta entrada no vamos a explicar la demostración de este resultado. Sin embargo, podéis encontrar una demostración geométrica del mismo en la magnífica página de Alexander Bogomolny, Cut the Knot, Interactive Mathematics Miscellany and Puzzles, en la entrada dedicada al teorema de van Aubel: Van Aubel’s Theorem for Quadrilaterals And Generalization. También en el artículo The Beautiful Geometric Theorem of van Aubel, del matemático japonés Yutaka Nishiyama, pueden leerse dos demostraciones, una utilizando números complejos y otra geométrica.

Morley Triangle (1969), del dibujante e ilustrador infantil estadounidense Crockett Johnson. Esta pintura representa el diagrama asociado al resultado de la geometría plana conocido como el teorema de Morley. Imagen de la página web de The National Museum of American History.

Morley Triangle (1969), del dibujante e ilustrador infantil estadounidense Crockett Johnson. Esta pintura representa el diagrama asociado al resultado de la geometría plana conocido como el teorema de Morley. Imagen de la página web de The National Museum of American History.

Existen varias generalizaciones del teorema de van Aubel, algunas de las cuales las vamos a mostrar en esta entrada.

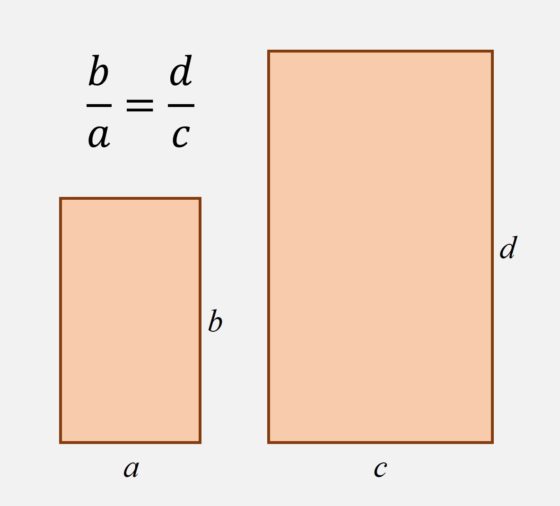

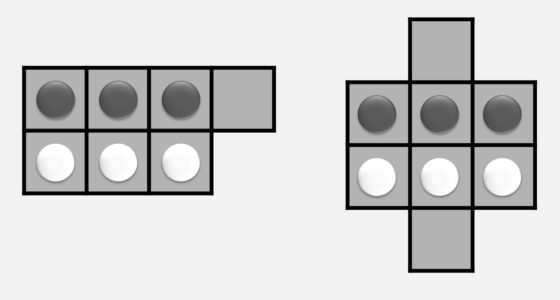

Para empezar, si se consideran rectángulos semejantes en los lados del cuadrilátero, en lugar de cuadrados, el ángulo entre los dos segmentos sigue siendo recto (como el ángulo entre los lados del rectángulo), pero ahora los segmentos, que no tienen la misma longitud, sí tienen la misma proporción que los lados del rectángulo.

Además, recordemos que dos rectángulos –en general, cualesquiera figuras geométricas- son semejantes si tienen la misma forma, aunque no necesariamente el mismo tamaño u orientación. Dada una figura geométrica se obtiene otra similar si se amplía o reduce la figura, se gira o se da la vuelta. En el caso particular de los rectángulos, la proporción entre los lados, ancho y largo, es la misma en los dos rectángulos semejantes.

Rectángulos semejantes

Rectángulos semejantes

La generalización del teorema de van Aubel para rectángulos semejantes es la siguiente.

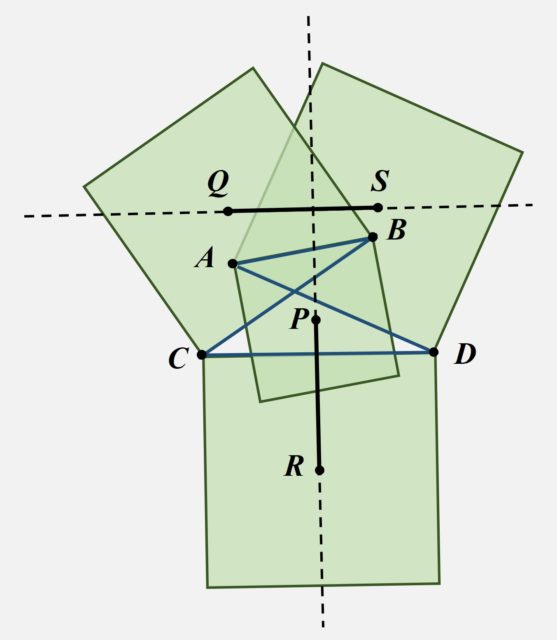

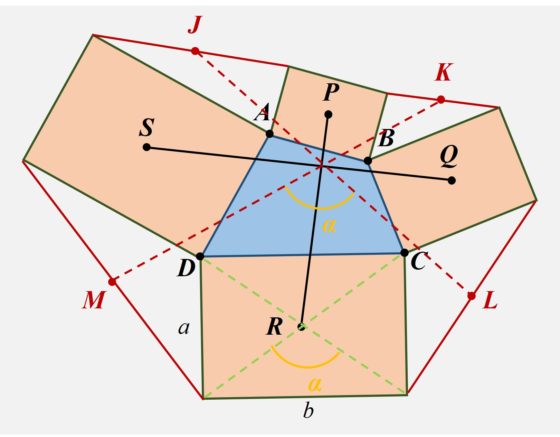

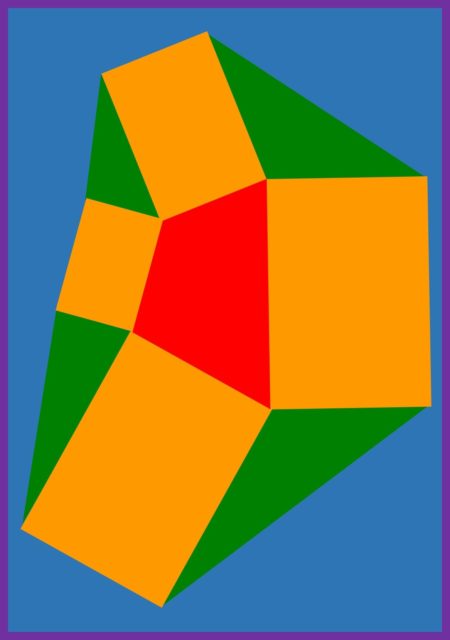

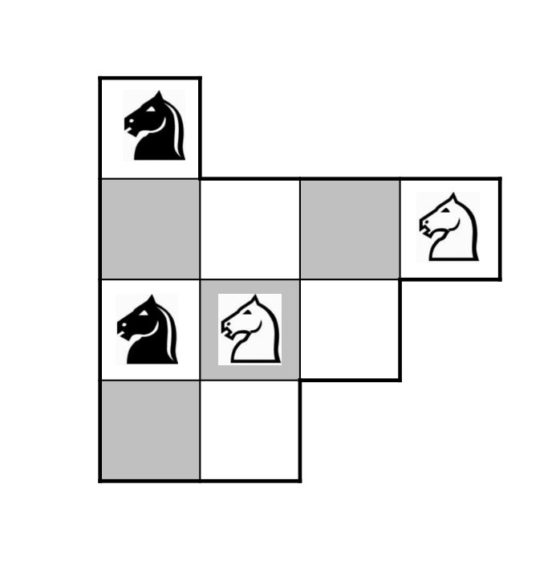

Teorema de van Aubel con rectángulos semejantes: Dado un cuadrilátero cualquiera ABCD, se construye un rectángulo (como aparece en la siguiente imagen) sobre cada uno de los lados del mismo, AB, BC, CD y DA, de forma que los cuatro sean semejantes, y se consideran sus centros, P, Q, R y S, respectivamente. Entonces, los segmentos PR y SQ son perpendiculares y la proporción entre los mismos es igual a la proporción entre los lados distintos (ancho y alto) del rectángulo.

Los segmentos PR y SQ son perpendiculares y además PR / SQ = a / b

Los segmentos PR y SQ son perpendiculares y además PR / SQ = a / b

Además, si J, K, L y M son los puntos medio de los segmentos que unen los vértices contiguos de los rectángulos (como se muestra en la siguiente imagen), entonces los segmentos JL y KM tienen la misma longitud y el ángulo entre los segmentos JL y KM es igual al ángulo entre las diagonales de los rectángulos.

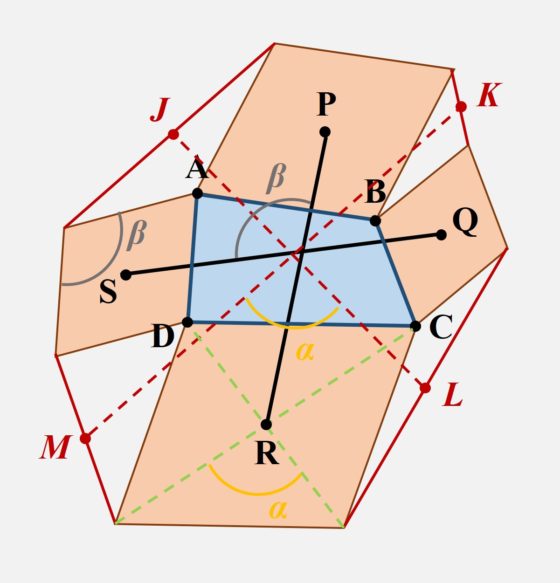

Más aún, el resultado sigue siendo válido para rombos o, en general, paralelogramos semejantes construidos en cada uno de los lados del cuadrilátero. El resultado, que se ilustra en el siguiente diagrama, es esencialmente el mismo que el anterior, pero con algunas generalizaciones. Así, ahora los segmentos PR y SQ no se cruzan en el mismo punto que los segmentos JL y KM; y el ángulo entre los segmentos PR y SQ, ya no es recto, pero sigue siendo el mismo que el ángulo de los paralelogramos de la construcción.

Existen también otras generalizaciones de este resultado de la geometría plana, como la siguiente que podemos leer en la página de Alexander Bogomolny, Cut the Knot, Interactive Mathematics Miscellany and Puzzles, en la que se construyen triángulos rectángulos sobre cada lado del cuadrilátero.

Teorema de van Aubel con triángulos rectángulos: Dado un cuadrilátero cualquiera ABCD, se construye un triángulo rectángulo APB sobre el lado AB con el ángulo recto en P y de forma similar para los demás lados, se construyen los triángulos rectángulos BQC,CRD y DSA, tal que los ángulos de los triángulos que comparten el mismo vértice del cuadrilátero son iguales (por ejemplo, en el vértice A, los ángulos ∠PAB y ∠SAD son iguales). Entonces las longitudes de los segmentos PR y QS son iguales, y el ángulo entre los segmentos PR y QS es dos veces el ángulo ∠PAB.

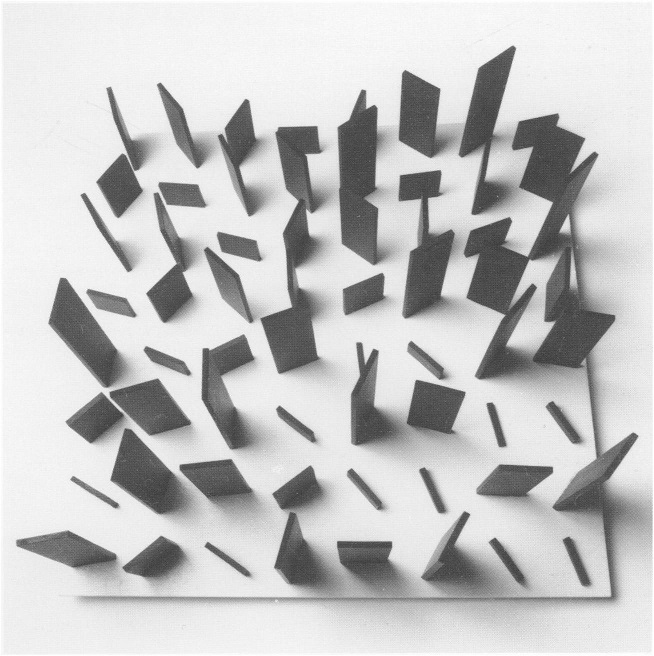

Aunque existen más resultados relacionados con el teorema de van Aubel, no vamos a entrar en ellos en esta entrada del Cuaderno de Cultura Científica, sino que para terminar vamos a incluir dos sencillas ilustraciones que podríamos relacionar con el arte concreto.

Bibliografía

1.- David Wells, The Penguin Dictionary of Curious and Interesting Geometry, Penguin Books, 1991.

2.- H. H. van Aubel, Note concernant les centres de carrés construits sur les côtés d’un polygon quelconque, Nouvelle Correspondance Mathématique, 4, pp. 40–44, (1878).

3.- Wolfram Mathworld: van Aubel’s Theorem

4.- Alexander Bogomolny, Cut the Knot, Interactive Mathematics Miscellany and Puzzles: Van Aubel’s Theorem for Quadrilaterals And Generalization

5.- Yutaka Nishiyama, The Beautiful Geometric Theorem of van Aubel, International Journal of Pure and Applied Mathematics, Volume 66, No. 1, pp. 71-80, 2011.

6.- Michael de Villiers, Van Aubel’s Theorem and some Generalizations

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Una pequeña joya geométrica: el teorema de van Aubel se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Fisión nuclear (1): los elementos transuránidos

Foto: Snowy Vin / Unsplash

Foto: Snowy Vin / UnsplashEl descubrimiento de la fisión nuclear es un ejemplo de resultado inesperado con grandes implicaciones prácticas y sociales. Su desarrollo tuvo lugar durante el curso de una investigación llevada a cabo por razones que no tienen nada que ver con los posibles usos que la sociedad haría del descubrimiento. También es un excelente ejemplo del uso combinado de métodos físicos y químicos en la investigación nuclear y de la eficacia del trabajo en equipo.

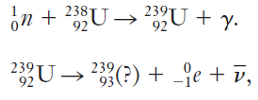

Cuando los Joliot-Curie demostraron que algunos productos de reacciones nucleares inducidas por neutrones son radiactivos, Fermi y sus colegas en Roma, iniciaron un estudio sistemático de las reacciones nucleares inducidas por neutrones. Uno de los propósitos de esta investigación fue producir nuevos nucleidos.

Como resultado, se produjeron muchos nuevos nucleidos radiactivos y se determinaron sus periodos de semidesintegración. Una reacción nuclear utilizada con éxito en este estudio fue la captura de un neutrón seguida de inmediato por la emisión de un rayo gamma. Por ejemplo, cuando el aluminio se bombardea con neutrones, se produce la siguiente reacción:

![]()

El aluminio-28 es radiactivo, con un periodo de semidesintegración de 2,3 min y se descompone por desintegración beta en silicio, con la emisión de un neutrino.

![]()

Como consecuencia de estas dos reacciones, se produce un nucleido, el silicio-28, con valores de número atómico (Z=14) y masa atómica (A=28) cada uno mayor en una unidad que los del núcleo inicial. Fermi pensó que si los neutrones bombardeaban el uranio, la especie atómica que con Z=92 tenía el mayor valor de Z conocido en ese momento, podría formarse un elemento completamente nuevo por la desintegración beta del isótopo de uranio más pesado.

También especuló que el nuevo nucleido 23993(?) a su vez podría sufrir otra desintegración beta, produciendo un segundo elemento más allá del uranio.

![]()

De esta manera, se podrían producir dos nuevos elementos, uno con Z=93, otro con Z=94. Si estas reacciones realmente podían ocurrir, el resultado sería la producción artificial de un elemento, o elementos, cuya existencia no se conocía ni se había previsto: los elementos transuránidos.

Fermi descubrió en 1934 que el bombardeo de uranio con neutrones en realidad producía nuevos elementos radiactivos en el objetivo, como lo demostraban la emisión de rayos y una actividad de desintegración que indicaba periodos de semidesintegración relativamente cortos. Al principio se asumió que estos nuevos elementos eran los hipotéticos elementos transuránidos.

Los resultados de Fermi despertaron mucho interés, y en los siguientes 5 años varios grupos de investigadores experimentaron con el bombardeo de uranio con neutrones. Se encontraron muchas periodos de semidesintegración radiactiva diferentes para la radiación procedente del objetivo, pero los intentos de identificar estos periodos de semidesintegración con elementos concretos solo llevaron a una confusión enorme.

Los métodos utilizados fueron similares a los empleados en el estudio de los elementos radiactivos naturales. Pero la dificultad de identificación era ahora aún mayor porque un nucleido radiactivo formado en una reacción nuclear generalmente está presente en el área objetivo solo en una cantidad extremadamente pequeña, posiblemente del orden de 10-12 g. Debían desarrollarse, pues, nuevas técnicas para purificar estas cantidades minúsculas. Hacían falta especialistas en química.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Fisión nuclear (1): los elementos transuránidos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Los nuevos ‘elementos’ de las series radiactivas

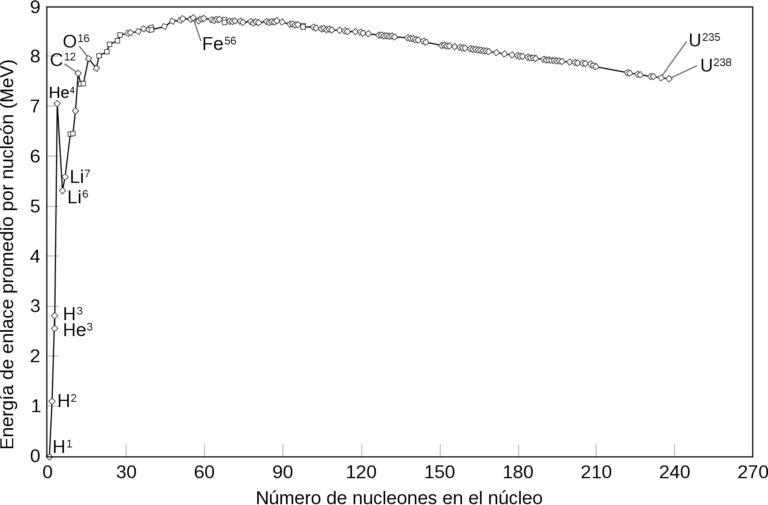

- Energía de enlace nuclear y estabilidad

- La naturaleza estadística del periodo de semidesintegración

10 años promoviendo la cultura científica

La Cátedra de Cultura Científica de la UPV/EHU ha cumplido a finales de 2020 su primera década. Nació fruto de un acuerdo entre la Universidad del País Vasco (UPV/EHU) y el Departamento de Cultura de la Diputación Foral de Bizkaia (DFB). En el documento que se presentó al Consejo de Gobierno de la universidad para justificar su creación se señalaba la importancia de difundir la cultura científica. Su promoción social se consideraba conveniente tanto por razones de carácter cultural, como por constituir fuente de criterio para la toma de decisiones, tanto individuales como colectivas.

Durante todos estos años la Cátedra, haciendo uso de varios soportes, ha desplegado una actividad intensa en diferentes ámbitos. Programamos conferencias en contextos variados, publicamos medios de difusión digitales, organizamos concursos, producimos documentales y vídeos de formatos diversos, ofrecemos talleres para jóvenes, montamos exposiciones, promovemos cursos y posgrados, y desarrollamos otras actividades de divulgación. El resumen de la mayor parte de nuestra actividad puede consultarse aquí.

Por su alcance y por servir de plataforma de difusión del resto de nuestras actividades, destaca nuestra actividad en internet. Por esa razón me detendré en comentar algunos datos. Hemos publicado del orden de 11 500 artículos, que han recibido, en conjunto, más de 32 M (millones) de visitas. El Cuaderno de Cultura Científica (CCC) echó a andar en junio de 2011, en diciembre de 2012 arrancó Mapping Ignorance (MI); Zientzia Kaiera (ZK) nació en septiembre de 2013, y Mujeres con Ciencia (McC), en mayo de 2014.

La difusión que han alcanzado esos medios en 2020 se condensa en unas pocas cifras: El CCC ha recibido 8,5 M de visitas (más de 10 M de páginas vistas), de las que un 67% proceden de América Latina y un 13% de otros países. MI ha recibido más de 300 000 visitas (más de 385 000 páginas vistas), de las que el 40% proceden de EEUU, 8% del RU, 5% de Canadá y un 39% adicional de otros países extranjeros. A ZK se han acercado en más de 75000 ocasiones, (130 000 páginas); la mayor parte de las visitas son de la Comunidad Autónoma Vasca (84%), un 4% proceden de Navarra, un 8% de los EEUU, y otro 4% del resto del mundo. A McC han accedido en más 2,5 M de sesiones (más de 3,5 M de páginas servidas), de las que la mitad proceden de América Latina y el 5% de EEUU; un 10% proviene de otros países extranjeros. En valores acumulados son 11,375 M de sesiones, lo que representa una tercera parte del tráfico total en los años de vida de los medios y es muestra del fuerte crecimiento experimentado a lo largo de los años.

Parte importante del alcance de los medios digitales se debe a la actividad en las redes sociales de internet. Por otra parte, los más de 400 vídeos publicados en nuestro canal de Youtube han sido vistos en más de 2,5 M de ocasiones. Y en el concurso de vídeos científicos Ciencia Clip, en marcha desde 2016, han participado más de 2 500 jóvenes, que han presentado 1 350 vídeos.

Desde su nacimiento, en octubre de 2010, y hasta este pasado mes de diciembre, la Cátedra ha contado con el apoyo económico de la Diputación Foral de Bizkaia para el desempeño de sus actividades. En 2013 el Departamento de Educación del Gobierno Vasco empezó a apoyar la difusión de contenidos científicos en lengua vasca y posteriormente ha intensificado su apoyo, principalmente para impulsar proyectos de carácter educativo y de promoción de las disciplinas STEAM. A partir de 2015 Bizkaia Talent ha venido impulsando varios programas cuyo principal objetivo es acercar la ciencia y la tecnología a adolescentes y jóvenes. El Ayuntamiento de Bilbao, a través de Bilbao Ekintza, ha hecho posible la celebración de Naukas Bilbao en el Auditorium y otras salas del Palacio Euskalduna. También hemos contado con la ayuda de la FECyT para desarrollar algunas de nuestras actividades durante los años 2016 y 2017.

Además de las anteriores, otras entidades públicas han colaborado en nuestros programas y actividades. El grupo EiTB, a través de su canal Nahieran y de Kosmos, han retransmitido, grabado y puesto a disposición del público casi todas las conferencias y festivales que hemos programado.

El Donostia International Physics Center ha sido nuestro principal socio científico; su apoyo para la realización de numerosas actividades (Naukas Bilbao, en especial) ha resultado imprescindible, pero también hemos colaborado en varias iniciativas, como las sesiones de Bertsozientzia en Gipuzkoa, los festivales Naukas Donostia y Passion for Knowledge y otras.

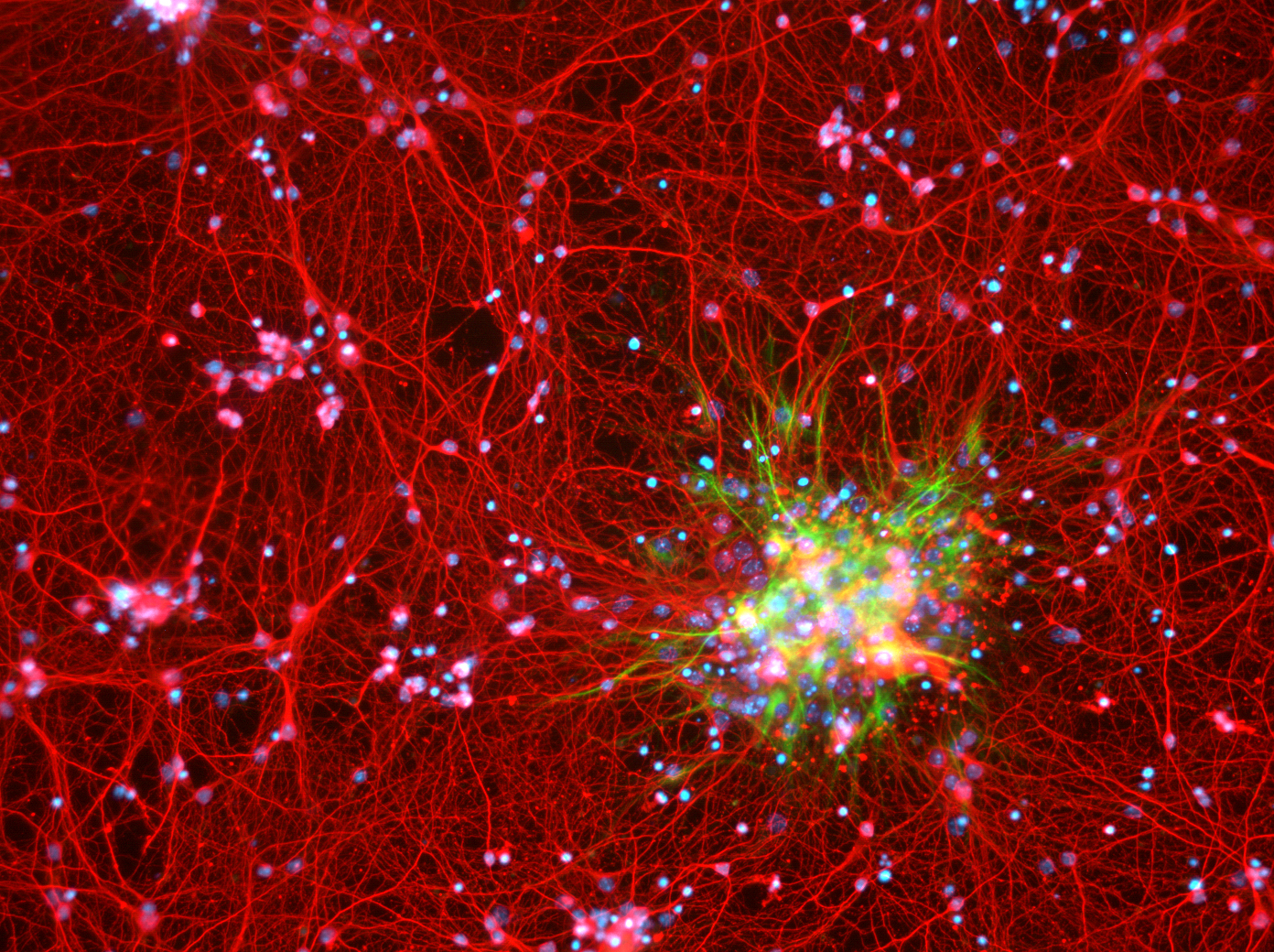

Gracias a la colaboración con Ikerbasque, cada año hemos organizado un curso en el marco de los Cursos de Verano de la UPV/EHU y su apoyo se ha extendido también a otras esferas. La colaboración con el Basque Center for Applied Mathematics ha permitido mantener a lo largo de varios años los seminarios y talleres del programa Matemáticas para mentes inquietas y organizar las actividades del Día de Pi en 2018 y 2019. También hemos desarrollado actividades diversas -jornadas, conferencias y seminarios, principalmente- junto con otros centros de investigación, como Biofisika-Basque Center for Biophysics, BCMaterials, Plentziako Itsas Estazioa, o Achucarro-Basque Center for Neuroscience.

La celebración cada año, desde 2011 hasta 2019, en Bilbao de sendos festivales Naukas ha sido posible gracias a la disposición de los responsables de la plataforma de divulgación del mismo nombre y a la participación desinteresada de sus colaboradores y colaboradoras.

El centro cultural Azkuna Zentroa acogió el programa Zientziateka desde 2012 hasta 2018. La Biblioteca Bidebarrieta ha dado acomodo, en el programa Bidebarrieta Científica, a una rica oferta de conferencias (de 2018 en adelante). Metro Bilbao ha hecho posible la exposición de infografías sobre la Ría de Bilbao desplegada en sus estaciones a lo largo de 2020. La Fundación Bilbao 700 colaboró en la celebración de Naukas Bilbao en varias de sus ediciones. El Consejo Escolar de Euskadi, en la Comunidad Autónoma Vasca, y la Fundación Promaestro, en otras comunidades, han hecho posible la extensión geográfica del programa Las pruebas de la educación, una iniciativa que se puso en marcha en 2017 y que ha cosechado un éxito notable. También hemos colaborado con Jakiunde en los ciclos de Bizkaia de su programa Jakin-mina. Y desde 2017 ofrecemos charlas de contenido científico en la programación de la asociación Goienagusi, del Alto Deba en Gipuzkoa.

Las empresas Euskaltel y Petronor han apoyado el festival Naukas Bilbao en diferentes ediciones. E Iberdrola, desde 2018, viene apoyando la producción del vídeo mediante el que celebramos el Día Internacional de la Mujer y la Niña en la Ciencia.

Los videos emitidos en las temporadas 1ª, 2ª, 5ª y 6ª de Órbita Laika, el programa de ciencia de La 2 de TVE, han sido fruto de la colaboración con la productora de televisión K2000. También hemos apoyado, desde su nacimiento en febrero de 2014, la producción del podcast de ciencia Catástrofe Ultravioleta, que recibió el premio Ondas 2017 al mejor programa online.

Además, mantenemos colaboraciones estables con diversos espacios radiofónicos: La mecánica del caracol (Radio Euskadi), Zientzia eta Pazientzia (Faktoria, Euskadi Irratia), Lau Haizetara (Bizkaia Irratia), Zientzialari (Bilbo Hiria Irratia), Euskadi Hoy Magazine (Onda Vasca) y Zebrabidea, programa producido por la red de emisoras Arrosa Irratien Sarea.

En los primeros años de nuestra andadura colaboramos con la Fundación Elhuyar en la realización del estudio sobre La percepción de los jóvenes vascos sobre la ciencia (2010-2011) y el proyecto Zientzia Live 2012. Igualmente, colaboramos en el estudio sobre Percepción de la ciencia y tecnología en el País Vasco 2012.

En 2016 nos asociamos con el grupo Big Van para organizar el concurso Ciencia Show, un proyecto de educación a través de las artes escénicas (monólogos humorísticos o “stand-up comedy”) que tiene como objetivo incentivar el interés por la ciencia y la tecnología entre las y los jóvenes de ESO, Bachillerato y FP.

En 2015 y 2017 organizamos, junto con otras entidades, Science+. En las jornadas de que consta, conferenciantes del máximo nivel provenientes de ámbitos profesionales muy diversos ofrecen a jóvenes graduados una amplia panorámica de las posibilidades profesionales en el mundo de la ciencia. Estas jornadas las organizamos en colaboración con las sociedades de Científicos Españoles en la República Federal de Alemania (CERFA) y de Científicos Españoles en el Reino Unido (CERU), y con Bizkaia Talent.

Desde 2015 apoyamos el certamen Cristalización en la Escuela que organiza el Grupo de Cristalografía del Departamento de Mineralogía y Petrología de la UPV/EHU. Así mismo, desde 2018 venimos colaborando con la Sección de Geología de la Facultad de Ciencia y Tecnología en las jornadas “Geología para miopes, poetas y despistados”. Hemos contribuido con algunas actividades a la celebración de la Zientzia Astea de nuestra universidad de 2016 en adelante y a la conmemoración del 50 aniversario de la Facultad de Ciencia y Tecnología, en 2019, dando a conocer y difundiendo su labor de investigación. Junto con el Vicerrectorado de Euskera y Formación Continua de nuestra universidad y la revista científica Ekaia trabajamos en la difusión de la labor investigadora en euskara desde 2015.

Desde el comienzo de nuestra andadura, cada 12 de febrero hemos organizado conjuntamente con el Círculo Escéptico el Día de Darwin. Conmemoramos así el aniversario del nacimiento del padre de la teoría de la evolución por selección natural con un programa de dos charlas sobre tema evolutivo.

En 2018 comenzamos a colaborar con LOGOS Elkartea en el proyecto de divulgación científica Zientziaz Blai. Este proyecto tiene como objetivo acercar la cultura a zonas vulnerables y desfavorecidas de Bilbao para combatir la estigmatización de estas áreas y reforzar la convivencia.

Otras entidades o grupos con los que hemos mantenido colaboraciones son la Asociación Española de Comunicación Científica, el Museo Guggenheim Bilbao, Innobasque, la plataforma Scenio, el Laboratorium de Bergara, EHUgune, Colegio Oficial de Biólogos de Euskadi, Pint of Science o asociaciones culturales como Zientziaren Giltzak, ZarautzOn o Lemniskata.

La Cátedra de Cultura Científica se articula sobre una doble estructura. Cuenta, como el resto de cátedras de extensión de la UPV/EHU, con una persona que la dirige y con otras que tienen la condición de colaboradores; todos ellos son académicos de la propia universidad. En nuestro caso, el director es quien suscribe, y las personas colaboradoras son Ana Arrieta, Aitor Bergara, Raúl Ibáñez, y Miren Bego Urrutia, que desempeñan tareas de organización y presentación de los actos que organizamos, y Marta Macho, que es editora y redactora de Mujeres con Ciencia. Por otro lado, la Unidad de Cultura Científica e Innovación de la Fundación Euskampus presta a la Cátedra servicios esenciales para su funcionamiento. Lo hace asumiendo tareas de administración y gestión del grueso de los convenios que proporcionan el sostén económico a nuestras actividades, a la vez que desempeña labores de difusión. Esta segunda y esencial tarea es desempeñada por Ziortza Gezuraga, en tareas principalmente de comunicación y apoyo a la celebración de eventos, César Tomé, como editor y principal redactor de Mapping Ignorance y Cuaderno de Cultura Científica, y Uxune Martínez, editora de Zientzia Kaiera y coordinadora general de las actividades de la Cátedra.

Son muy numerosos los agentes que han contribuido a las realizaciones de estos diez años. Nada sería posible sin el apoyo de las instituciones (y, por supuesto, de las personas al frente) que proporcionan el necesario sostén económico. La red de centros de investigación y entidades colaboradoras que hemos tejido a lo largo de los años compensa las reducidas dimensiones de nuestra estructura. Una larga lista de colaboradores y colaboradoras, bien como profesionales o bien de forma desinteresada, nos han prestado una ayuda esencial, pues dirigen ciclos, seminarios y jornadas, dictan conferencias y presentan ponencias en los actos que programamos; no me es posible citar a todos ellos. Y por supuesto, son las personas que sostienen el día a día de la Cátedra las principales responsables de nuestros logros. A todas ellas quiero agradecer, como director, su inestimable contribución, por hacer realidad un proyecto único.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo 10 años promoviendo la cultura científica se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La Cátedra de Cultura Científica cumple 5 años

- 5 años de Cátedra de Cultura Científica, el vídeo

- Actividad de la Cátedra de Cultura Científica (UPV/EHU) en 2010/2011

Cómo los apellidos nos hablan de genes e historia, y viceversa

Xulio Sousa

Shutterstock / paula sierra

Shutterstock / paula sierraEn la década de los ochenta del siglo pasado el genetista italiano Luigi Luca Cavalli-Sforza comenzó la publicación de una serie de trabajos que descubrían la existencia de similitudes entre la diversificación y distribución territorial de grupos genéticos y de familias lingüísticas.

Desde los años cincuenta Cavalli-Sforza, formado en genética bacteriana, se había interesado por la genética de poblaciones, movido por el propósito de reconstruir la historia de dispersión de las poblaciones humanas. A lo largo de los tiempos, los humanos se han organizado en grupos que comparten tradiciones culturales, características lingüísticas y rasgos genéticos. Cavalli-Sforza sugirió que el análisis de los datos genéticos podría permitir trazar un árbol de los linajes de las poblaciones humanas y comenzar a reconocer la existencia de paralelismos entre la clasificación genética y la clasificación de las lenguas y otros rasgos culturales.

Las conclusiones de los trabajos de Cavalli-Sforza y de sus colaboradores originaron controversias que resultaron muy fructíferas para el avance de los distintos ámbitos científicos concernidos: ¿derivan las lenguas actuales de una única lengua?, ¿tienen las lenguas africanas características más arcaicas que el resto?, ¿apoyan las diferencias genéticas la singularidad lingüística de lenguas como el vasco? Como todos los trabajos sólidos y singulares, sirvieron también de acicate para muchas investigaciones interdisciplinares.

Los trabajos del grupo de Cavalli-Sforza se fundamentaban en el estudio de genes y tenían como objetivo poblaciones y familias lingüísticas de continentes enteros o bien de todo el mundo. Investigaciones posteriores comenzaron a indagar si existía también algún paralelismo entre la diversidad genética y lingüística a menor escala. En el ámbito europeo se han realizado estudios fundamentalmente en los dominios de las lenguas germánicas y románicas, muchos de ellos echando mano de un indicador menos preciso que los genes y que había sido aprovechado en lo estudios de poblaciones desde hacía tiempo: los apellidos. Como ejemplo, en 2015 un grupo de investigadores identificaron conexiones entre la fragmentación de los reinos medievales de España, los romances peninsulares y la organización regional de los apellidos contemporáneos.

Apellidos y poblaciones

El uso de los apellidos en los estudios genéticos se remonta al siglo XIX, cuando George Darwin, hijo de primos hermanos (Charles y Emma), estudió la consanguinidad en poblaciones rurales de Inglaterra a partir de la coincidencia de apellidos de los dos miembros de la misma pareja (la estimación de la isonimia). En la mayoría de las sociedades europeas, los apellidos se hicieron hereditarios a partir de la Edad Media, y desde el siglo XVIII, buena parte de los estados oficializaron su uso.

Pocos años después del estudio de Darwin, su compatriota Henry Guppy mostró que los apellidos (family names) se distribuían territorialmente de forma organizada y tenían límites de difusión similares a las fronteras políticas y naturales. Trabajos posteriores descubrieron que algunos apellidos, como los originados a partir de nombres de lugar (Ariza, Barceló, Orozco, Ares, etc.), se extendían trazando un radio que marcaba la movilidad y extensión de los grupos poblacionales. Los apellidos, como los genes, funcionan como contenedores de información que podían ser aprovechados para indagar en la historia, las vinculaciones y la distribución de las poblaciones.

Apellidos y dialectos

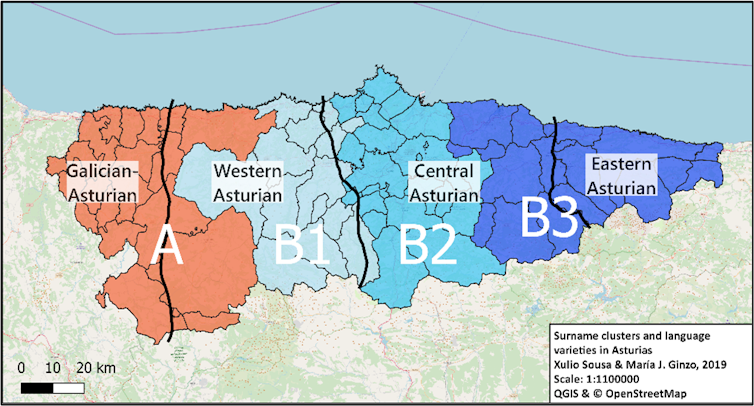

Siguiendo el método empleado en algunos de estos trabajos, un grupo interdisciplinar de lingüistas y matemáticos hemos emprendido el estudio de los apellidos de distintas zonas peninsulares para descubrir qué nos pueden decir estos nombres propios sobre las poblaciones que los portan. En nuestro estudio, publicado en la revista Journal of Linguistic Geography, analizamos la distribución territorial de los apellidos de Asturias.

A diferencia de trabajos previos basados en datos provinciales y más parciales, nuestra investigación parte de censos completos de los 78 municipios asturianos. Estos registros fueron filtrados de dos modos para obtener un conjunto más significativo:

- Se eliminaron aquellos apellidos que por su frecuencia dificultan el descubrimiento de las agrupaciones regionales (los más frecuentes –García, Fernández, Rodríguez, etc.- y los más raros);

- Además, se realizó un corte temporal (apellidos de personas nacidas antes de 1960) para minimizar la repercusión de los movimientos de población consecuencia de las migraciones a las ciudades.

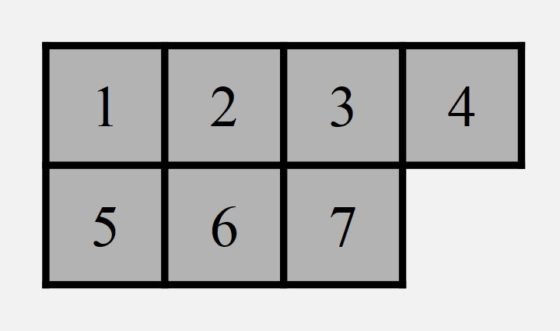

El conjunto resultante se trató con procedimientos estadísticos que permitieron identificar las principales regiones de apellidos de Asturias.

El resultado muestra cuatro agrupaciones compactas, separadas por barreras que corren de norte a sur y que se asemejan bastante en su trazado a las isoglosas que separan las variedades lingüísticas asturianas.

Asimismo, es posible reconocer que los dos primeros grandes bloques de la fragmentación de los apellidos muestra coincidencias evidentes con la partición del territorio de Asturias entre un área lingüística occidental, con características compartidas con el gallego, y otras tres zonas, identificadas con trazos exclusivos del asturiano.

Regiones de apellidos y límites lingüísticos en Asturias.

Regiones de apellidos y límites lingüísticos en Asturias.Un campo de datos a explotar

Los lingüistas interesados por la variación lingüística investigamos los datos con la intención de descubrir las causas que ayuden a comprender cómo y por qué divergen las lenguas. El estudio de la distribución de apellidos en una población permite obtener información sobre su movilidad y sobre la extensión de las relaciones grupales.

Las características lingüísticas se difunden socialmente en la interacción y, por lo tanto, son dependientes de las relaciones y movimientos de las comunidades, que pueden ser observadas a partir de la información proporcionada por los apellidos.

Los resultados destacados en nuestro trabajo dan cuenta de que las similitudes entre las dos clases de datos pueden ser consecuencia de formas de ocupación del territorio del pasado. Con seguridad, la cooperación de investigadores de distintas disciplinas contribuirá a continuar explotando todo el valor informativo de esta clase tan peculiar de nombres propios.![]()

Sobre el autor: Xulio Sousa es profesor titular e investigador del Departamento de Filología Gallega de la Universidade de Santiago de Compostela

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Cómo los apellidos nos hablan de genes e historia, y viceversa se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Historia de cómo el VIH ayudó a derribar el dogma central de la biología molecular

- Quince virus que han cambiado la historia de la Humanidad

- Las lapas como indicador paleoclimático de alta resolución

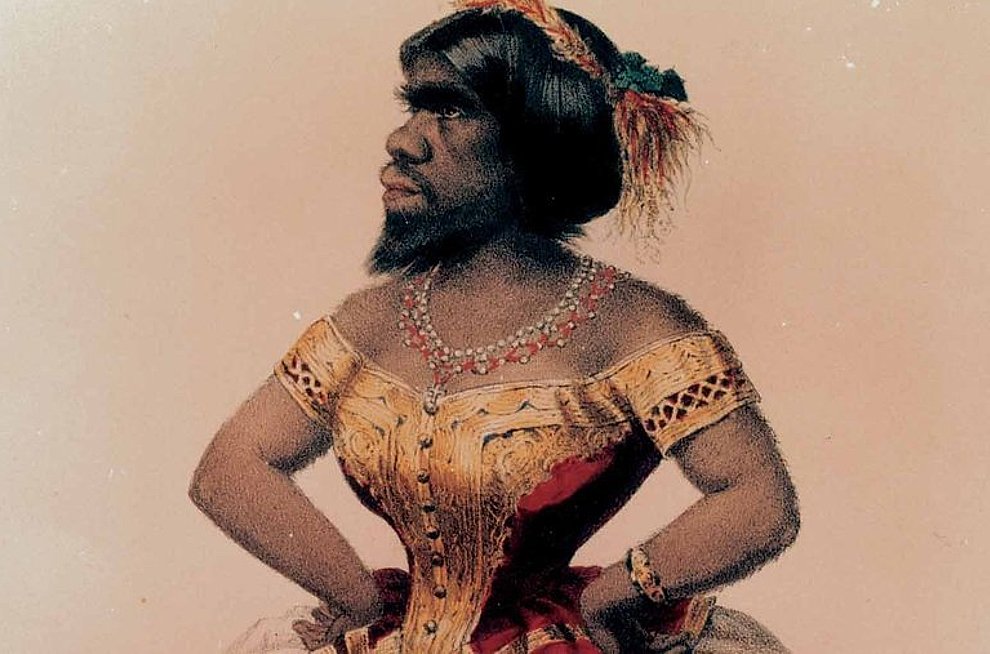

Susana Escudero – Naukas 2019: La mujer más fea del mundo

Julia Pastrana, «la mujer más fea del mundo», nació en México en el siglo XIX. Clasificada como un híbrido entre humano y mono, aunque hablase 3 idiomas o tocase la guitarra y la armónica, esta persona singular, víctima de una enfermedad rara, tuvo una vida no menos extraordinaria.

Susana Escudero es licenciada en filología inglesa y máster en antropología forense, aunque ejerce de periodista desde los 20 años. En la actualidad trabaja en Canal Sur, donde realiza junto a Emilio García (IAA-CSIC) el programa de ciencia de radio “El Radioscopio”, galardonado, entre otros premios, con tres Prismas y el Premio Andalucía de Periodismo.

La charla puede leerse como texto, aquí.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Susana Escudero – Naukas 2019: La mujer más fea del mundo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Isabel Moreno – Naukas Bilbao 2019: El cielo en clave de Sol

- Juan Manuel Bermúdez-García – Naukas Pro 2019: Sólidos como refrigerantes

- Aran Garcia-Leuke – Naukas Pro 2019: Intro a la nanoelectrónica

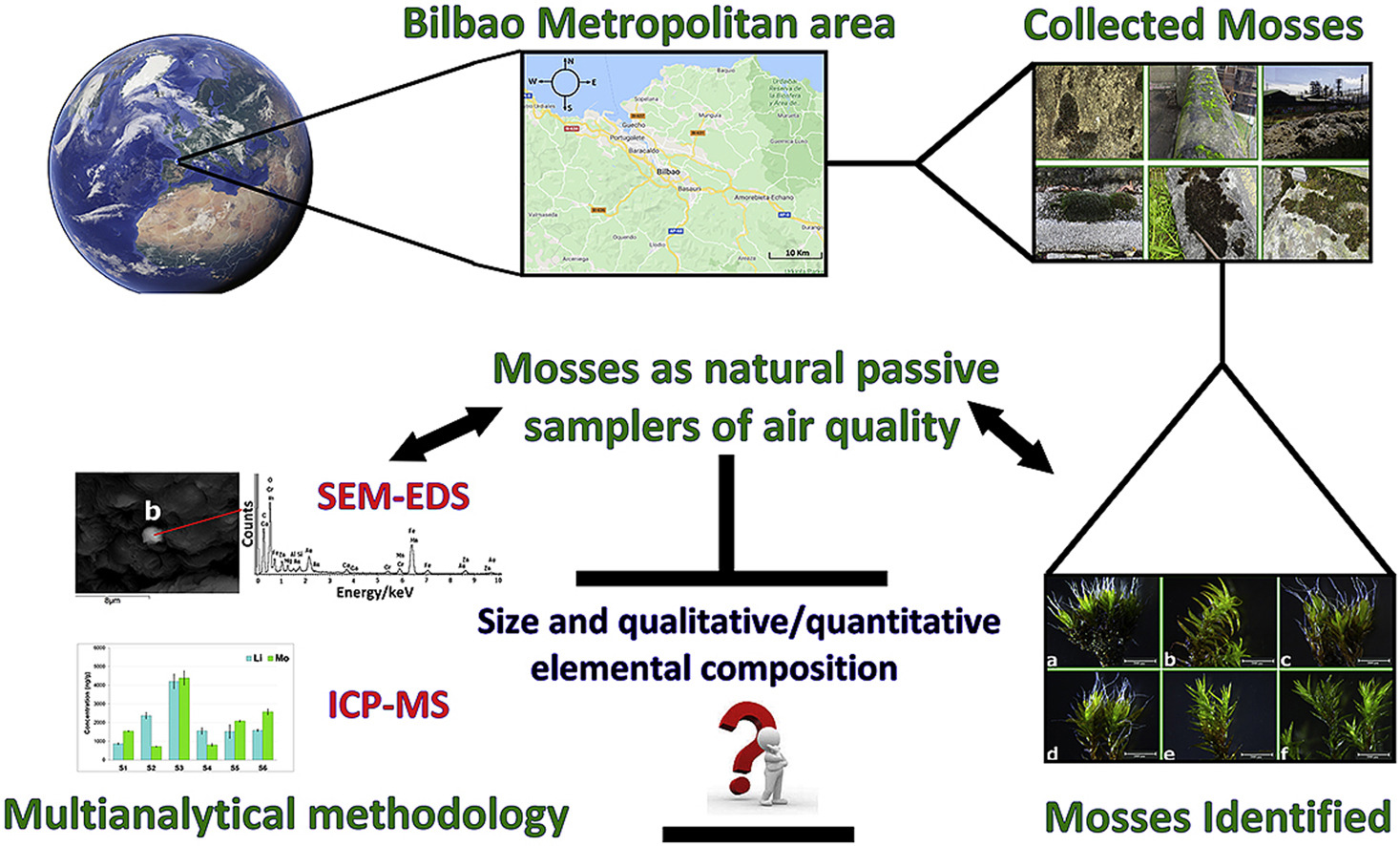

Musgos como biomonitores pasivos de la contaminanción por metales pesados

Grimmia pulvinata. Fuente: Wikimedia Commons

Grimmia pulvinata. Fuente: Wikimedia Commons¿Por qué crecen más unas especies de colonizadores, como es el caso de los musgos o los líquenes, en un lugar y no en otro? En opinión de la investigadora del grupo IBeA de la UPV/EHU Maite Maguregui, “ya solo visualmente, la presencia de algunas especies nos puede estar dando una idea de si la atmosfera de una determinada zona está más o menos contaminada, dependiendo de la especie de que se trata. El crecimiento de ciertas especies que son más o menos resistentes a la contaminación nos estaría dando información de la calidad atmosférica, por lo menos en el ámbito de los metales del material particulado”.

La biomonitorización es una metodología que considera el uso de organismos vivos para vigilar y evaluar el impacto de diferentes contaminantes en una zona conocida, relativamente barata y fácil de aplicar. Estos organismos, que tienen la capacidad de vigilar la contaminación, se conocen también como biomonitores pasivos, ya que son capaces de identificar posibles fuentes de contaminación sin necesidad de ningún instrumento adicional.

En el estudio realizado con muestras de seis emplazamientos vizcaínos (Muskiz, Getxo, Lutxana, Zamudio, Basauri y Amorebieta-Etxano), se aplicó una metodología multianalítica para verificar la utilidad de los musgos del género Grimmia que crecen naturalmente como biomonitores pasivos de la contaminación atmosférica por metales pesados. Una vez identificados los musgos según su morfología y taxonomía, se determinó la capacidad de los mismos para acumular material particulado, se identificaron las principales partículas metálicas depositadas y, finalmente, se definieron con mayor precisión los niveles de metales acumulados en cada musgo recogido.

Maguregui explica que no se trata de contaminación relacionada con un evento puntual, sino que “el musgo nos estaría mostrando un efecto acumulativo. El musgo no es nuevo, se ha podido desarrollar hace años y ha ido acumulando metales; eso nos mostraría cómo ha habido diferentes eventos a lo largo de los años”. Los resultados obtenidos mostraron que los diferentes metales pesados detectados en el material particulado atrapado y acumulado por los musgos están estrechamente relacionados con las actividades antropogénicas (tráfico rodado, emisiones del tráfico ferroviario y marítimo, emisiones de las industrias del hierro, emisiones de las refinerías de petróleo, emisiones de las centrales eléctricas, industrias de destilación de alquitrán, etc.). No obstante, Maguregui subraya que “en ningún momento hemos encontrado concentraciones preocupantes para la salud”.

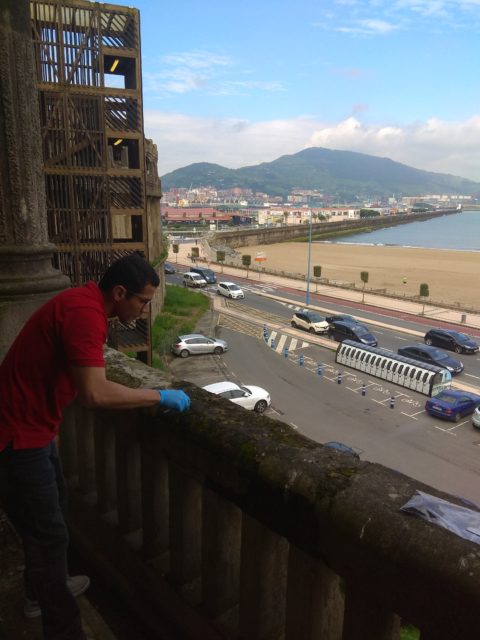

El investigador Euler Gallego Cartagena, primer autor del estudio, tomando muestras de musgos del género Grimmia en las Galerías de Punta Begoña, en Getxo. Fuente: UPV/EHU

El investigador Euler Gallego Cartagena, primer autor del estudio, tomando muestras de musgos del género Grimmia en las Galerías de Punta Begoña, en Getxo. Fuente: UPV/EHUCabe destacar la alta concentración de plomo en Punta Begoña (Getxo), siendo diez veces mayor que en los puntos de muestreo adicionales. En este caso y gracias a la relación con otras evidencias experimentales en soportes adicionales (partículas acumuladas en costras negras que crecen en los materiales de construcción), se pudo confirmar que esta zona fue altamente impactada por las emisiones de plomo en el pasado.

Por otra parte, “dado que en Lutxana la mayoría de los metales pesados (titanio, cobre, zinc, hierro y manganeso) mostraron concentraciones mucho más altas que en el resto de los puntos de muestreo, fue posible concluir que Lutxana es el punto de muestreo que muestra mayores concentraciones de metales en el material particulado atmosférico atrapado en los musgos. Por el contrario, el menos contaminado fue el muestreo de Zamudio”, concluye.

Referencia:

Euler Gallego-Cartagena, Héctor Morillas, José Antonio Carrero, Juan Manuel Madariaga, Maite Maguregui (2021) Naturally growing grimmiaceae family mosses as passive biomonitors of heavy metals pollution in urban-industrial atmospheres from the Bilbao Metropolitan area Chemosphere doi: 10.1016/j.chemosphere.2020.128190

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Musgos como biomonitores pasivos de la contaminanción por metales pesados se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Los umbrales ecológicos en la bioacumulación de metales

- La contaminación por metales pesados no llega a los tomates

- Membranas de celulosa nanoestructurada como sensores de metales

Ingredientes para la receta: El olivo

La paloma vino al atardecer, y he aquí que traía en el pico un ramo verde de olivo, por donde conoció Noé que habían disminuido las aguas de encima de la tierra.

Primera mención del olivo en la Biblia, Génesis 8, 11.

El olivo es la especie Olea europaea, de la familia Oleaceae, con unas 600 especies y, de ellas, 33 son del género Olea. En Olea europea se incluyen seis subespecies y variedades, con Olea europea var. europaea, el olivo cultivado de la cuenca mediterránea, y Olea europaea var. sylvestris, el acebuche, el olivo silvestre, con una distribución geográfica parecida.

El olivo es una especie mediterránea, sensible a las heladas y resiste temperaturas desde 35ºC hasta -10ºC. Las temperaturas muy altas perjudican la floración y, en general, prefiere una intensidad media de pluviosidad anual y tolera la sequía aunque la falta de agua afecta al crecimiento del árbol y la formación de hojas y frutos.

Crece a altitudes que van desde el nivel del mar hasta los 900-1000 metros. Prefiere colinas boscosas y siempre con clima mediterráneo: calor en verano, baja humedad ambiental, y temperatura baja en invierno pero sin helar.

El cultivo del olivo es una antigua tradición en la cuenca mediterránea, con una gran influencia en la ecología, economía y cultura de esta región. La primera vez que se ha encontrado el término Olea escrito fue en una tablilla griega fechada hace 16 siglos. Su importancia en la vida de las gentes ha convertido a este árbol en un símbolo desde las culturas más antiguas. Significa belleza, lozanía, fertilidad, salud, prestigio y paz.

Cuando ofrezcas una oblación de pasta cocida al horno, será de flor de harina en panes ázimos amasados con aceite, o en tortas ázimas untadas en aceite.

Levítico: 2, 4.

En la Biblia, incluyendo el Nuevo Testamento, hay 60 capítulos que citan el olivo, según datos publicados por Jules Janick, de la Universidad Purdue de West Lafayette, en Estados Unidos. Son seis los capítulos del Corán que citan este árbol. En los textos sagrados la planta cultivada que más aparece es la vid, con 90 citas en total. Y, después de la vid, están el dátil y el higo.

Las arboledas de olivos, los olivares, se consideran un ecosistema agrario con una gran multifuncionalidad y un potencial significativo de servicios del ecosistema relacionados con la provisión de frutos, las olivas o aceitunas, y madera, la regulación y retención del agua y la fijación de dióxido de carbono. Su transmisión entre generaciones supone el mantenimiento de la biodiversidad y de paisajes agrícolas de gran valor.

La selección de ejemplares para su cultivo se centra en conseguir la mejor adaptación a las condiciones ambientales del entorno concreto donde se plantará. También importa una gran producción y un rango amplio de aromas y sabores. De media, la composición en aceite de los frutos es del 22%.

En general, el olivo empieza a producir entre el tercer y quinto año de su plantación, con la mayor producción entre el octavo y el décimo año. Se mantiene en buena producción durante 25 a 30 años e, incluso, puede llegar a los 100 años de vida. La edad máxima, con evidencia científica, está alrededor de los 700 años. En Cataluña, en un estudio liderado por X. Arnau, de la Universidad Autónoma de Barcelona, con muestras de 14 olivos considerados monumentales, la edad máxima estimada fue de 627 años.

Tal vez podamos decir que el árbol más longevo es el que en todos los sentidos es capaz de persistir, como lo hace el olivo por su tronco, por su poder de desarrollar el crecimiento lateral y por el hecho de que sus raíces son tan difíciles de destruir.

Teofrasto (371-287 a C.)

Y hay que asumir que el olivo es una planta vecera, es decir, que da mucho fruto un año y poco o nada en el siguiente. La aceituna tarda en madurar unos ocho meses y, en ese tiempo, el árbol produce fitohormonas que inhiben la floración y, por tanto, de nuevos frutos para dedicar sus reservas a la maduración de los anteriores.

En la actualidad y desde la época de los romanos, se cultivan mezclados los olivos cultivados y los acebuches. Lo han estudiado en detalle, en el norte de Marruecos, Yildiz Aumeeruddy-Thomas y su grupo, del Centro de Ecología Funcional y Evolutiva de Montpellier. En estas plantaciones mixtas, los acebuches tienen interés medicinal, se produce aceite y, sobre todo, se hace para injertar olivos y plantar por estaquillado. Es una técnica que ya se conocía en tiempos de Homero. También utilizaron este método los almohades o, más recientemente, el gobierno español cuando Marruecos era una colonia.

Salvador Arenas y su grupo, de la Universidad de Oporto, calculan que hay más de 2000 tipos de olivo cultivado en todo el planeta y, en España, se han documentado 262 de ellos. Sin embargo, solo 24 son importantes y se cultivan con regularidad. En Andalucía hay 156 tipos pero solo siete se cultivan en extensión y ocupan el 90% del área dedicada al cultivo del olivo. Las siete variedades son Hojiblanca, Lechín de Sevilla, Manzanilla de Sevilla, Nevadillo Negro, Picudo, Picual y Verdial de Huévar. El Picual supone el 60% del cultivo y Hojiblanca el 20%. Muchas de estas variedades ya se cultivaban en el siglo XV.

España produce el 33% del aceite de oliva del planeta y, de ese porcentaje, el 80% se recoge en Andalucía. Los olivos ocupan más de cinco millones de hectáreas en la Europa mediterránea, con 2.6 millones en España y, de ellos, el 60%, o sea, 1.5 millones en Andalucía. Y para la aceituna se mesa, según la FAO y para 2011, España es el primer productor con casi ocho millones de toneladas, seguida por Italia con algo más de tres millones y Grecia con dos millones. En 2015, más del 90% de la producción de aceituna se recogía en el Mediterráneo.

El olivo cultivado ha sido introducido para su cultivo en muchas zonas de otros continentes y se ha naturalizado en entornos con clima mediterráneo como Australia, Nueva Zelanda, algunas islas del Pacífico, China, Sudáfrica, Perú, Chile, Brasil, México, el Caribe, California y Argentina.

Acebuche. Fuente: Bioeduca Málaga.

Acebuche. Fuente: Bioeduca Málaga.El olivo cultivado viene de la domesticación del acebuche. La explotación de este último está documentada desde el Neolítico en el Mediterráneo, en un área que va desde el Próximo Oriente hasta la Península Ibérica. La revisión de David Kaniewski y su equipo, de la Universidad de Toulouse, establece que la evidencia más antigua de uso del acebuche está fechada hace 19000 años en el yacimiento paleolítico de Ohalo II, junto al Mar de Galilea.

La hipótesis más aceptada sobre la domesticación del olivo la sitúa, hace unos 6000 años, en Oriente Próximo, con reproducción y selección por esquejes y estaquillado de los mejores ejemplares de acebuche. Pertenece al primer grupo de árboles domesticados, quizá por la facilidad de su reproducción y cultivo.

Pues si algunas de las ramas fueron desgajadas, y tu, siendo olivo silvestre, has sido injertado en lugar de ellas, y has sido hecho participante de la raíz y de la rica savia del olivo.

Pablo de Tarso, Epístola a los Romanos, 11:17.

También se sitúa la domesticación en el valle del Jordán hace 5500 años. Hace 5300 años ya existía un comercio importante de aceitunas y aceite de oliva en el Mediterráneo oriental. Hace unos 5000 años llegó a Egipto, aparece en papiros y era costumbre coronar a las momias con ramas de olivo. Fue tema de un himno del faraón Ramsés III al dios Ra: “He plantado muchos olivos en huertos, en la ciudad de Heliópolis; de estas plantas sale un aceite muy puro para mantener encendidas las lámparas de tu altar”.

Sin embargo, es notable que asirios y babilonios no utilizaban aceite de oliva; utilizaban aceites del sésamo y de la nuez.

Para conocer su distribución en el Neolítico, entre hace 5600 y 11500 años, Yolanda Cerrión y su grupo, del Centro de Investigaciones sobre Desertificación del CSIC en Moncada, Valencia, revisaron lo publicado sobre restos de madera, en general quemada, recuperados en yacimientos arqueológicos según los métodos de la Antracología. En total revisan los hallazgos de 34 yacimientos de toda la cuenca, con mayoría en la costa mediterránea occidental, en España y el sur de Francia.

El número de restos de Olea crece con el tiempo, desde los más antiguos a los más modernos. Los hay muy antiguos en yacimientos de la Península Ibérica, Sicilia, Chipre y Oriente Próximo. Hace 12000 años hay olivos o acebuches en Jericó y Abu Salem, y hace 10000 años en Atlit Yam, Horvat Galil y Divson, todos yacimientos en el actual Israel. También hay restos de madera en Chipre fechados hace 10000 años, con presencia continua y, según yacimientos, abundante. Aumentan los restos hace 7000 años y, como ejemplo, hay diversas plantas y, entre ellas el acebuche, en Pirineos de hace 5500 años. Por ello hay autores que sitúan un protocultivo de acebuche en el Península en el Neolítico de hace 7000 años.

Un yacimiento con olivo o acebuche en la Península Ibérica está en la Cueva de Nerja, al final del Pleistoceno. Y, a partir de hace 11000 años, se recuperan restos en varios yacimientos de la costa en Andalucía, Valencia y Cataluña y, también, en la costa atlántica, cerca del Guadalquivir, y en Portugal. Se supone que a la Península el olivo cultivado llegó de oriente en los viajes de exploración y comercio de fenicios, griegos, etruscos y romanos.

Vista aérea del yacimiento de Cástulo, rodeado de olivos. Fuente: Cástulo Linares

Vista aérea del yacimiento de Cástulo, rodeado de olivos. Fuente: Cástulo LinaresEn los estudios del yacimiento de Cástulo, cerca de Linares, en Jaén, se han encontrado restos que van desde la Edad del Bronce final, en el siglo VIII a.C. hasta la Edad Media, en el siglo IV d.C. Hay fases ibérica y romana. María Oliva Rodríguez-Ariza, de la Universidad de Jaén, se centra en los hallazgos antracológicos, es decir, de restos de carbón vegetal.

Encuentran Olea europaea como carbones de acebuche en la época ibérica y comienzo de la era romana, en el siglo II a.C. A continuación, con el imperio romano, entre el siglo I a.C. y la Alta Edad Media, en el siglo IX, recogen restos de carbón de olivo cultivado.

Cuando extendieron el estudio a 57 yacimientos andaluces, fechados desde hace 32000 años hasta el periodo romano en el siglo III, confirmaron los resultados de Cástulo. El cultivo del olivo comienza en la ápoca romana, en los siglos I a IV, y, además, por primera vez encuentran restos de olivo fuera del área de distribución del acebuche. El olivo fue transportado hacia zonas donde era posible su cultivo y, por ello, el área de distribución del olivo en la cuenca mediterránea es más extenso que el del acebuche.

Pollo relleno de aceitunas (Apicio, Roma, siglo I)

Machacar pimienta, comino, un poco de tomillo, hinojo en grano, menta, ruda, raíz de benjuí, rociar con vinagre, añadir dátiles y picar bien; amalgamar con miel, garum, vinagre y aceite … Rellenar la tripa de aceitunas verdes abiertas, cerrarlo y cocer. Cuando haya cocido, sacar las aceitunas … Presentar el pollo frío y secado con un paño, por encima se le echará la salsa antes de servirlo.

En la Roma imperial, aceitunas y pan eran la dieta habitual del campesino y de las clases trabajadoras, aunque también lo tomaban temprano, a la mañana, patricios y filósofos como, por ejemplo, Séneca. A menudo, el pan se untaba con aceite de oliva, se aromatizaba con ajo y se acompañaba de queso.

Además de restos de madera, también se encuentran huesos de aceituna, a menudo parcialmente quemados. Según Ehud Galili y sus colegas, de la Autoridad de Antigüedades de Israel, también evidencian que la domesticación el olivo, posterior a la de los cereales, ocurrió en el sexto milenio antes de nuestra era, hace unos 8000 años.

En general, las aceitunas no se comen sin tratar, por su amargor e, incluso, pueden ser peligrosas para la salud porque llevan un glucósido fenólico llamado eleuropeina.

Galili propone que la explotación del olivo se extendió en varias zonas cuando se desarrollaron las técnicas para prensar las aceitunas y extraer el aceite. Hay pruebas de estas técnicas, de hace 7000 años, en Samaria, en el valle del Jordán y en los Altos del Golan, en el actual Israel. En yacimientos al sur de Haifa hay evidencias de extracción de aceite con vertidos de huesos de aceitunas y de pulpa del prensado. Son yacimientos, fechados hace 6500 años, que se han conversado bien al estar sumergidos en el mar.

La extracción del aceite se hace en estructuras circulares construidas con piedras, de unos 60 centímetros de fondo y de diámetro. Se colocan las aceitunas en su interior, se prensan con morteros circulares de madera con piedras encima. Galili menciona que técnicas semejantes todavía se utilizan en Oriente Próximo.

Es difícil distinguir, solo por los huesos del fruto, si lo que se prensa es acebuche u olivo cultivado. Para Galili, lo más plausible es que sean de acebuche. Nili Lilpschitz y su grupo, de la Universidad de Tel Aviv, encuentran evidencias relacionadas con la extracción de aceite de oliva, como lámparas o candiles, vasijas para almacenarlo e instalaciones para prensarlo. A la vez, encuentran polen de olivo en yacimientos de la Edad del Bronce Temprana, hace 5200 años. Sin embargo, el pequeño tamaño de los huesos de los frutos utilizados lleva a Lipschitz a proponer que son de acebuche y no de olivo cultivado. Son conclusiones similares a las propuestas de Galili.

En la Edad del Bronce Tardía y como en el estudio anterior en Palestina, Evi Margaritis, de la Escuela Americana de Estudios Clásicos de Atenas, obtiene parecidos resultados en Grecia. Plantea la hipótesis de que, en primer lugar, se utilizó la madera como leña y para la construcción, lo que llevó a consumir aceitunas y a gestionar la selección de árboles para favorecer su producción. Y no es fácil distinguir acebuches y olivos cultivados. Propone la hipótesis, sin evidencias, de que la domesticación o, si se quiere, la selección de árboles puede haber ocurrido en varios episodios y en diferentes lugares.

El acebuche ocupa, en la actualidad, las áreas más cálidas de la cuenca mediterránea. En el oeste es zonas con una temperatura media anual de 17-19ºC y la temperatura media más fría no debe bajar de 6ºC. No ocupa altitudes más allá de los 500 metros. El olivo es más flexible a las condiciones climáticas y ambientales y, por ello, su área de dispersión en mayor que la del acebuche. Llega a zonas más altas, más frías y con más diferencias en la temperatura.

Sin embargo, los estudios genéticos muestran varios orígenes el olivo en toda la cuenca mediterránea. Quizá se deben a una diversificación secundario, con múltiples cruces entre olivos y acebuches más que a sucesos múltiples de domesticación del cultivo. Guillaume Besnard y su grupo, de la Universidad de Toulouse, han revisado el genoma de los cloroplastos, orgánulos encargados de la fotosíntesis, en 1263 acebuches y 534 olivos.

Los resultados muestran tres linajes diferenciados. Dos de ellos se sitúan en el centro y el oeste de la cuenca, mientras que el tercero está en toda la cuenca.

Para Besnard, la primera domesticación del olivo ocurrió en el norte del Levante mediterráneo, entre Siria, Irak y Turquía, y se dispersó el olivo domesticado por la cuenca con la expansión de las civilizaciones, el comercio y las migraciones.

El grupo de la Universidad de Montpellier dirigido por Catherine Breton, después de analizar 411 variedades de olivo y 958 muestras de acebuche, concluye que los cultivados tienen nueve orígenes pero, por lo menos la mitad, vienen de cruces de los tres linajes originales. El flujo de genes entre acebuche y olivo es continuo y se movió hacia el este y el oeste de la cuenca.

Los datos arqueológicos y genéticos que indican la existencia de tres linajes de Olea apoyan la hipótesis, según Anne Dighton y su equipo, de la Universidad de Queensland en Brisbane, Australia, de que la domesticación del olivo se inició en Oriente Próximo, aunque se han propuesto otros centros, según los linajes, en el centro y el oeste del Mediterráneo.

Los estudios genéticos llevan a la frontera actual entre Siria y Turquía, según los hallazgos de Dighton. Pero los datos arqueológicos llevan la domesticación a las colinas alrededor del valle del Jordán, en Palestina.

Las fechas serían hace algo más de 8000 años o, quizá más atrás en el tiempo, pues las primeras pruebas de prensar olivas para extraer aceite son de hace 7000 años, aunque también se extrae del acebuche. Y, posteriormente, por selección y con tiempo, se llegó al olivo.

El cultivo del olivo, como el de la vid, acompañó la aparición y desarrollo de las civilizaciones más antiguas del Mediterráneo. Sin embargo, la extensión de su cultivo por la cuenca mediterránea ha tenido episodios de aparición y desaparición lo que, de alguna forma, ayuda a comprender la existencia de linajes diferentes y de muchos tipos. Alessia D’Auria y su grupo, de la Universidad Federico II de Nápoles, han encontrado su cultivo en Calabria, en el sur de Italia, durante la primera Edad del Bronce. Han analizado los restos de madera encontrados en un yacimiento y fechados en los siglos 18-21 antes de nuestra era y, después, en la Edad del Bronce tardía, en los siglos 12-13 de nuestra era.

En la primera Edad del Bronce abundan los restos de olivo que los autores proponen que es cultivado aunque, también, hay acebuche. Parece que el cultivo se inicia por contacto con los griegos.

En el Bronce tardío, hay menos restos de madera de olivo y más de encina. El país perdió población y el cultivo del olivo se sustituyó por bosques de encina. Dafna Langutt y su grupo, de la Universidad de Tel Aviv, con muestras de polen del fondo del Mar de Galilea, llegan a conclusiones parecidas. Hay polen de olivo en la Edad del Bronce temprana, hace 4500 años y, después, baja la cantidad y se mantiene así durante el resto de la Edad del Bronce, hace unos 3600 años.

Cuando compara sus resultados con los yacimientos de Siria para dilucidar si la domesticación del olivo ocurrió en el Jordán o en Siria, Langutt encuentra que, mientras en el Jordán el máximo de polen de olivo aparece hace unos 5000 años y luego disminuye, en Siria, en el yacimiento Tell Sukas, el polen es más numeroso desde hace 4500 años y se mantiene alto hasta los 3000 años y, más tarde, desciende. Son datos que encajan entre sí: en Galilea, porcentajes altos al principio, hace 5000 años, bajan y hasta los 3000 años no vuelven a subir; en Siria, bajos al principio y suben desde los 4500 hasta los 3000 años y, a continuación, bajan.

Para Langgut hubo una época de mucha sequía pero, sobre todo, el cambio se produjo por actividades humanas. Fueron movimientos de población, cambios en las rutas comerciales, el transporte de olivas al Egipto de los faraones y varios conflictos bélicos.

El resumen de Langgut sobre el origen y expansión del cultivo del olivo por el Mediterráneo, publicado en 2019, utiliza datos de polen encontrado en yacimientos arqueológicos. Los datos llevan hasta hace 6500 años en el Levante mediterráneo, entre el valle del Jordán y el sur de Siria. Entre hace 5500 y 6000 años ya había olivos en la islas del Egeo. Y en la actual frontera entre Siria y Turquía aparece hace 4800 años. A los 3200 y 3400 años hay polen de olivo en la Anatolia y en Italia. El más antiguo que conocemos en la Península Ibérica está fechado hace 2500 años. Otra evidencia que apoya estas fechas para la Península es que, por su morfología y tamaño, los huesos de aceituna que aparecen en Siria en la Edad del Bronce, unos 1000-1500 años después ya se encuentran en España y en el sur de Francia.

El cultivo del olivo, la obtención de aceite y su almacenaje, uso y comercio suponen un grupo social estable y si, además, hay algún sistema de riego para aumentar la producción se necesita una comunidad organizada.

No traigo ningún anuncio de guerra, ningún impuesto de homenaje, tengo el olivo en mi mano; mis palabras están llenas de paz.

William Shakespeare, Noche de reyes, 1602.

Los olivos (1889) de Vincent van Gogh. Óleo sobre lienzo. 72.6 x 91.4 cm. Fuente: Museum of Modern Art (MoMA).

Los olivos (1889) de Vincent van Gogh. Óleo sobre lienzo. 72.6 x 91.4 cm. Fuente: Museum of Modern Art (MoMA).Para terminar, lo que ahora conocemos del olivo y sus cuidados no ha cambiado mucho en los últimos 3000 años. No ha variado sustancialmente los procesos básicos del cultivo, la tecnología y el equipamiento necesario para la obtención del aceite.

Estoy luchando por capturar la luz de los olivos. Es plateada, a veces azulada, a veces verdosa, blanquecina, sobre un fondo amarillo, rosa, violeta o naranja a ocre roja. Es muy difícil … [unos meses más tarde] Por fin, ya tengo un paisaje con olivos.

Vincent Van Gogh, 1889.

Y; para terminar, una receta moderna, un suspiro de aceite de oliva, publicada en 2006 pero con origen en el Celler de Can Roca en Girona.

Aceite texturizado (o, si se quiere, solidificado)

(Diccionario: Texturizar. Tratar los hilos de las fibras sintéticas para darles buenas propiedades textiles):

Se pone aceite en un cuenco, tapado con film, y se mete doce horas en el congelador a -20ºC. Después se pasa a la nevera, a 3ºC, otras doce horas. Se recoge el aceite sólido (o texturizado) con dos cucharas para darle forma ovoide y alargada (quenelle en término técnico) y se coloca sobre una lámina de pan tostado cortado fino para servir de inmediato.

Y, también, una receta para pobres tal como la cuenta el doctor Juderías.

Cavero con aceite (Diccionario: Cavero. Obrero dedicado a abrir zanjas de desagüe en las tierras labrantías).

Se corta un buen pedazo de pan y se le hace, quitando la miga, un agujero en el centro. Echamos una chorretada de aceite crudo de oliva; se espolvorea de sal o de azúcar, a gusto del comensal, y un polvillo de pimentón.

Es el desayuno de los romanos o, quizá, un derivado evolutivo.

Referencias:

Apicio, Marco Gavio. 2007. El arte de la cocina. De re coquinaria. Comunicación y Publicaciones. Barcelona. 119 pp.

Arenas-Castro, S. et al. 2020. Projected climate changes are expected to decrease the suitability and production of olive varieties in southern Spain. Science of the Total Environment 709: 136161.

Arnau, X. et al. 2012. The age of monumental olive trees (Olea europaea) in northern Spain. Dendrochronologia 30: 11-14.

Aumeeruddy-Thomas, Y. et al. 2014. Beyond the divide between wild and domesticated: Spaciality, domesticity and practices pertaining to fig (Ficus carica L.) and olive (Olea europaea L.) agroecosystems among Jbala communities in Northern Morocco. En “Plants and people. Choice and diversity through time”, p. 191-197. Ed. Por A. Chevalier et al. Oxbow Books. Oxford & Philadelphia.

Aumeeruddy-Thomas, Y. et al. 2017. Ongoing domestication and diversification in grafted olive-oleaster agroecosystems in Northern Morocco. Regional Environmental Change DOI: 10.1007/s10113-017-1143-3

Besnard, G. et al. 2013. The complex history of the olive tree: from Late Quaternary diversification of Mediterranean lineages to primary domestication in the northern Levant. Proceedings of the Royal Society B 280: 20122833.