Naukas Bilbao 2022: Un telescopio de oro

El telescopio espacial James Webb lleva 48 gramos de oro en forma de una capa de solo 100 nanómetros de espesor, recubriendo los espejos hexagonales que aparecen en el cartel anunciador del evento. Y ¿por qué de oro? Eso nos lo explica Ángel Gómez Roldán en su charla.

Ángel Gómez Roldán ha sido durante muchos años operador de telescopio en el Observatorio del Teide del Instituto de Astrofísica de Canarias, es autor y coautor de varios libros de divulgación astronómica, pertenece a multitud de sociedades y ha recibido varios premios por su tarea divulgativa a lo largo de los años. Es el director y editor de la revista Astronomía.

Si no ve correctamente el vídeo, use este enlace.

Más sobre el tema:

El sucesor del Hubble: el telescopio espacial James Webb

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Bilbao 2022: Un telescopio de oro se ha escrito en Cuaderno de Cultura Científica.

Apibioma y antropización

El conjunto de microorganismos de una colmena de abejas melíferas (el apibioma) varía considerablemente dependiendo del grado de transformación que haya ejercido el ser humano (antropización) sobre el entorno. Tras trasladar colmenas de un entorno agrícola a uno seminatural en tan solo 16 días el desequilibrio microbiano disminuye.

Foto: Maxime Bouffard / Unsplash

Foto: Maxime Bouffard / UnsplashLa abeja melífera occidental (Apis mellifera) está en peligro debido a muchos de los factores de estrés que sufren en zonas dependientes de los seres humanos, como la mala nutrición, los pesticidas y los patógenos. “Desde hace varios años se está evidenciando que la mortalidad de las abejas ha aumentado mucho; es por eso que hace unos 6 años empezamos a investigar qué factores influyen en la microbiota de la abeja y qué relación tiene esto con las enfermedades o la salud de las abejas”, explica Iratxe Zarraonaindia, investigadora Ikerbasque del grupo Applied Genomics and Bioinformatics de la UPV/EHU.

En colaboración con tres universidades croatas el grupo ha tenido la oportunidad de investigar algunas colmenas situadas en la isla croata de Unije, lejos de la influencia humana. Durante diez años estas colmenas no han recibido tratamiento alguno; se sabía que sus abejas tenían una larga supervivencia a pesar de la presencia del ácaro Varroa destructor, causante de una enfermedad mortal para las abejas. La idea era estudiar cómo influye la antropización en la microbiota de las abejas. Para ello, se han comparado las colmenas de la isla de Unije con la microbiota de dos colmenas situadas en zonas rurales.

Para que las dos colmenas de la zona agrícola fueran comparables, se han utilizado «hermanas genéticas» (colmenas formadas por abejas que contienen el mismo material genético que las de la zona agraria), una de las cuales se ha trasladado a una zona seminatural. “Hemos visto claramente que la antropización tiene un impacto importante, ya que sólo 16 días después detectamos que el desequilibrio microbiano por estrés agrícola se había atenuado en la colmena trasladada a la zona seminatural”, explica Zarraonaindia. Esto demostraría que la microbiota de las abejas melíferas tiene una gran capacidad de adaptación. “No suponíamos que la composición de la microbiota fuera a cambiar tan rápido”, dice.

Los investigadores han encontrado un claro gradiente relacionado con el grado de antropización y la comunidad microbiana de la colmena: “La microbiota de la colmena de la isla Unije está más equilibrada, su proporción de microorganismos beneficiosos es mayor y en ambiente seminatural la proporción va reduciéndose, mientras que en el ámbito agrícola la colmena tiene una composición muy desequilibrada, se encuentran más bacterias oportunistas y es más sensible a las enfermedades”, explica Zarraonaindia. Según la investigadora, “en las zonas agrícolas los factores de estrés están muy activados”.

Las investigadoras del grupo Applied Genomics and Bioinformatics Andone Estonba e Iratxe Zarraonaindia en la isla Unije, preparando las colmenas para el estudio, junto a sus colegas croatas. Foto: Marin Kovačić / Universidad de OsijekInvestigación del apibioma

Las investigadoras del grupo Applied Genomics and Bioinformatics Andone Estonba e Iratxe Zarraonaindia en la isla Unije, preparando las colmenas para el estudio, junto a sus colegas croatas. Foto: Marin Kovačić / Universidad de OsijekInvestigación del apibioma

Estas conclusiones han permitido al grupo investigador determinar biomarcadores que aportarán información sobre la salud de las abejas. Por ejemplo, los investigadores han detectado que una bacteria determinada, Arsenophonus, es muy abundante en las zonas agrícolas, que está menos presente en las zonas seminaturales, y que apenas aparece en las zonas naturales.

Han estudiado la colmena en su totalidad, no sólo las abejas. Esta es una de las claves más importantes de esta investigación: “Este enfoque es innovador. Hemos estudiado el apibioma: el conjunto de microorganismos en los nichos presentes en la colmena. Hemos estudiado el intestino de las abejas, la entrada de la colmena, el pan de abeja (la sustancia de la que se alimentan las abejas) y el aire interior de la colmena”. Como se ha comentado anteriormente, la bacteria Arsenophonus es la más frecuente en la zona agrícola, y se trata de una tendencia que se ha encontrado en todos los nichos. Por lo tanto, es un biomarcador muy adecuado para medir el impacto de la agricultura en las colmenas y medir su salud; además, “este método no es invasivo, ya que se puede llevar a cabo tomando una muestra de la entrada de la colmena”.

La investigación recogida en el artículo de referencia solo representa un primer año de trabajo. Las investigaciones continúan: “Ahora hemos trasladado la colmena de la zona seminatural a una zona natural para observar si se le equilibra la microbiota y llega a ser la misma que la de las abejas de la zona natural. Esto nos permitirá conocer el alcance tanto de la contribución genética como de la contribución ambiental”.

Referencia:

June Gorrochategui Ortega, Marta Muñoz Colmenero, Marin Kovačić, Janja Filipi, Zlatko Puškadija, Nikola Kezić, Melanie Parejo, Ralph Büchler, Andone Estonba, Iratxe Zarraonaindia (2022) A short exposure to a seminatural habitat alleviates the honey bee hive microbial imbalance caused by agricultural stress Scientific Reports DOI: 10.1038/s41598-022-23287-6

Para saber más:

Qué puedes hacer tú para proteger a las abejas

La mente de una abeja

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Apibioma y antropización se ha escrito en Cuaderno de Cultura Científica.

Los invasores: La perca del Nilo

Perca del Nilo (Lates niloticus). Fuente: Wikimedia Commons

Perca del Nilo (Lates niloticus). Fuente: Wikimedia CommonsEs un invasor de otros hábitats, no de nuestro entorno más cercano y, sin embargo, desde aquí subvencionamos esa invasión. Y, es curioso, ahora ni eso pues ha desaparecido, que sepamos, de nuestros mercados. Es un pez de gran tamaño, de agua dulce y hasta 1.80 metros de longitud y 200 kilogramos de peso, que vive en África central y oriental y que, para promocionar la pesca, se ha introducido en lagos y ríos de ese continente. Durante un tiempo, era habitual verlo a la venta en pescaderías y supermercados de nuestro entorno pero en poco tiempo ha desaparecido. Ya no se vende porque adquirió mala fama pues era típico que se ofreciera sustituyendo a otras especies como, por ejemplo, el mero, en los menús del día de muchos restaurantes. En el estudio de José Luis Horreo y sus colegas de la Universidad Complutense con 77 platos de pescado en el menú de 53 restaurantes de Madrid, publicado en 2019, siete especies y el 30% de las muestras están mal etiquetadas en cuanto a la especie que indican. Y entre ellas varios platos de mero, Epinephelus marginatus, contienen perca del Nilo cuyo parecido con esa especie es muy alto.

Además, un estudio detallado que lleva varios años en marcha ha encontrado que los cíclidos del lago Victoria están desapareciendo al ser alimento para la perca del Nilo, un depredador voraz.

Los cíclidos son peces de agua dulce del hemisferio sur, sobre todo de África, y muy populares entre los aficionados a los acuarios; entre ellos están los discos o los peces ángel. Los que habitan en Lago Victoria son únicos y han aparecido en una radiación evolutiva única entre los vertebrados. Antes de llegar la perca había más de 300 especies que ocupaban una gran variedad de nichos y, por ello, cada hábitat del lago tenía su propia comunidad de cíclidos.

La perca del Nilo, un “elefante” del agua dulce por su tamaño, fue introducido en el norte del lago y avanza hacia el sur alimentándose de los cíclidos. Donde se ha hecho dominante, más de la mitad de las especies de cíclidos han desaparecido. Ha sido introducida en otros lagos africanos y como decía, en el caso mejor conocido, en el Lago Victoria al que llegó en la década de los cincuenta para reforzar la pesca y promocionar la pesca deportiva para turistas.

Ejemplar de perca del Nilo capturado en el lago Victoria, en aguas de Uganda. Habida cuenta del efecto de la perspectiva la longitud de la perca es aproximadamente la altura del hombre. Fuente: Wikimedia Commons

Ejemplar de perca del Nilo capturado en el lago Victoria, en aguas de Uganda. Habida cuenta del efecto de la perspectiva la longitud de la perca es aproximadamente la altura del hombre. Fuente: Wikimedia CommonsEs un lago con una superficie de 68.000 kilómetros cuadrados y su costa se reparte entre tres países con el 51% en Tanzania, el 43% en Uganda y el 6% en Kenia. En 2007, alrededor de tres millones de personas dependían de la pesca en el lago.

Para 1980, la perca suponía el 2% de la pesca en el Lago Victoria; para 1986, era el 80%. Fue en los años 1983-84 cuando se detectó un crecimiento dramático de las poblaciones de perca del Nilo. Además, la pesca en el lago era de 100.000 toneladas anuales en los sesenta y, tres décadas después, en los noventa e incluyendo la perca del Nilo, llegaba a las 500.000 toneladas. Mas datos de la pesquería en Uganda muestran que los peces nativos pasaron de casi el 92% a casi cero entre 1981 y 1985 y, por el contrario, la perca pasó, en esas fechas, del 5% al 96%.

El número de pescadores aumentó un 32% en 2002, las embarcaciones lo hicieron en un 24%, las redes en el 50% y el número de anzuelos de palangre se dobló. Incluso la potencia de los motores fuera borda de las embarcaciones de los pescadores creció un 47%. El número de barcos pasó de 12.000 en 1983 a 23.000 en 1990 y 42.000 en 2000. Todo ello es, concluye John Balirwa, del Instituto Nacional de Recursos Pesqueros de Uganda en Jirja, un caso claro de síntomas de sobreexplotación.

Además, la perca capturada se destinó a ser fileteada para la exportación mientras que para los habitantes de la costa solo quedaban los desechos como los esqueletos, las cabezas o las colas o, también los ejemplares de tamaño pequeño. Los salarios han caído, el sistema tradicional de pesca familiar casi ha desaparecido, escasea la alimentación adecuada y el número de personas que sufren hambre había crecido un 25% en los últimos diez años según datos de 2007.

Por todo ello, la perca del Nilo aparece en la lista de las 100 especies invasoras más peligrosas del planeta.

La perca del Nilo, Lates niloticus, es una especie de agua dulce con una distribución original por África tropical y nativa del Congo, Senegal, Níger y, en concreto, en el Nilo, el lago Chad, Volta o Turkana. Es parte sustancial de la economía y la alimentación de África Oriental. Puede alcanzar gran tamaño y en la madurez llega a una longitud de 1.20-1.40 metros, con un peso de hasta 200 kilogramos. Crece entre 21 y 28 centímetros por año y hay datos de que puede llegar a los 40 centímetros anuales. Es un predador feroz que ocupa todos los ambientes con suficiente oxígeno y se alimenta de peces, incluso ejemplares de su propia especie, así como crustáceos, moluscos e insectos. Habitualmente se mueve en grupo como sistema de defensa ante otros predadores, entre ellos los de su especie.

Probaremos la perca del Nilo con una receta fácil de la cocina de Tanzania según la experta Eva Pendaeli-Sarakikya. Vamos a freír unos filetes de perca.

Filetes de perca del Nilo fritos servidos en un hotel de Zambia. Fuente: Wikimedia Commons

Filetes de perca del Nilo fritos servidos en un hotel de Zambia. Fuente: Wikimedia CommonsMezclamos harina, sal y pimienta y, a la vez, limpiamos los filetes de perca con un trapo limpio hasta que estén secos. Recubrimos los filetes con la mezcla de harina. Para freír usaremos grasa animal, quizá manteca. La calentamos y freímos los filetes por ambos lados, bajamos el fuego y seguimos hasta que estén marrón dotado. Los servimos en caliente, quizá adornados con rodajas de limón.

Introducida de forma activaLlegó al Lago Victoria, en África Oriental, a Uganda, según relata Robert Pringle, de la Universidad de Oxford, en la década de los cincuenta del siglo pasado, hacia 1954 por iniciativa de funcionarios británicos de la colonia. El objetivo era contrarrestar la caída de los stocks de peces nativos que comenzaban a escasear debido a la sobrepesca. En los sesenta, la mayoría de las especies de peces de gran tamaño del Lago Victoria estaban sobreexplotadas. La respuesta de las autoridades fue la introducción de la perca. Sin embargo, contribuyó a la extinción de más de 200 especies endémicas por depredación y competencia por el alimento.

Además, la acción de la perca provocó la invasión de algas y, sobre todo, del jacinto acuático o Euchornia crassipes. Así disminuyó el oxígeno en las aguas del lago lo que ayudó a la extinción de más especies de cíclidos. Para Tijs Goldschmidt y sus colegas, de la Universidad de Leiden, en Holanda, el 18% de los cíclidos se alimentaban de fitoplancton y hasta el 31% lo hacían de detritos. En total, calculan que más del 58% de su alimento son fitoplancton y detritos. La desaparición de estas especies aumentó la turbidez de las aguas del lago con más fitoplancton, mayor escasez de oxígeno y contribuyó a la colonización por el jacinto acuático.

El aumento de población de la perca del Nilo se detectó a finales de los setenta en Kenia, a principios de los ochenta, un par de años después, en Uganda, y a mediados de esta década en Tanzania, según la revisión publicada en 2008 por Kees Goudswaard y sus colegas, también de la Universidad de Leiden, en Holanda.

Puesto de pescadería en la orilla ugandesa del lago Victoria. En primer plano, piezas de perca del Nilo.La perca del Nilo cambió la economía local

Puesto de pescadería en la orilla ugandesa del lago Victoria. En primer plano, piezas de perca del Nilo.La perca del Nilo cambió la economía local

Además, la introducción y pesca de la perca del Nilo cambió el sistema socioeconómico de los habitantes del lago. Muchos de los habitantes han sido desplazados de sus ocupaciones tradicionales en la pesca y el comercio de los productos pesqueros y se han visto obligados a entrar en las empresas que se dedican a la preparación y exportación de perca del Nilo. Son, en este momento, refugiados económicos. La preparación de la perca no es la habitual para los cíclidos. Tiene más componentes grasos y no funciona bien el secado al sol y, además, necesita el ahumado. Por tanto, necesita madera para quemar en una región con problemas de deforestación.

Todo ello se refleja en el documental La pesadilla de Darwin, estrenado en 2004, y dirigido por Hubert Sauper. En la película aparece el comercio en tres etapas que se ha desarrollado con la exportación de la perca del Nilo a Europa en aviones de Rusia que, una vez descargado el pescado en Europa, viajan a Rusia y cargan armas que llevan al centro de África y surten a las numerosas guerrillas que allí operan. En el lago ahora se reúnen pescadores locales, ejecutivos financieros internacionales, ministros africanos, niños sin hogar, comisarios de la Unión Europea, pilotos rusos y prostitutas locales. Para su director, Hubert Sauper, el documental “es una historia sobre seres humanos del norte y del sur, sobre la globalización y sobre pescado”. Es un buen resumen.

En 2003 las exportaciones a la Unión Europea llegaron a 169 millones de euros. Sin embargo, las exportaciones totales de perca del Nilo en el comercio mundial cayeron casi un 30% en 2020. Entre los exportadores están Tanzania, Uganda, con el 65% del total, y Kenia, países que rodean el Lago Victoria. Entre los importadores están y pertenecen a la Unión Europea, Polonia, Rumania y Grecia, con el 23% del total. España, en 2020, importó el 6.50%.

Hay que añadir que la pesca deportiva de perca del Nilo atrae a numerosos turistas a Uganda, Tanzania y Kenia. También se ha propuesto la introducción de la perca del Nilo en Australia pero expertos como Christopher Barlow y Allan Lisle, de la Estación de Investigación de Walkamin, se oponen a ello y argumentan con datos de lo que ha supuesto la perca en el lago Victoria para la fauna indígena. Los riesgos asociados se consideran muy superiores a los futuros beneficios. Se ha abandonado la propuesta.

Pero, años después, en 2013, biólogos de la Universidad de Leiden, en Holanda, descubren que, más o menos, un 25% de las especies de cíclidos se han recuperado del “desierto” que provocó la perca e, incluso, algunas de las especies recuperadas son ahora más abundantes que en el pasado. Algunas de esas especies recuperadas han cambiado en parte su morfología y son más ágiles y rápidas para huir de los depredadores, entre ellos, de la perca del Nilo.

Y para terminar no hay nada mejor que una buena receta, algo más complicada que la anterior. Es perca al curry, un plato que muestra la influencia de la cocina de la India, al otro lado del Océano Índico, sobre el África Oriental.

Primero cortar en cubos un filete grueso de perca. Después pelar y picar ajo, cebolla y tomate. Mezclar pimentón, ralladura de coco, zumo de limón, sal y curry en polvo. Calentar aceite o manteca en la sartén y freír al ajo y la cebolla y añadir la mezcla anterior. Solo unos minutos y añadir el tomate y cocinar algo más. Añadir los cubos de perca, leche y agua y cocinar suave un cuarto de hora o algo más hasta que el pescado esté hecho. Servir caliente.

Referencias:

Altimira i Palau, J. 2007. Efectos socioeconómicos y medioambientales de la introducción de la Perca del Nilo (Lates niloticus) en el Lago Victoria. Ecología Política 32: 111-114.

Balirwa, J.S. 2007. Ecological, environmental and socioeconomic aspects of the Lake Victoria’s introduced Nile perch fishery in relation to the native fisheries and the species culture potential: lessons to learn. African Journal of Ecology 45: 120-129.

Barlow, C.G. & A. Lisle. 1987. Biology of the Nile perch Lates niloticus (Pisces: Centropomidae) with reference to its proposed role as a sport fish in Australia. Biological Conservation 39: 269-289.

Chapman, L.J. et al. 2008. Biodiversity conservation in African inland waters: Lessons of the Lake Victoria region. Verhandlungen des Internationalen Verein Limnologie 30: 16-34.

De Zeeuw, M.P. et al. 2013. Two new species of zooplanktivorous haplochromine cichlids from Lake Victoria. ZooKeys 256: 1-34.

Goldschmidt, T. et al. 1993. Cascading effects of the introduced Nile Perch on the detritivorous/phytoplanktivorous species in the sublittoral areas of Lake Victoria. Conservation Biology 7: 686-700.

Goudswaard, K. (P.C.) et al. 2008. The invasion of an introduced predator, Nile perch (Lates niloticus, L.) in Lake Victoria (East Africa): chronology and causes. Environmental Biology of Fishes 81: 127-139.

Horreo, J.L. et al. 2019. Amplification of 16S rDNA reveals important fish mislabeling in Madrid restaurants. Food Control 96: 146-150.

IUCN. 2000. 100 of the World’s worst invasive alien species. A selection from the Global Invasive Species Database. University of Auckland. New Zealand. 10 pp.

Mercadal Orfila, R. 2005. La pesadilla de Darwin. Making of: cuadernos de cine y educación 35: 16-21.

Pendaeli-Sarakikya, E. 1978. Tanzania cookbook. Tanzania Publ. House. Dar Es Salaam. 165 pp.

Prados, L. 1999. El mayor lago de África se muere por la introducción de especies foráneas. El País 21 noviembre.

Pringle, R.M. 2005. The origins of the Nile Perch in the Lake Victoria. BioScience 55: 780-787.

Wanink, J.H. 1991. Survival in a perturbed environment: the effects of Nile perch introduction on the zooplanktivorous fish community of Lake Victoria. En “Terrestrial and aquatic ecosystems: perturbation and recovery”, p. 268-275. Ed. por O. Ravera. Ellis Horwood Ltd. Chichester.

Wikipedia. 2023. Nile perch. 23 January.

Wilson, E.O. 1995. La diversidad de la vida. En defensa de la pluralidad biológica. Círculo de Lectores. Barcelona. 561 pp.

Para saber más:

Catástrofe Ultravioleta #18 INVASORES

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Los invasores: La perca del Nilo se ha escrito en Cuaderno de Cultura Científica.

Dibujando grafos sobre la banda de Moebius

La banda de Moebius es un sorprendente objeto geométrico, y más concretamente topológico (véase la entrada La topología modifica la trayectoria de los peces), que ha cautivado a personas de dentro y fuera de las matemáticas. En el Cuaderno de Cultura Científica hemos hablado en varias ocasiones, tanto de sus sorprendentes propiedades matemáticas, como de su utilización en el arte (algunas interesantes entradas sobre la misma son: Poesía retorcida sobre banda de Möbius, De menú para hoy, dos novelas gráficas negras con salsa matemática, Arte Moebius (I), Arte Moebius (II), En busca de la banda de Moebius más corta posible).

Libertas quae sera tambem (2021), del artista brasileño Valin Branco. Triánngulo, curva de Moebius con corte central. Madera dura: Caoba. Dimensiones: 34cm x 30cm x 17cm. Imagen de la cuenta de instagram de Valin Branco

Libertas quae sera tambem (2021), del artista brasileño Valin Branco. Triánngulo, curva de Moebius con corte central. Madera dura: Caoba. Dimensiones: 34cm x 30cm x 17cm. Imagen de la cuenta de instagram de Valin BrancoPodéis leer más sobre la banda de Moebius y su utilización en el arte contemporáneo en el libro Las matemáticas como herramienta de creación artística (R. Ibáñez, colección Miradas matemáticas, Catarata, 2023), que estará en las librerías a finales del mes de marzo.

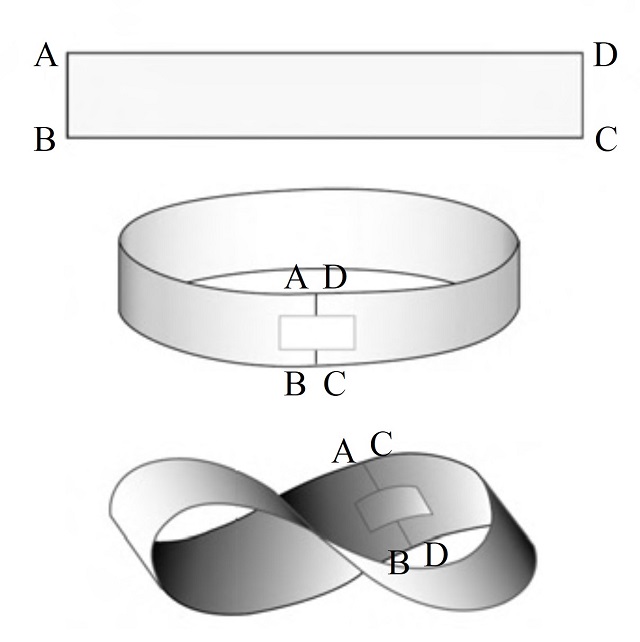

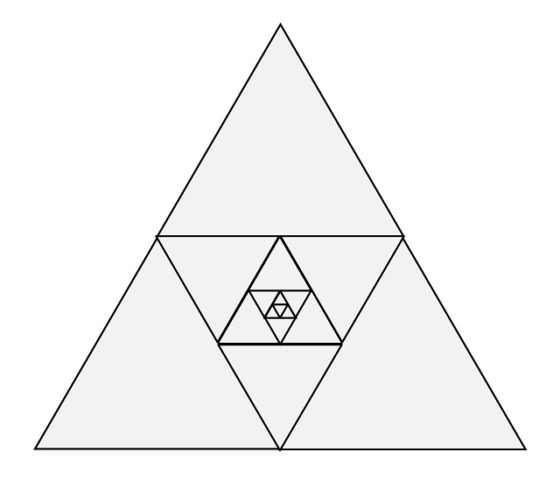

Pero en esta entrada del Cuaderno de Cultura Científica queremos hablar de una curiosa propiedad de la banda de Moebius, que tiene que ver con la teoría de grafos. Aunque esta superficie es un objeto matemático de sobra conocido, no está de más volver a recordar su construcción. Una banda de Moebius es una banda retorcida que podemos construir de forma sencilla de la siguiente forma. Si tomamos una tira de papel y pegamos los extremos se obtiene una banda normal con dos caras y dos bordes, pero si primero giramos uno de los extremos del papel media vuelta y después juntamos los extremos se obtiene la banda de Moebius, una superficie que solo tiene una cara y un solo borde (como se observa en la siguiente imagen).

Por otra parte, la teoría de grafos es la rama de las matemáticas que estudia los grafos, estructuras formadas por puntos –llamados vértices– y líneas uniendo pares de puntos –llamadas aristas–, que son estructuras matemáticas muy sencillas, pero a la vez muy versátiles, con muchas aplicaciones en ciencia y tecnología (véase, por ejemplo, El problema de los tres caballeros y los tres criados, El grafo de Marion (Gray) o El juego de Sim, entre otros).

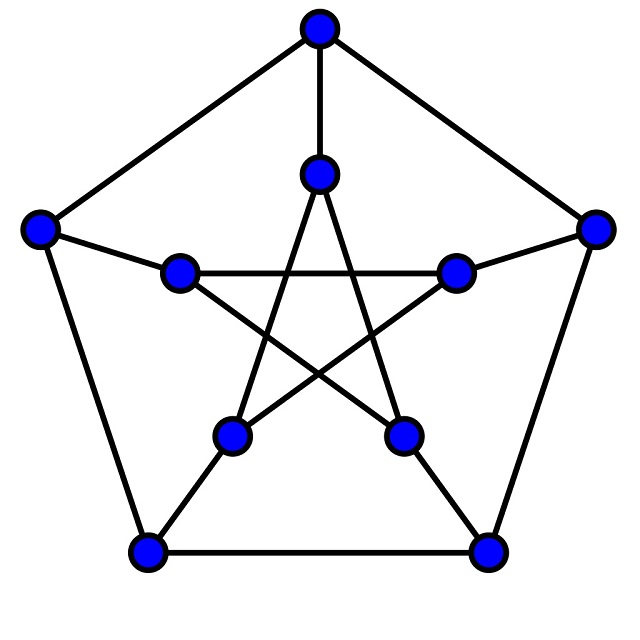

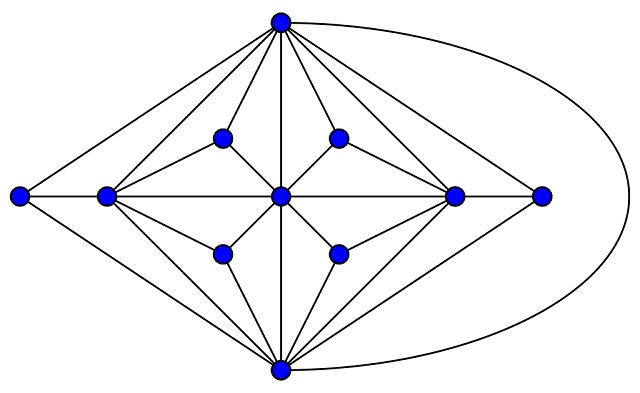

El conocido grafo de Petersen, con 10 vértices y 15 aristas. Imagen: Leshabirukov / Wikimedia Commons

El conocido grafo de Petersen, con 10 vértices y 15 aristas. Imagen: Leshabirukov / Wikimedia CommonsAntes de adentrarnos en la mencionada propiedad de los grafos sobre la banda de Moebius, primero vamos a plantear un sencillo problema sobre grafos en el plano.

Problema: ¿Cual es el mayor número de puntos (vértices) que puede unirse mediante líneas (aristas), sin que estas se crucen unas con otras y de manera que todos los pares de puntos queden unidos por líneas?

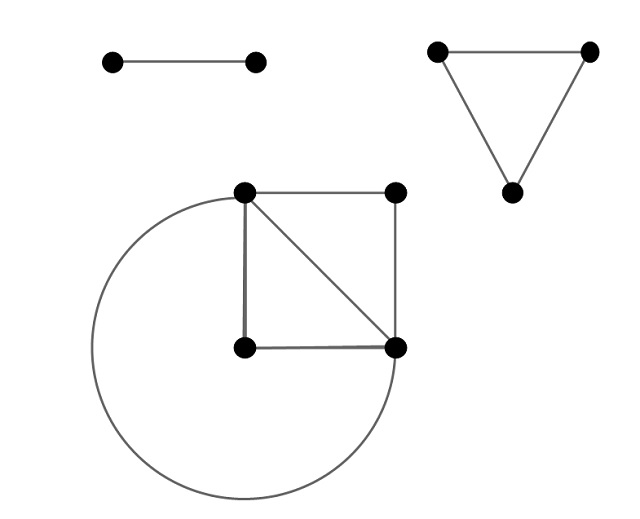

Si tomamos un trozo de papel y empezamos a pintar puntos y líneas uniendo esos puntos, es fácil ver que el problema es trivial para 2, 3 y 4 puntos del plano, como se muestra en la siguiente imagen.

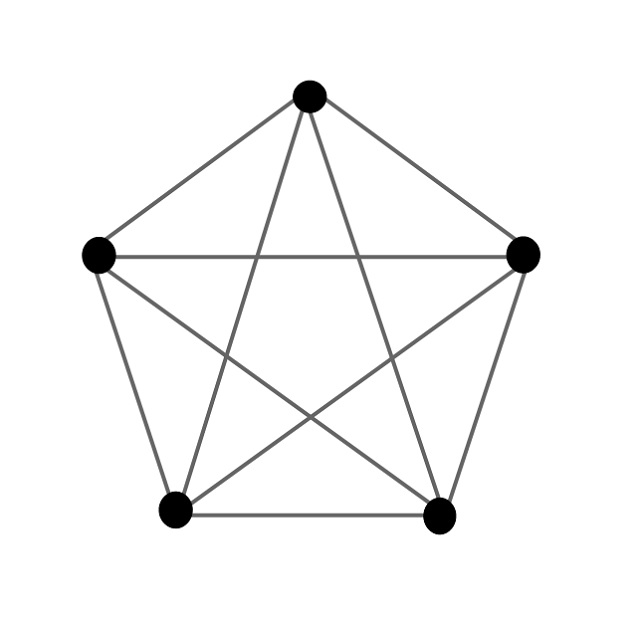

Pero parémonos a pensar un momento qué ocurre para 5 puntos. Empecemos dibujando el grafo de 5 puntos con todas las aristas posibles que unen dos de esos puntos, es lo que en matemáticas, en concreto, en teoría de grafos, se denomina el “grafo completo” de 5 vértices (y se denota como K5).

En el dibujo que hemos realizado del grafo completo de 5 vértices. Observamos que las aristas se cruzan entre ellas y nos planteamos si será posible redibujar las aristas de tal manera que estas no se crucen, como hemos visto que sí es posible para el grafo completo de 4 vértices, K4. Por cierto, esto es lo que en teoría de grafos se dice que es un “grafo plano”, un grafo que podemos dibujar en el plano sin que las aristas se crucen. Luego nuestro problema consiste en averiguar si el grafo completo de 5 vértices es plano, o no. La respuesta es negativa. Veamos una idea de cómo demostrarlo.

Para probar que el grafo completo de 5 vértices no es plano se hace uso de la fórmula de Euler. Esta establece que para los grafos planos “conexos” (esto quiere decir que cada par de vértices está conectado por un camino de aristas que empieza y termina en esos dos vértices) con v vértices, a aristas y c caras (se incluye también como cara la zona exterior no acotada) se verifica la fórmula:

![]()

Por ejemplo, el grafo de Goldner-Harary, que vemos en la siguiente imagen, es un grafo plano y se verifica la fórmula de Euler (v = 11, a = 27 y c = 17).

Grafo de Goldner-Harary. Imagen: David Eppstein / Wikimedia Commons

Grafo de Goldner-Harary. Imagen: David Eppstein / Wikimedia Commons

Ahora, si tenemos un grafo plano y simple (esto quiere decir que en ese grafo no hay bucles, es decir, aristas que unan un vértice consigo mismo, ni tampoco hay aristas múltiples, esto es, que no hay dos aristas distintas que unan los mismos dos vértices) con más de dos vértices, la fórmula de Euler permite afirmar (la prueba es simple) que

![]()

A partir de esta fórmula se demuestra que el grafo completo de 5 vértices no es plano, ya que v = 5, pero el número de aristas, al ser completo, es a = 10, y no se verifica la anterior desigualdad. Por lo tanto, queda demostrado que el grafo completo de 5 vértices K5 no es plano.

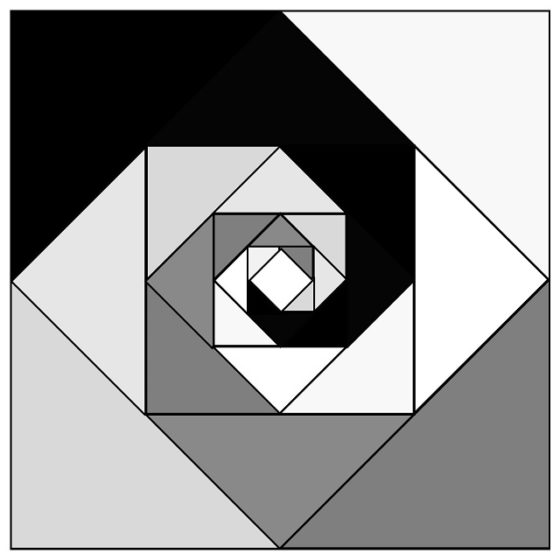

¿Pero qué ocurre si consideramos el problema sobre la banda de Moebius?

Problema: Dados 5 puntos en la banda de Moebius, ¿pueden unirse mediante líneas, sin que estas se crucen unas con otras y de manera que todos los pares de puntos queden unidos por líneas? ¿Es el grafo completo de 5 vértices sobre la banda de Moebius un “grafo plano”, es decir, cuyas aristas pueden trazarse de forma que no se crucen?

Antes de abordar esta cuestión, una pequeña reflexión sobre el concepto de superficie, ya que la banda de Moebius es una superficie (matemáticamente hablando). Esto es algo trivial, a priori, pero para entender bien este concepto, lo primero que hay que comprender es que una superficie matemática “ideal” no tiene grosor, luego sus puntos están “dentro” de la misma, no “sobre” ella. Para visualizar esto pensemos en una superficie transparente (por ejemplo, acetato) sobre la que se pinta un punto, este podrá verse “desde los dos lados”, lo cual nos permite entender qué significa que el punto está en la superficie, pero no sobre uno de sus lados. De hecho, podríamos decir que la superficie matemática no tiene “lados” en sí misma, sino que estos son una manifestación de la relación de la superficie con el espacio tridimensional que la contiene. En conclusión, a la hora de resolver el problema anterior sobre la banda de Moebius, es conveniente que pensemos en la banda de Moebius como si fuese una superficie transparente sobre la que pintamos las aristas.

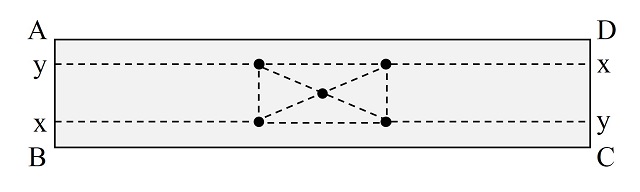

Ahora, contrariamente a lo que ocurría para el plano, dados 5 puntos en la banda de Moebius sí se pueden trazar líneas que unan todas las parejas de puntos sin que se crucen entre ellas, como se muestra en la siguiente imagen (se realiza el dibujo sobre la tira de papel estirada, teniendo en cuenta que luego los extremos se unen después de medio giro, por eso la línea que pasa por y en el lado AB, arriba a la izquierda, continua por abajo a la derecha en el lado CD).

El grafo completo K5 de 5 puntos es un grafo “plano” en la banda de Moebius

El grafo completo K5 de 5 puntos es un grafo “plano” en la banda de MoebiusEl siguiente paso sería ver si es posible lo mismo para 6 puntos, es decir, si el grafo completo de 6 vértices es un grafo “plano” en la banda de Moebius.

Problema: Dados 6 puntos en la banda de Moebius, ¿pueden unirse mediante líneas, sin que estas se crucen unas con otras y de manera que todos los pares de puntos queden unidos por líneas?

Este problema queda para quienes queráis divertiros intentando resolverlo. No olvidéis que estáis sobre una banda de Moebius, es decir, una tira de papel cuyos extremos se unen después de dar media vuelta a la misma. ¡Que os divirtáis!

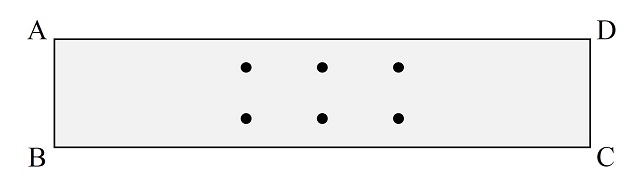

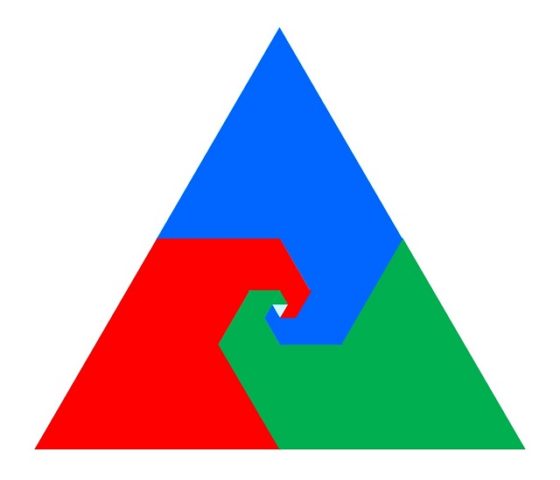

El problema anterior está relacionado con un pasatiempo matemático clásico, el problema del agua, el gas y la electricidad, también conocido como problema de los tres servicios. Este problema aparece recogido en el libro Amusements in mathematics (1917), que fue publicado en castellano en tres partes, con el nombre conjunto de Diversiones Matemáticas (El acertijo del mandarín, Los gatos del hechicero y El misterio del muelle), del experto inglés en matemática recreativa Henry E. Dudeney (1857-1930). Aunque ya lo había publicado con anterioridad, en 1913, en la revista The Strand Magazine. Dudeney dice que es un pasatiempo matemático muy antiguo, que él ha bautizado como el problema del agua, el gas y la electricidad, aunque es más antiguo que la utilización de la electricidad para iluminar las casas. El problema, traducido del original de Dudeney, dice así.

El problema del agua, el gas y la electricidad: El rompecabezas consiste en tender agua, gas y electricidad, desde W, G y E, a cada una de las tres casas, A, B y C, sin que ninguna tubería se cruce con otra. Coge tu lápiz y dibuja líneas que muestren cómo hacerlo. Pronto te encontrarás con dificultades.

Según vayáis intentando resolver este problema clásico os daréis cuenta de que nos encontramos ante una cuestión similar a la anterior, que era intentar dibujar el grafo completo K5 de 5 vértices sin que se crucen las líneas. Sin embargo, ahora el grafo asociado al problema del agua, el gas y la electricidad, que es el grafo bipartito completo K3,3 (que aparece en la siguiente imagen), es decir, está formado por dos conjuntos de vértices, en este caso, de 3 vértices cada uno, y están todas las aristas que unen los vértices de un conjunto con los del otro.

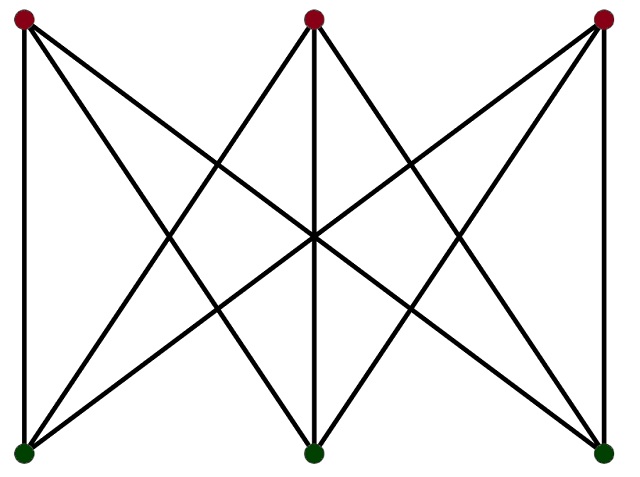

El grafo bipartito completo K3,3, que es el grafo asociado al pasatiempo del agua, la electricidad y el gas

El grafo bipartito completo K3,3, que es el grafo asociado al pasatiempo del agua, la electricidad y el gasUtilizando de nuevo la fórmula que es consecuencia de la fórmula de Euler puede demostrarse que el grafo bipartito completo K3,3 no es plano y el problema del agua, el gas y la electricidad no tiene solución.

Para terminar…

Problema: ¿es posible resolver el problema del agua, el gas y la electricidad para la banda de Moebius?

Curva clásica de Moebius (2021), del artista brasileño Valin Branco. Madera dura: Cedro. Dimensiones: 21cm x 20cm x 13cm. Imagen: Instagram de Valin Branco

Curva clásica de Moebius (2021), del artista brasileño Valin Branco. Madera dura: Cedro. Dimensiones: 21cm x 20cm x 13cm. Imagen: Instagram de Valin BrancoBibliografía

1.- Raúl Ibáñez, Las matemáticas como herramienta de creación artística , colección Miradas matemáticas, Catarata, 2023.

2.- Clifford A. Pickover, La banda de Möbius, Almuzara, 2009.

3.- Martin Gardner, Festival mágico-matemático, Alianza editorial, 1984.

4.- Raúl Ibáñez, Del ajedrez a los grafos, la seriedad matemática de los juegos, El mundo es matemático, RBA, 2015.

5.- David E. Kullman, The utilities problem, Mathematics Magazine, 52 (5), pp. 299–302, 1979.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Dibujando grafos sobre la banda de Moebius se ha escrito en Cuaderno de Cultura Científica.

Un bombeo intermitente ahorra energía

El bombeo intermitente de un fluido por una tubería reduce significativamente el coste de transporte.

Foto: Pedro Netto / Unsplash

Foto: Pedro Netto / UnsplashEn un estudio de prueba de concepto, los investigadores utilizaron simulaciones numéricas para demostrar que, cuando se conecta y se apaga periódicamente una bomba, el flujo sigue cambiando entre un estado turbulento y otro laminar. Esto redujo los costes de energía hasta en un 22%, una cifra que, según los investigadores, puede optimizarse aún más.

Los flujos laminares, como el que se ve cuando se abre lentamente un grifo, son regulares, ocupan el menor espacio posible y son energéticamente eficientes. Los flujos turbulentos, por otro lado, como cuando un grifo abre a tope, son caóticos y desperdician energía.

Si inyectamos tinta en un flujo laminar en una tubería transparente, veremos una línea bien definida de tinta moviéndose por la tubería. Con un flujo turbulento, sin embargo, veremos a la tinta dispersarse a medida que cada partícula de fluido toma un camino impredecible. Este movimiento caótico a pequeña escala da como resultado que se pierda mucha energía. Los flujos laminares son ideales para el transporte de fluidos, pero cuando los fluidos viscosos se mueven rápido y a gran escala, el sistema evoluciona naturalmente hacia un estado turbulento.

En el estudio, los investigadores codificaron un modelo que, usando un superordenador, pudo simular un flujo turbulento estandarizado. Los científicos ejecutaron diferentes escenarios, cambiando la duración del tiempo en que la bomba estaba encendida, su intensidad (la velocidad a la que acelera el fluido) y la duración total de cada ciclo de encendido y apagado de la bomba.

Descubrieron que los ciclos caracterizados por un bombeo breve e intenso que aceleraba rápidamente el fluido seguido de una fase larga en la que se apagaba la bomba y el fluido se ralentizaba funcionaban mejor para mantener el fluido en un estado laminar durante la mayor cantidad de tiempo.

Reducir la turbulencia y, por lo tanto, los costes de mover fluidos a través de tuberías podría generar numerosos beneficios económicos y ambientales. El transporte de fluidos constituye una parte importante del costo final del combustible, por lo que el hidrógeno líquido podría volverse más barato para los países desarrollados. Para los países en desarrollo que aún no pueden hacer el cambio a la energía verde, el petróleo y el gas natural podrían convertirse en una alternativa energética más asequible a la leña, cuyo uso contribuye a la deforestación y produce más contaminantes nocivos que los combustibles fósiles.

Referencia:

Foggi Rota, G., Monti, A., Rosti, M.E. et al. (2023) Saving energy in turbulent flows with unsteady pumping. Sci Rep 13, 1299. doi: 10.1038/s41598-023-28519-x

Para saber más:

Un modelo para la máquina de coser fluidodinámica, o como untar miel con conocimiento

¿Por qué moja el agua? La física de fluidos inunda nuestras vidas

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Un bombeo intermitente ahorra energía se ha escrito en Cuaderno de Cultura Científica.

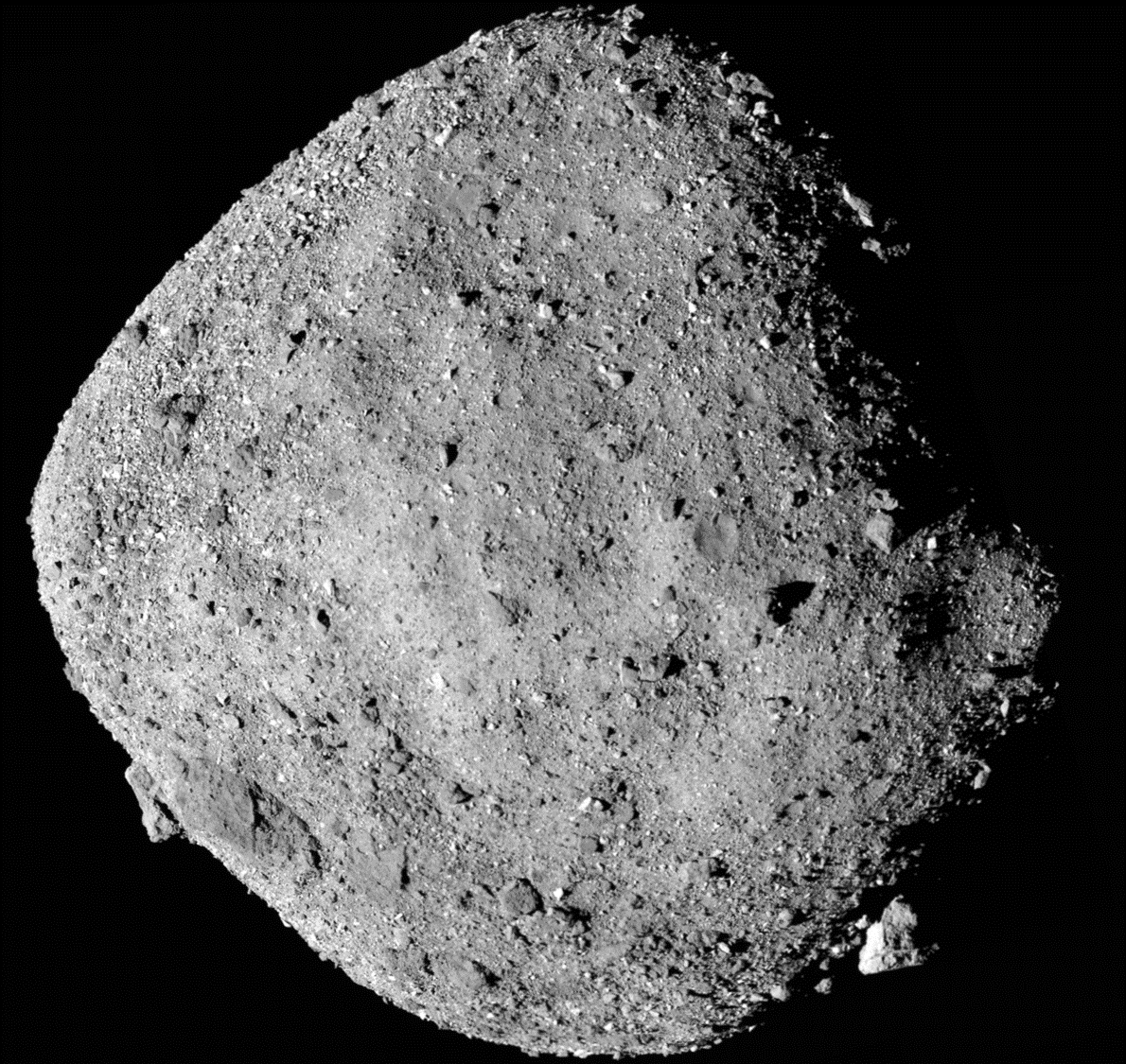

Meteoritos con una pizca de sal

Los meteoritos son una de las fuentes fundamentales en nuestro conocimiento sobre el Sistema Solar, que nos permiten reconstruir distintos aspectos de la historia de nuestro sistema planetario, desde los más dinámicos hasta los geoquímicos, pasando incluso por los ambientales en algunos casos, ya que nos traen muestras de otros cuerpos sin necesidad de ir a recogerlos con una compleja misión de retorno de muestras.

Obviamente esto tiene su parte negativa, porque nosotros no escogemos en ningún caso lo que queremos muestrear. Además, quien sabe si en estos meteoritos que recogemos de la superficie de nuestro planeta podrían existir algunos sesgos de preservación o incluso temporales, habiendo familias composicionales que ya serían difíciles de encontrar porque hace mucho que cayeron y desaparecieron de nuestro entorno cercano. Y es que cuanto más tiempo pasa un meteorito en la superficie de nuestro planeta, más sufre de procesos de alteración que pueden cambiar su composición y provocar la aparición de nuevos minerales. Incluso puede experimentar una fragmentación que acelere estos procesos de alteración.

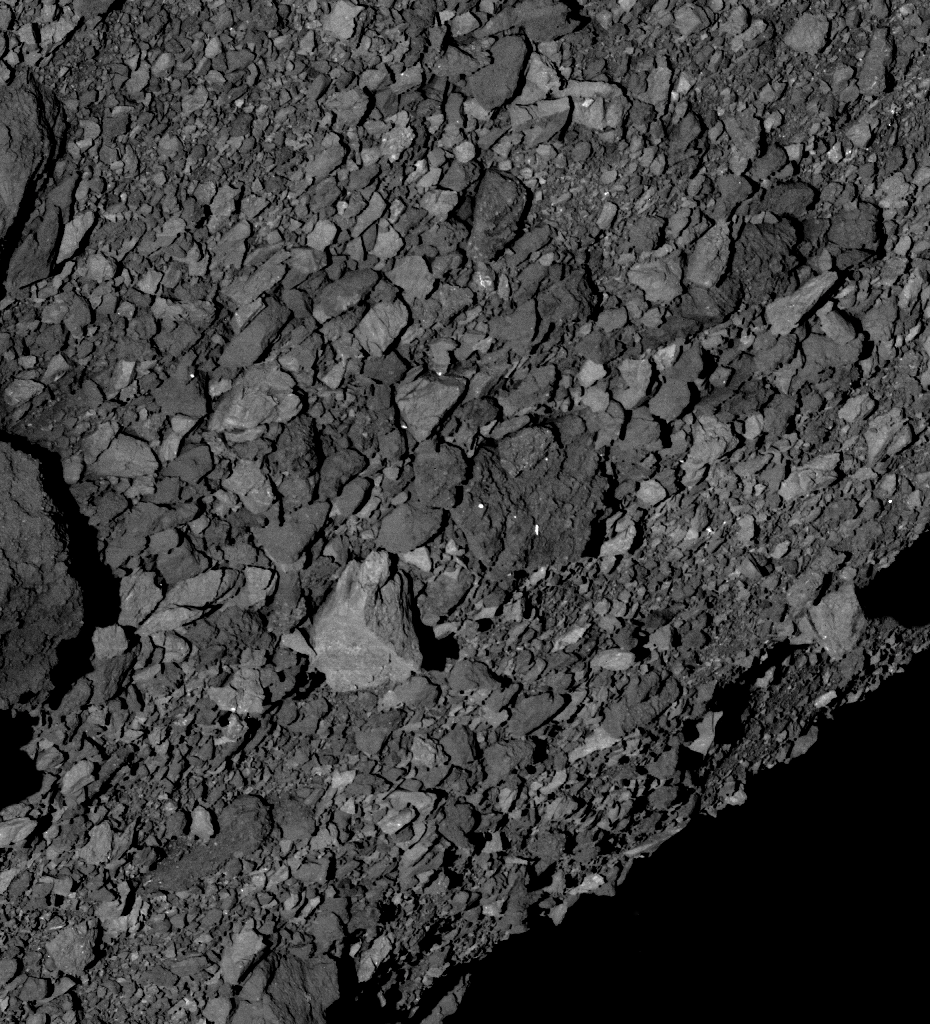

Imagen de un meteorito metálico en la superficie de Marte. Estos meteoritos son muy fáciles de observar en su superficie por el fuerte contraste con las rocas autóctonas. Cortesía de NASA/JPL-Caltech/LANL/CNES/IRAP/LPGNantes/CNRS/IAS/MSSS.

Imagen de un meteorito metálico en la superficie de Marte. Estos meteoritos son muy fáciles de observar en su superficie por el fuerte contraste con las rocas autóctonas. Cortesía de NASA/JPL-Caltech/LANL/CNES/IRAP/LPGNantes/CNRS/IAS/MSSS.Recientemente se ha estimado que sobre la superficie de la Tierra caen unos 6000 meteoritos al año, de los cuales en torno a unos 2000 caerían sobre tierra firme, sin embargo, un número muy pequeño de estos es recuperado para su estudio y en ocasiones pasa mucho tiempo entre la caída y el descubrimiento, especialmente en el caso de fragmentos muy pequeños. Cada instante que pasa en la superficie sin proteger, la alteración avanza.

Y es que un análisis recién publicado sobre el meteorito de Winchcombe, que cayó en febrero de 2021 en el Reino Unido y el primero en ser recuperado en este país en casi 30 años, ha puesto de manifiesto la gran velocidad a la que los procesos de alteración tienen lugar, independientemente de lo rápido que se recuperen los fragmentos.

De hecho, los primeros fragmentos fueron recuperados tan solo unas horas después de la caída gracias a que lo hicieron sobre una carretera, y otra gran parte de estos en los primeros seis días después sobre un pasto de ovejas. Hasta al menos septiembre de 2021 se estuvieron encontrando fragmentos de este meteorito en distintos lugares.

Un nuevo estudio pone de manifiesto que, a pesar de la rápida recuperación de los meteoritos, sobre estos habían aparecido ya minerales fruto de la interacción entre el meteorito y la humedad del ambiente. Gracias al uso de técnicas como la microscopía electrónica y la espectroscopía de tipo Raman, los investigadores han podido estudiar con un gran nivel de detalle la superficie de algunos de los meteoritos y caracterizar su mineralogía. Concretamente estudiaron dos fragmentos: uno recogido de la carretera y otro del pasto de ovejas.

Durante la reentrada, los meteoritos suelen desarrollar lo que denominamos costra de fusión: debido a las altas temperaturas que sufre el meteorito en su contacto con la atmósfera debido a la gran velocidad que lleva con respecto a nuestro planeta, su superficie empieza a fundirse. Cuando el meteorito ha frenado, empieza a enfriarse y este fundido que queda se transforma en una capa vitrificada y que muchas veces ayuda a los científicos a distinguir en el campo lo que es un meteorito de lo que no.

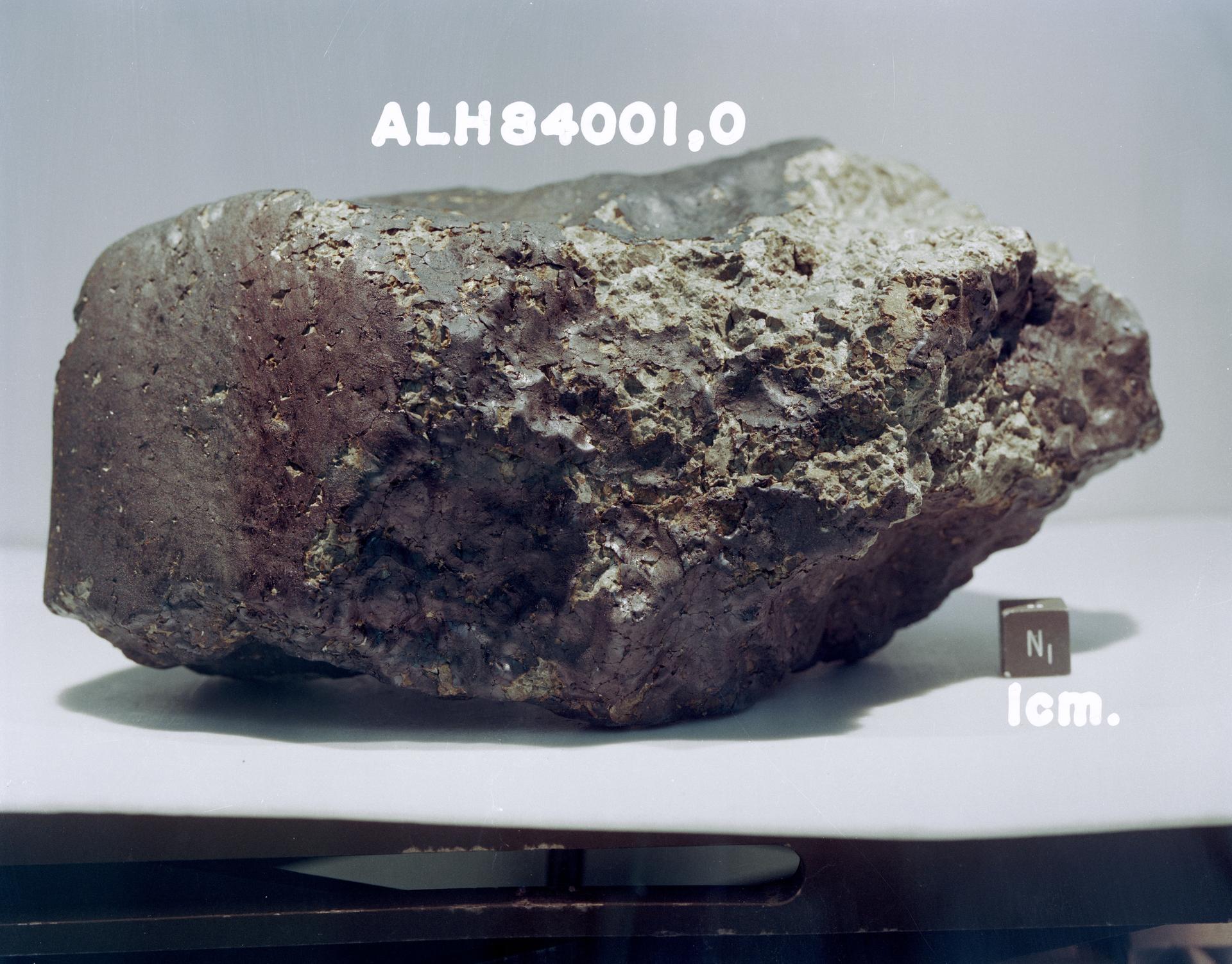

El famoso meteorito ALH84001, conocido por la posibilidad de haber preservado formas de vida microscópicas -y muy discutidas-, deja entrever parte de su costra de fusión, como una fina capa negra de un color y textura distinta al meteorito original que cubre parte de este. Imagen cortesía del JSC.

El famoso meteorito ALH84001, conocido por la posibilidad de haber preservado formas de vida microscópicas -y muy discutidas-, deja entrever parte de su costra de fusión, como una fina capa negra de un color y textura distinta al meteorito original que cubre parte de este. Imagen cortesía del JSC.En el meteorito recogido del pasto de las ovejas, los análisis descubrieron minerales como el sulfato de calcio y calcita, pero estos aparecían fuera de la costra de fusión, por lo que lo más posible es que se formaran después de su caída por la exposición a las condiciones de humedad del pasto.

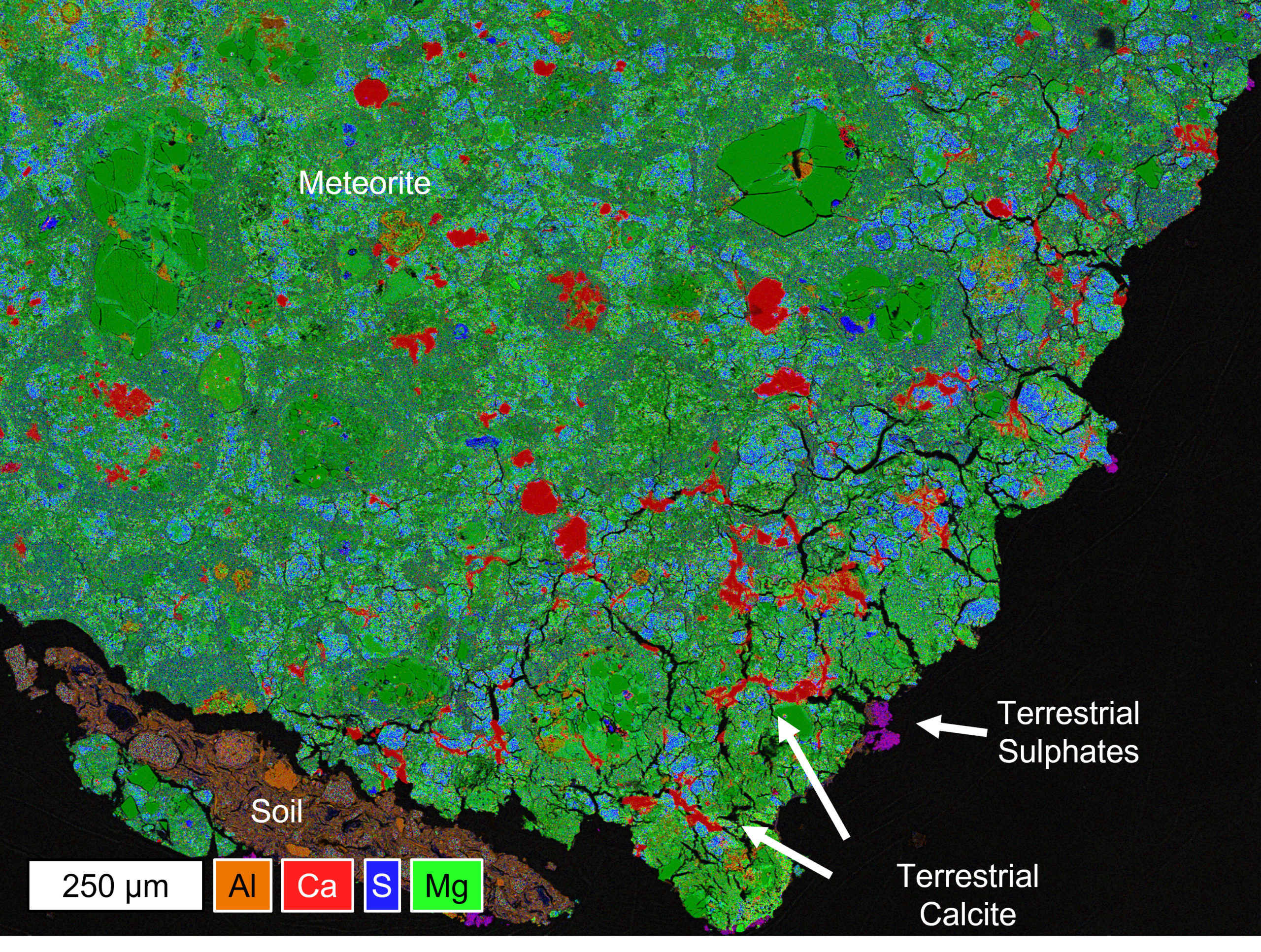

Una de las secciones del meteorito de Winchcombe analizadas. Señalados por flechas podemos ver las apariciones de sulfatos y de calcita de origen terrestre. Imagen cortesía de la Universidad de Manchester.

Una de las secciones del meteorito de Winchcombe analizadas. Señalados por flechas podemos ver las apariciones de sulfatos y de calcita de origen terrestre. Imagen cortesía de la Universidad de Manchester.Sin embargo, el fragmento recuperado de la carretera se cortó en secciones que se pulieron en el laboratorio, y en estas secciones se dieron cuenta de que aparecía halita -el mineral que forma la sal común- de tal manera que este mineral tendría que haber aparecido después del corte y el pulido por la interacción con el propio aire del laboratorio.

¿Qué nos quiere decir este estudio? Pues hay varias cosas a tener en cuenta: Lo primero es que por muy rápido que recuperemos el meteorito, lo normal es esperar que haya algo de alteración, incluso si solo han pasado unas horas.

Lo segundo, pone de manifiesto que es importante que preservemos los meteoritos en unas condiciones lo más inertes posibles, es decir, con la mejor presencia posible de gases como el oxígeno o el dióxido de carbono, que pueden reaccionar muy rápidamente con los meteoritos, así como las muestras que traigamos de asteroides, satélites y planetas.

Y por último, la importancia de discriminar en los meteoritos cuáles de los minerales son de origen terrestre y cuáles originales del propio meteorito, especialmente en aquellos que hayan pasado prolongados tiempos expuestos a las condiciones ambientales de nuestro planeta, porque no podemos olvidar que los meteoritos pueden también haber sufrido previamente procesos de alteración por colisiones o por su historia en el cuerpo progenitor.

Este estudio podría sentar las bases para nuevas directrices que nos permiten preservar mejor las colecciones de meteoritos y muestras de otros cuerpos de cara al futuro, para que las siguientes generaciones de científicas puedan estudiarlos tal y como si estuviesen recién caídos.

Bibliografía:

Jenkins, L. E., Lee, M. R., Daly, L., King, A. J., Floyd, C. J., Martin, P. E., Almeida, N. V., & Genge, M. J. (2023). Winchcombe: An example of rapid terrestrial alteration of a chondrite. Meteoritics & Planetary Science. doi: 10.1111/maps.13949

Sobre el autor: Nahúm Méndez Chazarra es geólogo planetario y divulgador científico.

El artículo Meteoritos con una pizca de sal se ha escrito en Cuaderno de Cultura Científica.

¿Cómo se mide un sentimiento?

Foto: Stephen Dawson / Unsplash

Foto: Stephen Dawson / Unsplash¿Se puede medir un sentimiento? Me refiero a su intensidad. ¿Qué tal está usted? ¿Cuán satisfecho está con la vida? ¿Cómo es la relación con su pareja? ¿Cuánto le satisface vivir donde vive? Estas son preguntas a las que, en ocasiones, se nos pide que respondamos con un número. Cuando se encuesta a la gente para conocer su nivel de satisfacción con diferentes aspectos de la vida, normalmente en el marco de una investigación científica o un estudio sociológico, se le suele pedir que lo cuantifiquen. Ocurre lo mismo cuando se nos pide que valoremos de 1 a 5 (por ejemplo) el grado de satisfacción con el servicio prestado por los empleados de una empresa. Lo normal es que lo hagamos, aunque en este caso el valor otorgado suele ser –por razones que no hace falta explicitar– muy alto o máximo.

Pues bien, cuando estas encuestas se hacen en el contexto de una investigación, es normal que surjan dudas acerca de la fiabilidad de la calificación numérica otorgada. Sospecho que a la mayoría nos parece que la intensidad de un sentimiento es algo demasiado subjetivo como para que se le pueda asignar un valor numérico fiable. Por esa razón, dos miembros del Centro de Investigación en Bienestar (Universidad de Oxford, Reino Unido) han hecho un estudio para valorar hasta qué punto hay una correspondencia entre el número (entero, sin decimales) con el que las personas encuestadas valoran ciertos sentimientos, y la probabilidad de que esas mismas personas actúen más adelante en consonancia con la valoración otorgada. La probabilidad de que actúen se refiere a si toman, o no, decisiones del tipo “get-out-of-here” (sácame de aquí).

En economía del trabajo ya habían comprobado, por ejemplo, que un bajo nivel de satisfacción con el trabajo es un predictor muy bueno de la decisión de abandonarlo y buscar otro. Ese es un buen ejemplo de una decisión “sácame de aquí”. En la investigación que nos ocupa han estudiado la vinculación entre el sentimiento de satisfacción (o insatisfacción) y las decisiones posteriores (hasta un año después) relativas a asuntos correspondientes a cuatro dominios de la experiencia humana: vivienda, pareja, trabajo, y salud. En el estudio han recurrido a bases de datos –recogidos durante años en tres países (Reino Unido, Alemania y Australia) por administraciones públicas y organismos internacionales– sobre los sentimientos y decisiones de decenas de miles de personas a las que se ha encuestado con diferentes motivos a lo largo de cuatro décadas. Han utilizado del orden de setecientos mil datos, aproximadamente.

Los resultados del estudio fueron muy claros. En los cuatro dominios examinados, el número entero con el que las personas cuantifican un sentimiento tiene un mayor poder predictivo que un conjunto de variables económicas y sociales objetivas. Además, hay una relación inversa entre las acciones “sácame-de-aquí” y los valores asignados a los correspondientes sentimientos. Así, la probabilidad de cambiar de vivienda es mayor cuanto menor es la satisfacción con aquella en que se vive; la de romper una relación disminuye con el grado de satisfacción con la pareja; la de cambiar de trabajo se reduce con la satisfacción con el que se tiene; y la de acudir a hospitales cae con la satisfacción con el estado de salud. La relación entre los sentimientos y la probabilidad de actuar para cambiar las cosas es prácticamente linear (y negativa).

En resumidas cuentas, los seres humanos podemos usar una escala numérica fiable para asignar un valor a sentimientos que, en principio, son inmensurables. No sabemos cómo, pero lo hacemos. O, dicho de forma más castiza, “sabemos lo que queremos”.

Fuente: C. Kaiser, A. J. Oswald, The scientific value of numerical measures of human feelings. Proc. Natl. Acad. Sci. U.S.A. 119, e2210412119 (2022). doi: 10.1073/pnas.2210412119

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo ¿Cómo se mide un sentimiento? se ha escrito en Cuaderno de Cultura Científica.

Naukas Bilbao 2022: La fina línea

Es posible que, en alguna ocasión, un sentimiento homicida te haya invadido ante según qué plantemientos de tu profesor de matemáticas. Sentimiento este que podría verse correspondido desde el momento en que para algún matemático el asesinato es la única salida lógica a determinadas cuestiones. Este matemático ingresó en un manicomio, pero su fama empezó ahí, precisamente. Juan Antonio Prado nos cuenta su historia.

Juan Antonio Prado Bassas es profesor titular del departamento de Análisis Matemático y vicedecano de Innovación Docente y Divulgación Científica de la Facultad de Matemáticas de la Universidad de Sevilla.

Si no ve correctamente el vídeo, use este enlace.

Más sobre el tema:

André Bloch: el asesinato como una cuestión de lógica matemática

Matemáticos y sin embargo criminales

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Bilbao 2022: La fina línea se ha escrito en Cuaderno de Cultura Científica.

El impacto de la violencia en la incertidumbre de vida

La duración de la vida en países con altas tasas de violencia es menos predecible y la esperanza de vida de los jóvenes puede ser hasta 14 años más corta en comparación con los países pacíficos, según un nuevo estudio realizado por un equipo internacional, liderado por la Universidad de Oxford y en el que ha participado el investigador Ikerbasque en la UPV/EHU, Tim Riffe.

Foto: Tengyart / Unsplash

Foto: Tengyart / UnsplashSegún la investigación, las muertes violentas son responsables en una alta proporción del diferente nivel de incertidumbre de vida entre los países violentos y los pacíficos. La incertidumbre de vida hace referencia a la dispersión en las edades de mortalidad; cuanto mayor es la dispersión, mayor incertidumbre. El impacto de la violencia en la mortalidad va más allá de acortar vidas, ya que cuando, debido a la violencia se pierden vidas de forma continuada, las personas supervivientes tienen mayor incertidumbre sobre quién será la siguiente víctima. En palabras de los autores de la investigación lo más sorprendente de este estudio ha sido constatar que la incertidumbre sobre la vida tiene una mayor asociación con la violencia que la esperanza de vida, de ahí su importancia para analizar los cambios en los patrones de mortalidad

Utilizando los datos de mortalidad de 162 países y el Índice de Paz Interna entre 2008 y 2017, el estudio muestra que los países más violentos también son aquellos con mayor incertidumbre de vida. En el caso de Oriente Medio son las muertes relacionadas con el conflicto a edades tempranas las que más contribuyen a la percepción de incertidumbre elevada. Asimismo, en América Latina se observa un patrón similar resultado de los homicidios y de la violencia interpersonal. En el otro extremo nos encontramos que la incertidumbre de vida fue «notablemente baja» entre 2008 y 2017, en la mayoría de los países del norte y sur de Europa.

En los países de ingresos altos la reducción de la mortalidad temprana por cáncer ha influido en reducir la incertidumbre de vida. Sin embargo, en las sociedades más violentas, la incertidumbre de vida es incluso experimentada por aquellos que no están directamente involucrados en la violencia. El informe recoge que “Los ciclos de pobreza, inseguridad y violencia magnifican los patrones estructurales preexistentes de desventaja para las mujeres. En algunos países de América Latina, los asesinatos a mujeres han aumentado en las últimas décadas y la exposición a entornos violentos tiene consecuencias sociales y de salud, en particular para niños y mujeres”. Según los autores del estudio «Si bien los hombres son las principales víctimas directas de la violencia, las mujeres tienen más probabilidades de experimentar sus consecuencias en contextos violentos»

Según el informe la esperanza de vida más baja suele estar asociada con una mayor incertidumbre de vida. Además, vivir en una sociedad violenta crea vulnerabilidad e incertidumbre y eso, a su vez, puede conducir a un comportamiento más violento. Los países con altos niveles de violencia tienen una esperanza de vida más baja que los más pacíficos. Se estima una brecha de alrededor de 14 años en la esperanza de vida entre los países menos y más violentos. Así, en países como El Salvador, Honduras, Guatemala o Colombia la brecha en la esperanza de vida con los países de altos ingresos se explica principalmente por el alto nivel de mortalidad debido a los homicidios.

Según el investigador Ikerbasque de la UPV/EHU, Tim Riffe, autor del estudio, es importante mostrar en un sentido amplio los efectos que la violencia tiene para la salud de la población, de modo que pueda considerarse un problema de salud pública y, por lo tanto, pueda ser susceptible de programas de prevención. La violencia como causa de muerte resulta, en principio, más fácil de prevenir que otras grandes causas, como puede ser el cáncer, y los beneficios de hacerlo son tanto inmediatos como duraderos. De hecho, existen muchos ejemplos de sociedades que transitaron de una situación de elevada violencia a otra de paz prolongada.

El estudio está basado en el uso masivo de datos y se fundamenta, en parte, en estimaciones de mortalidad modeladas por el proyecto Global Burden of Disease. Muchas de las poblaciones incluidas no tienen información demográfica directa sobre la mortalidad, debido a que, en gran parte del mundo, los sistemas de registro vital, que permiten desarrollar una investigación como esta de forma directa, están aún por desarrollar o requieren de mejoras significativas.

Referencia:

José Manuel Aburto, Vanessa di Lego, Tim Riffe, Ridhi Kashyap, Alyson van Raalte, and Orsola Torrisi (2023) A global assessment of the impact of violence on lifetime uncertainty Science Advances doi: 10.1126/sciadv.add9038

Para saber más:

Serie Preparados para matar

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo El impacto de la violencia en la incertidumbre de vida se ha escrito en Cuaderno de Cultura Científica.

Geóloga, ¿una especie en peligro de extinción?

Geóloga

El sábado once de febrero se celebró el Día Internacional de la Mujer y la Niña en la ciencia. Este evento pretende visibilizar el papel femenino en las disciplinas científicas y técnicas, buscando crear referentes entre las más jóvenes, de tal manera que puedan plantearse su futuro como profesionales en este ámbito, incluidas las Ciencias de la Tierra.

De manera general, la Geología siempre se ha considerado como una ciencia muy masculinizada. En la sociedad, tanto en el pasado como en la actualidad, nunca se ha visto como “muy femenino” una profesión que implica ir al campo a llenarse de barro, dar martillazos a rocas y cargar en la espalda con una mochila llena de muestras durante largos paseos en mitad del monte. Como mucho, se normalizaba más la presencia de mujeres en el laboratorio, procesando esas muestras de roca, apretando botoncitos en máquinas y dejándose la vista ante un microscopio contando minerales y fósiles microscópicos. De hecho, generalmente nuestro papel era el de “secretarias” que pasaban a limpio las sesudas divagaciones y complejos esquemas realizados por los compañeros varones. Pero sin darnos la opción de pensar en hipótesis demasiado complejas para nuestro limitado conocimiento científico. Y sin que se nos pasase por la cabeza la remota posibilidad de redactar, ni siquiera firmar, publicaciones científicas resultantes de esas investigaciones.

Pero esta imagen dista mucho de la realidad. Hace más de doscientos años que las mujeres han ido realizando importantísimos descubrimientos que han permitido avanzar en el conocimiento de la historia de nuestro planeta, sentando las bases de la Geología tal y como la conocemos en la actualidad, aunque su nombre se haya cubierto con el polvo del paso del tiempo. Por eso, uno de los deberes de aquellas que, muchas veces sin saberlo, seguimos sus pasos es coger nuestro martillo geológico y retirar esas capas de roca que cubren su legado hasta desvelar sus nombres y trabajos al mundo.

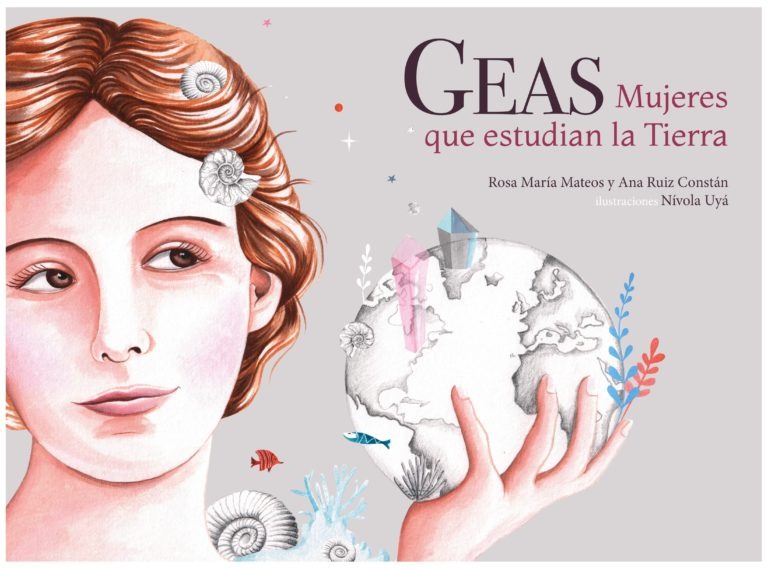

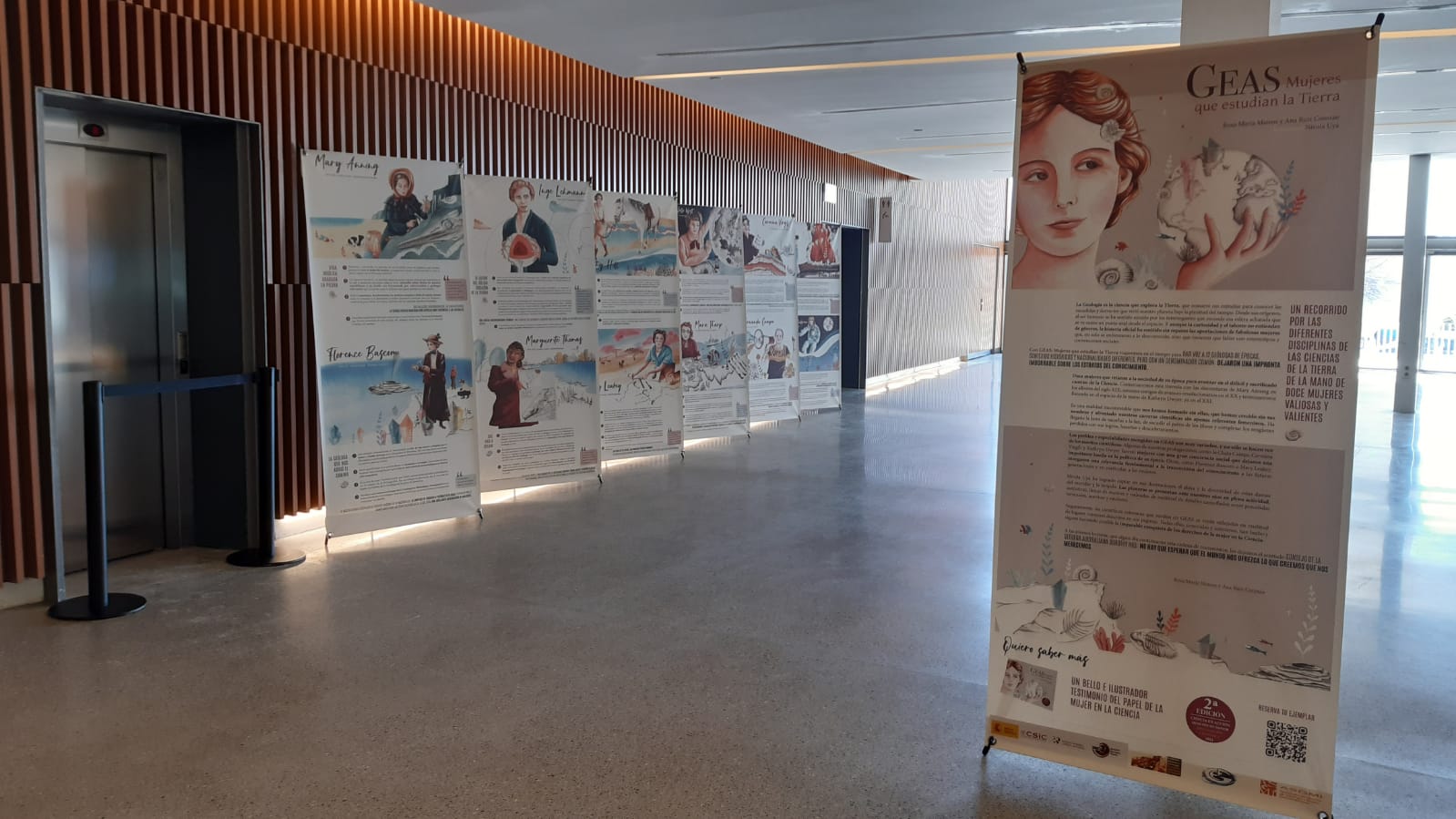

Portada del libro “GEAS, Mujeres que estudian la Tierra” en su versión en castellano.

Portada del libro “GEAS, Mujeres que estudian la Tierra” en su versión en castellano.Con este objetivo nació la Comisión Mujeres y Geología en el seno de la Sociedad Geológica de España. Y una de sus últimas actividades ha sido la colaboración en la publicación del libro “GEAS, Mujeres que estudian la Tierra”. Escrito por Rosa Mateos y Ana Ruiz Constán, geólogas del Instituto Geológico y Minero de España (IGME-CSIC) y bellamente ilustrado por Nívola Uyá, recoge las biografías de doce pioneras de las Ciencias de la Tierra que han cambiado el mundo de la Geología en los dos últimos siglos. Sin hacer muchos spoilers, descubriremos como antes de que Charles Lyell animase a otro Charles, Darwin, a lanzar su teoría de la evolución, una joven medio analfabeta inglesa había descubierto cómo cambiaban las especies fósiles con el tiempo, dándole a Lyell las pruebas que necesitaba para sustentar sus hipótesis. O cómo una geofísica danesa descubrió que el núcleo interno es sólido mientras que el núcleo externo es líquido, algo básico para que se forme el campo magnético terrestre y se sustente la vida en nuestro planeta. Incluso, conoceremos a la geóloga marina que, dibujando los mapas de los fondos marinos, dio con la clave de la tectónica de placas, a pesar de que se burlasen de sus descubrimientos sus propios compañeros de laboratorio. Este libro, traducido a más de diez idiomas, también se ha convertido en una exposición itinerante solicitada por varios museos, instituciones y centros educativos, para trasladar su legado a todos los rincones posibles.

Paneles que componen la exposición itinerante de “GEAS, Mujeres que estudian la Tierra” colocados en el Parque de las Ciencias de Granada, donde permanecerán todo el mes de febrero.

Paneles que componen la exposición itinerante de “GEAS, Mujeres que estudian la Tierra” colocados en el Parque de las Ciencias de Granada, donde permanecerán todo el mes de febrero.Pero el trabajo de la Comisión Mujeres y Geología no termina aquí. Dos cosas que tenemos muy claras es que no debemos caer en el error de transmitir a las futuras generaciones que para ser geóloga debes ser brillante y hacer un descubrimiento que cambie los pilares de la ciencia, ni tampoco que esta visibilización de nuestro trabajo deba realizarse únicamente un día al año. Por este motivo pusimos en marcha la iniciativa Geocharlas, que consisten en charlas, conferencias, talleres y paseos geológicos ofertados de manera totalmente gratuita a centros educativos, museos, instituciones y asociaciones de diversa índole durante todo el año. Así, las geólogas pertenecientes a la Comisión nos desplazamos a los centros demandantes para hablar de nuestro trabajo y nuestra disciplina científica a un público muy diverso, principalmente estudiantes de niveles preuniversitarios, para aumentar su conocimiento en Ciencias de la Tierra y crear referentes cercanos para las más jóvenes: nosotras mismas.

Taller didáctico ofertado como una Geocharla ante alumnado de educación primaria.

Taller didáctico ofertado como una Geocharla ante alumnado de educación primaria.Crear vocaciones científicas es una tarea ardua y muy noble, pero al igual que cuando siembras una semilla hay que regarla y cuidarla continuamente para que se desarrolle la planta, también debemos mantener y potenciar el interés por la Geología en las jóvenes. Con este propósito surgió una de las últimas iniciativas que hemos desarrollado en la Comisión, el “Programa de Mentorización Geólogas en Red” (GERMEN). Se trata de un programa en el que geólogas experimentadas de diferentes disciplinas, ámbitos de conocimiento y puestos laborales, no solo relacionados con la investigación, actuamos como mentoras de jóvenes que inician su camino como profesionales de las Ciencias de la Tierra y buscan una mano amiga para que las guíe y aconseje. Realmente, hemos creado una red de apoyo en la que todas podemos ayudarnos mutuamente a mejorar en nuestra profesión.

Reunión de bienvenida de las mentoras y mentorizadas de la última edición del “Programa de Mentorización Geólogas en Red”.

Reunión de bienvenida de las mentoras y mentorizadas de la última edición del “Programa de Mentorización Geólogas en Red”.Todas estas actividades no serían posibles si no remásemos todas en la misma dirección, compartiendo objetivos comunes que nos dan la capacidad de aumentar nuestros esfuerzos y dedicación. Salvo que las geólogas queramos acabar extinguiéndonos en unas pocas décadas.

Si queréis conocer con más detalle las actividades que realizamos en la Comisión Mujeres y Geología, solicitarnos alguna Geocharla o uniros a nuestra lista de distribución de información, no dejéis de visitar nuestra página web. Estaremos encantadas de atenderos.

Sobre la autora: Blanca María Martínez es doctora en geología, investigadora de la Sociedad de Ciencias Aranzadi y colaboradora externa del departamento de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU

El artículo Geóloga, ¿una especie en peligro de extinción? se ha escrito en Cuaderno de Cultura Científica.

Sophie Bryant, matemática y educadora irlandesa

Sophie Bryant fue la primera mujer de Gran Bretaña e Irlanda que obtuvo un doctorado en cualquier disciplina: ocurrió en 1884. También fue la primera mujer que publicó un artículo científico en las actas de la London Mathematical Society: sucedió en 1885. Y, además, fue la primera mujer irlandesa que publicó un libro de texto de matemáticas: ocurrió en 1897, era el primero de varios tomos sobre la geometría de Euclides.

Sophie Bryant. Fuente: Wikimedia Commons.

Sophie Bryant. Fuente: Wikimedia Commons.

Sophie Willock nació el 15 de febrero de 1850 en Dublín (Irlanda). Era la tercera de los seis hijos de Sophie Morris y el reverendo William Alexander Willock, miembro del Trinity College de Dublín donde enseñaba matemáticas. Fue educada en su casa por su padre y por institutrices privadas. Estas últimas eran francesas o alemanas y, gracias a ellas, Sophie consiguió hablar con fluidez ambas lenguas.

En 1863 William Alexander Willock fue nombrado titular de la Cátedra de Geometría de la Universidad de Londres y la familia se mudó a esta ciudad. Sophie pudo ingresar en 1866 en el Bedford College gracias a la concesión de una beca Arnott para ciencias. Al año siguiente se presentó al examen local de Cambridge que acababa de abrirse a mujeres; sus buenos resultados en matemáticas la colocaron en la primera clase.

En 1869 se casó con un cirujano, William Hicks Bryant, diez años mayor que Sophie. El médico enfermó y falleció un año más tarde. Sophie Bryant comenzó a trabajar entonces como maestra en una escuela para mujeres en Highgate, cerca de Londres. Pero no abandonó sus propios estudios.

La influencia de Frances Mary BussSophie conoció a la educadora Frances Mary Buss (1827-1894) en 1867, cuando se presentó al examen local de Cambridge para mujeres. Buss, que había fundado en 1850 la North London Collegiate School, animó a Bryant a continuar con su educación tras la muerte de su marido.

En 1875, la invitó a formar parte del personal del colegio para niñas que dirigía, trabajando como profesora de matemáticas. En realidad, Sophie no poseía ningún título universitario, ya que las mujeres no podían obtenerlos en ese momento. Finalmente, en 1878, la Universidad de Londres abrió sus puertas a las mujeres; Buss volvió a animar a Bryant a continuar con sus estudios. Aunque Sophie debió salvar previamente algunas carencias en su formación; su educación en casa no había incluido el aprendizaje del latín, y esa materia era necesaria para ser admitida en la universidad. Así que tuvo que recurrir de nuevo a clases particulares para aprender esa lengua y completar también sus conocimientos en alguna otra materia como la biología. En 1881 consiguió un grado con honores de primera clase en ciencias mentales y morales (filosofía) y honores de segunda clase en matemáticas. Tres años más tarde consiguió un doctorado sobre filosofía mental y moral, convirtiéndose en la primera mujer en Inglaterra en obtener este título.

Frances Mary Buss y Sophie Bryant. Fuente : Wikimedia Commons.

Frances Mary Buss y Sophie Bryant. Fuente : Wikimedia Commons.

En 1882, Bryant fue admitida como miembro de la London Mathematical Society; fue la tercera mujer en entrar en esa sociedad científica tras la geómetra algebraica Charlotte Angas Scott (1858-1931) y la lógica Christine Ladd-Franklin (1847-1930), que ingresaron en 1881.

Bryant fue la primera mujer en publicar un artículo en la revista Proceedings of the London Mathematical Society. Fue en 1884; el trabajo se titulaba On the Ideal Geometrical Form of Natural Cell-Structure. En él investigaba la forma hexagonal de los panales de abejas. Su enfoque era lógico y descriptivo, no era demasiado matemático para los estándares actuales, aunque su manera de proceder era una práctica común en la época. En su artículo, Bryant explicaba cómo la forma de los panales podría deberse a la actividad natural de las abejas, a su intuición usando el método de prueba y error. Argumentaba que era necesario que cada abeja excavara su propia celda, aproximadamente al mismo ritmo que las demás, y concluía que los semidodecaedros rómbicos alargados eran la forma natural de las celdas de los panales de abeja.

En 1895 Frances Mary Buss falleció y Bryant la sucedió como directora de la North London Collegiate School, ocupando este cargo hasta que se jubiló en 1918. Durante esos años escribió sobre temas de educación y de educación matemática.

Pionera en la educación de las mujeres, nacionalista irlandesa y feministaEntre otras muchas actividades, Sophie Bryant jugó un papel decisivo en la creación del Cambridge Training College for Women, ahora llamado Hughes Hall.

Fue miembro de la London Ethical Society, una de las primeras comunidades humanistas que defendía una vida moral al margen de la religión. Además, apoyó abiertamente el sufragio femenino, aunque defendió su aplazamiento hasta que las mujeres tuvieran una mejor educación.

Interesada en la política irlandesa y entusiasta nacionalista, Bryant escribió varios libros sobre la historia de Irlanda y la antigua ley irlandesa.

Falleció practicando senderismo en los Alpes: su cadáver fue descubierto el 28 de agosto de 1922, tras permanecer dos semanas desaparecida. Algunas noticias apuntaban a un asalto para robar sus pertenencias.

Referencias

-

Sophie Willock Bryant, MacTutor History of Mathematics Archive, St Andrews University

-

Patricia Rothman, ‘So work the honey bees… building roofs of gold’. The Story of Sophie Bryant, The London Mathematical Society Newsletter 311 (2003) 22-24

-

Patricia Rothman, A biography of Sophie Bryant, Chalkdust Magazine,18 octubre 2017

-

Peter Berresford Ellis, Sophie Bryant (part 1) y Sophie Bryant (part 2), Irish Democrat

-

Sophie Bryant, Wikipedia

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad

El artículo Sophie Bryant, matemática y educadora irlandesa se ha escrito en Cuaderno de Cultura Científica.

Un simulador hidrodinámico de superradiación

Los fluidos permiten crear sistemas a escala de laboratorio que simulan objetos muy diversos, desde átomos a agujeros negros. Los experimentos con estos fluidos ofrecen información valiosa sobre procesos que pueden ser muy difíciles de estudiar directamente. El último ejemplo de este uso de los fluidos lo proporciona un equipo de investigación del Instituto Tecnológico de Massachusetts que ha demostrado que un análogo de este tipo puede mostrar un comportamiento que recuerda a la superradiación.

En óptica cuántica, la superradiación es un fenómeno que ocurre cuando un grupo de N emisores, átomos excitados, por ejemplo, interactúa con una luz monocromática, como la de un láser. Si la longitud de onda de la luz es mucho mayor que la separación entre los emisores, entonces los emisores interactúan con la luz de manera colectiva y coherente. Esto hace que el grupo emita luz como un pulso de alta intensidad, proporcional a N2. Este es un resultado sorprendente, drásticamente diferente al caso de una longitud de onda menor que la separación, en el que la intensidad de la luz emitida es proporcional a N.

La superradiación no solo ocurre a nivel atómico. En 1969 Roger Penrose describió un proceso por el que se puede extraer la energía rotacional de un agujero negro. Un objeto cercano al horizonte de sucesos del agujero negro se divide en dos partículas. Una, con energía negativa, cae al agujero negro, haciendo que la velocidad de rotación de este disminuya. La otra, con energía positiva, escapa. El resultado neto es que se ha extraído energía a costa de la energía rotacional del agujero negro.

La superradiación en teoría general de la relatividad sería el equivalente al proceso Penrose pero con ondas. Así, en las ondas electromagnéticas o gravitacionales que se acercan a un agujero negro que rota es posible que, para algunas frecuencias, parte de la onda, con energía negativa, sea absorbida por el agujero negro, con el resultado de que la parte de la onda no absorbida tenga mayor energía e intensidad que la onda incidente.

La superradiación como fenómeno colectivo de emisión de luz tiene tanto interés fundamental como práctico. Se le pueden encontrar aplicaciones en varios campos, incluida la criptografía y la información cuántica.

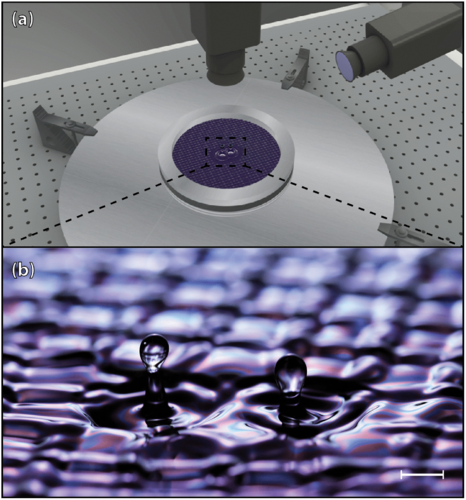

https://culturacientifica.com/app/uploads/2023/02/video1.mp4El equipo ha conseguido ahora un comportamiento similar al de la superradiación en un baño líquido con vibración vertical que contenía dos pozos circulares. Un aumento en la fuerza vibratoria hizo que la superficie líquida inicialmente plana se desestabilizara en un patrón de ondas. Un aumento adicional en la fuerza resultó en la ruptura de estas ondas y la emisión de gotas de los dos pozos. El equipo descubrió que la tasa de emisión era más alta que la de dos pozos aislados y oscilaba a medida que variaba la distancia entre los pozos. Por lo tanto, este efecto hidrodinámico captura las características clave de la superradiación en los sistemas ópticos. Este simulador físico podría proporcionar una plataforma para explorar versiones hidrodinámicas de otros fenómenos superradiativos de emisión de partículas.

Referencias:

V. Frumkin et al. (2023) Superradiant droplet emission from parametrically excited cavities Phys. Rev. Lett. doi: 10.1103/PhysRevLett.130.064002.

Ryan Wilkinson (2023) A Hydrodynamic Version of Superradiance Physics 16, s16

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Un simulador hidrodinámico de superradiación se ha escrito en Cuaderno de Cultura Científica.

¿Por qué, a veces, la somnolencia después de comer?

Imagen: Piyapong Saydaung / Pixabay

Imagen: Piyapong Saydaung / PixabayUn día, como otro cualquiera, te enfrentas a la jornada con la voluntad e ilusión de que sea especialmente productivo y así terminar una buena cantidad de tareas pendientes porque tú lo vales. Pasan las horas y vas sacando faena adelante, lo que te motiva aún más. Llega la hora de comer y te decides a ingerir un menú contundente porque, al fin y al cabo, te lo has ganado y tienes un apetito voraz. Y ahí se termina la racha productiva. Cuando pasan entre 30 y 60 minutos tras la generosa comida te invade un aplastante sopor y la concentración y la motivación que te embargaban desaparecen de forma fulminante. Bienvenido a la somnolencia postprandial.

La somnolencia postprandial o, como dicen los anglosajones, el «coma alimentario», es un fenómeno muy frecuente que no solo ocurre en los seres humanos, sino que también está documentado en múltiples especies animales, desde gatos, perros y ratones hasta moscas de la fruta y gusanos. Este estado, que suele durar entre una y dos horas, se caracteriza por la presencia de sueño, cansancio, pesadez y de estar «bajo de energías», además de dificultad para concentrarse. Estudios en humanos han observado cambios en la actividad cerebral, registrada mediante electroencefalografía, durante esta fase.

A pesar de ser algo tan cotidiano, lo cierto es que no está claro qué mecanismos provocan este estado de sopor tras las comidas. Para la medicina, esta reacción fisiológica no deja de ser una curiosidad y, por ello, son relativamente pocos los estudios que se han centrado en ella. No se trata de algo excepcional, ocurre algo similar con el hipo y el bostezo, cuyas causas también se desconocen y existen múltiples hipótesis al respecto.

Entre lo poco que sabemos sobre la somnolencia postprandial hay algunos hechos que sí están bastante claros: su aparición y magnitud depende de numerosas variables como la cantidad de comida ingerida y las característica de esta. Además, cada persona tiene una susceptibilidad diferente a «sufrir» este estado.

Por otro lado, no es cierto que una posible causa para esta somnolencia sea un flujo sanguíneo menor al cerebro por un incremento de la irrigación en el aparato digestivo. Aunque esta idea siga persistiendo en la actualidad, lo cierto es que el aporte sanguíneo al cerebro está regulado de forma precisa en todo momento y no se observan cambios significativos en este tras la ingestión de comidas. En su lugar, lo que ocurre es que hay un ligero descenso del flujo sanguíneo de los músculos esqueléticos, para que llegue más sangre al aparato digestivo en sus tiempos de mayor actividad.

Las hipótesis sobre las posibles causas detrás de la somnolencia postprandial son variadas, pero su validación científica en humanos ha sido entre escasa y nula, por lo que, a día de hoy, no es posible saber su origen. Las explicaciones que más respaldo tienen en la actualidad son las siguientes:

- El sueño y la sensación de baja energía serían unos de los muchos efectos del sistema nervioso parasimpático y la inhibición del simpático tras la ingesta de alimentos. Estos sistemas autónomos se encargan de controlar multitud de procesos involuntarios: respiración, circulación sanguínea, digestión de alimentos, función sexual, excreción de desechos, estado de alerta… El parasimpático, activado a través del nervio vago tras las comidas, causaría sueño, además de todos sus efectos bien conocidos: potenciar los movimientos intestinales (peristaltismo intestinal), relajar las válvulas gastrointestinales (esfínteres), estimular la salivación y la liberación de diversas moléculas implicadas en la digestión y absorción de nutrientes (insulina, gastrina, lipasas (enzimas que metaboliza grasas) secretina…), entre otras tareas.

- La liberación de una o varias hormonas/neurotransmisores después de comer (melatonina, adenosina, serotonina u otras) provocaría sueño al modular la actividad de ciertas regiones cerebrales como el hipotálamo, que está involucrado en la regulación de los ciclos de vigilia y sueño. La liberación de estas moléculas se produciría como consecuencia del incremento de glucosa en sangre tras la ingestión de alimentos. Las hormonas causarían la inhibición de unas neuronas específicas del hipotálamo llamadas orexigénicas (que provocan ganas de comer), lo que llevaría a una diminución del estado de alerta y a experimentar sueño.

Quizás ambos mecanismos podrían estar participando en la somnolencia postprandial de forma coordinada, junto con la posible influencia de los ritmos circadianos que llevan a un aumento de la melatonina (una hormona que estimula el sueño) y de la temperatura corporal justo en las horas posteriores a la comida. La participación conjunta de todos estos mecanismos no sería ninguna sorpresa si se considera la gran interconexión funcional que existe entre los diferentes elementos que componen el sistema nervioso. La inducción del sueño sería una forma de priorizar la función digestiva, frente a otros procesos o actividades del organismo.

En cualquier caso, sea cual sea el mecanismo que provoca el sopor tras las comidas, se recomienda no darse grandes comilonas y evitar el consumo de alcohol para reducir el riesgo de que aparezca. Varias investigaciones en personas han observado que la somnolencia postprandial surge con más frecuencia entre aquellos que comen más. Por otro lado, salir a dar un paseo tras la comida estimula el sistema nervioso simpático, lo que podría reducir los efectos soporíferos de la comida. Claro que si nos queremos rendir a los efectos de la somnolencia postprandial, una buena siesta (de entre 20 y 30 minutos) puede ser también una excelente opción para descansar y retomar el día con fuerzas renovadas.

Para saber más:

Sobre la autora: Esther Samper (Shora) es médica, doctora en Ingeniería Tisular Cardiovascular y divulgadora científica

El artículo ¿Por qué, a veces, la somnolencia después de comer? se ha escrito en Cuaderno de Cultura Científica.

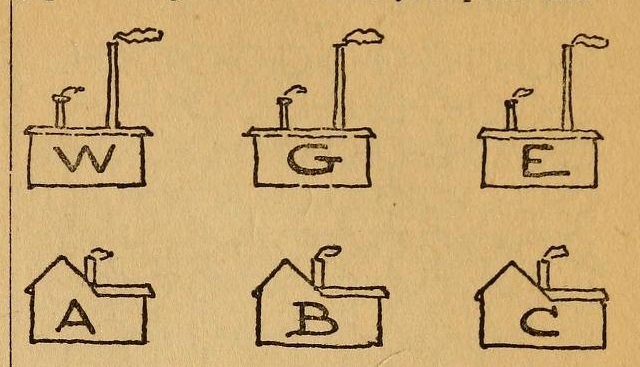

Media, mediana y moda

Foto: Pop & Zebra / Unsplash

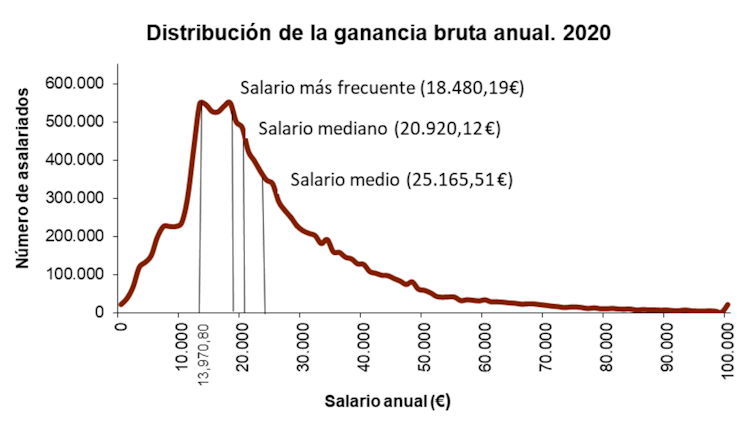

Foto: Pop & Zebra / UnsplashSegún los datos del estudio de estructura salarial que realiza el Instituto Nacional de Estadística (INE) en España, de media el salario en 2020 era de 25 165 € (en bruto, considerando los salarios a tiempo completo). Si eso implicara que la mayoría de los trabajadores a tiempo completo cobran esa cantidad, podríamos estar razonablemente satisfechos.

Lamentablemente, no es esa la realidad. El dato de 25 165 euros es la media. Pero si analizamos el salario mediano, es decir, aquel que se sitúa justo en la mitad del conjunto ordenado de salarios, fue de 20 920 €, sensiblemente más bajo.

Es más, el salario más frecuente (el salario modal o la moda de los salarios, otro valor estadístico) fue de 18 490 €. Es decir, lo más habitual es cobrar casi un tercio menos que el salario medio. ¡Hay casi 7 000 € de diferencia entre el salario más frecuente y el salario medio!

Media, mediana o moda, ¿cuál es mejor?Cuando analizamos unos datos, ya sean de empleo, de salud o de consumo energético, deberíamos elegir el valor estadístico que mejor los represente. Pero para hacerlo es importante comprender conceptualmente el significado de cada una de las tres medidas de centralización que acabamos de utilizar: la media, la mediana y la moda.

- La media es el valor que resultaría de repartir equitativamente el total observado entre los individuos de la muestra.

- La mediana es el valor que divide la secuencia ordenada de observaciones en dos partes iguales.

- La moda es el valor más frecuente.

Salario medio, salario más frecuente y salario mediano en España en el año 2020.

Salario medio, salario más frecuente y salario mediano en España en el año 2020.INE, Author provided