Alfred Werner, químico hasta la extenuación

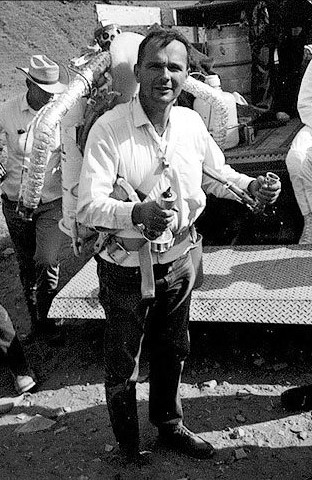

Imagen oficial de Werner que se conserva en la Biblioteca del Politécnico de Zúrich (ETH Zürich)

Imagen oficial de Werner que se conserva en la Biblioteca del Politécnico de Zúrich (ETH Zürich)Alfred Werner nació en 1866 en uno de esos lugares marcados por la guerra en la vieja Europa, una de esas ciudades en la frontera entre imperios que cambiaba de manos según soplase el viento. Mulhouse tenía tendencia a ser francesa, la mayoría de sus habitantes se sentían franceses, a pesar de que sus apellidos eran una mezcolanza de prusianos y galos. Siendo Alfred niño, la guerra franco-prusiana de 1870 hizo que la ciudad cambiase de nuevo de manos, siendo anexada al recién formado Reich Alemán diseñado por Otto von Bismarck para mayor gloria del káiser Wilhelm.

Muchos ciudadanos con lazos franceses abandonaron la ciudad, no así los padres de Alfred, que prefirieron quedarse y resistir, hablando francés en casa aunque estuviese expresamente prohibido. Ya adulto, Alfred recordaría cómo disparaba su fusil de juguete contra los soldados alemanes y su mesa de despacho en Zúrich estaba presidida por un trozo de bomba que recogió cerca de su casa siendo niño.

Alfred no fue precisamente un alumno ejemplar y, como precaución, solía llevar trozos de cartón dentro de sus pantalones con la idea de aliviar el castigo físico que suponía saltarse clases. Los biógrafos de Werner hablan de rebeldía frente a la extrema rigidez del sistema de enseñanza alemán, la misma que años después mostraría Einstein. Sin embargo, Alfred era muy experimental a la par que teórico: sus escapadas las empleaba en hacer experimentos químicos detrás de un granero cercano y está documentada al menos una explosión en su habitación.

Entre 1885 y 1886 Alfred tuvo que hacer el servicio militar en Karlsruhe, donde aprovechó para asistir a las conferencias que Engler daba en el Politécnico local. En 1886 toma la decisión de alejarse de conflictos y se matricula en el Politécnico de Zúrich. En 1889 se diploma en química técnica y, a pesar de suspender varios exámenes de matemáticas en su primer intento, consigue su doctorado en 1892, tras una estancia de casi dos años en París, con una tesis sobre la disposición espacial de moléculas que contienen nitrógeno, con Arthur Hanztsch como director y Marcellin Berthelot como codirector. Al igual que Einstein, si bien realizó su trabajo en el Politécnico el doctorado se lo otorgó la Universidad de Zúrich.

Los años 1892 y 1893 fueron de subsistencia para Alfred, trabajando como privat dozent, profesor sin sueldo (lo que sus alumnos le pagasen), en la Universidad de Zúrich. En 1893 se convirtió e profesor asociado de la Universidad con un modesto salario, sucediendo a Victor Merz como profesor de química orgánica. En 1895 adquiriría la nacionalidad suiza y, a pesar de tener ofertas de Viena, Basilea o Wurzburg, decide quedarse en la Universidad de Zúrich aceptando la plaza de catedrático con sólo 29 años. Pero, ¿qué había hecho Alfred en este tiempo para escalar así de rápido?

Alfred hizo su primera investigación química independiente con 18 años y su interés siempre había estado en la frontera entre la química orgánica y la inorgánica, alrededor del problema de la valencia y la estructura de los compuestos químicos. Un par de años después de su doctorado, obsesionado como estaba con el problema, cuenta la leyenda que una noche se despertó sobresaltado a las dos de la madrugada, saltó de la cama y se puso a escribir. A las cinco había terminado “Contribución a la constitución de los compuestos inorgánicos”, el artículo que sentaba las bases de la teoría actualmente aceptada sobre los compuestos de coordinación, también llamados complejos.

Alfred proponía flexibilizar las ideas de Kekulé, de una valencia rígida en una dirección, a una esfera de fuerza con el centro en el átomo. Sugería la existencia de un número de coordinación, que sería el número de ligandos que un determinado átomo metálico buscaría adquirir. Estas ideas eran controvertidas pero lo suficientemente interesantes como para asegurarle un puesto en la universidad.

Con el futuro asegurado, se dejó barba y bigote para intentar conseguir un poco de respeto por parte de los alumnos y colegas, se casó con una chica suiza y se dispuso a fundar una familia y a probar su teoría. La familia estuvo completa 8 años después. Probar la teoría le costaría 20 años de trabajo incansable.

La rutina era siempre la misma: sugería una estructura para un compuesto y predecía sus propiedades a partir de ella. Después una laboriosísima serie de síntesis muy meticulosas hasta conseguir el compuesto. Finalmente caracterizar el compuesto, asegurarse de que era el que se quería obtener y comprobar que sus propiedades correspondían a las predichas. Por ejemplo, proponía que los compuestos octaédricos tenían átomos en posiciones fijas alrededor de un centro, lo que significaba que tenían quiralidad y, por tanto, podían rotar la luz polarizada. Si se encontraban los compuestos mediante síntesis, su actividad óptica vendría a confirmar las ideas de Alfred.

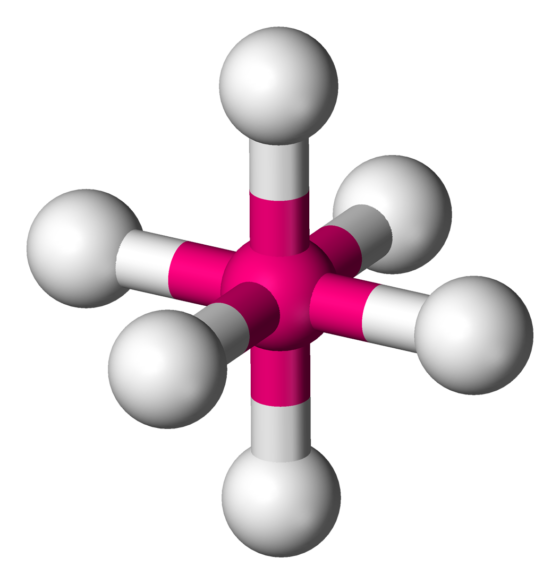

En química, se llama geometría molecular octaédrica a la forma de los compuestos en los que seis ligandos (átomos, moléculas o iones) se disponen alrededor de un átomo o ion central, definiendo los vértices de un octaedro.

En química, se llama geometría molecular octaédrica a la forma de los compuestos en los que seis ligandos (átomos, moléculas o iones) se disponen alrededor de un átomo o ion central, definiendo los vértices de un octaedro.A diferencia de los compuestos que usó Pasteur, las moléculas ópticamente activas de Alfred no formaban cristales que se pudiesen separar con pinzas. Empleó 18 años en perfeccionar el método para conseguir separarlas con la ayuda inestimable de su alumno de doctorado Victor King.

Pero siempre hay críticos, y eso no es necesariamente malo. Se pensaba que la quiralidad era algo propio de los átomos de carbono y, como en los compuestos de Alfred había carbono, sugerían que la actividad óptica era consecuencia de la presencia de estos. En 1914, un año después de recibir el Nobel por sus logros, con la ayuda de otra estudiante de doctorado, Sophie Matissen, Alfred consiguió preparar un compuesto ópticamente activo en el que solo había nitrógeno, hidrógeno y oxígeno, despojando al carbono de sus derechos exclusivos en lo que a quiralidad se refiere.

Werner, maestro

Todos los avances químicos de Alfred Werner están disponibles en múltiples recursos en la red (por ejemplo). Sin embargo, en pocos lugares encontraréis su otra gran contribución a la ciencia. Su labor como enseñante y director de personas, en lo que fue un avanzado a su tiempo.

Alfred era un orador magnífico y profesor vocacional. El aula en el que daba clases Alfred solía contener de forma rutinaria del orden del doble de personas de las que se suponía que era su capacidad: se sentaban en los pasillos, se aglomeraban alrededor del banco de demostraciones. En verano había desmayos y los rectores de la institución mostraban su preocupación por los riesgos de incendio o explosión. Un chascarrillo de la época era “¿cuándo ocupa un estudiante de química el volumen mínimo? En una clase de Nunwiegeht’s”. Ni que decir tiene que Nunwiegeht’s era uno de los motes de Alfred, por su costumbre de saludar con un ¿cómo te va?.

Alfred dirigió más de 200 tesis doctorales y, siendo la Universidad de Zúrich pionera en admitir mujeres para el doctorado, él fue pionero en admitirlas en ciencia, aplicando una meritocracia estricta. Buena parte de sus más 200 tesis dirigidas fueron escritas por mujeres. No es de extrañar que personas de toda Europa y Estados Unidos fuesen a Zúrich a estudiar con él.

El laboratorio de Alfred en Zúrich era extraoficialmente conocido como “las catacumbas”, celdas semisubterráneas donde siempre era necesaria la iluminación artificial. Según una revista humorística de la universidad, una muestra del aire de las catacumbas contenía de forma típica “un 50% de ácidos evaporados, 30% de olores nauseabundos de preparados, 10% de humo de cigarrillo, 5% de alcohol y 5% de gas de iluminación mal quemado, lo suficiente para enviar al más resistente de los individuos al gran más allá”. La universidad, consciente de la necesidad de un nuevo edificio para albergar los laboratorios, lo acabó concediendo, con lo que Alfred trabajó incansablemente en su diseño y construcción mientras seguía dirigiendo elementos fundamentales de su investigación. Alfred empezó a dormir muchos días en su despacho de la universidad y a buscar en el alcohol una manera rápida de relajarse.

El precio que Alfred pagó fue muy alto. El estrés, el exceso de trabajo, su consumo excesivo de tabaco y alcohol le llevaron al colapso nervioso. No mucho después de recibir su nuevo edificio fue obligado a dimitir.

Alfred Werner murió en un hospital psiquiátrico de Zúrich poco después de cumplir los 53 años.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Alfred Werner, químico hasta la extenuación se ha escrito en Cuaderno de Cultura Científica.

¿Por qué la carne de los atunes es roja y la de los lenguados, blanca?

Cola de atún y cabeza de lenguado.

Cola de atún y cabeza de lenguado.Shutterstock / Natasha Breen

El color de los atunes tiene importancia económica: existen casos de fraude en los que se enrojece la carne de ejemplares de otras especies para hacerlas pasar por atún rojo (Thunnus thynnus) o para que las piezas parezcan frescas y no deterioradas por una conservación deficiente. Pero ¿por qué la carne de estos animales es roja?

El color de la carne de los túnidos (género Thunnus) varía entre especies, pero tiende a ser más oscuro que el del resto de peces. Por un lado, es una carne con un alto contenido en mioglobina, un pigmento que se encuentra en las células musculares de muchos vertebrados y que hace las veces de depósito celular de oxígeno para cuando se necesita.

Por otro lado, es una musculatura con alta densidad de vasos sanguíneos, en especial la del atún rojo. Como norma general, cuando un animal tiene músculos muy irrigados es que es muy activo. Así son los atunes, fuertes, capaces de nadar a velocidades asombrosas y hacerlo de forma sostenida. Recorren por ello grandes distancias. Además, la sangre de los túnidos –la del atún rojo en especial– tiene un contenido muy alto en hemoglobina.

La razón de todos estos rasgos –alto contenido muscular de mioglobina, musculatura muy irrigada, alto contenido de hemoglobina en la sangre– es que la gran actividad que desarrollan exige un suministro permanente e intenso de nutrientes y, sobre todo, de oxígeno. Lo cierto es que la musculatura de los atunes alcanza prestaciones metabólicas difícilmente superables.

Pero hay más. Hay una zona en el tronco de los túnidos que es más oscura, tiene más vasos sanguíneos y una consistencia casi esponjosa. De hecho, los atunes pierden mucha sangre por esa zona cuando sufren un corte. Esa zona oscura, sanguinolenta incluso, es lo que se conoce como rete mirabile.

La red maravillosa —su nombre en español– es un dispositivo que permite que la sangre (arterial) fría procedente de las branquias se caliente antes de llegar a los músculos. Recibe el calor de la sangre (venosa) procedente de la musculatura, donde se ha calentado por efecto del metabolismo. Ese intercambio de calor se produce entre vasos sanguíneos dispuestos en íntima proximidad unos con otros, pero en cuyo interior la sangre circula en sentidos opuestos. Esa forma de circular –contracorriente– permite una transferencia óptima de calor entre los dos subsistemas circulatorios. Es un ejemplo fisiológico de lo que se denomina un “intercambiador contracorriente”. En el mundo animal no son raros intercambiadores así, de calor, de gases o de iones.

Nosotros utilizamos intercambiadores contracorriente –no biológicos, por supuesto– para termostatizar instalaciones, por su gran eficiencia. Aunque hay ingenieros que creen que son una creación de la mente humana, en realidad fueron diseñados por la naturaleza hace millones de años, gracias a la selección natural.

Así pues, el calor generado por la potente actividad muscular de los atunes no se pierde por las branquias cuando la sangre llega a ellas. Se ha transferido a la sangre arterial. Se podría decir que ha quedado preso en una jaula fisiológica. Y gracias a ello, el interior de los atunes –parte de su musculatura, los ojos y el encéfalo– se encuentra, en aguas frías, hasta diez grados más caliente que el agua en que nadan. Desarrollan así niveles metabólicos muy altos, acordes con los de la actividad física que despliegan.

Atún fresco.

Atún fresco.Shutterstock / Mark Watts

Llegados a este punto se habrán acordado de los lenguados o peces similares cuya carne es blanca. En efecto, esos peces no dan un palo al agua, son lo que en inglés se denomina depredadores sit and wait, porque se “sientan” a esperar.

Durante la mayor parte del tiempo permanecen sobre el sustrato, quietos, mimetizados con el fondo o semicubiertos con partículas de arena o fango. Pasan así inadvertidos por sus posibles presas. Los ojos de los peces planos se encuentran en uno de los lados de la cabeza mirando hacia arriba. Cuando ven que pasa alguna posible presa por encima, realizan un movimiento veloz, como un latigazo, se lanzan hacia ella. Si tienen suerte, la capturan.

Lo interesante es que los músculos que ejecutan ese movimiento no utilizan oxígeno, son anaerobios, músculos que obtienen su energía (el ATP) únicamente de la glucolisis, sin completarse, por lo tanto, la ruta estándar del metabolismo aerobio –a través del ciclo de Krebs y la cadena respiratoria en el interior de las mitocondrias– característico de otros tejidos.

Lenguado fresco.

Lenguado fresco.Shutterstock / seeshooteatrepeat

La glucolisis es una vía muy rápida aunque ineficiente. Proporciona energía a gran velocidad, que es de lo que se trata en este caso. Surte de ATP a músculos rápidos y por eso la utiliza el lenguado para atrapar a sus presas. Así pues, como no es necesario un aporte permanente de oxígeno, no hace falta que llegue mucha sangre a esa musculatura. A ello se debe que los peces planos y especies con un modo de vida similar tengan la carne tan blanca.

La carne de los atunes es roja; la de los peces planos, blanca, apenas sangra al cortarla. Esas diferencias obedecen al modo de vida de las especies. No son caprichosas, como no lo son gran parte de los fenómenos de la naturaleza, aunque creamos lo contrario.![]()

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo ¿Por qué la carne de los atunes es roja y la de los lenguados, blanca? se ha escrito en Cuaderno de Cultura Científica.

Introducción a Bitcoin

Mikel Lezaun Iturralde

Bitcoin es la primera moneda nativa digital. Como moneda digital, Bitcoin no tiene ninguna componente física, simplificando mucho, se puede afirmar que los bitcoin son registros informáticos y claves para realizar transacciones. Bitcoin opera en una extensa red de ordenadores abierta a quien lo desee, descentralizada (todos los nodos son iguales, no hay un nodo central que gestiona la red) y en la que los nodos tienen una copia de la gran base de datos de todas las transacciones. La red Bitcoin funciona con la tecnología blockchain, que garantiza por sí misma la seguridad de su gran base de datos. Bitcoin emite su propia moneda sin ningún respaldo de una entidad financiera o banco central. La emisión de moneda la hace Bitcoin en tiempo, número y destino siguiendo unas reglas fijas, independientemente del valor de cambio de bitcoin y de la coyuntura económica. En este artículo se describe los principales procesos del sistema blockchain, o cadena de bloques, y Bitcoin.

Foto: Executium / Unsplash

Foto: Executium / Unsplash-

Introducción

En el sistema bancario tradicional, para hacer una transferencia de una cuenta de un banco a otro banco, se cursa la orden, el banco comprueba si la cuenta del ordenante tiene fondos, resta del saldo de su cuenta el dinero de la transferencia y comunica al otro banco que debe sumar esa cantidad al saldo de la cuenta del destinatario. Esta gestión no mueve billetes de un lado a otro, simplemente es un cambio en los saldos de las cuentas. En realidad, todo esto lo hace un programa informático. Los bancos son los intermediarios y garantes de las transacciones, son quienes mantienen de forma segura toda la información en sus bases de datos y por ello cobran sus comisiones.

Ya en 1996, el Premio Nobel de economía Milton Friedman apuntó la necesidad de que se creara un protocolo específico para transferir valor por Internet, para trasferir dinero electrónico de un usuario A a uno B, sin que A tenga por qué saber la identidad de B o B quien es A.

En 2008, Satoshi Nakamoto, del que hasta la fecha no se sabe nada, ni quien, quienes o qué es, publicó un artículo en la lista de correo Cryptography de Internet, en el que definía un protocolo de comunicaciones para transmitir valor, basado en una red en la que todos los nodos se comportan como iguales, sin jerarquías. El año siguiente, él mismo publicó la primera versión del software Bitcoin, creó la red del mismo nombre y las primeras unidades de moneda, que también denominó bitcoin. En 2010, una vez puesto en marcha el sistema Bitcoin, Nakamoto se apartó y desapareció del mapa.

Características de la red Bitcoin

Las características más destacables de las monedas digitales, en particular de la red blockchain (cadena de bloques) de Bitcoin son las siguientes.

-

La red blockchain de Bitcoin es abierta, todo el que quiera puede participar, no se necesita autorización ni identificación.

-

La red es transfronteriza, se puede transferir de un punto a cualquier otro punto del mundo. En realidad, los bitcoin no residen en ningún sitio, no son algo físico.

-

La red es neutral, no hay que dar ninguna explicación a una transferencia. La red procesa cualquier transacción independientemente del ordenante, destinatario y cantidad.

-

La red es resistente a la censura, nadie puede evitar que se realice una transacción.

-

La red es pública, todo es verificable por todos, la red es totalmente transparente.

-

La red por sí misma gestiona las transacciones y garantiza la seguridad tanto de las transacciones como de la base de datos. No necesita de intermediarios ni de bancos.

-

Las transacciones son seudónimas, no se sabe directamente quien es el emisor ni quien el receptor.

-

Las transacciones son muy fáciles de realizar. El único coste es la tasa por transferencia que se abona a los denominados mineros, que además es voluntaria. Ahora bien, hace tiempo que se prioriza las transacciones con las comisiones más altas.

-

Preliminares

Digitalización

Al hablar de Bitcoin se dice que es una moneda digital. Digitalizar no es otra cosa que convertir un texto, un documento en números. Todos los símbolos tipográficos tienen un equivalente numérico. Cualquier número, entendido como el valor que representa, se puede escribir de distintas formas. En el sistema decimal se utilizan los diez caracteres 0, 1, 2, 3, 4, 5, 6, 7, 8 y 9; en el hexadecimal los dieciséis caracteres 0, 1, 2, 3, 4, 5, 6, 7, 8, 9, a, b, c, d, e, f y en el binario solamente los caracteres 0 y 1. En particular, cualquier documento se puede convertir en una lista de 0 y 1. Lo mismo que en el sistema decimal, las operaciones matemáticas se pueden realizar en los otros sistemas. En un sistema electrónico el 0 se corresponde con un circuito abierto y el 1 con uno cerrado. Así, la información trasladada a números binarios se puede almacenar y tratar matemáticamente en dispositivos electrónicos.

A modo de ejemplo, la expresión binaria de la palabra covid-19 es

0110001101101111011101100110100101100100001011010011000100111001

y la de Covid-19

0100001101101111011101100110100101100100001011010011000100111001

Notemos que solo se diferencian en el tercer carácter, en el primer caso es 1 y en el segundo 0.

Funciones resumen

Dado un documento, en muchos casos interesa tener un resumen representativo que lo identifique de forma única y que sirva para verificar su correcta trasmisión y almacenamiento en redes y sistemas digitales. Para obtener estos resúmenes, en Bitcoin se utilizan las funciones resumen (hash en inglés) criptográficas. Las principales características de estas funciones son las siguientes.

-

Una función resumen no es aleatoria, en general es fácil de calcular y aplicada a un mismo documento siempre da el mismo resultado. Por contra, de un resumen criptográfico no es posible recuperar computacionalmente el documento del que proviene.

-

Las funciones resumen son muy sensibles, una levísima modificación de la entrada produce un resumen completamente diferente.

-

Sea cual sea el tamaño de la entrada, que en general suele ser grande, la longitud del resumen es la misma. Así, del resumen no se puede deducir si proviene de un documento extenso o de uno breve.

Las funciones resumen se calculan a partir de la expresión binaria del documento, esto es, de su expresión en 0 y 1. Para ello, se expande la lista original de 0 y 1 a una más amplia, se descompone esta nueva lista en bloques, en cada bloque se cambia varias veces de sitio los 0 y 1 y se realizan distintas operaciones matemáticas. Esto es relativamente fácil de hacer, siempre se siguen las mismas reglas. Así, validar el resumen de un texto es prácticamente instantáneo.

En Internet se encuentran muchas páginas web que calculan el resumen de un documento con distintas funciones resumen. En Bitcoin, de todas las transacciones y bloques se calcula el correspondiente resumen identificativo. Para ello utiliza la función resumen SHA-256, que proporciona resúmenes formados por 256 ceros o unos, que se traducen en 64 caracteres hexadecimales 0, 1, 2, 3, 4, 5, 6, 7, 8, 9, a, b, c, d, e, f. Por ejemplo, el resumen de la palabra covid-19 es

88529c3ac8ebd2dcb21a432c4ea0190c8370850b73ef95a527d150d4d424bc62

y el de la palabra Covid-19

993ab4dd1fb517c10afcd32c007ec64c3d76bac264104bf44c57f5667f609da7

Como se ve, una simple diferencia de un carácter 0 y 1 da un resumen completamente diferente.

El resumen de los tres párrafos de la introducción de este mismo documento es

aedd1bb22c321638f1155e3611bed6e677b73de5c428a9ed956d35f54d47a3e6

que también tiene 64 caracteres hexadecimales.

Árbol de Merkle

Supongamos que tenemos un bloque de documentos, cada uno con su resumen criptográfico y que, para reforzar la seguridad del contenido del bloque, se quiere obtener un resumen de todos los resúmenes. Para ello se construye un árbol de Merkle, que consiste en lo siguiente. Se ordenan los resúmenes de los documentos del bloque (no hay que olvidar que los resúmenes no dejan de ser números) y se van juntando de dos en dos en un mismo texto. De cada uno de los nuevos textos formados por un par de resúmenes, se obtiene su resumen. Con los resúmenes obtenidos se vuelve a repetir la operación, esto es, se forman los textos de pares de resúmenes y de cada uno se obtiene su resumen. Se sigue el proceso hasta llegar a un solo resumen, que se denomina raíz de Merkle. Así, cualquier modificación en una transacción almacenada, para que sea coherente, implica la modificación de su resumen, lo cual conlleva la modificación de la raíz de Merkle.

Firma digital

Una firma digital es un mecanismo criptográfico que garantiza que la firma de un documento es auténtica, esto es, que no ha sido suplantada; que el documento no ha sido alterado y, además, que quien lo firma no lo puede repudiar. Bitcoin, para la autentificación de las transacciones, para la firma digital, utiliza un sistema criptográfico de clave pública y clave privada. Las claves pública y privada de una firma digital son dos números muy grandes, dependientes entre sí y que se generan simultáneamente mediante un algoritmo matemático. Generar los dos números es relativamente fácil, pero el camino inverso, obtener de uno de ellos el otro, es computacionalmente imposible.

La clave privada se debe guardar de forma muy segura para que nadie tenga acceso a ella. Por contra, como indica su nombre, la clave pública es pública. La firma se realiza con la clave privada. El proceso de firma digital es como sigue. En primer lugar, la aplicación informática de la firma digital obtiene el resumen del documento. Luego, este resumen, mediante un algoritmo matemático basado en la clave privada del firmante, se encripta. Junto con el documento se graba su resumen, el resumen encriptado y la clave pública. Todo esto es público, de acceso libre. Para verificar la autenticidad de la firma se utiliza la clave pública del firmante. Primero se comprueba que el resumen es el del documento. A continuación, se aplica al resumen encriptado un algoritmo matemático basado en la clave pública y el resultado tiene que ser exactamente igual que el resumen del documento firmado. Si ocurre así, el documento firmado es auténtico. Si no, se rechaza, ya que haciendo lo que se indica, solo se recupera el texto del resumen del documento si se utiliza la clave pública de quien lo ha firmado. Esta comprobación la puede hacer quien quiera.

-

Monedero o wallet

Crear una cuenta bitcoin es muy fácil. Basta con registrarse en alguna de las múltiples páginas web dedicadas a ello e introducir una serie de datos personales. Una vez registrado, para operar se necesita instalar un monedero o wallet, que no es más que una simple aplicación informática que permite transferir y recibir moneda digital. Instalado el monedero, él mismo crea los pares de claves pública y privada para la firma digital de las transacciones. A partir de la clave pública, el monedero genera de forma determinista la dirección. Los monederos guardan la identificación de las transacciones dirigidas a sus claves públicas y direcciones y su contenido es de acceso público. Ahora bien, las correspondientes claves privadas se deben mantener bien guardadas, ya que, como se verá, con ellas se hacen las transferencias de las transacciones registradas en el monedero. Una misma persona puede tener varios monederos. También, conforme va recibiendo transacciones, se puede ir cambiando las claves privada y pública y por tanto la dirección de recepción. Así, no se sabe si distintas direcciones en realidad corresponden a un mismo usuario.

Un ejemplo de clave pública es

020766fd4ffbbfa2086a96b335ba6eff24b58e4819936f8dc9d4002dabc9b11405

que genera mediante cálculos matemáticos la dirección

1FVRX63gUDxkQ25C7ivMa27C9nT1DUafmD

-

Transacciones

Las transacciones son el vehículo para transferir bitcoin de un usuario A a uno B. Las transacciones son públicas, están identificadas por su resumen y se guardan agrupadas en bloques, que van conformado una cadena. Una transacción contiene una entrada (input) en la que consta la procedencia de los bitcoin a transferir y una salida (output) que indica a donde van esos bitcoin. Si A quiere hacer una transferencia a B, en la salida de la transacción A incluirá la dirección y clave pública que le habrá proporcionado B. La correspondiente clave privada B la mantendrá oculta y segura, ya que la tendrá que utilizar cuando quiera transferir los bitcoin que reciba en esta transacción. En la entrada de la transacción A incluirá la identificación de una transacción con suficientes bitcoin que tiene por salida una transacción que un usuario C envió a una dirección y clave pública de A. La transacción de la entrada tiene que estar sin gastar, A no la ha tenido que haber utilizado en anteriores transacciones. Esta transacción la tendrá registrada A en su monedero. La validez de la transacción, la seguridad de que A tiene los bitcoin que pretende transferir a B, la realiza A con la firma digital. Para ello A firma la transacción con la clave privada asociada a la clave pública de la salida de la transacción que realizó C dirigida a la dirección y clave pública de A. Con la clave pública se puede verificar que esta transacción solo la ha podido firmar A, lo cual asegura que A es el propietario de los bitcoin que transfiere a B. En realidad los usuarios no tienen en propiedad bitcoin, lo que tienen son claves privadas de salidas de transacciones no gastadas (en inglés UTXO de Unspent Transaction Output) para con ellas hacer transacciones. Si A pierde la clave privada, nadie puede utilizar los bitcoin de la transacción y desaparecen. Y si alguien se apodera de la clave privada, el dinero de la salida de la transacción es suyo, lo puede utilizar sin ninguna cortapisa.

La salida de una transacción solo se puede utilizar una vez y siempre se transfiere completa. Ahora bien, ¿cómo se hace una transferencia de 3,9 bitcoin, cuando se quiere utilizar una salida de transacción no gastada con 5,3 bitcoin, sin perder los 1,4 bitcoin restantes? El procedimiento ideado para solventar esta dificultad es que, en estas situaciones, efectivamente la entrada de la transacción es la salida con 5,3 bitcoin que se quiere transferir, pero se crean dos salidas, una de 3,9 bitcoin a la dirección que se quiere enviar y otra de 1,4 bitcoin a una dirección y clave pública propia. De esta forma, la salida no gastada de la auto transacción con 1,4 bitcoin vuelve al emisor y solo él la puede utilizar firmándola con su clave privada. De esta forma no pierde los 1,4 bitcoin.

Veamos como ejemplo una de transacción incluida en el bloque 672431 que se describirá más adelante. El resumen que identifica a esta transacción es

57ff5d1af48c6687f1500e5acfe9a2297d5091a62e5e8da72ae31967282bdd22

y la dirección del ordenante

1KbnB9GTmUDn9Kjebm9w7aC9s5WxjSMcR5

La entrada de la transacción, es la salida de la transacción con 3,61216838 bitcoin contenida en el bloque 672424, cuyo resumen es

d42f3804872d1b4fe466aa156bfe92e430564f445d6ac5cf172e7e1630b2560e

y dirección la del ordenante

1KbnB9GTmUDn9Kjebm9w7aC9s5WxjSMcR5

La transacción tiene dos salidas. Una con 3,54120686 bitcoin a la dirección

12hy9qkZTiBcN9kCMKvQ62YDj3D7d2Ay3H

y otra con 0,07059952 bitcoin a la dirección

3JmgHw6rjUHgkptYmKX5SmekScxjFzHve9

La tarifa que fija la transacción es 0,00036200 bitcoin

El gasto total de la transacción es 0 bitcoin, que es igual a la cantidad de la entrada.

Este sistema público de transacciones es anónimo. Aunque se puede seguir el recorrido de las transacciones, de los usuarios solo se conoce claves públicas y direcciones obtenidas de ellas.

Para facilitar las transacciones un bitcoin está fraccionado en satoshi. Un bitcoin son cien millones de satoshi.

-

Nodos de la red

La red Bitcoin es una red descentralizada, no hay un nodo central que gestiona la red, y abierta, quien quiera puede unirse libremente a la red con solo descargar e instalar en su ordenador el software adecuado. En la red Bitcoin existen varios tipos de nodo, cada uno con sus funciones específicas.

Los nodos completos son los nodos que almacenan una copia exacta y actualizada de la cadena de bloques. Son los que verifican la validez de las transacciones y bloques de transacciones y los propagan por la red a otros nodos. Los nodos completos son los encargados de verificar que se cumplen todas las reglas del protocolo Bitcoin y, por tanto, son los que verdaderamente otorgan robustez, seguridad y estabilidad a la red. Entre los nodos completos se destacan los nodos públicos. Estos nodos ejercen de forma continua e ininterrumpida como un punto de comunicación e interconexión con otros nodos de la red para transmitir datos e información. Cualquier nodo que desee conectarse con un nodo público lo puede hacer libremente cuando quiera.

Los nodos de minería o mineros son los nodos completos que agrupan las transacciones en bloques y los confirman realizando lo que se denomina minado y que se explica más adelante.

Por último, están los nodos ligeros. Son nodos que no mantienen una copia de la cadena de bloques y no participan en el proceso de verificación y validación de las transacciones. Los nodos ligeros pueden solicitar y recibir de los nodos completos públicos el estado de una transacción concreta. En particular pueden obtener información de sus propias transacciones, si están incluidas o no en un bloque. Los nodos ligeros trabajan únicamente como puntos finales de comunicación y son ejecutables en dispositivos móviles como teléfonos y tablet.

Hay que destacar que toda transacción también debe incluir el pago voluntario de una comisión para quienes realizan las verificaciones, agrupan las transacciones en bloques y confirman los bloques, esto es, para los mineros.

-

Bloques de la cadena

Una ver realizadas, las transacciones se trasmiten entre los nodos mediante el protocolo de comunicación de la red Bitcoin y los nodos completos verifican su validez. Una vez verificada su validez, las transacciones quedan a la espera de que los nodos mineros las agrupen en un bloque y lo confirmen. Cada minero construye su propio bloque seleccionando las transacciones que más le beneficien y no estén incluidas en bloques ya confirmados. Estos bloques son los bloques candidato y su tamaño tiene que ser inferior a un megabyte. Como se verá más adelante, para que un bloque sea confirmado, y en consecuencia también todas sus transacciones, se tiene que minar. Como minar un bloque está recompensado, hay muchos mineros construyendo su bloque candidato y todos ellos contendrán más o menos las mismas transacciones. Además, junto con las transacciones verificadas, en los bloques se introduce una primera transacción denominada coinbase, que no tiene entrada y la salida está dirigida a una clave pública y dirección del minero. Esta salida de transacción contiene los bitcoin que recibirá el minero por el minado y las comisiones de las transacciones. También, de los resúmenes de las transacciones de cada bloque se calcula su raíz de Merkle.

Todos los bloques confirmados tienen su propio resumen. Para encadenar un bloque con los anteriores, se introduce en los bloques candidato el resumen del último bloque confirmado. Así confirmado un bloque candidato con su correspondiente resumen, queda encadenado al anterior. Cualquier modificación en una transacción almacenada en un bloque requerirá cambiar el resumen de su bloque y, como este resumen está contenido en el bloque siguiente, también se deberá cambiar su resumen, y así sucesivamente. En definitiva, modificar una transacción almacenada en un bloque requiere modificar el resumen de su bloque y el de todos los bloques siguientes, lo cual resulta técnicamente irrealizable. Ésta es la gran garantía de seguridad de la base de datos Bitcoin.

Para su identificación e información, en el encabezado de cada bloque se incluye su resumen, la raíz de Merkle, una marca de tiempo, timestamp en inglés, y los datos del minado.

-

Minado de un bloque. Prueba de trabajo

En Bitcoin, una vez conformado un bloque de transacciones, para confirmarlo hay que minarlo realizando una prueba de trabajo (PoW del inglés Proof-of-Work). La prueba de trabajo consiste en obtener un resumen del bloque que sea menor que un número fijado, denominado target, que en hexadecimal es un número de 64 cifras que comienza por unos cuantos ceros. Recordemos que los resúmenes son números y se pueden comparar con el target. Esta prueba de trabajo es muy difícil de realizar, pero muy fácil de verificar.

En Bitcoin, cada bloque se conforma y mina más o menos cada diez minutos y el primer minero que supera la prueba de trabajo recibe una recompensa en bitcoin de nueva creación. Se consigue mantener un ritmo de más o menos diez minutos en la creación de los bloques, controlando la dificultad del minado. La dificultad del minado es una medida de la cantidad de recursos necesarios para minar Bitcoin, que sube o baja dependiendo de la cantidad de potencia computacional disponible en la red. La dificultad se actualiza automáticamente cada 2016 bloques, más o menos cada dos semanas. Se calcula mediante una fórmula matemática a partir de lo que se ha tardado en minar los 2016 bloques precedentes.

Una vez obtenida la nueva dificultad, a partir de ella, inmediatamente se actualiza y fija un nuevo target para los 2016 bloque venideros. Éste será menor, y por tanto será más difícil minar el bloque, cuanto menor haya sido la dificultad del minado de los 2016 bloques precedentes. Así, conforme más fácil sea el minado debido a la mejora computacional, se aumenta la dificultad del minado imponiendo un target más pequeño. De esta forma, aunque varíe la capacidad computacional de la red, se consigue mantener el tiempo de unos 10 minutos entre cada bloque.

El procedimiento para superar la prueba de trabajo consiste en añadir al bloque un número arbitrario, que sólo se puede usar una vez, con el fin de que el resumen resultante cumpla la condición de ser menor que el target. Este número se denomina nonce o número de un solo uso y normalmente consta de 8 cifras hexadecimales. La única forma de obtener el número de un solo uso requerido es probando por fuerza bruta. Este proceso requiere un intensivo trabajo computacional con hardware especializado (ASIC) y consume gran cantidad de energía eléctrica. A esto se debe la creación de pools de mineros en países como China, en los que la energía es barata y el minado resulta rentable.

Una cuestión a solucionar es cómo resolver el problema del doble gasto, que una misma moneda no se pueda gastar dos veces. Esta dificultad es propia de las monedas descentralizadas, ya que al no haber un centro que controle la llegada de las transacciones, ante dos iguales, no siempre es posible decidir cual se ha producido la primera y darle a ésa la validez. En Bitcoin, con frecuencia se da el caso en que, a partir de un mismo bloque, dos mineros minen casi simultáneamente su bloque y lo distribuyen a la red por caminos distintos. Como son los propios mineros quienes conforman los bloques, los dos bloques serán parecidos, contendrán casi las mismas transacciones, pero no serán idénticos, tendrán distinto resumen. En estos casos, unos mineros trabajarán con de uno de los bloques para conformar y minar un nuevo bloque, y otros lo harán con el otro bloque. Detectada esta situación, aunque los dos bloques sean válidos, los mineros confirmarán el bloque que tenga mayor prueba de trabajo, el que tenga mayor resumen. El bloque descartado se denomina bloque huérfano. El bloque huérfano se invalida; el minero que realizó la prueba de trabajo se queda sin recompensa y las transacciones que no estén incluidas en el bloque confirmado quedan a la espera de ser incluidas en un nuevo bloque. De esta forma se evita que una transacción se utilice dos veces, que haya doble gasto, y el resultado es una única versión de la cadena de bloques. Una vez que un minero encuentra el número de un solo uso, lo anuncia inmediatamente a los otros mineros, éstos verifican la prueba de trabajo y las transacciones y deshacen su bloque candidato. La comprobación de que el minado es correcto por parte de los mineros es fácil e inmediata y el bloque junto con todas las transacciones que contiene queda confirmado e incluido en la cadena de bloques.

Como ejemplo volvemos al resumen de los tres párrafos de la introducción de este artículo. Hemos mostrado que es

aedd1bb22c321638f1155e3611bed6e677b73de5c428a9ed956d35f54d47a3e6

Fijamos como target el número

00000000000000000fffffffffffffffffffffffffffffffffffffffffffffff

Este número es el mayor escrito con 64 cifras hexadecimales que tiene 47 cifras significativas (las 17 primeras son 0). La prueba de trabajo, el minado, consiste en añadir al texto del resumen un número de un solo uso para forzar que el resumen sea menor que este número, es decir, que tenga 46 cifras significativas (las 18 primeras 0) o 47 significativas (las 17 primeras 0) seguidas de alguna que no sea la f. Esto solo se puede hacer probando, probando y probando. Como se ha indicado, esto requiere de hardware específico que consume mucha energía. Como hay muchos mineros intentando superar la prueba trabajo y como esto hay que hacerlo prácticamente de forma continua para todos los bloques, el consumo global de energía en el minado es altísimo.

-

Recompensa por minar

Una de las claves de la superveniencia de Bitcoin se debe a que, por cada bloque minado, quien lo consigue en primer lugar recibe una recompensa en nuevos bitcoin. En concreto, todos los bitcoin que se van acuñando son para los mineros que consiguen en primer lugar el minado. También, estos son quienes reciben las comisiones de las transacciones. Está programado que cada 210.000 bloques, unos 4 años a diez minutos por bloque, la emisión de bitcoin se reduzca a la mitad. En consecuencia, la remuneración del minado por bloque también se reduce a la mitad. En los cuatro primeros años, de 2009 a 2012, se pusieron en circulación 10.500.000 bitcoin y por el minado de cada bloque se pagaron 50 bitcoin (210.000×50=10.500.000). A partir de mayo de 2020 y hasta 2024, el pago por minado se ha reducido a 6,250 bitcoin, por lo que en esos cuatro años se acuñarán en total 1.312.500 bitcoin. La producción total de bitcoin está limitada a 21 millones y a este ritmo finalizará en el año 2140. A partir de esa fecha, los mineros solo recibirán por el minado las comisiones de las transacciones. Otra cuestión muy distinta es por cuantos euros o dólares se cambie un bitcoin.

Veamos como ejemplo el bloque número 672431 de fecha 2021-02-27 13:28.

-

Bloque: 672431

-

Resumen:

00000000000000000003120e9aa5b6f1247a730c4b0dfc6716db4b855c978da5

-

Raíz de Merkle:

6b44315f7b2621d8a21554e1dc96178bd935d042e23cb77e75bf4b1f4fd78ff1

-

Número de transacciones: 2096

-

Volumen de la transacción: 1446,34840523 bitcoin

-

Recompensa por minado: 6,250 bitcoin

-

Remuneración por comisiones: 0,41695539 bitcoin

-

Target:

0000000000000000000cf4e30000000000000000000000000000000000000000

-

Nonce: 04e9a917

Es inmediato comprobar que, como números hexadecimales, el resumen es menor que el target.

-

Comentario final

Bitcoin es una moneda totalmente digital, no se sustenta en nada físico, ni en bancos centrales, ni en organizaciones financieras. El propio Bitcoin es quien crea y emite su moneda. Bitcoin opera en una red de ordenadores abierta, descentralizada y distribuida. Esto es, quien quiera se puede integrar en la red Bitcoin, todos los nodos son iguales, no hay jerarquías, y tienen una copia de la gran base de datos de todas las transacciones. Las transacciones se realizan directamente entre origen y destino y son públicas. Su fiabilidad y seguridad reposa en la firma digital. Para almacenar de forma segura los datos, las transacciones se agrupan en bloques que se van encadenando uno detrás de otro, de forma que un bloque contiene el resumen del anterior. Una modificación de una transacción de un bloque requiere modificar su resumen, al estar este resumen incluido en el siguiente bloque, se tendrá que modificar su resumen y así uno a uno el resumen de todos los bloques siguientes, lo cual no es realizable computacionalmente. Además, como la base de datos está replicada en los nodos, habría que cambiar la de todos los nodos. Los bloques los confirman los mineros mediante una prueba de trabajo. El primer minero que supera la prueba de trabajo transmite el bloque al resto de mineros, éstos verifican la validez de las transacciones y de la prueba de trabajo, el bloque queda confirmado e incluido en la base de datos y el minero recibe una recompensa en bitcoin de nueva creación.

La emisión de moneda bitcoin está totalmente regulada, tanto en sus tiempos como en su número y destino, por unas reglas fijas. La emisión es totalmente independiente del valor de los bitcoin, de que haya una mayor o menor demanda de bitcoin y de la coyuntura económica del momento. Ninguno de los bitcoin que se emiten van al mercado, todos se adjudican a los mineros que superan la prueba de trabajo. La retribución en bitcoin por minado también está fijada por el propio sistema. Cada cuatro años la emisión de bitcoin se reduce a la mitad. Como en total se emitirán 21 millones de bitcoin, se alcanzarán los 21 millones en el año 2140. En 2020 ya han sido acuñados alrededor de 18.593.000 bitcoin. Se estima que alrededor de tres o cuatro millones de bitcoin han desaparecido por pérdida de las claves privadas, errores en las direcciones, etc.

Realizar la prueba de trabajo requiere hardware especializado de elevado consumo energético. Como le retribución por minado resulta al cambio alta, hay muchos mineros y pools de mineros que se dedican al minado. Como el minado de los bloques es prácticamente continuo, ya que en cuanto se mina un bloque se comienza a conformar el siguiente, el consumo global de energía por minado es muy elevado, lo cual suscita mucha controversia.

Para terminar, unas observaciones sobre Bitcoin.

Las monedas al uso tienen que cumplir tres funciones: permitir almacenar valor, realizar intercambios y transacciones, y servir como unidad de cuenta. Esto último significa servir de referencia de valor como, por ejemplo, basta con leer el precio en euros de un teléfono móvil para hacerse una idea de su valor. Según estos criterios, no se puede decir que las criptomonedas sean monedas de verdad, ya que no cumplen estas tres propiedades. La que más se cumple es la de almacenamiento de valor. Pero como medio de intercambio no se acepta en demasiados sitios, y debido a su constante cambio de valor, tampoco sirve como referencia. Las criptomonedas no serán monedas de verdad hasta que no se cumplan estas tres propiedades, en particular hasta que no se generalice cambiar bitcoin por, por ejemplo, un coche, un billete de avión o la realización de un trabajo.

Existen en el mercado casas de cambio que permiten cambiar bitcoin por dólares o euros y viceversa. Así, quienquiera puede adquirir bitcoin e ingresar en la red Bitcoin. En sus dos primeros años, 2009 y 2010, el valor del bitcoin era prácticamente cero y el 2-01-2011 valía 5 dólares. En enero de 2015 se cambiaba por alrededor de 300 dólares y desde entonces, con grandes altibajos, no ha dejado de acumular valor. ¿Hasta cuanto podrá alcanzar su valor? ¿Se está ante una burbuja?

Bibliografía

Para un estudio más detallado

Mikel Lezaun. Blockchain. Bitcoin, La Gaceta de la RSME, Vol. 24 (2021), Núm. 3, Págs. 533-558.

Sobre el autor: Mikel Lezaun Iturralde es catedrático de matemáticas aplicadas en el Departamento de Matemáticas de la UPV/EHU

El artículo Introducción a Bitcoin se ha escrito en Cuaderno de Cultura Científica.

Naukas Bilbao 2021: Daniel Torregrosa – La química al servicio del mal

El gran evento de divulgación Naukas regresó a Bilbao para celebrar su décima edición en el magnífico Palacio Euskalduna durante los pasados 23, 24, 25 y 26 de septiembre.

Daniel Torregrosa, famoso popularmente entre otras cosas por su libro del Mito al laboratorio (Ed. Cálamo), se hizo muy conocido en la blogosfera por sus textos sobre venenos. Estaba tardando que diese una charla sobre su historia.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Bilbao 2021: Daniel Torregrosa – La química al servicio del mal se ha escrito en Cuaderno de Cultura Científica.

Observación experimental del fraccionamiento del espín en un material orgánico

Una cadena con siete nanografenos triangulares (triangulenos) depositada en una superficie de oro es sondeada con un microscopio de efecto túnel. Mientras que cada trianguleno tiene espín 1, las correlaciones cuánticas a lo largo de la cadena dan lugar a la emergencia de dos espines ½, representados de color azul y rojo en los bordes de la cadena. (Imagen: EMPA)

Una cadena con siete nanografenos triangulares (triangulenos) depositada en una superficie de oro es sondeada con un microscopio de efecto túnel. Mientras que cada trianguleno tiene espín 1, las correlaciones cuánticas a lo largo de la cadena dan lugar a la emergencia de dos espines ½, representados de color azul y rojo en los bordes de la cadena. (Imagen: EMPA)Nos resulta de sentido común el que unidades sencillas se unan para formar estructuras más complicadas. Así, los átomos se unen para formar moléculas, que a su vez se combinan formando células y estas forman tejidos, dando lugar por último a seres vivos. En el mundo cuántico, este proceso puede ocurrir en dirección contraria, de forma que la interacción entre cosas “complejas” da lugar a cosas más “sencillas”. Así, en ciertas circunstancias, como el efecto Hall cuántico fraccionario, la interacción entre electrones, partículas indivisibles con carga eléctrica e, puede dar lugar a la emergencia de partículas con carga e/3. Este fenómeno se conoce como fraccionamiento.

Todas las partículas elementales poseen propiedades intrínsecas como masa o carga, que nos resultan intuitivas, y otras que nos lo son menos, como el espín, pero que podemos visualizar como una brújula. A diferencia de las brújulas normales, que pueden apuntar en cualquier dirección, el espín de los sistemas cuánticos está cuantizado, valga la redundancia, y únicamente puede tomar un conjunto discreto de valores. Por ejemplo, decimos que el espín del electrón es 1/2 y puede tomar únicamente dos valores, +1/2 y -1/2. Partículas con espín 1 pueden tomar tres valores, +1, 0 y -1.

En los años 80 el físico inglés Duncan Haldane construyó un modelo matemático para partículas de espín 1 en el que se producía el fraccionamiento de los espines. Así, una cadena unidimensional de partículas indivisibles de espín 1, interactuando con sus vecinas, daba lugar a la aparición de partículas de espín 1/2 en los bordes de la cadena. Igual que el truco de magia en el que el mago que corta en dos mitades a una persona y las separa, el modelo de Haldane permite fraccionar espines 1 y separarlos. Se trata de uno de los modelos centrales del magnetismo cuántico, un trabajo que le valió el premio Nobel en 2016.

La verificación experimental de esta predicción era complicada por varios motivos, empezando por el hecho de que no existen materiales unidimensionales. Había evidencia indirecta del fenómeno de fraccionamiento del espín en materiales orgánicos que contienen cadenas de átomos magnéticos, pero faltaba una observación directa. Ahora esa observación se ha llevado a cabo por un equipo internacional de investigadores, entre los que se encuentra el investigador Ikerbasque David Jacob, del Departamento de Polímeros y Materiales Avanzados: Física, Química y Tecnología de la Facultad de Química de la UPV/EHU, que ha colaborado en este trabajo con el INL, la Universidad de Alicante, el EMPA en Zurich y la Universidad de Dresde.

Para conseguirlo los investigadores han combinado técnicas de química orgánica con ciencia de superficies en ultraalto vacío para sintetizar moléculas de grafeno con espín 1 que forman cadenas unidimensionales. Usando un microscopio de efecto túnel los investigadores han podido estudiar los estados cuánticos de la cadena depositada en una superficie de oro, con resolución atómica, compararlos con los predichos por la teoría, y establecer que en efecto el sistema se comporta como el modelo de Haldane. En particular, en cadenas con un número suficientemente alto de moléculas magnéticas, los investigadores encontraron en los extremos de la cadena resonancias Kondo, un fenómeno que ocurre cuando partículas de espín ½ interactúan con los electrones de un conductor como el oro.

Los investigadores afirman que este trabajo “muestra el potencial para usar nanografenos para formar redes bidimensionales de nanoimanes que permitan comprobar predicciones análogas a las de Haldane, como por ejemplo la existencia de estados cuánticos que permitirían realizar la computación cuántica”.

Referencia:

Shantanu Mishra, Gonçalo Catarina, Fupeng Wu, Ricardo Ortiz, David Jacob, Kristjan Eimre, Ji Ma, Carlo A. Pignedoli, Xinliang Feng, Pascal Ruffieux, Joaquín Fernández-Rossier, Roman Fasel (2021) Observation of fractional edge excitations in nanographene spin chains Nature doi: 10.1038/s41586-021-03842-3

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Observación experimental del fraccionamiento del espín en un material orgánico se ha escrito en Cuaderno de Cultura Científica.

Nuestro cerebro no piensa (y el de usted, tampoco)

José Manuel Muñoz y Javier Bernácer

Shutterstock / Mopic

Shutterstock / Mopic

“Los seres humanos solo utilizamos el 10 % de nuestro cerebro”. “El cerebro de los adultos no cambia”. “El cerebro reptiliano es el que gobierna la conducta de los niños”. “Una persona es más inteligente cuantas más neuronas tenga”. ¿Quién de nosotros no ha escuchado estas afirmaciones alguna vez? Y, sin embargo, son falsas.

Se trata de malas interpretaciones acerca del cerebro (“neuromitos”) que calan a menudo en la población a través de ciertas formas de divulgación científica. También llegan incluso al ámbito de la educación. Así lo demuestra un estudio publicado en 2014, en el que se comprobó que los profesores de diversos países, tanto occidentales como orientales, tendían a creer en esta clase de afirmaciones.

La difusión de estas ideas erróneas no es banal, sino que puede llevar a estrategias educativas sin sustento científico y dañinas. Por ejemplo, el enriquecimiento excesivo del entorno de los niños y la obsesión por enseñarles cuantas más cosas mejor antes de los seis años.

Confundir la parte con el todo

Otro error que se presenta con frecuencia en la comunicación de la neurociencia consiste en perpetuar la llamada “falacia mereológica”: adjudicar a la parte (el cerebro) atributos psicológicos que, en realidad, pertenecen al todo (el ser humano en su conjunto).

Mediante una rápida búsqueda en internet podemos toparnos con expresiones como “el cerebro piensa”, “el cerebro recuerda”, “tu cerebro ve”, o hasta “tu cerebro odia”.

Este tipo de expresiones no solo se emplean por parte de los divulgadores científicos, sino también en ámbitos como la enseñanza e, incluso, la ciencia profesional. Sirva como muestra de esto último uno de los objetivos perseguidos por la iniciativa australiana para la investigación del cerebro (Australian Brain Initiative), que sus promotores plantean como “entender y optimizar cómo el cerebro aprende en la infancia”.

Esta falacia mereológica constituye la base conceptual de lo que el filósofo Carlos Moya califica como un nuevo (y paradójico) “dualismo materialista”. Una vez superada la concepción dualista alma-cuerpo (al modo cartesiano), se tiende ahora a pensar en un cerebro independiente o aislado del cuerpo. Este último parece, en cierto modo, prescindible. Esto no se ajusta a la realidad: el cerebro es solo una parte del sistema nervioso, que a su vez es solo una parte del cuerpo. Dicho cuerpo, además, se enmarca en un contexto social (no es un “cerebro en una cubeta”) que afecta decisivamente al desarrollo y la historia vital del individuo.

Ni los pies caminan, ni el cerebro piensa

El lector estará de acuerdo en que sus pies no caminan, sino que es usted quien camina empleando sus pies. De igual forma, no es su cerebro el que piensa, recuerda, odia o ama, sino que es usted quien hace todo esto utilizando su cerebro.

Podría pensarse que la comparación entre cerebro y pies no resulta adecuada, pues el cerebro, a diferencia de aquellos, goza de una gran capacidad de control sobre las demás partes del organismo. Sin embargo, no debe olvidarse que el cerebro depende, a su vez, de otros órganos para su subsistencia y funcionamiento, en especial (aunque no solo) del corazón.

De ningún modo el cerebro es independiente y gobernador del resto del cuerpo, como demuestra la dinámica de su desarrollo: no es hasta la vigesimotercera semana de vida prenatal cuando aparecen las primeras sinapsis en el embrión humano, y no es hasta pasados los veinte años cuando el cerebro termina de desarrollarse por completo. De hecho, el cerebro sigue cambiando hasta el día de nuestra muerte. Sencillamente, sin cuerpo no puede haber cerebro, tanto funcional como cronológicamente.

Hasta cierto punto, resulta comprensible que científicos o divulgadores formados en neurociencia tiendan a transmitir, consciente o inconscientemente, la falacia mereológica. Después de todo, su conocimiento especializado puede conducir a sobredimensionar la importancia de una parte de la realidad.

Por eso, y al igual que se ha normalizado el hecho de que una “ciencia de la parte”, como es la neurociencia, impregne decisivamente la comprensión de las ciencias sociales y las humanidades que estudian al ser humano en su conjunto, debería normalizarse también el camino complementario: que estas “ciencias del todo” contribuyan a un entendimiento más completo (y realista) del sistema nervioso.

Para lograrlo, la neurociencia debería ser más receptiva al estudio y el diálogo genuino con otras disciplinas (psicología, educación, comunicación, derecho, filosofía). La colaboración interdisciplinar podría, así, contribuir a frenar la proliferación de neuromitos y visiones reduccionistas de lo humano que entorpecen incluso el avance de la propia neurociencia. El rigor metodológico no debería asociarse a una falta de rigor argumentativo. Comunicar el cerebro, después de todo, no implica limitarse al cerebro.![]()

Sobre los autores: José Manuel Muñoz es investigador en el Centro Internacional de Neurociencia y Ética (CINET) de la Fundación Tatiana Pérez de Guzmán el Bueno, y en el Grupo Mente-Cerebro, Instituto Cultura y Sociedad (ICS) de la Universidad de Navarra y Javier Bernácer es investigador en el Grupo Mente-Cerebro del ICS.

Este artículo fue publicado originalmente en The Conversation. Artículol original.

El artículo Nuestro cerebro no piensa (y el de usted, tampoco) se ha escrito en Cuaderno de Cultura Científica.

La disección de Dudeney, de rompecabezas matemático a creación artística

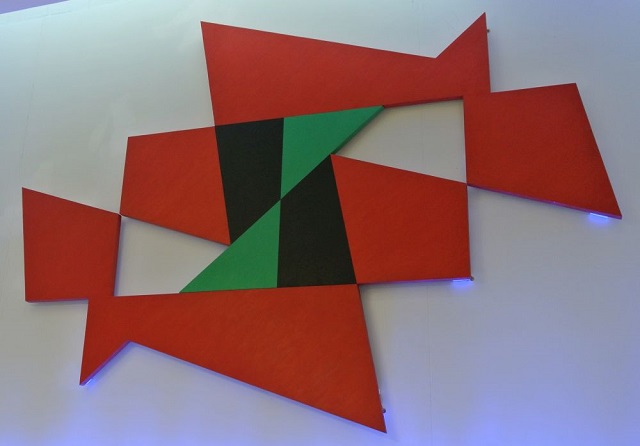

La historia que está detrás de esta entrada del Cuaderno de Cultura Científica empieza cuando hace unos meses descubro la existencia de varias obras de la artista constructivista británica Natalie Dower (1931, Londres) relacionadas con la conocida disección de Dudeney, una disección geométrica de un triángulo equilátero cuyas piezas se pueden reordenar formando un cuadrado, o viceversa.

Red flyer (1989), de la artista británica Natalie Dower, quien toma la disección de Dudeney como herramienta de creación artística. El cuadro pertenece a la colección artística de la Universidad de Warwick

Red flyer (1989), de la artista británica Natalie Dower, quien toma la disección de Dudeney como herramienta de creación artística. El cuadro pertenece a la colección artística de la Universidad de Warwick

De hecho, esta entrada podría tener de subtítulo “Sobre la importancia de la divulgación de las matemáticas”, ya que en una entrevista realizada por el artista Patrick Morrisey a la artista Natalie Dower, para Saturation point, esta ponía de relieve cómo había llegado a la disección de Dudeney a través de un texto del gran divulgador de las matemáticas Martin Gardner (1914-2010):

La exploración es el uso que yo hago de cualquier sistema con el que estoy trabajando. El más importante ha sido la disección de Dudeney, que encontré en “Mathematical Puzzles and Diversions” de Martin Gardner. Se trata de la disección de un cuadrado en cuatro piezas diferentes que, incluso articuladas, pueden ensamblarse formando un triángulo equilátero. Recuerdo dónde estaba y la emoción del momento exacto en que me di cuenta del enorme abanico de posibilidades que ofrecía. Durante la década siguiente, todos los dibujos, relieves, esculturas y pinturas, variando en escala de centímetros a metros, se generaron a partir de esta […].

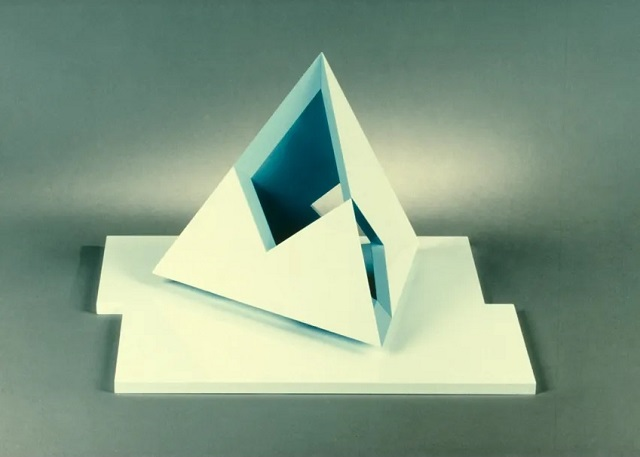

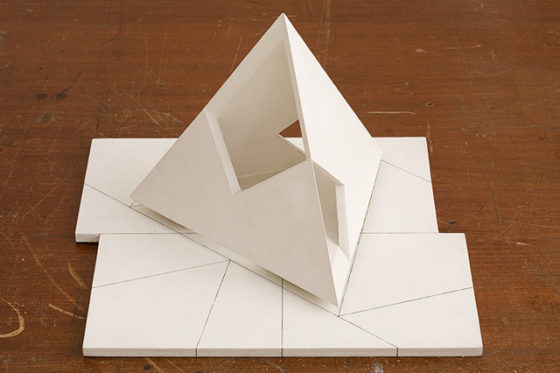

Tetraedro (1985), de la artista británica Natalie Dower, escultura realizada en aluminio y esmalte cocido, cuyo tamaño es 43 x 40,5 x 28 cm. Imagen de la Eagle Gallery EMH Arts

Tetraedro (1985), de la artista británica Natalie Dower, escultura realizada en aluminio y esmalte cocido, cuyo tamaño es 43 x 40,5 x 28 cm. Imagen de la Eagle Gallery EMH Arts

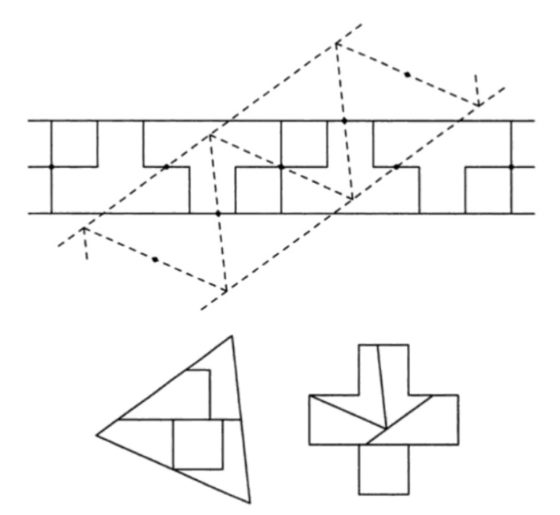

Pero vayamos con la disección de Dudeney. En general, una disección geométrica consiste en cortar una figura geométrica dada, como un triángulo, un cuadrado u otra figura más compleja, en una serie de piezas que reordenadas dan lugar a otra figura geométrica.

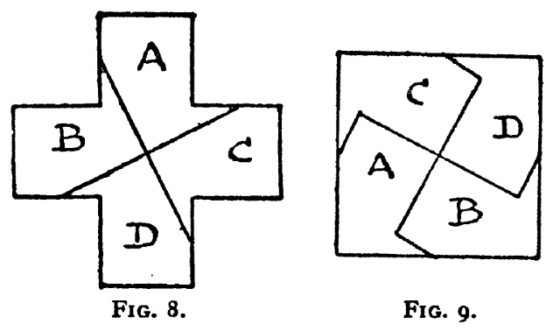

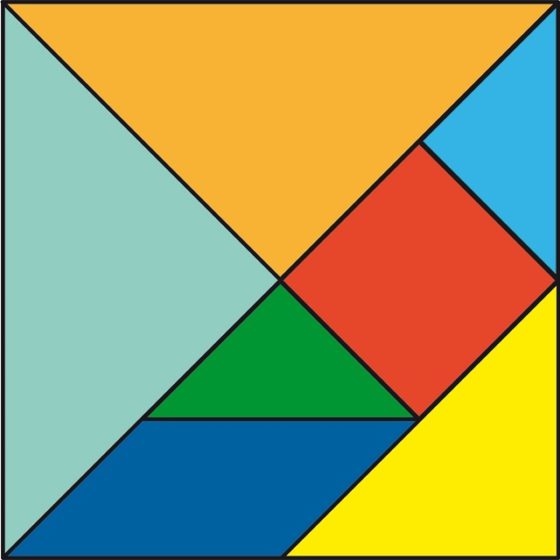

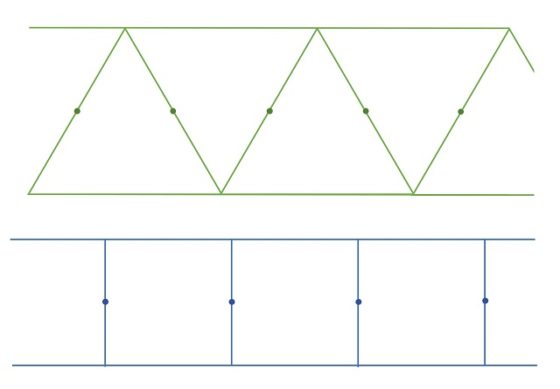

Como ejemplo de disección geométrica podemos mostrar la solución a uno de los problemas que el matemático recreativo británico Henry E. Dudeney (1857-1930) comenta en su libro Amusements in mathematics (1917). El problema consiste en saber cómo dividir un cuadrado en cuatro partes para generar una cruz griega, es decir, una cruz con los cuatro brazos iguales. Las soluciones mostradas en el libro, que podían realizarse con dos cortes, eran:

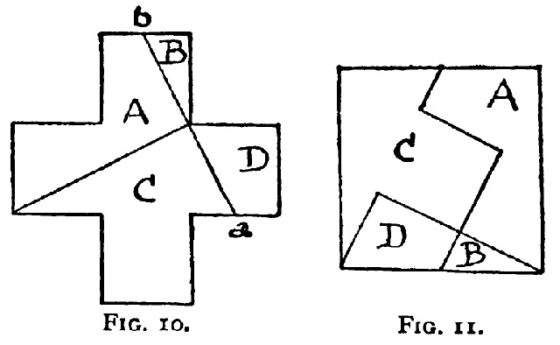

Estas disecciones geométricas, como muchas otras, son utilizadas a menudo como rompecabezas geométricos. El rompecabezas consistiría en las cuatro piezas –las cuatro iguales en el primer caso o todas distintas en el segundo– para construir con ellas tanto el cuadrado como la cruz griega. De hecho, este es uno de los cuatro rompecabezas que utilizamos en la Real Sociedad Matemática Española para darle publicidad a la página DivulgaMAT y que se muestran a continuación.

Pero hay muchos rompecabezas geométricos relacionados, de diferentes formas, con las disecciones, como los clásicos Tangram (véanse las entradas Tangram, El arte contemporáneo que mira al Tangram y Un teorema sobre el Tangram) y Stomachion (véanse las entradas El puzle Stomachion y el palimpsesto de Arquímedes (1) y El puzle Stomachion y el palimpsesto de Arquímedes (2)).

Las siete piezas del Tangram formando la figura básica del cuadrado

Las siete piezas del Tangram formando la figura básica del cuadrado

Las disecciones geométricas tienen una historia muy larga y rica, ya que nos las podemos encontrar hace dos milenios en la matemática griega o hace mil años en la matemática árabe. Dentro de la matemática recreativa tiene una historia más reciente. En la revisión del libro Récréations mathématiques et physiques (1694) del matemático francés Jacques Ozanam que realiza Jean Montucla (1778), ya aparecen problemas con disecciones geométricas. También se incluyen disecciones geométricas en el libro Rational Amusement for Winter Evenings (1821), del matemático John Jackson.

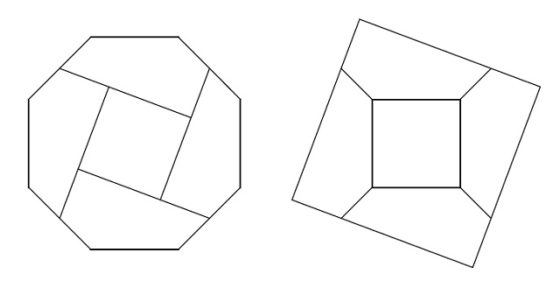

Disección de un octógono en un cuadrado que aparece en el manuscrito persa Compendio de figuras entrelazadas similares y complementarias (escrito entre los siglos XIII-XV), redescubierto, según Henry Dudeney, por el matemático británico Geoffrey Th. Bennett (1868-1943)

Disección de un octógono en un cuadrado que aparece en el manuscrito persa Compendio de figuras entrelazadas similares y complementarias (escrito entre los siglos XIII-XV), redescubierto, según Henry Dudeney, por el matemático británico Geoffrey Th. Bennett (1868-1943)

El problema de las disecciones geométricas cautivó a la comunidad matemática en el siglo XIX. Entre otras cuestiones estudiadas, varios matemáticos demostraron, de forma independiente, que para cualesquiera dos polígonos simples (es decir, cuyos lados no contiguos no se intersecan) con la misma área, se puede cortar cualquiera de ellos en una cantidad finita de piezas que reordenadas nos permiten obtener el otro. Fueron el matemático británico John Lowry (1769-1850) en 1814, el matemático británico William Wallace (1768-1843) en 1831 (según Greg Frederickson, aunque según Ian Stewart fue en 1807), el matemático húngaro Farkas Bolyai (1775-1856), padre de uno de los protagonistas del nacimiento de las geometrías no euclídeas, Janos Bolyai (1802-1860), en 1832, y el matemático alemán Paul Gerwien (1799-1858) en 1833. La idea de la prueba es cortar cada polígono simple en triángulos y luego estos en piezas de forma que con las mismas se pueda generar un cuadrado, después superponiendo las dos disecciones sobre el cuadrado se obtienen las nuevas piezas que nos dan la disección geométrica entre los dos polígonos simples.

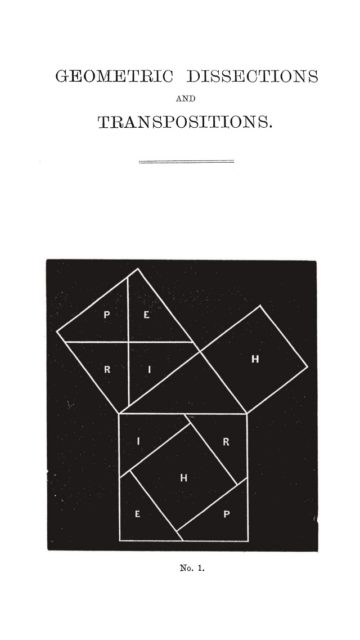

El resultado anterior nos asegura la existencia de una disección entre dos polígonos simples con la misma área, sin embargo, el método genera una disección compleja (podríamos decir fea) con muchísimas piezas. Por otra parte, desde la matemática recreativa se preocuparon de disecciones más atractivas y con pocas piezas. Entre los autores que estudiaron las disecciones geométricas encontramos al matemático francés Edouard Lucas (1842-1891), autor del texto Recreaciones matemáticas (1894), al corredor de bolsa y matemático amateur británico Henry Perigal (1801-1898), conocido por su demostración del teorema de Pitágoras mediante disecciones que aparece en su texto Geometric Dissections and Transpositions (1891), el matemático y abogado británico Henry M. Taylor (1842-1927) o el matemático e ingeniero británico William H. Macaulay (1853-1936).

Página 1 del texto Geometric Dissections and Transpositions (1891), de Henry Perigal, con la demostración del teorema de Pitágoras por medio de una disección geométrica

Página 1 del texto Geometric Dissections and Transpositions (1891), de Henry Perigal, con la demostración del teorema de Pitágoras por medio de una disección geométrica

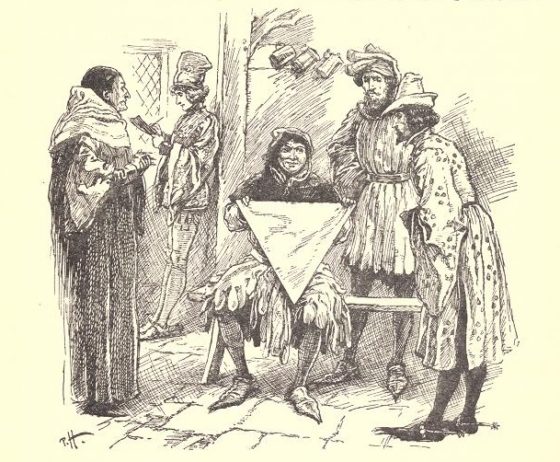

Aunque debemos destacar a dos de los más grandes creadores de juegos lógicos y rompecabezas matemáticos, el matemático británico Henry E. Dudeney y el matemático recreativo y ajedrecista estadounidense Sam Loyd (1841-1911). Estos dos matemáticos, que colaboraron por correspondencia durante algún tiempo hasta que el inglés acusó al norteamericano de robarle sus rompecabezas y publicarlos con su nombre, se preocuparon de encontrar disecciones geométricas con el menor número de piezas posibles. Pueden encontrarse sus rompecabezas y problemas matemáticos relacionados con las disecciones en sus libros, entre ellos, Cyclopedia of 5000 Puzzles, Tricks and Conundrums with Answers (1914), de Sam Loyd, The Canterbury Puzzles (1907) y Amusements in Mathematics (1917), de Henry E. Dudeney.

La conocida como disección de Dudeney, de un triángulo equilátero en un cuadrado, aparece como “el acertijo del mercero” en el libro de Henry E. Dudeney The Canterbury Puzzles.

El acertijo del mercero: […] Enseñó [el mercero] un trozo de tela con forma de triángulo equilátero perfecto, como se ve en la ilustración y dijo: “¿Es alguno de vosotros diestro en el corte de género? Estimo que no. Cada hombre a su oficio, y el estudioso puede aprender del lacayo, y el sabio del necio. Mostradme, pues, si podéis, de qué manera puede cortarse este trozo de género en cuatro piezas, para que puedan reunirse y formar un cuadrado perfecto”.

La solución al acertijo del mercero que incluye Dudeney en su libro The Canterbury Puzzles es la que aparece en la siguiente imagen.

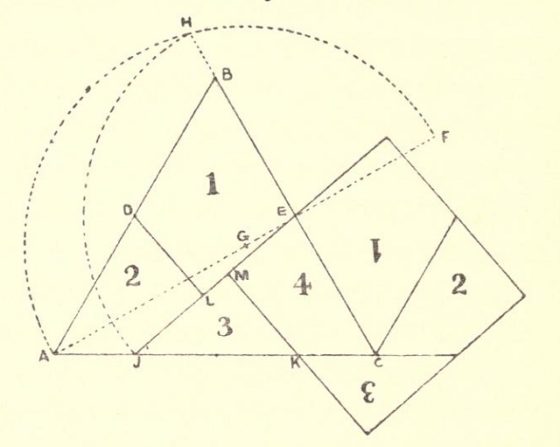

Dado el triángulo ABC la construcción que propone Dudeney, mostrada en la anterior imagen, es la siguiente:

a. marcar los puntos medios D y E de los lados AB y BC, respectivamente;

b. extender el segmento AE hasta un punto F tal que EF = EB;

c. marcar el punto medio G del segmento AF y trazar el arco de circunferencia de centro G y radio GF = AG;

d. extender el segmento CB hasta que corte el arco de circunferencia en el punto H;

e. trazar un arco de circunferencia con centro E y radio EH hasta que corte el lado AC en el punto J;

f. determinar el punto K tal que JK = AD (= DB = BE = EC);

g. trazar el segmento JE;

h. trazar desde D y K los segmentos perpendiculares al segmento JE, dando lugar a los puntos L y M (los segmentos serían DL y KM).

El problema del mercero fue propuesto por primera vez por Dudeney en 1902 en el periódico británico Weekly Dispatch. Dos semanas después de publicarse el acertijo el matemático realizó una pequeña discusión sobre el problema y finalmente, otras dos semanas después, Dudeney publicó la solución y la explicación.

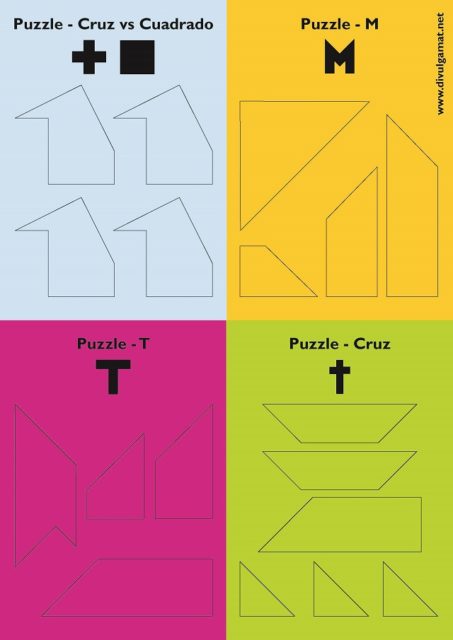

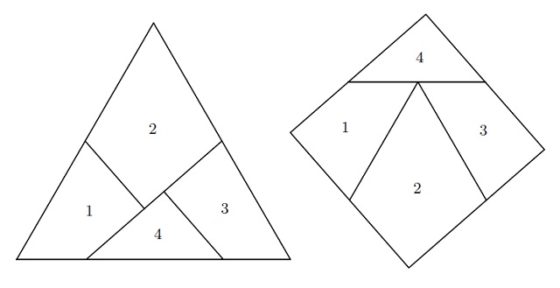

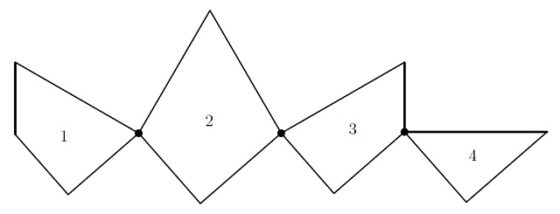

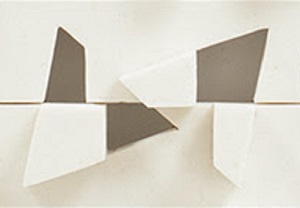

Pero la disección de Dudeney del triángulo equilátero en el cuadrado tiene una propiedad muy especial –es lo que se conoce como una disección con bisagras, pero incluso estas direcciones han tomado el nombre de disecciones de Dudeney–, ya que todas las piezas pueden conectarse a través de una serie de puntos “bisagra” que permiten transformar una figura en la otra (en este caso el triángulo en el cuadrado, o viceversa) girando las piezas alrededor de las bisagras. En el caso de la disección de Dudeney se pueden colocar tres bisagras en los puntos D, E y K de la imagen anterior, aunque esos puntos no son únicos, también podrían ponerse las bisagras en los puntos J, K y E.

Piezas con bisagras que permiten transformar el triángulo equilátero en el cuadrado, o viceversa, de forma cinética

Piezas con bisagras que permiten transformar el triángulo equilátero en el cuadrado, o viceversa, de forma cinética

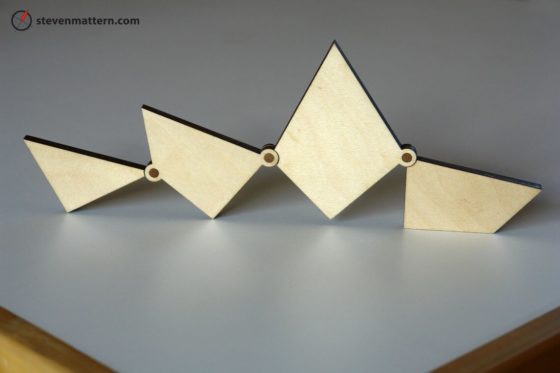

Utilizando la anterior propiedad se puede construir un juguete cinético como el siguiente.

Juguete de geometría de cuadrado a triángulo – Disección de Dudney, construido por Steven Mattern Design y vendido en etsy.com

Juguete de geometría de cuadrado a triángulo – Disección de Dudney, construido por Steven Mattern Design y vendido en etsy.com

Más aún, se podría diseñar una mesa que en algunas ocasiones se puede utilizar con forma cuadrada y en otras con forma triangular, como aparece en el siguiente diseño de Mackenzie Kovaka (véase su página web Mackenzie Kovaka).

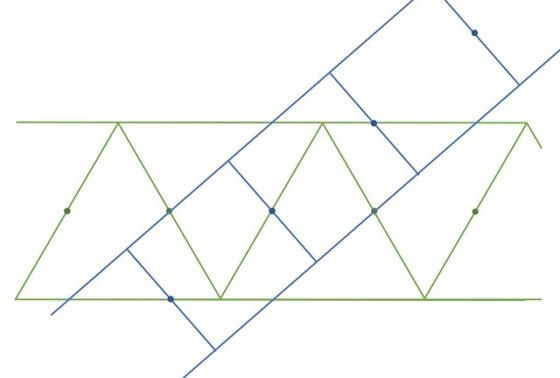

La disección de Dudeney del triángulo equilátero en el cuadrado, al igual que otras disecciones con bisagras, puede obtenerse con el “método de la tira en T” introducido por el ingeniero y matemático aficionado británico-australiano Harry Lindgren (1912-1992) en su libro Geometric Dissections (1964). Expliquemos en qué consiste este método geométrico (véase Recreational Problems in Geometric Dissections and How to Solve Them de Lindgren o Dissections: Plane & Fancy de Frederikson).

El método para obtener la disección del triángulo equilátero y el cuadrado empieza construyendo dos tiras, una de cuadrados y otra de triángulos (ambas figuras con la misma área) y luego marcando los puntos de ancla de las dos tiras, es decir, aquellos puntos tales que si se hace una rotación de 180 grados alrededor de ellos se obtiene de nuevo la tira inicial (es decir, los puntos ancla son los centros de las simetrías rotacionales, de 180 grados, de las tiras).

El siguiente paso es cruzar las dos tiras de manera que los puntos ancla de una tira estén sobre los bordes o los puntos ancla de la otra tira, como se puede observar en la siguiente imagen para el caso que estamos analizando.

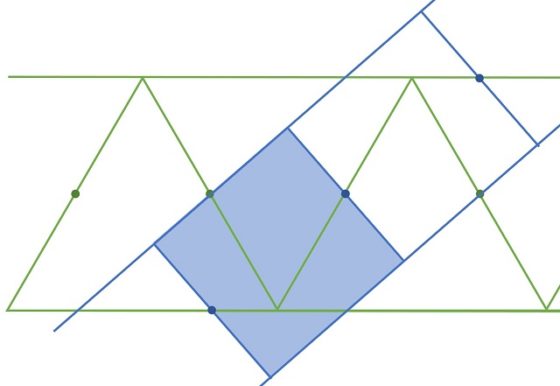

Y se obtiene así la disección con bisagras (que están en los puntos ancla) del triángulo equilátero en el cuadrado, o viceversa.

El método de la tira en T nos permite obtener más ejemplos, como se muestra, por ejemplo, en los libros Recreational Problems in Geometric Dissections and How to Solve Them de H. Lindgren o Dissections: Plane & Fancy de Frederikson. En la siguiente imagen, del segundo de los libros, tenemos una disección geométrica de un triángulo en una cruz griega, que no es de Dudeney, es decir, no pueden unirse las piezas con bisagras.

En relación a las disecciones geométricas con bisagras también se planteó el problema de la existencia, es decir, el problema de si dadas dos figuras geométricas cualesquiera con la misma área y cuyos bordes son polígonos simples, siempre era posible encontrar una disección con bisagras entre ellas. La respuesta llegó en 2008 de la mano de los matemáticos Timothy G. Abbott, Zachary Abel, David Charlton, Erik D. Demaine, Martin L. Demaine y Scott D. Kominers, que publicaron (en 2012) su resultado en el artículo Hinged Dissections Exist.

Pero finalicemos esta entrada del Cuaderno de Cultura Científica volviendo a la artista constructivista británica Natalie Dower y a algunos ejemplos más que ponen de manifiesto su profundo interés en este resultado matemático y en su uso como herramienta de creación artística.

Empecemos con una versión en madera de la anterior escultura Tetraedro (1985), en cuya base se puede apreciar la disección de Dudeney que da lugar a las dos esculturas.

Tetraedro de Dudeney – Área 3 (1985), de Natalie Dower. Madera pintada al óleo, de tamaño 33,5 x 36,8 x 24 cm. Imagen de la página de Natalie Dower

Tetraedro de Dudeney – Área 3 (1985), de Natalie Dower. Madera pintada al óleo, de tamaño 33,5 x 36,8 x 24 cm. Imagen de la página de Natalie Dower

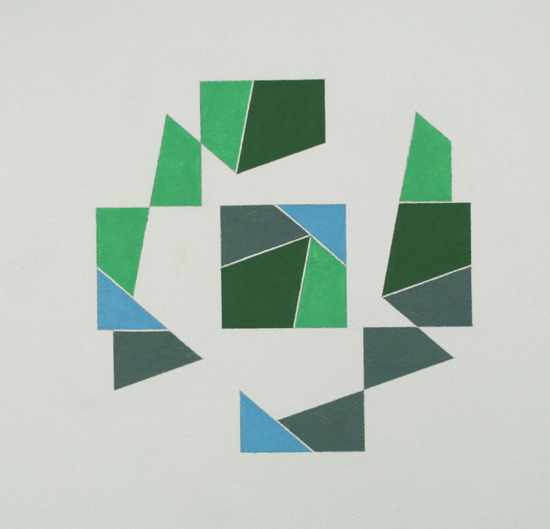

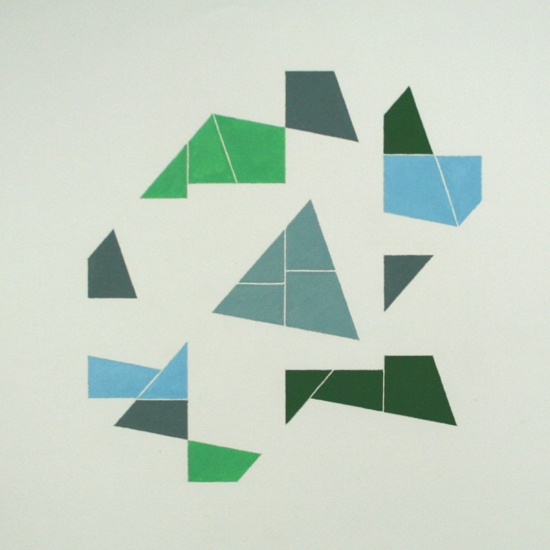

A continuación, mostramos dos pasteles al óleo de Dower cuyo motivo central es el cuadrado, respectivamente el triángulo, con la disección de Dudeney, mientras que alrededor hay una composición con las piezas de la misma, que son sus herramientas en toda esta serie de obras constructivistas.

Dudeney Stencil n. 1 / Plantilla de Dudeney no. 1 (1987), de Natalie Dower. Pastel al óleo de tamaño 58 x 48 cm. Imagen de la página de Natalie Dower

Dudeney Stencil n. 1 / Plantilla de Dudeney no. 1 (1987), de Natalie Dower. Pastel al óleo de tamaño 58 x 48 cm. Imagen de la página de Natalie Dower Dudeney Stencil n. 2 / Plantilla de Dudeney no. 2 (1987), de Natalie Dower. Pastel al óleo de tamaño 58 x 48 cm. Imagen de la página de Natalie Dower

Dudeney Stencil n. 2 / Plantilla de Dudeney no. 2 (1987), de Natalie Dower. Pastel al óleo de tamaño 58 x 48 cm. Imagen de la página de Natalie Dower

La siguiente obra, Círculo de Dudeney (1989), está creada a partir de las piezas de la disección de Dudeney. En la parte central de la misma pueden verse dos copias, complementarias, del triángulo diseccionado.

Dudeney’s circle / círculo de Dudeney (1989), de Natalie Dower. Imagen de la Eagle Gallery EMH Arts

Dudeney’s circle / círculo de Dudeney (1989), de Natalie Dower. Imagen de la Eagle Gallery EMH Arts

Detalle de la obra Dudeney’s circle (1989), de Natalie Dower

Detalle de la obra Dudeney’s circle (1989), de Natalie Dower

Terminamos con otra obra donde se intuye, por su título Dudeney codificado (1987), que su diseño está inspirado también en la disección de Dudeney.

Dudeney encoded / Dudeney codificado (1987). De Natalie Dower. Imagen de Saturation point

Dudeney encoded / Dudeney codificado (1987). De Natalie Dower. Imagen de Saturation point

Bibliografía

1. Greg N. Frederickson, Dissections: Plane & Fancy, Cambridge University Press, 1997.

2. Ian Stewart, From Here To Infinity, Oxford University Press, 1996.

3. Greg N. Frederickson, Ernest Irving Freese’s Geometric transformations: the man, the manuscript, the magnificent dissections!, World Scientific, 2018.

4. Harry Lindgren, Recreational Problems in Geometric Dissections and How to Solve Them, Dover, 1972 (versión revisada por Greg Frederickson del libro Geometric Dissections de 1964).

5. Timothy G. Abbott, Zachary Abel, David Charlton, Erik D. Demaine, Martin L. Demaine, and Scott D. Kominers, Hinged Dissections Exist, Discrete & Computational Geometry volume 47, pp. 150–186, 2012.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo La disección de Dudeney, de rompecabezas matemático a creación artística se ha escrito en Cuaderno de Cultura Científica.

Tres modelos atómicos de los que no has oído hablar

En 2013 se cumplió el centenario del modelo atómico de Bohr. Es el que todavía hoy, a pesar de ser incompatible con principios básicos de la física cuántica, como el de incertidumbre, se sigue explicando para introducir a los estudiantes en el mundo cuántico. Curiosamente, en los libros de texto tan sólo se mencionan dos modelos atómicos anteriores al de Bohr: el de Thomson y el de Rutherford. Parece como si los átmos modernos apareciesen con Dalton en 1804 y lo siguiente fuese el modelo de Thomson.

Leyendo la descripción habitual, a saber,

modelo de Dalton => descubrimiento del electrón => modelo de Thomson => experimentos de Geiger y Marsden => modelo de Rutherford => física cuántica v 1.0 => modelo de Bohr

a uno le queda la sensación de que el desarrollo del modelo de Bohr es algo lineal y que todo se deduce de lo anterior de manera lógica, sólo con esperar el experimento crucial o la idea genial adecuada. Y esto no es así. Para ilustrarlo vamos a conocer solo tres de los modelos atómicos clásicos sugeridos antes del modelo de Bohr.

Cada uno tiene su lógica y su fundamento; todos o bien pasaron desapercibidos o tuvieron vidas breves, habida cuenta de la rapidez con la que descubrían nuevas leyes y se realizaban más experimentos.

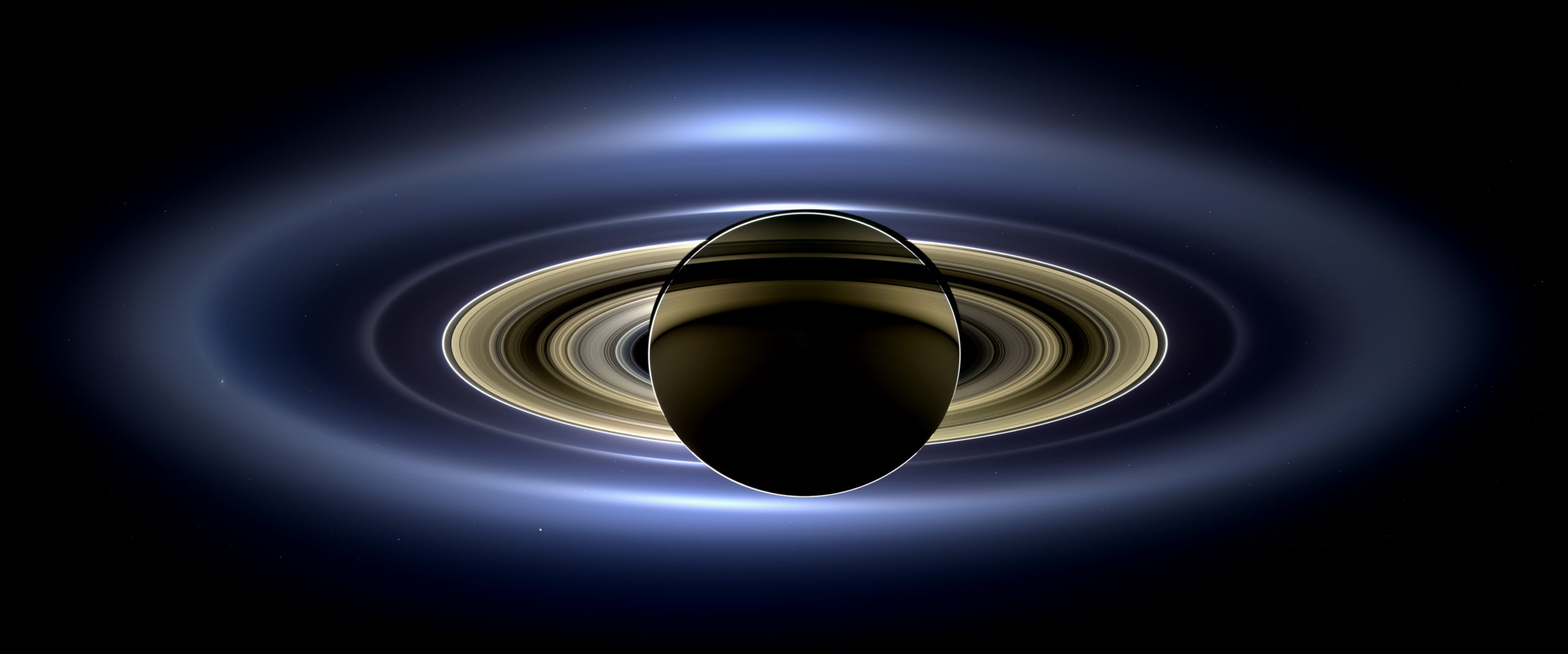

Imagen: NASA / JPL-Caltech / Space Science Institute

Imagen: NASA / JPL-Caltech / Space Science InstituteLas mónadas físicas de Lomonósov

Empecemos por el principio. Se suele recoger en los libros de texto que la teoría atómica moderna empieza con John Dalton. Y a efectos prácticos, efectivamente es así, porque fueron sus ideas las que se propagaron por la comunidad científica y fructificaron casi 80 años después de haber sido formuladas, eso sí. Pero la primera teoría atómica moderna no se formuló ni en Inglaterra ni en Francia, sino en Rusia 60 años antes de que lo hiciese Dalton.

Su autor fue Fue Mijail Vasílievich Lomonósov quien escribió una serie de artículos entre 1743 y 1744, el primero de los cuales deja claro su visión atomista de la materia ya en el título: “Sobre las partículas físicas intangibles que constituyen las sustancias naturales”. A este artículo le seguiría otro sobre lo que hoy entendemos como enlace químico “Sobre la adhesión de los corpúsculos”. En el tercero de la serie, ante la necesidad de referirse a las partículas o corpúsculos de materia de una manera diferenciada, aparece el nombre elegido: “Sobre la adhesión y la posición de las mónadas físicas”. Lomonósov obviamente había leído a Leibniz, y le tomó prestada la palabra mónada con el apellido física para diferenciarla.

Las mónadas de Lomonósov tenían forma, peso y volumen y las empleó para explicar la naturaleza del calor y la elasticidad de los gases en función del movimiento de partículas, anticipando la teoría cinética de los gases de Krönig de 1856 en ciento once años, y descartando la existencia del flogisto 30 años antes que Lavoisier. Nadie le hizo caso en Occidente (salvo Euler).

El oscilador electrónico de Lorentz