Rocas no sedimentarias en la base de un paleolago marciano

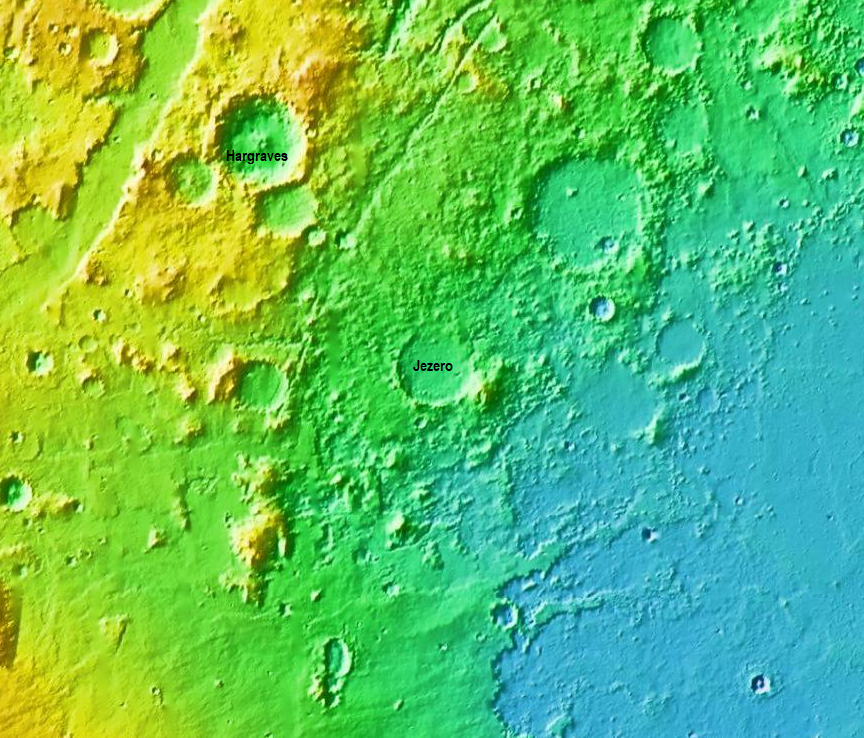

Cráter Jezero. Imagen: USGS / Wikimedia Commons

Cráter Jezero. Imagen: USGS / Wikimedia CommonsCasi 300 días después de la llegada a Marte del rover Perseverance, el equipo multidisciplinar de investigación de la misión Mars2020, al que pertenece el grupo de Excelencia IBeA (Ikerkuntza eta Berrikuntza Analitikoa), del Departamento de Química Analítica de la UPV/EHU, ha comenzado a despejar algunas de las incógnitas sobre la composición de la base del cráter Jezero gracias a los datos enviados por el vehículo.

Como se recordará, el 30 de Julio de 2020 la NASA lanzó la misión Mars2020 con destino al planeta Marte, cuyo objetivo era enviar el rover Perseverance al cráter Jezero, con el fin de iniciar la exploración de terrenos que podrían albergar restos de moléculas orgánicas relacionadas con el metabolismo de microorganismos. El vehículo amartizó con éxito el 18 de febrero de 2021 y, tras los primeros días de comprobación de los distintos elementos del rover, así como del correcto funcionamiento de los distintos instrumentos, a mediados de abril se iniciaron los días de trabajo dedicados a la investigación científica.

“Los datos obtenidos por el instrumento SuperCam desde su amartizaje son muy abundantes y de gran interés”, señala Juan Manuel Madariaga, investigador principal del Grupo IBeA. La información enviada por el rover Perseverance ha sorprendido al Equipo de Ciencia de SuperCam, compuesto por más de 100 científicos de USA, Francia, Canada, España, Alemania y Dinamarca y que está trabajando sobre los datos que reciben cada día, para hacer un diagnóstico preliminar de las muestras analizadas, así como sobre los datos históricos agrupados por tipología de muestras (rocas, pátinas o costras, suelos, etc.) y emplazamientos que el rover visita durante su trayecto hacia las paredes del cráter Jezero, donde se llegará a mediados del año 2023 y donde finalizará la misión nominal de Mars2020.

SuperCam es un instrumento que combina varias técnicas espectroscópicas: espectroscopia LIBS para la detección y cuantificación de elementos químicos (hay más de 44.000 datos sobre 1450 puntos de análisis situados en rocas, suelos y costras) en muestras situadas entre 1,5 y 8 metros de distancia; espectroscopia Visible-Infrarroja (VISIR) para la detección de enlaces químicos entre elementos, tanto en muestras cercanas al rover como en muestras a más de 100 metros (hay más de 1500 espectros VISIR tomados sobre más de 250 muestras); espectroscopia Raman para la identificación de fases minerales (se han tomado más de 100 espectros en un número seleccionado de esas muestras); finalmente Imagen Optica de Alta Resolución para situar el contexto donde se hacen las medidas espectroscópicas.

Rocas no sedimentarias en la base de un paleolago de 3300 millones de años de antigüedad

En estos primeros meses de la misión el equipo de investigación de SuperCam ha analizado muestras de la base del cráter, un terreno plano que contiene diferentes tipos de rocas enterradas en el suelo/sedimento que quedó tras la desecación del agua que llenó el cráter, a modo de lago de unos 50 km de diámetro. Es decir, se han estado analizando restos de la base de un paleolago de entre 3300 a 3000 millones de años de antigüedad.

Según se desprende de los datos enviados por el Perseverance, en la base del paleolago no existen estructuras sedimentarias, sino que las rocas dispersas han sido transportadas hasta su actual emplazamiento no por corrientes acuosas sino por fenómenos de transporte de lava procedente de diferentes erupciones volcánicas, que han sufrido posteriores procesos de erosión. Hasta la fecha se han identificado tres tipos de rocas volcánicas, unas con abundancia de feldespatos (alrededor del 50%) seguidos de piroxenos y ausencia de olivinos (tres familias de minerales de las rocas volcánicas), otra con más piroxenos que feldespatos y un poco de olivino, y el tercer grupo de rocas volcánicas con abundancia similar de olivinos y piroxenos y menor cantidad de feldespatos. Para todos los casos, alrededor de un 5% de las fases minerales son óxidos de hierro y titanio.

Casi todas las fases minerales detectadas en las muestras analizadas han dado señales positivas de la existencia de agua y/o hidroxilos en las mismas, lo que indica la existencia de eventos de alteración promovidos por la presencia de agua en contacto con los materiales geológicos. Sin embargo, estos procesos de alteración de las rocas volcánicas no han llegado hasta la formación de arcillas, tal como se conocen en la Tierra, sino que se han parado en estados previos de alteración. Y este descubrimiento no esperado va a impulsar un conjunto de estudios de laboratorio para entender cómo se pudo pasar de las fases minerales originales, tras eventos de volcanismo, a las primeras fases de alteración detectadas sin que se lleguen a formar filosilicatos (los minerales que componen las arcillas).

Por otro lado, el grupo de Ciencia de SuperCam ha descubierto la presencia de sales precipitadas en el interior de las rocas analizadas. Estas observaciones se han realizado tras taladrar la superficie de las rocas donde se han tomado muestras que almacena el rover para que puedan ser traídas a la Tierra en la futura Misión de Retorno de Muestras de Marte. Estas sales contienen al menos sulfatos de calcio y magnesio, perclorato de sodio y fosfatos de calcio, no descartándose la presencia de otros sulfatos, percloratos y fosfatos, ni tampoco cloruros de sodio y potasio.

El tercer descubrimiento importante en los suelos de la base del paleolago es que no son como los suelos investigados en otros lugares de Marte, sino que están compactados por sales que han precipitado en su superficie, uniendo los distintos granos de los compuestos silicatados que forman los suelos habituales de Marte. De nuevo, entender cómo se han podido formar las costras en la superficie de los suelos va a requerir un conjunto de ensayos de laboratorio que se deberán realizar en el corto-medio plazo.

El grupo de investigación IBeA de la UPV/EHU participará, así mismo, en estos futuros ensayos de laboratorio, así como en la interpretación de los distintos datos espectroscópicos, ya que la misión le ha encomendado liderar los estudios que puedan conducir a explicar la formación de los distintos percloratos en el interior de las rocas volcánicas y en los suelos endurecidos con costras de sales.

El Centro de Investigación Martina Casiano de la UPV/EHU, alberga el nuevo Centro de Operaciones de Marte

Leioa 22-12-2021 El grupo de investigación IBeA participa en la recogida de datos de la misión espacial ‘Mars 2020’ desde el edificio Martina Casiano en el Parque científico de la Universidad del País Vasco. Foto: Fernando Gómez / UPV/EHU

Leioa 22-12-2021 El grupo de investigación IBeA participa en la recogida de datos de la misión espacial ‘Mars 2020’ desde el edificio Martina Casiano en el Parque científico de la Universidad del País Vasco. Foto: Fernando Gómez / UPV/EHUMiembros del Grupo de Excelencia IBeA (kerkuntza eta Berrikuntza Analitikoa), del Departamento de Química Analítica de la UPV/EHU, pertenecen al Grupo de Ciencia del Instrumento SuperCam y de la propia misión Mars2020. Desde el momento del amartizaje hasta hoy día, IBeA ha participado en Operaciones del Instrumento, tanto en la fase de bajada de datos desde el rover como en la fase de subida de órdenes de trabajo para la siguiente tanda de análisis. Inicialmente, estas operaciones se realizaron en el Centro de Operaciones de Toulouse (Francia), donde se construyeron partes del instrumento SuperCam, pero a partir de mediados de junio las tareas de operaciones se realizan en el Centro de Operaciones de Marte, instalado en la Plataforma Tecnológica Martina Casiano del Parque Científico del Campus de Bizkaia (UPV/EHU). La dedicación de cada miembro de IBeA a las operaciones del instrumento SuperCam han sido de unas dos jornadas al mes, jornadas que empiezan a media tarde y acaban en la madrugada del día siguiente.

Este Centro de Operaciones de Marte de la UPV/EHU tiene tres salas, una para la gestión de las operaciones de bajada de datos desde el rover, otra para las operaciones de subida de órdenes de trabajo, y una tercera para la difusión de imágenes, videos y resultados de las labores de investigación que realizan los miembros de IBeA a la sociedad. El miércoles 22 de diciembre coincidió que miembros de IBeA tenían asignada la responsabilidad de la gestión de recepción de datos de los análisis realizados por SuperCam el día anterior, así como la responsabilidad de enviar las órdenes de trabajo de los siguientes tres días (del 23 al 25 de diciembre) al rover Perseverance. Los trabajos empezaron a las 17.45 del miércoles y finalizaron alrededor de la 1 de la madrugada del jueves 23.

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Rocas no sedimentarias en la base de un paleolago marciano se ha escrito en Cuaderno de Cultura Científica.

Oh, blancos acantilados

Acantilados blancos de Dover. Foto: Immanuel Giel / Wikimedia Commons.

Acantilados blancos de Dover. Foto: Immanuel Giel / Wikimedia Commons.En muchas escenas de famosas películas y series de televisión hemos visto a los protagonistas cruzando el Canal de la Mancha enmarcados en una bucólica y típica estampa inglesa, los acantilados blancos de Dover. Pero, ¿por qué son blancos?

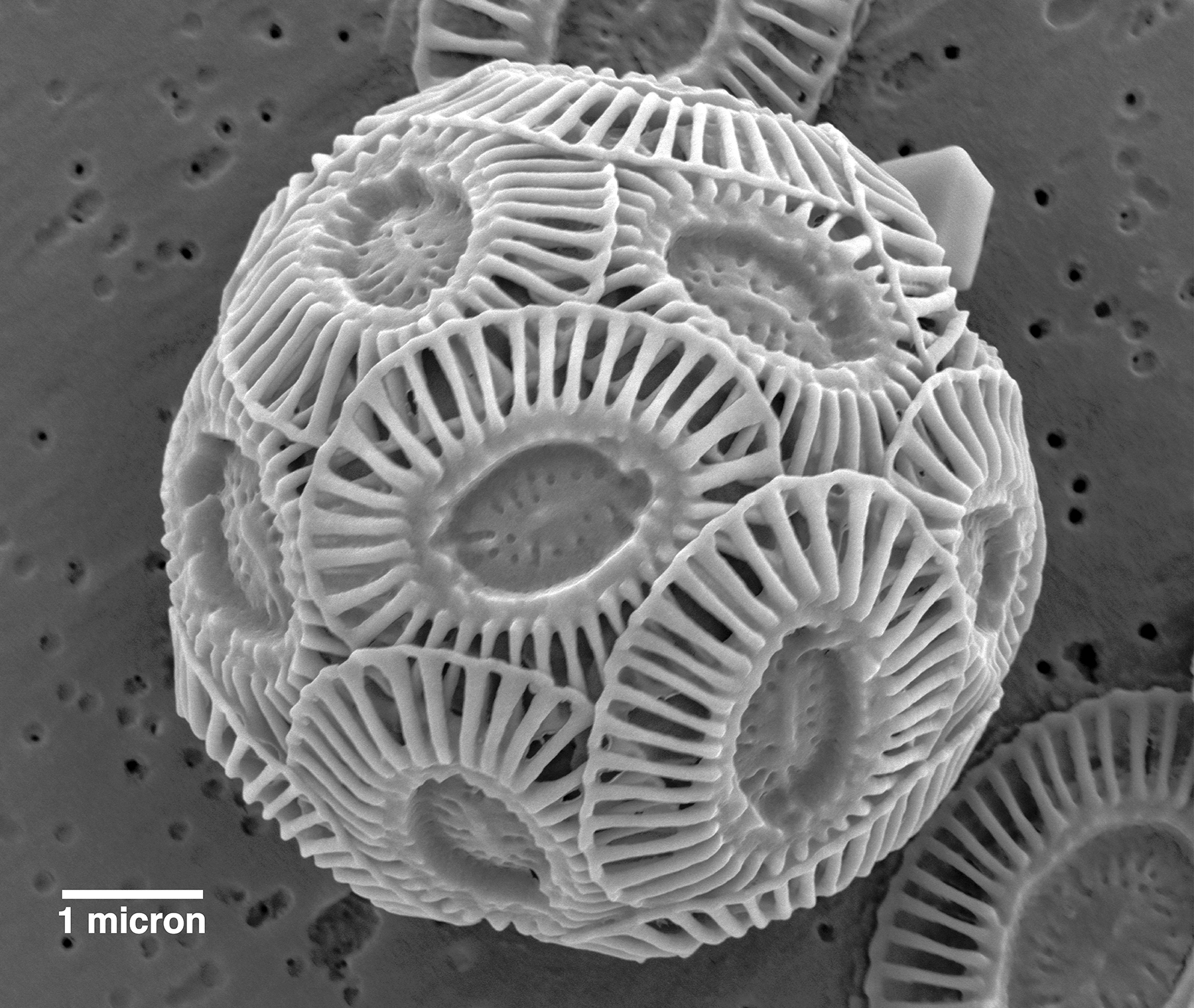

La respuesta a esta pregunta debemos buscarla en el origen de estos materiales. Las rocas que afloran en el litoral de Dover y otras zonas del sureste inglés, como las costas de Sussex, están formadas por los restos de los caparazones de unos microorganismos llamados cocolitofóridos. Los cocolitofóridos son unas algas unicelulares que viven en el agua marina formando parte del fitoplancton, cuya principal característica es que están recubiertas por un caparazón construido de carbonato cálcico (CaCO3) y compuesto por una serie de placas con forma de pequeños discos que se van ensamblando unas con otras hasta generar una especie de envoltura esférica que protege la célula del organismo. Cuando este muere, las placas del caparazón generalmente se separan y acaban acumulándose en el fondo oceánico. Y, puesto que son capaces de vivir en ambientes marinos profundos, es frecuente que en ese fondo encontremos el depósito de un barro carbonatado muy puro procedente casi exclusivamente de la acumulación de las partes de los caparazones de los cocolitofóridos.

Fotografía de microscopio electrónico de barrido de un cocolitofórido. La barra de escala representa 0,001 mm. Imagen de Ina Benner / EUMETSAT

Fotografía de microscopio electrónico de barrido de un cocolitofórido. La barra de escala representa 0,001 mm. Imagen de Ina Benner / EUMETSATCon el paso del tiempo geológico y el enterramiento continuado de ese barro generado a partir de la acumulación de placas de caparazones de cocolitofóridos, acaba formándose una roca sedimentaria. Y puesto que el carbonato cálcico tiene un color blanquecino, la roca resultante también adquirirá una coloración blanca muy llamativa. Así que, tras aflorar en superficie, estas rocas resaltarán sobre el paisaje que las rodea gracias a esa blancura tan significativa, lo que las llevará a convertirse en un atractivo turístico seña de identidad de algunas zonas, como es el caso del litoral suroriental inglés.

En inglés, esta roca se denomina chalk. Pero aquí la conocemos con el nombre de creta, que procede del latín y significa tiza. Con esto ya nos estamos haciendo una idea de uno de los usos más comunes que se le han dado a esta roca a lo largo de la historia. Y es que esta roca, al estar compuesta prácticamente al completo por carbonato cálcico, tiene una dureza relativamente baja, es decir, es fácil romperla y machacarla, dando un fino polvo de color blanco. Por eso, antiguamente, pequeños fragmentos de esta roca se utilizaban para pintar, marcar o escribir figuras, números o palabras de color blanco sobre superficies de colores más oscuros. Ya fuera un sastre tomando medidas sobre una prenda de ropa, ya fuera un docente dando la lección a su alumnado ayudándose de una pizarra. Y aunque hoy en día se emplean otros componentes para la manufactura de estos materiales de apoyo, seguimos denominándolos tiza como un recuerdo de la roca original de la que surgió esta brillante idea. Seguro que en muchos museos educativos que conserven pizarras centenarias que no se hayan limpiado a conciencia podemos encontrar preservadas para la posteridad pequeñas placas carbonatadas procedentes del caparazón de cocolitofóridos fósiles.

Pero aún nos queda hablar de otra particularidad de esta roca y es que da nombre a un Periodo geológico, el Cretácico. Este Periodo, que abarca el tiempo comprendido entre hace 145 y 66 millones de años, fue definido a comienzos del siglo XIX por un geólogo belga, que lo denominó Cretácico debido a la abundancia de la roca creta que afloraba en los alrededores de París. Por supuesto, los blancos acantilados de Dover se formaron durante este Periodo, concretamente hace unos 100 millones de años, por la acumulación de caparazones de cocolitofóridos en el fondo de un mar de aguas cálidas y cristalinas con unos 300 o 400 metros de profundidad. Y debido a esa baja dureza que tiene esta roca, hoy en día estos materiales están siendo erosionados con bastante rapidez por el embate de las olas sobre el acantilado.

Este es un claro ejemplo de cómo nuestro patrimonio geológico, en este caso una roca con una coloración particular y llamativa, puede llegar a convertirse en un emblema característico de una región y de toda una sociedad. Seguro que, la próxima vez que veamos una escena de película o serie rodada junto a estos acantilados, nos imaginaremos a esos minúsculos organismos marinos que han dado lugar a esas rocas posando como los protagonistas que son de una maravillosa historia de millones de años.

Sobre la autora: Blanca María Martínez es doctora en geología, investigadora de la Sociedad de Ciencias Aranzadi y colaboradora externa del departamento de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU

El artículo Oh, blancos acantilados se ha escrito en Cuaderno de Cultura Científica.

Nicole-Reine Lepaute, la minuciosa e incansable astrónoma calculadora

«Madame Lepaute fue la negación viva de esta opinión, a menudo fundada, que niega a las mujeres la capacidad de reconciliar la ciencia y el encanto, el estudio y las cualidades domésticas. Era tan buena ama de casa como excelente geómetra, y era aún más diligente en ayudar que en realizar un cálculo.»

Pierre Larousse, Grand dictionnaire universel du XIXe siècle, 1866-1877.

Las líneas que abren este escrito, no exentas de misoginia, forman parte de la reseña que Larousse dedicó a Nicole-Reine Lepaute en su famoso diccionario. Cien años antes, en vida, tampoco fue reconocida como merecía.

Nicole-Reine Lepaute. Fuente: Wikimedia Commons.

Nicole-Reine Lepaute. Fuente: Wikimedia Commons.

Nicole-Reine nació el 5 de enero de 1723 en el Palacio de Luxemburgo de París donde residía su familia: era la sexta de nueve hijos. Su padre, Jean Étable, trabajaba al servicio de la Reina de España Louise Élisabeth d’Orléans (1709-1742).

En verano de 1749 se casó con Jean-André Lepaute (1720-1789), un relojero real en el Palacio de Luxemburgo, conocido en Europa por su gran labor como maestro artesano, diseñador, fabricante y reparador de relojes. Nicole-Reine ayudaba a su marido en su trabajo y, a través de él, conoció al astrónomo Joseph-Jérôme de Lalande (1732-1802).

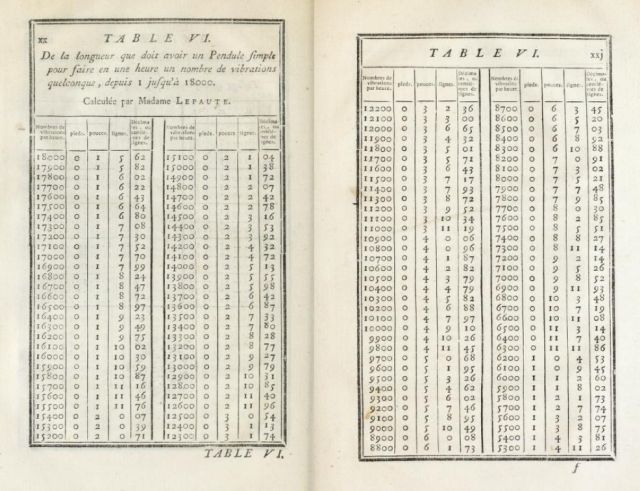

En 1753, la Académie des Sciences encargó a Lalande el estudio del reloj de Lepaute, provisto de un mecanismo de escape de un nuevo tipo. Animado por el astrónomo, Lepaute comenzó a diseñar y construir péndulos astronómicos. Nicole-Reine realizó los cálculos de las tablas de oscilaciones del péndulo para el Traité d’Horlogerie contenant tout ce qui est nécessaire pour bien connoître et pour régler les pendules et les montres de su marido.

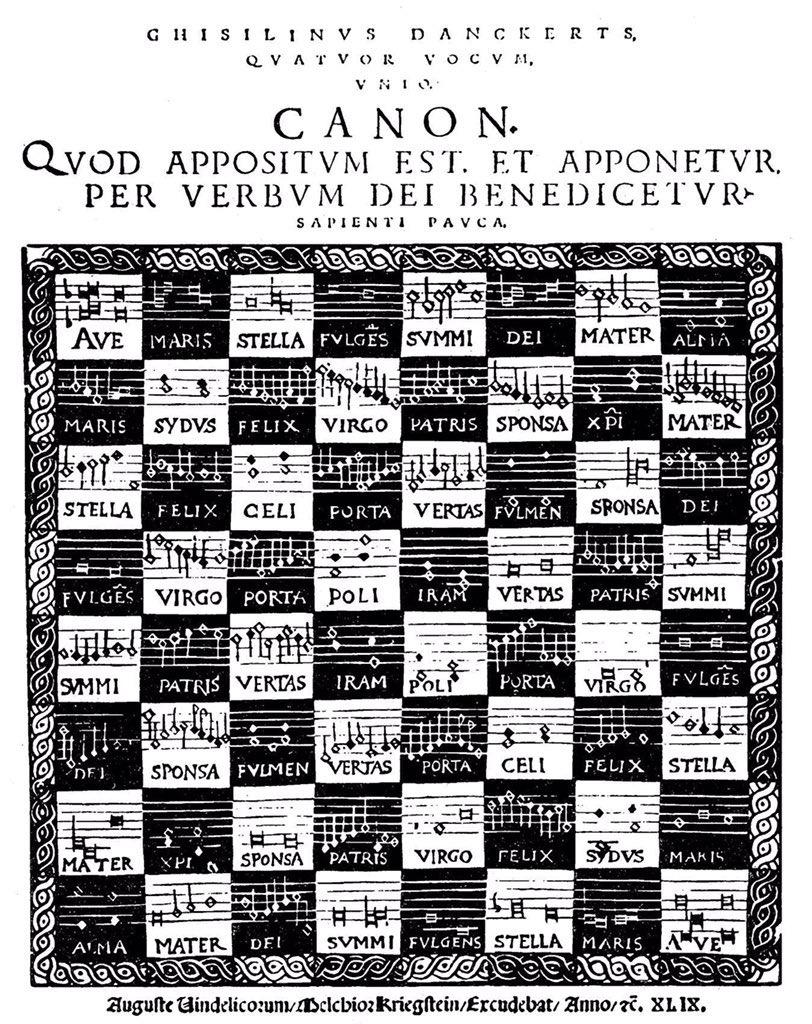

Tabla del Traité d’Horlogerie. Fuente: Archive.org

Tabla del Traité d’Horlogerie. Fuente: Archive.org

En 1757, un año antes del esperado regreso del cometa Halley (según la predicción realizada por Edmund Halley (1656-1742)), Lalande propuso a Alexis Clairaut (1713-1765) aplicar su solución (aproximada) del problema de los tres cuerpos para comprobar (o corregir, en su caso) la fecha prevista por Halley. Clairaut estableció los modelos de cómputo y Lalande (ayudado por Nicole-Reine Lepaute) se encargó de los numerosos cálculos que se precisaban: se trataba principalmente de medir el efecto que ejercían los planetas Júpiter y Saturno sobre la trayectoria del cometa y, por lo tanto, sobre la fecha prevista de su regreso. Lalande escribía en 1803:

«Durante más de seis meses, nosotros [Nicole Reine Lepaute y yo] calculamos desde la mañana hasta la noche, algunas veces incluso durante las comidas. […] La ayuda de Madame Lepaute fue tal que, sin ella, nunca hubiera podido emprender la enorme labor, en la que era necesario calcular la distancia de cada uno de los dos planetas, Júpiter y Saturno, al cometa, por separado, para cada grado sucesivo, durante 150 años.»

En noviembre de 1758, Clairaut anunció el regreso del cometa Halley para el 13 de abril de 1759, con un mes como margen de error. La predicción fue un gran éxito: el cometa pasó su perihelio el 13 de marzo de 1759.

Clairaut publicó en 1760 su Théorie du mouvement des comètes sin mencionar a Nicole-Reine Lepaute entre las personas calculadoras que habían contribuido a esta obra. Se dice que quería evitar los celos de una amante, intentando no ofenderla al alabar los méritos de otra mujer. Este hecho minó su larga amistad con Lalande y, de hecho, no volvieron a colaborar en investigaciones astronómicas.

En 1759, la Académie des Sciences solicitó a Lalande que se encargara de las efemérides astronómicas que publicaban bajo el nombre de La connaissance des temps; este anuario era muy utilizado por astrónomos y marinos y sirvió, por ejemplo, para calcular el tránsito de Venus de 1761 y de 1769. El astrónomo contrató a personas calculadoras, y eligió a Nicole-Reine Lepaute como su ayudante en esta tarea. El cartógrafo y astrónomo Cassini de Thury (1714-1784), rival y muy crítico con Lalande, calificó este equipo como «manufactura de astronomía», añadiendo además que «está dirigida en segundo lugar por una académica de no sé qué academia». Este desafortunado comentario ignoraba, por supuesto, que dos años más tarde Lepaute iba a ser admitida en la Académie de Béziers por sus trabajos en tablas astronómicas.

Ciertamente Lalande reclutaba para sus cálculos a numerosos astrónomos amateurs, algunos de ellos eran mujeres. De hecho, en su publicación Astronomie des dames (1785), Lalande defendía que la astronomía no debía ser un reducto masculino, mencionando a algunas mujeres astrónomas y comentando sus aportaciones:

«La bella Hipatia escribió varios tratados: profesaba la astronomía en Alejandría cuando fue asesinada por el clero, fue en 415. Maria Cunitz, hija de un médico de Silesia, publicó en 1650 unas tablas astronómicas. Marie-Claire Eimmart Muller, hija y esposa de astrónomos conocidos, también fue astrónoma. Jeanne Dumée presentó en 1680 unas entrevistas sobre el sistema de Copérnico. La esposa de Hevelius realizaba observaciones junto a él. Las hermanas de Manfredi calculaban las efemérides de Bolonia; las tres hermanas de Kirch calcularon durante mucho tiempo las efemérides de Berlín; su esposa, nacida Winkelmann, presentó en 1712 una obra de astronomía. La Marquesa de Châtelet ha proporcionado una traducción de Newton. La condesa de Puzynina ha fundado un observatorio en Polonia […]. Madame Lepaute, fallecida en 1788, ha calculado durante más de diez años efemérides de la Academia, y la viuda de Edwards trabaja en Inglaterra en el “Nautical almanac”. Madame du Piery ha realizado numerosos cálculos de eclipses para comprender mejor el movimiento de la Luna; fue la primera que ejerció la astronomía en París. Miss Caroline Herschel trabaja con su hermano. Ya ha descubierto cinco cometas. La Señora Duquesa de Gotha ha realizado gran cantidad de cálculos, pero no desea ser citada. Mi sobrina, Le Français de Lalande, ayuda a su marido en sus observaciones y obtiene conclusiones de ellas mediante cálculos; ha reducido diez mil estrellas, ha preparado trescientas páginas de tablas horarias para la marina, un trabajo inmenso para su edad y sexo. Están en mi “Abrégé de Navigation”.»

Joseph-Jérôme Le Français de Lalande, Astronomie des dames.

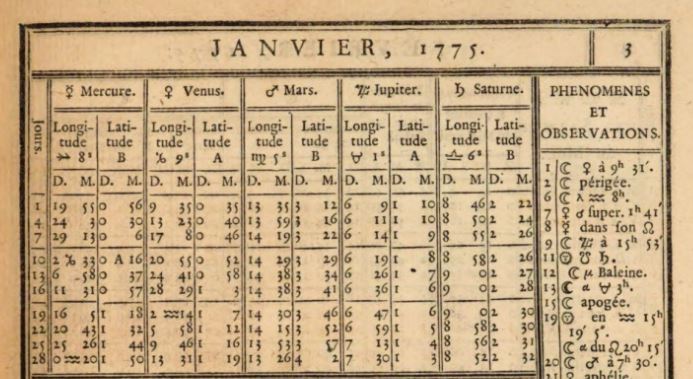

En 1774 Lalande comenzó a ocuparse de la publicación Éphémérides des mouvements célestes dirigiendo el tomo 7 (publicado en 1774 y dedicado a los años 1775 a 1784) y el tomo 8 (publicado en 1783 y correspondiente a los años 1785 a 1792). En el prefacio de ambos escritos reconoció el trabajo de Lepaute:

«Los cálculos de Saturno han sido realizados por Madame le Paute, quien, desde hace muchos años, se dedica con éxito al cálculo astronómico.»

«Madame le Paute, quien, desde más de 20 años, se dedica a la astronomía, ha realizado ella sola los cálculos del Sol, de la Luna y de los planetas.»

Página de las Efemérides de 1775. Fuente: Wikimedia Commons.

Página de las Efemérides de 1775. Fuente: Wikimedia Commons.

Nicole-Reine Lepaute investigó también el eclipse anular del 1 de abril de 1764 para el que trazó un mapa de visibilidad mostrando la progresión de cuarto de hora en cuarto de hora para toda Europa. Este trabajo fue publicado con su propio nombre en La connaissance des temps bajo el título de Explication de la carte qui représente le passage de l’ombre de la lune au travers de Europe dans l’eclipse du soleil centrale et annulaire. Sus cálculos necesitaron la preparación de una tabla de ángulos paralácticos (ángulo de desplazamiento de un objeto causado por un cambio en la posición del observador), cuya versión extendida fue publicada por el gobierno francés.

Nicole-Reine Lepaute no tuvo hijos, pero acogió en 1768 a uno de los sobrinos de su marido, Joseph Lepaute Dagelet (1751-1788), al que enseñó astronomía y que se convirtió en profesor de matemáticas de la École militaire en 1777, antes de ser elegido astrónomo adjunto en la Académie royale des sciences en 1785. Lalande consideraba la tutorización de su sobrino como una contribución de Lepaute a la astronomía.

Los últimos siete años de su vida los dedicó a cuidar de su marido, gravemente enfermo. Su propia salud se vio afectada, perdiendo la vista paulatinamente. Nicole-Reine falleció pocos meses antes que Jean-André Lepaute, el 6 de diciembre de 1788.

El asteroide 7720 (Lepaute) y un cráter de la Luna le rinden un merecido homenaje.

Referencias

-

John J. O’Connor y Edmund F. Robertson, Nicole-Reine Etable de Labrière Lepaute, MacTutor History of Mathematics archive, University of St Andrews

-

Nicole-Reine Lepaute, Wikipédia

-

María Angélica Salmerón, Distintas y distantes: mujeres en la ciencia. Hortense LEPAUTE: la astrónoma calculadora, La ciencia y el hombre XXVIII, no. 1, 2015

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad

El artículo Nicole-Reine Lepaute, la minuciosa e incansable astrónoma calculadora se ha escrito en Cuaderno de Cultura Científica.

Gilbert Lewis: átomos cúbicos y algo más

Los átomos cúbicos de Lewis en sus notas de 1902. Fuente: Wikimedia Commons

Los átomos cúbicos de Lewis en sus notas de 1902. Fuente: Wikimedia CommonsUna vez que los físicos que estudiaban la estructura del átomo comenzaron a darse cuenta de que los electrones que rodeaban el núcleo tenían una disposición especial, los químicos comenzaron a investigar cómo estas teorías se correspondían con la química conocida de los elementos y su capacidad para formar enlaces. Gilbert Newton Lewis (1875-1946) fue clave en el desarrollo de una teoría del enlace basada en el número de electrones de la capa más externa de electrones del átomo, la capa de “valencia”. En 1902, mientras estaba tratando de explicar el concepto de valencia a sus estudiantes, representó los átomos como constituidos por una serie de cubos concéntricos con electrones en cada vértice.

Este “átomo cúbico” explicaba los ocho grupos de la tabla periódica y representaba su idea de que los enlaces químicos se formaban por una transferencia electrónica para completar el conjunto de ocho electrones más externos (un “octeto”). La teoría de Lewis del enlace químico continuó evolucionando y, en 1916, publicó su artículo fundamental [*] en el que sugería que el enlace químico era un par de electrones compartidos por dos átomos. (El investigador de la General Electric Irving Langmuir elaboraría esta idea e introduciría el término enlace covalente). Para los casos en los que no se compartían los electrones, Lewis redefinió en 1923 el concepto de ácido como cualquier átomo o molécula con un octeto incompleto que era, por tanto, capaz de aceptar electrones de otro átomo; las bases eran, por consiguiente, donantes de electrones.

La contribución de Lewis también fue importante en el desarrollo de la termodinámica y en la aplicación de sus leyes a sistemas químicos reales. A finales del siglo XIX, cuando comenzó a trabajar, la ley de conservación de la energía y otras relaciones termodinámicas existían como ecuaciones aisladas. Lewis se basó en el trabajo de otro pionero de la termodinámica, Josiah Willard Gibbs (Universidad de Yale), cuyas contribuciones se estaban conociendo muy lentamente. El trabajo de ambos fue fundamental para poder predecir si una reacción avanzaría hasta casi consumir todos los reactivos, si alcanzaría un equilibrio o si no tendría lugar en absoluto, y también para determinar si una mezcla de sustancias podría ser separada por destilación.

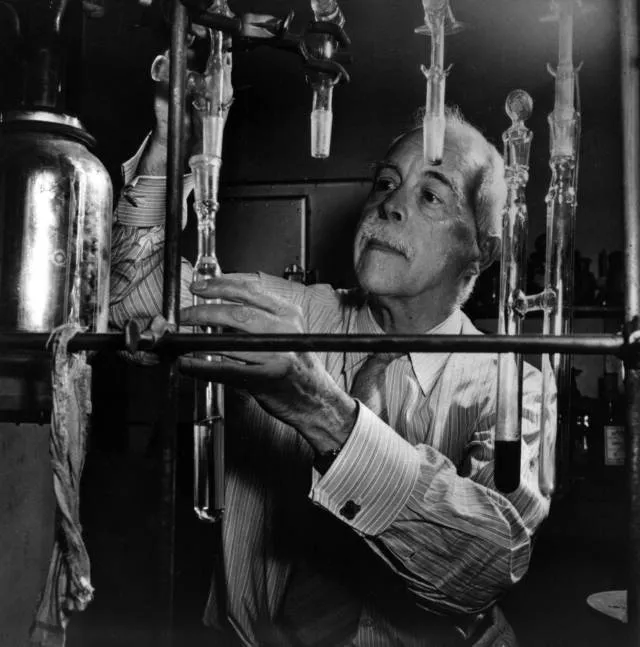

En 1931 uno de los estudiantes de Lewis, Harold Urey, detectó espectroscópicamente el deuterio. Lewis fue el primero en sintetizar óxido de deuterio (agua pesada) en 1933 y en estudiar su influencia en la supervivencia y crecimiento de formas de vida en agua pesada. Su interés en el deuterio le llevó a realizar experimentos junto a su ayudante Glenn T. Seaborg en el ciclotrón que había construido Ernest O. Lawrence en Berkeley. Urey y Seaborg recibirían sendos premios Nobel, en 1934 y 1951, respectivamente.

Lewis fue educado en su casa hasta que cumplió los 14 años. Su educación posterior fue más convencional, culminando con un doctorado por la Universidad de Harvard que le dirigió Theodore Richards. Posteriormente haría la peregrinación a Alemania de los químicos y físicos que querían estar a la vanguardia de la investigación a finales del XIX y primeras décadas del XX, trabajando con Walter Nernst (U. Gotinga) y Wilhelm Ostwald (U. Leipzig). Ocupó varias posiciones académicas, las más notables en el Instituto de Tecnología de Massachusetts (EE.UU.) y en la Universidad de California en Berkeley (EE.UU.), donde amplió los programas de química e ingeniería química.

Referencia:

[*] Lewis, G. (1916). The Atom and the Molecule Journal of the American Chemical Society, 38 (4), 762-785 doi: 10.1021/ja02261a002

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Una versión anterior de este texto se publicó en Experientia Docet el 8 de febrero de 2011.

El artículo Gilbert Lewis: átomos cúbicos y algo más se ha escrito en Cuaderno de Cultura Científica.

Los invasores: Las algas Caulerpa

“Un alga colonizadora [Caulerpa taxiflora] se aprovecha de un desorden provocado por la acción humana de una manera inesperada y brutal”.

Thomas Belsher, IFREMER, 2000.

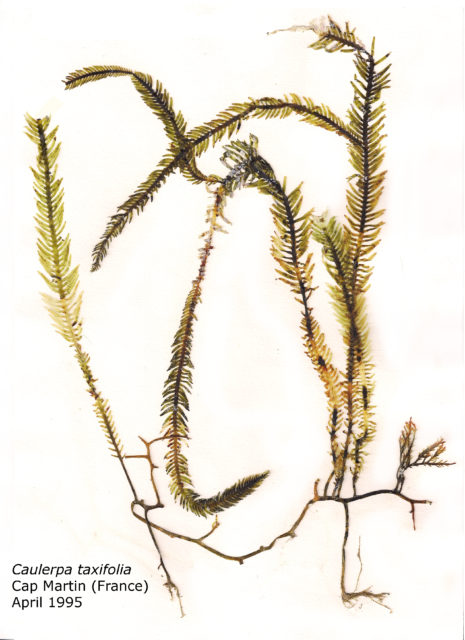

En todas las costas del planeta, la invasión de algas tiene un papel importante en la estructura de las comunidades. En el Mediterráneo se considera que hay unas 100 especies invasoras de macroalgas. Alexandre Meinesz y otros 21 expertos, liderados desde la Universidad de Niza-Sophia Antipolis, relatan la invasión de un alga en el Mediterráneo occidental. Es la especie Caulerpa taxifolia, un alga verde tropical con una distribución habitual en la costa americana de Brasil al Caribe, en el Golfo de Guinea en África y en los océanos Índico y Pacífico.

Espécimen de Caulerpa taxifolia expuesto en el Museo Nacional de la Naturaleza y la Ciencia de Tokio (Japón). Fuente: Wikimedia Commons.

Espécimen de Caulerpa taxifolia expuesto en el Museo Nacional de la Naturaleza y la Ciencia de Tokio (Japón). Fuente: Wikimedia Commons.En el Mediterráneo occidental se la detectó por vez primera en 1984, a pocos metros del Museo Oceanográfico de Mónaco y, se supone, fue vertida al mar por accidente durante la limpieza de sus acuarios. Procedía de una cepa del Zoo Wilhelm de Stuttgart, en Alemania, que desde 1980 se utilizaba como alga decorativa en sus acuarios. Llegó a Mónaco desde los acuarios de París y Niza que la habían recibido de Stuttgart.

Fuente: Wikimedia Commons

Fuente: Wikimedia CommonsSeis años más tarde, en 1990, se detectó en Francia, 6 kilómetros al este de Mónaco. A finales de 2000 había 76 colonias en Francia y Mónaco.

En España se observó por primera vez en Mallorca en 1992 y, a finales de 2000, había cuatro colonias en la isla.

El mismo año, en 1992, se encontró en Italia en el puerto de Imperia, 40 kilómetros al este de Mónaco. Para el 2000 estaba en cinco regiones: Liguria, Toscana, Elba, Sicilia y Calabria.

Caulerpa taxifolia se encontró por primera vez en Croacia en 1994, en la isla Hvar. Al año siguiente, en 1995, fue descubierta en la isla Krk.

A finales del 2000, seis países estaban afectados por la invasión de Caulerpa taxifolia en el Mediterráneo: España, Francia, Mónaco, Italia, Croacia y Túnez. En total, son 103 áreas independientes de invasión en 191 kilómetros de costa. Coloniza desde el nivel del mar hasta los 30 metros de profundidad. Y, en esas fechas del 2000, hace dos décadas, había colonizado 5000 hectáreas y parecía seguir en expansión. Había pasado de ocupar 1 metro cuadrado en 1984 a 3000 hectáreas en 1996 y, para 2000, llegar a las 5000 hectáreas.

Mancha de Caulerpa taxifolia. Foto: Rachel Woodfield / Wikimedia Commons

Mancha de Caulerpa taxifolia. Foto: Rachel Woodfield / Wikimedia CommonsSegún el Catálogo Español de Especies Exóticas Invasoras, en 2013, Caulerpa taxifolia es una especie que se ha extendido por el Mediterráneo en pequeñas manchas pero, rápidamente, llega a ocupar grandes extensiones de costa en varios países. Está incluida en la lista de las 100 peores especies invasoras del planeta.

Con estudios de ADN, el grupo de O. Jousson, de la Universidad de Ginebra, ha analizado muestras de Caulerpa del Mediterráneo y de varios acuarios públicos, incluyendo el de Mónaco, tomadas en 24 lugares. Los resultados confirman que provienen de la misma cepa que está disponible en los comercios que surten a los acuarios públicos y domésticos desde la década de los setenta. Todos los datos confirman que la especie invasora es Caulerpa taxifolia. Fue por el comercio de material para acuarios como se difundió por las costas del planeta.

Para reducir los riesgos de nuevas invasiones, en 2001, era ilegal importar o poseer Caulerpa en Francia, Australia, Estados Unidos y España. En España, por la Orden de 20 de marzo de 1996 se prohibió la extracción del alga Caulerpa taxifolia en el litoral nacional. La Orden se publicó en el BOE el 30 de marzo.

La cepa invasora se ha detectado también, en 2000, en San Diego y Los Angeles, en la costa de California. De esta zona se eliminó, entre 2000 y 2002, por la acción de agencias oficiales y de ONGs. Y al año siguiente, en 2001, se encontró el alga cerca de Sydney, en Australia. En este caso, solo 600 kilómetros al norte, hay Caulerpa taxifolia autóctona. También se eliminó cambiando el agua marina por agua dulce en el embalse en que había aparecido.

La dispersión del alga se hace por pequeños fragmentos que son arrastrados por las corrientes o en anclas y redes de los barcos. Se fijan al fondo, hasta los 30 metros de profundidad, y crecen como clones de la planta de la que proceden los fragmentos. También tiene reproducción sexual, poco conocida hasta el momento. Crece y se extiende en verano, de junio a septiembre. Lo hace donde encuentra las condiciones ambientales adecuadas para el asentamiento y la proliferación. La temperatura óptima de crecimiento va de 20ºC a 30ºC, y muere por debajo de los 7ºC y por encima de los 32ºC.

La dispersión por fragmentación la experimentaron Giulia Ceccherelli y Francesco Cinelli, de las universidades de Sassari y Pisa, en Italia, en la costa sur de la isla de Elba. En tres fechas, elegidas al azar en las cuatro estaciones del año, dispersaron 20 fragmentos de Caulerpa de 15 centímetros de longitud en los márgenes de praderas de Posidonia. Pasado un mes, contaron el número de fragmentos establecidos a 3 y a 10 metros de profundidad.

El mayor número de fragmentos establecidos se daba en verano en un periodo iniciado a finales de primavera y que terminó a principios del otoño. Fueron muy escasos los fragmentos que se fijaron en invierno. Destacaron algunos días de junio y julio en que se fijaron al sustrato entre el 60% y el 80% de los fragmentos de Caulerpa dispersados por los autores.

Sus predadores más habituales son peces, moluscos y erizos de mar. Su sistema de defensa es la producción de compuestos químicos tóxicos para otras especies. Reduce el número de especies autóctonas entre un 25% y un 55% y llega a ocupar el hábitat de algunas de ellas. Una de las más afectadas y estudiadas es Posidonia oceánica. En un solo año, afecta hasta el 45% de las praderas de esta especie. El impacto lo estudiaron Heike Molenaar y su grupo, de la Universidad de Niza-Sophia Antipolis, entre 1995 y 2005 en dos lugares de la costa mediterránea francesa: en Cap Martin y, como control en Cap Antibes.

Cada año medían la densidad del alga en cada zona de muestreo. Entre 1995 y 2000, Caulerpa taxifolia ocupó el suelo desde el 3% hasta el 95%. Pero en 2001, la extensión ocupada cayó hasta el 5% sin que se conozca la causa. Quizá temperatura del agua del marina era muy alta aquel año. Entre 2002 y 2005 creció la cobertura pero se mantuvo entre el 10% y el 22% y no llegó a la extensión de los últimos años de la década de los noventa. La densidad de Posidonia no recuperó los valores iniciales de antes de la llegada del alga, incluso después de la disminución de la Caulerpa entre 2000 y 2001.

Caulerpa cylindracea. Fuente: IMEDEA

Caulerpa cylindracea. Fuente: IMEDEAAlgunas variedades de otra especie de Caulerpa, la Caulerpa racemosa, se extendieron por el Mediterráneo oriental durante el siglo XX. La variedad cylindracea que llegó al Mediterráneo occidental venía de Perth, en Australia, aunque su distribución natural es tropical.

Invadió el Mediterráneo occidental y las Islas Canarias. Para 1991 se había encontrado en Túnez, Libia y se extendió por las costas españolas, francesas e italianas. El primer hallazgo parece que fue en Túnez, en 1985, según la revisión publicada por Yassine Sghaier y su grupo, del Centro de Actividad Regional para Áreas Especialmente Protegidas de Túnez, en el que participaron investigadores de Palma de Mallorca y de Alicante.

Tiene la variedad cylindracea un comportamiento invasor muy agresivo y, en general, imparable. Su tasa de crecimiento es cuatro veces mayor que la de Caulerpa taxifolia y, además, tiene reproducción sexual y asexual. Y puede establecerse hasta 60 metros de profundidad, aunque parece preferir los 20 metros en algunas zonas como, por ejemplo, las costas de Murcia.

En España se encontró en Baleares en 1998, en Castellón en 1999, en Alicante en 2001 y en Murcia en 2005 y se extiende hacia Andalucía.

En resumen, dos especies de algas tropicales del género Caulerpa colonizan en la actualidad las costas del Mediterráneo occidental, escriben en 2003 A. Occhipinti-Ambrogi y D. Savini, de la Universidad de Pavía, en Italia. Son Caulerpa taxifolia y Caulerpa racemosa var. cylindracea. La primera llegó desde los acuarios en 1984 y la segunda desde Australia, quizá por el Mar Rojo y el Canal de Suez o, también, por el comercio para acuarios, en la década de los ochenta del siglo XX.

Para los autores, el éxito de la colonización de las dos especies de Caulerpa se basa en su fácil diseminación, su elevado ajuste al medio ambiente del Mediterráneo y la resistencia a la contaminación en entornos muy dañados.

Sin embargo, en 2007 y según la revisión de J.M. Ruiz Fernández y sus colegas, del Instituto Español de Oceanografía en San Pedro del Pinatar, en Murcia, la invasión de Caulerpa taxiflora no ha sido el desastre que se preveía hace dos décadas. Su velocidad de dispersión se ha ralentizado o detenido, y las praderas de Posidonia no han experimentado la gran regresión que se esperaba. Ya en 2003, un estudio, dirigido por Jean Jaubert, del Observatorio Oceanológico Europeo de Mónaco, con fotografías aéreas del 44% de la costa de Francia con Caulerpa taxifolia mostró que la cobertura con el alga se había sobreestimado como diez veces y, de nuevo, se mencionan entornos con contaminación o de salida de aguas de tormenta como áreas adecuadas para la implantación del alga.

En Baleares, con taxiflora desde los noventa, no se han observado alteraciones en la distribución y abundancia de las praderas de Posidonia. Es más, en un estudio publicado en 2021 y liderado por Fabrice Houngnandan desde la Universidad de Montpellier, se concluye que la presencia de Caulerpa crece cuando el estado de conservación de las praderas de Posidonia decrece y cuando el número de barcos anclados es alto. Parece que las praderas de Posidonia deben estar dañadas para que Caulerpa taxifolia colonice el entorno y, en parte, la sustituya.

Sin embargo, Caulerpa racemosa var. cylindracea, sin recibir tanta atención mediática como “alga asesina”, parece cumplir las peores expectativas. Hay que recordar que su tasa de crecimiento es cuatro veces superior a la de Caulerpa taxiflora. Por la profundidad en la que se asienta, es más difícil de controlar y menos visible para el público en general lo que provoca, a su vez, menos atención y rechazo.

Referencias:

Catálogo Español de Especies Exóticas Invasoras. 2013. Caulerpa taxifolia. Ministerio de Agricultura, Alimentación y Medio Ambiente. Madrid. Septiembre. 8 pp.

Catálogo Español de Especies Exóticas Invasoras. 2013. Caulerpa racemosa. Ministerio de Agricultura, Alimentación y Medio Ambiente. Madrid. Septiembre. 6 pp.

Ceccherelli, G. & F. Cinelli. The role of vegetative fragmentation in dispersal of the invasive alga Caulerpa taxifolia in the Mediterranean. Marine Ecology Progress Series 182: 299-303.

Houngnandan, F. et al. 2021. The joint influence of environmental and anthropogenic factors on the invasion of two alien caulerpae in northwestern Mediterranean. Biological Invasions doi: 10.1007/s10530-021-02654-w.

Jaubert, J.M. et al. 2003. Re-evaluation of the extent of Caulerpa taxifolia development in the northern Mediterranean using airborne spectrographic sensing. Marine Ecology Progress Series 263: 75-82.

Jourdaa, F. 2000. Thomas Belsher. Organismos invasores. Mundo Científico enero: 14-15.

Jousson, O. et al. 1998. Molecular evidence for the aquarium origin of the green alga Caulerpa taxifolia introduced to the Mediterranean Sea. Marine Ecology Progress Series 172: 275-280.

Klein, J. & M. Verlaque. 2008. The Caulerpa racemose invasion: A critical review. Marine Pollution Bulletin 56: 205-225.

Meinesz, A. et al. 2001. The introduced green alga Caulerpa taxifolia continues to spread in the Mediterranean. Biological Invasions 3: 201-210.

Molenaar, H. et al. 2009. Alterations of the structure of Posidonia oceanica beds due to the introduced alga Caulerpa taxifolia. Scientia Marina 73: 329-335.

Occhipinti-Ambrogi, A. & D. Savini. 2003. Biological invasions as a component of global change in stressed marine ecosystems. Marine Pollution Bulletin 46: 542-551.

Sghaier, Y. et al. 2016. Review of alien marine macrophytes in Tunisia. Mediterranean Marine Science 17: 109-123.

Simberloff, D. 2021. Maintenance management eradication of established aquatic invaders. Hydrobiologia 848: 2399-2420.

Wikipedia.2021. Caulerpa taxifolia. 13 mayo.

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Los invasores: Las algas Caulerpa se ha escrito en Cuaderno de Cultura Científica.

Las plantas parásitas roban agua, nutrientes… y hasta genes

Carlos Frey y José Luis Acebes Arranz

Cuscuta chinensi. Fuente: Vinayaraj, CC BY-SA

Cuscuta chinensi. Fuente: Vinayaraj, CC BY-SA

La idea general que tenemos de las plantas es que son organismos verdes anclados en el suelo y que elaboran su propio alimento mediante la fotosíntesis. Pero ¿son todas las plantas así? Entre la gran diversidad que alberga este reino, algunas se han especializado en robar el alimento a otras. Estas jetas son las plantas parásitas.

Estudios recientes concluyen que el parasitismo ha aparecido independientemente en doce ocasiones a lo largo de la historia evolutiva de las plantas. En total se han identificado 292 géneros y 4 750 especies de estas plantas. Es decir, este comportamiento no es tan raro como podría parecer, ya que lo tiene aproximadamente el 1,6 % de las especies de plantas con flores y frutos (angiospermas).

Especies reprentativas de los 12 grupos de plantas parásitas. A: Cassytha filiformis (Sudáfrica); B: Hydnora africana (Sudáfrica); C: Cynomorium coccineum (España); D: Krameria ixine (Puerto Rico); E: Rafflesia pricei (Malasia); F: Pilostyles thurberi (EEUU); G: Cytinus ruber (Francia); H: Amyema artensis (Papúa Nueva Guinea); I: Mitrastemon yamamotoi (Japon); J: Pholisma culiacanum (México); K: Cuscuta rostrata (EEUU); L: Harveya purpurea (Sudáfrica). Nickrent, D. L., 2020. Parasitic angiosperms: How often and how many? Taxon, 69(1), 5-27.

Especies reprentativas de los 12 grupos de plantas parásitas. A: Cassytha filiformis (Sudáfrica); B: Hydnora africana (Sudáfrica); C: Cynomorium coccineum (España); D: Krameria ixine (Puerto Rico); E: Rafflesia pricei (Malasia); F: Pilostyles thurberi (EEUU); G: Cytinus ruber (Francia); H: Amyema artensis (Papúa Nueva Guinea); I: Mitrastemon yamamotoi (Japon); J: Pholisma culiacanum (México); K: Cuscuta rostrata (EEUU); L: Harveya purpurea (Sudáfrica). Nickrent, D. L., 2020. Parasitic angiosperms: How often and how many? Taxon, 69(1), 5-27.No todos los ladrones son de la misma condición

No todas las plantas parásitas roban de la misma manera. Algunas son “parásitas facultativas”. Son capaces de vivir autónomamente, pero parasitan a otras si se les brinda la ocasión.

Otras muchas son “parásitas obligadas”. Su forma de vida consiste exclusivamente en robar.

Dentro de las parásitas obligadas podemos reconocer dos tipos. Las “hemiparasitas” solo roban de la planta parasitada (hospedadora) la savia bruta, que les aporta agua y sales minerales (los nutrientes), mientras que fabrican su propio alimento (los fotoasimilados) mediante la fotosíntesis. Un ejemplo es el conocido muérdago (Viscum album).

Por el contrario, las “holoparásitas” o parásitas completas roban de la parasitada tanto la savia bruta como la elaborada, de las cuales reciben agua/nutrientes y fotoasimilados respectivamente. Entre ellas cabe citar las cuscutas (Cuscuta sp.) y los jopos (Orobanche sp.).

Pequeña planta de muérdago (Viscum album) creciendo sobre una rama leñosa. Nótese la coloración verde que indica actividad fotosintetizadora. Fuente: Salicyna – CC BY-SA 4.0

Pequeña planta de muérdago (Viscum album) creciendo sobre una rama leñosa. Nótese la coloración verde que indica actividad fotosintetizadora. Fuente: Salicyna – CC BY-SA 4.0Curiosamente, hay algunas plantas que son capaces de robar a hongos: reciben el nombre de micoheterótrofas y parasitan hongos micorrícicos que están asociados a otras plantas. Tienen aspectos impresionantes, como el de la planta fantasma.

Monotropa uniflora. Planta micoheterótrofa también conocida como planta fantasma, pipa fantasma o pipa india. Nótese la coloración blanca (y rosada) en contraposición al verde mostrado por una planta fotosintética. Fuente: Magellan nh – CC BY 3.0¿Pueden las plantas parásitas ‘robar’ genes?

Monotropa uniflora. Planta micoheterótrofa también conocida como planta fantasma, pipa fantasma o pipa india. Nótese la coloración blanca (y rosada) en contraposición al verde mostrado por una planta fotosintética. Fuente: Magellan nh – CC BY 3.0¿Pueden las plantas parásitas ‘robar’ genes?

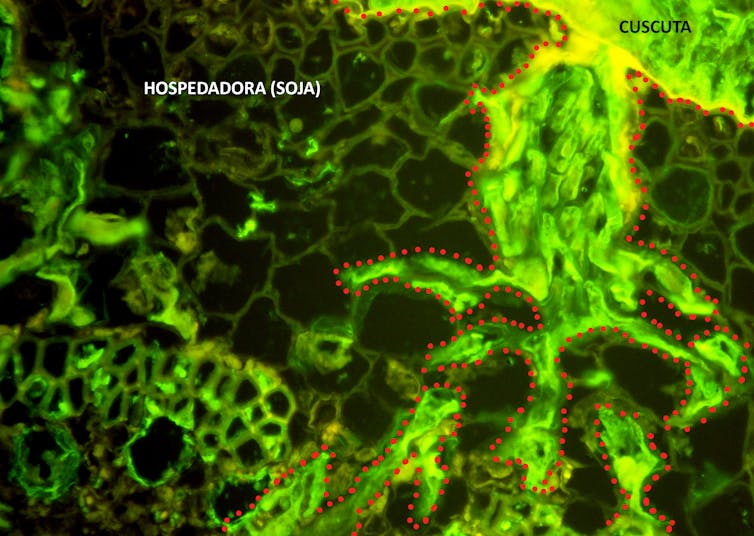

Las plantas parásitas cuentan con un órgano especializado para ejercer el robo. Se trata del haustorio, que penetra los tejidos de las plantas parasitadas hasta que se conecta a su sistema vascular.

Haustorio leñoso. Corte longitudinal de la conexión haustorial entre muérdago (parásito) y manzano (hospedador). Fuente: Schurdl – CC BY-SA 4.0

Haustorio leñoso. Corte longitudinal de la conexión haustorial entre muérdago (parásito) y manzano (hospedador). Fuente: Schurdl – CC BY-SA 4.0 Haustorio herbáceo. Corte transversal microscópico del haustorio de Cuscuta campestris (parásita) avanzando hacia los tejidos vasculares del tallo de la planta de soja (hospedadora).

Haustorio herbáceo. Corte transversal microscópico del haustorio de Cuscuta campestris (parásita) avanzando hacia los tejidos vasculares del tallo de la planta de soja (hospedadora).En las plantas holoparásitas se ha visto que, además de agua, nutrientes y fotoasimilados, otras muchas sustancias pasan por el haustorio hacia la planta asaltante y, curiosamente, entre esas sustancias se encuentran ácidos nucleicos como son pequeños ARN o ARN mensajeros móviles.

Sorprendentemente, se ha demostrado que existe transferencia de genes, es decir, genes de la planta parasitada que se integran en el genoma de células de la planta asaltante. Esto representa un caso sobresaliente de transferencia genética horizontal.

La transferencia genética horizontal consiste en el traspaso de material genético entre organismos (diferenciándose así de la transmisión genética vertical que tiene lugar a través de la descendencia). Esta transferencia normalmente se asocia a bacterias y otros microorganismos, aunque está ampliamente demostrada en plantas y se considera que ha sido un factor de gran importancia en el proceso evolutivo. Desde hace unos años se van conociendo más y más casos de transferencia genética desde plantas hospedadoras a plantas parásitas.

En las células de las plantas, además del genoma nuclear (que incluye la mayoría de los genes), aparece un genoma mitocondrial y otro plastidial (el de los cloroplastos). La gran mayoría de los eventos de transferencia genética horizontal en plantas parásitas han involucrado al genoma mitocondrial, pero también se han descrito otros asociados a los genomas nuclear y plastidial.

Esta transferencia está facilitada por el íntimo contacto que se produce en los haustorios entre células de la planta parásita y la parasitada, ya que las membranas plasmáticas entre unas y otras se conectan gracias a la formación de plasmodesmos (a modo de túneles entre células). En cuanto a los mecanismos descritos se distinguen varios:

- Captura directa de ADN.

- Fusión mitocondrial, nuclear o plastidial.

- Intermediarios de ARN mensajero.

- Transposones.

Tipos y mecanismos de transferencia genética horizontal (TGH) entre plantas parásitas y hospedadoras.

Tipos y mecanismos de transferencia genética horizontal (TGH) entre plantas parásitas y hospedadoras.¿Y los genes ‘robados’ funcionan?

Aunque muchos de los genes robados que se incorporan al genoma en los eventos de transferencia genética horizontal no desempeñan función conocida en la planta parásita, algunos de ellos sí se expresan, son funcionales y contribuyen a la buena salud de la salteadora. Por citar un par de ejemplos:

La escoba de Egipto (Phelipanche aegyptiaca), emparentada con los jopos, ha importado genes de defensa que se expresan. Se sospecha que contribuyen a la atenuación del sistema inmune de la planta hospedadora.

En las cuscutas, la mayoría de los eventos de transferencia genética horizontal se expresan y 18 de ellos coinciden de manera independiente con eventos encontrados en la familia de los jopos (Orobanchaceae). Esto sugiere una posible retención convergente. ¿Son capaces las plantas parásitas de quedarse con los genes más interesantes?

En conclusión, los datos disponibles muestran que la transferencia de genes ha sido un fenómeno muy importante en la evolución de las plantas parásitas. Estas atípicas plantas no solo han conseguido robar agua, nutrientes y fotoasimilados a otras plantas, sino que también han logrado robar genes útiles para ellas. Ilustran como nadie el famoso refrán español: “Fruto del árbol ajeno, sale de balde y sabe bueno”.![]()

Sobre los autores: Carlos Frey está realizando su doctorado en fisiología vegetal y José Luis Acebes Arranz es catedrático de fisiología vegetal, ambos en la Universidad de León

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Las plantas parásitas roban agua, nutrientes… y hasta genes se ha escrito en Cuaderno de Cultura Científica.

Naukas Bilbao 2021: Manu Arregi – Una historia muy oscura

El gran evento de divulgación Naukas regresó a Bilbao para celebrar su décima edición en el magnífico Palacio Euskalduna durante los pasados 23, 24, 25 y 26 de septiembre.

¿Usó Vermeer tecnologías ópticas para realizar sus obras maestras? Manu Arregi nos presenta las pruebas que parecen indicar que sí.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Bilbao 2021: Manu Arregi – Una historia muy oscura se ha escrito en Cuaderno de Cultura Científica.

Un 2021 de ciencia

Foto: engin akyurt / Unsplash

Foto: engin akyurt / Unsplash2021 ha sido año de exploración marciana. El 18 de febrero aterrizó en el planeta rojo Perseverance, un vehículo que había sido lanzado por la NASA el 30 de julio de 2020. Y por si poner un cochecito lleno de instrumentos científicos en la superficie de Marte y hacer que se desplace por su superficie fuese hazaña pequeña, el 19 de abril la NASA hizo volar un pequeño helicóptero, de nombre Ingenuity. Que sepamos, es la primera vez que un artilugio semejante sobrevuela ese planeta o cualquier otro distinto del nuestro. Y desde entonces, a comienzos de este mes de diciembre lo había hecho ya en diecisiete ocasiones.

Esos no son los únicos hitos de la exploración espacial de este año, porque el pasado día 25 fue lanzado al espacio, a bordo del cohete Ariane 5, el telescopio James Webb. Será el sustituto del Hubble y, si todo funciona como es de esperar, será capaz de obtener imágenes mejores y de objetos astronómicos más lejanos aún que su predecesor. El telescopio ha sido lanzado por un consorcio formado por las agencias espaciales estadounidense, europea y canadiense.

En 2021 la inteligencia artificial ha seguido haciendo de las suyas, para bien y para mal. Me han impresionado dos grandes logros. Uno ha sido el descubrimiento, gracias a su potencial, de 301 nuevos planetas fuera del Sistema Solar. Y el otro su aplicación para decodificar con éxito actividad neurológica encefálica de macacos, registrada mediante ultrasonidos, y anticipar así los movimientos que se proponían hacer. Corresponden a áreas muy diferentes, y se suman a hallazgos tan asombrosos como la capacidad para determinar la estructura y forma de las proteínas a partir de su secuencia de aminoácidos, que se había conseguido en 2020. La cara negativa es la constatación, en reiteradas ocasiones, de que la inteligencia artificial dota a sus productos de sesgos indeseables. Son el reflejo de prejuicios y estereotipos negativos para con quienes forman parte de ciertos grupos de población, y deben, por ello neutralizarse, para que no perjudiquen a las personas pertenecientes a esos grupos cuando se aplican en la esfera social y económica.

Las vacunas de la Covid-19 no han sido las únicas por las que debemos congratularnos este año. En 2021 se ha constatado que, un año después de su administración, la de la malaria ha mostrado una eficacia del 75% en una muestra de cuatrocientas cincuenta niños y niñas. No es una muestra muy grande, pero es un resultado prometedor. No olvidemos que el paludismo mata cada año a cuatrocientas mil personas. Hasta ahora, el protozoo de la malaria se ha mostrado esquivo en extremo a la acción de las vacunas. Cualquier avance en la prevención de esta enfermedad se traducirá en más salud y, como consecuencia, en menos pobreza y más bienestar general.

En España la vulcanología ha adquirido este año una relevancia enorme, acorde con la magnitud de las erupciones de Cumbre Vieja y con los estragos que han causado en la isla de La Palma. Los ríos de lava nos han recordado que la geología importa y que es una disciplina imprescindible para entender el mundo en el que vivimos y para relacionarnos de forma más inteligente con nuestro planeta.

Y luego está la Covid-19, con sus vacunas, variantes, olas y demás. Pero de eso ya hablan otros más y mejor que un servidor. Hagámonos a la idea: antes o después, a todos nos alcanzará el SARS-Cov-2. De lo que se trata es de que lo haga lo más tarde posible y que, cuando eso ocurra, nos encuentre lo más protegidos posible.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Un 2021 de ciencia se ha escrito en Cuaderno de Cultura Científica.

Interpretar el arcoíris para clasificar las estrellas

Los muchos cientos de líneas de absorción del espectro solar. Fuente: NoirLab

Los muchos cientos de líneas de absorción del espectro solar. Fuente: NoirLabLa luz de las estrellas contiene información esencial sobre su estructura química. Pero esa información permaneció oculta, como un mensaje encerrado dentro de una botella, durante decenas de siglos. El prisma de Newton, capaz de destejer el arcoíris interno de la luz, fue solo la primera pieza de un puzzle que más tarde nos permitiría interpretar todos esos mensajes.

En el siglo XIX, gracias al avance de la ciencia y la tecnología, las herramientas ópticas se fueron haciendo cada vez más precisas. Después de que William H. Wollaston descubriese las primeras líneas oscuras ocultas en la luz del Sol (los espectros de absorción), Joseph von Fraunhofer perfeccionó su técnica y dedicó años a clasificarlas con precisión. Este físico alemán fue el pionero en utilizar una red de difracción para obtener el espectro de la luz. Se trata de una rejilla, de ranuras diminutas, que consigue difractar la luz y hacer que los rayos de distinta longitud de onda (de distinto color) se separen entre sí. También fue el primero en utilizar este dispositivo para medir las longitudes de onda asociadas a las misteriosas líneas oscuras del arcoíris. Por ello, hoy se considera a Fraunhofer el padre de la espectroscopía. Su nombre estará escrito para siempre en el espectro de la luz del Sol.

Durante el siglo XIX, los astrofísicos fueron abriendo poco a poco los mensajes de la luz procedente de las estrellas. Gracias a estos espectros, la ciencia contó con una gran cantidad de datos nuevos, medidos con una precisión cada vez mayor. Sin embargo, para poder darle sentido a todos esos números, aún era necesario analizarlos e interpretarlos, construir un modelo con ellos. ¿Qué nos podían contar aquellas líneas oscuras sobre sus estrellas de origen?

Los primeros intentos de clasificación estelar basados en estos espectros tuvieron lugar entre 1860 y 1870. En esta época destaca la labor de Angelo Secchi, un astrónomo italiano que dirigía el observatorio de la Pontificia Universidad Gregoriana. Secchi propuso una clasificación basada en cuatro tipos de estrellas, en función de su color y de algunos de sus componentes químicos. Las estrellas de tipo 1 eran blancas o azuladas, sus espectros se caracterizaban unas líneas muy marcadas propias del hidrógeno, e incluían estrellas como Vega o Sirio. Su tono se iba apagando, pasando por las estrellas de luz predominantemente amarilla (tipo 2), naranja (tipo 3) o roja (tipo 4). Aunque este sistema de clasificación ya no se utiliza en la actualidad, Secchi fue uno de los pioneros en basar sus estudios astronómicos en la espectrografía. También fue uno de los más prolíficos: el italiano llegó a clasificar los espectros de más de 4.000 estrellas basándose en su propio sistema1.

Al otro lado del Atlántico, otro físico llamado Edward Charles Pickering, profesor en el Instituto de Tecnología de Massachusetts (el famoso MIT), estaba también convencido de que la nueva astronomía no debía limitarse a medir velocidades y posiciones relativas de las estrellas: su espectro, su brillo y su color serían las claves que nos permitirían entender el universo, la base de la nueva astrofísica. Pero para conseguir este ambicioso objetivo, necesitaba dos ingredientes fundamentales. Para empezar, necesitaba más datos. Por suerte, Pickering contaba con dos grandes telescopios que podrían proporcionárselos: el “Gran Refractor” de Cambridge, construido en 1847, que fotografiaba el cielo desde el hemisferio norte, y el telescopio Bruce de Arequipa, de 1896, situado en el hemisferio sur.

Pero sobre todo, el proyecto de Pickering requería un análisis pormenorizado de todos esos datos. Necesitaba contratar cabezas pensantes, mano de obra cualificada capaz de analizar toda esa nueva información. Fue así como se formó un equipo sin precedentes de computadoras humanas, que aún hoy conocemos con el desafortunado nombre de “el harén de Pickering”.

Referencia:

1R. O. Gray, C. J. Corbally. Stellar Spectral Classification. 2009.

Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica

El artículo Interpretar el arcoíris para clasificar las estrellas se ha escrito en Cuaderno de Cultura Científica.

¿Conocían los romanos el triángulo fractal de Sierpinski?

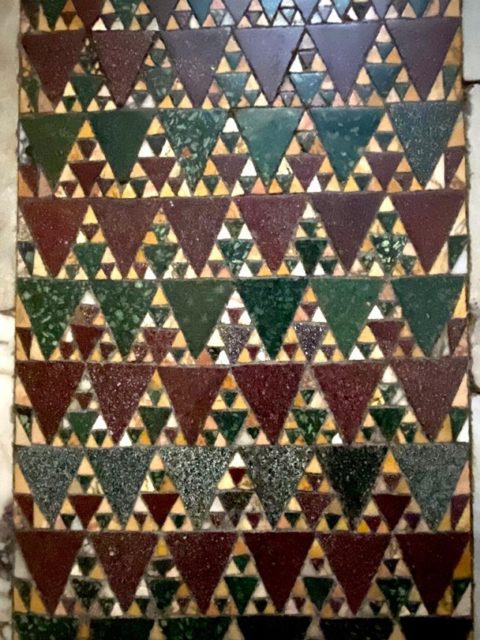

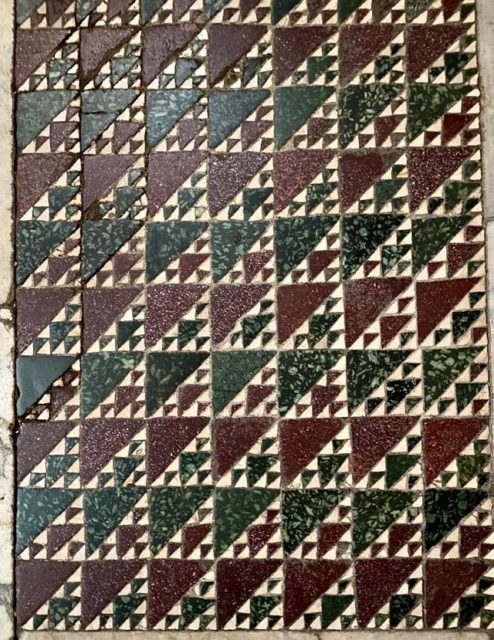

Como escribí en mi anterior entrada del Cuaderno de Cultura Científica, titulada Geometría en los pavimentos romanos cosmatescos, observando el hermoso pavimento de la Basílica de Santa María en Cosmedin en Roma, en la cual se encuentra la Boca de la Verdad, me llevé algunas sorpresas.

Fotograma de la película Vacaciones en Roma (1953) de William Wyler, interpretada por Gregory Peck y Audrey Hepburn, en la que vemos a sus protagonistas frente a la Boca de la Verdad

Fotograma de la película Vacaciones en Roma (1953) de William Wyler, interpretada por Gregory Peck y Audrey Hepburn, en la que vemos a sus protagonistas frente a la Boca de la Verdad

Una de esas sorpresas, además de las mencionadas en mi anterior entrada, fue que en parte de ese pavimento de estilo cosmatesco pude observar el triángulo fractal de Sierpinski, o, para ser más preciso, una estructura geométrica que me recordaba claramente al triángulo de Sierpinski. En concreto, en este pavimento, que os muestro en la siguiente imagen, observé que la mitad de las baldosas triangulares del mosaico estaban formadas por un triángulo equilátero dividido en cuatro triángulos equiláteros, de los cuales el central estaba dotado de color, mientras que los otros tres apoyados en los vértices, estaban divididos de nuevo en cuatro triángulos equiláteros, con color solamente los pequeños triángulos centrales.

Parte del pavimento de la Basílica de Santa María en Cosmedin (Roma), con mosaicos formados por lo que nos recuerda a triángulos fractales de Sierpinski. Fotografía de Marian Espinosa

Parte del pavimento de la Basílica de Santa María en Cosmedin (Roma), con mosaicos formados por lo que nos recuerda a triángulos fractales de Sierpinski. Fotografía de Marian Espinosa

Aunque la mayor sorpresa en mi viaje a Roma, en relación con esta estructura geométrica, me la encontré en el suelo de la Basílica de Santa María en Trastevere (siglo XII). Al entrar en el interior de esta basílica romana uno descubre tanta belleza geométrica que no sabe a dónde mirar. Entre todas las bellezas del pavimento, también de estilo cosmatesco, se encontraba esta que os muestro a continuación y que es una versión más compleja aún del triángulo fractal de Sierpinski “romano”.

Triángulo fractal de Sierpinski en el pavimento de la Basílica de Santa María en Trastevere (Roma). Fotografía de Francesco de Comité para MAA Found Math

Triángulo fractal de Sierpinski en el pavimento de la Basílica de Santa María en Trastevere (Roma). Fotografía de Francesco de Comité para MAA Found Math

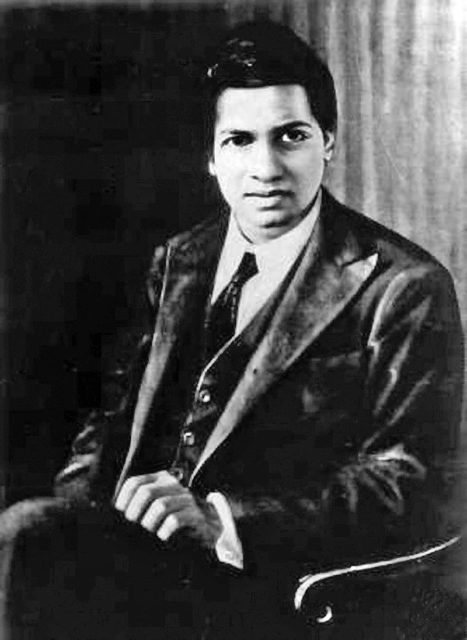

Pero expliquemos qué es eso del triángulo fractal de Sierpinski. Este objeto fractal (véase la entrada Fractus, arte y matemáticas para saber qué es un fractal) debe su nombre al matemático polaco Waclaw Franciszek Sierpinski (1882-1969). Este gran matemático del siglo XX, que escribió más de 700 artículos de investigación y 50 libros (entre ellos: Números cardinales y ordinales (1958), Introducción a la topología general (1934), Topología general (1952), Triángulos pitagóricos (1952) o Teoría elemental de números (1914 y 1959)), trabajó en teoría de conjuntos –con contribuciones al axioma de elección y la hipótesis del continuo-, teoría de números, teoría de funciones, topología y lógica matemática. Su nombre se ha asociado a algunos objetos matemáticos, como los fractales denominados curva de Sierpinski, triángulo de Sierpinski y alfombra de Sierpinski, o a los conocidos como números de Sierpinski.

Fotografía de 1928 de Waclaw Sierpinski. Imagen del Archivo Estatal de Polonia – Archiwa państwowe

Fotografía de 1928 de Waclaw Sierpinski. Imagen del Archivo Estatal de Polonia – Archiwa państwowe

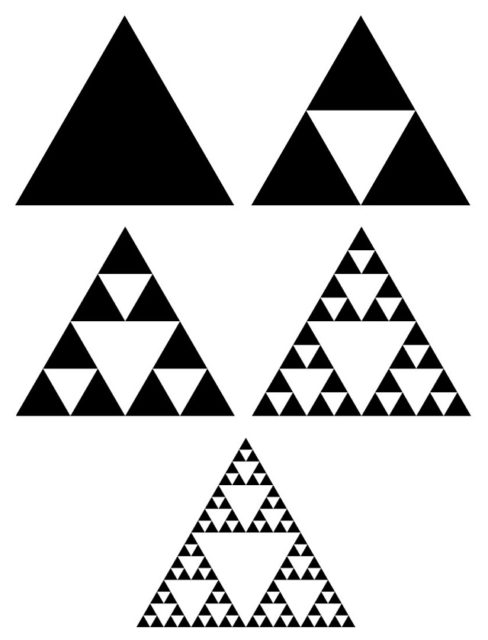

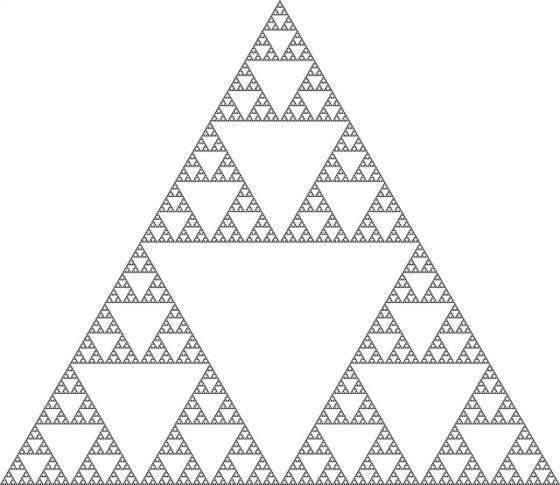

El triángulo de Sierpinski es un objeto fractal introducido por el matemático Wraclaw Sierpinski en 1916. Satisface algunas de las propiedades características de los fractales: es autosemejante (es decir, al hacer zoom sobre el objeto, se observa que partes más pequeñas del objeto son exactamente, o aproximadamente, iguales a todo el objeto), se puede construir mediante un algoritmo recursivo (en este caso, a partir de un triángulo equilátero), tiene área cero (si se calcula el área del objeto en cada paso de su construcción cada vez es más pequeña y su límite es cero) y tiene dimensión no entera, de hecho, irracional (1,58496…), aunque esto necesitaría de una explicación más larga que ahora no abordaremos.

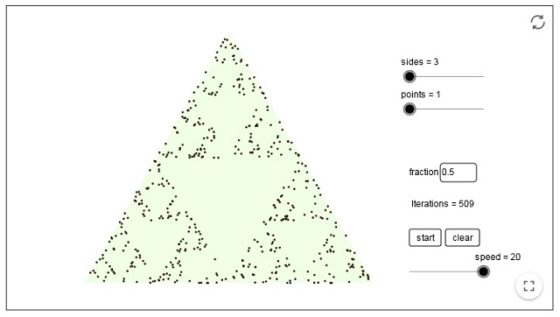

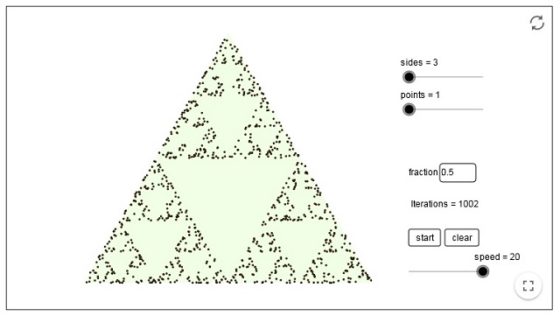

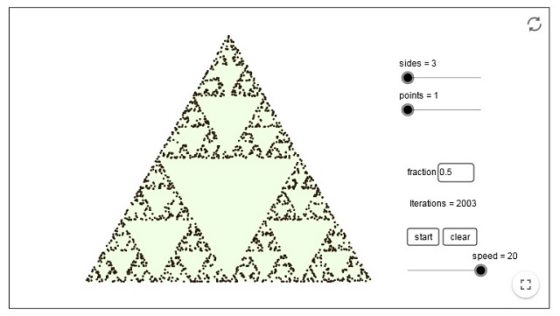

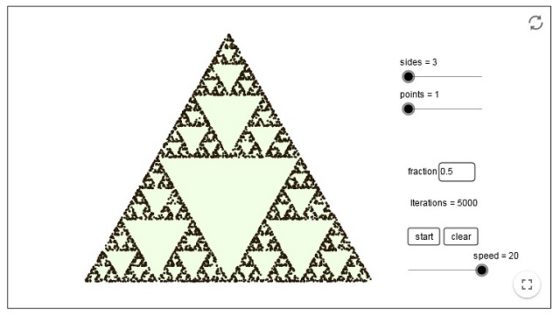

La construcción es la siguiente. En el primer paso se considera un triángulo equilátero (en negro en la siguiente imagen). En el segundo paso se divide el triángulo inicial en cuatro triángulos equiláteros más pequeños de la siguiente forma. Se considera los puntos medios de los tres lados del triángulo y se unen mediante segmentos rectos, esto nos genera un triángulo central, que se elimina (por eso queda blanco en la imagen), y tres triángulos equiláteros que tocan los vértices del triángulo inicial (que se mantienen negros). En el tercer paso se realiza la misma operación para cada uno de los tres pequeños triángulos (negros) que se han mantenido, es decir, se eliminan los tres pequeños triángulos equiláteros centrales (blancos) y se mantienen los otros nueve triángulos (negros). De esta forma se continua en cada paso, dividiendo cada triángulo equilátero negro, en cuatro triángulos más pequeños y eliminando el central (blanco) y dejando los exteriores (negros), como se muestra en la siguiente imagen. El triángulo de Sierpinski es el objeto fractal que se obtiene al continuar este proceso de forma infinita.

Los cinco primeros pasos del proceso de construcción del triángulo fractal de Sierpinski

Los cinco primeros pasos del proceso de construcción del triángulo fractal de Sierpinski

La construcción de este fractal de Sierpinski se puede explicar de otra manera. Como antes, partimos en el primer paso de un triángulo equilátero (negro). En el segundo paso se realizan tres copias, de la mitad de altura y la mitad de anchura, del anterior triangulo y se pegan de manera que cada uno de esos tres nuevos triángulos toque a los otros dos por uno de sus vértices, como se observa en la imagen. En el tercer paso se realizaría una operación similar, pero para el objeto geométrico obtenido en el segundo paso. Y así se continua de forma infinita. Esta construcción nos da una idea de la autosemejanza de este fractal.

El triángulo fractal de Sierpinski tras nueve pasos

El triángulo fractal de Sierpinski tras nueve pasos

Como podemos observar, la imagen del pavimento de Santa María en Cosmedin se corresponde con el tercer paso de esta construcción fractal, mientras que el pavimento de Santa María en Trastevere se corresponde con el objeto geométrico tras cinco pasos. Claramente los artesanos romanos que construyeron estos maravillosos pavimentos de estilo cosmatesco, alrededor del siglo XII, no sabían qué era un fractal, pero sí eran capaces de realizar hermosas construcciones geométricas como esta.

La construcción del triángulo fractal de Sierpinski se puede realizar con cualquier otro tipo de triángulo, no necesariamente equilátero. De hecho, en la Basílica de Santa María en Cosmedin también nos encontramos la realización, hasta el tercer paso, para triángulos rectángulos isósceles (véase la siguiente imagen).

Parte del pavimento de la Basílica de Santa María en Cosmedin (Roma), con mosaicos formados por lo que nos recuerda a triángulos fractales de Sierpinski, realizados con triángulos rectángulos isósceles. Fotografía de Marian Espinosa

Parte del pavimento de la Basílica de Santa María en Cosmedin (Roma), con mosaicos formados por lo que nos recuerda a triángulos fractales de Sierpinski, realizados con triángulos rectángulos isósceles. Fotografía de Marian Espinosa

El triángulo de Sierpinski, que nos lo podemos encontrar en diferentes contextos, como el grafo asociado al rompecabezas de la torre de Hanoi (como puede verse en el libro Del ajedrez a los grafos, RBA, 2015) o los patrones geométricos del triángulo de Pascal (véase la entrada de Marta Macho Triangulando: Pascal versus Sierpinsaki, la novela El diablo de los números, de Hans Magnus Enzensberger, publicado en Siruela en 1997, o el libro La gran familia de los números, Catarata, 2021), aparece también asociado al conocido como “juego del caos”, al que vamos a dedicar la última parte de esta entrada.

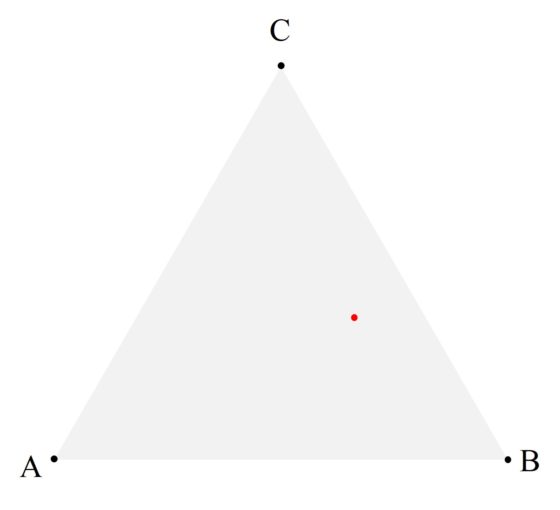

Para jugar al juego del caos se necesita una hoja de papel, un lápiz, una regla y un dado, para una versión manual del mismo. Lo primero que debemos hacer es pintar tres puntos A, B, C que forman un triángulo equilátero, es decir, cada punto está a la misma distancia de los otros dos (aunque el juego funciona para cualquier tipo de triángulo).

Se empieza pintando un punto cualquiera P(0) dentro del triángulo formado por los puntos A, B y C (que hemos pintado de rojo en la imagen siguiente).

A continuación, vamos a lanzar el dado y pintaremos el siguiente punto P(1) en el triángulo en función del resultado:

i) si sale 1 o 2, entonces P(1) será el punto medio entre el punto inicial P(0) y A;

ii) si sale 3 o 4, entonces P(1) será el punto medio entre el punto inicial P(0) y B;

iii) si sale 5 o 6, entonces P(1) será el punto medio entre el punto inicial P(0) y C.

La regla se utiliza para determinar el punto medio entre los dos puntos correspondientes, en cualquiera de las tres circunstancias anteriores. Obtenido el punto P(1), tomamos este punto y calculamos el punto P(2) utilizando el mismo algoritmo anterior, pero considerando P(1) en lugar de P(0). De esta forma, se irán obteniendo los diferentes puntos P(3), P(4), etc. Es decir, obtenidos n puntos mediante este algoritmo, desde P(0) hasta P(n – 1), se calcula el punto P(n) de la misma forma a partir del punto P(n – 1). Esto es,

i) si sale 1 o 2, entonces P(n) será el punto medio entre el punto inicial P(n – 1) y A;

ii) si sale 3 o 4, entonces P(n) será el punto medio entre el punto inicial P(n – 1) y B;

iii) si sale 5 o 6, entonces P(n) será el punto medio entre el punto inicial P(n – 1) y C.

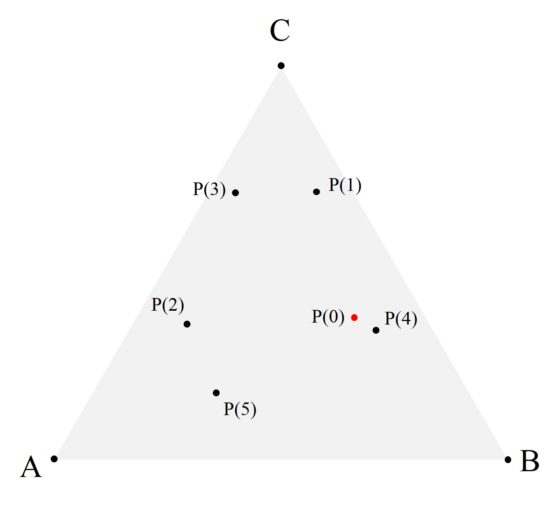

En la siguiente imagen hemos pintado los cinco primeros puntos descritos con este algoritmo, empezando en el punto rojo (que es el punto inicial P(0)), después de sacar con el dado 6, 1, 5, 4 y 1.

Lo sorprendente de este juego es que según se van representando cada vez más puntos mediante ese algoritmo, independientemente de cual sea el punto inicial, empieza a surgir el triángulo de Sierpinski.

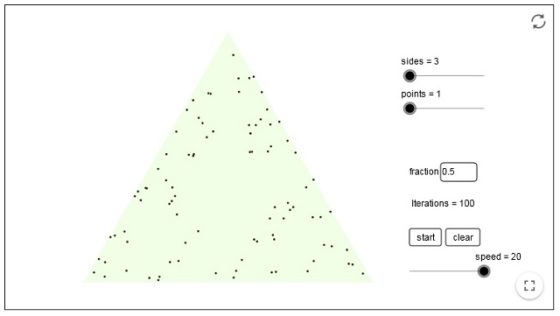

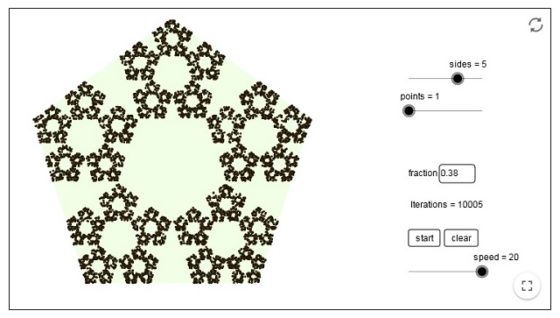

Veamos una sucesión de imágenes –obtenidas con un simulador del juego del caos realizado con Geogebra, diseñado por slik y que podéis ver aquí – que nos ofrecen los diferentes resultados del juego del caos para un determinado punto inicial, tras 100, 500, 1.000, 2.000 y 5.000 pasos.

Este algoritmo fue introducido por el matemático británico Michael Barnsley en su libro Fractals Everywhere (1988) y no solo sirve para triángulos y la mitad de a distancia, sino para polígonos de n lados y una fracción de distancia r. Por ejemplo, para n = 5, sobre un pentágono, y para una fracción de distancia de r = 3/8 se obtiene el siguiente objeto fractal, tras 10.000 pasos.

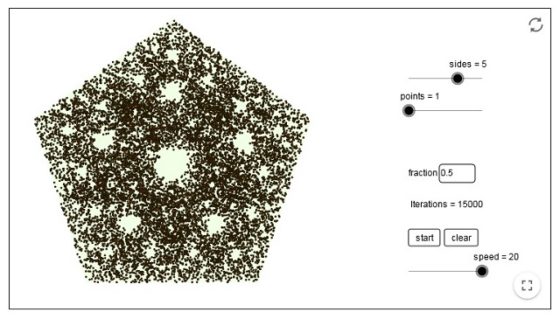

Mientras que si tomamos una fracción de distancia de r = 1/2 el resultado, tras 15.000 pasos es el siguiente conjunto.

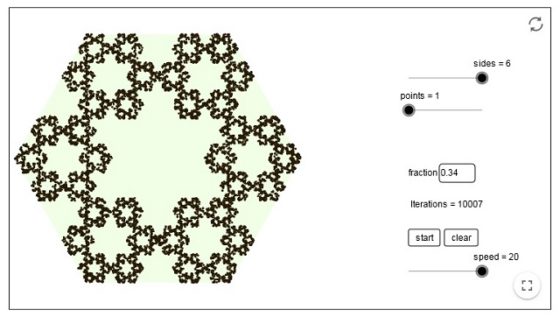

O para n = 6, sobre un hexágono, con una fracción de distancia de r = 3/8 se obtiene el siguiente resultado tras 10.000 pasos.

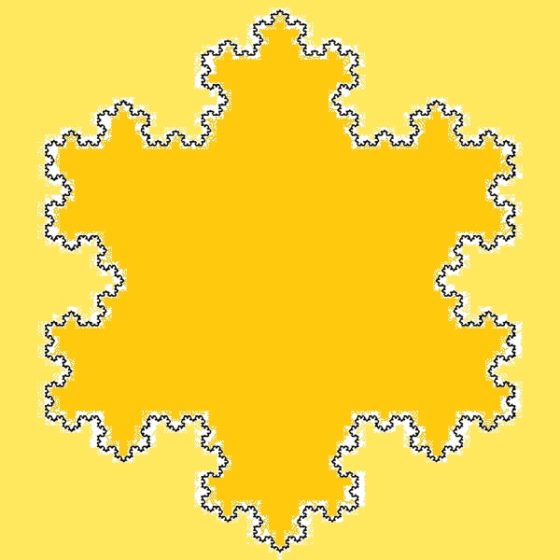

Y en esta última imagen obtenemos un nuevo fractal clásico, el copo de nieve de Koch (véase la entrada Fractus, arte y matemáticas), justo como la frontera interior del mismo.

Imagen de la sexta iteración del copo de nieve de Koch. Imagen de Mcgill a través de Wikimedia Commons

Imagen de la sexta iteración del copo de nieve de Koch. Imagen de Mcgill a través de Wikimedia CommonsSobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo ¿Conocían los romanos el triángulo fractal de Sierpinski? se ha escrito en Cuaderno de Cultura Científica.

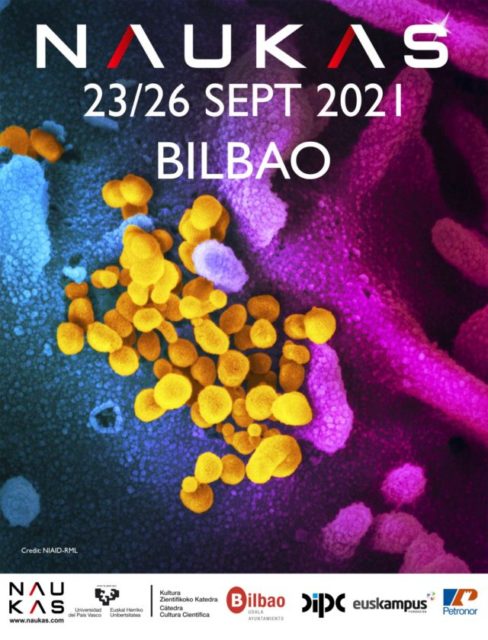

Fritz London: cuando la química se hizo cuántica pero no se lo contaron a Pauling

Fritz London

Fritz LondonLa concesión de la prestigiosa beca Guggenheim en 1926 le dio la oportunidad a Linus Pauling de visitar Europa y trabajar con Bohr en Copenhague, con Sommerfeld en Múnich, y con Schrödinger en Zúrich. Fue en Suiza donde coincidió con Fritz London, un joven filósofo cuyo interés en la mecánica cuántica le había llevado a realizar estudios postdoctorales con Sommerfeld. Pauling también discutiría extensamente de mecánica cuántica con Walter Heitler, que estaba haciendo su doctorado con Herzfeld pero en estrecho contacto con Sommerfeld. Es comprensible la estupefacción de Pauling al enterarse al año siguiente de que Heitler y London eran los autores del primer tratamiento mecanocuántico de un sistema químico: ninguno de los dos le había dicho nada de su trabajo en común. Años más tarde el propio Pauling describiría el acontecimiento como “la mayor contribución a la concepción química de valencia” desde la introducción por Lewis de la idea de par compartido en 1916.

Heitler, Pauling, Ava Pauling, London. Múnich, 1927. La mirada entre Heitler y London podría interpretarse como un «si este supiera».

Heitler, Pauling, Ava Pauling, London. Múnich, 1927. La mirada entre Heitler y London podría interpretarse como un «si este supiera».Fritz London nació en 1900 en Breslavia (Breslau en alemán, Wrocław en polaco) en el seno de una próspera y cultivada familia germano-judía. Su padre era profesor de matemáticas en Breslavia (después lo sería en Bonn) y su madre era la hija de un fabricante de tejidos. London recibiría una educación clásica en Bonn lo que alimentaría su interés por la filosofía. Estudió esta disciplina en Bonn, Frankfurt y Múnich. Con sólo 21 años recibió un doctorado (summa cum laude) por la universidad de Múnich tras presentar una tesis espectacular: sin supervisión alguna, había elaborado toda una presentación de la teoría del conocimiento basada en el lenguaje simbólico y los métodos desarrollados por Peano, Russell y Whitehead. Presentó este trabajo como tesis de doctorado solo después de que Pfänder, que lo había recibido para comentarios, le animase a ello.

Las querencias filosóficas son detectables en todo el trabajo de London, caracterizado por una búsqueda constante de los principios generales y la exploración concienzuda de las bases lógicas de los temas elegidos. Nunca fue un mero calculista. Así, por ejemplo, en 1939 publicó con Ernst Bauer una breve monografía (en francés) sobre la teoría de la medida en mecánica cuántica.

Durante los tres años posteriores a la presentación de su tesis, London escribiría dos artículos filosóficos más y se ganaría la vida como profesor de instituto en varios lugares de Alemania. Pero sus intereses iban concretándose y en 1925 toma la decisión de volver a Múnich para trabajar en física teórica con Sommerfeld. Tras este período trabajaría con Ewald en Stuttgart y en Zúrich y en Berlín con Schrödinger.

En 1933 la persecución nazi llevó al judío London a abandonar Alemania. Pasaría dos años en Oxford y otros dos en París en el Institut Henri Poincaré. Finalmente, en 1939, aceptó el puesto de profesor de química teórica (el equivalente hoy sería química física) en la universidad Duke en Estados Unidos, donde permanecería hasta su muerte.

Entre 1925 y 1934 los intereses de London se centraron en la espectroscopía y en la nueva mecánica cuántica, especialmente aplicadas al estudio y caracterización del enlace químico. En 1927, como vimos, Heitler y London produjeron su tratamiento mecanocuántico de la molécula de hidrógeno.

Su problema era calcular la energía de la molécula de hidrógeno en la que dos electrones se mantienen unidos a dos protones. Si los núcleos estuviesen muy alejados la energía del sistema sería esencialmente la de dos átomos de hidrógeno separados, y sólo habría que considerar la interacción entre un electrón y un protón. Pero cuando los núcleos están próximos hay que considerar cuatro interacciones. Usando teoremas matemáticos que lord Rayleigh había desarrollado para estimar la energía mínima de una campana, Heitler y London pudieron ignorar el espinoso problema de la distribución efectiva de los electrones. La demostración de Heisenberg de que los electrones son indistinguibles (resonancia) les permitió hacer más simplificaciones.

Con todas estas aproximaciones consiguieron una expresión lo suficientemente simple de la ecuación de Schrödinger que la hacía manejable para obtener la ecuación de onda del hidrógeno. La solución arrojaba valores de la energía de enlace increíblemente próximos a los obtenidos experimentalmente a partir de estudios espectroscópicos.

Cuando hoy día lees un libro de texto que trate del enlace químico solo encontrarás, si acaso, el nombre de Pauling. Incluso en muchos textos de química física el desarrollo de Heitler y London aparece anónimamente. No solo eso, en algunas historias de la química la teoría del enlace parece una creatio ex nihilo de Pauling. Sabemos que no fue así y quizás, también, intuyamos por qué Heitler y London decidiesen, como años más tarde harían Watson y Crick, no anticipar nada de su trabajo a Pauling.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Una versión anterior de este texto se publicó en Experientia Docet el 7 de abril de 2013.

El artículo Fritz London: cuando la química se hizo cuántica pero no se lo contaron a Pauling se ha escrito en Cuaderno de Cultura Científica.

Kelvin, padre de la termodinámica: cuando la religión inspira a la ciencia

Javier Sánchez Cañizares

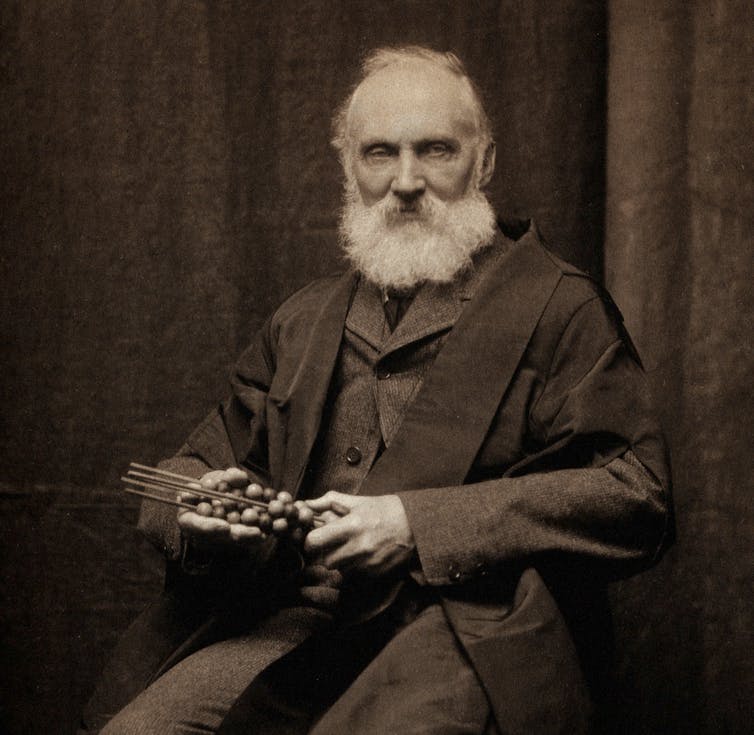

William Thomson, baron Kelvin fotografiado por T R Annan. Fuente: Wikimedia Commons / Wellcome Collection, CC BY-SA

William Thomson, baron Kelvin fotografiado por T R Annan. Fuente: Wikimedia Commons / Wellcome Collection, CC BY-SA

El 17 de diciembre se cumplen 114 años del fallecimiento de William Thomson, también conocido como barón Kelvin, uno de los físicos más reconocidos del siglo XIX por su aportación a la termodinámica. Su título nobiliario da nombre a la unidad de temperatura medida a partir del cero absoluto. Kelvin fue un elder (dirigente laico en la Iglesia de Escocia) de la Iglesia de St. Columba en Largs durante muchos años, y un cristiano devoto a lo largo de toda su vida. Al igual que otros muchos científicos antes y después que él, no veía conflicto alguno entre la ciencia y sus creencias.

Sus biógrafos coinciden en afirmar que buscaba soluciones a los problemas dentro del curso normal de la naturaleza. Al mismo tiempo, entendía las leyes de la naturaleza como la obra de una inteligencia creativa, de modo que la fe informaba y apoyaba su trabajo científico. Cuanto más profundizaba en su investigación, más próximo se sentía al teísmo.

Curiosamente, la nueva disciplina que fundó junto a otros físicos le llevó a entrar en polémica con la contemporánea teoría de la evolución mediante selección natural, sobre la que albergaba serias dudas. El problema residía en que la teoría de la evolución prestaba poca atención al enorme lapso de tiempo necesario para que la vida evolucione, mediante pequeños cambios, hasta alanzar la complejidad que hoy conocemos. Se aceptaba implícitamente una edad de la Tierra indefinida, según la visión geológica uniformista, que permitiría a los cambios aleatorios y a la selección natural realizar pacientemente su trabajo.

Pero las cosas no eran tan sencillas para Kelvin quien, precisamente gracias a los avances termodinámicos, comenzó a realizar estimaciones cada vez más precisas sobre el tiempo que nuestro planeta lleva existiendo. Los números del barón no cuadraban y la Tierra sería demasiado joven para que la estrategia de ensayo y error de la evolución pudiera producir una biosfera tan variada como la que observamos. Estos argumentos causaron dolores de cabeza al propio Darwin.

No obstante, el descubrimiento de la radiactividad, a finales del siglo XIX, abrió la posibilidad a una fuente de energía desconocida por Kelvin, que hacía irrelevantes sus cálculos sobre la antigüedad real de la Tierra y permitió al darwinismo respirar tranquilo. Sí. Había suficiente tiempo para la evolución.

La termodinámica entra en escena