Dozena erdi ariketa 2021eko udarako (5): Perimetroaren bila

Gogoan izan ahalegina bera –bidea bilatzea– badela ariketa. Horrez gain, tontorra (emaitza) lortzen baduzu, poz handiagoa. Ahalegina egin eta emaitza gurekin partekatzera gonbidatzen zaitugu. Ariketaren emaitza –eta jarraitu duzun ebazpidea, nahi baduzu– idatzi iruzkinen atalean (artikuluaren behealdean daukazu) eta irailean emaitza zuzenaren berri emango dizugu.

Hona hemen gure bosgarren ariketa: Perimetroaren bila.

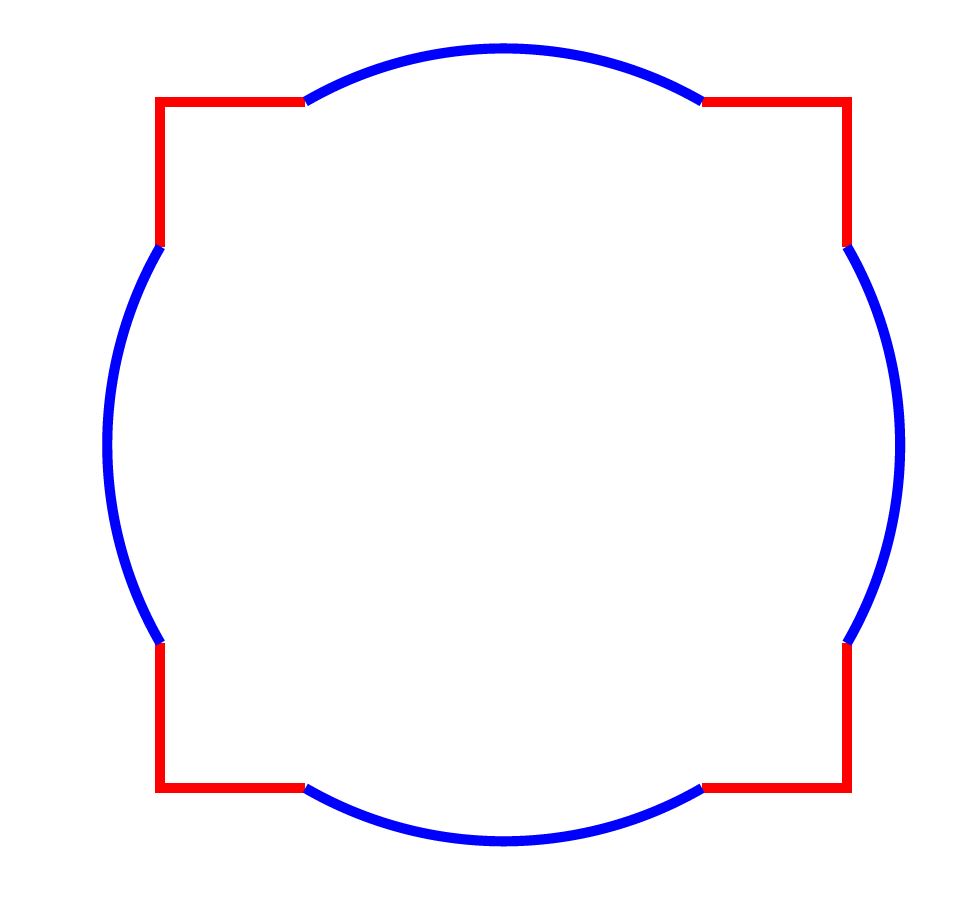

Goiko irudia egiteko √12 zentimetroko aldea duen karratu bat 2 zentimetroko erradioa duen zirkulu baten gainean ezarri dugu, biak zentro bera izanik. Zein da irudiaren perimetroa?

———————————————————————————-

Ariketak “Calendrier Mathématique 2021. Un défi quotidien” egutegitik hartuta daude. Astelehenetik ostiralera, egun bakoitzean ariketa bat proposatzen du egutegiak. Ostiralero CNRS blogeko Défis du Calendrier Mathématique atalean aste horretako ariketa bat aurki daiteke.

———————————————————————————-

Utzi zuen erantzuna iruzkinetan!

The post Dozena erdi ariketa 2021eko udarako (5): Perimetroaren bila appeared first on Zientzia Kaiera.

Los fenicios fueron los primeros en circunnavegar África hace más de 2500 años

En 2010 Phillip Beale, con la réplica de un barco fenicio, demostró que un barco así podía circunnavegar África.

En 2010 Phillip Beale, con la réplica de un barco fenicio, demostró que un barco así podía circunnavegar África.Los fenicios contribuyeron muy significativamente al conocimiento antiguo en dos ámbitos principalmente: geografía y navegación. Los fenicios fueron los grandes marineros de la antigüedad, navegando en expediciones comerciales desde sus ciudades portuarias de Tiro, Sidón y Biblos en el Mediterráneo oriental. Abrieron toda la región mediterránea al comercio, navegando más allá del Estrecho de Gibraltar (los Pilares de Heracles) a finales del segundo milenio a.e.c.

Fundaron las ciudades portuarias de Cartago y Útica en el norte de África y Cádiz en España y los griegos estaban convencidos de que los fenicios habían creado la ruta comercial con Tartessos en la costa atlántica de la península ibérica. Fueron los fenicios de Cartago los encargados de crear un gran imperio comercial que se extendía desde el norte de África hasta Sicilia e Iberia y en el Atlántico desde las Islas Británicas hasta la costa occidental de África. La comprensión algo errática de Homero de la geografía en la Odisea debe mucho a la exploración fenicia.

Los griegos, que emergieron de su Edad Media en el siglo VIII a.e.c., tomaron prestado el alfabeto fenicio. Irónicamente, pocos registros sobreviven de las ciudades-estado fenicias, incluida Cartago. Las fuentes sobre la exploración y la ciencia fenicias son escritores griegos y romanos.

Fuente: Wikimedia Commons

Fuente: Wikimedia CommonsHeródoto, escribiendo a mediados del siglo V a.e.c., describió en detalle a los pueblos del antiguo Oriente Próximo, registrando historias que había escuchado sobre los fenicios. Le dijeron, por ejemplo, que cuando el rey persa Jerjes marchaba contra los griegos en el 480 a.e.c., ordenó a los fenicios que construyeran un puente a través del Helesponto (el estrecho de los Dardanelos), el estrecho que separa Asia de Europa. Los constructores de puentes fenicios atravesaron el estrecho amarrando barcos juntos, uno al lado del otro, con gruesas cuerdas hechas de lino; finalmente colocaron enormes tablones a las cubiertas de los barcos que permitieron el paso de cientos de miles de tropas persas, la marabunta de servidores y comerciantes que seguía al ejército y todos los animales asociados a ambos grupos.

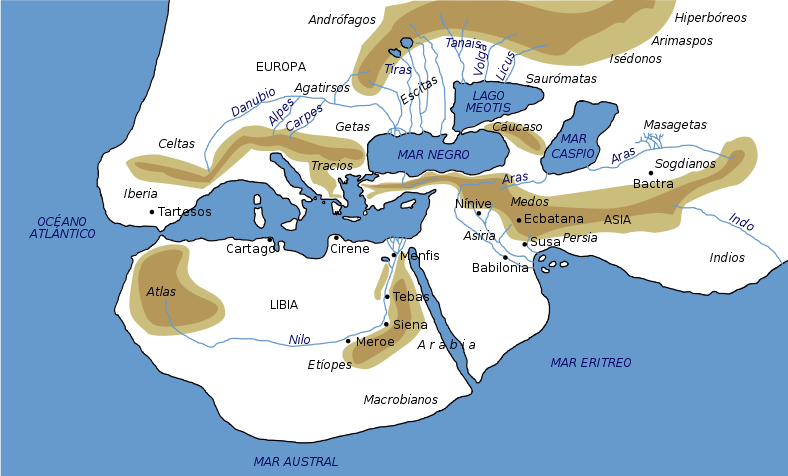

El mundo según Heródoto. Fuente: Wikimedia Commons

El mundo según Heródoto. Fuente: Wikimedia CommonsHeródoto también describió una de las más grandes expediciones de exploración de todos los tiempos. La conoció gracias a los egipcios, cuando viajó a Egipto para investigar para su libro. El faraón Necao II había ordenado, alrededor del año 600 a.e.c., a los marineros fenicios que descubrieran la extensión y la naturaleza de África, llamada por los griegos Libia. En el libro 4 de Historias, Heródoto narra el viaje de los fenicios, quienes zarparon desde el extremo norte del Mar Rojo, salieron al Océano Índico y prosiguieron a lo largo de la costa oriental de África. Sus pequeños barcos de madera eran lo suficientemente marineros como para navegar por las aguas someras cercanas a la costa. Heródoto afirma que haciendo gala de una excelente planificación y paciencia, hacían puerto al entrar el otoño, sembraban semillas, esperaban, exploraban y cazaban, recogían la cosecha y luego continuaban el viaje descansados, con la primavera bien entrada y bien provistos de alimentos. Emplearon más de dos años en hacer el viaje, durante el cual observaron y registraron sus hallazgos. Tras circunnavegar el continente, rodeando el Cabo de Buena Esperanza navegando de este a oeste, entraron en aguas del Atlántico y navegaron por la costa de África hasta el golfo de Guinea. Luego rodearon el cuerno de África, luchando contra los vientos y las corrientes contrarias, hasta llegar finalmente a los Pilares de Heracles y al Mediterráneo.

Una vez de regreso al río Nilo, informaron a Necao de un extraño fenómeno. Navegando hacia el oeste desde el océano Índico al Atlántico, rodeando el Cabo de Buena Esperanza, veían el sol en el lado de babor (a la derecha del sentido de avance) de sus barcos. Cuando Heródoto escuchó esto, se mostró incrédulo, sabiendo por su experiencia que los barcos que navegaban hacia el oeste en el Mediterráneo siempre tenían el sol a estribor (a la izquierda). De todos modos, registró la dudosa historia, proporcionando así a los observadores posteriores una clara evidencia de que los fenicios habían cruzado el Trópico de Capricornio hacia el hemisferio sur, donde para los viajeros que van de este a oeste, los rayos del sol siempre están hacia el norte.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Los fenicios fueron los primeros en circunnavegar África hace más de 2500 años se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Hace 16 años ya: el hundimiento del Prestige

- Flores en su tumba, hace 16.000 años

- Técnicas artísticas de hace 40.000 años

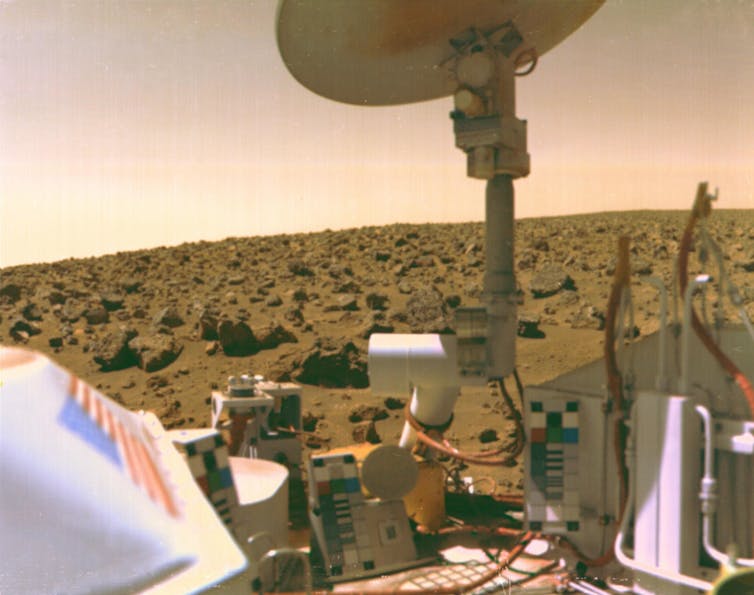

15 años con el planeta enano Plutón

Carlos de la Fuente Marcos

Tras intensos debates en la comunidad astronómica mundial y a pesar de las protestas de muchos aficionados, el 24 de agosto de 2006 Plutón dejó de ser un planeta y pasó oficialmente a ser un planeta enano. Mientras se acaba de zanjar la polémica, este cautivador mundo helado se ha convertido en la primera etapa de una nueva época de descubrimientos en los confines del sistema solar.

Imagen de Plutón captada por la nave New Horizons de la NASA cuando pasó cerca de este planeta enano en julio de 2015. Fuente: NASA/JHUAPL/SwRI

Imagen de Plutón captada por la nave New Horizons de la NASA cuando pasó cerca de este planeta enano en julio de 2015. Fuente: NASA/JHUAPL/SwRIHace casi un siglo, el 14 de marzo de 1930, periódicos de todo el mundo se hacían eco del descubrimiento de Plutón con titulares como este: “Descubierto el noveno planeta al borde del sistema solar: el primero encontrado en los últimos 84 años”.

Su clasificación como planeta se mantuvo durante décadas, pero justo hace ahora 15 años, el 24 de agosto de 2006, pierde ese estatus y pasa a ser clasificado como ‘planeta enano’, tras un encendido debate en la XXVI Asamblea General de la Unión Astronómica Internacional (UAI) celebrada en Praga (República Checa) y la subsiguiente votación: 237 votos a favor del cambio, 157 en contra y 17 abstenciones.

Pocos acontecimientos han dividido tanto a la comunidad astronómica mundial, tanto aficionada como profesional, como la reclasificación de Plutón. Sin embargo, este tipo de reclasificaciones de objetos una vez que se ha comprendido mejor su naturaleza no es ajena a la historia de la propia astronomía.

Ahí está el caso de Ceres. Cuando Giuseppe Piazzi anunció su descubrimiento el 24 de enero de 1801, los únicos objetos del sistema solar conocidos eran los ocho planetas, algunas de sus lunas y los cometas. Lógicamente y tras calcularse su órbita con una precisión razonable, Ceres fue clasificado en principio como planeta.

Asteroides y planetas menores

Pero los años pasaron y aunque los libros y otros materiales educativos seguían hablando del planeta Ceres, la comunidad astronómica continuó encontrando objetos con propiedades similares. Herschel acuñó el término ‘asteroide’en 1802 para referirse a ellos, el almanaque británico The Nautical Almanac and Astronomical Ephemeris comenzó a denominarles ‘planetas menores’ en 1841, y el Observatorio Naval de EEUU como ‘pequeños planetas’ en 1868.

Las palabras asteroide y planeta menor fueron aceptadas rápidamente por la comunidad astronómica y las designaciones estándar (1 Ceres, 2 Palas, 3 Juno, etc.) para los asteroides fueron adoptadas en 1851.

No fue necesario realizar una votación oficial para reclasificar a Ceres. El tiempo y la ausencia de una directriz oficial posibilitaron una transición paulatina y sin traumas.

A medida que se produjeron nuevos descubrimientos, la comunidad astronómica comprendió que estos eran fundamentalmente distintos de los planetas conocidos y dejó paulatinamente de referirse a ellos como planetas, comenzando a llamarles asteroides, planetas menores o cuerpos menores, aunque esta última acepción también incluye a los cometas.

De hecho, es poco habitual encontrar en publicaciones del siglo XX referencias a Ceres o a alguno de los asteroides del cinturón principal como planetas. El caso de Plutón guarda cierto paralelismo con el de Ceres, aunque el primero haya sido reclasificado oficialmente.

Unos años antes, el 30 de agosto de 1992, David C. Jewitt y Jane X. Luu observando desde el observatorio de Mauna Kea en Hawái (EE UU) descubrieron 15760 Albion, cuya designación provisional fue 1992 QB1. Era la primera vez que se descubría un objeto tan distante como Plutón y la prensa no tardó en referirse a él como el décimo planeta.

Pero poco duró: cientos de los llamados objetos transneptunianos fueron descubiertos entre 1992 y 2006, cuando la UAI decidió reclasificar a Plutón. Algunos tienen órbitas similares a la suya, otros se mueven en trayectorias mucho más excéntricas y distantes.

Varios de los objetos transneptunianos descubiertos, en concreto Eris (cuyo estudio condujo al ‘destierro’ de Plutón como planeta), Makemake y Haumea, rivalizan en tamaño con Plutón o lo superan. Junto a Ceres, son los cinco planetas enanos.

Comparación aproximada de tamaños de los planetas enanos Plutón (con su satélite Caronte), Haumea, Eris, Makemake y Ceres respecto a la Tierra y la Luna. Fuente: NASA, ESA, JPL, A. Feild (STScI)

Comparación aproximada de tamaños de los planetas enanos Plutón (con su satélite Caronte), Haumea, Eris, Makemake y Ceres respecto a la Tierra y la Luna. Fuente: NASA, ESA, JPL, A. Feild (STScI)Plutón había dejado de ser un objeto único, peculiar o especial. Como Ceres, para muchos ahora estaba claro que es fundamentalmente diferente de los ocho planetas clásicos, aunque haya sido también visitado por nuestras sondas espaciales. En concreto, por la nave New Horizons de la NASA, que el 14 de julio de 2015 se aproximó a una distancia de 12.500 km de Plutón.

Sin embargo, su naturaleza misteriosa había cautivado durante décadas la imaginación tanto del público en general como de sectores de la comunidad astronómica. Un cambio drástico como el que se votó aquel 24 de agosto de 2006 tenía que ser necesariamente polémico y suscitar reacciones encontradas.

Pasar página a una controversia que sigue

Desafortunadamente, la controversia asociada a la decisión de reclasificar a Plutón como planeta enano todavía persiste quince años después. Quizás ya es hora de mirar hacia adelante y dejar de lado controversias improductivas. En su momento, Plutón representó el salto de una barrera, la de las 30 unidades astronómicas o UA (1 UA es la distancia media entre la Tierra y el Sol, y 30 es la distancia media entre Neptuno y el Sol).

Pero los nuevos descubrimientos nos han llevado mucho más allá, abriéndonos horizontes previamente inexplorados, despejando viejas incógnitas y trayéndonos infinidad de nuevas cuestiones a resolver.

La controversia de Plutón ha restado brillo al reciente cruce de una nueva barrera, la de las 100 UA que define de forma aproximada el denominado frente de choque de terminación y la heliopausa o frontera que separa el viento solar del medio interestelar.

El 17 de diciembre de 2018 se anunció el descubrimiento de 2018 VG18 o FarOut, el primero objeto del sistema solar encontrado a una distancia más allá de 100 UA. Lo encontraron los astrónomos estadounidenses Scott S. Sheppard, David J. Tholen y Chadwick Trujillo a casi 124 UA de la Tierra.

Pero afortunadamente las buenas noticias no acaban aquí. El 10 de febrero de 2021, el mismo equipo anunció el descubrimiento de un objeto aún más lejano: 2018 AG37 (apodado Farfarout), situado a más de 132 UA.

La ventana de las 100 UA ya está abierta y la comunidad astronómica está lista para empezar a explorarla. Los astrónomos Malena Rice y Gregory Laughlin de la Universidad de Yale (EE UU) anunciaron en diciembre de 2020 el descubrimiento, con el telescopio espacial TESS, de ocho objetos situados a más de 100 UA, incluyendo un candidato localizado a más de 200 UA.

¿Nuevos planetas en el sistema solar?

Pero esto puede ser sólo el principio. El Atacama Cosmology Telescope (ACT) ha observado en microondas varios objetos candidatos situados a distancias de entre 300 UA y 2000 UA. La colaboración encabezada por Sigurd Naess cree que alguno de ellos podría corresponder a un cuerpo celeste con una masa igual o superior a las cinco masas terrestres; es decir, se trataría de un planeta propiamente dicho, pero de menor masa que Urano y Neptuno.

La confirmación y el eventual estudio de objetos tan remotos como estos necesitan de los mayores telescopios disponibles, como el Gran Telescopio Canarias (GTC) de 10,4 metros de diámetro, actualmente el mayor telescopio óptico operativo completamente orientable.

GTC ha sido capaz de observar 2018 VG18 y 2018 AG37 y ha comenzado un sondeo para intentar recuperar los candidatos anunciados por la colaboración ACT y quizás otros nuevos. Las primeras observaciones ya han sido realizadas y el análisis de los datos está en curso. Se esperan resultados preliminares antes de que acabe el año.

El descubrimiento de Plutón fue solo el principio, gracias a disponer de telescopios de mayor tamaño y de mejor tecnología ahora podemos ir mucho más allá. Probablemente surgirán nuevas controversias científicas, pero la exploración del sistema solar más distante, que comenzó con el hallazgo de Plutón, sin duda nos va a deparar grandes descubrimientos en los próximos años.

Diferencia entre planeta y planeta enano

En la misma asamblea de 2006 donde la UAI acordó que Plutón es un planeta enano, se definió planeta como un cuerpo celeste que (a) está en órbita alrededor del Sol, (b) tiene suficiente masa para que su autogravedad supere las fuerzas del cuerpo rígido, de modo que asume una forma de equilibrio hidrostático casi redonda, y (c) ha despejado [de objetos] la vecindad alrededor de su órbita.

En el caso de los planetas enanos coinciden los puntos (a) y (b), aunque respecto a que deben ser aproximadamente esféricos, alguno como Haumea es más bien elipsoidal. Pero en lo que son diferentes es en la (c), ya que los planetas enanos no han limpiado la vecindad alrededor de su órbita, es decir, puede tener objetos de similar tamaño en órbitas relativamente cercanas. En los planetas, no.

Por ejemplo, coorbitando con la Tierra se mueven los Arjunas, un tipo de objetos cercanos con período orbital en torno al Sol virtualmente idéntico al de nuestro planeta. Puede que haya cientos o incluso miles de ellos. Sin embargo, los Arjunas más grandes tienen tamaños del orden del kilómetro, miles de veces más pequeños que nuestro planeta.

Sin embargo, en el caso de los objetos del cinturón de Kuiper, hay varios con tamaños similares al de Plutón.

Sobre el autor: Carlos de la Fuente Marcos es astrónomo de la Universidad Complutense de Madrid (UCM), especialista en objetos transneptunianos.

Este artículo se publicó originalmente en SINC. Artículo original.

El artículo 15 años con el planeta enano Plutón se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El planeta enano Haumea tiene anillo

- #Naukas15 El año que descubrimos Plutón

- Planeta océano: el corazón líquido que nos mantiene vivos

Gaixotasun zeliakoa listuaren bidez diagnostikatzeko metodoa

Eritasun zeliakoa asaldu autoimmune konplexu bat da, eta genetikoki aurrez prestatuta dauden pertsonei eragiten die. Egun, diagnostikoa baieztatzeko endoskopia egitea beharrezkoa da. Hau prozedura desatsegina izateaz gain, nahiko garestia izaten da. Alde batetik, gaixotasun zeliakoaren sintomatologia duten pazienteei endoskopia egiten zaie, baina kontuan euki behar da sintomak (tripako mina, pisu galera edo anemia, besteak beste) oso arruntak izaten dira, alegia, beste gaixotasun askoren antzekoak. Era berean, gaixotasun zeliakoa garatzeko arrisku handiena ematen duen aldaera genetikoa populazio osasuntsuaren ehuneko handi batean dago. Ondorioz, sintoma eta arrisku genetikoa duten paziente ez-zeliako askori behar ez den endoskopia bat egiten zaie.

Irudia: Listu laginen bilketa odola ateratzea baina erosoagoa da. (Argazkia: Tho-Ge – Pixabay lizentziapean. Iturria: pixabay.com)

Irudia: Listu laginen bilketa odola ateratzea baina erosoagoa da. (Argazkia: Tho-Ge – Pixabay lizentziapean. Iturria: pixabay.com)Orain, Ikerbasqueko eta UPV/EHUko ikertzaileek, Biodonostia eta Biocruces institutuekin eta Txagorritxu eta Galdakaoko ospitaleekin lankidetzan, burutu berri duten ikerketa batean, gaixotasun zeliakoaren diagnostikoan laguntzeko metodo ez inbaditzaile bat garatu dute listua erabiliz. Endoskopia horiek ekidin edota murrizte aldera, ikerketa honetan listua erabiliz gaixotasun zeliakoa diagnostikatzeko metodo ez inbaditzaile baten garapena posible dela erakutsi dute.

Metodoa garatzeko prozeduraLehenik eta behin, listuan ere zeliakoen hestean ikusten den inflamazioa ikusteko gai zirela ziurtatu zuten Ainara Castellanos ikerlari nagusiak eta Maialen Sebastian doktoratu aurreko ikasleak. Ondoren, paziente zeliakoen eta paziente kontrolen (hau da, paziente ez zeliako) listu laginetan inflamazioa kuantifikatu zuten. Listu lagin horietan gaixotasun zeliakoaren arrisku genetika ere aztertu zuten. Datu hauekin (inflamazioa eta arrisku genetika) iragarpen formula bat sortu zuten. Azkenik, eredu honen iragarpen ahalmena 100 listu laginetan itsuan frogatu zuten eta lortutako asmatze tasa %73koa izan zen. Gainera, euren iragarpen ereduak %91ko sentikortasuna aurkeztu zuen, hau da, gaixotasun zeliakoa dutenen artean asmatze tasa %91koa izan zen.

Iragarpen ereduak sentikortasun altua du eta beraz, gaixotasun zeliakoaren diagnostikoa baztertzeko egokia izan daiteke. Era berean, gogoratu behar da ereduarekin emaitza onak lortu diren arren ez dela %100 zehatza, eta beraz gaur egungo diagnostiko metodo tradizionala ezin dela guztiz baztertu. Ondorioz, eredu honek zeliakotzat iragartzen dituen pazienteei endoskopia egin beharko zaie. Edozein kasutan ere, metodo hau erabiliz egiten diren endoskopia kopurua asko murriztuko litzateke.

Gainera, konprobatu da, listu lagin berdinean gaixotasunaren arrisku genetika ere aztertu ahal denez, odolean egiten diren proba genetikoen alternatiba ez-inbaditzailea ere izan daitekela, listu laginen bilketa odola ateratzea baina erosoagoa baita.

Iturria:UPV/EHU prentsa bulegoa: Gaixotasun zeliakoa diagnostikatzeko metodo ez inbaditzailea.

Erreferentzia bibliografikoa:Sebastian-delaCruz M, Olazagoitia-Garmendia A, Madrigal AH, Garcia-Etxebarria K, Mendoza LM, Fernandez-Jimenez N, Casales ZG, Navarro EdlC, Calvo AE, Legarda M, Tutau C, Irastorza I, Bujanda L, Bilbao JR, Castellanos-Rubio A. (2021). A novel non-invasive method based on salivary inflammatory biomarkers for the screening of celiac disease. Non-invasive diagnosis for celiac disease. Cellular and Molecular Gastroenterology and Hepatology DOI:10.1016/j.jcmgh.2021.05.01

The post Gaixotasun zeliakoa listuaren bidez diagnostikatzeko metodoa appeared first on Zientzia Kaiera.

El velo de la ignorancia en mangostas

Fuente: Wikimedia Commons

Fuente: Wikimedia CommonsLas mangostas rayadas, Mungos mungo, no crían a su propia progenie. En casi todos los grupos de la especie las hembras adultas dan a luz el mismo día. La sincronía viene de semanas atrás. Todas entran en celo alrededor del décimo día después de haber parido. Tras quedar preñadas de nuevo, las que completan la gestación dan a luz a sus crías en un cubil bajo tierra. Se forma así una especie de camada comunal compartida.

Esa ajustada sincronía parece eliminar las claves de la maternidad, los elementos que permiten identificar a las crías propias. Durante el primer mes de vida de las recién nacidas, las madres amamantan a unas y otras con independencia de si son suyas o no; es más, las crías maman de diferentes madres. Ahora bien, en las raras ocasiones en que sí hay claves de maternidad, como cuando no se sincroniza la reproducción de todo el grupo de madres, o cuando a las de más edad se les suministran anticonceptivos, unas hembras matan a las crías de las otras en vez de cuidar de ellas. Esto sugiere que esas claves no existen en las camadas comunales sincrónicas propias de condiciones normales.

Transcurrido el periodo en que las crías son amamantadas, salen de la hura y se asocian de forma biunívoca con adultos, sus escoltas, que pueden ser cualquier macho o hembra del grupo, con independencia del grado de parentesco que haya entre ellos. Cada escolta se ocupa de su cachorro, lo alimenta y protege hasta que, con unos noventa días de edad, es capaz de mantenerse por sí mismo. Tanto los escoltas como las crías contribuyen a mantener el vínculo entre ambos. El escolta reconoce de forma individual y responde preferentemente a las llamadas del cachorro al que cuida, y lo busca activamente si se separa o se pierde. Lo alimenta casi de manera exclusiva; el cachorro recibe casi todo el alimento de su escolta y le pide comida de forma continua.

Salvo en los insectos sociales, en las especies en que hay cuidado parental, los progenitores cuidan de sus propios descendientes. De esa manera son ellos y, con ellos, sus propios genes, los que tienen mayor probabilidad de perpetuar su linaje. En Mungos mungo no ocurre tal cosa.

En un experimento reciente con mangostas rayadas en que se suministró más alimento a un grupo de madres que a otras, se observó que las que contaban con más recursos alimentaban preferentemente a las crías de menor tamaño. Crecían de esa forma más que las otras, y acababan teniendo todas similar peso. Así pues, en esta especie las madres invierten los recursos para la crianza de manera que minimizan el riesgo de que su propia progenie se encuentre en posición de desventaja, en vez de hacerlo de manera que la privilegien. Y es la ignorancia acerca de la relación de parentesco la que permite que se produzca la redistribución de recursos que reduce las posibles desigualdades.

Hasta ahora, solo en nuestra especie sabíamos de la disposición a pagar un precio por atenuar desigualdades, aunque tales desigualdades pudieran favorecer a los individuos que lo pagan. Se favorece así la cooperación, porque cuando hay incertidumbre con respecto al retorno esperable del desempeño de diferentes roles sociales, el compartir de forma igualitaria los recursos asegura a quienes interaccionan frente al riesgo de encontrarse en posición de desventaja. Las mangostas se comportan de acuerdo con la lógica del “velo de la ignorancia” de John Rawls: al ignorar quiénes son sus crías, el trato que les dan tiende a eliminar las desigualdades entre ellas.

Fuente: Marshall, H.H., Johnstone, R.A., Thompson, F.J. et al. (2021): A veil of ignorance can promote fairness in a mammal society. Nat Commun 12, 3717.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo El velo de la ignorancia en mangostas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La reacción de las madres al llanto de los bebés es universal

- Cuando se escoge la ignorancia

- La frontera de la ignorancia no deja de expandirse, por Juan Ignacio Pérez

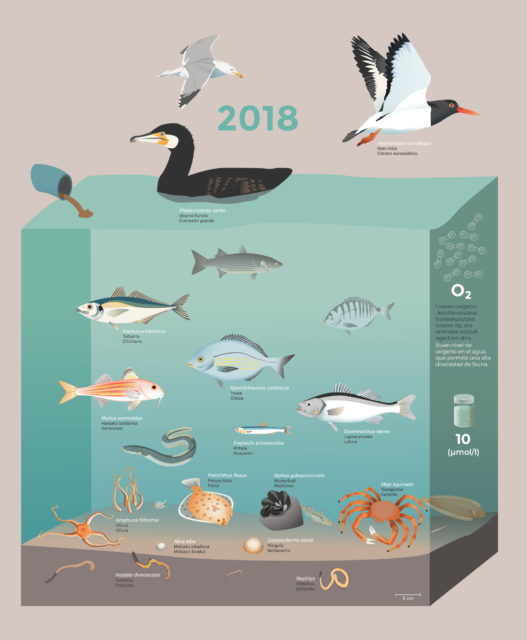

Infraestructuras para el retorno de la vida a la ría del Nervión

En primer término la estación depuradora de aguas residuales (EDAR) de Galindo. Fuente: FYSEG

En primer término la estación depuradora de aguas residuales (EDAR) de Galindo. Fuente: FYSEGBizkaia tuvo un enorme desarrollo económico, tecnológico y social en la segunda mitad del siglo el siglo XIX, y alcanzó su máximo esplendor a finales de ese siglo y a principios del siglo XX. Este desarrollo fue consecuencia de la confluencia de varios factores, entre los que se encontraba la explotación eficiente de los recursos minerales del territorio. La industrialización asociada en el entorno de la ría del Nervión supuso un impacto ecológico enorme en el que solo las especies animales muy resistentes a la contaminación podían subsistir. La recuperación de la ría supuso una decidida inversión en infraestructuras con la vista puesta en el largo plazo, que es nuestro hoy. El vídeo forma parte del proyecto «La Ría del Nervión a la vista de las ciencias y las tecnologías».

Edición realizada por César Tomé López

El artículo Infraestructuras para el retorno de la vida a la ría del Nervión se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Recuperación de fauna en la ría de Bilbao

- La ría de Bilbao como medio de transporte de mineral

- La Ría del Nervión a vista de ciencia y tecnología

Alta velocidad: ineficiente, injusta e insostenible

David Hoyos, Andoni Kortazar y Gorka Bueno Mendieta

Un tren de alta velocidad a su paso por el viaducto de Roden (Zaragoza). Foto: Shutterstock / pedrosala

Un tren de alta velocidad a su paso por el viaducto de Roden (Zaragoza). Foto: Shutterstock / pedrosala

En 2022 se cumplirán 30 años desde la puesta en marcha de la primera línea de alta velocidad en España, Madrid-Sevilla. Tras más de 56 000 millones de euros invertidos en la segunda red más extensa del mundo (3 086 km), los argumentos sociales, económicos y ambientales favorables al modelo español de alta velocidad ferroviaria se han desvanecido a la luz de la evidencia científica acumulada.

La emergencia climática no hace sino apuntalar el sinsentido del AVE y urge a repensar la política española de transportes con medidas concretas y creíbles, consistentes con los compromisos climáticos del Acuerdo de París.

Piedra angular de la movilidad sostenible

La Comisión Europea declaraba 2021 como el año europeo del ferrocarril. La promoción de modos más sostenibles de transporte ha sido una de las prioridades de la política europea desde finales del siglo pasado. El objetivo ha sido reconciliar un crecimiento imparable del transporte de pasajeros y mercancías con unos crecientes efectos perjudiciales para la sociedad, el medio ambiente e incluso la propia economía.

El ferrocarril, central en esta nueva política de transporte, ha adquirido un protagonismo especial en el caso español en forma de inversiones masivas en alta velocidad ferroviaria.

Paradójicamente, entre 1990 y 2018, la cuota modal del ferrocarril ha bajado del 7 % al 6 % en el transporte de pasajeros y del 10 % al 4 % en lo que se refiere al transporte de mercancías. No es de extrañar que en el periodo de vigencia del Protocolo de Kyoto, el transporte es el único sector que ha aumentado sus emisiones de gases de efecto invernadero (GEI) (+73 %), representando en la actualidad un 31 % del total.

Ineficiente en lo económico e injusta en lo social

La evaluación económica del modelo ferroviario de alta velocidad español ha concluido en la ausencia de rentabilidad financiera y social de todos los corredores. En otras palabras, la sociedad nunca recuperará el dinero invertido.

Detrás de estos resultados se encuentra una escasa demanda fruto de una planificación deficiente y alejada de las necesidades sociales y unas inversiones caracterizadas por permanentes retrasos, sobrecostes y corrupción –como han reflejado diversos informes de los tribunales de cuentas europeo y español–. Todo ello convierte a ADIF-Alta Velocidad en la empresa pública más endeudada del Estado.

Los promotores de este modelo ferroviario destacan la necesidad de culminar una red mallada en todo el Estado para mejorar su utilidad. Sin embargo, los estudios realizados concluyen que la rentabilidad social es aún menor en la medida en que se conectan núcleos con menor demanda potencial de pasajeros.

Desde el punto de vista social, la escasa demanda obedece a la inexistencia de una disposición a pagar alta velocidad por parte de los usuarios (que apenas alcanza a cubrir los costes variables del servicio). Esto se traduce en una regresividad de la inversión.

El AVE tampoco ha demostrado favorecer el desarrollo regional ni cambios en productividad. Sus mayores efectos se reducen a la propia construcción y a la reorganización (especulación) urbana en torno a las estaciones.

Otra de las consecuencias de las masivas inversiones en alta velocidad ha sido el abandono de la red española de cercanías. Esta da servicio al 90 % de los usuarios del ferrocarril en España y atiende fundamentalmente a la movilidad obligada.

Insostenible en lo ambiental

Dejando a un lado importantes efectos ambientales negativos, como la ocupación de suelo, el efecto barrera, el impacto paisajístico o la contaminación acústica y atmosférica, el debate sobre el carácter ecológico del tren de alta velocidad se ha centrado en el balance de emisiones de gases de efecto invernadero debido, lógicamente, a su implicación en el cambio climático.

Los defensores del tren de alta velocidad han argumentado, con razón, que dadas sus menores emisiones por persona/mercancía transportada, desviar tráficos desde la carretera y el avión hacia el ferrocarril de alta velocidad era beneficioso para el medio ambiente.

Sin embargo, estos análisis han contado con una carencia fundamental: obviar la contabilidad de las emisiones asociadas a la construcción de estas infraestructuras. Ninguna familia valoraría, por ejemplo, sustituir un electrodoméstico por otro de mayor eficiencia energética sin tener en cuenta el coste del nuevo electrodoméstico.

El análisis de ciclo de vida es vital en este contexto. La amenaza del cambio climático alienta numerosas propuestas de energías “limpias” que, tras ser debidamente analizadas, acaban teniendo un balance neto incluso negativo. Se ha visto recientemente, por ejemplo, en el caso del hidrógeno azul.

Según los resultados de nuestro reciente estudio, el primero –del que tengamos conocimiento– que ha intentado abordar este análisis en el marco de las publicaciones académicas, el balance medioambiental neto del conjunto de la red española de alta velocidad es, sin ser perjudicial, considerablemente más pobre de lo que se pensaba.

Teniendo como referencia el año 2016 (últimos datos disponibles), la red española de alta velocidad requiere una media de 15 años de funcionamiento para compensar las emisiones GEI asociadas a su construcción (hasta 62 y 87 años en lo que se refiere a emisiones de SO₂ y partículas PM₁₀ respectivamente). No obstante, encontramos diferencias notables entre los corredores: 9 años en el corredor andaluz, 12 en el catalán, 20 en el corredor levantino y 79 en el caso del corredor norte.

Al igual que ocurría con la evaluación económica, el factor más influyente en estos pobres resultados es la baja densidad de transporte, la escasa desviación de viajeros de modos más contaminantes como el automóvil o el avión y el hecho de ser una red exclusiva de pasajeros, dejando fuera el transporte de mercancías que se realiza casi exclusivamente por carretera.

El estudio constata, además, que los resultados empeoran a medida que la red se expande a corredores con menor demanda de transporte.

El problema, sin embargo, no es solo que algunos corredores no estén justificados. Una vez ponemos en su contexto los resultados del balance climático de la red española de alta velocidad, nos encontramos con que apenas contribuye a reducir un 1 % las emisiones anuales totales de transporte en España.

El AVE ante la emergencia climática

Todo lo anterior debería haber servido para alentar un debate en torno a la inversión en alta velocidad ferroviaria en España hace 20 o 30 años. Habría permitido abandonar unas inversiones que se han demostrado beneficiosas para las empresas constructoras y perjudiciales para el resto de la sociedad.

Sin embargo, el debate actual no es –o al menos, no debería ser– este. El debate actual nada tiene que ver con estar a favor o en contra del tren de alta velocidad como modo de transporte, ya que indudablemente tiene virtudes como su rapidez, comodidad y puntualidad.

El contexto ha cambiado radicalmente al encontrarnos en una situación inédita global de emergencia climática. La comunidad científica mundial ha hecho un llamamiento unánime a reducir drásticamente las emisiones de gases de efecto invernadero con el fin de limitar el aumento de la temperatura global a 1,5 grados. Una llamada a la acción que se está traduciendo en compromisos internacionales de reducción de emisiones cada vez más ambiciosos –neutralidad climática en 2050 y hasta un 55 % en 2030, en apenas 8 años–. “No hay plan B porque no hay planeta B”, decía recientemente Emmanuel Macron en el aniversario del Acuerdo de París.

Así, el debate necesario y urgente es en qué medida puede contribuir o no el AVE a la reducción drástica de emisiones comprometidas en París y que, a la luz de los resultados del último informe del IPCC, deberá ser aún mayor tras la Conferencia de Glasgow.

Y es en este contexto donde nos encontramos que el modelo ferroviario de alta velocidad no solo no es la solución, sino que la obstaculiza y nos hace perder un tiempo que no tenemos en la necesaria transición ecológica del transporte en España.![]()

Sobre los autores: David Hoyos es profesor agregado en el Departamento de Métodos Cuantitativos, Andoni Kortazar, profesor interino en el Departamento de Economía Aplicada V y Gorka Bueno Mendieta, profesor titular de Tecnología Electrónica de la Universidad del País Vasco/Euskal Herriko Unibertsitatea.

Este artículo fue publicado originalmente en The Conversation. Arículo original.

El artículo Alta velocidad: ineficiente, injusta e insostenible se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El impacto medioambiental del ciclo de vida del tren de alta velocidad en España

- Cómo regular la velocidad de disolución de los biometales de las prótesis

- Un equipo de alta fidelidad de ciencia ficción

Koordinazio polimero luminiszenteak: gailu argitsuen etorkizuna

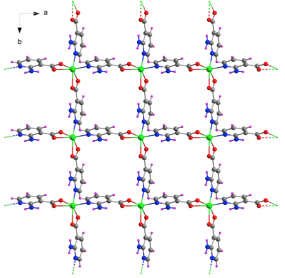

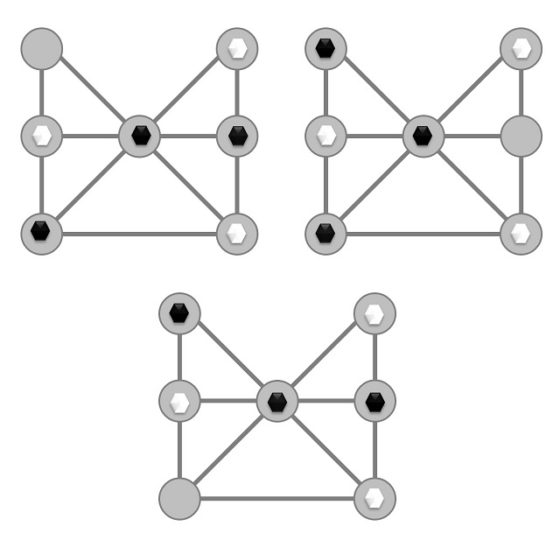

Koordinazio polimeroek (CPs) azken urteetan jasan duten hazkundea ikaragarria izan da material ez-organiko hibridoen arloan. Konposatu hauen karakteristikarik erakargarriena beraien egitura kristalinoa diseinatzeko erraztasuna eta hauek aurkezten dituzten propietate ugariak dira. Egitura horiek eraikitzeko bi osagai beharrezkoak dira: estekatzaileak eta metalak. Estekatzaileak atomo emaileak dituzten molekula organikoak dira eta nodoak metal edo kluster metalikoak (1. irudia).

1. Irudia. Metalen (berdea) eta estekatzaileen arteko konbinaketa sare moduko eraikin kristalinoa osatzen duen koordinazio polimeroa. (Iturria: Ekaia aldizkaria)

1. Irudia. Metalen (berdea) eta estekatzaileen arteko konbinaketa sare moduko eraikin kristalinoa osatzen duen koordinazio polimeroa. (Iturria: Ekaia aldizkaria)Esan bezala, konposatu horiek propietate anitzak erakusten dituzte haien egitura hibridoa dela medio, eta horrek hainbat aplikaziotan erabiltzeko gaitasuna ematen die. Horien artean, gehien nabarmentzen den erabilera gas edo molekula txikien (H2, CO2…) adsortzioa da, gas horien biltegiratze edo banaketarako prozesuak goitik behera aldatu dutenak “Metal-Organic-Frameworks” (MOFs) deritzon koordinazio polimeroetan. Bestalde, konposatu horiek beste ezaugarri interesgarri batzuk eskaintzen dituzte hala nola katalisi arloan edo luminiszentzian. Azken horien interesa asko hazi da azken urteetan gailu argitsu hobeak sortu ditzaketelako, aplikazio-esparru anitzak dauzkatenak, hala nola trafiko-seinaletan, pantaila digitalean edo faltsifikazio sistemetan. Halaber, ezaugarri hori konbina daiteke molekula zehatzak detektatu ditzaketen sentsore gisa erabil daitezkeen material berriak sortzeko.

Luminiszentziari materialak argia igortzeko duten gaitasunari deritzo, aldez aurretik energia xurgatu behar izan duelarik. Bi argi igorpen mota bereiz ditzakegu: fluoreszentzia eta fosforeszentzia. Lehenengoaren kasua argi igorpena oso azkarra da, aurrez aurretik xurgatuta energia xurgatu bezain laster bueltatzen dute argi moduan; beraz, energia iturria kenduz gero argia igortzeari uzten diote. Fosforeszentzian berriz, xurgatutako energiaren igorpena argi moduan askoz motelagoa da, igorpenak denboran luzatzea ahalbidetzen duena eta kitzikatze iturria behin kenduta argia igortzen jarraitzen dute. Denboran luzatzeko argi igorpenari iraupen luzeko fosforeszentzia (ingelesez Long-Lasting Phosphorescence, LLP) deitzen zaio.

2. Irudia. Koordinazio-polimero baten argi igorpena kitzikatzearen ondorioz. (Iturria: Ekaia aldizkaria)

2. Irudia. Koordinazio-polimero baten argi igorpena kitzikatzearen ondorioz. (Iturria: Ekaia aldizkaria)Luminiszentzia konposatuaren izaera hibrido metal-organikotik dator, hau da, metalaren eta estekatzailearen ezaugarrien arteko konbinaziotik. Horretarako, metalaren eta estekatzailearen aukeraketa egokia egitea ezinbestekoa da gure konposatuak luminiszenteak izan dezaten. Metalen artean, geruza osoko metalak dira egokienak, hala nola zink (II) edo kadmio (II), biek d10eko konfigurazio elektronikoa dute. Geruza osoa izateagatik, d-d trantsizioetan oinarritutako erlaxazio prozesu ez-erradiatiboak (ez dutenak argirik igortzen) ezin dira eman eta ondorioz igorpen luminiszentea bermatzen du. Horrek esan nahi du beste metal batzuk ere baliagarriak direla koordinazio polimero luminiszenteak eraikitzeko baldin eta geruza osoko metalak baldin badira, hala nola metal-lurralkalinoek. Estekatzailearen aldetik, konposatu organikoak elektroi pare bakartiak dituzten atomoak eduki behar ditu, adibidez oxigeno, nitrogeno edo fosforo atomoak, eta elkarrekintza supramolekularrak sortzen laguntzen dituzten talde funtzionalak, hala nola eraztun aromatikoak edo karboxilato taldeak.

Dena den, konposatu hauek aurreko mendetik ezagunak diren arren, azkenengo hamarkadan hazkunde handia jaso dute bere egituraren natura hibridoa metal-organikoak osagaien konbinaketa mugagabea eskaintzen duelako eta horren ondorioz propietate luminiszenteak egokitzea erraza suertatzen delako. Horrenbestez, molekula adimenduak sor ditzakegu sistema optiko gisa erabiltzeko. Igorpen luminiszenteak dituzten koordinazio-polimeroak aplikazio gutxi batzuetan sustatu badira ere, bere garapena abiapuntuan baino ez dago eta; hortaz, ibiltzeko geratzen den bidean tarte handia dago oraindik ere iraupen luzeagoko argi igorpena erakusten duten material berri eta hobeak sortzeko.

Iturria:

Pajuelo Corral, Oier; Seco, Jose Manuel; Cepeda, Javier (2020). «Koordinazio polimero luminiszenteak: gailu argitsuen etorkizuna»; Ekaia, 37, 2020, 159-174. (https://doi.org/10.1387/ekaia.20840) Artikuluaren fitxa:- Aldizkaria: Ekaia

- Zenbakia: Ekaia 37

- Artikuluaren izena: Koordinazio polimero luminiszenteak: gailu argitsuen etorkizuna.

- Laburpena: Koordinazio-polimero luminiszenteak aurreko mendetik ezagutzen diren arren, izugarrizko hazkundea izan dute aurreko hamarkadatik gaur egun arte, erakusten duten argi-igorpen gaitasun paregabeei esker. Material horiekin, gailu argitsuen arloan belaunaldi berri bat garatzen hasi da, bereziki sentsore gisa edo faltsifikazio-sistemetan erabiltzeko. Material hauen aplikazio gehienek intentsitate handiko igorpenak edota igorpen iraunkorrak izatera behartzen dute. Zentzu horretan, koordinazio-polimeroak aukera egokiak dira, beren izaera metal-organikoa dela eta; haien egitura kristalinoa nahi diren propietate fotoluminiszenteak erakusteko diseina daitezke, horrela eginkizun zehatz batera bideratzeko. Azpimarratzekoa da azken urteotan ikusi egin dela koordinazio-polimeroek iraupen luzeko argi-igorpenak emateko gaitasuna daukatela. Lan honen helburu nagusia da koordinazio-polimero luminiszenteak eta, bereziki, argi-igorpen fosforeszenteak sortzen dituztenak nola eraiki eta haietan gertatzen diren fenomenoak azaltzea.

- Egileak: Oier Pajuelo Corral, Jose Manuel Seco, Javier Cepeda

- Argitaletxea: UPV/EHUko argitalpen zerbitzua

- ISSN: 0214-9001

- eISSN: 2444-3255

- Orrialdeak: 159-174

- DOI: 10.1387/ekaia.20840

————————————————–

Egileez:

Oier Pajuelo Corral, Jose Manuel Seco eta Javier Cepeda UPV/EHUko Donostiako Kimika Zientzien Fakultateko Kimika Ez-organiko Sailekoak dira.

———————————————–

Ekaia aldizkariarekin lankidetzan egindako atala.

The post Koordinazio polimero luminiszenteak: gailu argitsuen etorkizuna appeared first on Zientzia Kaiera.

El error de usabilidad que definió la temperatura más alta de la Tierra

Foto: Jarosław Kwoczała / Unsplash

Foto: Jarosław Kwoczała / UnsplashSi me preguntan a mí, la temperatura más alta de la historia debió de producirse el sábado pasado en el salón de mi casa. No tenía ningún termómetro a mano, pero según mis estimaciones, la sensación térmica durante la ola de calor en el centro de Madrid ascendió a los 74,3 ºC (74,5 ºC cuando el ventilador apuntaba para otro lado).

Los climatólogos, en cambio, tienen su propia versión de los hechos. Según sus registros históricos, la temperatura más alta de la Tierra jamás anotada por un ser humano ascendió a 58 grados centígrados. Esta fue la cifra que nos legó un soldado italiano durante un tórrido verano en el desierto de Libia, en 1922. Sin, embargo no está exenta de polémica. Existen varias inconsistencias en estos registros que parecen apuntar a un error. Concretamente, a un error de usabilidad de su termómetro.

Pero pongámonos en contexto. Estamos en 1922. Imagina que eres un soldado destinado en la región de Al Azizia, cerca de Trípoli. En algún momento, te han dado instrucciones para apuntar diariamente lo que marca el termómetro, pero probablemente no te han explicado muy bien cómo hacerlo ni tampoco para qué. Y ahí estás tú, sudando como un pollo, viendo hincharse una barrita de Mercurio en medio del desierto africano.

Probablemente, la sensación térmica de ese soldado debió de parecerse bastante a la de mi piso de Madrid. Se le derretía el alma y la mollera, y él ni siquiera contaba con un triste ventilador. Aún así, tuvo la paciencia de fijarse en el termómetro cada día y fue anotando sus numeritos: 50, 56, 58, 53, 53… da calor solo de leerlo. Difícilmente podía saber que sus anotaciones pasarían a definir en el récord de temperatura registrada sobre la Tierra durante un total de 90 años.

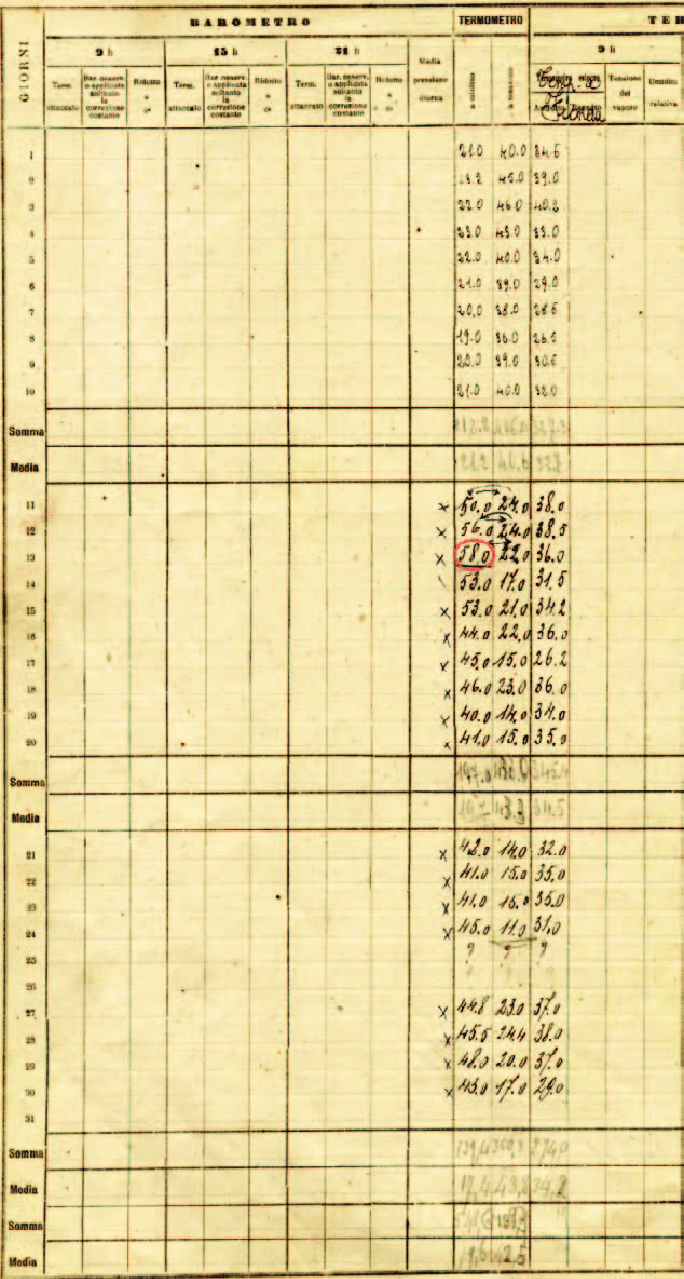

Parte de la hoja de observación meteorológica original de El Azizia, septiembre de 1922. Fuente

Parte de la hoja de observación meteorológica original de El Azizia, septiembre de 1922. Fuente

Los apuntes de aquel soldado nos permiten rastrear las huellas de su posible error. Dos días antes del 13 de septiembre (el día en que se batió el récord), la caligrafía de los registros cambia. Resulta evidente que entra en escena un nuevo apuntador. El mismo día el orden de todos los datos se invierte: la temperatura máxima pasa a estar en la columna de la izquierda, la mínima a la derecha. Claramente, nuestro héroe no estaba prestando mucha atención. ¿Pero es posible que se confundiese, también, al interpretar su aparato de medición?

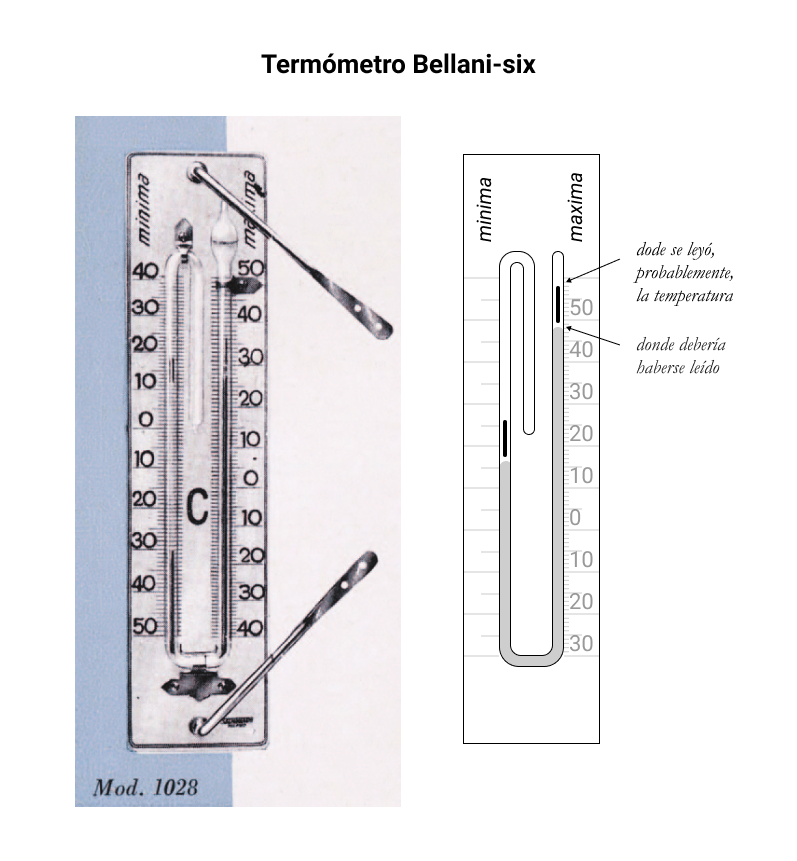

Esta es la hipótesis que defienden los autores de un estudio publicado hace algunos años por la Organización Meteorológica Mundial (OMM)1. Durante 2010 y 2011, un panel internacional de expertos llevó a cabo una investigación en profundidad sobre este récord en los registros y concluyó que no podían darse por buenos. Las mediciones de aquel soldado no solo son incoherentes con las registradas en otras estaciones cercanas. Tampoco pueden compararse con los valores de temperatura observados posteriormente en el mismo lugar, y constituirían un microclima impropio de la región. Pero además, parece que el propio termómetro podría haber jugado un papel en aquel error. Se trataba de un modelo Bellani-six, con dos masas flotantes sobre dos columnas de fluido. Al contraerse o dilatarse, el fluido empujaba las masas, que se superponían sobre una escala e indicaban la temperatura máxima y mínima del aire durante el día. Pero aquellas masillas eran bastante alargadas y era importante saber que la temperatura debía medirse en su punto más bajo (esto es, inmediatamente, encima de la columna de fluido).

Si aquel soldado italiano, por inexperiencia o por falta de atención, hubiese anotado la temperatura que figuraba encima de la masa del termómetro, todas sus mediciones habrían resultado anormalmente altas, como de hecho sucede. Un error que recuerda poderosamente al de cierto compositor europeo, que se aceleró, quizás, al anotar los tempi de sus sinfonías2.

En 2012 y tras concluir su estudio, la Organización Meteorológica Mundial decidió descartar los registros de Al-Haziza de 1922. Desde entonces, la temperatura más alta registrada en la Tierra ha descendido 1,3 ºC. El 7 de julio de 1913, en el Valle de la Muerte de Estados Unidos, California, algún desdichado con el cerebro achicharrado anotó una temperatura de 56,7 ºC (esperamos que con algo más de acierto, aunque tampoco está del todo claro).

Referencias:

1K.I, El & Cerveny, R.s & Burt, Christopher & Eden, Philip & Parker, David & Brunet, Manola & Peterson, Thomas & Mordacchini, Gianpaolo & Pelino, Vinicio & Bessemoulin, Pierre & Stella, José & Driouech, Fatima & M.M, Abdel & Pace, Matthew. (2013). World Meteorological Organization Assessment of the Purported World Record 58°C Temperature Extreme at El Azizia, Libya (13 September 1922). Bulletin of the American Meteorological Society. 94. 199-204. 10.1175/BAMS-D-12-00093.1.

2Martín-Castro A., Ucar I. (2020). Conductors’ tempo choices shed light over Beethoven’s metronome. PLOS ONE 15 (12) : e0243616. doi: 10.1371/journal.pone.0243616

Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica

El artículo El error de usabilidad que definió la temperatura más alta de la Tierra se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El misterio de la temperatura constante

- Un equipo de alta fidelidad de ciencia ficción

- Escaneando la Tierra con neutrinos solares

Siempre es buen momento para jugar: Pong Hau Ki y Madelinette

Había pensado empezar esta entrada del Cuaderno de Cultura Científica diciendo que el verano es un buen momento para jugar a cualquier tipo de juego, ya sea un juego popular, de ingenio, de estrategia, de azar, de construcción, solitario, matemático o del tipo que sea, aunque la verdad es que cualquier época del año es un buen momento para jugar. No nos olvidemos nunca de jugar.

En otras entradas de la sección Matemoción ya hemos hablado de algunos juegos, como el molino o alquerque de nueve (en la entrada Mujeres jugando (el juego del molino) relacionada con un cuadro del Museo de Bellas Artes de Bilbao), el tangram (por ejemplo, en las entradas Tangram o Un teorema sobre el tangram), el tchuka ruma (en la entrada Tchuka Ruma, el mancala solitario), el juego coreano kono (en la entrada El juego coreano kono), …

El juego koreano Kono

El juego koreano Kono

… el salto de la rana, el cinco por cinco, veinticuatro, o el puzle dieciséis inglés (en El salto de la rana y familia), el juego Vee-21 (en la entrada Embaldosando con L-triominós (Un ejemplo de demostración por inducción)), el clásico y universal mancala (en Juegos del mundo: el mancala), el Tetris (en Tetris, embaldosados y demostraciones), algunos juegos con tabletas de chocolate (como los comentados en la entrada Juegos matemáticos con tabletas de chocolate), el rompecabezas geométrico cubo soma (en El cubo soma: diseño, arte y matemáticas), el juego de cartas SET (cuyo análisis matemático presentamos en dos entradas, Matemáticas en el juego de cartas SET (1) y Matemáticas en el juego de cartas SET (2)), el juego probabilístico que analizó el matemático inglés Arthur Cayley, la ratonera (explicado en la entrada La ratonera, el juego de Cayley), el Sim (en El juego del Sim), el solitario locura instantánea (en la entrada Locura instantánea, un rompecabezas con cubos de colores), el tradicional juego de la morra (en La morra, jugando a contar con los dedos), algunos rompecabezas matemáticos (en las entradas Rompecabezas matemáticos con números y Más rompecabezas matemáticos con números) o el margarita y el bloqueado (analizados en la entrada La simetría como estrategia ganadora: la margarita y bloqueado).

En esta entrada del Cuaderno de Cultura Científica me ha parecido una buena idea recuperar un juego tradicional, estos son siempre una fuente de inspiración y de entretenimiento, que analicé en el libro Del ajedrez a los grafos, la seriedad matemática de los juegos (RBA, 2015), el pong hau ki.

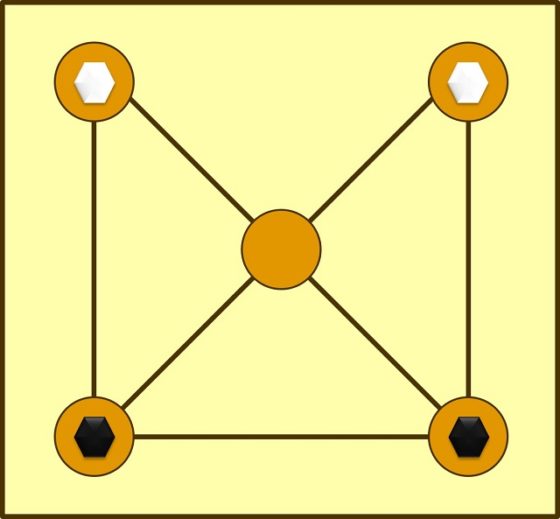

Tablero del Pong Hau Ki

Tablero del Pong Hau Ki

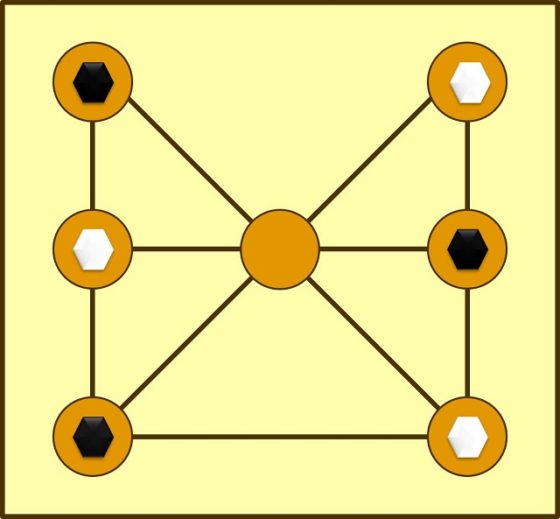

El pong hau ki es un juego tradicional chino, que también encontramos en Corea, con el nombre ou moul ko no, en Tailandia como sua tok tong o en la India como do guti, cuyo tablero y forma de juego nos recuerda al clásico tres en raya. En Europa no se empezó a jugar hasta más recientemente, quizás en la época medieval, con el nombre la herradura, así como una variación más moderna de este, el madelinette.

El tablero del pong hau ki está formado por cinco vértices, los cuatro de un cuadrado y el dado por la intersección de las dos diagonales del mismo, y siete aristas que los unen, todas las posibles, menos uno de los lados del cuadrado (véase la imagen de arriba o el esquema de abajo). Hay dos fichas de cada color (por ejemplo, blancas y negras), colocadas inicialmente como se muestra en la siguiente imagen, y cada color le corresponde a un jugador.

Tablero del Pong Hau Ki, con las dos fichas blancas y negras en la posición inicial del juego

Tablero del Pong Hau Ki, con las dos fichas blancas y negras en la posición inicial del juego

Las reglas del pong hau ki son las siguientes. Cada uno de los dos jugadores, por turnos, mueve una ficha de su color hacia la casilla adyacente que esté vacía. Por ejemplo, en la posición inicial, tanto las blancas como las negras, si empiezan la partida, solo pueden mover una de sus fichas a la casilla central. Gana el jugador que consigue bloquear las dos fichas de su oponente, de forma que este no pueda mover a la casilla libre.

Se considera que este es un juego infantil por su sencillez, como ocurre con el tres en raya o el salto de la rana, pero al igual que estos, tiene más interés del que pueda parecer a primera vista.

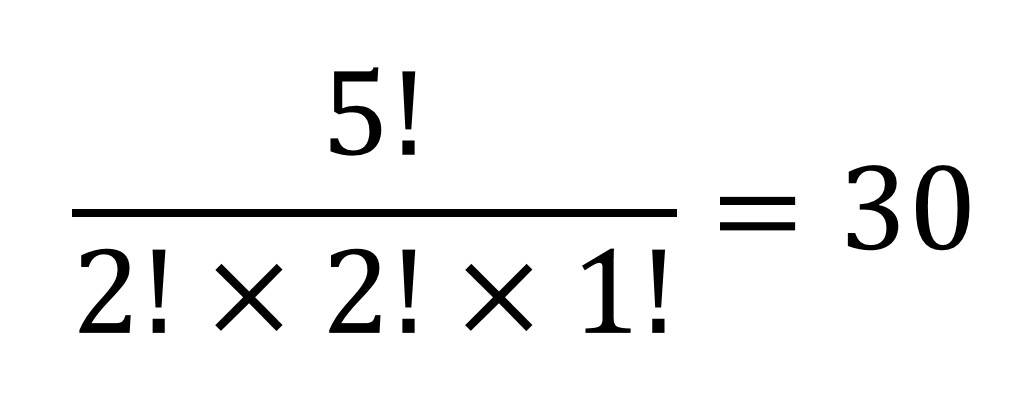

Empecemos analizando cuál es el número de posiciones posibles en el juego ou moul ko no. Tenemos cuatro fichas que debemos colocar en el tablero y dejar un hueco vacío. Si todas las fichas fuesen distintas (por ejemplo, las denominamos blanca 1, blanca 2, negra 1 y negra 2) y marcásemos la casilla vacía con una ficha trasparente, entonces el número de formas de colocar las cinco fichas en las cinco casillas sería el factorial de 5, denotado en matemáticas como 5!, cuyo valor es 5! = 5 x 4 x 3 x 2 x 1 y que son el número de permutaciones de cinco elementos (véase El problema matemático de las cartas extraviadas). Sin embargo, las dos fichas blancas son iguales, luego podemos intercambiar las casillas en las que están y sigue siendo la misma posición, luego debemos dividir entre dos. Lo mismo para las fichas negras. De hecho, hemos obtenido la regla para calcular las permutaciones con repetición. En consecuencia, hay 30 posiciones distintas en el juego, ya que:

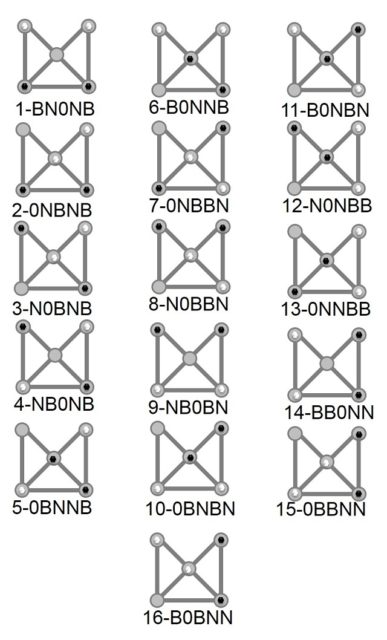

Por otra parte, si miramos la simetría respecto al eje vertical central del tablero, hay dos posiciones que son simétricas respecto a ese eje, es decir, la parte de la izquierda de la posición es igual a la parte de la derecha (que se corresponden con las posiciones 1 y 9 de la siguiente imagen), y catorce pares de posiciones relacionadas, esto es, al intercambiar las fichas de un lado y otro del eje se pasa de una posición a la otra (por ejemplo, la posición 2 de la siguiente imagen –las dos fichas negras abajo, una ficha blanca en medio y una ficha blanca en la posición de arriba a la derecha– se corresponde con la posición simétrica siguiente: las dos fichas negras abajo, una ficha blanca en medio y una ficha blanca en la posición de arriba a la izquierda). Luego, esencialmente tenemos que hay 16 posiciones distintas (salvo simetría) en el sua tok tong.

Si numeramos las casillas del 1 al 5, de arriba abajo y de izquierda a derecha, y etiquetamos cada posición diciendo qué ficha está en cada casilla (B para blanca, N para negra y 0 para vacía), por ejemplo, BN0NB es la posición inicial, podemos listar las 16 posiciones del juego.

Las dieciséis posiciones posibles, salvo isometría, del Pong Hau Ki

Las dieciséis posiciones posibles, salvo isometría, del Pong Hau Ki

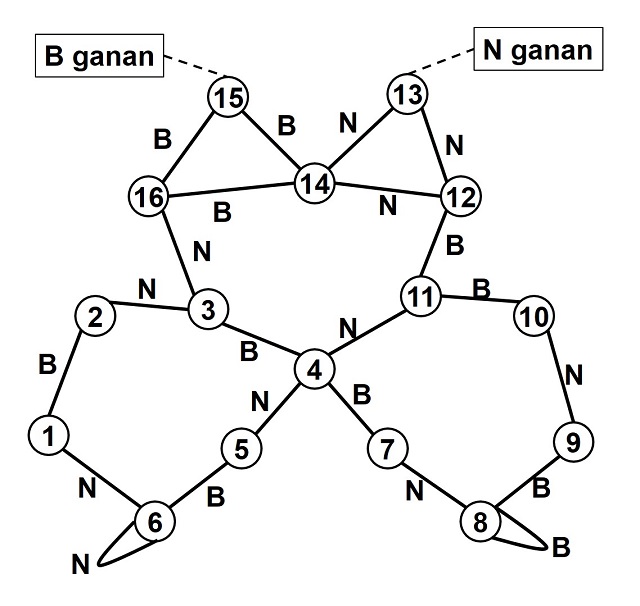

El matemático Philip D. Straffin, en su artículo Position graphs for Pong Hau K’i and Mu Torere (Mathematics Magazine, 1995), analizó mediante grafos (véase Locura instantánea, un rompecabezas con cubos de colores o El problema de los tres caballeros y los tres criados), la estrategia ganadora del Pong Hau Ki. Cada una de las dieciséis posiciones del juego es un vértice del grafo y existe una arista entre dos vértices si es posible realizar un movimiento que lleve de una posición a otra. El grafo es además etiquetado, puesto que cada arista llevará la etiqueta B o N, dependiendo de si el movimiento lo realiza el jugador que juega con blancas, o el que juega con negras. El grafo no es dirigido puesto que el movimiento entre dos posiciones puede ser en ambos sentidos.

En consecuencia, el grafo asociado a la herradura, teniendo en cuenta las dieciséis posiciones esenciales del mismo, es el siguiente.

Solo existe una posición ganadora para las blancas, si les toca mover a las negras, que es la posición 15, 0BBNN. Lo mismo para las negras, si mueven blancas, la posición 13, 0NNBB (vemos que es la misma configuración, solo se intercambia la posición de las casillas de las fichas blancas y negras). Para que las blancas lleven la partida a la posición 15, tienen que hacerlo a través de las posiciones 14 o 16, sin embargo, las negras pueden evitar esas posiciones. Lo mismo ocurre para las negras, en relación a la posición 13. De hecho, el juego, bien jugado, se mantendrá en un movimiento infinito entre los ciclos 1-2-3-4-5-6 y 4-11-10-9-8-7. Lo cual implica que el pong hau ki siempre terminará en tablas, salvo que se cometa un error, como ocurre con el tres en raya.

Una forma alternativa de jugar a la herradura, para darle un poco más de interés, es que el tablero esté inicialmente vacío y que los jugadores empiecen colocando por turnos cada una de sus fichas en el mismo. Si observamos el grafo anterior, la táctica para no perder es la misma que partiendo de la posición inicial dada (posición 1), solo que ahora hay que evitar las posiciones conflictivas al ir colocando las fichas al principio. Si empiezan las blancas, las negras evitarán las posiciones en las que tocándole mover a las blancas ganen, que son las posiciones 14 y 16, y las blancas evitarán la posición 13, que es la posición ganadora para las negras si mueven blancas (o, en ambos casos, sus posiciones simétricas).

Tablero y posición inicial del juego conocido como el mandelinette

Tablero y posición inicial del juego conocido como el mandelinette

El madelinette es una versión más compleja e interesante del juego de la herradura, que podría haber sido inventada por el militar y matemático aficionado francés Henri August Delannoy (1833-1915). El madelinette se juega con tres fichas de cada color y al tablero se le añade el segmento horizontal que pasa por el centro, obteniéndose así un total de siete casillas (como se muestra en la imagen anterior). Según el matemático francés Édouard Lucas (1842-1891), en sus Recreaciones matemáticas, las posiciones ganadoras, perdedoras y de tablas de los juegos la herradura y el madelinette fueron estudiadas por Henri Delannoy.

El madelinette se puede jugar a partir de la posición inicial que aparece en la anterior imagen, o con el tablero vacío, y el objetivo es de nuevo bloquear las fichas del jugador contrario.

Con un argumento similar al del juego pong hau ki se obtiene que el número de posiciones distintas del madelinette es

que dan lugar a 70 parejas de posiciones simétricas, una de la otra, respecto al eje vertical central.

Si pintásemos el grafo etiquetado asociado a este juego, resulta ser más complejo que el del pong hau ki, puesto que de cada posición (vértice del grafo) podemos pasar mediante un movimiento a más posiciones que antes. Por ejemplo, si empezasen moviendo las fichas negras, de la posición inicial se podría pasar a una de las siguientes tres posiciones siguientes. Además, aunque en la primera posición las blancas solo tendrían un movimiento posible, en las otras dos posiciones existirían dos opciones de movimiento.

Delannoy estudió qué posiciones son ganadoras, perdedoras o que terminan en tablas, jugando bien, suponiendo que mueven blancas (un razonamiento simétrico se obtiene si mueven negras). De las 70 posiciones diferentes (salvo simetría) hay 21 ganadoras para las blancas, 12 para las negras y 37 que serán empates.

A continuación, como ejemplo mostramos tres posiciones, una ganadora para las blancas, otra ganadora para las negras y otra que termina en empate, suponiendo que mueven blancas:

Al contrario que en la herradura, aquí hay más posiciones ganadoras para ambos colores, hay muchas más combinaciones y es fácil cometer fallos o despistes. Por eso mismo, el juego se hace más interesante.

Para terminar, lo que decimos siempre, lo mejor de un juego es jugar y disfrutarlo. Divertíos.

Bibliografía

1.- Raúl Ibáñez, Del ajedrez a los grafos, la seriedad matemática de los juegos, El mundo es matemático, RBA, 2015.

2.- Philip D. Straffin, Position graphs for Pong Hau K’i and Mu Torere, Mathematics Magazine, vol. 68, n. 5, 1995.

3.- Édouard Lucas, Recreaciones Matemáticas, vol. 1 – 4, Nivola, 2007, 2008.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Siempre es buen momento para jugar: Pong Hau Ki y Madelinette se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Adivinando o empleando la lógica?

- Ajedrez y matemáticas: el problema de Guarini

- En el lugar correcto en el momento adecuado

Dozena erdi ariketa 2021eko udarako (4): Auto ibilbidea

Gogoan izan ahalegina bera –bidea bilatzea– badela ariketa. Horrez gain, tontorra (emaitza) lortzen baduzu, poz handiagoa. Ahalegina egin eta emaitza gurekin partekatzera gonbidatzen zaitugu. Ariketaren emaitza –eta jarraitu duzun ebazpidea, nahi baduzu– idatzi iruzkinen atalean (artikuluaren behealdean daukazu) eta irailean emaitza zuzenaren berri emango dizugu.

Hona hemen gure laugarren ariketa: Auto ibilbidea.

Jonek ibilbide bat egin du kotxez. Batez besteko abiadura 55 km/h izan da eta ordu-kopuru oso bat behar izan du ibilbidea egiteko. Hasieran, kilometro-kontagailuak abc markatzen zuen, a ≥ 1 eta a + b + c ≤ 7 izanik. Amaieran, cba irakurri du Jonek kontagailuan. Zein zen hasierako abc zenbakia?

———————————————————————————-

Ariketak “Calendrier Mathématique 2021. Un défi quotidien” egutegitik hartuta daude. Astelehenetik ostiralera, egun bakoitzean ariketa bat proposatzen du egutegiak. Ostiralero CNRS blogeko Défis du Calendrier Mathématique atalean aste horretako ariketa bat aurki daiteke.

———————————————————————————-

Utzi zuen erantzuna iruzkinetan!

The post Dozena erdi ariketa 2021eko udarako (4): Auto ibilbidea appeared first on Zientzia Kaiera.

Los mitos como protociencia

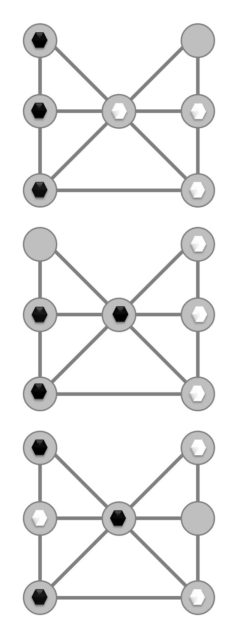

Apolo, Zeus y Hera. Fuente: Wikimedia Commons

Apolo, Zeus y Hera. Fuente: Wikimedia CommonsLos mitos son una expresión de la existencia de la especie, un espejo en constante cambio de las percepciones de la condición humana. Los mitos se basan en un pasado real impreciso en el tiempo, una realidad del comportamiento humano que trasciende un tiempo y un lugar determinados. La ciencia también tiene estos atributos. La estrecha asociación entre el mito y la ciencia se ve claramente cuando se considera la ciencia antigua. Los antiguos lucharon por explicar el entorno natural y su propia humanidad con respecto a lo divino. Las explicaciones iniciales incorporaron dioses y héroes, sucesos fantásticos y acontecimientos dignos de ser recordados. Debajo de lo fantástico y lo extraordinario de la tradición oral, los poemas cantados por el antiguo bardo, existía un verdadero intento de comprender y describir la naturaleza y al propio ser humano.

La antigua civilización sumeria fue el resultado de la organización, el trabajo y la ingeniería de los diques y canales que controlaban los ríos Tigris y el Éufrates, muy propensos a las inundaciones, y que irrigaban la tierra reseca durante la estación seca. La cultura sumeria se basa en última instancia en al agua y sus usos. La epopeya sumeria de la creación, Enûma Elish, describe a Apsu, la personificación deificada de las aguas originales de la creación; a Adad, la de las tormentas; a Ea, la de las aguas; a Ennugi, la del riego; Ningirsu, la de la fertilidad del suelo regado; a Ninurta, la de los de pozos de agua dulce.

Los sumerios está clero que pensaban mucho en el agua. La lluvia y el agua del río daban lugar a abundantes cosechas, vigiladas por Nisaba, la diosa de las cosechas. Ninhursag, la diosa madre, también supervisaba todas las plantas y animales o, lo que es equivalente, a todos los alimentos. Una vez que se recogían las cosechas, Shulpae se encargaba del éxito de los banquetes; Siduri aportaba lo suyo, como diosa del vino que era. Los milagros del agua, la comida, la abundancia, la bebida, los banquetes y los estómagos llenos tenían que ser explicados, y no era concebible otra que no fuese por la benevolencia de los dioses.

Serket protegiendo la caja de vasos canopos de Tutanjamón (Tutankamón). Fuente: Wikimedia Commons

Serket protegiendo la caja de vasos canopos de Tutanjamón (Tutankamón). Fuente: Wikimedia CommonsLos egipcios, igualmente, dependían del clima, como todas las civilizaciones, pero especialmente del Nilo y sus inundaciones anuales, y del Sol siempre presente. El Sol era tan importante que se necesitaban varios dioses para compartir su poder: Amón, Ra (el sol al mediodía), Atón (el sol al mediodía), Atón (el disco solar), Jepri (el sol en el este), Atum (el sol en el oeste). También se necesitaban varias deidades para el Nilo, gobernando varias regiones de Egipto según la ubicación del propio Nilo (alto o bajo Egipto). Los dioses y diosas de la fertilidad se asociaban con frecuencia con el Nilo: Happi era el dios de las inundaciones del Nilo durante el verano. Nun y Nefertum eran deicaciones de las aguas del abismo que estuvieron presentes en la creación. Sobek, el dios cocodrilo, era el dios del pantano.

Los egipcios, dedicados a comprender la naturaleza de la que tanto dependían, adoraban a los dioses de la ciencia y el saber. Imhotep, quien supuestamente fue un constructor durante la era de las pirámides en el tercer milenio a. e. c., evolucionó hasta ser un dios de la curación y la magia. Serket era su contraparte femenina, la diosa de la curación. Seshat y Thoth eran las deidades de la erudición, de los escribas y de la sabiduría.

Prometeo (1868) de Gustave Moreau. Fuente: Wikimedia Commons

Prometeo (1868) de Gustave Moreau. Fuente: Wikimedia CommonsGrecia es un paisaje de profundos valles, enormes crestas, bosques ocultos y montañas infranqueables. Los dioses de Grecia eran, por tanto, los de las montañas, los bosques, los ríos, la costa rocosa y las islas del Egeo y el Adriático. Se cree que antes de la llegada al poder de los griegos micénicos, los primeros griegos y la gente de Creta y las islas adoraban a las deidades de la naturaleza dominadas por las diosas de la fertilidad. Atenea, Afrodita, Hera, Artemisa, Hestia, Deméter y Rea fueron una vez, en el pasado mítico, los principales objetos de culto entre los griegos.

En un momento dado, el hijo de Rea, Zeus, dio un golpe de estado divino ocupando el lugar de su padre Cronos y llevando al poder también a sus hermanos Poseidón y Hades. Zeus gobernaba a través de la fuerza, a través del terrible rayo, que solo él controlaba, y que inspiraba terror tanto a dioses como a humanos. Poseidón personificó el mar; Hades se identificó tanto con su cometido que terminó convirtiéndose en él, el inframundo. Las diosas de la fertilidad perdieron poder o cambiaron de forma; por ejemplo, Atenea se convirtió en una virgen con apariencia de hombre; Hera se convirtió en una diosa malhumorada e impotente, siempre regañando a su hermano y esposo Zeus; Afrodita pasó a ser una diosa casquivana del amor que siempre metía a dioses y humanos en líos con la lujuria y el adulterio como fatores comunes; Deméter conservó su papel de diosa de la fertilidad del grano y de la agricultura.

Los poemas de Homero y de Hesíodo ilustran cómo los antiguos bardos personificaban los fenómenos naturales y humanos por medio de los dioses y diosas. Hesíodo explicó la presencia del mal mediante Pandora y su estúpido esposo Epimeteo, quien poseía el don de la retrospectiva pero no el de la previsión, que era la especialidad de su hermano Prometeo. Las mentiras y los robos se explican por la presencia de Hermes, experto en juegos de manos. Hesíodo, creyente en el recurrente concepto a través de los tiempos de que vivía en una época que encarnaba el declive de la cultura de «los buenos tiempos», argumentó que su época era una Edad de Hierro de maldad y desesperación, a diferencia de las edades anteriores de la humanidad: la Edad de Oro de los hombres que eran como dioses; la Edad de Plata, cuando Zeus castigó la arrogancia humana; la Edad del Bronce, cuando los humanos eran gigantes; y la Era Heroica, cuando existían héroes, descendiente de los dioses, pero destruida por la Guerra de Troya.

Los himnos homéricos y la Ilíada y la Odisea describen una cosmovisión totalmente antropomórfica. Los dioses y diosas se mezclan constantemente con los humanos, tanto que los humanos nunca están completamente seguros de quién es dios y quién es mortal. Quizás el extraño en la puerta sea un ser divino enviado para probar al ser mortal, une duda y preocupación recurrentes en los personajes de la Ilíada y la Odisea. Los dioses simbolizan la mente consciente y lo que hoy llamaríamos el subconsciente, por ejemplo, cuando Aquiles quiere destruir a Agamenón en el Libro 1 de la Ilíada, es la diosa Atenea la que interviene personalmente para calmar su ira y proporcionándole razón y paciencia.

La Odisea describe la dicotomía de civilización (el pensamiento, personificado por Ulises) y salvajismo (el cíclope). Ulises utiliza repetidamente su ingenio, artimañas, engaños y, en fin, el pensamiento analítico para salir de apuros. Ulises tiene sabiduría, es decir, ejerce la razón sobre las pasiones, tiene previsión y retrospectiva, tiene paciencia cuando los demás son impulsivos. Las divinidades de la sabiduría, el pensamiento y el ingenio lógicamente ayudan a Ulises. Atenea lo cuida, al igual que Hermes (después de todo era su bisnieto).

De hecho, encontramos en la mitología griega un énfasis en las deidades que personifican el pensamiento humano de una forma u otra. Además de Atenea, Apolo es un dios de la sabiduría, de la lira, de los sueños, de la profecía, de los videntes. Prometeo enseña a los humanos la creatividad, el pensamiento analítico, la inventiva y la curación.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Los mitos como protociencia se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cristalografía (1): Protociencia, del «Homo erectus» a Linneo

- Mesopotamia (1): La epopeya de Gilgamesh

- Antes del hierro

Células madre para el tratamiento de la enfermedad inflamatoria intestinal

María Larumbe / GUK

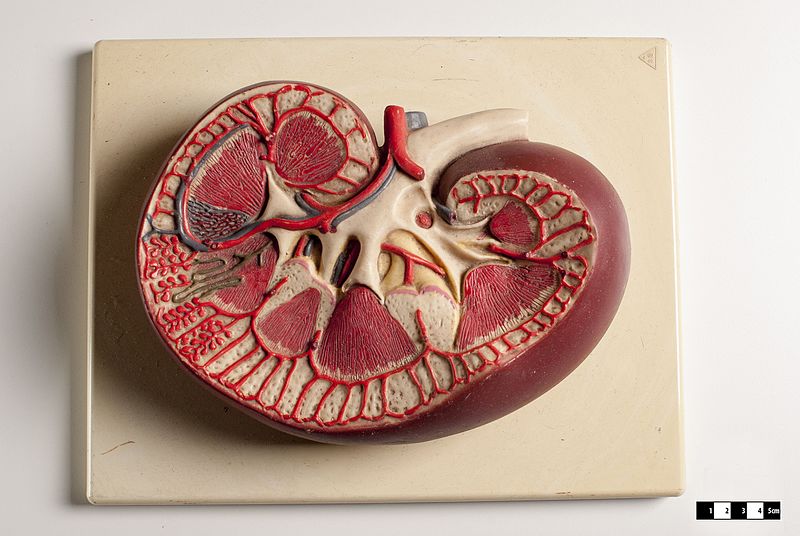

Células madre mesenquimales humanas de origen adiposo (AT-MSCs) encapsuladas en hidrogeles de alginato. Tinción live/dead: células viables (verde) y no viables (rojo).

Células madre mesenquimales humanas de origen adiposo (AT-MSCs) encapsuladas en hidrogeles de alginato. Tinción live/dead: células viables (verde) y no viables (rojo).La enfermedad inflamatoria intestinal (EII) es un concepto amplio que se usa para describir distintas patologías inmunomediadas, inflamatorias y crónicas, como la enfermedad de Crohn y la colitis ulcerosa, que presentan inflamación crónica del tracto digestivo. En la descripción que da la ACCU – Confederación Crohn y Colitis Ulcerosa – ambos trastornos alteran la capacidad del organismo para digerir los alimentos y absorber los nutrientes. Las personas que padecen esta enfermedad pueden presentar diarrea, sangre en las heces, cansancio, dolor abdominal, pérdida de apetito y peso o fiebre, entre otros síntomas.

En los últimos años, se está viviendo un aumento de la incidencia de la EII en la población a nivel mundial, sobre todo en las zonas urbanas de los países desarrollados. Más allá de las causas de componente genético, se sabe que algunos factores como el estrés que conlleva un estilo de vida frenético, las sustancias tóxicas presentes en el ambiente y la alimentación juegan un papel fundamental en la alteración de la flora intestinal. Esto provoca una respuesta inmune anómala que da lugar a la inflamación y sintomatología de la EII, dando como resultado que se reporten más casos de esta enfermedad.

Hasta la fecha no existe ningún tratamiento que cure esta enfermedad. Los fármacos disponibles en el mercado — como los aminosalicilatos, corticoesteroides e inmunomoduladores — tratan de disminuir la inflamación intestinal, evitar brotes de los síntomas y mantener la dolencia en remisión, pero no consiguen dar una respuesta definitiva.

Sin embargo, la evolución de las terapias avanzadas en farmacia y medicina abre la puerta al tratamiento efectivo de este tipo de patologías inflamatorias e inmunológicas. En concreto, en el grupo de investigación de NanoBiocel de la Facultad de Farmacia de la UPV/EHU — expertos en el desarrollo y encapsulación de medicamentos — llevan desde 2017 trabajando en un proyecto que tiene como objetivo desarrollar un medicamento efectivo para tratar esta enfermedad basado en células madre mesenquimales.

¿Por qué se han decantado por este tipo de células? Como explica Rosa Hernández — catedrática en Farmacia y responsable del proyecto dentro del grupo — “las células madre mesenquimales poseen una gran capacidad terapéutica a través de las sustancias que secretan entre ellas múltiples citoquinas y factores de crecimiento, y que pueden regular el funcionamiento de un sistema inmune alterado como sucede en el caso de pacientes con enfermedad de Crohn o colitis ulcerosa”.

Las terapias celulares no son desconocidas. Se llevan aplicando desde hace tiempo para el tratamiento de enfermedades como la leucemia. Es el caso del trasplante de médula ósea, que consiste en el reemplazo de células enfermas por células madre sanas.

Sin embargo, la aplicación de las terapias celulares en el tratamiento de la EII, presenta, según Hernández, ciertos problemas que son necesarios solventar para desarrollar un medicamento efectivo. “La célula es un organismo vivo que no se puede comprimir al igual que otros principios activos sintéticos como el ácido acetilsalicílico — principio activo de la Aspirina —. Por tanto, es necesario desarrollar nuevos sistemas que puedan encapsular esas células para implantarlas en el cuerpo y que sean capaces de secretar las sustancias terapéuticas durante largo tiempo”.

En este sentido, como afirma Hernández, no son los primeros en tratar de aplicar este tipo de terapias al servicio del tratamiento de la EII. “Partiendo de investigaciones previas en este ámbito, nuestro objetivo es desarrollar un sistema de administración que consiga potenciar y alargar los efectos positivos de las células madre, evitando además los problemas asociados a este tipo de terapias como son la rápida eliminación del organismo y la generación de trombos. Para ello, la correcta encapsulación de la célula es clave”.

Se trata de una investigación ambiciosa y colaborativa, financiada por el Ministerio de Ciencia e Innovación, que cuenta — además de con la participación del propio grupo de la UPV/EHU — con la colaboración de expertos en medicina, bioquímica, farmacia y biología de otras universidades como Harvard (EE.UU), la Universidad Católica de Lovaina (Bélgica) o centros médicos como el servicio de patología del Hospital Universitario de Álava.

Una factoría celular 24/7

Dentro de esta investigación multidisciplinar y colaborativa, el principal reto consiste en conseguir encapsular las células madre de forma efectiva y lograr que estén el suficiente tiempo en el organismo para mitigar la inflamación persistente y regenerar los tejidos dañados.

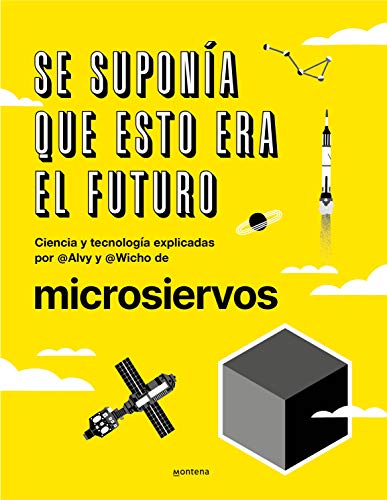

Para conseguir este objetivo, altamente complejo, han trabajado en el desarrollo de tres elementos fundamentales: un hidrogel para encapsular las células (soporte); las propias células madre (principio activo del medicamento) y el interferón gamma (sustancia activadora de las células).

Desarrollo de un sistema multifuncional para potenciar las propiedades terapéuticas de las células madre mesenquimales (MSCs). Las MSCs se encapsulan en hidrogeles de alginato-colágeno que contienen micropartículas cargadas con interferón para promover su efecto inmuno-modulador y favorecer la retención del implante.

Desarrollo de un sistema multifuncional para potenciar las propiedades terapéuticas de las células madre mesenquimales (MSCs). Las MSCs se encapsulan en hidrogeles de alginato-colágeno que contienen micropartículas cargadas con interferón para promover su efecto inmuno-modulador y favorecer la retención del implante.En primer lugar, para resolver el problema de la encapsulación, han desarrollado un hidrogel en colaboración con la Universidad de Harvard, el cual funciona a modo de soporte y protege la célula. “Este hidrogel, compuesto por polímeros de origen natural, posee unas características biomiméticas que permiten que la célula se encuentre ‘como en casa’, proporcionando las condiciones adecuadas para que su supervivencia sea mayor”. Además, al introducir las células en este hidrogel, se tienen localizadas y se evita que puedan migrar a cualquier otra parte del organismo.

Por otro lado, el segundo componente que se ha utilizado para desarrollar este medicamento es el más importante: el propio principio activo, es decir, la célula. “En este caso, hemos optado por células madre mesenquimales de origen adiposo. A futuro, si todo va bien, al realizar la traslación clínica, el objetivo sería poder obtener las células de la grasa del propio paciente para que fuese un trasplante totalmente autólogo y que ocasione menos problemas desde el punto de vista de la respuesta inmune”. En este sentido, también se está investigando en el uso de otras células como las del folículo piloso, que tienen muy buenas propiedades inmuno-moduladoras y requieren de técnicas muy poco invasivas.

Por último, el tercer componente busca activar las células madre para que puedan secretar de manera continuada y prolongada las sustancias inmuno-moduladoras requeridas para tratar esta enfermedad. “Lo que hemos desarrollado son unas micropartículas que hemos unido a una sustancia ‘activadora’ llamada interferón gamma, que da las señales a la célula madre para que secrete las sustancias beneficiosas que disminuyan los síntomas de la EII.”

Este trabajo se ha realizado con el objetivo de crear un sistema multifuncional para su administración a nivel subcutáneo en el paciente, de forma que libere ininterrumpidamente estas sustancias terapéuticas, como si se tratara de una fábrica celular en constante funcionamiento.

Actualmente, la investigación se encuentra en fase preclínica. “Acabamos de realizar la primera prueba de concepto en ratones, siguiendo el modelo en estos animales para conseguir reproducir la enfermedad al igual que en los humanos”. Para llevar a cabo esta tarea, han contado con la colaboración del servicio de patología del Hospital Universitario de Álava, que diagnostica la enfermedad patológica en humanos y les han apoyado en la creación del modelo en ratones.

Tras realizar la autopsia a los ratones, “lo que se ha comprobado es que las células encapsuladas continúan vivas y siguen secretando las sustancias inmuno-moduladoras, lo que supone un paso hacia adelante en la investigación”, afirma Hernández. Sin embargo, hasta que no comprobemos los resultados histológicos no podremos determinar si este tratamiento ayuda a la regeneración tisular, es decir, de los tejidos del organismo”, afirma Hernández.

Tratamiento para otras enfermedades inmunológicas

La investigación, que comenzó hace cuatro años, tiene todavía un largo camino por delante. “Tendremos que acometer ajustes e ir controlando poco a poco el sistema, incorporando nuevos elementos que conseguirán mejorar el comportamiento de la célula en cuanto a las secreciones. Además de esto, probaremos otro tipo de células con propiedades inmuno-moduladoras, aunque las que estemos utilizando actualmente sean el gold standard.