Atracción (electroestática) fatal

En una entrega anterior de esta sección describíamos la curiosa estrategia del nematodo Caenorhabditis elegans para dispersarse en el medio. Estos pequeños gusanos forman torres para salvar espacios y, eventualmente, adherirse a insectos que los transporten a otros lugares. Parecía difícil superar esto, pero otro nematodo, Steinernema carpocapsae (Figura 1), acaba de proporcionarnos un caso aún más sorprendente. Con una longitud máxima de medio milímetro, este minúsculo gusano es capaz de saltar a una distancia superior a veinte veces su longitud corporal, con una velocidad inicial de 1.5 m/s, y adherirse a un insecto al que matará y consumirá. Si a esto le añadimos que rara vez falla en su objetivo, nos tenemos que preguntar cómo un animal, tan limitado en lo sensorial como en lo motor, tiene tanta puntería. Y la respuesta, totalmente inesperada, radica en la electroestática.

Figura 1. El nematodo Steinernema carpocapsae, individuo juvenil en fase infectiva. De Lu et al. (2017), doi: 10.1371/journal.ppat.1006302, CC BY 4.0.

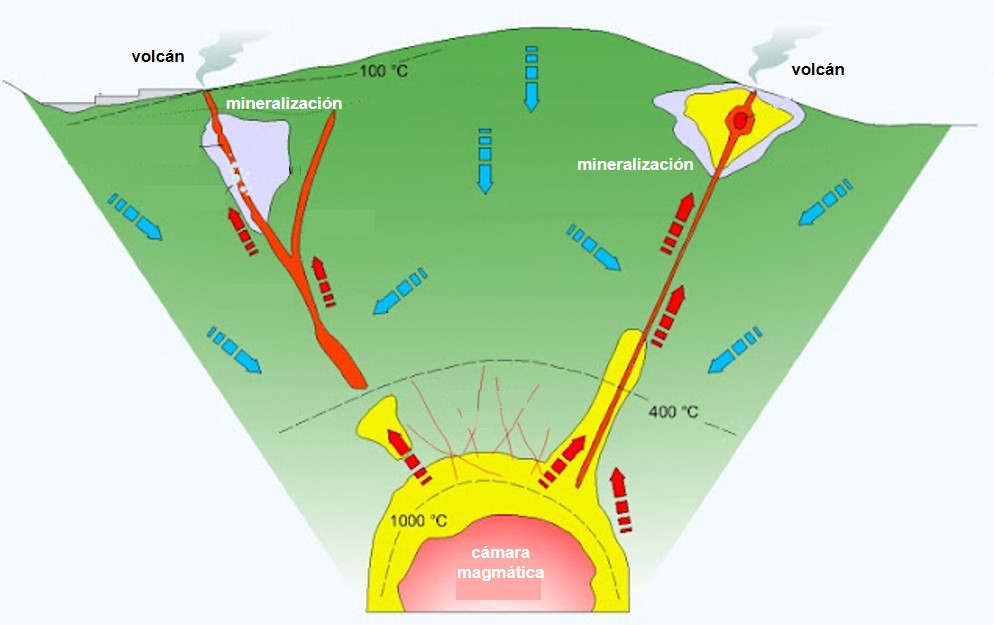

Figura 1. El nematodo Steinernema carpocapsae, individuo juvenil en fase infectiva. De Lu et al. (2017), doi: 10.1371/journal.ppat.1006302, CC BY 4.0.La electricidad estática está presente en muchos fenómenos biológicos. Los insectos voladores, por ejemplo, suelen cargarse positivamente por el roce con partículas presentes en el aire. De esta forma se facilita la recolección de polen por abejas, mariposas o colibrís. Eso sí, la carga eléctrica positiva de los insectos voladores aumenta su riesgo de enredarse en telarañas. La electricidad estática también está implicada en el vuelo de arañas, en ocasiones a cientos de kilómetros de distancia. Los filamentos de seda emitidos por estas arañas y cargados negativamente son atraídos por cargas eléctricas positivas en la atmósfera, como podemos ver en este vídeo.

Volvamos a S. carpocapsae. Este nematodo ha sido comercializado debido a su utilidad en la lucha biológica contra plagas de insectos. Cincuenta millones de gusanos pueden adquirirse en el mercado fitosanitario por unos 20 euros. A pesar de su pequeño tamaño, S. carpocapsae mata rápidamente (en 24-48 horas) a los insectos a los que ataca. Esta letalidad se debe a dos factores. Por un lado, transporta en su intestino bacterias simbióticas del género Photorhabdus o Xenorhabdus. Cuando el gusano penetra en su víctima, las bacterias son liberadas y proliferan rápidamente, produciendo toxinas y enzimas que degradan los tejidos del insecto. Al mismo tiempo, el nematodo produce otras sustancias tóxicas y supresoras del sistema inmune del insecto, que no puede defenderse de la infección bacteriana. Para completar el trabajo, las bacterias también segregan antibióticos que evitan la competencia de otras bacterias.

A estas alturas el insecto ha sido ya atacado por otros nematodos de la misma especie, que pasan de un estadio juvenil (el único de vida libre) a adultos de ambos sexos. Se aparean, ponen huevos y mantienen el ciclo hasta que el insecto ha sido completamente consumido. En ese momento los juveniles vuelven a asociarse con las bacterias (que solo pueden vivir en simbiosis con S. carpocapsae) y abandonan el cadáver para buscar otra víctima.

La pregunta que nos hacíamos al principio es, ¿cómo este pequeño gusano es capaz de saltar y adherirse a un insecto volador con precisión? La sorprendente respuesta acaba de aparecer en un artículo publicado en PNAS por investigadores estadounidenses. Es el propio insecto el que atrae al nematodo a causa de su carga eléctrica positiva, como vemos en este video.

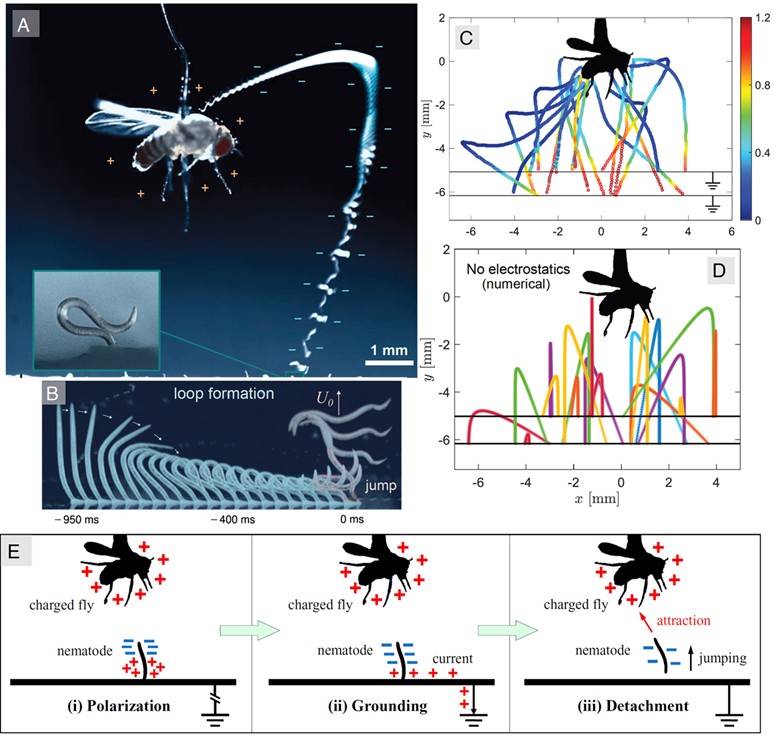

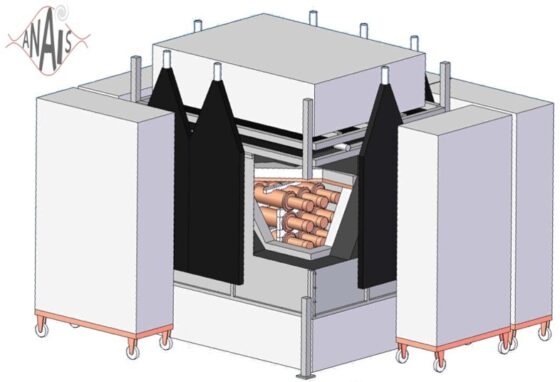

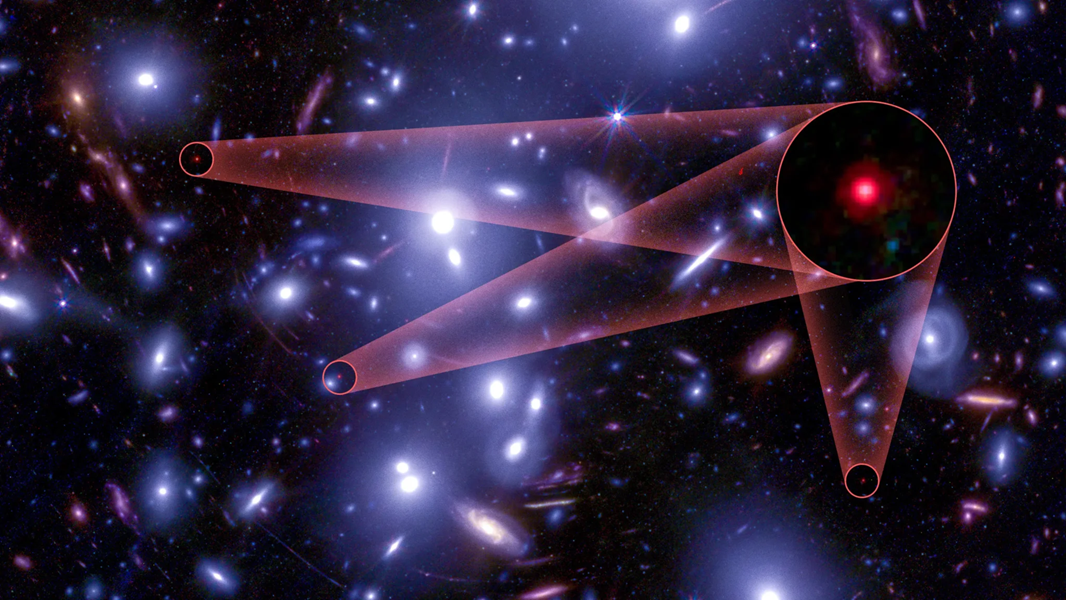

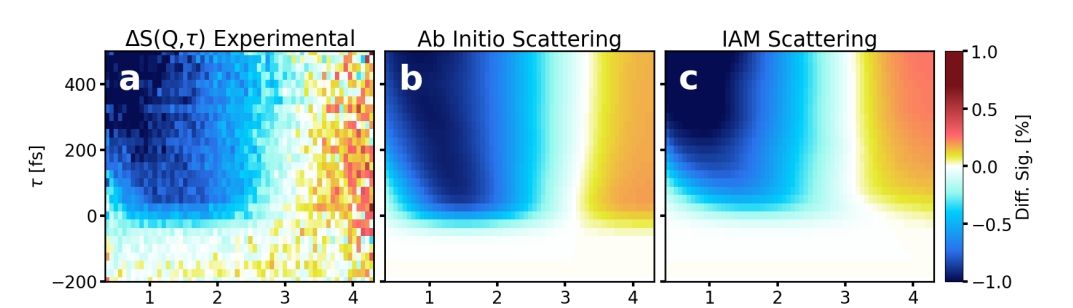

Los experimentos se realizaron con moscas del vinagre conectadas a un filamento de cobre para proporcionarles carga eléctrica positiva (Figura 2A-C). De acuerdo con las medidas tomadas en insectos voladores, estas cargas suelen estar entre 10 y 200 picoculombios (pC), lo que equivale a voltajes entre 50 y 1000 voltios. En todos los experimentos, los nematodos saltarines aterrizaron sobre el insecto. Lo mismo sucedió cuando el insecto fue reemplazado por una bola metálica con la misma carga eléctrica.

Figura 2. A: Trayectoria del nematodo Steinernema carpocapsae. Tras el salto es atraído hacia la mosca, cargada positivamente. B: El nematodo se dobla como un resorte antes de saltar. C: Trayectoria registrada en 19 individuos, partiendo de dos alturas diferentes. Todos ellos impactan contra el insecto, independientemente de la dirección del salto. Los colores indican la velocidad en m/s. D: Modelo numérico basado en las observaciones anteriores (velocidad y dirección), pero asignando carga neutra a los gusanos. Solo en un caso se logra el contacto con el insecto. Los colores indican diferentes voltajes para la mosca, entre 100 y 700 V. E: Carga del nematodo por inducción. El insecto cargado positivamente polariza al gusano atrayendo cargas negativas. El sustrato actúa como toma de tierra y proporciona electrones que neutralizan las cargas positivas. Cuando el nematodo salta, su carga es negativa y es atraído hacia el insecto. Fuente: Ran et al. (2025), cita completa en referencias, CC BY 4.0.

Figura 2. A: Trayectoria del nematodo Steinernema carpocapsae. Tras el salto es atraído hacia la mosca, cargada positivamente. B: El nematodo se dobla como un resorte antes de saltar. C: Trayectoria registrada en 19 individuos, partiendo de dos alturas diferentes. Todos ellos impactan contra el insecto, independientemente de la dirección del salto. Los colores indican la velocidad en m/s. D: Modelo numérico basado en las observaciones anteriores (velocidad y dirección), pero asignando carga neutra a los gusanos. Solo en un caso se logra el contacto con el insecto. Los colores indican diferentes voltajes para la mosca, entre 100 y 700 V. E: Carga del nematodo por inducción. El insecto cargado positivamente polariza al gusano atrayendo cargas negativas. El sustrato actúa como toma de tierra y proporciona electrones que neutralizan las cargas positivas. Cuando el nematodo salta, su carga es negativa y es atraído hacia el insecto. Fuente: Ran et al. (2025), cita completa en referencias, CC BY 4.0.Para que la atracción electrostática sea eficaz, el nematodo debe tener carga eléctrica negativa, y los modelos numéricos mostraron que, en efecto, esta carga está alrededor de 0.1 pC. ¿Cómo se genera esta carga? La hipótesis más probable es que se deba a la inducción (Figura 2E). Cuando el insecto cargado positivamente se acerca, atrae cargas negativas del extremo más próximo del nematodo, con lo que el extremo contrario se carga positivamente. Ese extremo está en contacto con el sustrato, que actúa como toma de tierra y proporciona electrones que cancelan las cargas positivas. Por eso, todo el gusano, cuando salta hacia su objetivo, tiene carga negativa y es atraído hacia su víctima.

La pequeñísima carga negativa adquirida por inducción es esencial. De acuerdo con los modelos numéricos, cuando se simularon las trayectorias y las velocidades de los saltos, pero se asignó una carga nula a los gusanos, solo uno de los 19 intentos terminó con éxito (Figura 2D).

Resulta paradójico que la misma carga positiva que resulta útil, por ejemplo, para la recogida de polen, pueda ser fatal al atraer a nematodos parásitos. En cualquier caso, este descubrimiento ilustra la importancia de comprender mejor los fenómenos eléctricos en las interacciones animales.

Referencias

Ran, R., Burton, J.C., Kumar, S. et al. (2025). Electrostatics facilitate midair host attachment in parasitic jumping nematodes, Proc. Natl. Acad. Sci. U.S.A. doi: 10.1073/pnas.2503555122.

Sobre el autor: Ramón Muñoz-Chápuli Oriol es Catedrático de Biología Animal (jubilado) de la Universidad de Málaga.

El artículo Atracción (electroestática) fatal se ha escrito en Cuaderno de Cultura Científica.

Nuestros ojos saben lo que hicimos el último verano

Foto: Eugene Golovesov en Unsplash

Foto: Eugene Golovesov en Unsplash

La miopía avanza de forma imparable en todo el mundo. Según la Organización Mundial de la Salud, para 2050 la mitad de la población mundial será miope. No se trata solo de llevar gafas: cuando esa afección visual progresa mucho, aumenta el riesgo de desprendimiento de retina, glaucoma o ceguera irreversible.

En España, por ejemplo, la ceguera miópica es la primera causa de afiliación a la ONCE. La pregunta es inevitable: ¿qué podemos hacer para frenar la epidemia?

Una “caja negra” de la exposición al solLa respuesta podría estar, literalmente, en nuestros ojos. Más en concreto, en un curioso fenómeno llamado autofluorescencia ultravioleta conjuntival (CUVAF por su denominación en inglés), que funciona como una especie de “caja negra” de la exposición solar que ha recibido cada persona.

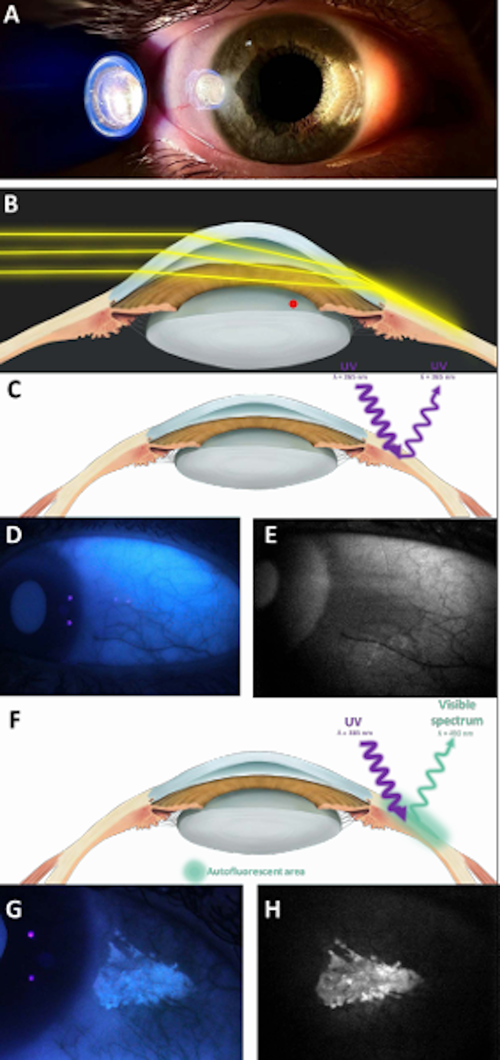

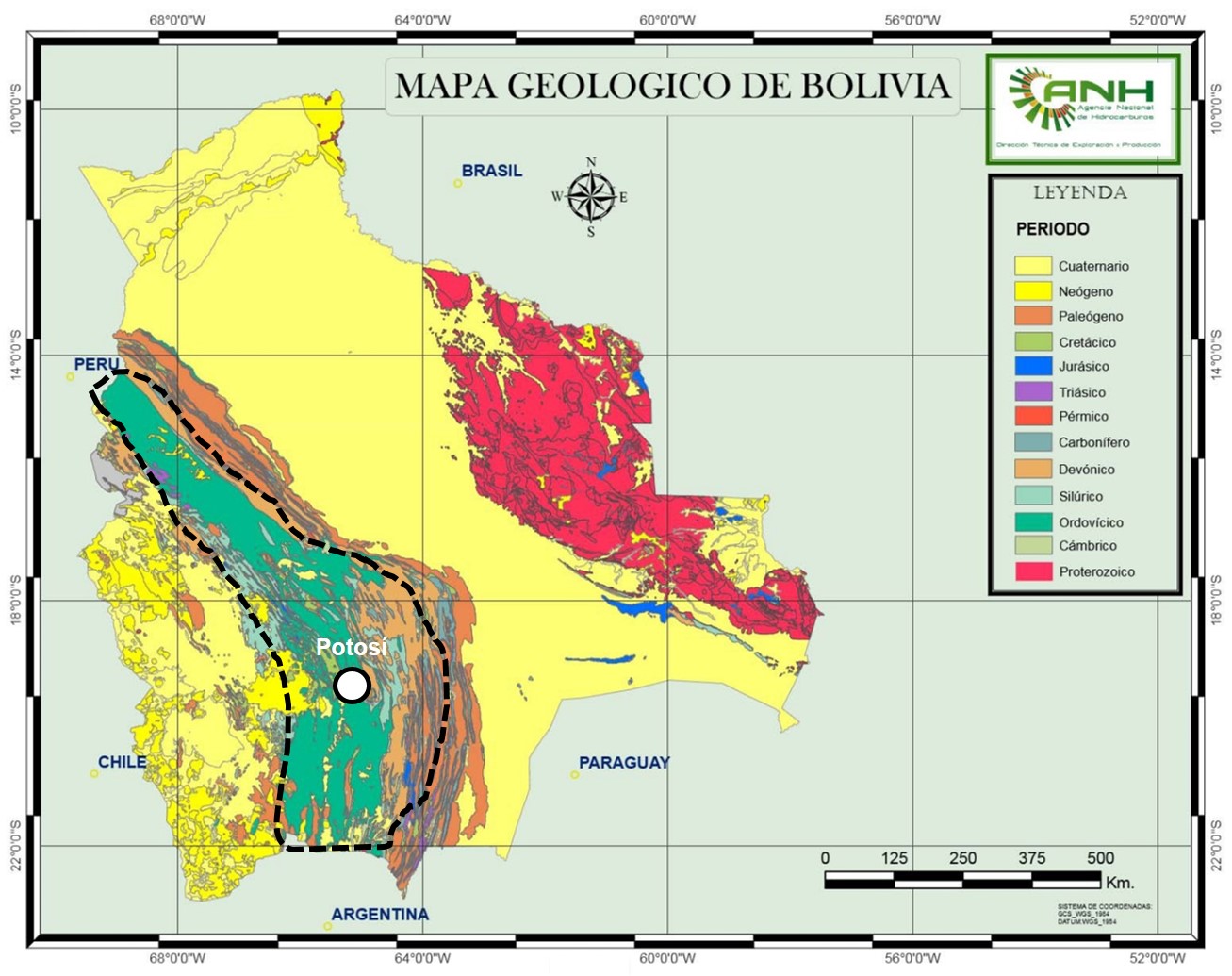

(A) Demostración ‘in vivo’ del enfoque corneal de la luz periférica proveniente del lado temporal del ojo hacia el limbo y la conjuntiva nasal, con una intensidad luminosa mayor en comparación con el lado temporal. (B) Representación óptica del efecto de enfoque de la luz periférica que provoca la concentración de los rayos incidentes, al atravesar la cámara anterior, sobre la superficie límbico-conjuntival contralateral del ojo. (C) Representación de un caso CUVAF negativo (sin área de hiperautofluorescencia conjuntival). (D–E) Fotografías CUVAF negativas tomadas bajo luz ultravioleta (D) (longitud de onda máxima de 365 nm) y (E) una fotografía tomada con el modo BAF del Heidelberg Spectralis HRA+OCT (longitud de onda máxima de 488 nm). (F) Representación de un caso CUVAF positivo (muestra un área de hiperautofluorescencia que absorbe a 360 nm y emite en el espectro visible). (G–H) Fotografías CUVAF positivas en una imagen a color tomada bajo luz ultravioleta (G) y (H) con el Heidelberg Spectralis HRA+OCT.

(A) Demostración ‘in vivo’ del enfoque corneal de la luz periférica proveniente del lado temporal del ojo hacia el limbo y la conjuntiva nasal, con una intensidad luminosa mayor en comparación con el lado temporal. (B) Representación óptica del efecto de enfoque de la luz periférica que provoca la concentración de los rayos incidentes, al atravesar la cámara anterior, sobre la superficie límbico-conjuntival contralateral del ojo. (C) Representación de un caso CUVAF negativo (sin área de hiperautofluorescencia conjuntival). (D–E) Fotografías CUVAF negativas tomadas bajo luz ultravioleta (D) (longitud de onda máxima de 365 nm) y (E) una fotografía tomada con el modo BAF del Heidelberg Spectralis HRA+OCT (longitud de onda máxima de 488 nm). (F) Representación de un caso CUVAF positivo (muestra un área de hiperautofluorescencia que absorbe a 360 nm y emite en el espectro visible). (G–H) Fotografías CUVAF positivas en una imagen a color tomada bajo luz ultravioleta (G) y (H) con el Heidelberg Spectralis HRA+OCT.El CUVAF es un área de autofluorescencia en la conjuntiva (la parte blanca del ojo) que aparece cuando se ilumina con luz ultravioleta. Entonces, el ojo muestra manchas brillantes que delatan cuánto tiempo hemos pasado bajo la luz del sol.

Aunque esas manchas no son visibles a simple vista, quedan registradas de forma objetiva. Así, el CUVAF se ha convertido en un biomarcador fiable para saber cuántas horas al aire libre ha acumulado una persona a lo largo de su vida reciente.

Los científicos llevan años sospechando que la falta de luz natural es una de las grandes culpables del aumento de la miopía. Los niños que pasan más tiempo en interiores –ya sea frente al móvil, la tableta o los libros– tienen más riesgo de desarrollarla.

¿Por qué? La hipótesis más aceptada es que la luz solar estimula la liberación del neurotransmisor dopamina en la retina, y esa dopamina actúa como freno natural para que el ojo no crezca en exceso (además de controlar ciclos circadianos, hormonas, etc).

Otra posible causa es que cuando estamos en la calle miramos principalmente de lejos, de forma relajada y sin forzar los músculos de la acomodación (necesarios para ver de cerca), lo cual evita el crecimiento excesivo del ojo. Porque cuando esto último ocurre, la imagen no se enfoca nítidamente en la retina y aparece la miopía.

De los cuestionarios a la “memoria ocular”Hasta hace poco, los investigadores solo podían medir el tiempo que pasan los niños al aire libre preguntando a los padres o a los propios menores. Pero esos cuestionarios tienen muchas limitaciones: ¿quién recuerda con exactitud cuántas horas estuvo en el parque hace un mes?

El CUVAF resuelve este problema. Funciona como un registro objetivo de la exposición solar, independiente de la memoria o la percepción. Si un niño presenta poco CUVAF, significa que pasa poco tiempo en exteriores y, por tanto, que tiene más riesgo de ser miope.

Lo que dicen los estudiosVarios trabajos internacionales confirman su utilidad. Así, un metaanálisis con más de 3 600 personas de distintos países encontró que los miopes pasaban menos tiempo al aire libre y tenían áreas de CUVAF significativamente más pequeñas que los no miopes. Y en la Universidad de Navarra, un estudio con estudiantes de Medicina y de Ciencias Ambientales mostró que los segundos, que pasan más horas en el exterior por su carrera, tenían más CUVAF y la mitad de riesgo de desarrollar miopía.

Para conocer las repercusiones de este biomarcador en la edad infantil –la etapa más sensible para el crecimiento excesivo del ojo–, se llevó a cabo una investigación en más de 260 niños de entre 6 y 17 años. Los autores comprobaron que los miopes, efectivamente, pasaban menos tiempo al aire libre y presentaban menos CUVAF. Además, si el área de autofluorescencia de la conjuntiva era grande en relación a la edad, los menores estaban protegidos hasta 2,5 veces frente a la miopía y hasta 5 veces frente a la miopía alta.

Este hallazgo podría confirmarse en un estudio, actualmente en revisión, con más de 2 600 niños de la Comunidad de Madrid.

Imaginemos cómo podría usarse dicha información en la práctica clínica. En una revisión ocular, el oftalmólogo toma una imagen del CUVAF. Si el resultado muestra un área reducida, podría dar el siguiente consejo:

“Su hijo necesita al menos una o dos horas de juego al aire libre cada día. El mejor tratamiento ahora mismo es la luz natural, gratuita y sin efectos secundarios”.

En el futuro, las consultas de oftalmología podrían incorporar esa prueba rutinaria igual que hoy se mide la tensión ocular o el fondo de ojo.

No es solo cosa de niñosAunque la prevención en la infancia es clave, el CUVAF también puede ser útil en adultos jóvenes. Durante la universidad o los primeros años laborales, la miopía puede seguir progresando. Medir el CUVAF en esta etapa permite detectar a quienes mantienen un estilo de vida demasiado “de puertas adentro” y orientar cambios sencillos: salir a pasear, practicar deporte al aire libre, exponerse a la luz natural cada día.

Hay una metáfora muy bonita que usan algunos investigadores: el verano se borra de nuestra piel, pero permanece en nuestros ojos. Aunque la piel pierda el bronceado, el ojo conserva la huella del sol a través del CUVAF. Y esa huella no es un simple recuerdo: es una pista directa sobre nuestra futura salud visual.

Porque la miopía no es inevitable: aunque los genes juegan un papel, el ambiente es decisivo. Y entre los factores ambientales, el tiempo al aire libre es el más importante y modificable.![]()

Sobre el autor: Sergio Recalde Maestre es Director científico del laboratorio de oftalmología experimental de la Universidad de Navarra

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Nuestros ojos saben lo que hicimos el último verano se ha escrito en Cuaderno de Cultura Científica.

Un termómetro para medir la cuanticidad

El flujo de calor “anómalo”, que a primera vista parece violar la segunda ley de la termodinámica, ofrece a los físicos una forma de detectar el entrelazamiento cuántico sin destruirlo.

Un artículo de Philip Ball. Historia original reimpresa con permiso de Quanta Magazine, una publicación editorialmente independiente respaldada por la Fundación Simons.

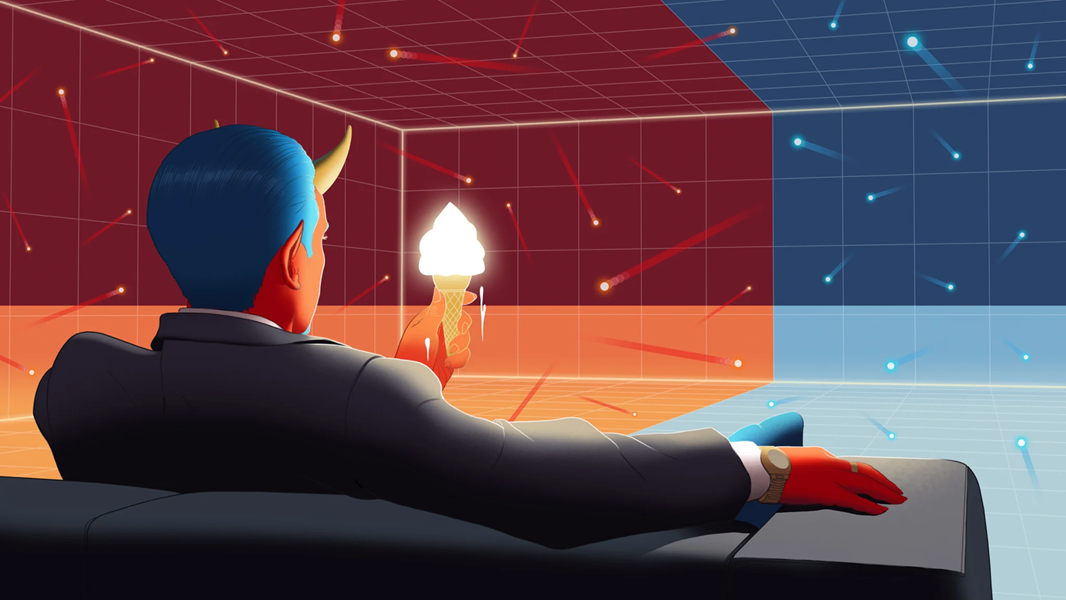

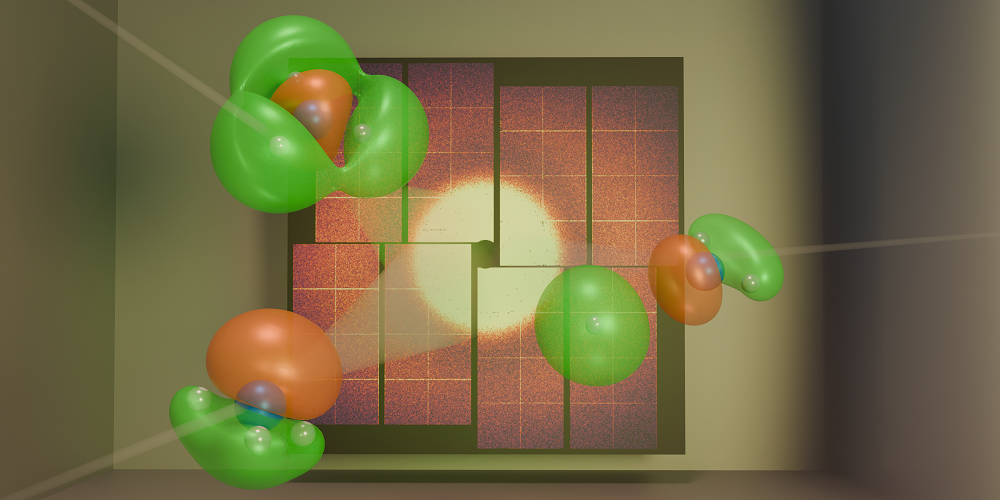

Una variante moderna del demonio de Maxwell puede actuar como una especie de catalizador, impulsando un flujo de calor de objetos cuánticos fríos a calientes. Ilustración: Daniel García / Quanta Magazine

Una variante moderna del demonio de Maxwell puede actuar como una especie de catalizador, impulsando un flujo de calor de objetos cuánticos fríos a calientes. Ilustración: Daniel García / Quanta Magazine

Si hay una ley de la física que parece fácil de comprender, esa es la segunda ley de la termodinámica: el calor fluye espontáneamente de los cuerpos más calientes hacia los más fríos. Pero ahora, de forma suave y casi casual, Alexssandre de Oliveira Jr. acaba de mostrarme que, en realidad, no la entendía del todo.

«Toma esta taza de café caliente y esta jarra de leche fría», dijo el físico brasileño mientras estábamos sentados en una cafetería de Copenhague. «Ponlas en contacto y, efectivamente, el calor fluirá del objeto caliente al frío, tal como el científico alemán Rudolf Clausius formuló oficialmente en 1850». Sin embargo, en algunos casos —explicó de Oliveira— los físicos han descubierto que las leyes de la mecánica cuántica pueden hacer que el flujo de calor ocurra en sentido contrario: del frío al caliente.

Esto no significa realmente que la segunda ley falle, añadió mientras su café se enfriaba con tranquilidad. Lo que sucede es que la expresión de Clausius es el límite clásico de una formulación más completa, exigida por la física cuántica.

Los físicos empezaron a apreciar la sutileza de esta situación hace más de dos décadas y, desde entonces, han estado explorando la versión cuántica de la segunda ley. Ahora, de Oliveira, investigador posdoctoral en la Universidad Técnica de Dinamarca, y sus colegas han demostrado que el tipo de “flujo de calor anómalo” que se da a escala cuántica podría tener una aplicación tan práctica como ingeniosa.

Según afirman, puede servir como un método sencillo para detectar la cuanticidad —por ejemplo, para saber si un objeto está en una superposición cuántica de varios estados observables posibles, o si dos objetos están entrelazados (es decir, sus estados son interdependientes)— sin destruir esos delicados fenómenos cuánticos. Una herramienta diagnóstica así podría usarse para verificar que un ordenador cuántico está utilizando realmente recursos cuánticos al realizar sus cálculos. Incluso podría ayudar a detectar aspectos cuánticos de la fuerza de la gravedad, uno de los grandes objetivos de la física moderna.

Según los investigadores, basta con conectar un sistema cuántico a un segundo sistema capaz de almacenar información sobre él, y a un sumidero térmico (un cuerpo capaz de absorber mucha energía). Con esta disposición, se puede aumentar la transferencia de calor al sumidero más allá de lo que permitirían las leyes clásicas. Midiendo simplemente lo caliente que está el sumidero se podría detectar la presencia de superposición o entrelazamiento en el sistema cuántico.

Más allá de las posibles aplicaciones prácticas, la investigación pone de manifiesto un nuevo aspecto de una profunda verdad sobre la termodinámica: la forma en que el calor y la energía se transforman y se desplazan en los sistemas físicos está íntimamente ligada a la información —a lo que se sabe o puede saberse sobre dichos sistemas—. En este caso, “pagamos” el flujo de calor anómalo sacrificando información almacenada sobre el sistema cuántico.

«Me encanta la idea de que las magnitudes termodinámicas puedan señalar fenómenos cuánticos», afirma la física Nicole Yunger Halpern, de la Universidad de Maryland. «El tema es fundamental y profundo».

El conocimiento es poder

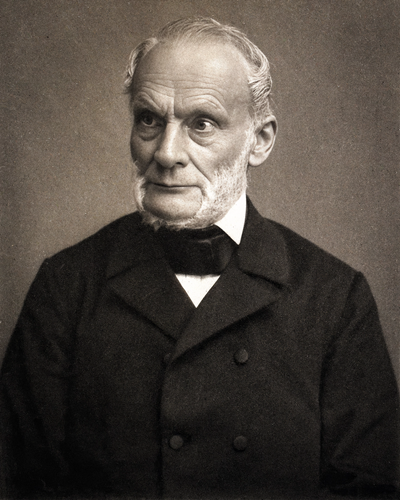

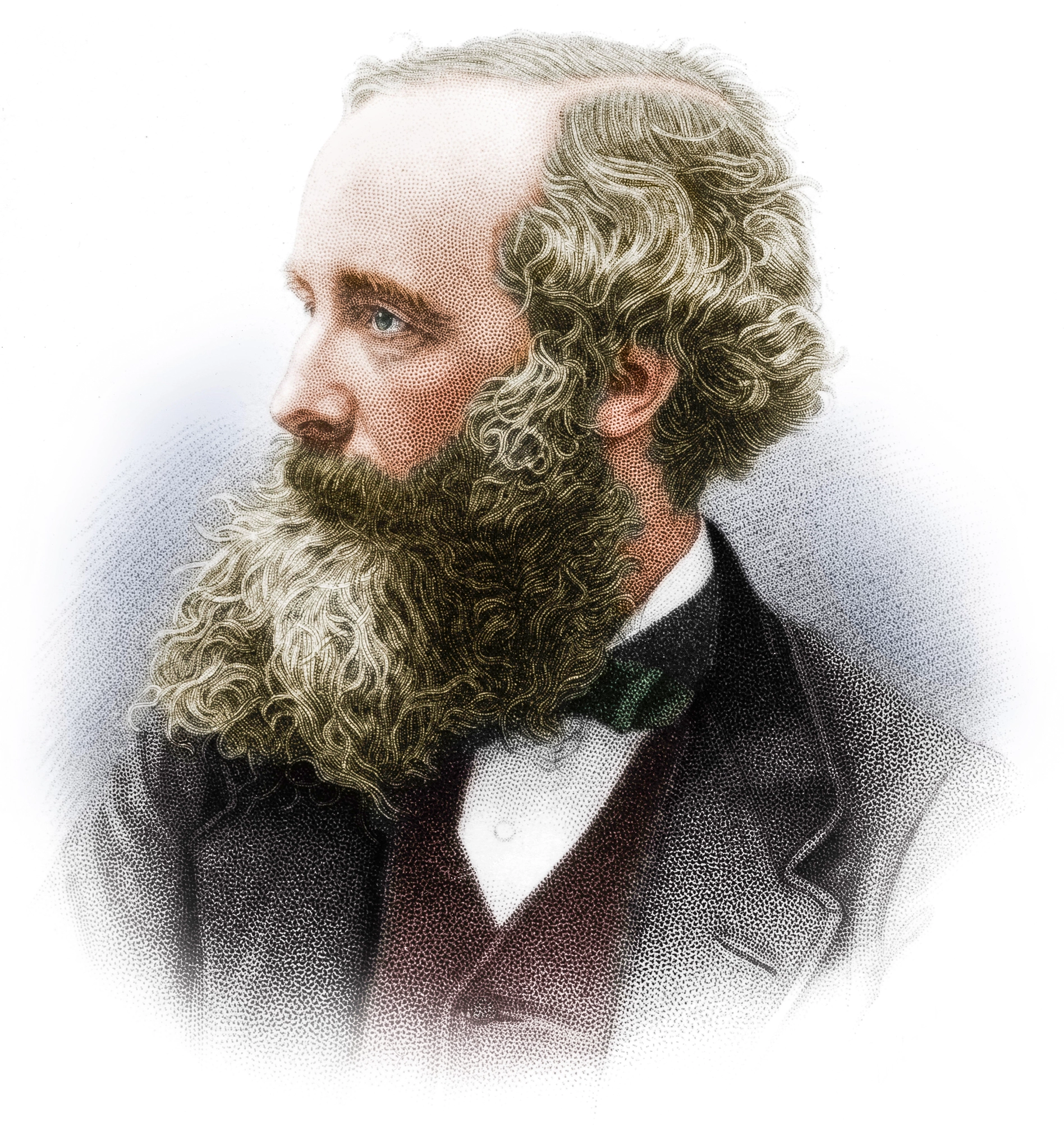

«Es imposible que una máquina autónoma, sin la ayuda de ningún agente externo, transmita calor de un cuerpo a otro a una temperatura más alta», escribió Rudolf Clausius (en alemán) en 1850. Fue la primera expresión de la segunda ley de la termodinámica. Foto: Theo Schafgans/Dominio público

«Es imposible que una máquina autónoma, sin la ayuda de ningún agente externo, transmita calor de un cuerpo a otro a una temperatura más alta», escribió Rudolf Clausius (en alemán) en 1850. Fue la primera expresión de la segunda ley de la termodinámica. Foto: Theo Schafgans/Dominio públicoLa conexión entre la segunda ley de la termodinámica y la información fue explorada por primera vez en el siglo XIX por el físico escocés James Clerk Maxwell. Para su consternación, la segunda ley de Clausius parecía implicar que los focos de calor acabarían disipándose por todo el universo hasta que desapareciesen todas las diferencias de temperatura. En ese proceso, la entropía total del universo —en términos simples, una medida de su desorden y falta de estructura— aumentaría inexorablemente. Maxwell comprendió que esa tendencia acabaría eliminando toda posibilidad de aprovechar los flujos de calor para realizar trabajo útil, y que el universo alcanzaría un equilibrio estéril, dominado por un zumbido térmico uniforme: la llamada “muerte térmica”. Esa perspectiva ya era bastante inquietante por sí misma, pero resultaba especialmente inaceptable para el devoto cristiano Maxwell. En una carta a su amigo Peter Guthrie Tait en 1867, afirmó haber encontrado una manera de “abrir un agujero” en la segunda ley.

Imaginó un diminuto ser (más tarde apodado demonio) capaz de ver el movimiento de las moléculas individuales de un gas. El gas llenaría una caja dividida en dos compartimentos por una pared con una trampilla. Abriendo y cerrando la trampilla selectivamente, el demonio podría separar las moléculas que se mueven más rápido en un lado y las más lentas en el otro, creando así un gas caliente y otro frío, respectivamente. Al actuar según la información obtenida sobre el movimiento molecular, el demonio reduciría la entropía del gas, generando un gradiente de temperatura con el que podría realizarse trabajo mecánico, como empujar un pistón.

Los científicos estaban seguros de que el demonio de Maxwell no podía violar realmente la segunda ley, pero se tardó casi un siglo en comprender por qué. La respuesta es que la información que el demonio recoge y almacena sobre los movimientos moleculares acabaría llenando su memoria finita. Para seguir funcionando, tendría que borrar y reiniciar esa memoria. El físico Rolf Landauer demostró en 1961 que ese borrado consume energía y genera entropía —más entropía de la que el demonio reduce mediante su selección—. El análisis de Landauer estableció una equivalencia entre información y entropía, lo que implica que la información misma puede actuar como un recurso termodinámico: puede transformarse en trabajo. Los físicos demostraron experimentalmente esta conversión de información en energía en 2010.

Incómodo con la segunda ley de la termodinámica, el físico escocés James Clerk Maxwell inventó un experimento mental sobre un demonio omnisciente que aún hoy nos brinda nuevas perspectivas. Imagen: The Print Collector/Heritage Images

Incómodo con la segunda ley de la termodinámica, el físico escocés James Clerk Maxwell inventó un experimento mental sobre un demonio omnisciente que aún hoy nos brinda nuevas perspectivas. Imagen: The Print Collector/Heritage ImagesPero los fenómenos cuánticos permiten procesar información de formas que la física clásica no permite —esa es, de hecho, la base de tecnologías como la computación cuántica y la criptografía cuántica—. Y por eso la teoría cuántica altera la versión convencional de la segunda ley.

Aprovechando las correlaciones

Los objetos cuánticos entrelazados comparten información mutua: están correlacionados, de modo que podemos conocer propiedades de uno observando el otro. Eso, por sí mismo, no es tan extraño; si observas uno de un par de guantes y ves que es el izquierdo, sabes que el otro es el derecho. Pero un par de partículas cuánticas entrelazadas difiere de los guantes en un aspecto esencial: mientras que la lateralidad de los guantes está fijada antes de mirar, en las partículas no es así, según la mecánica cuántica. Antes de medirlas, no está decidido qué valor de una propiedad observable tiene cada partícula del par entrelazado. En ese momento solo conocemos las probabilidades de las posibles combinaciones de valores (por ejemplo, 50 % izquierda-derecha y 50 % derecha-izquierda). Solo cuando medimos el estado de una partícula esas posibilidades se resuelven en un resultado concreto. En ese proceso de medición, el entrelazamiento se destruye.

Si las moléculas de un gas están entrelazadas de esta manera un demonio de Maxwell puede manipularlas con más eficacia que si todas se movieran independientemente. Si el demonio sabe, por ejemplo, que cada molécula rápida que ve venir está correlacionada de tal modo que otra rápida la seguirá al instante, no necesita observar la segunda partícula antes de abrir la trampilla para dejarla pasar. El coste termodinámico de (temporalmente) desafiar la segunda ley se reduce.

En 2004, los teóricos cuánticos Časlav Brukner, de la Universidad de Viena, y Vlatko Vedral, entonces en el Imperial College de Londres, señalaron que esto significa que las mediciones termodinámicas macroscópicas pueden utilizarse como un “testigo” para revelar la presencia de entrelazamiento cuántico entre partículas. Bajo ciertas condiciones, mostraron que la capacidad calorífica de un sistema o su respuesta a un campo magnético aplicado debería llevar la huella del entrelazamiento, si este existe.

De manera similar, otros físicos calcularon que se puede extraer más trabajo de un cuerpo caliente cuando hay entrelazamiento cuántico en el sistema que cuando es puramente clásico.

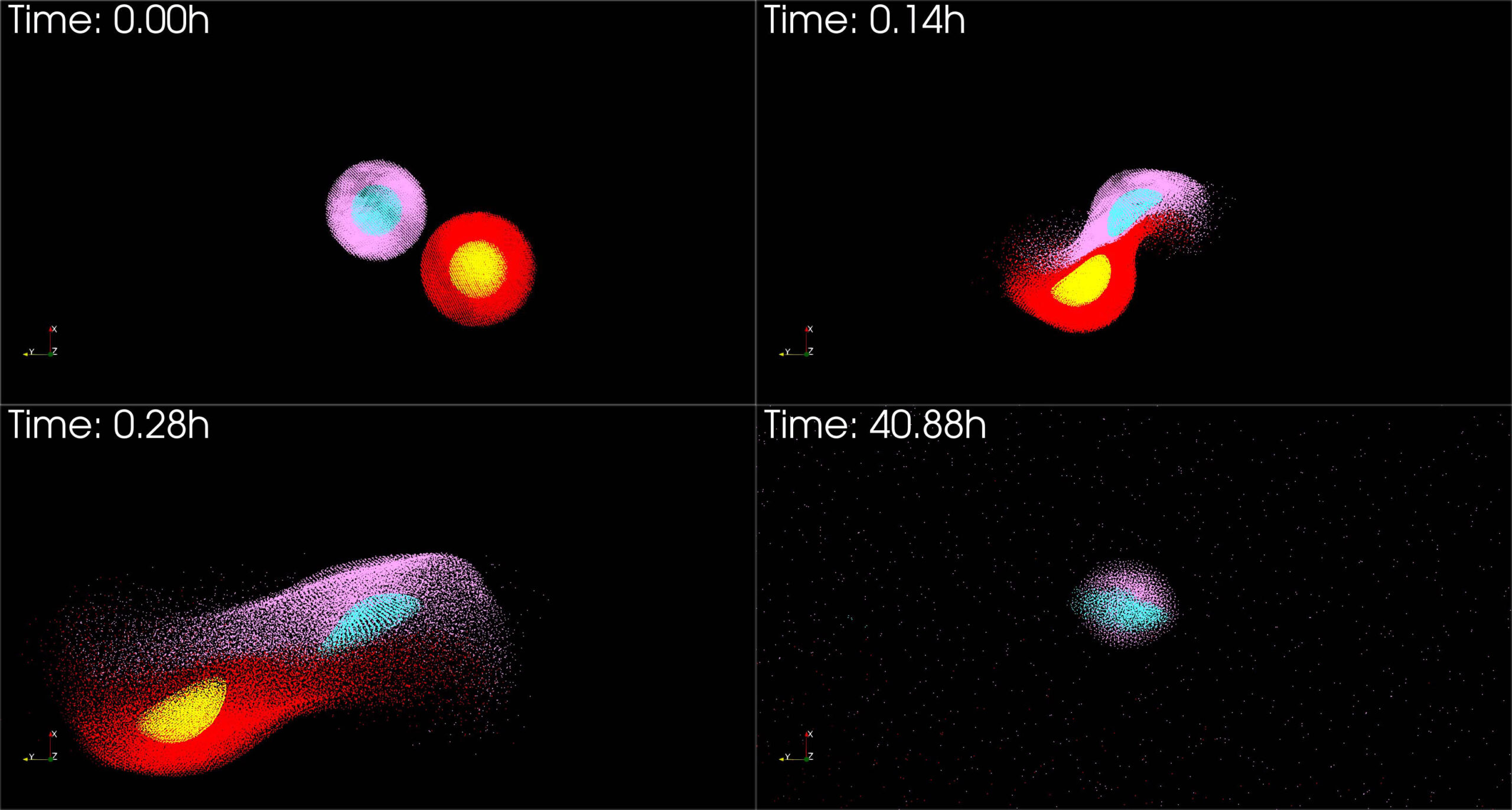

Y en 2008, el físico Hossein Partovi, de la Universidad Estatal de California, identificó una consecuencia particularmente llamativa del modo en que el entrelazamiento cuántico puede cuestionar las intuiciones derivadas de la termodinámica clásica. Descubrió que la presencia de entrelazamiento puede incluso invertir el flujo espontáneo de calor de un objeto caliente a uno frío, aparentemente subvirtiendo la segunda ley.

Esa inversión es una forma especial de refrigeración, explica Yunger Halpern. Y, como ocurre siempre con la refrigeración, no es gratuita (y por tanto no viola realmente la segunda ley). Clásicamente, refrigerar un objeto requiere trabajo: hay que bombear el calor en dirección contraria consumiendo combustible, compensando así la entropía perdida al enfriar el cuerpo frío y calentar el caliente. Pero en el caso cuántico —sigue Yunger Halpern—, en lugar de quemar combustible para lograr la refrigeración, «se queman las correlaciones». Es decir, a medida que avanza el flujo de calor anómalo, el entrelazamiento se destruye: las partículas que inicialmente tenían propiedades correlacionadas se vuelven independientes. «Podemos usar las correlaciones como un recurso para empujar el calor en dirección opuesta», añade.

Vlatko Vedral es uno de los creadores de la idea de utilizar mediciones termodinámicas como «testigo» para revelar la presencia de entrelazamiento cuántico entre partículas. foto: Cortesía de Vlatko Vedral

Vlatko Vedral es uno de los creadores de la idea de utilizar mediciones termodinámicas como «testigo» para revelar la presencia de entrelazamiento cuántico entre partículas. foto: Cortesía de Vlatko VedralDe hecho, el “combustible” aquí es la información misma: concretamente, la información mutua de los cuerpos calientes y fríos entrelazados.

Dos años más tarde, David Jennings y Terry Rudolph, del Imperial College de Londres, aclararon lo que sucede. Mostraron cómo puede reformularse la segunda ley de la termodinámica para incluir el caso en que existe información mutua, y calcularon los límites sobre cuánto puede modificarse —e incluso invertirse— el flujo de calor clásico mediante el consumo de correlaciones cuánticas.

El demonio sabe de cuanticidad

Cuando entran en juego los efectos cuánticos la segunda ley deja de ser tan sencilla. Pero ¿podemos hacer algo útil con la forma en que la física cuántica flexibiliza los límites de las leyes termodinámicas? Esa es una de las metas de la disciplina llamada termodinámica cuántica, en la que algunos investigadores buscan fabricar motores cuánticos más eficientes que los clásicos o baterías cuánticas que se carguen más rápidamente.

Patryk Lipka-Bartosik, del Centro de Física Teórica de la Academia Polaca de Ciencias, ha buscado aplicaciones prácticas en la dirección contraria: usar la termodinámica como herramienta para explorar la física cuántica. El año pasado, él y sus colaboradores vieron cómo materializar la idea de Brukner y Vedral (2004) de utilizar propiedades termodinámicas como testigo del entrelazamiento cuántico. Su esquema involucra sistemas cuánticos calientes y fríos correlacionados entre sí, y un tercer sistema que media el flujo de calor entre ambos. Podemos pensar en este tercer sistema como en un demonio de Maxwell, solo que ahora posee una “memoria cuántica” que puede estar entrelazada con los sistemas que manipula. Al estar entrelazados con la memoria del demonio, los sistemas caliente y frío quedan efectivamente vinculados, de modo que el demonio puede inferir información de uno a partir de las propiedades del otro.

Patryk Lipka-Bartosik ha explorado cómo utilizar mediciones termodinámicas para detectar efectos cuánticos. Foto: Alicja Lipka-Bartosik

Patryk Lipka-Bartosik ha explorado cómo utilizar mediciones termodinámicas para detectar efectos cuánticos. Foto: Alicja Lipka-BartosikUn demonio cuántico así puede actuar como un tipo de catalizador, facilitando la transferencia de calor al aprovechar correlaciones que de otro modo serían inaccesibles. Es decir, al estar entrelazado con los objetos caliente y frío, el demonio puede detectar y explotar todas sus correlaciones de manera sistemática. Y, de nuevo como un catalizador, este tercer sistema vuelve a su estado original una vez completado el intercambio de calor entre los objetos. De esta forma, el proceso puede potenciar el flujo de calor anómalo más allá de lo que sería posible sin dicho catalizador.

El artículo publicado este año por de Oliveira, junto con Lipka-Bartosik y Jonatan Bohr Brask, de la Universidad Técnica de Dinamarca, utiliza algunas de estas mismas ideas, pero con una diferencia crucial que convierte el sistema en una especie de termómetro para medir la cuanticidad. En el trabajo anterior, la memoria cuántica —el demonio— interactuaba con un par de sistemas cuánticos correlacionados, uno caliente y otro frío. Pero en este nuevo trabajo se coloca entre un sistema cuántico (por ejemplo, una red de bits cuánticos, o qubits, entrelazados en un ordenador cuántico) y un sumidero térmico sencillo con el que el sistema cuántico no está directamente entrelazado.

Como la memoria está entrelazada tanto con el sistema cuántico como con el sumidero, puede de nuevo catalizar un flujo de calor entre ellos más allá de lo posible clásicamente. En ese proceso, el entrelazamiento dentro del sistema cuántico se convierte en calor adicional que fluye hacia el sumidero. Así, medir la energía almacenada en el sumidero (equivalente a leer su “temperatura”) revela la presencia de entrelazamiento en el sistema cuántico. Pero, dado que el sistema y el sumidero no están entrelazados entre sí, la medición no afecta al estado del sistema cuántico. Este recurso elude la conocida dificultad de que las mediciones destruyen la cuanticidad. «Si intentaras simplemente medir el sistema [cuántico] directamente, destruirías su entrelazamiento antes incluso de que el proceso se desarrollara», explica de Oliveira.

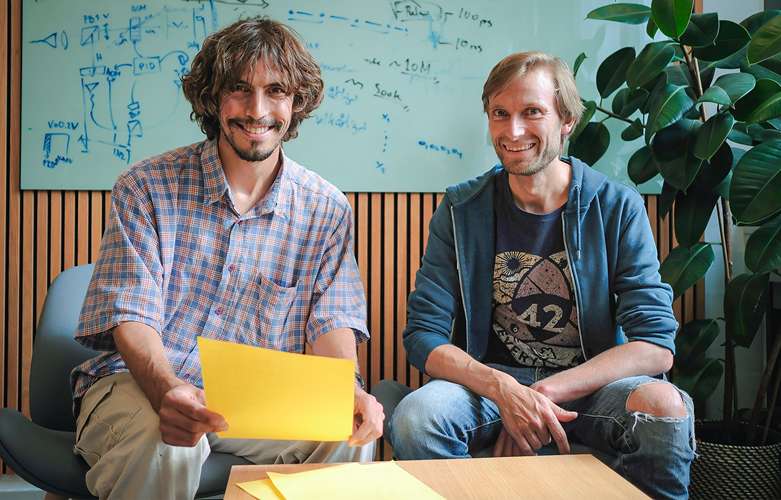

Los físicos Alexssandre de Oliveira Jr. (izquierda) y Jonatan Bohr Brask (derecha) colaboraron con Patryk Lipka-Bartosik en un nuevo esquema para detectar la cuántica sin destruirla. Foto: Jonas Schou Neergaard-Nielsen

Los físicos Alexssandre de Oliveira Jr. (izquierda) y Jonatan Bohr Brask (derecha) colaboraron con Patryk Lipka-Bartosik en un nuevo esquema para detectar la cuántica sin destruirla. Foto: Jonas Schou Neergaard-NielsenEl nuevo esquema tiene la ventaja de ser simple y general, señala Vedral, ahora en la Universidad de Oxford. «Estos protocolos de verificación son muy importantes», dice: cada vez que una empresa de computación cuántica anuncia un nuevo dispositivo, siempre surge la cuestión de cómo —o si— saben realmente que el entrelazamiento entre los qubits está contribuyendo al cálculo. Un sumidero térmico podría actuar como detector de tales fenómenos cuánticos simplemente a través de su cambio de energía. Para implementar la idea, podría designarse un qubit como la memoria cuyo estado revele el de otros qubits, y luego acoplar ese qubit de memoria a un conjunto de partículas que funcionen como sumidero, cuya energía se pueda medir. (Vedral añade una salvedad: es necesario tener un control muy preciso del sistema para asegurarse de que no haya otras fuentes de flujo de calor que contaminen las mediciones. Además, el método no detectará todos los estados entrelazados.)

De Oliveira cree que ya existe un sistema adecuado para poner a prueba su idea experimentalmente. Él y sus colegas están en conversaciones con el grupo de investigación de Roberto Serra en la Universidad Federal del ABC, en São Paulo (Brasil). En 2016, Serra y sus colaboradores utilizaron las orientaciones magnéticas, o espines, de los átomos de carbono e hidrógeno en moléculas de cloroformo como bits cuánticos entre los que podían transferir calor.

Usando este montaje, dice de Oliveira, debería ser posible aprovechar un comportamiento cuántico —en este caso la coherencia, es decir, que las propiedades de dos o más espines evolucionan en fase entre sí— para modificar el flujo de calor entre los átomos. La coherencia de los qubits es esencial para la computación cuántica, así que poder verificarla detectando un intercambio de calor anómalo sería muy útil.

Las implicaciones podrían ser aún mayores. Varios grupos de investigación intentan diseñar experimentos para determinar si la gravedad es una fuerza cuántica, al igual que las otras tres fuerzas fundamentales. Algunos de estos esfuerzos consisten en buscar entrelazamiento cuántico entre dos objetos generado únicamente por su atracción gravitatoria mutua. Tal vez los investigadores puedan explorar ese entrelazamiento inducido por la gravedad mediante simples mediciones termodinámicas sobre los objetos, verificando así (o no) que la gravedad está realmente cuantizada.

Para estudiar una de las cuestiones más profundas de la física —concluye Vedral—, «¿no sería maravilloso poder hacerlo con algo tan sencillo y macroscópico como esto?».

El artículo original, A Thermometer for Measuring Quantumness, se publicó el 1 de octubre de 2025 en Quanta Magazine. Cuaderno de Cultura Científica tiene un acuerdo de distribución en castellano con Quanta Magazine.

Traducido por César Tomé López

El artículo Un termómetro para medir la cuanticidad se ha escrito en Cuaderno de Cultura Científica.

Rarezas quiméricas: dientes fuera de la boca con funciones sexuales

El Diccionario de la lengua española define “quimérico” como fabuloso, fingido o imaginado sin fundamento, pero aquí nos referimos a una sorprendente peculiaridad recién descubierta en las quimeras u holocéfalos, un pequeño grupo de peces marinos. Los machos de estos peces son el único caso conocido de formación de dientes fuera de la cavidad bucal, unos dientes que usan para sujetar a la hembra durante la cópula.

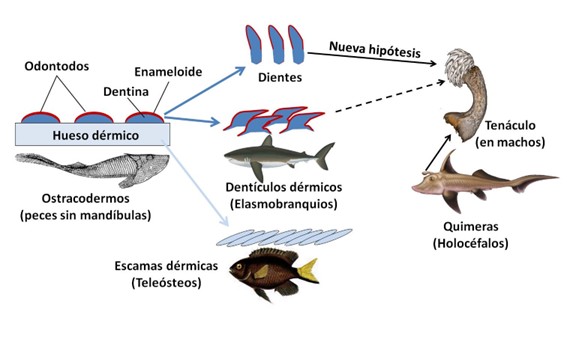

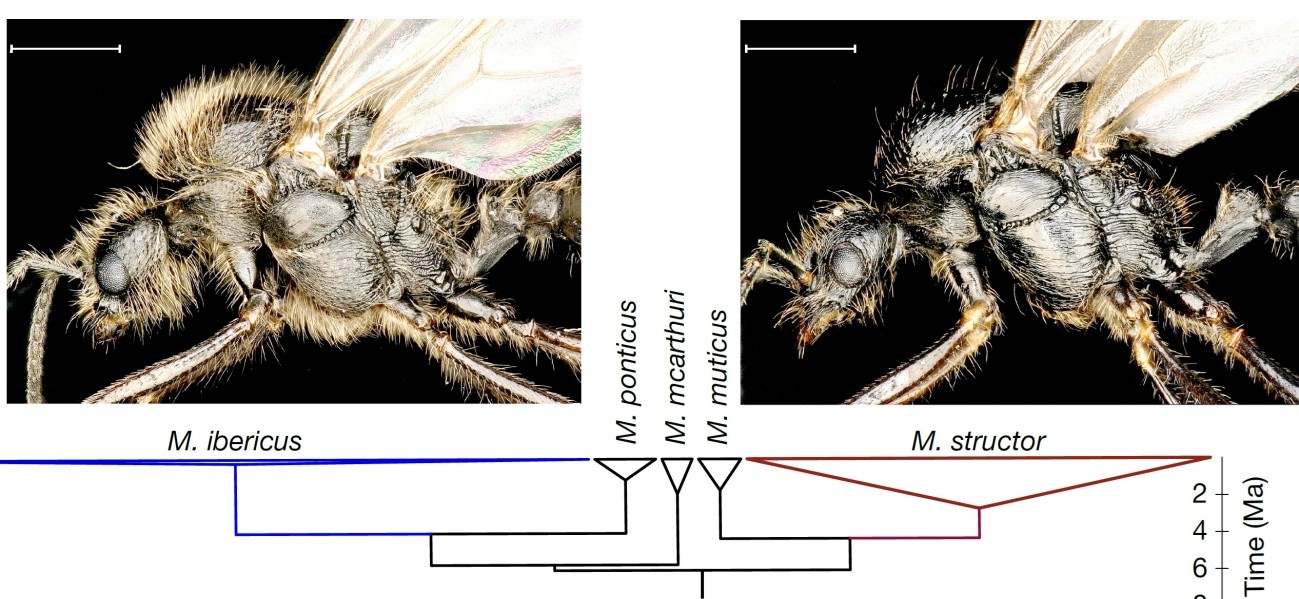

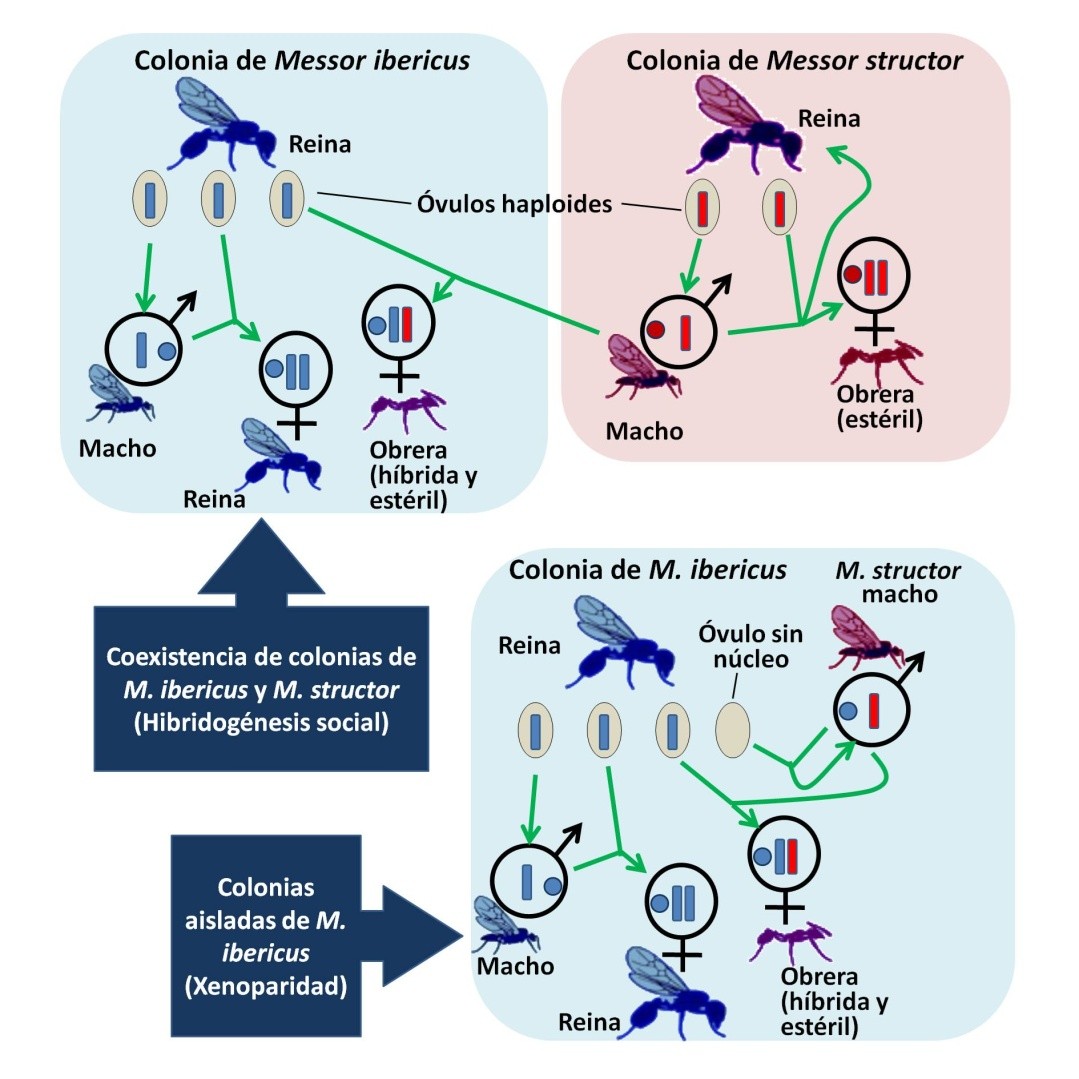

Vayamos por orden y comencemos por tratar el origen de los dientes en los vertebrados. Los primeros vertebrados aparecieron en el Cámbrico, hace unos 520 millones de años. Carecían de mandíbulas y su cuerpo era blando y vulnerable, pero muy pronto adquirieron una especie de caparazón de hueso dérmico (peces ostracodermos). Este caparazón está cubierto por unos pequeños tubérculos constituidos por dentina (una forma compacta de hueso) y recubiertos por un tipo de esmalte (enameloide). Son los llamados “odontodos” (Figura 1). Cuando los peces desarrollaron mandíbulas a partir del esqueleto branquial, hace unos 420-430 millones de años, aprovecharon los odontodos para fijarlos a las mandíbulas y formar los dientes[1].

Figura 1. Los odontodos del caparazón de los peces ostracodermos son el origen evolutivo tanto de los dentículos dérmicos de los elasmobranquios como de los dientes. En cambio, las escamas de los teleósteos derivan del hueso dérmico de dicho caparazón. Se pensaba que las espinas del tenáculo de las quimeras derivaban de los dentículos dérmicos (flecha discontinua), pero un nuevo estudio sugiere que se originaron a partir de dientes. Se han utilizado imágenes de Damouraptor, Gasmasque y Cohen et al. (2025), cita completa en referencias, con licencia CC BY 4.0.

Figura 1. Los odontodos del caparazón de los peces ostracodermos son el origen evolutivo tanto de los dentículos dérmicos de los elasmobranquios como de los dientes. En cambio, las escamas de los teleósteos derivan del hueso dérmico de dicho caparazón. Se pensaba que las espinas del tenáculo de las quimeras derivaban de los dentículos dérmicos (flecha discontinua), pero un nuevo estudio sugiere que se originaron a partir de dientes. Se han utilizado imágenes de Damouraptor, Gasmasque y Cohen et al. (2025), cita completa en referencias, con licencia CC BY 4.0.Los peces armados de mandíbulas y dentadura aumentaron de tamaño y llegaron a ser los predadores dominantes durante el periodo Devónico. Paralelamente, el caparazón óseo defensivo disminuyó su importancia, dando lugar a las escamas de los peces (Figura 1). En el grupo de los condrictios (elasmobranquios -es decir, tiburones y rayas- y quimeras) estas escamas retienen la composición de los odontodos primitivos, formados por dentina y un recubrimiento muy duro similar al esmalte dentario. Por eso, el cuerpo de los elasmobranquios actuales está cubierto de dentículos dérmicos derivados de los odontodos. En las quimeras, cuyo linaje se separó muy pronto del de los elasmobranquios, la mayor parte de la piel los ha perdido pero se mantienen en los apéndices copuladores.

Las quimeras forman un grupo muy reducido de peces marinos, alrededor de 50 especies de aguas profundas. A diferencia de tiburones y rayas no tienen dientes individuales, ya que se sueldan formando placas dentarias. Sí comparten con elasmobranquios la fecundación interna, y los machos disponen de una serie de apéndices copuladores en la región pélvica para sujetar a la hembra. Además, los machos tienen un curiosísimo apéndice, el tenáculo, situado entre los ojos, y dotado de unas fuertes espinas (Figura 2). Todo parece indicar que su función es también ayudar en la cópula y se consideraba que sus espinas eran dentículos dérmicos modificados, como los de los apéndices pélvicos.

Hasta ahora. Un estudio publicado en PNAS por investigadores estadounidenses sugiere que el tenáculo está provisto de auténticos dientes, lo que constituiría el único caso conocido entre los vertebrados en que los dientes se desarrollan fuera de la cavidad bucal.

Figura 2. Macho de quimera (Hydrolagus collei) y detalle del tenáculo. Modificado de Cohen et al. (2025), cita completa en referencias, con licencia CC BY 4.0.

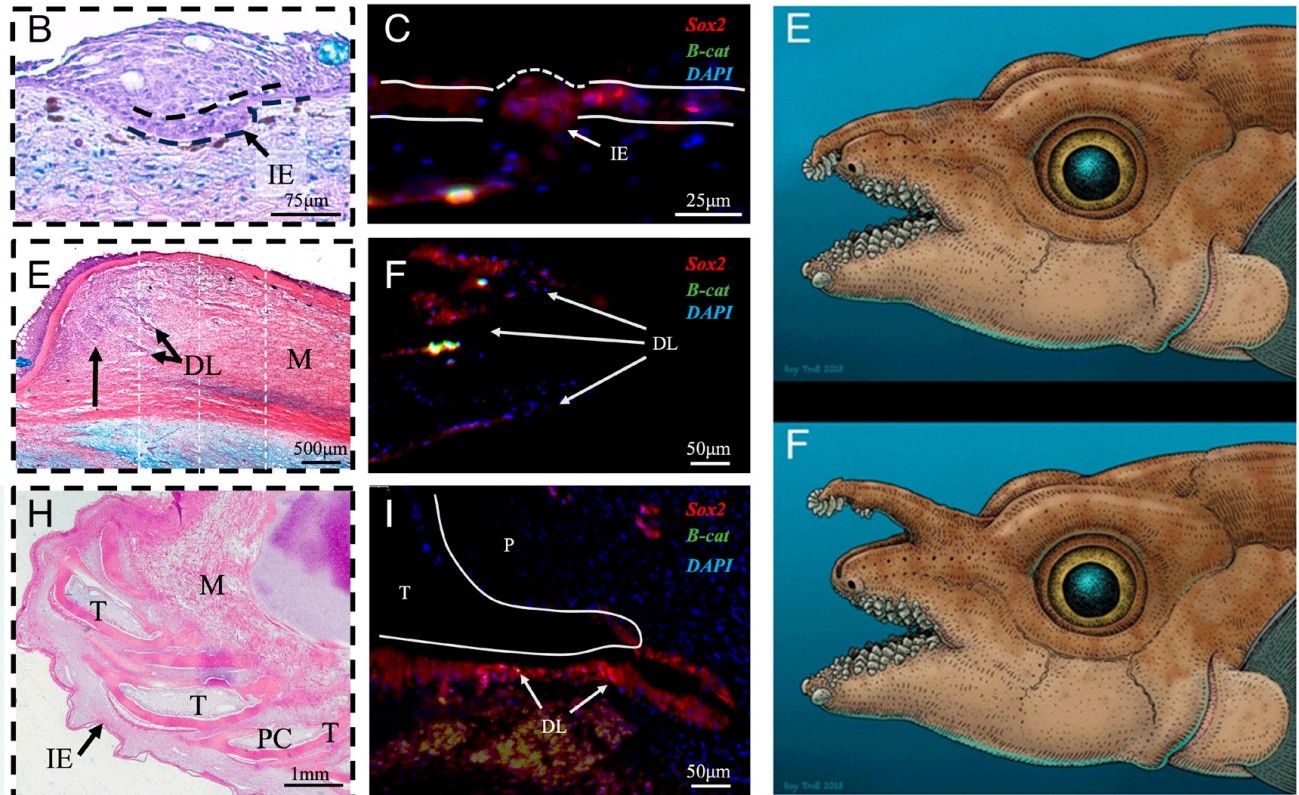

Figura 2. Macho de quimera (Hydrolagus collei) y detalle del tenáculo. Modificado de Cohen et al. (2025), cita completa en referencias, con licencia CC BY 4.0.El estudio consistió en una descripción del desarrollo embrionario del tenáculo en machos de la quimera Hydrolagus collei (Figura 2). Los dientes del tenáculo se desarrollan a partir de una estructura llamada lámina dental, que es la responsable de formar los dientes seriados en los elasmobranquios (recordemos que las quimeras tienen los dientes soldados en placas). Ni los dentículos dérmicos ni las escamas de los apéndices copuladores pélvicos de las quimeras se desarrollan a partir de una lámina dental. Por otro lado, el desarrollo de dientes en elasmobranquios (pero no el de los dentículos dérmicos) requiere la expresión del gen Sox2 (característico de las células madre dentales) y la activación de la proteína b-catenina. Pues bien, estos dos elementos están presentes en el desarrollo de los dientes del tenáculo (Figura 3). Más interesante aún, la expresión de Sox2 se mantiene en la lámina dental del tenáculo adulto, exactamente igual que sucede en las mandíbulas de elasmobranquios. Esta expresión en adultos permite la formación continua de dientes característica de tiburones y rayas.

Figura 3. A la izquierda se muestran tres etapas en el desarrollo del tenáculo. Se observa la lámina dental (DL) y los dientes (T) formándose en el interior del tejido. Células de la lámina dental expresan Sox2 (marcador de células madre dentales) y b-catenina. La figura I corresponde a un adulto, y revela que la expresión de Sox2 se mantiene en la lámina dental. Esto es lo mismo que sucede en elasmobranquios, permitiendo una formación continua de dientes en adultos. A la derecha, reconstrucción de la quimera fósil Helodus simplex. Los dientes del largo tenáculo encajan en la sínfisis mandibular. Modificado de Cohen et al. (2025), cita completa en referencias, con licencia CC BY 4.0.

Figura 3. A la izquierda se muestran tres etapas en el desarrollo del tenáculo. Se observa la lámina dental (DL) y los dientes (T) formándose en el interior del tejido. Células de la lámina dental expresan Sox2 (marcador de células madre dentales) y b-catenina. La figura I corresponde a un adulto, y revela que la expresión de Sox2 se mantiene en la lámina dental. Esto es lo mismo que sucede en elasmobranquios, permitiendo una formación continua de dientes en adultos. A la derecha, reconstrucción de la quimera fósil Helodus simplex. Los dientes del largo tenáculo encajan en la sínfisis mandibular. Modificado de Cohen et al. (2025), cita completa en referencias, con licencia CC BY 4.0.¿Cómo es posible que se formen dientes en una estructura localizada entre los ojos, en animales que, además, carecen de dientes aislados en las mandíbulas? La respuesta parece estar en una quimera fósil, Helodus simplex, que vivió hace 315 millones de años y que sí tenía dientes aislados (Figura 3). Los machos de Helodus poseían un largo tenáculo situado en la región etmoidea, y su extremo alcanzaba la sínfisis entre las dos mandíbulas superiores. Es concebible que el epitelio de ese extremo del tenáculo adquiriera capacidad odontogénica durante el desarrollo. A lo largo de la evolución, el tenáculo habría mantenido la capacidad de formar dientes pero se habría reducido en longitud hasta el tamaño actual, al tiempo que los dientes mandibulares terminaron soldándose en placas.

Las quimeras mitológicas eran monstruos híbridos que combinaban partes de distintos animales. Este insólito descubrimiento acerca de dientes extrabucales nos muestra cómo la realidad de la naturaleza puede igualar, si no superar, a la imaginación humana.

Referencias

Cohen, K.E., Coates, M.I., Fraser, G.J. (2025). Teeth outside the jaw: Evolution and development of the toothed head clasper in chimaeras. Proc Natl Acad Sci U S A. doi: 10.1073/pnas.2508054122.

Sobre el autor: Ramón Muñoz-Chápuli Oriol es Catedrático de Biología Animal (jubilado) de la Universidad de Málaga.

Nota:

[1] Es la llamada hipótesis “de fuera a dentro”. Un modelo alternativo, menos apoyado, es que los dientes proceden de una dentición faríngea que ya estaba presente en ostracodermos.

El artículo Rarezas quiméricas: dientes fuera de la boca con funciones sexuales se ha escrito en Cuaderno de Cultura Científica.

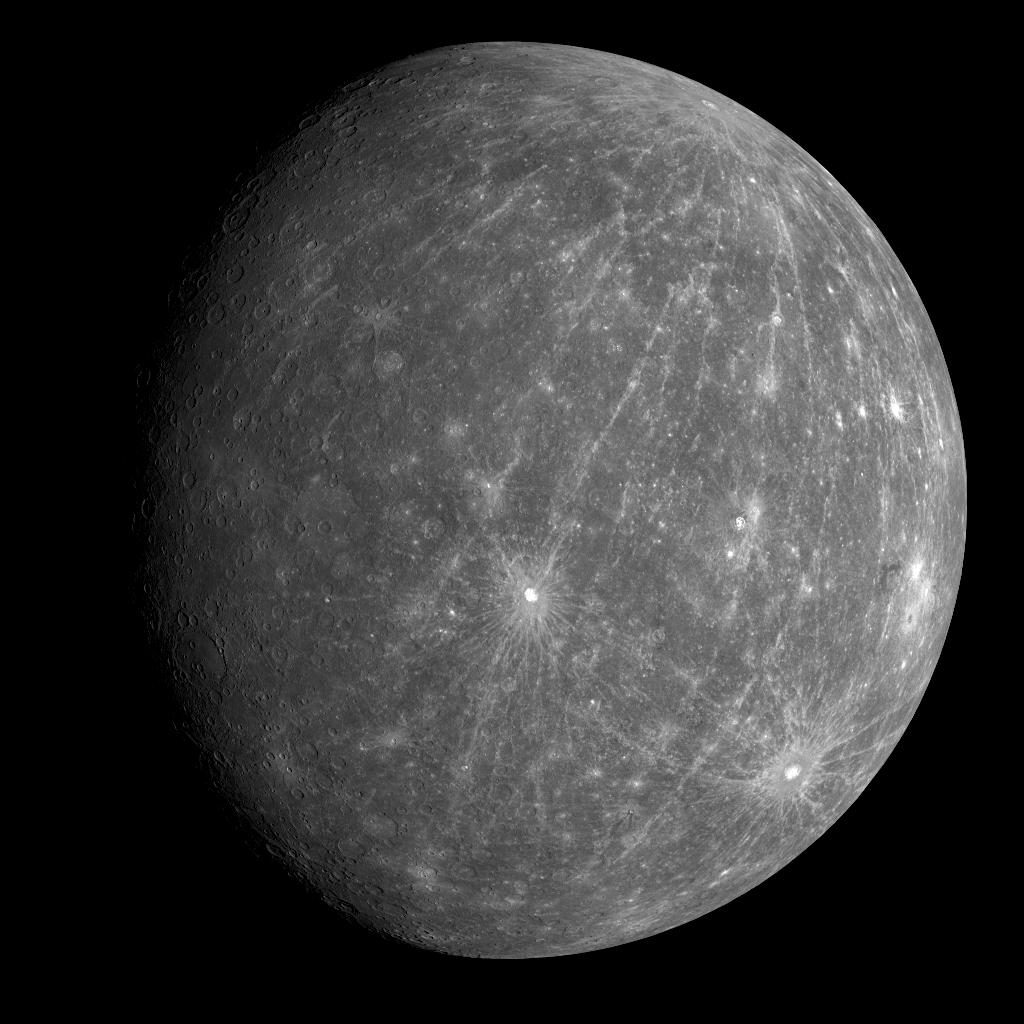

¿Cuándo podremos decir que “hemos encontrado vida en Marte”?

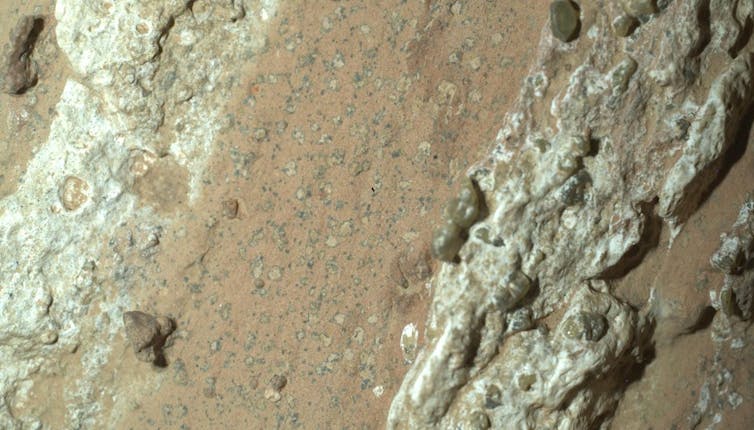

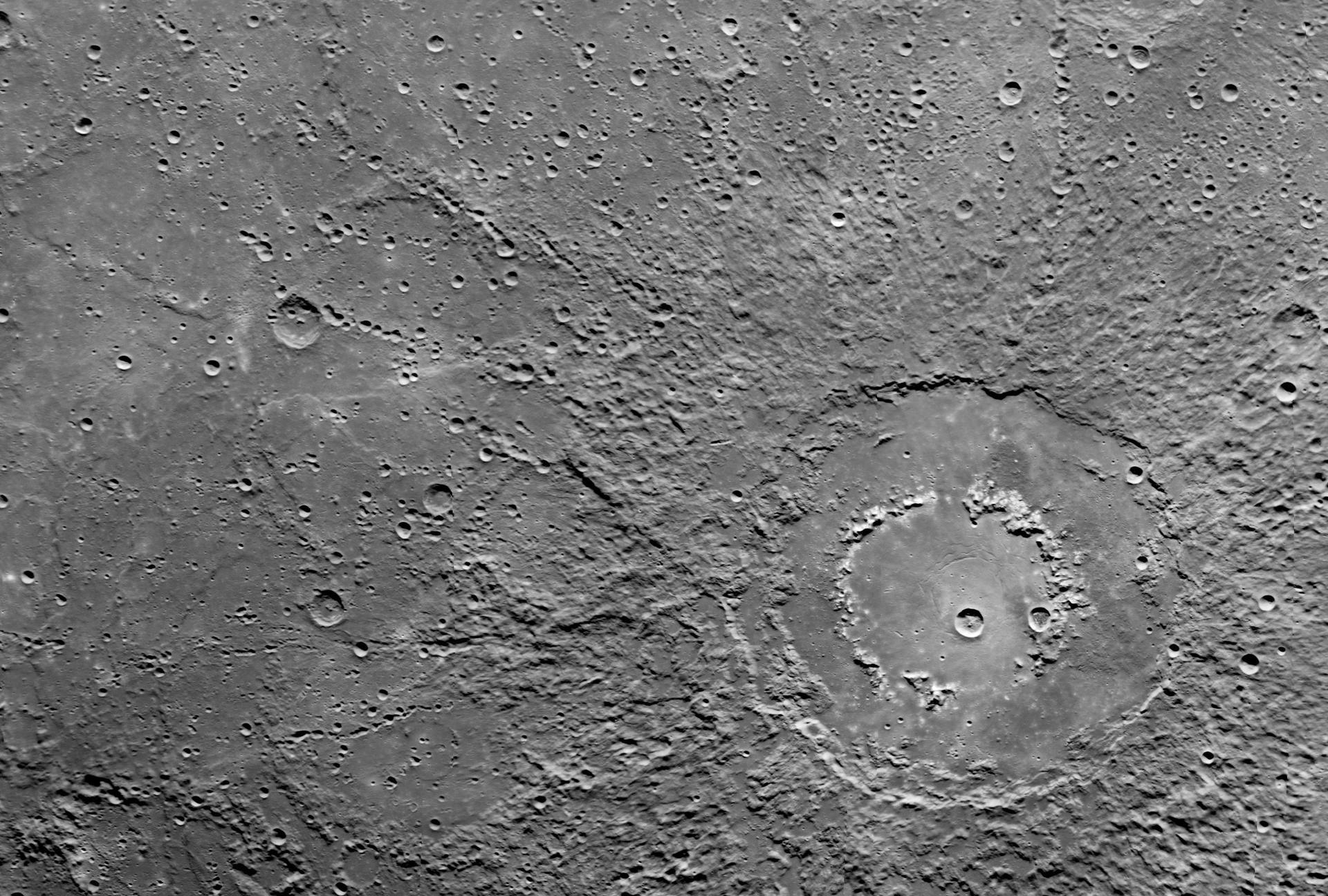

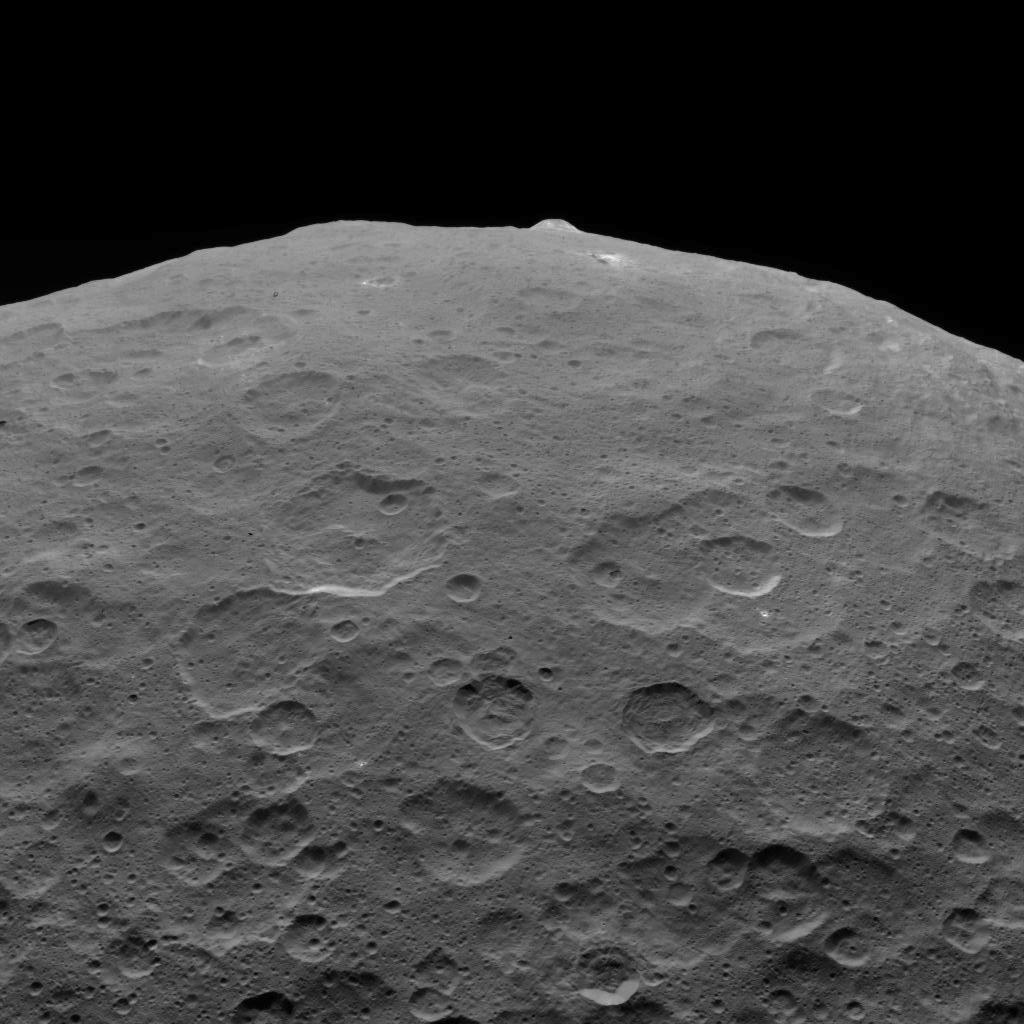

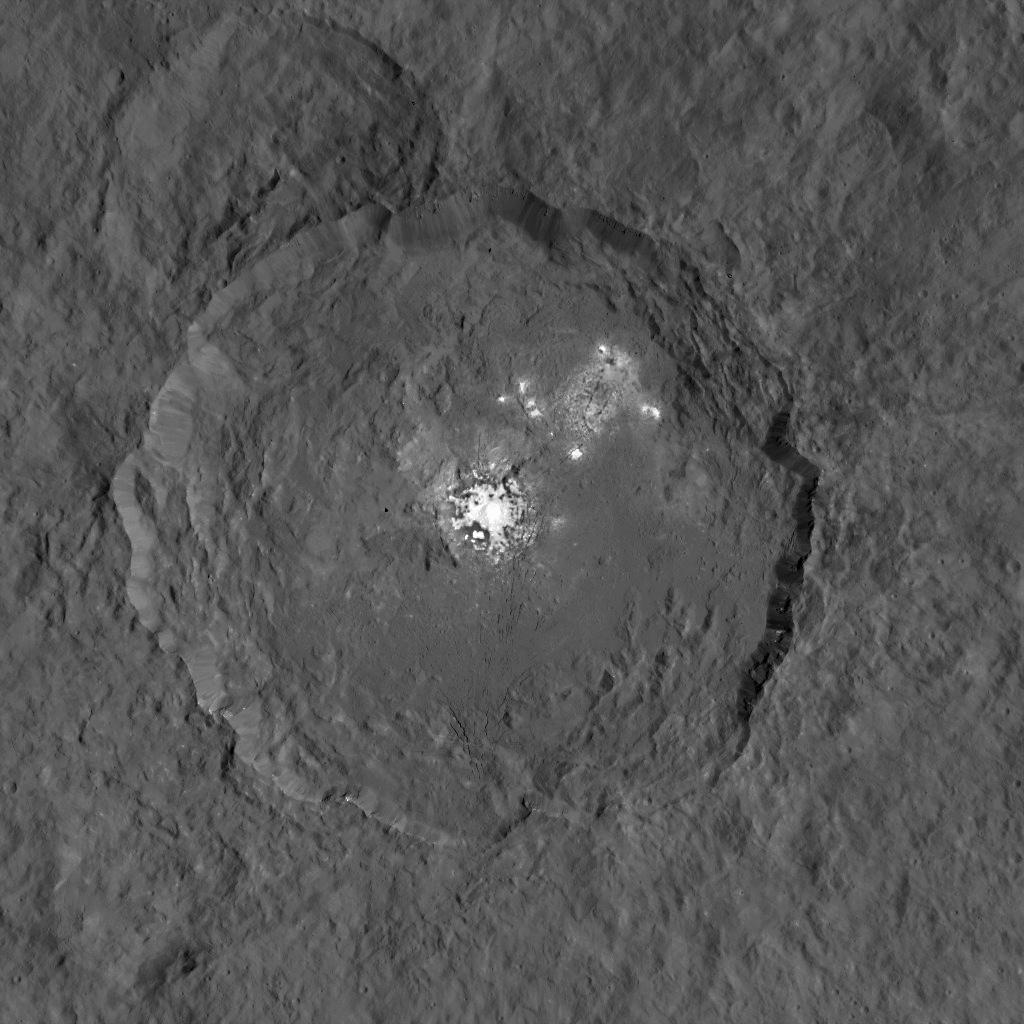

Las manchas de leopardo encontradas en el crater Jerezo de Marte podrían indicar que, hace miles de millones de años, las reacciones químicas en esta roca podrían haber sustentado vida microbiana. Foto:NASA/JPL-Caltech/MSSS, CC BY

Las manchas de leopardo encontradas en el crater Jerezo de Marte podrían indicar que, hace miles de millones de años, las reacciones químicas en esta roca podrían haber sustentado vida microbiana. Foto:NASA/JPL-Caltech/MSSS, CC BYUna roca moteada, bautizada como “Cheyava Falls” y situada en un antiguo cauce fluvial del cráter Jezero, ha encendido de nuevo una pregunta antigua con traje moderno: ¿hay o hubo vida en Marte?

Entre minerales rojos e indicios orgánicos, la NASA acaba de anunciar el hallazgo de posibles biofirmas en un roca marciana. El comunicado ha desatado el frenesí, pero en ciencia es un frenesí cauto.

Este es un análisis –con los pies en los datos– sobre pistas, escalas de certeza y lo que significaría oír, por fin, un “sí, esto es vida extraterrestre”. Pero aún no ha llegado el momento.

Los indicios de vida en MarteDesde hace años, la NASA ha ido informando de hallazgos que se acercan a lo que podría parecerse a una huella de vida.

En 1976, las sondas Viking realizaron los primeros experimentos biológicos en Marte. Sus resultados fueron intrigantes, pero también muy polémicos, y no se consideraron una prueba concluyente de vida. Desde entonces, ninguna misión ha vuelto a llevar experimentos tan directos. La lección de Viking es clara: en la exploración del planeta rojo, conviene mantener la curiosidad… pero también la cautela en las expectativas.

En 2018, la NASA informó de indicios de vida orgánica en barro antiguo de Marte. Entonces el rover Curiosity detectó en el cráter Gale moléculas orgánicas preservadas en lutitas lacustres (un tipo de roca sedimentaria, compuesta por partículas muy finas de arcilla y limo que se depositaron en el fondo de los lagos) de aproximadamente 3500 millones de años, así como una variación estacional del metano de fondo. Son ingredientes y pistas, pero no es propiamente vida.

En el estudio reciente, la NASA informa que en la zona conocida como Bright Angel, el instrumento SHERLOC del rover Perseverance también identificó la presencia de moléculas orgánicas, mientras que el instrumento PIXL mapeó minerales como vivianita y greigita en un lodo rico en hierro, fósforo y azufre.

Pero este tipo de mezcla puede formarse tanto por la acción de microorganismos como por procesos puramente químicos. Así que puede ser un indicio de vida, o no.

Esa ambigüedad es justo lo que resalta la síntesis publicada en Nature, que subraya cómo estos hallazgos mantienen abierto el debate sobre si Marte albergó vida o no.

Las muestras de metanoAnteriormente, el Curiosity detectó variaciones locales y estacionales en la presencia de metano en el planeta vecino, algo que también podría asociarse con una biofirma. Sin embargo, el orbitador europeo TGO (de la misión ExoMars) no ha encontrado prácticamente nada: sus mediciones ponen un límite global muy estricto, menos de 0,05 partes por mil millones.

El reto ahora es conciliar ambos resultados: ¿se trata de pequeñas emisiones superficiales que la atmósfera elimina rápidamente, o de mediciones que están sesgadas por factores aún desconocidos? La ciencia sigue en curso y la respuesta todavía no está cerrada.

¿Qué sería una prueba irrefutable?Tras varias decepciones, la comunidad científica ha elaborado una “escala de confianza” para detectar vida, llamada Confidence of Life Detection (CoLD).. Es como una escalera de siete peldaños: primero se detecta una posible señal y después hay que descartar contaminación; demostrar que la biología sería viable en ese entorno; excluir explicaciones no biológicas; encontrar otra señal independiente; derrotar hipótesis alternativas… y, por último, conseguir confirmación por distintos equipos. ¿Cómo se sube esa escalera? No con un único hallazgo espectacular, sino con varias pruebas que, juntas, formen un caso sólido.

Una química orgánica compleja con homoquiralidad (se refiere a moléculas que tienen una estructura no superponible con su imagen especular, similar a la de nuestras manos) sería un buen indicio, porque es extremadamente difícil de generar sin vida.

Otro rastro lo darían los isótopos: variaciones en elementos como el carbono o el azufre que, dentro de su contexto geológico, se ajusten a lo que esperaríamos de procesos biológicos. Sin ese contexto, el isótopo puede engañar.

También podrían encontrarse texturas microscópicas que recuerden a células o biofilms, siempre asociadas a moléculas orgánicas e isótopos de “firma biológica”.

Una sola pista nunca basta: se necesitan varias, y que se repitan de manera independiente, con instrumentos distintos.

Lo ideal sería confirmar en la Tierra, con muestras traídas de Marte bajo protocolos estrictos para evitar contaminación. Al final, no se trata de obtener una foto espectacular, sino un expediente coherente y abrumador.

De Europa a Venus¿Y en qué otros mundos podría asomarse la vida? Estos son los candidatos:

- Europa (Júpiter). Es el favorito: oculta un océano salado bajo el hielo. la misión Europa Clipper, que llegará hacia 2030, hará casi 50 sobrevuelos para estudiar si allí existen condiciones habitables. No busca vida directamente, pero sí comprobar si podría haberla.

- Encélado (luna de Saturno). Sus espectaculares géiseres conectan el océano interno con el espacio. Allí se ha detectado fósforo en abundancia, un nutriente esencial para la vida. Es, literalmente, un laboratorio natural abierto.

- Titán (luna de Saturno). Con su atmósfera densa y rica en compuestos orgánicos, es un lugar único para explorar química prebiótica. La misión Dragonfly despegará a finales de esta década (si no entra en el grupo de recortes de Donald Trump) y aterrizará hacia mediados de los 30, para estudiar si podrían darse formas de bioquímica distintas a las terrestres.

- Venus. En sus nubes se han detectado posibles rastros de fosfina, aunque el debate sigue abierto. Para unos es una señal sugerente; para otros, un artefacto de las observaciones. El debate es un buen antídoto contra el autoengaño.

En ciencia y tecnología, aceleraríamos las misiones de retorno de muestras y desarrollaríamos sistemas de contención de máximo nivel, además de nuevas herramientas para detectar formas de vida “no terráqueas”; en filosofía, nos obligaría a dejar de confundir singularidad con privilegio; en religión, probablemente inspiraría lecturas más inclusivas de la creación, más que crisis de fe; en política y ética, reforzaría la necesidad de no contaminar otros mundos ni traer riesgos a la Tierra.

Y en lo cotidiano, se abriría la puerta a nuevos materiales, sensores y biotecnologías

Pero más allá de lo práctico, nos brindaría una cura contra el provincianismo: nos recordaría que no somos el centro del universo.

¿Cuándo podríamos afirmarlo rotundamente?Hay dos ventanas realistas. En primer lugar, hacia la década de 2030. El rover europeo Rosalind Franklin, cuyo lanzamiento está previsto para 2028, llegará a Marte en unos cinco años. Está diseñado para perforar hasta dos metros bajo la superficie, donde la radiación no ha destruido los compuestos más delicados. Con su instrumento MOMA podría encontrar moléculas orgánicas complejas, señales de quiralidad (esa preferencia por una “mano” molecular que suele asociarse a la vida) y posibles texturas biológicas. No será fácil, pero las posibilidades están ahí.

La segunda ventana sería el retorno de muestras. La misión conjunta de NASA y ESA, que busca traer rocas marcianas a la Tierra, se ha encarecido y retrasado, por lo que lo más probable es que su “veredicto de laboratorio” no llegue antes de la década de 2040.

Eso sí, incluso si la roca Cheyava Falls ofrece biofirmas tentadoras, la confirmación no llegará con un único indicio. Habrá que recorrer toda la “escalera CoLD”: descartar explicaciones no biológicas y repetir pruebas de forma independiente, idealmente en laboratorios terrestres. El calendario es incierto. Mientras tanto, el escepticismo no supone un freno: es la dirección en la que vamos.

Si la vida marciana existe o existió, nos esperará, no tiene nuestras prisas. Y si no existió nunca, el hallazgo más grande será comprender por qué aquí sí. Esa respuesta también nos pertenece y entusiasma.![]()

Sobre el autor: José Ygnacio Pastor Caño, Catedrático de Universidad en Ciencia e Ingeniería de los Materiales, Universidad Politécnica de Madrid (UPM)

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo ¿Cuándo podremos decir que “hemos encontrado vida en Marte”? se ha escrito en Cuaderno de Cultura Científica.

La química del olfato vibra

Respiramos más de 20.000 veces al día. Es un mecanismo inconsciente y automático, imprescindible para sobrevivir. Al inhalar, obtenemos el oxígeno que nuestro cuerpo necesita para funcionar, lo transformamos en CO2 y lo exhalamos. Sin embargo, junto al oxígeno, entran en nuestro organismo otras muchas moléculas como nitrógeno, bacterias o virus. Toda esta mezcla nos aporta una ingente cantidad de información sobre nuestro entorno, tanta que contamos con un sentido especializado para poder descifrarla: el olfato.

Gracias a él, somos capaces de identificar con los ojos cerrados a quien tenemos al lado, sortear un peligro inminente, o viajar de golpe a un verano de la infancia. Pero, ¿cómo funciona este gran detective alojado en nuestra nariz?

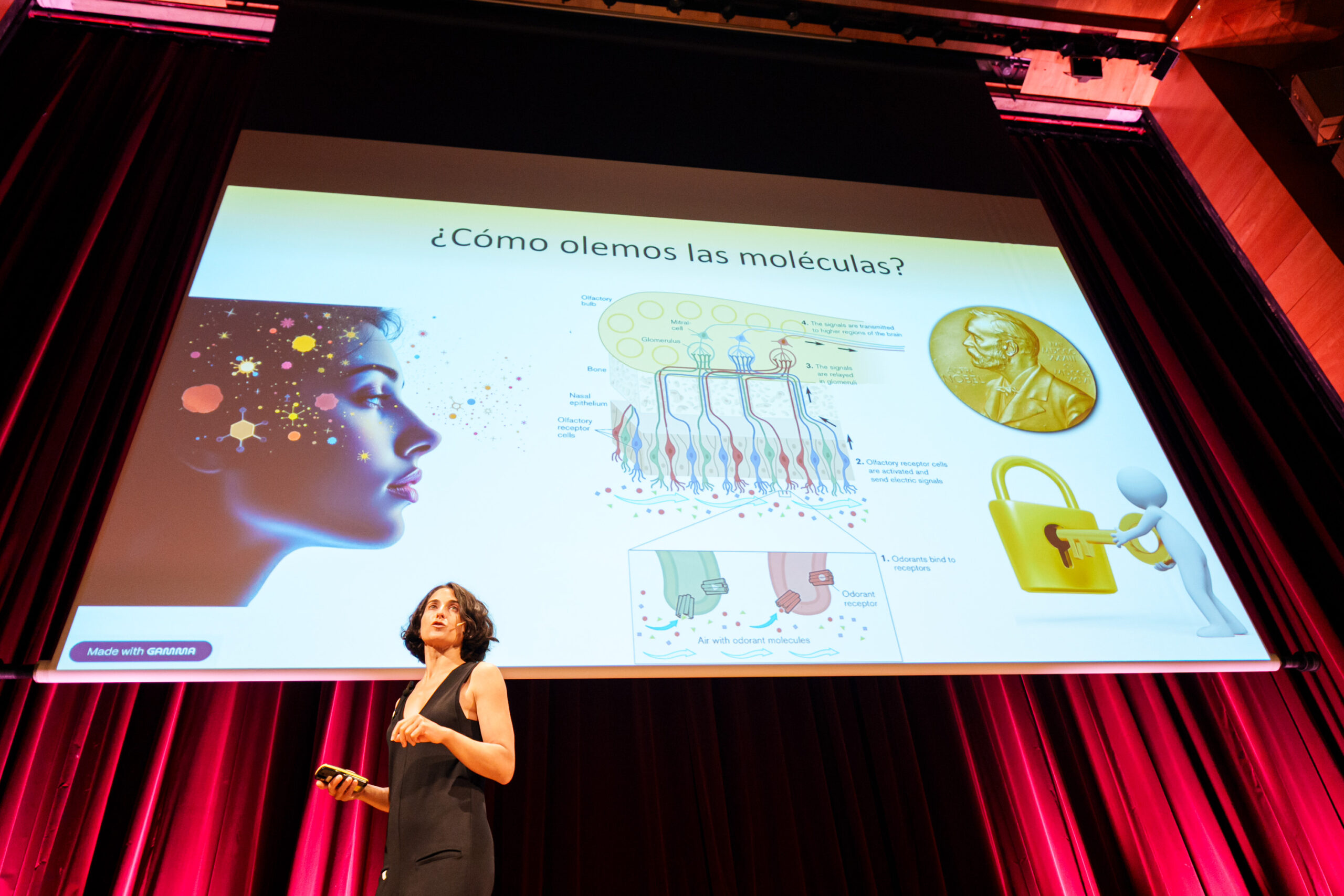

La química Elixabete Rezabal, experta en química física y profesora titular en la facultad de Química de la EHU, lo explicó durante el decimoquinto aniversario de Naukas Bilbao, en una charla dedicada a la química que se esconde tras este misterio.

© Iñigo Sierra | Cátedra de Cultura Científica de la EHU.La teoría clásica del olfato

© Iñigo Sierra | Cátedra de Cultura Científica de la EHU.La teoría clásica del olfato

La teoría clásica sostiene que al fondo de la nariz y cerca del cerebro tenemos una serie de proteínas receptoras que captan las moléculas procedentes del exterior. Si una de ellas encaja de la forma adecuada, se activa una señal que nuestro cerebro reconoce como un olor.

“Nos han contado que oler es como meter la llave correcta en la cerradura nasal: si la llave encaja, la cerradura se abre y la señal pasa al cerebro, y nosotros detectamos ese olor”, explicó Rezabal. Por esta teoría, que describe el funcionamiento del olfato, los investigadores Linda Buck y Richard Axel recibieron el Premio Nobel de Medicina en 2004.

Sin embargo, como subrayó la química, esta explicación no siempre funciona. ¿Qué ocurre, por ejemplo, con las moléculas que tienen casi la misma forma, pero huelen de manera radicalmente diferente? Pongamos el caso de una molécula formada por un grupo alcohol, compuesto por un oxígeno unido a un hidrógeno. Puede oler a hierba recién cortada. No obstante, si sustituimos ese oxígeno por un azufre, la geometría se mantiene, pero el olor se convierte en el de un huevo podrido. La forma, por tanto, no basta para explicar cómo procesamos los olores.

© Iñigo Sierra | Cátedra de Cultura Científica de la EHU.

© Iñigo Sierra | Cátedra de Cultura Científica de la EHU.Para ofrecer una respuesta, Rezabal expuso la atrevida teoría del biofísico Luca Turin y su equipo de colaboradores del MIT, quienes en 1996 propusieron una teoría alternativa en la que planteaba que nuestra nariz no detecta la forma de las moléculas, sino sus vibraciones a nivel cuántico.

¿Y si lo que olemos son vibraciones?

Su hipótesis partía de la idea de que las moléculas no solo tienen una geometría, sino que no paran de moverse. A temperatura ambiente, vibran de manera constante, pero no de cualquier manera. Esto, en palabras de Rezabal, se debe a que “la energía vibracional está cuantizada, lo que quiere decir que sólo ciertos modos de vibración están permitidos, cada uno con su energía”.

El agua es un buen ejemplo. Se trata de una molécula simple que, debido a su geometría, tiene tres modos de vibración, “tres pasos de baile”, cada uno con una energía asociada. Si recibe la cantidad exacta de energía del entorno, puede vibrar de otra manera y subir al siguiente escalón. Y así hasta alcanzar el tercer nivel.

© Iñigo Sierra | Cátedra de Cultura Científica de la EHU.

© Iñigo Sierra | Cátedra de Cultura Científica de la EHU.Por su parte, el agua deuterada -conocida como agua pesada- es idéntica en su forma al agua, con la salvedad de que los átomos de hidrógeno son sustituidos por deuterio, que incorpora un neutrón, además de un protón, en su núcleo. Esto hace que los átomos sean más pesados y que las energías necesarias para pasar de un modo de vibración a otro sean diferentes. En definitiva, la forma es la misma, en cambio, sus vibraciones no lo son.

En la mente de Turin, si el olfato se basa en las vibraciones, se debería poder distinguir el agua del agua pesada. Para comprobar su teoría, él y su equipo realizaron experimentos con un animal de olfato extremadamente fino, la mosca de la fruta.

Acertó. Estos insectos se acercaban al agua y se alejaban del agua pesada. Entonces, ¿qué hace nuestra nariz para detectar este fenómeno cuántico?

A partir de este curioso experimento, se desarrolló el concepto del túnel cuántico de la nariz. Un mecanismo que aprovecha las propiedades cuánticas de los electrones para identificar moléculas basándose en sus vibraciones, de manera similar a ciertos espectrómetros de laboratorio, como la espectroscopía de túnel inelástico de electrones, Inelastic Electron Tunneling Spectroscopy (IETS), en inglés.

La nariz, un espectrómetro biológico

“Esta teoría actual lo que propone es que cuando la molécula se une, hay un electrón que tiene que pasar de una parte de la proteína a otra, lo que genera una transferencia de energía que manda una señal al cerebro”, resumió.

© Iñigo Sierra | Cátedra de Cultura Científica de la EHU.

© Iñigo Sierra | Cátedra de Cultura Científica de la EHU.Hay que tener en cuenta que la molécula siempre estará vibrando o “bailando” en su nivel más bajo de energía, pero si la energía que necesita para saltar al siguiente modo de vibración coincide exactamente con la que tiene que liberar el electrón para poder moverse, la transferencia se produce y se activa el olor en nuestro cerebro. En cambio, si la energía que necesita la molécula odorífera para subir de escalón no es la misma que requiere el electrón, no habrá transferencia y, por tanto, el olor no se activará.

Más allá de la curiosidad científica, Turin aplicó este concepto de la teoría de la vibración olfativa para fundar Flexitral, una empresa -ya extinta- al servicio de la industria de la perfumería. ¿Cómo? Calculando los modos vibracionales de las moléculas, el biofísico libanés era capaz de sustituir compuestos carísimos, apreciados por los perfumistas por su particular aroma, por otros más baratos que vibraban del mismo modo y, por tanto, olían igual.

Rezabal cerró su intervención en Naukas Bilbao 2025 recordando que la mecánica cuántica, aunque pueda parecernos lejana, está más presente en nuestra vida cotidiana de lo que podamos imaginar, ya que “muchos fenómenos de nuestro cuerpo se basan en principios cuánticos”. Y, en el caso del olfato, todo apunta a que el secreto está en la vibración.

Si no ve correctamente el vídeo, use este enlace.

Sobre la autora: María Larumbe es periodista y responsable de comunicación de la Cátedra de Cultura Científica de la Universidad del País Vasco / Euskal Herriko Unibersitatea.

El artículo La química del olfato vibra se ha escrito en Cuaderno de Cultura Científica.

Las veladuras blancas de los óleos contemporáneos

En las pinturas al óleo pueden producirse alteraciones por las interacciones entre sus componentes químicos y por factores externos: por ejemplo, pueden aparecer sustancias blanquecinas en todo el cuadro o en algunas partes concretas. Sin embargo, estas veladuras blancas no siempre tienen el mismo aspecto y pueden tener diferentes orígenes. “Estas sustancias que blanquean la superficie de las obras de arte no solo afectan a la estética, sino que también son un problema de conservación, y es muy importante saber qué las produce para poder resolver el problema”, explica Erika Tarilonte, investigadora de la Facultad de Bellas Artes de la Universidad del País Vasco / Euskal Herriko Unibertsitatea (EHU).

Veladuras blancas Sin título (1971) de Santos Iñurreta. Óleo sobre lienzo (114×146 cm). Fuente: Erika Tarilonteet al. (2025) Journal of Cultural Heritage doi: 10.1016/j.culher.2025.06.007

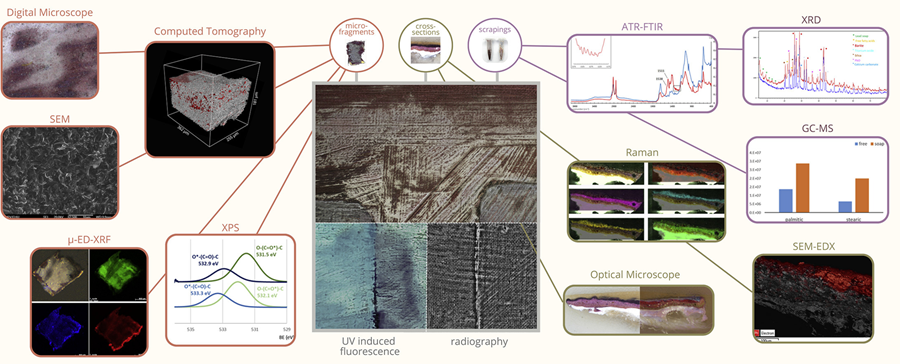

Sin título (1971) de Santos Iñurreta. Óleo sobre lienzo (114×146 cm). Fuente: Erika Tarilonteet al. (2025) Journal of Cultural Heritage doi: 10.1016/j.culher.2025.06.007La obra Sin título del pintor vasco Santos Iñurrieta (1950-2023) es un óleo sobre lienzo no barnizado que está cubierta en gran parte por una sustancia blanquecina homogénea y frágil. A partir de este cuadro, los investigadores del grupo FARMARTEM de la EHU han llevado a cabo el estudio analítico más completo hasta la fecha para identificar los fenómenos de blanqueo de la superficie de los óleos contemporáneos. “Hemos definido una metodología multianalítica exhaustiva que nos permitirá analizar algunos fenómenos de degradación y conservar las pinturas”, explica Tarilonte. Este estudio supone un gran paso para hacer frente a uno de los problemas más importantes de la conservación del arte contemporáneo en la actualidad.

Jabones plúmbicos Erika Tarilonte tomando una micromuestra. Fuente: EHU

Erika Tarilonte tomando una micromuestra. Fuente: EHUEn primer lugar, el estudio histórico-artístico de las obras de Iñurrieta ha demostrado que estas veladuras blancas no son intencionadas por parte del artista y, a partir de ahí, los investigadores han analizado diferentes hipótesis: «Pueden ser hongos, o el efecto de la cristalización de sales, la migración de ácidos grasos, la exudación de ceras, los jabones metálicos… Los análisis efectuados por nosotros han demostrado que los jabones plúmbicos son la principal causa de las veladuras blancas en las pinturas, y que probablemente fuera un secante de plomo el origen del plomo”, afirma la investigadora. El proceso de formación de jabones plúmbicos se produce dentro de la capa de pintura, “pero poco a poco, con el tiempo, va aflorando y aparece la veladura blanca. Da la impresión de que la obra está cubierta de niebla”.

Conocer para intervenirLa investigación ha permitido obtener una amplia información sobre los materiales y las técnicas que el artista empleó en la pintura. “Ahora sabemos qué capas pictóricas tiene la obra, cómo son, qué espesor tienen, qué granulometría, qué pigmentos ha utilizado exactamente, qué aditivos, qué aglutinantes, etc. Tras esta investigación, lo sabemos todo sobre la obra de arte, y hoy en día eso es muy importante para poder intervenir”. Según la investigadora de la EHU, ese ha sido el primer paso: “La obra de arte está así ahora, pero sabemos que el original no era así. El siguiente paso natural sería intervenir en la obra, limpiarla y dejarla como era en su origen”.

El estudio multianalíticoEl estudio multianalítico para detectar el origen de las veladuras blancas en las pinturas al óleo ha uncluido análisis microbiológicos diversos, radiografías, estudios de fluorescencia, análisis químicos de micromuestras, microscópicos, espectroscópicos, tomografías computarizadas, cromatografías, etc. Como resultado la investigación ha puesto a disposición de la comunidad científica y artística información detallada sobre la utilidad de cada una de estas técnicas y la información específica que aporta cada una de ellas.

Fuente: Erika Tarilonteet al. (2025) Journal of Cultural Heritage doi: 10.1016/j.culher.2025.06.007

Fuente: Erika Tarilonteet al. (2025) Journal of Cultural Heritage doi: 10.1016/j.culher.2025.06.007De hecho, “la flexibilidad de esta metodología multianalítica nos ha permitido comprobar que algunas técnicas que no aportan resultados significativos para los jabones metálicos pueden aportar, sin embargo, información útil para otros fenómenos de veladura”, afirma Tarilonte. Por ejemplo, ahora están trabajando con otra obra: Sin título, de Alberto González (1978). “Esta obra también tiene veladuras blancas, pero su morfología es diferente: presenta puntos blancos en un color azul determinado”, explica la investigadora. Una de las principales hipótesis de los investigadores es que “la cristalización de sales ha sido el origen de estas acreciones. Gracias a la metodología que hemos desarrollado, vamos a poder usar únicamente las técnicas analíticas más interesantes para analizar la cristalización de las sales, en lugar de utilizar todas. Ahora sabemos qué tipo de información que nos da cada técnica y, por lo tanto, a la hora de analizar otras obras de arte, solo elegiremos aquellas que sean más útiles en cada caso. Hemos conseguido dar la opción de adaptarnos a cada caso”.

A pesar de los grandes avances en este campo, “todavía hay que investigar mucho sobre las causas y mecanismos que provocan las veladuras. Este trabajo servirá para desarrollar mejores estrategias de conservación de las pinturas al óleo y para investigar remedios eficaces para el cuidado de las obras de arte a largo plazo”, explica la investigadora de la EHU.

Referencia:

Erika Tarilonte, Oskar González-Mendia, Ilaria Costantini, Kepa Castro, Itxaso Maguregui (2025) A multi-analytical approach for the identification of surface whitening phenomena in contemporary oil painting and its application to metal soaps Journal of Cultural Heritage doi: 10.1016/j.culher.2025.06.007

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Las veladuras blancas de los óleos contemporáneos se ha escrito en Cuaderno de Cultura Científica.

Whole Earth Catalog: la versión analógica de internet

«¿Dónde buscabais la información antes de que existiera internet?» es una pregunta que a algunos nos ha hecho sentir viejos alguna vez. No tiene importancia, la normalización del uso de los grandes modelos del lenguaje ya hará que se sientan viejos los mismos que la formulan. Pero, efectivamente, hace no tanto vivíamos sin internet… y sobrevivimos. Hasta finales de los noventa, tratar de aprender algo nuevo implicaba, bien buscar a alguien que pudiera enseñarte, o bien una visita a una biblioteca, a una librería… y muchísimo tiempo. Es posible que la idea de contar con una especie de repositorio del conocimiento que nos permitiera un acceso rápido a la información se remonte a la biblioteca de Alejandría. Y es que, salvando las distancias, y dentro de sus limitaciones, ¿no era exactamente eso?

Pero lo cierto es que las bibliotecas no ofrecen el acceso rápido, directo y práctico al conocimiento que ofrece, por ejemplo, un tutorial de YouTube. El Whole Earth Catalog, editado por Steward Brand en la California de los años sesenta y setenta, sí lo hizo, y probablemente, por primera vez en la historia.

En plena efervescencia cultural y social, con los movimientos en defensa de los derechos civiles, la contracultura hippie, la expansión de la música y el arte experimentales, y un creciente interés por estilos de vida más libres, sostenibles y autónomos, surgió la necesidad de medios que ofrecieran un acceso rápido al conocimiento práctico y a herramientas que facilitaran la autosuficiencia —pensemos en las comunas hippies autogestionadas—. Como ciudadanos de un mundo muy diferente al de sus padres, la mayoría de aquellos jóvenes no sabía cómo construir una casa, cultivar sus propios alimentos o reparar los aparatos que utilizaba a diario… y tampoco había internet para buscar cómo se hacía. Steward Brand, que se movía en el corazón de ese ambiente, les dio los recursos que buscaban.

Steward Brand en 2020. Créditos: CC BY 2.0/Christopher Michel

Steward Brand en 2020. Créditos: CC BY 2.0/Christopher Michel

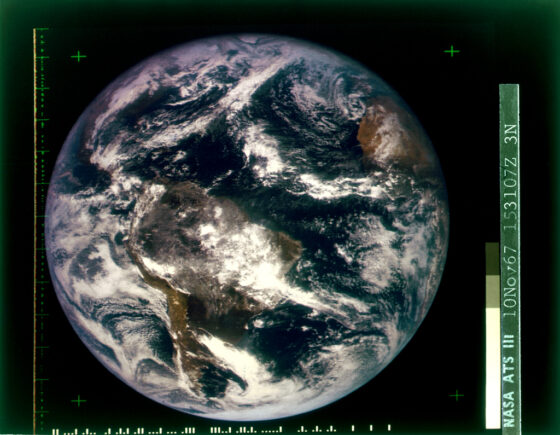

En 1966, y en plena alucinación psicodélica producida por el LSD, Brand tuvo una especie de revelación: si la humanidad pudiera ver una imagen de la Tierra completa desde el espacio, cambiaría su percepción del planeta y eso despertaría una conciencia global que lo transformaría todo —existían entonces imágenes de nuestro planeta tomadas desde la órbita, pero fragmentadas y de poca calidad—. Así que inició una campaña por campus universitarios de todo el país con el eslogan: «Why haven’t we seen a photograph of the whole Earth yet?» (‘¿Por qué no hemos visto todavía una fotografía de la Tierra entera?’) para que la NASA publicara una foto completa de nuestro planeta flotando en el vacío. Se disfrazó, vendió chapas y panfletos… y parece que dio resultado, porque al año siguiente, la NASA publicó la imagen que pedía y que tomó el satélite ATS-3 el 10 de noviembre del año siguiente.

Primera fotografía en color de la Tierra al completo, tomada por el satélite ATS-3 el 10 de noviembre de 1967. Fuente: NASA

Primera fotografía en color de la Tierra al completo, tomada por el satélite ATS-3 el 10 de noviembre de 1967. Fuente: NASA

Esta anécdota es importante porque esta fotografía sería la que aparecería en la portada del primer número del Whole Earth Catalog, que se publicó en el otoño de 1968.

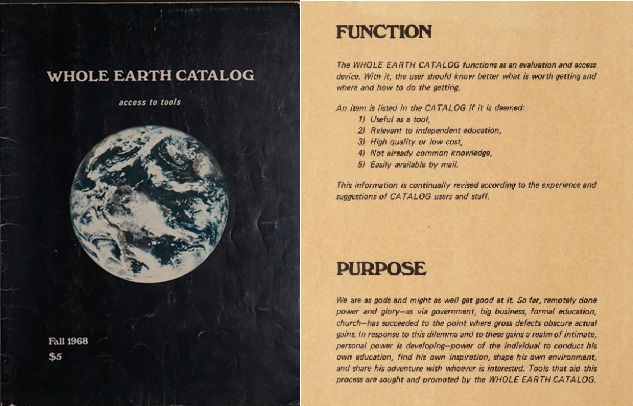

Primer número del Whole Earth Catalog y primera página, con una especie de manifiesto sobre el propósito de la publicación. Fuente: Whole Earth Index / fair use

Primer número del Whole Earth Catalog y primera página, con una especie de manifiesto sobre el propósito de la publicación. Fuente: Whole Earth Index / fair useSería bastante complicado definir qué era el Whole Earth Catalog, porque no entraría en la categoría de panfleto ni de revista ni de libro, me atrevería a decir que podría parecerse más a una guía telefónica de recursos de lo más… heterodoxo. Así, podíamos encontrar manuales de construcción, guías de jardinería y agricultura, planos y materiales para aprovechar fuentes de energía alternativas, recetas de cocina y remedios naturales, lecciones de programación, referencias a libros de todo tipo —ciencia, filosofía, artes, sociología…—, contactos y direcciones de expertos… Merece bastante la pena echarle un vistazo. Todo el material se encuentra digitalizado en Whole Earth Index.

El Whole Earth Catalog, aunque nunca se distribuyó de forma masiva, sí se convirtió en el símbolo de un colectivo de jóvenes que buscaba plantear alternativas al mundo que les había tocado vivir. Un mundo en el que el desarrollo tecnológico ya había mostrado su peor cara, pero también era una oportunidad para tratar de hacer las cosas de una manera más auténtica y sostenible. Su periodo de mayor auge fue la década de los setenta, aunque el último número, una edición por el trigésimo aniversario, se publicó en 1998… cuando internet ya estaba llegando a nuestras vidas. Y del mundo de internet y de aquella California en la que se gestó Silicon Valley llega el crossover de hoy.

Uno de los estudiantes que formó parte de aquella experiencia, dijo, ya de adulto, que el Whole Earth Catalog había sido «algo así como Google en formato libro, treinta y cinco años antes de que Google existiera». Lo hizo durante el discurso de graduación de la Universidad de Stanford el 12 de junio de 2005, junto con otra frase que pasaría a la historia, y que aparecía en la contraportada del número de octubre de 1974 del Whole Earth Catalog:

Whole Earth Index / fair use

Whole Earth Index / fair use

Bibliografía

Kabil, A. (29 de mayo de 2018). Seeing the whole earth from space changed everything. Long now.

Markoff, J. (2022). Whole Earth. The many lives of Steward Brand. Penguin Press.

Sobre la autora: Gisela Baños es divulgadora de ciencia, tecnología y ciencia ficción.

El artículo Whole Earth Catalog: la versión analógica de internet se ha escrito en Cuaderno de Cultura Científica.

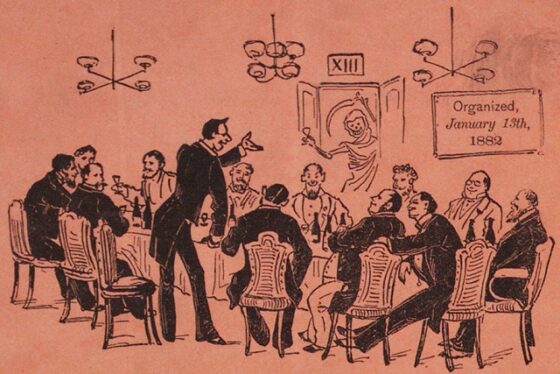

¿Es el número 13 un número nefasto?

En la anterior entrada del Cuaderno de Cultura Científica titulada Propiedades matemáticas del número 13 iniciamos una pequeña serie, de dos entradas, sobre un número que causa miedo o rechazo entre muchas personas, aunque para muchas otras es un número de la suerte, el número 13.

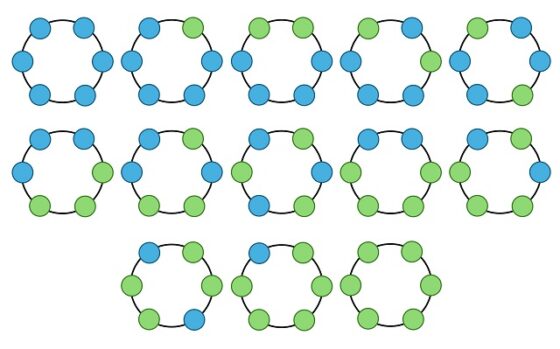

Esa primera entrada la dedicamos a las propiedades matemáticas del número trece, que como se comentaba, es un número primo, miembro de la famosa sucesión de Fibonacci, solución al problema de los collares de dos colores, un número poligonal centrado, perteneciente a dos ternas pitagóricas e incluso a las familias de los números felices y los de la suerte, entre otras propiedades.

La solución al problema de los collares (o pulseras) para 6 cuentas (de dos colores distintos) es 13

La solución al problema de los collares (o pulseras) para 6 cuentas (de dos colores distintos) es 13

Esta segunda entrada la vamos a centrar en las supersticiones, creencias y miedos alrededor del número 13, un número que increíblemente ha sido eliminado de la numeración de los pisos de los hoteles, de las filas de los aviones o de las calles de algunas poblaciones, pero que también se ha considerado por muchas personas como un número de buena suerte.

Triscaidecafobia

Aunque este término no esté recogido en el Diccionario de la Real Academia Española, la triscaidecafobia es el miedo irracional al número 13. De hecho, esta palabra se deriva de las palabras griegas treiskaideka, “trece”, o más concretamente “tres y diez”, y fobia, “miedo” o “temor”. También se suelen utilizar los términos tredecafobia o tridecafobia, aunque son menos habituales que el anterior.

La superstición alrededor del número 13 es lo que ha provocado que muchos hoteles y edificios a lo largo del mundo, con más de trece plantas, hayan decidido eliminar la planta 13 de los mismos, como los hoteles Waldorf Astoria o The Plaza en Nueva York (EE.UU.), o el rascacielos londinense One Canada Square.

La triscadecafobia estaba muy extendida en Estados Unidos a finales del siglo XIX y principios del XX, época en la que se empezaron a construir los rascacielos. Tanto las constructoras, como los hoteles, se dieron cuenta que era más difícil vender o alquilar un piso situado en la planta número 13, o que los clientes de un hotel quisieran reservar una habitación en esa planta. Como el dinero manda, rápidamente se empezó a no incluir la denominación de planta 13 en muchos rascacielos, que pasaban directamente de la planta 12 a la planta 14.

Cuadro de botones de un ascensor de un edificio en el que no hay planta 13, luego tampoco botón en el ascensor para la misma

Cuadro de botones de un ascensor de un edificio en el que no hay planta 13, luego tampoco botón en el ascensor para la misma

Por supuesto, la planta número 13 en estos rascacielos sí existe, solo se ha suprimido el nombre “planta 13”, se ha sustituido por el nombre “planta 14” y se han trasladado los nombres de las demás plantas, pero eso parece que calma a los que sufren de triscaidecafobia.

Pero la triscaidecafobia no se manifiesta solo en los hoteles. Muchas ciudades del mundo han eliminado el número 13 de algunas sus calles. Por ejemplo, varias de las calles de Londres no tienen portal número 13, entre ellas Fleet Street, Oxford Street, Park Lane, Praed Street, St James’s Street, Haymarket y Grosvenor Street, según se menciona en el libro London The Biography (2000), del escritor y crítico británico Peter Ackroyd. Además, según el sitio web inmobiliario británico Zoopla, las casas cuyo número es el 13 son más baratas que sus vecinas con números 11, 12, 14 o 15 (de media una cantidad de 4.500 euros, según un estudio publicado en 2011, que serían unos 6.500 euros en la actualidad). Dicho estudio dice más aún, comenta que el 28% de las calles de Gran Bretaña no tienen el temido número 13. Siguiendo con Londres, podemos comentar que la famosa atracción turística London Eye, la noria más alta de Europa, posee 32 cápsulas, numeradas entre 1 y 33, ya que, una vez más, se ha eliminado el número 13.

La atracción turística London Eye, al lado del río Támesis, en Londres. Fotografía de Khamtran

La atracción turística London Eye, al lado del río Támesis, en Londres. Fotografía de KhamtranMedios de transporte

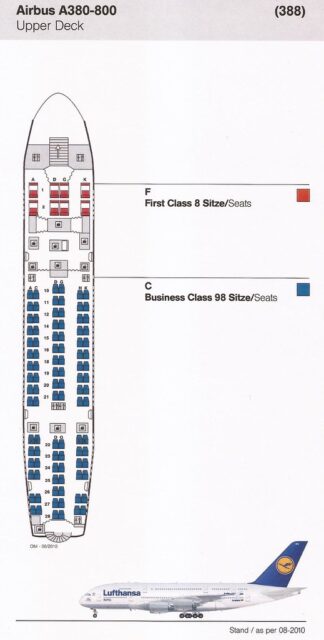

Pero los rascacielos o las calles de las ciudades no son los únicos ejemplos en los cuales se ha eliminado el odiado número 13. Muchas compañías aéreas han suprimido la fila 13 de sus aviones para evitar el malestar de sus clientes supersticiosos, como la aerolínea francesa Air France, la aerolínea estadounidense United Airlines, la británica British Airways o la española Iberia, entre muchas otras, como la aerolínea alemana Lufthansa que no solo ha eliminado esta fila, sino también la fila 17, ya que el número 17 también es considerado nefasto en Italia.

Dibujo del interior de un avión AIRBUS de la compañía Luftansa, en el que puede apreciarse que no hay fila 13, se pasa de la fila 12 a la fila 14

Dibujo del interior de un avión AIRBUS de la compañía Luftansa, en el que puede apreciarse que no hay fila 13, se pasa de la fila 12 a la fila 14

Pero podemos hablar de otros medios de transporte. Por ejemplo, la empresa de transporte público de Madrid, la EMT (Empresa Municipal de Transportes de Madrid), que tiene más de doscientas líneas de autobuses, no tiene precisamente la línea 13 entre ellas. Entre las líneas 1 (Cristo Rey – Prosperidad) y 100 (Moratalaz – Valderrivas), están todos los números incluidos, salvo el número 13. Se pasa de la línea 12 a la línea 14. Aunque, el 23 de junio de 2011, de forma puntual y con motivo de la celebración de un festival internacional de magia, circuló un autobús con el número 13 (conocido como la “línea mágica”) con un recorrido circular alrededor del Retiro llevando a magos que iban realizando trucos de magia a lo largo de su recorrido.

En Madrid no hay línea 13 de autobuses, aunque durante un día, el 23 de junio de 2011, circuló un bus mágico, con magos realizando trucos de magia, que llevó el número 13

En Madrid no hay línea 13 de autobuses, aunque durante un día, el 23 de junio de 2011, circuló un bus mágico, con magos realizando trucos de magia, que llevó el número 13

Siguiendo con Madrid, en la actualidad existen doce líneas de metro, entre la línea 1, azul claro (Pinar de Chamartín – Valdecarros), y la línea 12, dorado (circular). Como se explica en el artículo Así sería la línea 14 del Metro de Madrid: el trayecto fantasma que nunca fue, publicado por el periódico El Español (enero, 2024), en 2003 se planeó, con la apertura de Metrosur, la creación de la línea 14 del Metro de Madrid que conectaba la capital con Alcorcón, Móstoles, Leganés, Getafe y Fuenlabrada. De esta forma se saltaba de la línea 12 a la línea 14. Sin embargo, esta línea se quedó en proyecto y nunca se realizó. En diferentes medios se ha hablado de la construcción de nuevas líneas, en particular de la línea 13, pero ya veremos que nombre recibe cuando se haya construido.

Superstición en la Fórmula 1