Los humanos, un Macguffin matemático

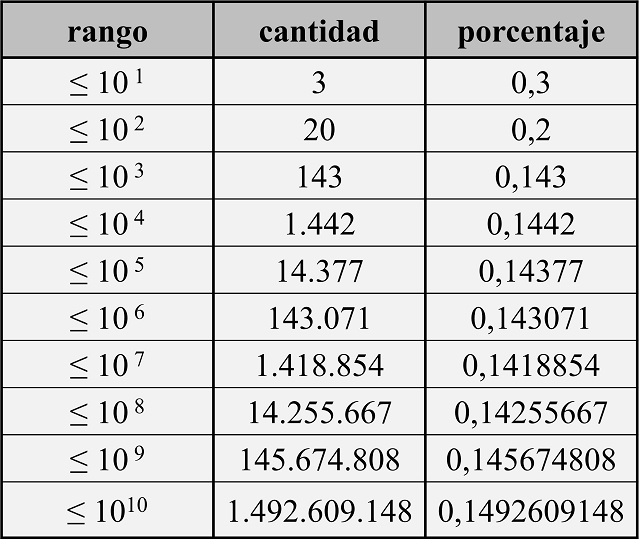

Siempre que escucho la palabra “Macguffin” mi mente se va hacia el gran cineasta británico Alfred Hitchcock (1899-1980), autor de grandes películas como La ventana indiscreta (1954), Vértigo (1958), Con la muerte en los talones (1959), Psicosis (1960) o Los pájaros (1963). Y más concretamente me remite al libro El cine según Hitchcock, que recoge la entrevista que le hizo el cineasta francés Francois Truffaut (1932-1984), un libro de cuya lectura he disfrutado en varias ocasiones.

Fotografía de la entrevista que hizo el cineasta francés Francois Truffaut al cineasta británico Alfred Hitchcock en 1962

Fotografía de la entrevista que hizo el cineasta francés Francois Truffaut al cineasta británico Alfred Hitchcock en 1962¿Qué es el Macguffin?

El Macguffin, término acuñado por el maestro del suspense Alfred Hitchcock, es un objeto, persona, situación o suceso necesario para impulsar la trama y la motivación de los personajes, pero insignificante, sin importancia o irrelevante en sí mismo. Como diría Truffaut “es el pretexto”.

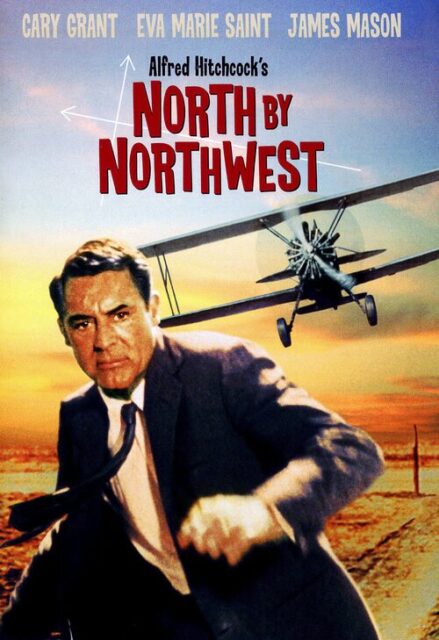

Por ejemplo, en las películas de espías suele ser un secreto o unos documentos, que hacen que la trama se desarrolle, pero que realmente da igual cuál sea el secreto o el contenido de los documentos. Como afirmó el propio Hitchcock, “el Macguffin es lo que persiguen los espías, pero al público le da igual”. En la película Con la muerte en los talones, el protagonista, encarnado por el actor estadounidense Cary Grant (1904-1986), es un agente publicitario que es confundido con un agente del gobierno por unos espías e intentan asesinarlo, motivando la huida del publicista para salvar su vida. Mientras que en la película Psicosis el Macguffin es el robo de un dinero y la posterior huida de su protagonista femenina, interpretada por la actriz estadounidense Vera Miles (1929), que provoca que se esconda en un pequeño hotel regentado por el tímido Norman Bates, que interpretaba el actor estadounidense Anthony Perkins (1932-1992), y que era realmente la parte central de la película. Otro ejemplo interesante es la estatuilla de la película El halcón maltés (1941), interpretada por Humphrey Bogart, Mary Astor y Peter Lorre, y basada en la novela negra homónima del escritor estadounidense Dashiell Hammett (1894-1961), que es el objeto de deseo de una serie de personajes de dudosa moral.

Cartel de la película Con la muerte en los talones (1959), dirigida por Alfred Hitchcock e interpretada por Cary Grant, Eva Marie Saint, James Mason y Martin Landau

Cartel de la película Con la muerte en los talones (1959), dirigida por Alfred Hitchcock e interpretada por Cary Grant, Eva Marie Saint, James Mason y Martin LandauPara finalizar con los ejemplos, un Macguffin esclarecedor, más moderno y en otro tipo de película, como es The Blues Brothers (1980), donde los personajes encarnados por los actores estadounidenses John Belushi (1949-1982) y Dan Aykroyd (1952), intentan conseguir el dinero necesario para salvar el orfanato en el cual se criaron, lo cual no es más que la excusa para realizar un viaje con el objetivo de reunir a los miembros de un grupo musical y llenar ese viaje de humor y música, buena música de blues y soul.

En el libro El cine según Hitchcock, el maestro del suspense explicaba el origen del término de la siguiente forma.

Y ahora, conviene preguntarse de dónde viene el “MacGuffin”. Evoca un nombre escocés y es posible imaginarse una conversación entre dos hombres que viajan en un tren. Uno le dice al otro: “¿Qué es ese paquete que ha colocado en la red?” Y el otro contesta: “Oh, es un Mac Guffin”. Entonces el primero vuelve a preguntar: “¿Qué es un Mac Guffin?” Y el otro: “Pues un aparato para atrapar a los leones en las montañas Adirondaks”. El primero exclama entonces: “¡Pero si no hay leones en las Adirondaks!” A lo que contesta el segundo: “En ese caso no es un Mac Guffin”.

Esta anécdota demuestra el vacío del Mac Guffin … la nada del Mac Guffin.

Los humanos, de Matt HaigLa novela a la que vamos a dedicar esta entrada del Cuaderno de Cultura Científica, Los humanos (2013), del escritor británico Matt Haig (1975), contiene un Macguffin matemático. Pero vayamos por partes. Primero presentemos brevemente a su autor.

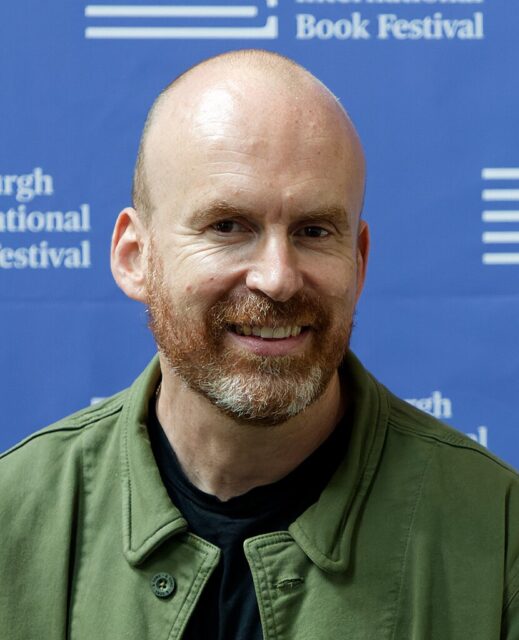

Matt Haig es un periodista y escritor inglés, que escribe tanto para adultos, como para jóvenes. Estudió Inglés e Historia en la Universidad de Hull. Entre sus libros nos encontramos novelas como Los humanos (2013), Cómo detener el tiempo (2017), La biblioteca de la medianoche (2020) o La vida imposible (2024), cuya protagonista es matemática; libros para jóvenes como Shadow Forest: el bosque de las sombras (2007), El chico que salvó la navidad (2015), La duendecilla sincera (2018) o Evie, la amiga de los animales (2019), y libros de no ficción como Razones para seguir viviendo (2015), Apuntes sobre un planeta estresado (2018) o El libro de la esperanza (2021).

Fotografía de Matt Haig en el Edinburgh International Book Festival de 2024

Fotografía de Matt Haig en el Edinburgh International Book Festival de 2024

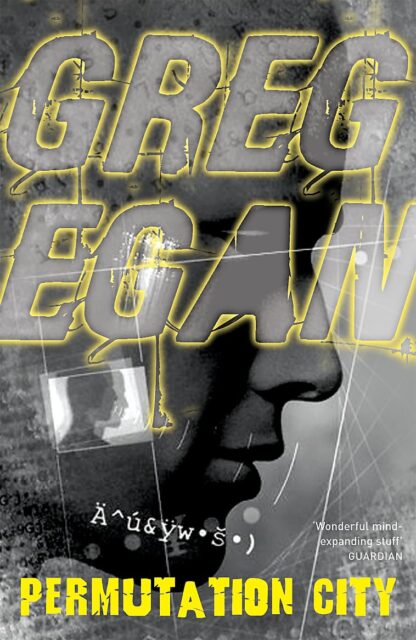

Respecto a la novela Los humanos, lo primero es recomendar a las personas que estáis leyendo esta entrada que la leáis, no porque sea una novela relacionada con las matemáticas, sino porque es una novela interesante y muy divertida.

Pero para hablar de esta novela podemos empezar por la sinopsis escrita por la editorial:

El profesor Andrew Martin de la Universidad de Cambridge acaba de descubrir el secreto de los números primos, encontrando al mismo tiempo la clave que garantizará el fin de la enfermedad y la muerte. Convencidos de que los secretos de los números primos no pueden dejarse en manos de una especie tan primitiva como los humanos, los vonadorianos, una civilización extraterrestre mucho más evolucionada, envían a un emisario para hacer desaparecer a Martin y a su descubrimiento. Y así es como un vonadoriano con el aspecto externo de Martin aparece con la misión de matar a la esposa, al hijo y al mejor amigo del profesor, pero no puede dejar de sentirse fascinado por esa fea especie y sus costumbres incomprensibles.

Portada de la novela Los humanos, de Matt Haig (Roca Editorial, 2014)

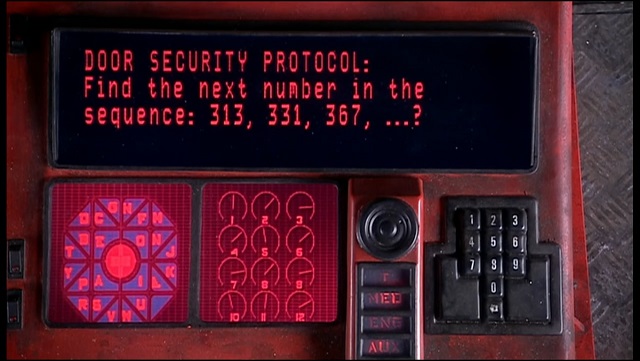

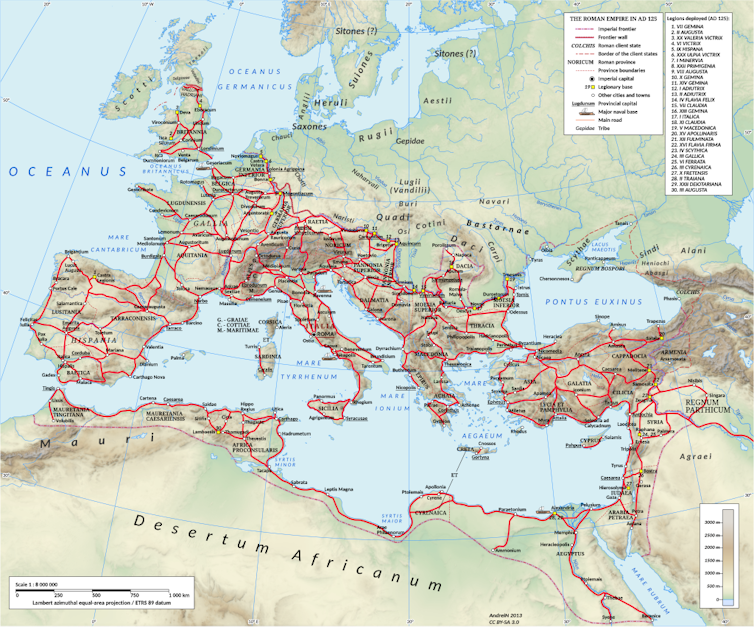

Portada de la novela Los humanos, de Matt Haig (Roca Editorial, 2014)El punto de partida de la novela es que el matemático y profesor de la Universidad de Cambridge (Gran Bretaña) Andrew Martin ha demostrado la llamada hipótesis de Riemann, uno de los problemas matemáticos abiertos, es decir, que está aún por resolverse, más importantes. De hecho, la hipótesis de Riemann es uno de los siete “problemas del milenio” que anunció el Instituto Clay de Matemáticas en el año 2000, con una recompensa de un millón de dólares para quien lo resolviese. Más aún, este problema ya estaba en la lista de los 23 problemas que recogió el matemático alemán David Hilbert (1862-1943) en el Congreso Internacional de Matemáticos de 1900, como problemas más importantes para el nuevo siglo xx.

Sin embargo, para una civilización extraterrestre, los vonadorianos, este es un conocimiento demasiado poderoso, que en manos de los humanos podría poner en peligro el equilibrio del universo y provocar su destrucción. Por este motivo, deciden reemplazar a Martin por un clon alienígena, que es realmente el protagonista de esta historia narrada por él mismo, y borrar toda evidencia de su descubrimiento, destruyendo los documentos relacionados con la demostración, los rastros digitales de la misma o las personas que hayan podido tener algún conocimiento de esta prueba, como la familia del matemático, su mujer y su hijo, y alguno de sus colegas.

Resulté ser un hombre casado de 43 años, la mitad exacta de una vida humana. Tenía un hijo. Era el profesor que acababa de resolver el enigma matemático más importante al que se habían enfrentado los humanos. Apenas tres horas antes había hecho progresar la especie humana más allá de lo que cualquiera habría podido imaginar.

La hipótesis de Riemann no es más que un pretexto, es decir, el Macguffin de esta historia, para contarnos de forma divertida cómo nos vería un extraterrestre a los terrícolas y hablar de lo que significa ser humano, del amor, la amistad, la familia, las relaciones humanas, los conflictos, la vida o la muerte.

Portada de la versión británica de la novela Los humanos / The humans (2013), de Matt HaigLas matemáticas de los vonadorianos

Portada de la versión británica de la novela Los humanos / The humans (2013), de Matt HaigLas matemáticas de los vonadorianos

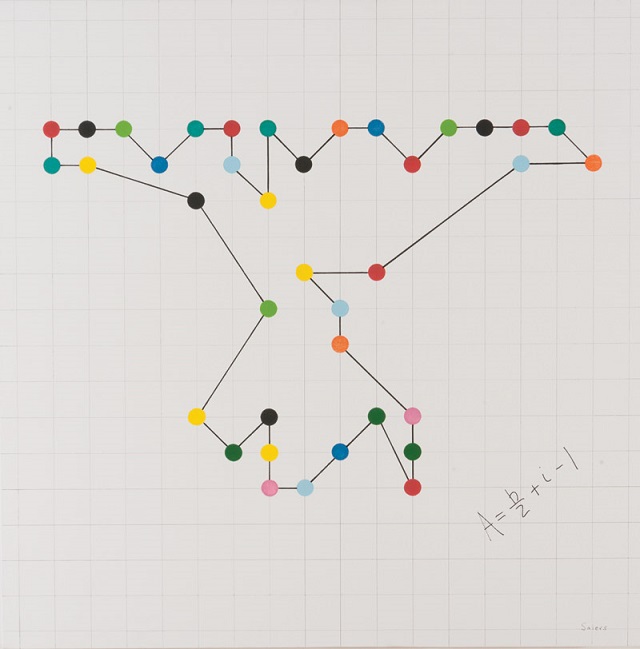

Antes de entrar en materia, un pequeño comentario sobre el hecho de que los vonadorianos son una civilización extraterrestre para la cual las matemáticas son extremadamente importantes y un conocimiento esencial para ellos. Para que nos hagamos una idea de esto, incluyo algunas sencillas citas de la novela, que son pensamientos del vonadoriano protagonista.

La primera:

Yo nunca quise que me mandasen aquí. Se trataba de una tarea que, tarde o temprano, alguien tenía que asumir y, después de la charla que di en el Museo de las Ecuaciones Cuadráticas –que muchos tacharon de blasfemia, de supuesto crimen contra la pureza matemática–, a los anfitriones [los dirigentes de los vonadorianos] les pareció el castigo perfecto.

La segunda:

Por supuesto, en teoría aquella era mi ciudad […]. La falta de imaginación geométrica me tenía fascinado: no había ni tan siquiera un decágono a la vista. […] Pronto aprendería que en las ciudades todo es una tienda. Son a los moradores de la Tierra lo que las cabinas de ecuaciones son a los vonadorianos.

La tercera:

Allá de donde venimos la tecnología que hemos creado sobre las bases de nuestro entendimiento supremo y exhaustivo de las matemáticas nos ha supuesto no solo la posibilidad de atravesar grandes distancias, sino también de reajustar nuestros propios componentes biológicos, renovarlos y reponerlos. Estamos equipados psicológicamente para tales progresos. Nunca hemos vivido una guerra civil. Nunca anteponemos los deseos individuales a las necesidades del colectivo.

En general, las citas matemáticas de la novela tienen un objetivo literario y no rigurosidad matemática. Por ejemplo, en cierto momento el vonadoriano clon de Andrew Martin se queja de que el orden de prioridad de las noticias en televisión es incomprensible para él y se sorprende de que no hable de “nuevas observaciones matemáticas” (lo cual es un comentario bastante indefinido y confuso) o de “polígonos todavía por descubrir” (también bastante impreciso e incluso que puede considerarse equívoco).

La hipótesis de RiemannA pesar de que la hipótesis de Riemann es solamente una excusa para hablar de los humanos, de la humanidad, Matt Haig sí intenta explicar en la novela, de forma muy sencilla y bastante literaria, en qué consiste la misma o, al menos, algunas ideas relacionadas con ella.

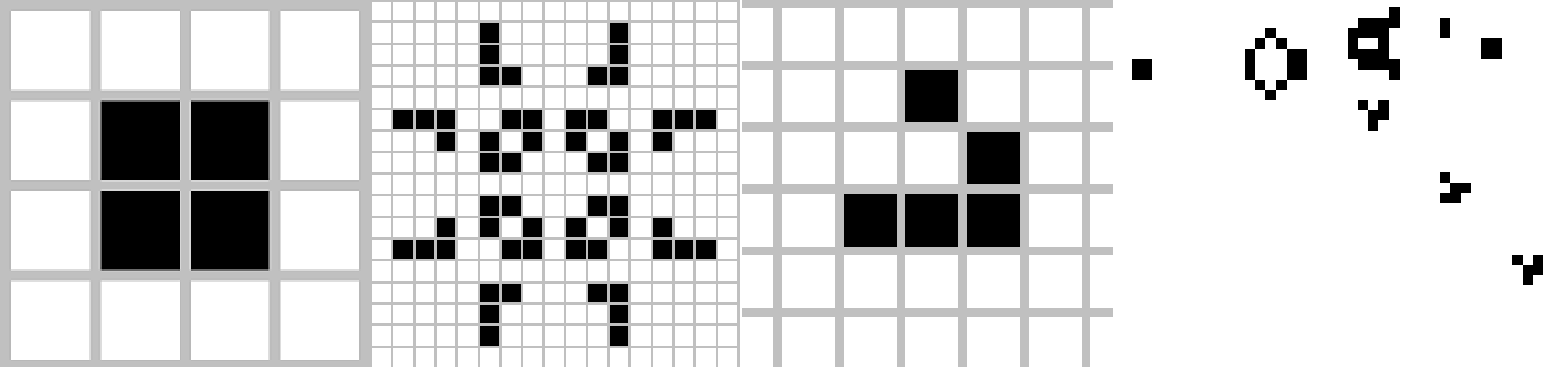

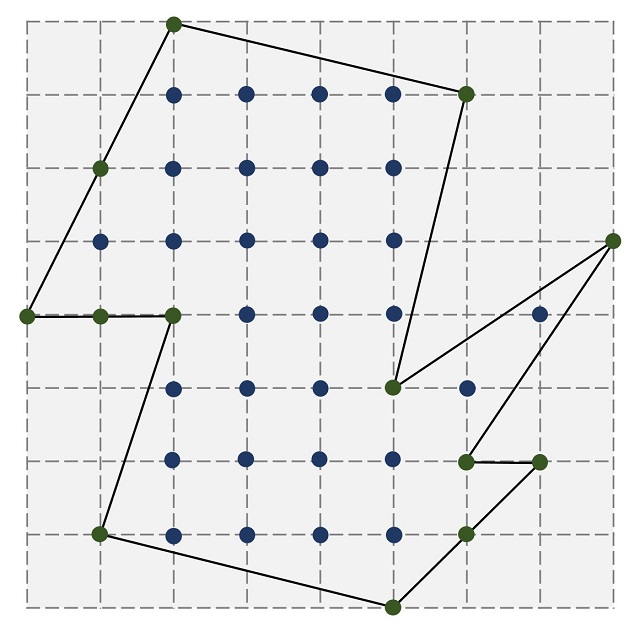

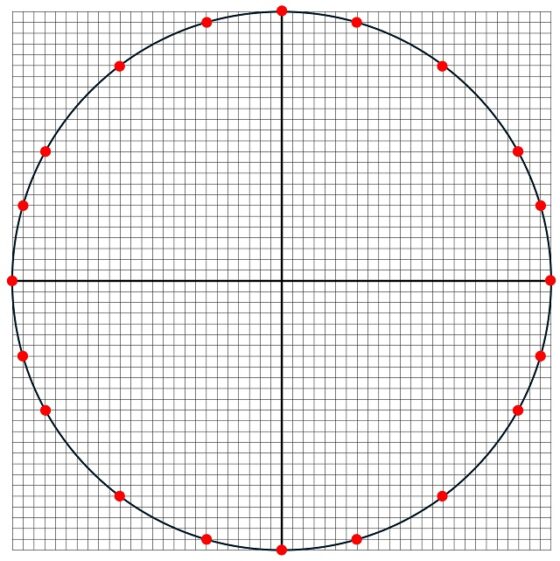

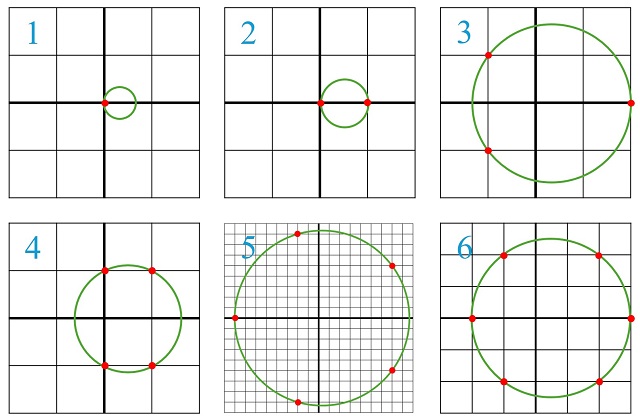

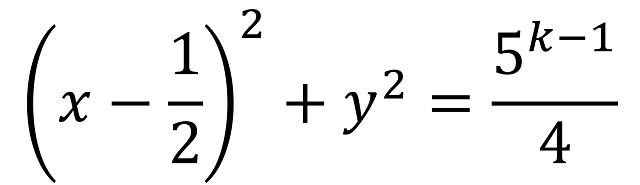

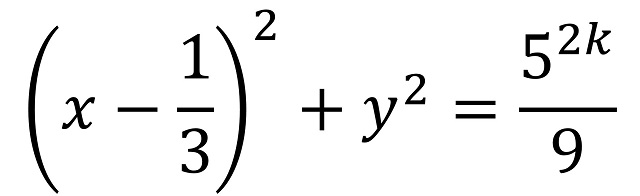

Así, cuando el vonadoriano con aspecto de Andrew Martin descubre en el ordenador del matemático de la Universidad de Cambridge el documento que contiene la demostración de la hipótesis de Riemann, hay un pequeño capítulo de la novela dedicado a los números primos y su distribución dentro de los números naturales (por cierto que una introducción a estos temas puede leerse en las entradas del Cuaderno de Cultura Científica Buscando lagunas de números no primos y El poema de los números primos, así como en el libro La gran familia de los números, que se menciona en la bibliografía), que comentaremos a continuación, aprovechando el texto de la novela.

Pero antes, así es como describe Matt Haig al autor de la hipótesis, el matemático alemán Bernhard Riemann (1826-1866).

Aprendí algo más sobre Bernhard Riemann, un niño prodigio alemán horrorosamente tímido que vivió en el siglo xix y que, ya desde una edad temprana, demostró su habilidad excepcional con los números, antes de sucumbir a su carrera de matemático y a la serie de crisis nerviosas que minaron su adultez. Más tarde descubriría que ese era uno de los problemas fundamentales que tienen los humanos con la comprensión numérica: simple y llanamente, su sistema nervioso no está capacitado.

La verdad es que no dice gran cosa, salvo que era un niño prodigio y que “sufría crisis nerviosas”, sobre una de las grandes mentes matemáticas de la historia, que realizó avances revolucionarios en todas las áreas de las matemáticas en las que trabajó, en particular, el análisis matemático, la geometría diferencial y la teoría de números. Muchos son los conceptos y resultados matemáticos asociados a su nombre, como la integral de Riemann, las ecuaciones de Cauchy-Riemann, las superficies de Riemann, la geometría riemanniana, el tensor de curvatura de Riemann, la función zeta de Riemann o la hipótesis de Riemann, entre otras.

Caricatura de Bernhard Riemann, realizada por Gerardo Basabe de Viñaspre, para la exposición de la Real Sociedad Matemática Española, El rostro humano de las matemáticas (2008)Los números primos

Caricatura de Bernhard Riemann, realizada por Gerardo Basabe de Viñaspre, para la exposición de la Real Sociedad Matemática Española, El rostro humano de las matemáticas (2008)Los números primos

Pero vayamos con los números primos. El primer párrafo sobre los mismos, que nos narra el vonadoriano, es el siguiente.

Los números primos vuelven a la gente loca, pero literalmente, sobre todo por la cantidad de enigmas que quedan sin resolver. Lo único que parecían saber es que un primo es un número entero que solo puede dividirse por 1 y por sí mismo, pero, más allá de eso, se dan de bruces con un problema tras otro.

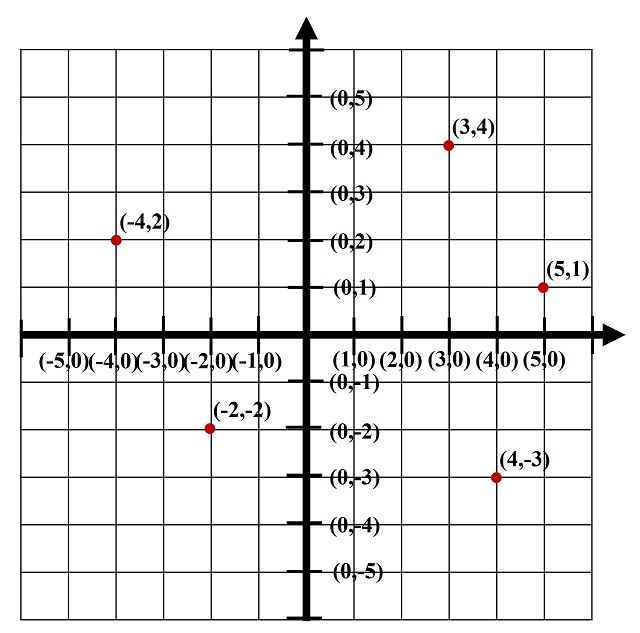

La verdad es que es un comentario bastante simplista, puesto que viene a decir que el único conocimiento que se tiene sobre los números primos es su definición, es decir, que son aquellos números naturales que solamente se pueden dividir por 1 y por ellos mismos. Por ejemplo, el número 25 no es primo ya que se puede dividir por 5, mientras que el número 19 sí es primo, ya que solamente es divisible por el 1 y él mismo, al igual que lo son los números 2, 3, 5, 7, 11 y 13, entre otros. Sin embargo, los humanos llevamos más de dos milenios investigando sobre los números primos y obteniendo muchos e importantes resultados, como que existen infinitos números primos, como ya demostraron los antiguos griegos, que todo número natural se puede expresar de forma única como producto de números primos (el teorema fundamental de la aritmética), que la función contador de números primos, es decir, para cada número x, la cantidad de números primos menores o iguales que x se aproxima por la función x/Ln x (el teorema de los números primos), y así existen miles y miles de resultados más que podríamos añadir. Cabe mencionar que existen muchos libros dedicados solo a los resultados sobre los números primos, de los que mencionaremos aquí cuatro en clave más divulgativa, por si hay alguien interesado: 1) Prime Numbers, The Most Mysterious Figures in Math (David Wells, John Wiley & Sons, 2005); 2) The Little Book of Bigger Primes (Paulo Ribenboim, Springer Verlag, 2004); 3) La música de los números primos (Marcus du Sautoy, Acantilado, 2007); 4) Los números primos, un largo camino al infinito (Enrique Gracián, RBA, 2010).

Aunque después del párrafo anterior, sí menciona alguno de los conocimientos que la humanidad ha alcanzado sobre los números primos, casi siempre expresado de una forma más literaria, o incluso poética, que matemática. Por ejemplo, afirma que se conoce que hay infinitos números primos (la sencilla y hermosa demostración de los griegos podéis leerla en la entrada Buscando lagunas de números no primos), pero además menciona que son numerables, es decir, que se pueden contar (sobre los conjuntos infinitos podéis leer la serie de entradas titulada El infinito en un segmento: uno, dos y tres), de la siguiente forma.

Saben que el total de todos los números primos es igual al total de todos los números, pues ambos sumarían infinitos. Para el humano medio, esto constituye un hecho bastante desconcertante, pues ciertamente tienen que existir más números aparte de los primos. Tan imposible les resulta asimilar que, al enfrentarse al tema, más de uno se ha metido un revólver en la boca, ha apretado el gatillo y se ha volado los sexos.

Aquí realmente está mezclando dos temas apasionantes e importantes, primero que hay infinitos números primos, que puede entenderse bien por sí solo, pero a la vez nos habla de que hay tantos como números naturales, hecho que está relacionado con la dificultad de entender el infinito y sus paradojas, como lo mencionado, que una parte del conjunto (los números primos) tenga tantos elementos como todo el conjunto (los números naturales). Aunque este segundo tema es un poco complejo para las personas que lean la novela, es muy exagerado decir que “tan imposible les resulta asimilar que, al enfrentarse al tema, más de uno se ha metido un revólver en la boca, ha apretado el gatillo y se ha volado los sexos”, aunque tenemos que entender que esto es literatura y no divulgación de las matemáticas.

El siguiente párrafo dice lo siguiente:

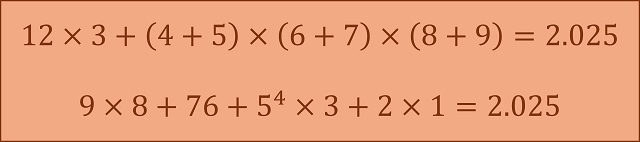

Los humanos también han llegado a entender que los números primos se parecen mucho al aire terráqueo. Cuánto más arriba subes, menos hay. Por ejemplo, hay 25 números primos menores que 100, pero solo 21 entre 100 y el 200 y solo 16 entre 1.000 y 1.100. Sin embargo, a diferencia de aire en la Tierra, no importa lo mucho que subas en la escala de los números, siempre habrá algún número primo. Por ejemplo, 2.097.593 es primo y hay millones más entre ese y, pongamos, 4314398832739895727932419750374600193. En consecuencia, podemos decir que la atmósfera de los números primos recubre todo el universo.

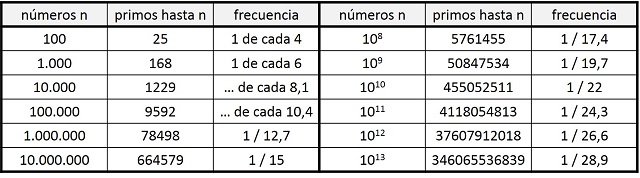

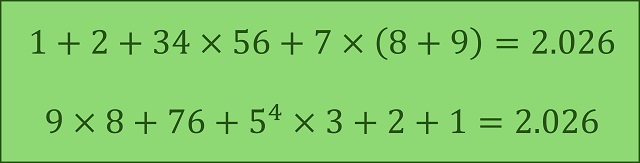

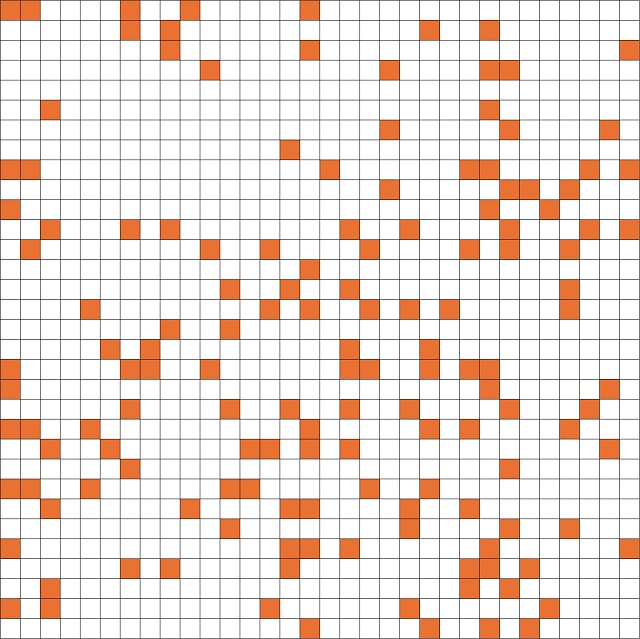

La primera parte ofrece el primer comentario sobre la distribución de los números primos dentro de los naturales, que es el tema central sobre el que versa la hipótesis de Riemann. Y efectivamente es así. Como se comentaba en la entrada Buscando lagunas de números no primos, entre los 100 primeros números hay 25 primos, es decir, 1 de cada 4 números es primo. Sin embargo, si miramos entre los 1.000 primeros números, resulta que hay 168 que son primos, 1 de cada 6 números. Un porcentaje menor. Y así, como podemos ver en la siguiente tabla, según vamos ampliando la cantidad de números considerados, existe un menor porcentaje de números primos. Luego según vamos avanzando en la recta de números naturales, los números primos van siendo cada vez más infrecuentes, y los números compuestos van ocupando más el espacio dentro de los números naturales.

Tabla con la cantidad de números primos y frecuencia de los mismos para cantidades de números que son potencias de 10

Tabla con la cantidad de números primos y frecuencia de los mismos para cantidades de números que son potencias de 10

Sin embargo, el segundo comentario solo es una forma diferente y poética de volver a afirmar que existen infinitos números primos.

La distribución de los números primosEl texto del capítulo “Números primos” sigue asi:

En 1859, no obstante, en la Academia de Berlín, un Bernhard Riemann cada vez más enfermo enunció la que sería la hipótesis más estudiada y celebrada de todas las matemáticas. Afirmaba que había un patrón, o al menos lo había para los primeros mil números primos. Y era bello, cristalino e involucraba algo llamado “función zeta”, una especie de máquina mental, una curva de aspecto complejo que servía para investigar las propiedades de los primos. Si los colocabas en ella, formaban un orden en el que nadie se había fijado con anterioridad: ¡un patrón! ¡La distribución de los números primos no era arbitraria!

Una vez más mencionemos que esto no es un texto de divulgación de las matemáticas, sino literatura, ya que lo afirmado en el anterior párrafo hay que cogerlo con pinzas, pero como lector tengo que entender la intención narrativa del autor de la novela.

Para empezar, podemos considerar que la hipótesis de Riemann es una de las conjeturas más importantes y estudiadas, no en vano estaba entre los 23 problemas de Hilbert (en 1900) y entre los siete problemas del milenio (en 2000), pero hay otros problemas matemáticos también importantes y muy estudiados, como el último teorema de Fermat, conjeturado por el matemático francés Pierre de Fermat (1601-1665) hacia 1637 y demostrado por el matemático británico Andrew Wiles en 1995 (puede leerse sobre esta cuestión en la entrada Euler y el último teorema de Fermat); la conjetura de Poicaré, formulada por el matemático francés Henri Poincaré (1854-1912) en 1904 y demostrada por el matemático ruso Gregori Perelman en 2006 (véase la entrada La conjetura de Poincaré-Perelman-Miander); o el problema del quinto postulado de Euclides y la existencia de las geometrías no euclídeas, un problema que tardó más de dos milenios en resolverse, por matemáticos como Nikolai Lobachevski (1752-1856) y János Bolyai (1802-1860); o incluso problemas matemáticos que permanecen abiertos, como la conjetura de Goldbach, formulada por el matemático prusiano Christian Goldbach (1690-1764) en 1742 (véase la entrada La conjetura de Goldbach); o cualquiera de los problemas del milenio, que son la conjetura de Birch y Swinnerton-Dyer, en teoría de números algebraica; la conjetura de Hodge, en geometría algebraica; la solución de las ecuaciones de Navier-Stokes de la mecánica de fluidos; el problema P = NP, en ciencias de la computación; la conjetura de Poncaré, en topología (ya resuelta en 2006); el problema de la masa en la teoría de Yang-Mills, en la teoría cuántica de campos; y la mencionada hipótesis de Riemann, en análisis complejo y teoría de números primos, que es una de las más importantes y conocida.

Caricatura de David Hilbert, realizada por Enrique Morente, para la exposición de la Real Sociedad Matemática Española, El rostro humano de las matemáticas (2008)

Caricatura de David Hilbert, realizada por Enrique Morente, para la exposición de la Real Sociedad Matemática Española, El rostro humano de las matemáticas (2008)Lo siguiente que vamos a comentar es la frase “afirmaba que había un patrón, o al menos lo había para los primeros mil números primos”, a la que podemos ponerle algunos peros matemáticamente hablando. Decir que había un patrón es ambiguo y simplista, aunque a Matt Haig le pueda valer para la novela.

Desde la matemática griega se ha intentado descubrir, sin éxito, la existencia de algún patrón en la distribución de los números primos dentro de los naturales, pero, como decía el matemático suizo Leonhard Euler (1707-1783), este será uno de esos misterios que la humanidad nunca será capaz de desvelar.

No existe ninguna fórmula que nos permita determinar cuál es el número primo n-ésimo, para cualquiera que sea la posición n, ni una expresión matemática que posibilite, conocidos todos los primos hasta uno dado, obtener el siguiente.

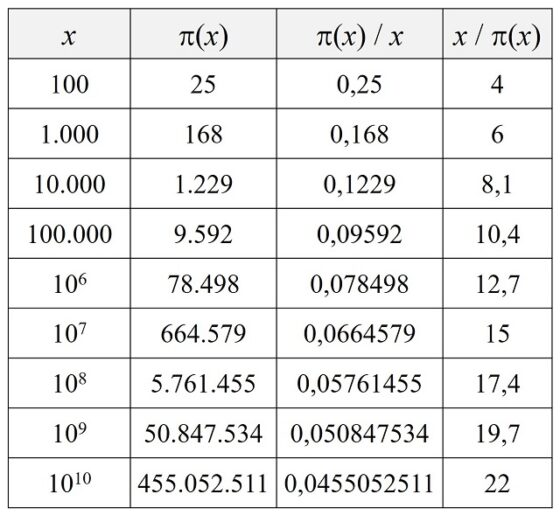

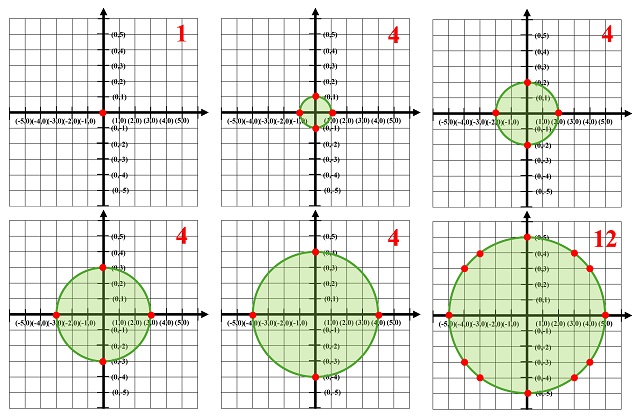

Aunque, una aproximación a la distribución de los números primos es el estudio de la función contador de números primos. Dado un número x se define pi(x) como la cantidad de primos menores, o iguales, que x. Si se observan los números primos hasta 100 se puede comprobar que pi(20) = 8 (que son 2, 3, 5, 7, 11, 13, 17 y 19) o pi(100) = 25 (que son, además de los anteriores, 23, 29, 31, 37, 41, 43, 47, 53, 59, 61, 67, 71, 73 79, 83 89 y 97). En la siguiente tabla se muestra el valor de la función contador de números primos (x) para las primeras potencias de 10, junto con la densidad (x) / x –la proporción de números primos respeto a los naturales, hasta x– y la frecuencia, x / (x) –cuántos números naturales hay por cada primo, hasta x–, que nos incide en la idea anterior de que cada vez hay menos números primos.

La primera aproximación a la distribución de los números primos vino de la mano del matemático alemán Carl F. Gauss (1777-1855), que, a la edad de 15 años, conjeturó que, aunque no se podía conocer con precisión el valor de la función contador de números primos (x), se podía aproximar con la ayuda de la función logaritmo neperiano. Este resultado, conocido como teorema de los números primos, establece que la función (x) se aproxima a la función x / Ln(x), cuando x tiende a infinito. Este teorema fue demostrado en 1896, de forma independiente, por el matemático francés Jacques Hadamard (1865-1963) y el belga Charles-Jean de la Vallé Poussin (1866-1962). Por ejemplo, si se considera x = 106, como Ln(106) es 6 multiplicado por Ln(10) = 2.30258509…, entonces x / Ln(x) es aproximadamente 72.382, siendo la cantidad de primos 78.498.

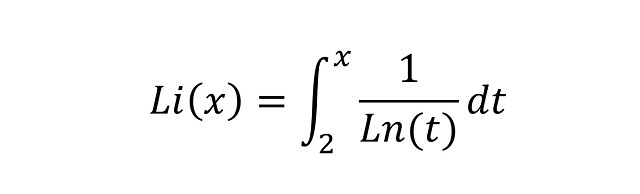

El propio Gauss dio una mejor aproximación a la función contador de números primos mediante la función logaritmo integral

Volviendo al caso de x = 106, mientras que la diferencia de x / Ln(x) con (x) es de 6.116 números, la variación del logaritmo integral Li(x), no os preocupéis ahora de su significado, es sólo de 130.

Pues resulta, que la hipótesis de Riemann, cuya formulación es bastante compleja y está relacionada con los ceros de la conocida función zeta de Riemann que se define sobre los números complejos (ya volveremos sobre ella en alguna futura entrada de Cuaderno de Cultura Científica), es equivalente al hecho de que el logaritmo integral es una “buena” aproximación.

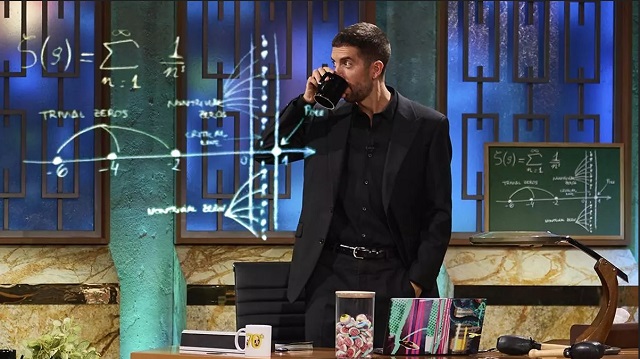

La pizarra del programa La Revuelta, de David Broncano, en TVE, está relacionada con la hipótesis de Riemann, puesto que representa la función zeta de Riemann y la recta donde estarían, según la hipótesis, los ceros no triviales de dicha función. Sobre la pizarra podéis leer el artículo del diario.es titulado El misterio de la pizarra de Broncano: ¿qué pinta esta maravilla de las matemáticas en La Revuelta?Para terminar

La pizarra del programa La Revuelta, de David Broncano, en TVE, está relacionada con la hipótesis de Riemann, puesto que representa la función zeta de Riemann y la recta donde estarían, según la hipótesis, los ceros no triviales de dicha función. Sobre la pizarra podéis leer el artículo del diario.es titulado El misterio de la pizarra de Broncano: ¿qué pinta esta maravilla de las matemáticas en La Revuelta?Para terminar

Para cerrar esta entrada del Cuaderno de Cultura Científica, me gustaría incluir los puntos relacionados con las matemáticas del listado de los 97 “consejos para un humano” que escribe el vonadoriano con aspecto de Andrew Martin al final de la historia, que están escritos para “su hijo” (el de Andrew Martin).

Consejo 12: Los telediarios deberían abrir con noticias de matemáticas y seguir con poesía, y a partir de ahí, que hagan lo que quieran.

Consejo 59: Los números son bonitos. Los primos son bonitos. Ya lo entenderás.

Bibliografía

1.- Francois Truffaut, El cine según Hitchcock, Alianza editorial, 1974.

2.- Matt Haig, Los humanos, Roca Editorial, 2014.

3.- R. Ibáñez, La gran familia de los números, Libros de la Catarata, 2021.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Los humanos, un Macguffin matemático se ha escrito en Cuaderno de Cultura Científica.

Primer plasma en el tokamak SMART de la Universidad de Sevilla

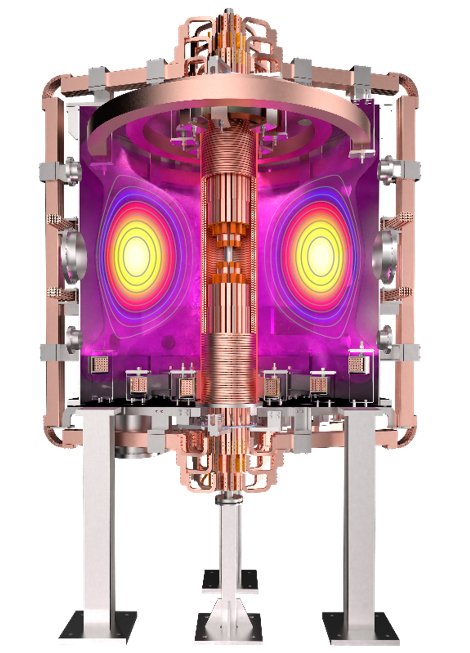

En el marco de un proyecto pionero en el camino hacia el desarrollo de la energía de fusión, el tokamak SMART ha generado con éxito su primer plasma. Este paso acerca a la comunidad internacional a la energía de fusión; una fuente de energía sostenible, limpia y prácticamente ilimitada.

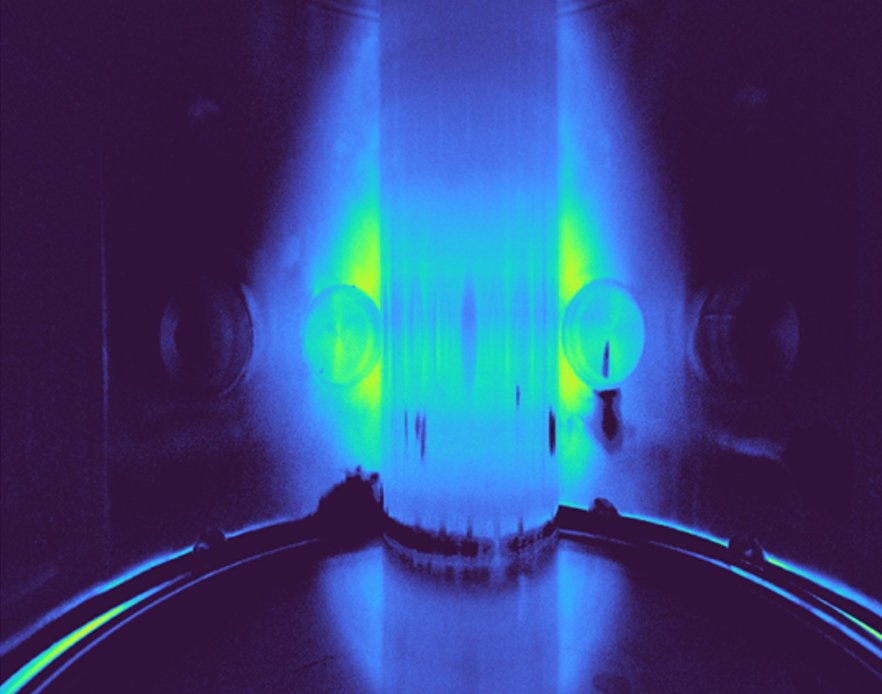

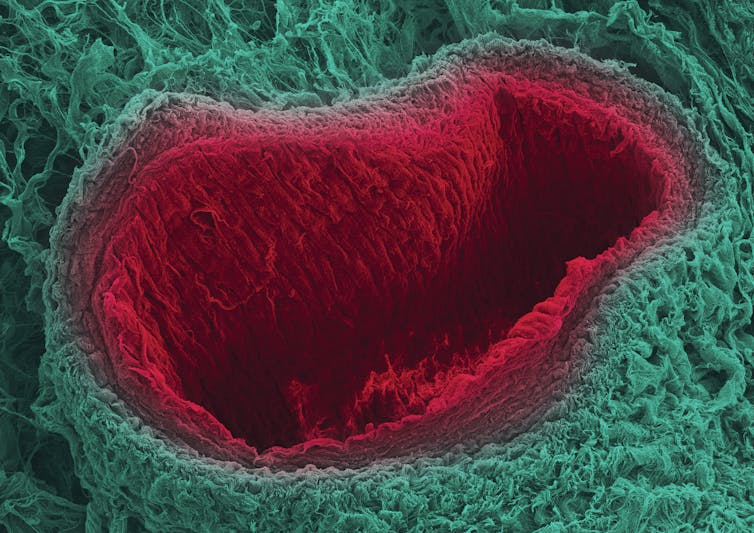

Primer plasma en el SMall Aspect Ratio Tokamak – SMART – grabado con una cámara superrápida en el espectro visible. Fuente: Universidad de Sevilla

Primer plasma en el SMall Aspect Ratio Tokamak – SMART – grabado con una cámara superrápida en el espectro visible. Fuente: Universidad de SevillaEl tokamak SMART (SMall Aspect Ratio Tokamak) es un dispositivo de fusión experimental de última generación diseñado, construido y operado por el Laboratorio de Ciencia del Plasma y Tecnología de Fusión (PSFT) de la Universidad de Sevilla. Se trata de un tokamak esférico único en el mundo debido a su flexibilidad para generar plasmas con distintas formas. SMART ha sido diseñado para demostrar las propiedades físicas e ingenieriles únicas que los plasmas con forma de triangularidad negativa tienen en el camino hacia el desarrollo de plantas de energía de fusión compactas basadas en Tokamaks Esféricos.

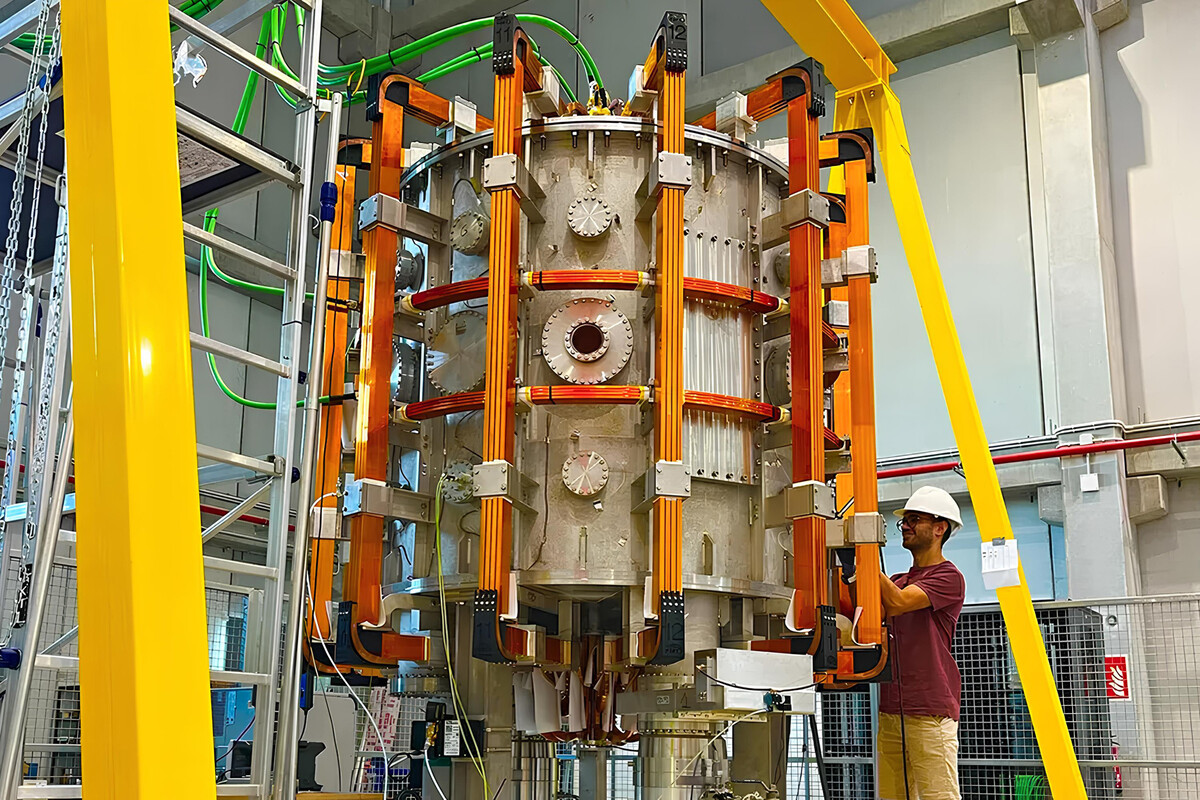

SMART explora un camino potencialmente revolucionario al combinar plasmas de fusión de alto rendimiento con atractivas soluciones para su implementación en reactores de fusión super compactos. Fuente: Universidad de SevillaUna cuestión de triangularidad

SMART explora un camino potencialmente revolucionario al combinar plasmas de fusión de alto rendimiento con atractivas soluciones para su implementación en reactores de fusión super compactos. Fuente: Universidad de SevillaUna cuestión de triangularidad

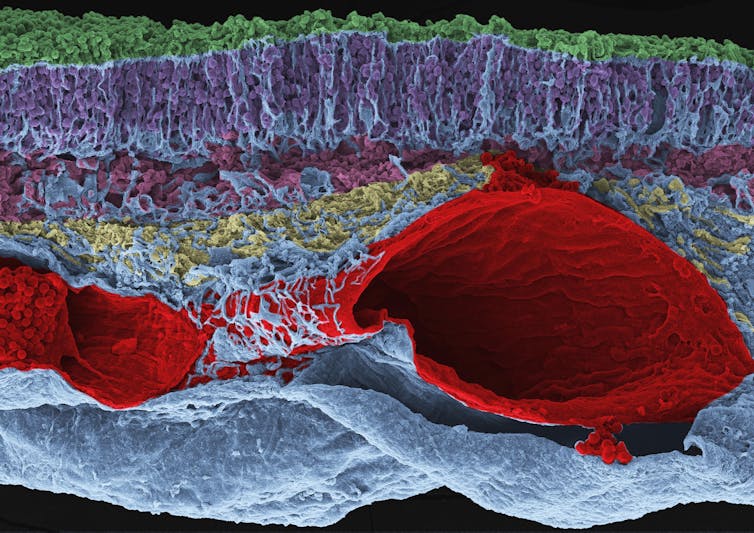

La triangularidad describe la forma del plasma. La mayoría de los tokamaks funcionan con triangularidad positiva, lo que significa que la forma de la sección del plasma parece una D. Si la forma del plasma se asimila a una D invertida (como se aprecia en la imagen de abajo), tiene triangularidad negativa.

Render del Tokamak SMART con un plasma de triangulación negativa en el interior. Fuente: Universidad de Sevilla

Render del Tokamak SMART con un plasma de triangulación negativa en el interior. Fuente: Universidad de SevillaLos plasmas con de triangularidad negativa presentan un rendimiento mejorado ya que suprimen las inestabilidades que degradan el confinamiento del reactor, evitando daños graves a la pared del tokamak. Además de ofrecer un alto rendimiento de fusión, la triangularidad negativa también presenta soluciones atractivas para el control de la potencia generada en las reacciones de fusión, dado que el calor que escapa se distribuye en un área mayor. Esto también facilita el diseño para futuras centrales eléctricas de fusión más compactas y eficientes.

Fusión compactaSMART es el primer paso en la estrategia Fusion2Grid, liderada por el equipo PSFT y en colaboración con la comunidad internacional de fusión, que tiene como objetivo el diseño de una planta de potencia basada en fusión por confinamiento magnético más compacta y eficiente usando tokamaks esféricos con forma de triangularidad negativa. SMART será el primero de este tipo que funcionará a temperaturas de fusión.

El objetivo del tokamak SMART es proporcionar las bases científicas y tecnológicas para el diseño del reactor de fusión más compacto posible. Este primer plasma representa un logro importante para el proyecto, así como para el avance hacia este objetivo.

Referencia:

Dominguez-Palacios, J., Futatani, S., García-Muñoz, M. et al. (2025) Effect of energetic ions on edge-localized modes in tokamak plasmas. Nat. Phys. doi: 10.1038/s41567-024-02715-6

Edición realizada por César Tomé López a partir de materiales suministrados por la Universidad de Sevilla.

El artículo Primer plasma en el tokamak SMART de la Universidad de Sevilla se ha escrito en Cuaderno de Cultura Científica.

El beso planetario de Caronte

Desde su descubrimiento en la década de los años treinta del siglo pasado y hasta el sobrevuelo de la sonda New Horizons en julio de 2015, Plutón y su sistema de satélites había sido poco más que un punto de luz, incluso en los telescopios más avanzados. Y es que si sumamos su pequeño tamaño -tiene un diámetro de apenas una sexta parte el de la Tierra- y su lejanía, era un cuerpo francamente difícil de estudiar.

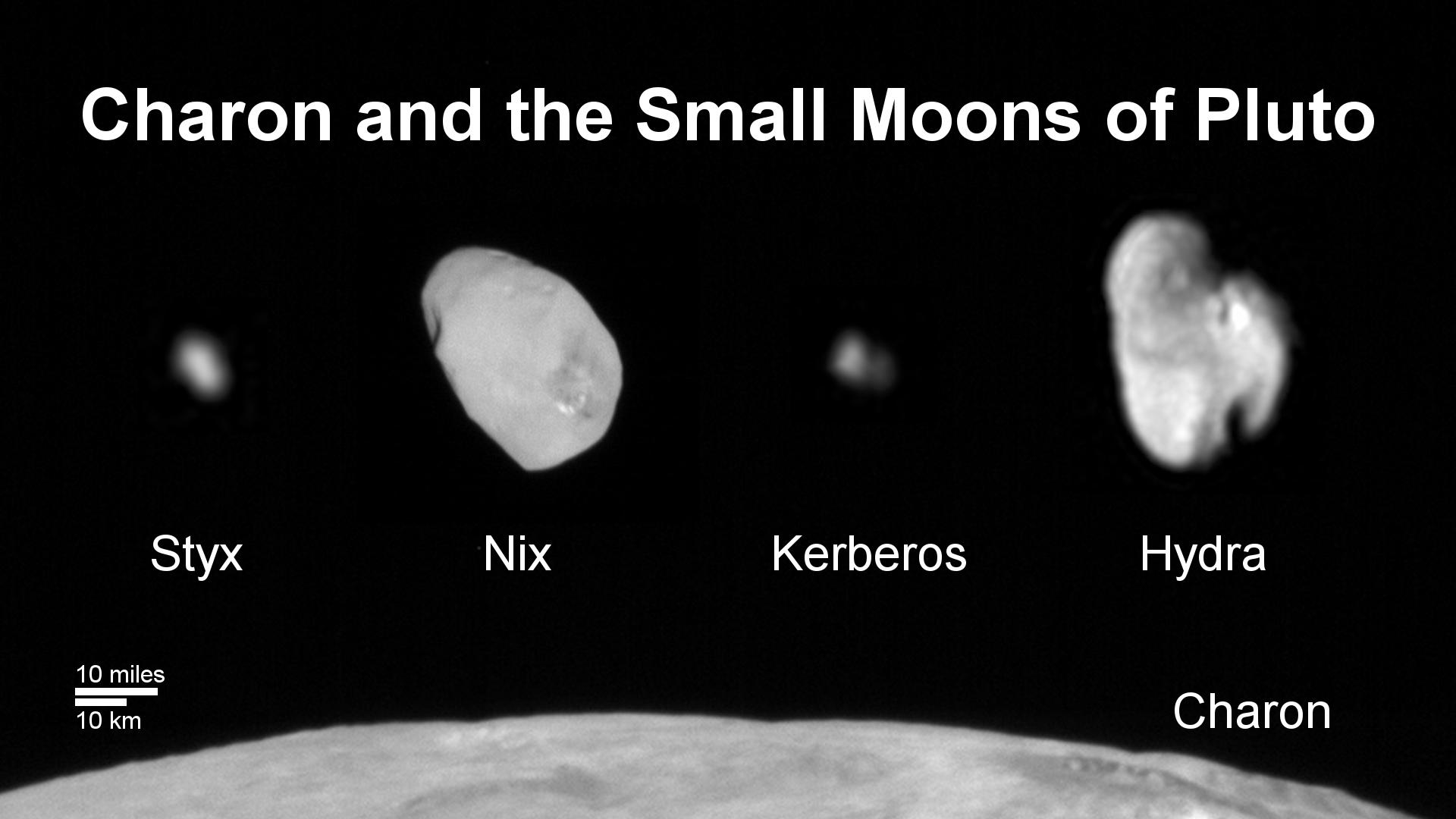

Plutón tiene cinco satélites naturales conocidos: Caronte, Nix, Hidra, Cerbero y Estigia. Caronte fue descubierto a finales de la década de los 70, mientras que el resto fueron descubiertos a partir de los años 2000 -algunos ya en la segunda década-, lo que nos hace una idea de la diferencia de tamaños entre los satélites y que, cuanto más pequeños, más cuesta detectarlos desde una distancia tan grande.

Pero hoy vamos a centrarnos en Caronte que, proporcionalmente, es un satélite enorme para un planeta como Plutón. De hecho, tanto es así que su masa supera al 10% de la suma de las masas del sistema que forma con el planeta enano. Por ponerlo en contexto, en el caso del sistema Tierra-Luna, la masa de la Luna es tan solo de aproximadamente un 1.2%. Echando un vistazo a esta relación de masas, es normal que algunos autores incluso hayan considerado a Plutón y Caronte un sistema binario de cuerpos planetarios.

Figura 1. Imagen de Caronte tomada por la sonda New Horizons en 2015. Destaca en la imagen el color rojizo de Mordor Macula frente a los tonos grisáceos de la superficie, así como zonas con un número de cráteres relativamente bajo en algunas partes de su superficie. ¿Esconderá Caronte procesos geológicos de rejuvencecimiento? Cortesía de NASA/Johns Hopkins University Applied Physics Laboratory/Southwest Research Institute.

Figura 1. Imagen de Caronte tomada por la sonda New Horizons en 2015. Destaca en la imagen el color rojizo de Mordor Macula frente a los tonos grisáceos de la superficie, así como zonas con un número de cráteres relativamente bajo en algunas partes de su superficie. ¿Esconderá Caronte procesos geológicos de rejuvencecimiento? Cortesía de NASA/Johns Hopkins University Applied Physics Laboratory/Southwest Research Institute.¿Y cómo surgió esta dispar pareja planetaria? La teoría más aceptada hasta el momento sugería un mecanismo de formación similar al de nuestra Luna, pero un nuevo estudio publicado en Nature Geoscience por Adeene Denton et al. (2025) propone una nueva teoría que los propios autores del estudio denominan “beso y captura”.

Volvamos por un momento a detallar los mecanismos de formación. Como decíamos en el párrafo anterior, la teoría más aceptada es la de un “gran impacto”. Es decir, en algún momento de la historia de Plutón, un cuerpo de un tamaño relativamente grande chocaría con este, lanzando una gran cantidad de materia a su órbita que, con el tiempo, iría uniéndose hasta formar Caronte. Pero, al igual que en nuestro sistema Tierra-Luna parece encajar este modelo, en el de Plutón y Caronte no parece funcionar del todo.

El mayor problema radica en explicar el tamaño que tiene Caronte ya que, al ser tan grande, requiere que la colisión tuviese unas condiciones muy específicas… casi “tocándose” suavemente, pero con una firmeza suficiente como para arrancar de ambos objetos una cantidad de materia suficiente para formar el satélite y al mismo tiempo no destruir por completo ninguno de los cuerpos en este proceso.

Pero, valga la redundancia, existe otro pero a la teoría del gran impacto en el caso concreto de Plutón: Las simulaciones de este tipo de impactos suelen dar como resultado la formación de más de un satélite, no solo de un gran satélite. Y cuando forman un satélite del tamaño de Caronte, lo hacen en una órbita más excéntrica y no tan circular como la que observamos.

Figura 2. Plutón y Caronte capturados en una sola fotografía. Impresiona ver la pequeña diferencia de tamaño, pero también la pequeña distancia que separa ambos cuerpos. Cortesía de NASA/Johns Hopkins University Applied Physics Laboratory/Southwest Research Institute.

Figura 2. Plutón y Caronte capturados en una sola fotografía. Impresiona ver la pequeña diferencia de tamaño, pero también la pequeña distancia que separa ambos cuerpos. Cortesía de NASA/Johns Hopkins University Applied Physics Laboratory/Southwest Research Institute.Entonces, ¿cómo pudo formarse Caronte? Aquí es donde este nuevo trabajo parece responder a la pregunta de porque no comprendíamos del todo su origen. A los modelos existentes les faltaba tener en cuenta la resistencia de ambos cuerpos y las propiedades mecánicas de los materiales que los conformaban, ya que trataban a Plutón y Caronte como gigantescas esferas con la consistencia de un fluido, con una extrema facilidad para deformarse.

Pero no olvidemos que son cuerpos formados principalmente por hielos, con una estructura interna y cierta capacidad para soportar la deformación. Si queréis pensarlo de manera gráfica -y quizás algo grosera- pensad que pasaría si lanzásemos dos globos llenos de agua uno contra el otro o dos bolas de nieve. ¿Verdad que el resultado sería muy distinto?

Hagamos un viaje al pasado e imaginémonos a un proto-Plutón girando por el espacio y a un proto-Caronte en rumbo de colisión, pero en vez de pensar en una colisión frontal -y que probablemente habría sido muy destructiva- pensemos más en un roce entre ambos cuerpos, o lo que los autores han denominado como un “beso” cósmico”. Pero un beso en el sentido figurado, ya que incluso en estas condiciones la fuerza de la colisión es brutal… y aquí es donde viene la innovación que aporta este estudio.

Al chocar ambos cuerpos, la fricción en el punto de contacto entre ellos actúa como una especie de “freno”, provocando una desaceleración en el movimiento orbital relativo entre ambos y transfiriendo una gran cantidad de momento -en el sentido físico de la palabra- también.

Figura 3. Los satélites de Plutón comparados en tamaño. Se puede apreciar perfectamente la enorme diferencia de tamaño entre los más pequeños y Caronte. ¿Se formarían en el mismo impacto que dio lugar a Caronte? Imagen cortesía de NASA/Johns Hopkins University Applied Physics Laboratory/Southwest Research Institute.

Figura 3. Los satélites de Plutón comparados en tamaño. Se puede apreciar perfectamente la enorme diferencia de tamaño entre los más pequeños y Caronte. ¿Se formarían en el mismo impacto que dio lugar a Caronte? Imagen cortesía de NASA/Johns Hopkins University Applied Physics Laboratory/Southwest Research Institute.Esta fricción provoca que ambos cuerpos conecten de manera temporal, formando una especie de cacahuete o muñeco de nieve rotando rápidamente. La resistencia de los materiales evitaría la mezcla completa del interior de ambos cuerpos, haciendo que ambos sigan siendo geoquímicamente distintos, con sus mantos y núcleos intactos casi por completo.

Poco a poco, la fuerza centrífuga y las de marea irían ayudando a separar al proto-Caronte de Plutón, algo que no fue instantáneo. Eso sí, comenzaría su andadura como satélite en una órbita muy cercana a la superficie de Plutón. Esto provocaría inmensas fuerzas de marea entre ambos cuerpos que ayudarían a que Caronte adquiriese una órbita circular, y no elíptica, como parecían mostrar modelos anteriores, otra de las piezas que no terminaba de encajar.

Este modelo de “beso y captura” no solo ofrece explicaciones que son capaces de satisfacer los parámetros orbitales, la existencia de los otros satélites menores que observamos hoy en día y el gran tamaño de Caronte, sino que además tiene una consecuencia que es muy interesante: Caronte podría ser tan antigua como Plutón, manteniendo una gran parte de su núcleo y su manto original, ya que -a diferencia del caso de la Tierra y la Luna- el grado de mezcla entre ambos cuerpos no fue tan importante, pudiendo servirnos como una ventana al estudio de otras zonas de nuestro sistema solar y a los procesos de un Sistema Solar Primitivo.

Referencias:

Denton, C.A., Asphaug, E., Emsenhuber, A. et al. (2025) Capture of an ancient Charon around Pluto. Nat. Geosci. doi: 10.1038/s41561-024-01612-0

Sobre el autor: Nahúm Méndez Chazarra es geólogo planetario y divulgador científico.

El artículo El beso planetario de Caronte se ha escrito en Cuaderno de Cultura Científica.

Las hormigas también pueden ser rencorosas

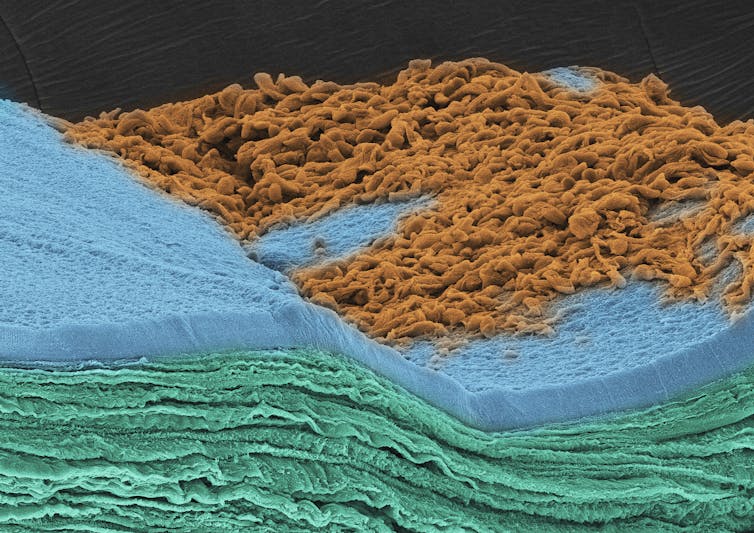

Nido de hormigas. Fuente: David Ballesteros CC

Nido de hormigas. Fuente: David Ballesteros CC

Las ventajas evolutivas del reconocimiento son incontables y han resultado claves para desarrollar un mundo de identidad y pertenencia. Saludamos al vecino del 4ºB por la mañana, dejamos prestado un bolígrafo a nuestro compañero de trabajo, cenamos en Nochebuena con los miembros de nuestra familia y desconfiamos del hombre que nos sigue de noche por un callejón. Cualquier colectivo, desde las tribus paleolíticas hasta nuestras modernas sociedades se han cimentado sobre la distinción entre el igual y el extraño. Pero esta capacidad no es única del ser humano, de hecho es un factor clave de unión y protección en todas las escalas de la vida. Desde nuestras diminutas células T, capaces de detectar y neutralizar las amenazas procedentes de otras células tumorales o virus, hasta los intrincados nexos que se producen en una manada de lobos.

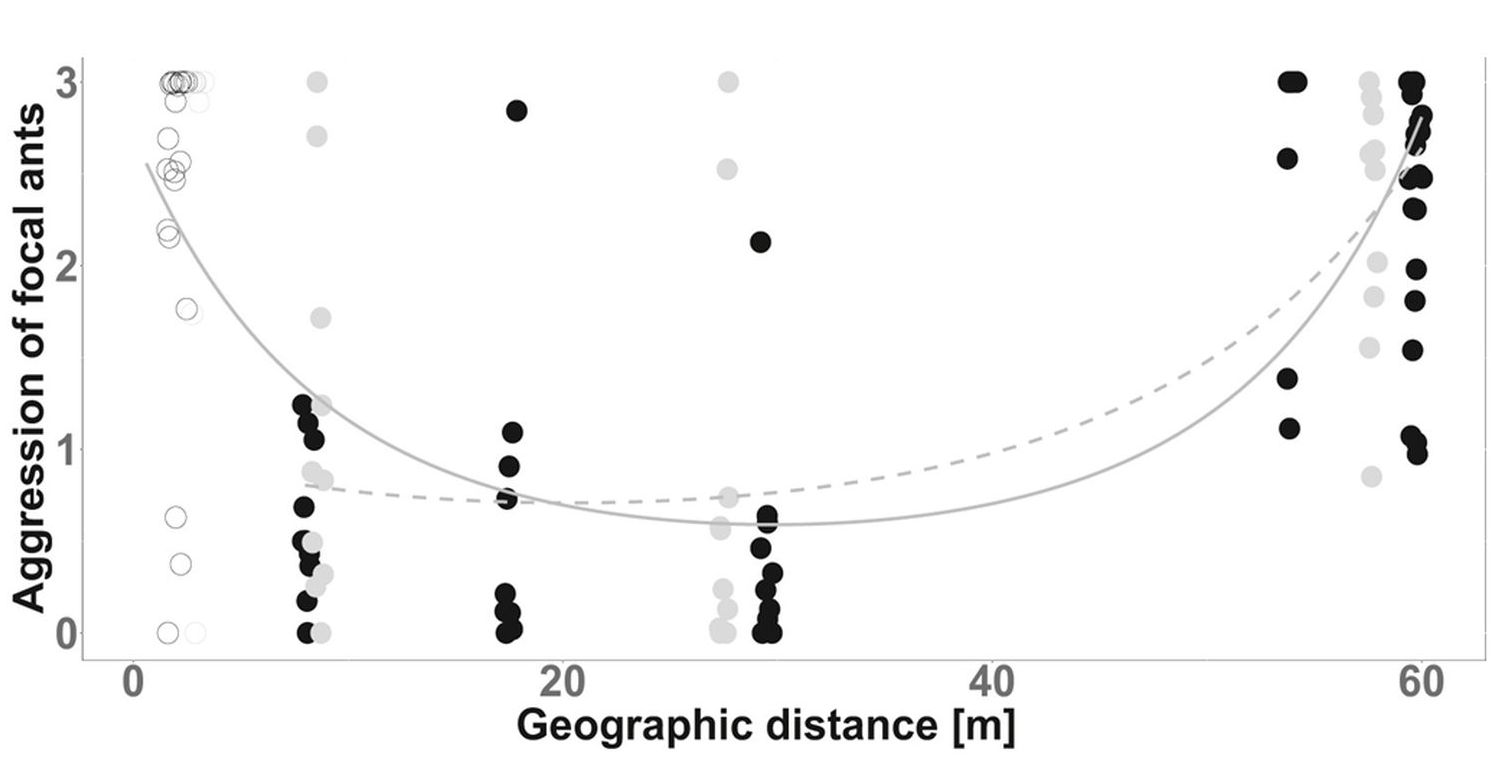

En las especies eusociales esta habilidad es aún más pronunciada, aunque las formas de identificar a los miembros de su grupo pueden llegar a ser muy variadas. Las hormigas utilizan «los olores para distinguir entre los miembros de su propio nido y los de otros nidos, ya que cada nido tiene su propio olor específico». En estudios anteriores se demostró que las hormigas se comportan de manera más agresiva con sus vecinas más cercanas, un comportamiento lógico puesto que esta cercanía supone una mayor amenaza por el control de los recursos en los alrededores del nido. Son especialmente propensas a abrir sus mandíbulas y morder, a rociar ácido o incluso a matar a sus competidoras. Por otro lado, estas maniobras tan agresivas son menos frecuentes contra los nidos que están más lejos del suyo. Esto representa un claro ejemplo de aprendizaje asociativo en el que los insectos sociales son capaces de asociar una señal de olor con una recompensa o una amenaza.

Es más, la agresividad de las hormigas en su objetivo de defender su hogar está directamente relacionada con la distancia a la que se encuentra el nido que podría suponer un peligro.

Las agresiones se intensifican frente a miembros de nidos cercanos. Fuente: Bey et al (2024) / Current Biology

Las agresiones se intensifican frente a miembros de nidos cercanos. Fuente: Bey et al (2024) / Current Biology

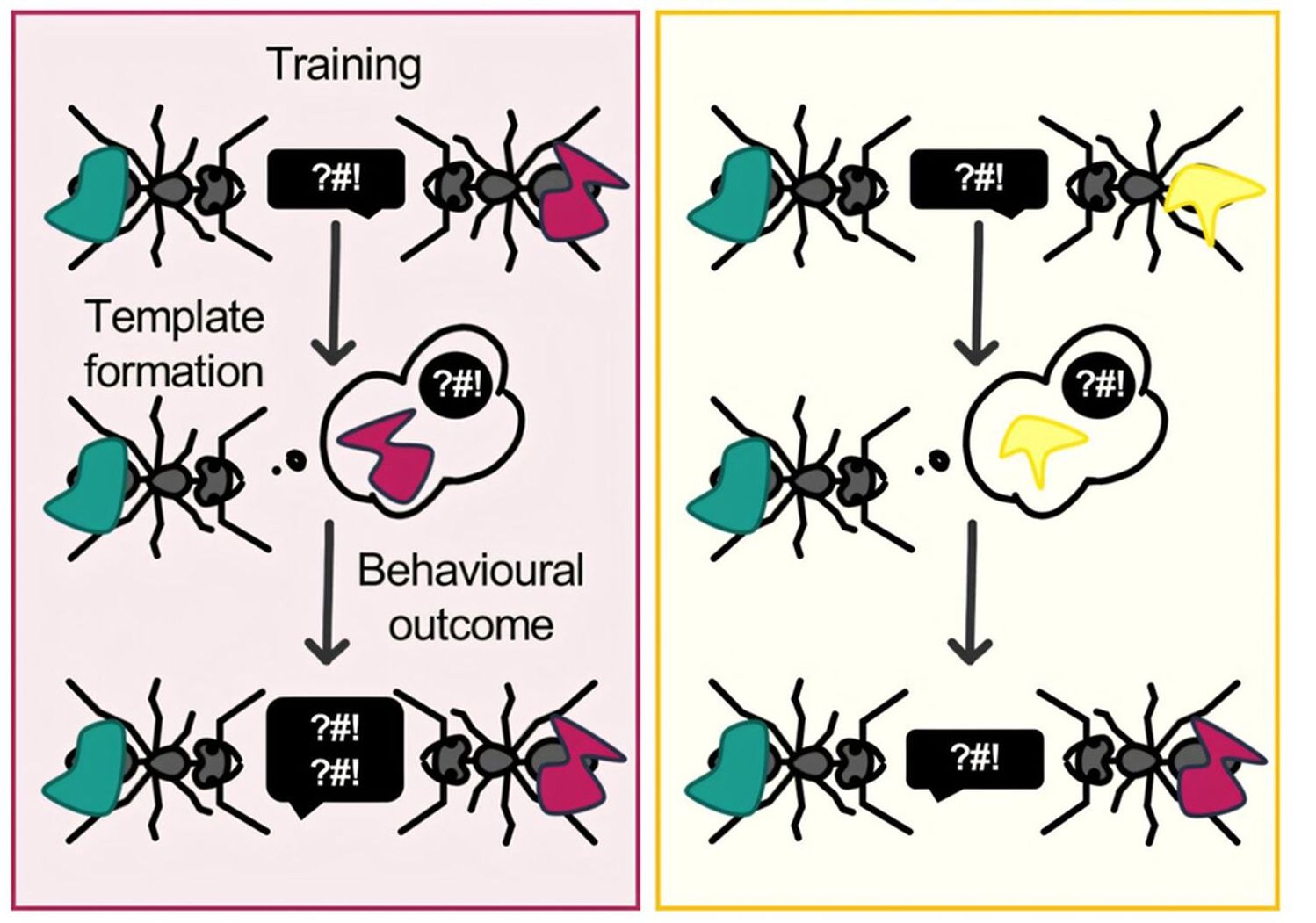

Sin embargo, un nuevo estudio publicado hace solo unos días en Current Biology ha dado un paso más y encontrado evidencias de aprendizaje no asociativo en la conducta de las hormigas. No solo detectan las señales características de un nido vecino (efecto del vecino desagradable) sino que son capaces de recordar individualmente a sus rivales más agresivos y adaptan su comportamiento específicamente a ese ejemplar.

Así lo ha demostrado un equipo de biólogos evolutivos de la Universidad alemana de Friburgo que enfrentaron repetidamente a un grupo de hormigas con competidoras de otro nido. Utilizaron hormigas negras de jardín (Lasius niger), muy frecuentes en Europa, América y Asia, que recogieron de diferentes nidos en los alrededores de su centro de investigación.

Las hormigas del grupo de control recordaron las experiencias negativas que tuvieron durante esos encuentros y cuando se encontraron con hormigas de un nido con las que previamente habían tenido encontronazos, recordaron esas experiencias negativas y se comportaron de manera más agresiva con esos adversarios. Por otro lado, esas mismas hormigas fueron menos agresivas con los miembros del nido rival con las que no habían mantenido ningún rifirrafe…

Las hormigas recuerdan a rivales con los que han tenido encuentros y modulan su agresividad al individuo rival. Fuente: Bey et al (2024) / Current Biology

Las hormigas recuerdan a rivales con los que han tenido encuentros y modulan su agresividad al individuo rival. Fuente: Bey et al (2024) / Current Biology

Es lo que en términos populares denominaríamos «me he quedado con tu cara y ya nos veremos la próxima vez». El estudio resulta interesante porque confirma que «el aprendizaje asociativo juega un papel crucial en el reconocimiento tanto de sus compañeras de nido como de sus rivales», pero además muestra que la agresión recibida por una hormiga «actúa como estímulo de aprendizaje no asociativo que la hormiga probable asocia con la etiqueta de olor de su enemigo individualmente». En sus conclusiones, los investigadores añaden que este tipo de aprendizaje y memoria a largo plazo podría ayudarnos a entender mejor las complejas variaciones que las hormigas muestran no solo con sus rivales sino con sus compañeras de nido.

Referencias y más información

Mélanie Bey et al. «Associative learning of non-nestmate cues improves enemy recognition in ants». Current Biology (2024). DOI: 10.1016/j.cub.2024.11.054

Albert Ludwigs «Ants hold grudges, study suggests» Phys.org

Nota de prensa de la Universidad de Freigurg

Sobre el autor: Javier «Irreductible» Peláez (Puertollano, 1974) es escritor y comunicador científico. Autor de 500 años de frío. La gran aventura del Ártico (Crítica, 2019) y Planeta Océano (Crítica 2022). Es uno de los fundadores de la plataforma Naukas.com, editor de ciencia en Yahoo España y Latinoamérica. Es guionista científico en los programas de televisión «El Cazador de Cerebros» y «Órbita Laika» de RTVE. Durante más de una década ha escrito en diferentes medios de comunicación (El País, El Español, National Geographic, Voz Populi). Es autor de los podcasts Catástrofe Ultravioleta y La Aldea Irreductible, y ha colaborado en diferentes proyectos radiofónicos y televisivos (Radio Nacional de España, Radio Televisión Canaria). Es ganador de tres premios Bitácoras, un premio Prisma a la mejor web de divulgación científica y un Premio Ondas al mejor programa de radio digital.

El artículo Las hormigas también pueden ser rencorosas se ha escrito en Cuaderno de Cultura Científica.

¿A qué saben las rocas?

Es fácil creer que el único sentido que utilizamos para trabajar en Geología es la vista. Mirar el paisaje para comprender su historia; mirar una roca o un fósil para poder identificarlos; mirar a través de un microscopio para descubrir los secretos más pequeños de ese material… mirar, siempre mirar. Pero, en realidad, las geólogas y los geólogos utilizamos nuestros cinco sentidos para hacer nuestros estudios de la manera más completa posible. Sí, los cinco, el gusto también.

Aspecto de un pequeño arroyo de agua salada en Bardenas Reales de Navarra bajo unas fuertes condiciones de evaporación. El agua adquiere una coloración rojiza debido a la alta concentración de elementos químicos, que se van depositando en el fondo y los márgenes del cauce en forma de una fina película de tonos blancos y grises claros.

Aspecto de un pequeño arroyo de agua salada en Bardenas Reales de Navarra bajo unas fuertes condiciones de evaporación. El agua adquiere una coloración rojiza debido a la alta concentración de elementos químicos, que se van depositando en el fondo y los márgenes del cauce en forma de una fina película de tonos blancos y grises claros.Si habéis leído algún otro artículo mío, ya sabréis que, dentro del ámbito científico, las personas que nos dedicamos a la Geología tenemos la fama de ser unas «chupa piedras». Y, como he dicho en otras ocasiones, es una fama más que merecida. Utilizamos nuestra propia saliva, muchas veces a partir de un lametón, sobre el corte fresco de una roca para que sea más fácil ver su estructura interna con la lupa de mano; arrimamos rocas a la punta de la lengua para comprobar si se nos pega y determinar así su porosidad; incluso, masticamos barro para estimar, de forma aproximada, el tamaño de grano de las partículas que componen ese sedimento. Pero también saboreamos los materiales geológicos para poder identificarlos.

Siempre nos han enseñado que el agua no tiene sabor, pero eso no es exactamente así. Si consumís agua mineral embotellada, seguro que tenéis una favorita que os gusta más que otra. En mi caso, como buena habitante de Solares (Cantabria), siempre digo que el resto de marcas no me saben a nada. Pues ese sabor que tienen las aguas embotelladas depende de su «mineralización», es decir, de los elementos químicos que lleva disueltos el agua. Y esos elementos solo los puede sacar de un lugar, las rocas que atraviesa el agua subterránea en su viaje bajo tierra. Así, el agua de Solares se considera «dura» al contener grandes cantidades de carbonato cálcico disuelto, lo que le confiere un sabor más intenso, debido a que atraviesa rocas calizas. Sin embargo, aguas que atraviesan rocas como los granitos son de «mineralización débil» y tienen un sabor muy suave. Además, esta composición química del agua mineral también va a determinar el sabor de los productos que se elaboren con ella, como la cerveza. Si queréis saber más sobre este tema, os aconsejo visitar el blog de mi querido y admirado compañero Andrés Díez Herrero llamado Geología de Segovia, porque os va a sorprender.

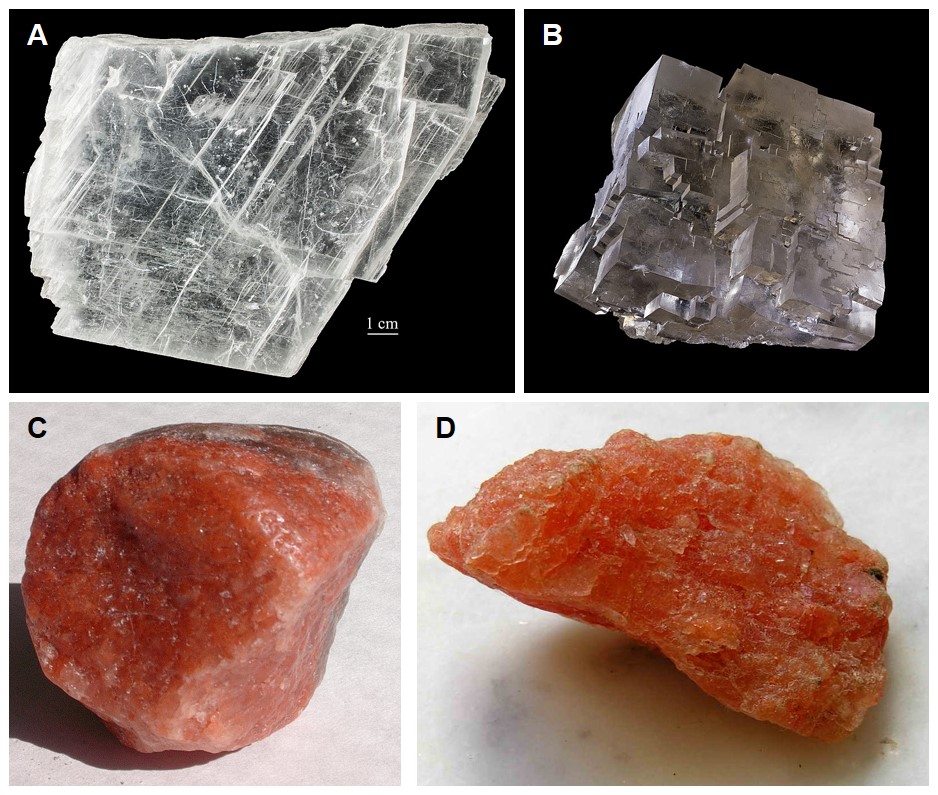

Ejemplos de los minerales más comunes que forman parte de las rocas evaporíticas: A) yeso, B) halita, C) carnalita, D) silvita. Imágenes: A) de Tõnis Saadre (Estonian Museum of Natural History), B) de Didier Descouens, C) de Miguel Sierra, y D) de Luis Miguel Bugallo Sánchez, todas ellas tomadas Wikimedia Commons.

Ejemplos de los minerales más comunes que forman parte de las rocas evaporíticas: A) yeso, B) halita, C) carnalita, D) silvita. Imágenes: A) de Tõnis Saadre (Estonian Museum of Natural History), B) de Didier Descouens, C) de Miguel Sierra, y D) de Luis Miguel Bugallo Sánchez, todas ellas tomadas Wikimedia Commons.Pero en el título no menciono el agua, sino las rocas, porque hay un tipo en particular en el que el gusto es el principal sentido empleado para identificar los minerales que la componen, al menos mientras estamos en el campo: las evaporitas. Se trata de unas rocas sedimentarias que, como su propio nombre indican, se forman por la evaporación de agua salada en medios tanto continentales (como los lagos salados) como marinos (por ejemplo, en lagunas costeras o albuferas) de zonas cálidas, donde la precipitación es escasa. Al evaporarse el agua, los elementos químicos disueltos en ella empiezan a aumentar su concentración, llegando a combinarse entre sí y a precipitar en forma de minerales que se van acumulando en el fondo de estos ambientes acuáticos.

Entre esos minerales precipitados encontramos yeso (CaSO4·1/2H2O), halita (NaCl), carnalita (KCl) y silvita (KMgCl3·6H2O). En un mundo ideal, estos minerales siguen una secuencia temporal de precipitación, apareciendo en finas capas superpuestas donde, además, cada mineral se puede diferenciar entre sí por su estructura cristalina y su color. Pero, en el mundo real, todos ellos aparecen entremezclados en las rocas evaporíticas, generalmente englobados en una masa arcillosa. En esos casos, sacamos la lengua para identificarlos, porque su sabor los delata: La halita es la famosa sal gema que utilizamos en la mesa para echarle a los alimentos, así que su sabor es salado; la silvita tiene un sabor entre salado y amargo; la carnalita es mucho más amarga, incluso con un tono picante; y el yeso…bueno, pues si le dais un lametazo a la pared, lo podréis saber. Así, gracias al gusto podemos hacernos una idea de los minerales que componen la roca.

Las evaporitas son las principales rocas que nos llevamos a la boca para que nuestro gusto nos de pistas sobre su composición mineral, pero no son las únicas. En ocasiones, también dejamos que nuestras pupilas gustativas nos vayan guiando cuando buscamos una mineralización metálica. Supongo que ya os imaginaréis el sabor que tienen esos materiales y, no, no es nada agradable, por eso os digo que solo lo hacemos cuando es estrictamente necesario.

Exterior de la denominada Montaña de Sal de Cardona (Barcelona), una gran formación evaporítica generada hace unos 37 Millones de años en la que se depositaron yeso, halita, carnalita y silvita, minerales que fueron explotados desde el Neolítico. Foto: Jordi Domènech i Arnau / Wikimedia Commons

Exterior de la denominada Montaña de Sal de Cardona (Barcelona), una gran formación evaporítica generada hace unos 37 Millones de años en la que se depositaron yeso, halita, carnalita y silvita, minerales que fueron explotados desde el Neolítico. Foto: Jordi Domènech i Arnau / Wikimedia CommonsPero esta propiedad de saborear las rocas para identificar sus minerales tiene otra aplicación diferente a la de ayudarnos en los trabajos de campo: que las personas con discapacidad también puedan disfrutar de la Geología. Cuando estamos preparando actividades de divulgación de las Ciencias de la Tierra para personas con problemas de visión, siempre pensamos en el tacto, generando maquetas de las estructuras geológicas o haciendo moldes de minerales y fósiles, y en el oído, grabando audioguías inclusivas con descripción de las imágenes. Sin embargo, también podemos utilizar el gusto, como en el taller de cata de aguas creado por la Asociación Ciencia sin Barreras de la Facultad de Geología de la Universidad Complutense de Madrid. De esta manera, tenemos una herramienta más para hacer que la divulgación de la Geología sea plenamente inclusiva.

Para terminar, solo me queda repetir una reivindicación. Soy una orgullosa “chupa piedras”, porque es la única herramienta geológica que siempre llevo encima, nunca me va a fallar y me va a solucionar un montón de dudas. Eso sí, no vayáis chupando rocas a lo loco por el campo, hacedlo solo en aquellas que os diga una geóloga.

Sobre la autora: Blanca María Martínez es doctora en geología, investigadora de la Sociedad de Ciencias Aranzadi y colaboradora externa del departamento de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU

El artículo ¿A qué saben las rocas? se ha escrito en Cuaderno de Cultura Científica.

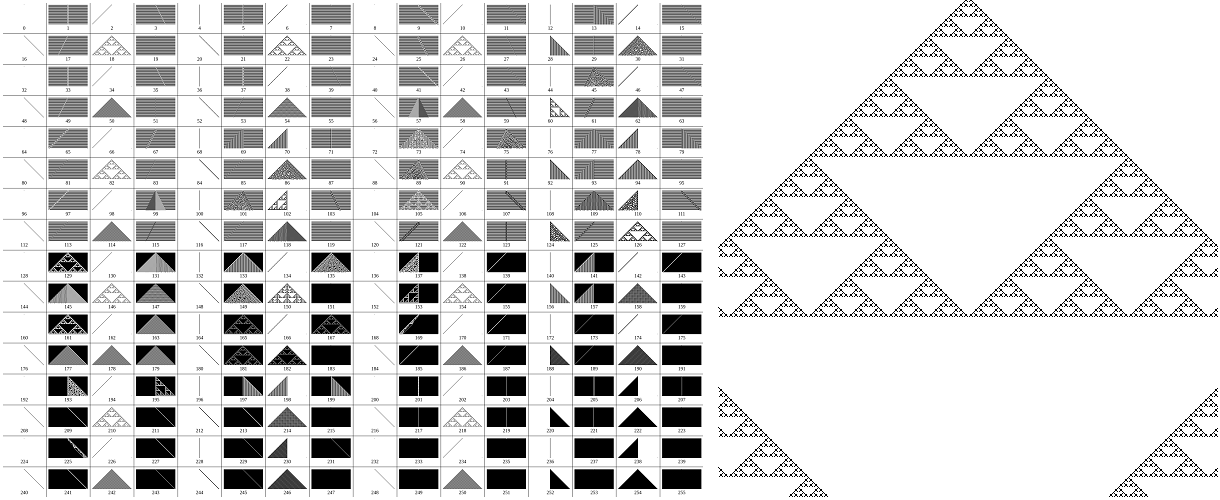

Euclides y sus rivales modernos

Euclid and His Modern Rivals(1879) es una comedia en cuatro actos de Charles Lutwidge Dodgson, más conocido como Lewis Carroll. Considerado como el más famoso trabajo en geometría del lógico y matemático, se trata de una defensa de la geometría de Euclides frente a lo que denominó teorías matemáticas modernas.

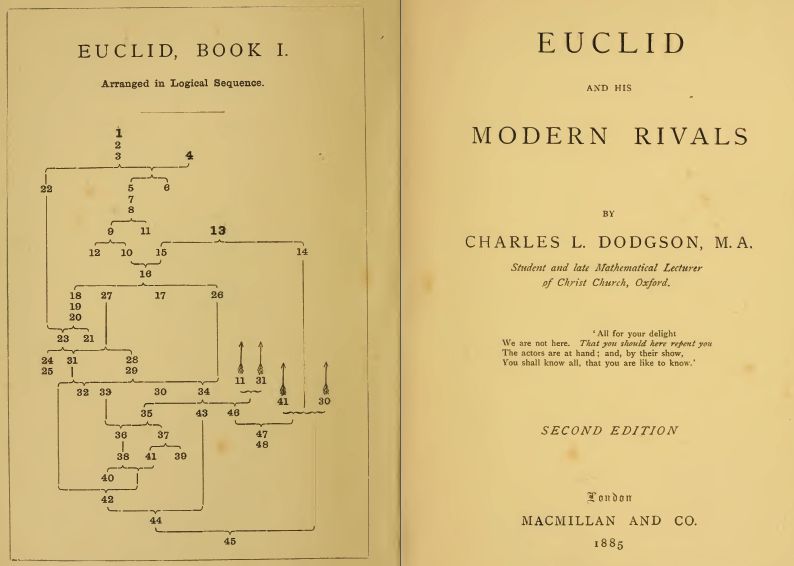

Portada de Euclid and His Modern Rivals. El esquema de la izquierda sugiere el orden en el que se deberían explicar los postulados de Euclides en el aula. Fuente: Internet Archive.

Portada de Euclid and His Modern Rivals. El esquema de la izquierda sugiere el orden en el que se deberían explicar los postulados de Euclides en el aula. Fuente: Internet Archive.

Los matemáticos británicos consideraban que la geometría euclidiana era el estándar más alto de aprendizaje escolar. Con la llegada de las geometrías no euclidianas y la geometría proyectiva y los cambios en la enseñanza de las matemáticas en Francia, muchos matemáticos decidieron redactar sus propias versiones de la geometría de Euclides. Los “tradicionalistas”, entre los que se encontraba Dodgson, acusaron a estos autores de “destruir a Euclides”.

Dodgson realiza en esta obra un estudio minucioso de trece libros destinados a la enseñanza de la geometría elemental en las escuelas de aquella época. En estos manuales, respecto al libro de Los Elementos de Euclides, se modifica a veces algún axioma o una definición, en otros se cambia el orden de los teoremas, en ocasiones se abordan las demostraciones de manera diferente, en algunos se modifica el tratamiento de la teoría de las paralelas, etc. Para Dodgson, ninguno de estos cambios mejora el texto de Euclides.

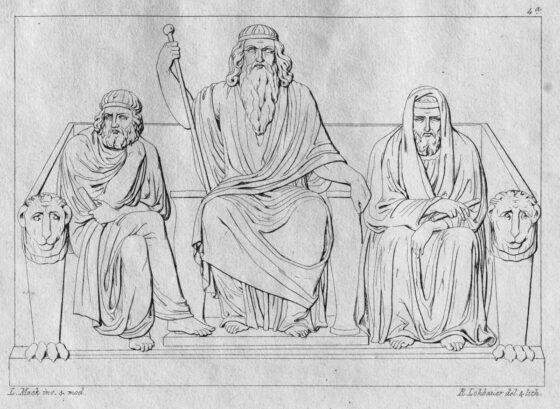

Para realizar este análisis, que podría resultar tedioso de otra manera, como afirma el propio autor en la introducción, Dodgson recurre al rey Minos y a su hermano Radamantis, ambos hijos de Zeus y Europa, según la mitología griega. Recordemos que, junto al rey Éaco, Minos y Radamantis son los tres jueces del Hades. En su papel de árbitros estrictos, en Euclid and His Modern Rivals dialogan con dos fantasmas, el de Euclides y el del profesor alemán Herr Niemand, portavoz de los trece autores cuyos libros se examinan.

Litografía de los tres jueces de los muertos: Minos, Éaco y Radamantis (Ludwig Mack, Die Unterwelt, 1826). Fuente: Wikimedia Commons.

Litografía de los tres jueces de los muertos: Minos, Éaco y Radamantis (Ludwig Mack, Die Unterwelt, 1826). Fuente: Wikimedia Commons.El matemático y geómetra griego Euclides en Alejandría aparece en la obra como un personaje modesto y, aunque convencido de la calidad de su obra, no tiene inconveniente en que se analice. Uno a uno, escena a escena, estos rivales modernos verán como sus textos se critican y se rechazan frente a Los Elementos de Euclides.

Lewis Carroll se sirve del humor y de los juegos de palabras para invalidar a los rivales de Euclides.

Los autores de los trece librosLos trece libros de geometría (sus años de edición y sus autores) examinados por Dodgson en Euclid and His Modern Rivals son, en el orden en el que aparecen citados en el texto:

-

Adrien-Marie Legendre y su Éléments de Géometrie (1860).

-

William Desborough Cooley y su The Elements of Geometry, simplified and explained (1860).

-

Francis Cuthbertson y su Euclidian Geometry(1874).

-

Olaus Henrici y su Elementary Geometry : Congruent Figures(1879).

-

James Maurice Wilson y su Elementary Geometry(1869).

-

Benjamin Peirce y su An Elementary Treatise on Plane and Solid Geometry (1872).

-

William Alexander Willock y su The Elementary Geometry of the Right Line and Circle (1875).

-

William Chauvenet y su A Treatise on Elementary Geometry(1876).

-

Elias Loomis y su Elements of Geometry and Conic Sectionsv ().

-

John Reynell Morell y su Euclid simplified. Compiled from the most important French works, approved by the University of Paris (1875).

-

Edward Morris Reynolds y su Modern Methods in Elementary Geometry (1868).

-

Richard P. Wright y su The Elements of Plane Geometry (1871).

-

Syllabus of Association for Improvement of Geometrical Teaching, Wilson’s ‘Syllabus’-Manual (1878).

En 2000 Jimbo Wales creó Nupedia, un proyecto de enciclopedia libre basado en un ambicioso proceso de revisión por pares. Debido al lento avance del proyecto, en 2001 se creó un motor de wiki –UseModWiki–vinculado a Nupedia cuya finalidad inicial era agilizar la creación de artículos de forma paralela, antes de que éstos pasaran al sistema de revisión por personas expertas. El éxito de aquel proyecto paralelo –Wikipedia– acabó eclipsando a Nupedia, que dejó de funcionar en 2003.

El primer logotipo de Wikipedia –conocido como Wiki logo Nupedia– se diseñó en 2001, superponiendo una frase de Lewis Carrollsobre un círculo, usando el efecto de ojo de pez para simular una esfera. La frase es una cita en inglés tomada del prefacio de Euclid and his Modern Rivals, que dice:

In one respect this book is an experiment, and may chance to prove a failure: I mean that I have not thought it necessary to maintain throughout the gravity of style which scientific writers usually affect, and which has somehow come to be regarded as an ‘inseparable accident’ of scientific teaching. I never could quite see the reasonableness of this immemorial law: subjects there are, no doubt, which are in their essence too serious to admit of any lightness of treatment – but I cannot recognise Geometry as one of them. Nevertheless it will, I trust, be found that I have permitted myself a glimpse of the comic side of things only at fitting seasons, when the tired reader might well crave a moment’s breathing-space, and not on any occasion where it could endanger the continuity of the line of argument.

[En un aspecto, este libro es un experimento y puede resultar un fracaso: quiero decir que no he creído necesario mantener en todo momento la gravedad del estilo que suelen adoptar los escritores científicos y que de alguna manera ha llegado a ser considerado como un “accidente inseparable» de la enseñanza científica. Nunca pude ver la razonabilidad de esta ley inmemorial: hay temas, sin duda, que son en esencia demasiado serios para admitir un tratamiento ligero, pero no puedo reconocer la Geometría como uno de ellos. Sin embargo, espero que se descubra que me he permitido vislumbrar el lado cómico de las cosas sólo en momentos apropiados, cuando el lector cansado bien podría anhelar un momento de respiro, y no en ninguna ocasión en la que pudiera poner en peligro la continuidad de la línea argumental.]

El discurso de despedidaEuclid and His Modern Rivals finaliza con el discurso de despedida de Euclides, tras el cual los fantasmas desaparecen y Minos se va a dormir:

‘The cock doth craw, the day doth daw’, and all respectable ghosts ought to be going home. Let me carry with me the hope that I have convinced you of the importance, if not the necessity, of retaining my order and numbering, and my method of treating straight Lines, angles, right angles, and (most especially) Parallels. Leave me these untouched, and I shall look on with great contentment while other changes are made while my proofs are abridged and improved, while alternative proofs are appended to mine and while new Problems and Theorems are interpolated.

In all these matters my Manual is capable of almost unlimited improvement.

[‘El gallo canta, el día amanece’ y todos los fantasmas respetables deberían regresar a casa. Permíteme llevarme conmigo la esperanza de haberte convencido de la importancia, si no la necesidad, de conservar mi orden y numeración, y mi método para tratar líneas rectas, ángulos, ángulos rectos y (muy especialmente) Paralelas. Déjadme esto intacto, y observaré con gran satisfacción cómo se realizan otros cambios, mientras mis pruebas se abrevian y mejoran, cómo se añaden pruebas alternativas a las mías y cómo se interpolan nuevos problemas y teoremas.

En todos estos asuntos mi Manual es susceptible de mejoras casi ilimitadas.]

Referencias

-

Charles Lutwidge Dodgson, Euclid and His Modern Rivals, MacMillan, 1879

-

Natalie Schuler Evers, Lewis Carroll’s Defense of Euclid: Parallels or Contrariwise, en Sriraman, B. (eds) Handbook of the Mathematics of the Arts and Sciences. Springer, Cham, 2021

-

Joan L. Richards, Mathematical Visions: The Pursuit of Geometry in Victorian England, Academic Press, 1988

-

Frank J. Swetz, Mathematical Treasure: Dodgson’s Defense of Euclid, MMA, 2013

El artículo Euclides y sus rivales modernos se ha escrito en Cuaderno de Cultura Científica.

Por qué los informáticos consultan oráculos

Los dispositivos hipotéticos que pueden responder preguntas con rapidez y precisión se han convertido en una potente herramienta en la teoría de la complejidad computacional.

Un artículo de Ben Brubaker. Historia original reimpresa con permiso de Quanta Magazine, una publicación editorialmente independiente respaldada por la Fundación Simons.

https://culturacientifica.com/app/uploads/2025/01/Oracle_Comp.mp4Haz una pregunta a una Bola 8 Mágica, y te responderá con un sí, un no, o algo exasperantemente impreciso. La consideramos un juguete para niños, pero los teóricos de la computación emplean una herramienta similar. A menudo imaginan que pueden consultar dispositivos hipotéticos llamados oráculos, que pueden responder instantáneamente y de manera correcta a preguntas específicas. Estos experimentos mentales fantásticos han inspirado nuevos algoritmos y ayudado a los investigadores a mapear el paisaje de la computación.

Los investigadores que invocan oráculos trabajan en un subcampo de la informática llamado teoría de la complejidad computacional. Se ocupan de la dificultad inherente de problemas como determinar si un número es primo o encontrar el camino más corto entre dos puntos en una red. Algunos problemas son fáciles de resolver, otros parecen mucho más difíciles pero tienen soluciones que son fáciles de verificar, mientras que otros son fáciles para los ordenadores cuánticos pero aparentemente difíciles para los ordenadores ordinarios.

Los teóricos de la complejidad buscan entender si estas diferencias aparentes en dificultad son fundamentales. ¿Hay algo intrínsecamente difícil en ciertos problemas, o simplemente no somos lo suficientemente ingeniosos para encontrar una buena solución? Los investigadores abordan estas preguntas clasificando los problemas en «clases de complejidad» —todos los problemas fáciles van en una clase, por ejemplo, y todos los problemas fáciles de verificar van en otra— y demostrando teoremas sobre las relaciones entre estas clases.

Lamentablemente, mapear el paisaje de la dificultad computacional ha resultado ser, bueno, difícil. Así que, a mediados de la década de 1970, algunos investigadores comenzaron a estudiar qué pasaría si las reglas de la computación fueran diferentes. Ahí es donde entran los oráculos.

Al igual que las Bolas 8 Mágicas, los oráculos son dispositivos que responden inmediatamente preguntas de sí o no sin revelar nada sobre su funcionamiento interno. A diferencia de las Bolas 8 Mágicas, siempre responden sí o no, y siempre tienen razón: una ventaja de ser ficticios. Además, cualquier oráculo dado solo responderá un tipo específico de pregunta, como «¿Es este número primo?».

¿Qué hace que estos dispositivos ficticios sean útiles para entender el mundo real? En resumen, pueden revelar conexiones ocultas entre diferentes clases de complejidad.

Tomemos las dos clases de complejidad más famosas. Está la clase de problemas que son fáciles de resolver, que los investigadores llaman «P», y la clase de problemas que son fáciles de verificar, que llaman «NP». ¿Son todos los problemas fáciles de verificar también fáciles de resolver? Si así fuera, eso significaría que NP sería igual a P, y toda la encriptación sería fácil de romper (entre otras consecuencias). Los teóricos de la complejidad sospechan que NP no es igual a P, pero no pueden probarlo, aunque llevan más de 50 años intentando precisar la relación entre ambas clases.

Los oráculos les han ayudado a entender mejor con qué están lidiando. Los investigadores han inventado oráculos que responden preguntas que ayudan a resolver muchos problemas diferentes. En un mundo donde cada ordenador tuviera una conexión directa con uno de estos oráculos, todos los problemas fáciles de verificar también serían fáciles de resolver, y P sería igual a NP. Pero otros oráculos menos útiles tienen el efecto opuesto. En un mundo poblado por estos oráculos, P y NP serían demostrablemente diferentes.

Los investigadores han utilizado este conocimiento para obtener una mejor comprensión del problema P contra NP. Los primeros intentos para determinar la relación entre P y NP utilizaron un truco elegante llamado diagonalización, que había sido esencial para otros resultados importantes en la informática. Pero los investigadores pronto se dieron cuenta de que cualquier prueba basada en diagonalización también se aplicaría a cualquier mundo donde cada ordenador pudiera consultar el mismo oráculo. Esto resultó ser un problema, ya que los oráculos cambian la respuesta a la pregunta de P frente a NP. Si los investigadores pudieran usar la diagonalización para probar que P y NP son diferentes en el mundo real, la misma prueba implicaría que P y NP son diferentes en un mundo con oráculos, donde claramente son equivalentes. Esto significa que cualquier solución basada en diagonalización al problema de P contra NP sería autocontradictoria. Los investigadores concluyeron que necesitarían nuevas técnicas para avanzar.

Los oráculos también han sido útiles en el estudio de la computación cuántica. En las décadas de 1980 y 1990, los investigadores descubrieron formas de aprovechar la física cuántica para resolver rápidamente ciertos problemas que parecían difíciles para los ordenadores «clásicos» ordinarios. Pero, ¿estos problemas solo parecen difíciles o realmente lo son? Demostrarlo de una manera u otra requeriría técnicas matemáticas radicalmente nuevas.

Por ello, los investigadores han estudiado cómo los ordenadores cuánticos abordan los problemas que involucran oráculos. Estos esfuerzos pueden proporcionar evidencia indirecta de que los ordenadores cuánticos realmente son más poderosos que los clásicos, y pueden ayudar a los investigadores a explorar tareas cualitativamente nuevas en las que los ordenadores cuánticos podrían destacar. A veces, incluso pueden tener aplicaciones prácticas. En 1994, el matemático aplicado Peter Shor se inspiró en un reciente resultado sobre oráculos para desarrollar un algoritmo cuántico rápido para factorizar números grandes, una tarea cuya aparente dificultad sustenta los sistemas criptográficos que mantienen segura nuestra información en línea. El descubrimiento de Shor dio inicio a una carrera para construir ordenadores cuánticos potentes que continúa hasta el día de hoy.

Es difícil predecir el futuro de la teoría de la complejidad, pero no todas las preguntas sobre la trayectoria del campo son igualmente difíciles de responder. ¿Seguirán los investigadores consultando oráculos? Las señales apuntan a que sí.

El artículo original, Why Computer Scientists Consult Oracles, se publicó el 16 de enero de 2025 en Quanta Magazine.

Traducido por César Tomé López

El artículo Por qué los informáticos consultan oráculos se ha escrito en Cuaderno de Cultura Científica.

Defensa insólita contra virus bacteriófagos: síntesis de un gen nuevo… y tóxico

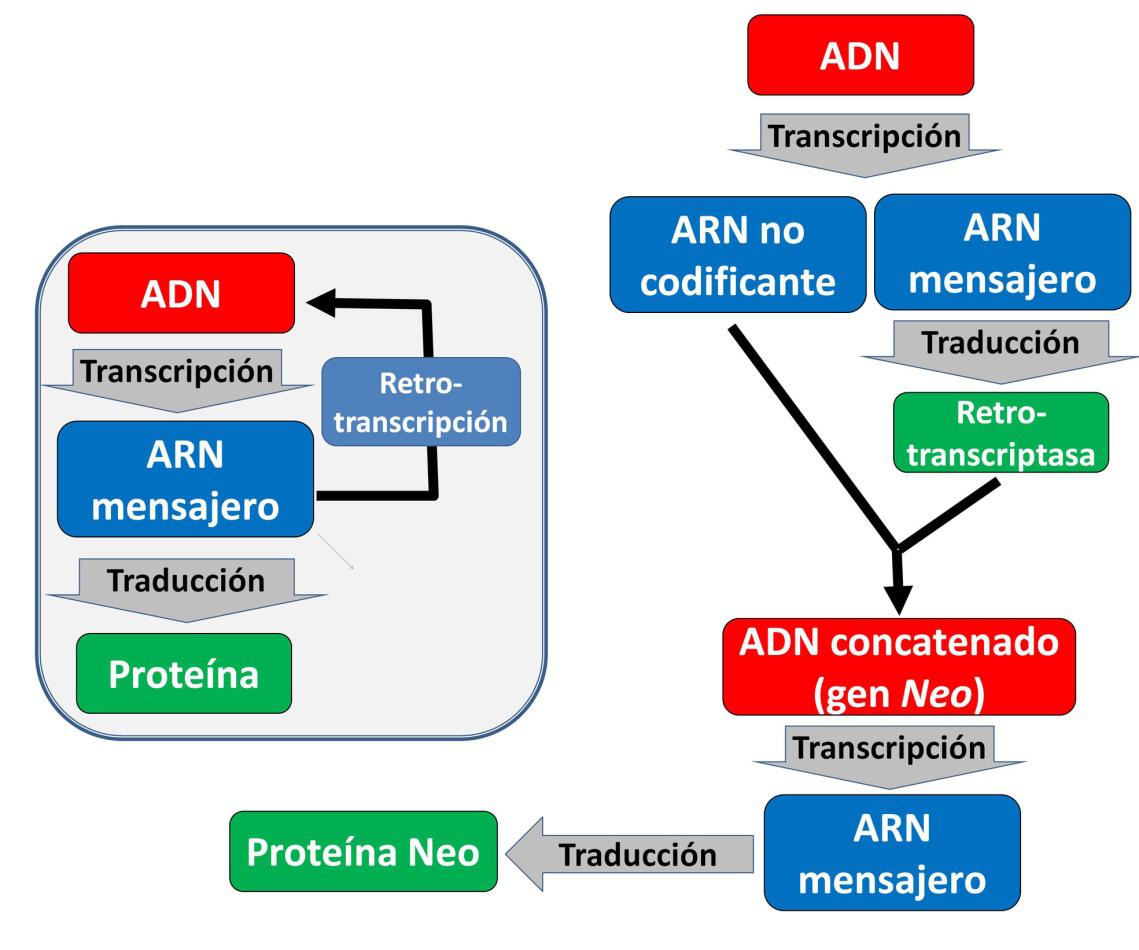

Francis Crick, codescubridor de la doble hélice, definió como “dogma central de la Biología Molecular” el hecho de que la información genética fluya en una sola dirección, del ADN al ARN mensajero y de este último a la secuencia de aminoácidos en la proteína. Este dogma tuvo que ser revisado cuando se descubrieron las retrotranscriptasas o transcriptasas inversas, enzimas capaces de sintetizar ADN a partir de secuencias de ARN (Figura 1). Estas enzimas son producidas por retrovirus como el VIH-1 para insertar su información en el ADN de la célula infectada. También nosotros utilizamos la retrotranscriptasa para amplificar las secuencias de ADN conocidas como retrotransposones y trasladarlas de una parte del genoma a otra. De hecho, más del 40% de nuestro genoma está constituido por retrotransposones.

Figura 1. En el recuadro de la izquierda se muestra el llamado “dogma central de la Biología Molecular”: el flujo de información genética desde el ADN hacia la secuencia de aminoácidos que constituyen las proteínas, pasando por el ARN mensajero. A la derecha se muestra el caso excepcional del sistema DRT2. Un nuevo gen (Neo) es sintetizado a partir de la retrotranscripción repetida múltiples veces de un ARN no codificante. La proteína Neo no está por tanto codificada en el genoma bacteriano

Figura 1. En el recuadro de la izquierda se muestra el llamado “dogma central de la Biología Molecular”: el flujo de información genética desde el ADN hacia la secuencia de aminoácidos que constituyen las proteínas, pasando por el ARN mensajero. A la derecha se muestra el caso excepcional del sistema DRT2. Un nuevo gen (Neo) es sintetizado a partir de la retrotranscripción repetida múltiples veces de un ARN no codificante. La proteína Neo no está por tanto codificada en el genoma bacterianoLas bacterias también utilizan las retrotranscriptasas como medio para defenderse de los virus bacteriófagos, sus grandes enemigos naturales. Esta estrategia defensiva suele activarse cuando han fallado los mecanismos basados en la degradación del material genético vírico. Un ejemplo de estos mecanismos es el conocido sistema CRISPR-Cas, que en la actualidad constituye una tecnología sencilla y eficaz para la edición genética.

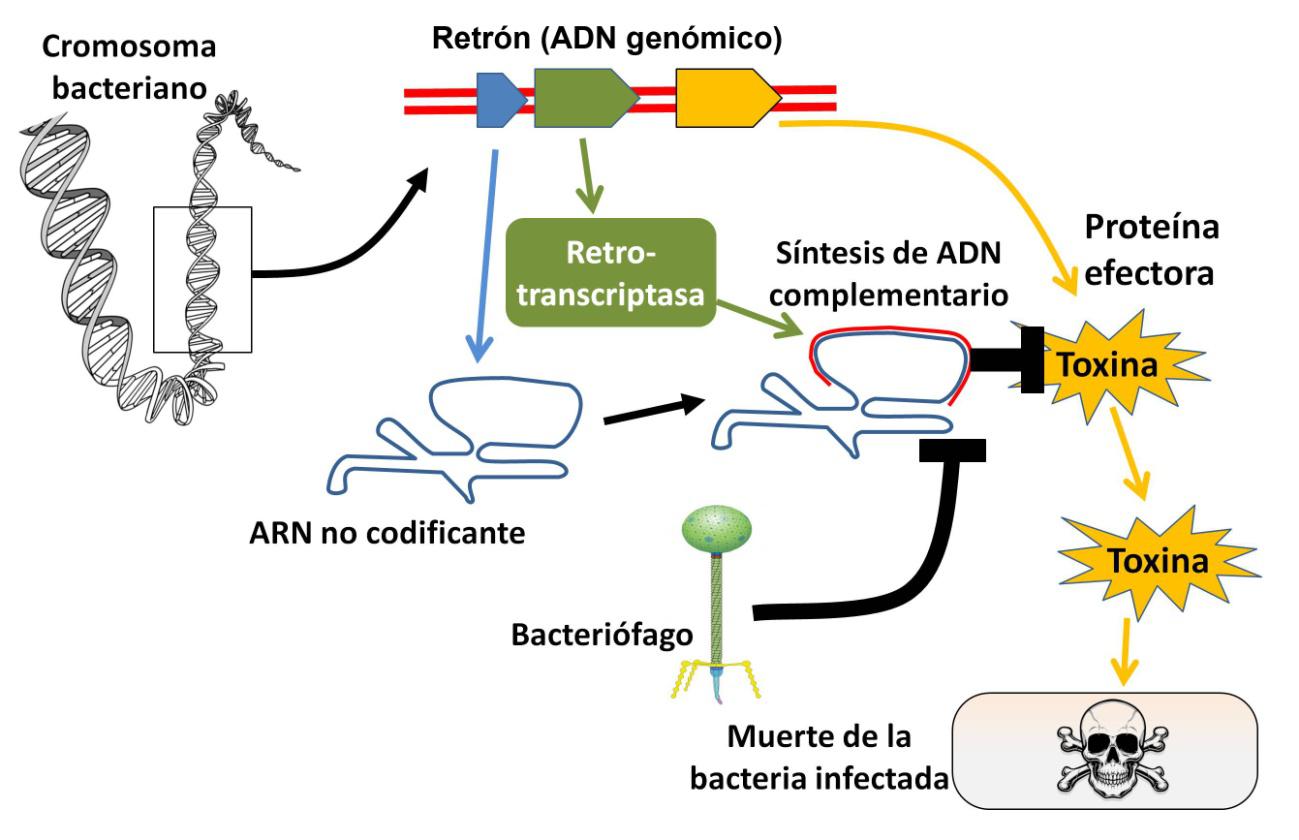

Si la infección vírica desborda esta primera línea de defensa, se activan procesos basados en retrotranscriptasas, descubiertos recientemente y mucho menos conocidos. Algunos de estos mecanismos defensivos se denominan retrones. Los retrones consisten típicamente en secuencias del cromosoma bacteriano que codifican un ARN que no contiene información para formar proteínas (ARN no codificante), una retrotranscriptasa y una proteína efectora, generalmente tóxica. En condiciones normales, la retrotranscriptasa sintetiza una cadena de ADN utilizando parte del ARN no codificante como plantilla. La molécula mixta de ADN y ARN mantiene inactiva la toxina. El sistema se altera en caso de infección vírica imparable, la toxina se activa y la bacteria se suicida (Figura 2).

Figura 2. Sistema defensivo contra bacteriófagos basado en retrones. El ADN se representa en rojo y el ARN en azul. Un ARN no codificante sirve de plantilla para que la retrotranscriptasa sintetice una cadena complementaria de ADN. El conjunto inhibe la actividad de una proteína efectora tóxica. La infección por bacteriófagos altera el sistema y la toxina queda libre, provocando la muerte de la bacteria y evitando la propagación del virus. Imágenes de Freepik, Inksyndromeartwork, y KES47, CC BY 4.0

Figura 2. Sistema defensivo contra bacteriófagos basado en retrones. El ADN se representa en rojo y el ARN en azul. Un ARN no codificante sirve de plantilla para que la retrotranscriptasa sintetice una cadena complementaria de ADN. El conjunto inhibe la actividad de una proteína efectora tóxica. La infección por bacteriófagos altera el sistema y la toxina queda libre, provocando la muerte de la bacteria y evitando la propagación del virus. Imágenes de Freepik, Inksyndromeartwork, y KES47, CC BY 4.0Se podría pensar, ¿qué clase de defensa antivírica implica un suicidio celular? La clave está en que la muerte de la bacteria impide la multiplicación del virus y su transmisión al resto de la población bacteriana. Esta estrategia “kamikaze” se conoce como infección abortiva y beneficia al conjunto de la población a expensas del individuo infectado.

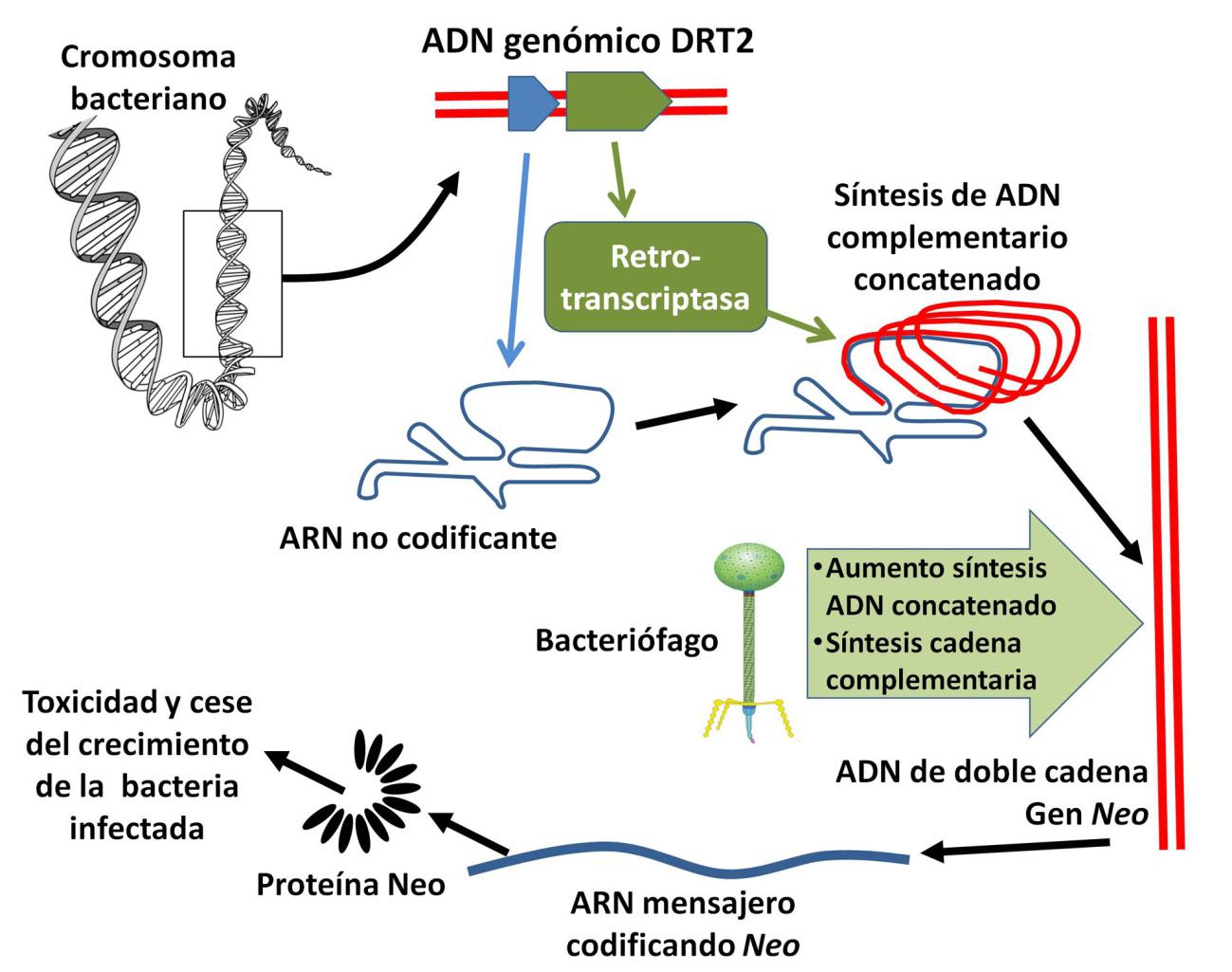

Otras defensas basadas en retrotranscriptasas son las DRTs (defense-associated retrotranscriptases). Una de ellas, la DRT2, constituía hasta ahora un enigma ya que, a diferencia de los retrones, solo está formada por el ADN que genera la secuencia de ARN no codificante y una retrotranscriptasa, sin ninguna proteína efectora. Dos artículos publicados simultáneamente en Science el pasado mes de octubre desvelaron la función de DRT2, y han supuesto una auténtica conmoción en medios científicos. El sistema se basa en algo excepcional: la síntesis de un nuevo gen, ausente en el genoma bacteriano original.

Ambos grupos de investigación, en la Universidad Columbia de Nueva York y en el Instituto Tecnológico de Massachusetts, utilizaron el mismo modelo, la bacteria Klebsiella pneumoniae. Comprobaron que la expresión de DRT2 provocaba la síntesis del ARN no codificante, que se pliega sobre sí mismo, y la retrotranscriptasa (Figura 3). Como sucede con los retrones, esta enzima genera la cadena de ADN complementaria de una parte del ARN. Pero, y aquí viene la sorpresa, cuando termina la síntesis, se produce un “salto” y la enzima vuelve a empezar la síntesis del ADN desde el principio. Este ciclo se repite una y otra vez, generando una cadena sencilla de ADN con múltiples secuencias repetidas, a la que se denominó ADN concatenado.

Figura 3. Sistema defensivo DRT2 contra bacteriófagos. El ADN se representa en rojo y el ARN en azul. En este caso no hay proteína efectora. La síntesis del ADN complementario se repite de manera cíclica creando una larga cadena de ADN concatenado. En caso de infección por bacteriófagos, aumenta exponencialmente la producción de este ADN y se sintetiza la cadena complementaria. El ADN se comporta como un nuevo gen (Neo) que se transcribe a ARN mensajero y se traduce a la proteína Neo. Esta proteína bloquea el crecimiento bacteriano evitando la propagación del virus

Figura 3. Sistema defensivo DRT2 contra bacteriófagos. El ADN se representa en rojo y el ARN en azul. En este caso no hay proteína efectora. La síntesis del ADN complementario se repite de manera cíclica creando una larga cadena de ADN concatenado. En caso de infección por bacteriófagos, aumenta exponencialmente la producción de este ADN y se sintetiza la cadena complementaria. El ADN se comporta como un nuevo gen (Neo) que se transcribe a ARN mensajero y se traduce a la proteína Neo. Esta proteína bloquea el crecimiento bacteriano evitando la propagación del virusEn caso de infección vírica suceden dos cosas (Figura 3). La síntesis de ADN concatenado aumenta miles de veces y, al mismo tiempo, se sintetiza la hebra complementaria, generando un ADN de doble cadena, como el del cromosoma bacteriano. Este ADN se comporta como un nuevo gen, denominado Neo1, que se traduce en una proteína con múltiples repeticiones de una secuencia de 40 aminoácidos. La predicción mediante Alphafold es que la proteína Neo está formada por un gran número de hélices. Esta proteína bloquea el crecimiento y la reproducción de la bacteria, evitando así la proliferación del virus.

Son muchas las incógnitas que permanecen, por ejemplo, qué tamaño puede alcanzar Neo, ya que la longitud de su gen no parece tener límites. Tampoco se sabe cómo Neo bloquea el crecimiento bacteriano. Lo que sí parece probable, según la comparación de secuencias que se ha hecho, es que este mecanismo esté presente en muchas otras bacterias.

Lo que resulta realmente llamativo de estos resultados es que a partir de un ARN no codificante se sintetice una secuencia de ADN que actúa como un gen extracromosómico que genera una proteína no codificada por el genoma bacteriano. Estamos, por tanto, ante un caso hasta ahora impensable de flujo de información genética entre el ADN y el ARN (Figura 1).

Referencias:

Tang, S., Conte, V., Zhang, D.J., et al. (2024). De novo gene synthesis by an antiviral reverse transcriptase. Science. Https://doi: 10.1126/science.adq0876.

Wilkinson, M.E., Li, D., Gao, A.F., et al. (2024). Phage-triggered reverse transcription assembles a toxic repetitive gene from a noncoding RNA. Science. Https://doi: 10.1126/science.adq3977.

Sobre el autor: Ramón Muñoz-Chápuli Oriol es Catedrático de Biología Animal (jubilado) de la Universidad de Málaga

Nota

1 Por never ending open reading frame, marco abierto de lectura sin fin. Un marco abierto de lectura es una secuencia de ADN con una señal de inicio de la traducción a proteína y una señal de terminación. El “sin fin” se debe a que, en este caso, la secuencia no tiene señales de terminación

El artículo Defensa insólita contra virus bacteriófagos: síntesis de un gen nuevo… y tóxico se ha escrito en Cuaderno de Cultura Científica.

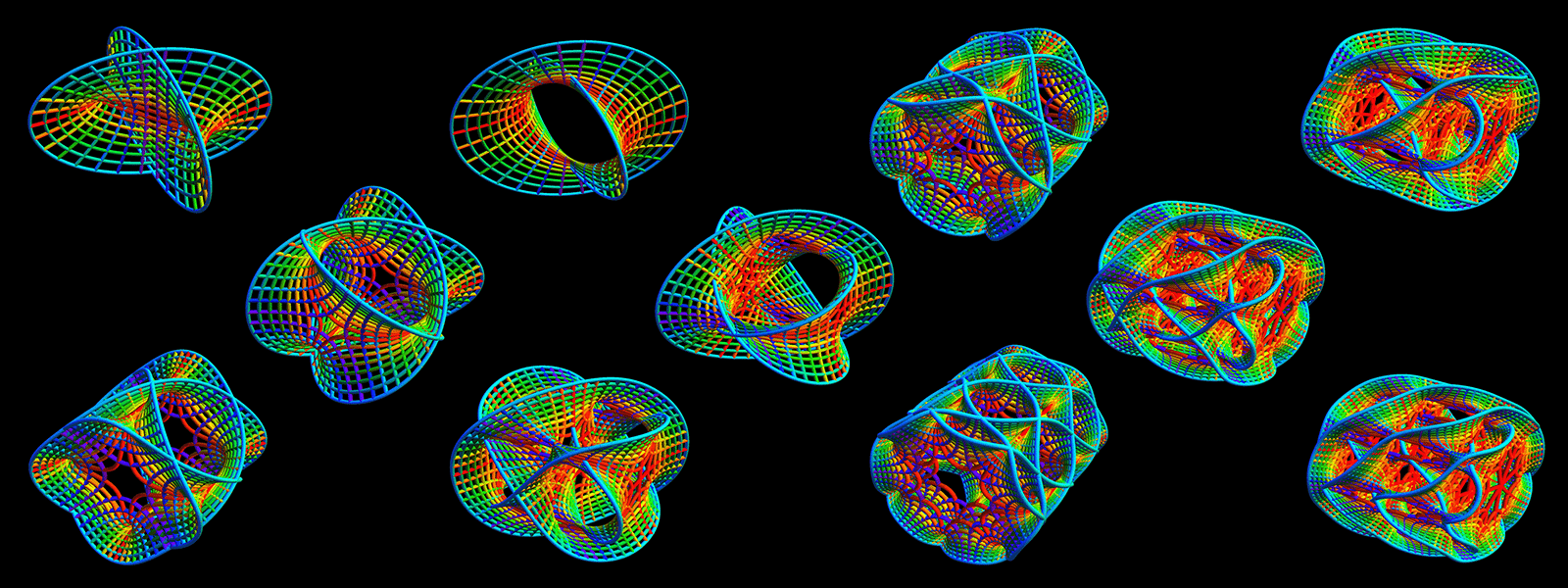

La teoría de cuerdas no ha muerto

Los físicos teóricos siguen buscando las matemáticas que puedan explicar las partículas y fuerzas del universo.

La teoría de cuerdas es una descripción matemática de la naturaleza que requiere que el espacio posea varias dimensiones adicionales más allá de las tres ordinarias. Estas dimensiones adicionales, demasiado pequeñas para percibirlas en la vida cotidiana, pueden adoptar muchas formas o geometrías posibles (representadas artísticamente aquí) que pueden influir en las propiedades del universo y de las partículas subatómicas. Ilustración: O. Knill & E. Slavkosky.