Maia García-Vergniory – P4K 2019: Materiales del futuro

Las grandes transformaciones sociales y los cambios de paradigma registrados a lo largo de la historia de la humanidad suelen ir aparejados al descubrimiento de un nuevo material, cuyas novedosas aplicaciones acaban desencadenando una gran revolución. La sociedad del futuro, más respetuosa con el medio ambiente e hiperconectada requiere de nuevos materiales. Maia García-Vergniory nos explica en esta charla en qué materiales se está investigando actualmente y por qué en ellos y no en otros.

Maia García Vergniory es profesora de la UPV/EHU, investigadora Ikerbasque en el Donostia International Physics Center y coautora de la llamada química cuántica topológica, uno de los hitos en ciencia de materiales de los últimos años.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Maia García-Vergniory – P4K 2019: Materiales del futuro se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Maia García Vergniory: «Materiales que nos cambiaron»

- Aran Garcia-Leuke – Naukas Pro 2019: Intro a la nanoelectrónica

- Juan Manuel Bermúdez-García – Naukas Pro 2019: Sólidos como refrigerantes

Invernaderos en las cubiertas para aumentar la eficiencia energética de los edificios

Todas las características de un edificio influyen de forma directa en el consumo energético y en la eficiencia energética global del edificio. Normalmente, se tiende a asociar este concepto solo con los equipos de climatización y con los materiales constructivos, pero el sistema de ventilación juega un papel primordial en la eficiencia energética.

“La necesidad de ventilación para expulsar el aire contaminado o viciado en los edificios de viviendas provoca que gran parte de las pérdidas de energía térmica se deba a la renovación de aire. Estas pérdidas por ventilación cada vez adquieren mayor importancia debido a que los edificios cada vez están mejor aislados y son más herméticos. Por tanto, siendo el objetivo a corto plazo construir edificios de consumo energético casi nulo, es necesario incidir sobre la optimización de la ventilación”, comenta Joseba Gainza-Barrencua miembro del grupo CAVIAR (Calidad de Vida en Arquitectura) de la UPV/EHU.

Según ha explicado Gainza, “la instalación de los invernaderos en la cubiertas para reducir el consumo energético de los edificios no ha sido estudiada en profundidad, a pesar de que cuentan con importantes ventajas: su instalación en la cubierta permite realizar el acristalamiento con el ángulo que se desee, lo que posibilita que las ganancias solares sean mayores; menos exigencias estéticas y urbanísticas; posibilidad de introducir el aire precalentado en el edificio mediante el sistema de ventilación mecánica del edificio, etc.”.

Por ello, en este trabajo “hemos diseñado y construido un prototipo de invernadero y hemos visto su funcionamiento los días soleados, nublados etc. Su comportamiento también ha sido analizado mediante simulación informática que ha sido validada utilizando las mediciones que hemos realizado en el prototipo. Hemos utilizado la simulación para analizar el comportamiento térmico del invernadero y calcular el ahorro energético en el caso de instalarlo en distintos lugares y climas”, señala el investigador de la UPV/EHU.

“El invernadero diseñado tiene forma de triángulo rectángulo; por un lado, es fundamental orientarlo al sur porque es donde más radiación solar recibe, y por otro lado, es importante que el acristalamiento esté lo más perpendicular posible al sol. La posición e inclinación del sol varía a lo largo del año, por lo tanto, hemos obtenido cuál es el ángulo óptimo y hemos visto que el ángulo con el que se obtienen temperaturas más altas en el invernadero en la mayor parte del estado español es de 55 grados”, indica el autor principal del trabajo.

“Nuestros resultados indican que los invernaderos pueden mejorar significativamente el comportamiento energético del edificio. La eficacia de estos sistemas depende claramente del clima. Mientras que en zonas con poca necesidad de calefacción el uso del invernadero no es aconsejable, en zonas más frías el ahorro energético es sustancial, más aún si se combina el sistema de ventilación con la recuperación de calor. En la zona climática más fría de España, en la zona de Burgos, es posible alcanzar ahorros en calefacción del 58 %”, comenta Joseba Gainza-Barrencua.

“Además, — añade — existe la posibilidad de acoplar un recuperador de calor entre la expulsión del aire viciado del edificio y el aire a introducir en el invernadero. Con ello se obtiene un doble calentamiento del aire y mejora el rendimiento del sistema significativamente”.

“El personal investigador cree que este trabajo presenta una visión útil de los beneficios potenciales de los invernaderos, en particular, cuando se combinan con un sistema de ventilación. En estos casos, el aire precalentado se distribuye fácilmente por todo el edificio, lo que mejora el potencial de ahorro energético”. “Para nosotros —añade Joseba Gainza-Barrencua— ésta es una de las contribuciones más importantes del trabajo, ya que las ventajas de utilizar invernaderos con sistemas de ventilación merecen una mayor investigación. Ahora, estamos analizando el uso de estos invernaderos para otros usos o como complementos de otros sistemas”.

Referencia:

J. Gainza-Barrencua, M. Odriozola-Maritorena, Rufino Hernandez_Minguillon, I. Gomez-Arriaran (2021) Energy savings using sunspaces to preheat ventilation intake air: Experimental and simulation study Journal of Building Engineering doi: 10.1016/j.jobe.2021.102343

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Invernaderos en las cubiertas para aumentar la eficiencia energética de los edificios se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Un modelo para evaluar los flujos de inversión en eficiencia energética

- Las barreras a los edificios de consumo de energía casi nulo en el sur de Europa

- Los edificios y el mar

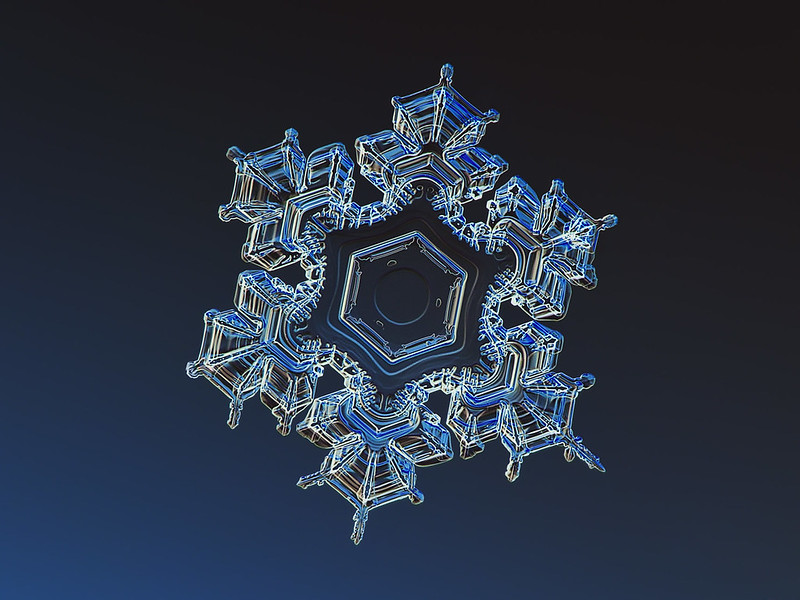

El copo asimétrico no sale en la foto

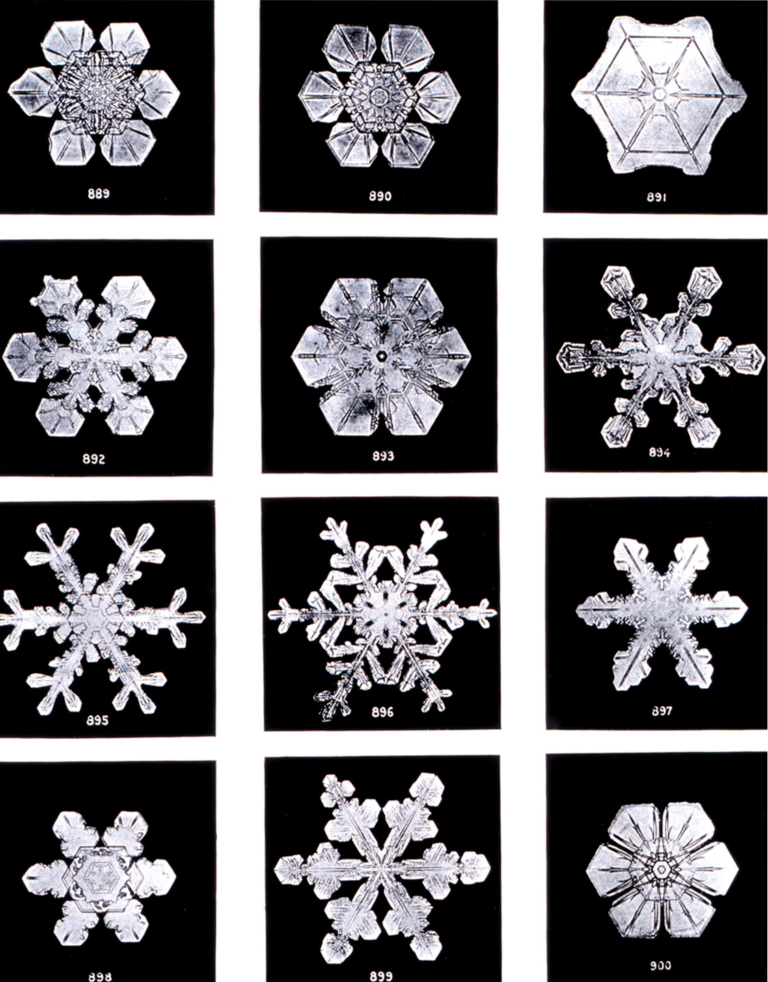

Fotografías de Bentley, circa 1902. Fuente: Wikimedia Commons

Fotografías de Bentley, circa 1902. Fuente: Wikimedia CommonsEn enero de 1885, a la edad de 19 años, Wilson Bentley se convirtió en la primera persona en fotografiar un copo de nieve. Desde adolescente había explorado estos cristales con ayuda de un microscopio que le había regalado su madre y cada año esperaba a que el invierno cubriese de estrellas de hielo la granja donde se había criado. Hasta que un buen día decidió hacer imperecedero su objeto de fascinación y acopló una cámara fotográfica a sus lentes de ampliación. Años más tarde escribiría1:

“Bajo el microscopio, descubrí que los copos de nieve eran milagros de belleza y parecía una lástima que esta belleza no pudiese ser disfrutada por otros. Cada cristal era una obra maestra de diseño y ninguno se repetía. Cuando un copo se derretía, ese diseño se perdía para siempre. Toda su belleza desaparecía sin dejar rastro».

Durante los siguientes 45 inviernos (y hasta su muerte a causa de una neumonía, en 1931), Bentley se dedicó a capturar estos diseños efímeros en placas fotográficas. Con el tiempo depuró una técnica que le permitía recoger los copos en una bandeja cubierta de terciopelo y trasladarlos a un portaobjetos con ayuda de una pluma. Todo su equipo tenía que estar preenfriado y Bentley debía contener su respiración para evitar arruinar sus miniaturas de nieve. Con infinito cuidado y algo más de paciencia, este fotógrafo autodidacta consiguió retratar más de 5000 cristales a lo largo de toda su vida. La idea popular de que “no hay dos copos de nieve iguales” tiene su origen, con toda probabilidad, en su trabajo.

¿Pero es este mito cierto? O en cualquier caso, ¿de dónde proviene su enorme diversidad?

Hasta ahora hemos contado que las moléculas del agua dan lugar a la simetría hexagonal de los copos de nieve. Sin embargo, este relato deja fuera su elaborada complejidad. La explicación completa es algo más sutil y tiene que ver con el modo en que crecen estos cristales. Aunque el empaquetamiento de las moléculas favorece la simetría en seis direcciones, los lados largos de un hexágono no son la solución más estable desde un punto de vista energético2. Al alcanzar cierto tamaño crítico, aparecen pequeñas rupturas en sus laterales que, a su vez, pueden desdoblarse, dando lugar a la ramificación característica de estos cristales. En conjunto, este proceso se conoce como crecimiento dendrítico (del griego δενδρον, dendron, árbol) y es el que da a algunos cristales un sorprendente aspecto vegetal.

Dendritas de manganeso en un plano de piedra caliza. Fuente: Wikimedia Commons

Dendritas de manganeso en un plano de piedra caliza. Fuente: Wikimedia Commons

La cuestión es que ese delicado punto de inflexión a partir del cual un hexágono de hielo perfecto empieza a romperse, doblarse y ramificarse depende críticamente de la temperatura y, muy especialmente, de la humedad del ambiente donde crece. Cuanta más humedad, más rápido crece y se desdobla. Puesto que el copo es diminuto, estas condiciones son casi* idénticas en sus seis brazos y su simetría se conserva a medida que crece. Pero en su viaje por el cielo, guiados por los arrebatos del viento, cada copo experimenta una trayectoria diferente (un historial de humedades y condiciones diferente), que podría considerarse casi* irrepetible. Por eso todos son tan diferentes entre sí. La forma precisa de un copo de nieve es su currículum vitae, la versión cristalográfica de las arrugas y las cicatrices, que dan carácter a su rostro a medida que crece.

Pero, antes de cerrar este artículo, volvamos a los casi*.

Hace algunos años, el profesor Kenneth G. Libbrecht consiguió producir copos de nieve idénticos. Los gemelos crecieron en la universidad de Caltech, bajo el sol de California, gracias a un ambiente de laboratorio cuidadosamente orquestado. Puesto que las condiciones de crecimiento eran idénticas, sus cristales terminaron siendo indistinguibles. Pero resultaron ser únicos además en otro sentido, quizás aún más insospechado: se trataba, probablemente, de los copos de nieve más perfectamente simétricos que la humanidad había visto jamás.

A pesar de lo que pueda parecer a primera vista, los copos de nieve de la naturaleza rara vez son exactamente iguales a lo largo de sus seis brazos. La mayoría tienen imperfecciones debidas a las pequeñas diferencias del ambiente donde crecieron, o a roturas ocasionadas por su viaje. Si uno mira con atención las fotografías de Bentley, puede observar pequeñas diferencias entre los lados opuestos de cada copo. Nuestro ojo tiende a omitirlas, cegado por su amor a simetría y a los patrones que le permiten interpretar el mundo. Es probable, incluso, que este mismo filtrado se dé en un paso previo: el propio fotógrafo y aquellos que divulgan su trabajo tenderán a compartir, de manera preferente, las imágenes más simétricas.

Fuera del laboratorio, no hay dos copos de nieve iguales, ni tampoco perfectos. Pero el origen de esas irregularidades es, probablemente, lo más bonito de su diseño.

Referencias:

1Wilson Bentley, 1925. Citado por Heidorn, Keith C. “The Snowflake Man of Vermont.” The Public Domain Review, 14 de febrero de 2011, https://publicdomainreview.org/essay/the-snowflake-man-of-vermont. Consultado el 24 de mayo de 2021.

2Stewart, Ian, and Javier García Sanz. El segundo secreto de la vida, cap.1. Crítica, 1999.

Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica

El artículo El copo asimétrico no sale en la foto se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Kepler y la simetría de los copos de nieve

- Del anumerismo también se sale

- Una foto de familia por fin completa

Siempre Alicia

– Entonces di lo que piensas –prosiguió la Liebre–.

– Eso es lo que hago –dijo Alicia precipitadamente– o al menos… al menos pienso lo que digo… Viene a ser lo mismo, ¿no?

– ¿Lo mismo? ¡De ninguna manera! –dijo el Sombrerero–. ¡En tal caso, sería lo mismo decir «veo lo que como» que «como lo que veo»!

– ¡Y sería lo mismo decir –añadió la Liebre– «me gusta lo que tengo» que «tengo lo que me gusta»!

– ¡Y sería lo mismo decir –añadió el Lirón, que parecía hablar en medio de sus sueños–«respiro cuando duermo» que «duermo cuando respiro»!

– Es lo mismo en tu caso –dijo el Sombrerero.

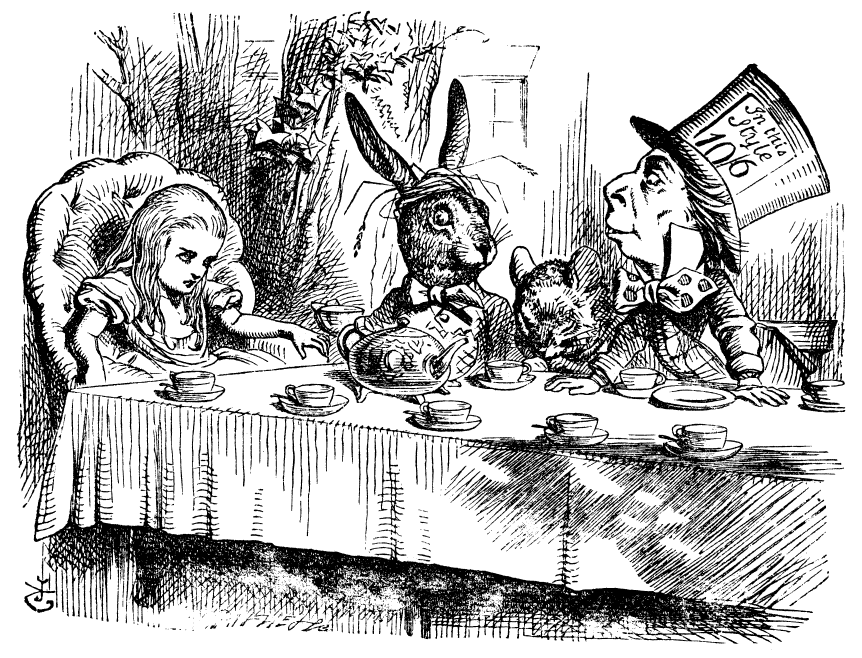

Lewis Carroll, Alicia en el país de las maravillas, Una merienda de locos

Una merienda de locos. Ilustración de John Tenniel. Fuente: Wikimedia Commons

Una merienda de locos. Ilustración de John Tenniel. Fuente: Wikimedia Commons

El 24 de mayo de 1865, la editorial Macmillan and Co. publicó dos mil ejemplares de Las aventuras de Alicia en el país de las maravillas, la novela nonsense escrita por Lewis Carroll (1832-1898) e ilustrada por John Tenniel (1820-1914). El extracto que abre este escrito es una de las “sorprendentes” referencias a la lógica –o a la falta de ella– muy presente en el libro.

La segunda parte de la novela –A través del espejo y lo que Alicia encontró allí–fue publicada seis años más tarde. En el extracto de debajo la Reina Blanca y la Reina Roja interrogan a Alicia intentando averiguar sus capacidades de cálculo:

La Reina Roja rompió el silencio diciéndole a la Reina Blanca: “Te invito al banquete que va a dar Alicia esta tarde.”

La Reina Blanca sonrió débilmente, y dijo: “Y yo a ti.”

– No sabía que fuera a dar un banquete –dijo Alicia–; pero si es así, creo que soy yo quien debería invitar.

– Te hemos dado la oportunidad de hacerlo –comentó la Reina Roja–; pero quizá no te han dado todavía bastantes clases de modales, ¿verdad?

– No se dan clases de modales –dijo Alicia–. Las clases son para enseñar a sumar y cosas por el estilo.

–¿Sabes la Adición? –preguntó la Reina Blanca–. ¿Cuántos hacen uno más uno más uno más uno más uno más uno más uno más uno más uno más uno?

– No lo sé –dijo Alicia–. He perdido la cuenta.

– No sabe la Adición –terció la Reina Roja–. ¿Sabes la Sustracción? Resta nueve de ocho.

– No se puede restar nueve de ocho –replicó Alicia con presteza–: pero,…

–Tampoco sabe la Sustracción –dijo la Reina Blanca–. ¿Sabes la División? A ver, divide un pan con un cuchillo…, ¿qué resultado te dará?

– Creo… –empezó Alicia, pero la Reina Blanca contestó por ella–: “Pan-con-mantequilla, naturalmente. Prueba a calcular otra sustracción. Quítale el hueso a un perro; ¿qué os queda?

Alicia reflexionó: “El hueso no quedaría, naturalmente, si se lo quito…, y el perro tampoco, porque echaría a correr detrás de mí para morderme…, ¡y desde luego, yo tampoco!”.

– Entonces, ¿crees que no quedaría nada? –dijo la Reina Roja.

– Creo que ése sería el resultado.

– Mal, como siempre –dijo la Reina Roja–: quedarían los estribos del perro.

– Pero no veo cómo…

– ¡Pues escucha! –gritó la Reina Roja–: el perro perdería los estribos, ¿no es así?

– Seguramente –contestó Alicia con cautela.

– ¡Así que si se fuera el perro, se quedarían los estribos! –exclamó triunfal la Reina.

Alicia dijo lo más gravemente que pudo: “Puede que se fueran en otra dirección”–. Pero no pudo por menos de pensar: ¡Cuántas tonterías estamos diciendo!

–¡No sabe ni jota de operaciones! –dijeron las Reinas a la vez, con mucho énfasis.

– ¿Sabéis vos hacer operaciones? –dijo Alicia, volviéndose de repente hacia la Reina Blanca, ya que no le gustaba que la criticasen tanto.

La Reina abrió la boca y cerró los ojos: “Sé la Adición –dijo–, si me das el tiempo… ¡pero no haré una sustracción bajo ningún concepto!”.

A través del espejo (Akal, 2003)

Parece que a la Reina Blanca le pasaba lo mismo que a la alumna de La lección de Eugène Ionesco (1909-1994); a ella también se le “atascaban” las sustracciones…

La historia de Alicia ha sido adaptada al cine y al teatro, versionada de originales maneras, anotada por Martin Gardner (1914-2010), ilustrada por numerosos artistas –muchos de ellos consagrados, como Peter Newell (1862-1924), Arthur Rackham (1867-1939) o Salvador Dalí (1904-1989)– o traducida a diferentes lenguas –incluso existe una versión escrita con un especial alfabeto inventado por el propio Carroll)–.

Entre las muchas versiones de esta novela, mi favorita es Alicia volátil (Cangrejo Pistolero Ediciones, 2010) de Sofía Rhei. En este poemario, Alice Riddell –la niña a la que Carroll dedicó su novela– es ya una mujer y Charles Lutwidge Dodgson –el nombre real de Lewis Carroll– un hombre mayor. Intercambian una serie de cartas en las que recuerdan el pasado y Dodgson desliza la última de ellas por detrás del azogue de un espejo en vez de enviarla. Provoca de este modo la fusión de Alicia-niña, Alicia-adolescente y Alicia-adulta. Todas entran en el país de las maravillas, saltando de una edad a otra y revelando sus vivencias más íntimas:

En la contraportada del libro, bajo el título de “poesía en tres dimensiones”, se incluyen las instrucciones de uso del poemario: 1: Abra el libro. Recorte y póngase las gafas. 2: Cierre uno de sus ojos. Lea un poema. 3: Cierre el ojo contrario. Vuelva a leer el mismo poema. 4: Abra los dos ojos. Lea el poema en su tercera dimensión.

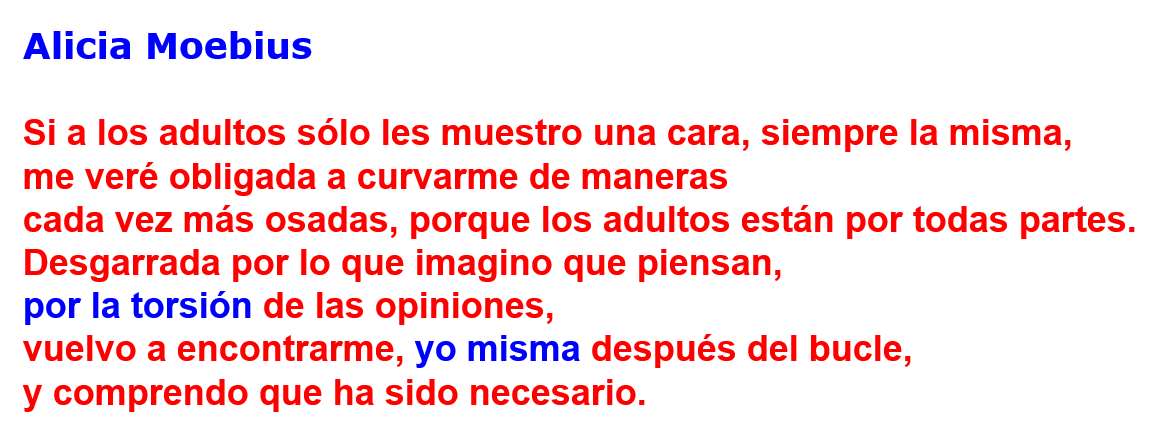

Las gafas a las que se alude son unas gafas anaglifas que permiten realizar tres lecturas de cada poema, escrito en rojo y azul –solo la parte en rojo, solo la escrita en azul o el poema completo en 3D–. De las sesenta y cuatro “Alicias” que aparecen en Alicia volátil me parece especialmente inspiradora una que tiene mucho que ver con la banda de Möbius:

Alicia Moebius, en Alicia Volátil de Sofía Rhei

Alicia Moebius, en Alicia Volátil de Sofía Rhei

Referencias

-

Lewis Carroll, Alicia (edición anotada por Martin Gardner), Ediciones Akal, 2017

-

Lewis Carroll, Alice’s adventures in Wonderland (ilustrated by Peter Newell), Harper and Brothers, 1901

-

Lewis Carroll, Alice’s adventures in Wonderland (ilustrated by Arthur Rackham), William Heinemann, 1907

-

Capi Corrales Rodrigáñez, Las aventuras de Alicia en el País de las Maravillas, por Lewis Carroll, Mujeres con ciencia, Ciencia y más, 1 octubre 2016

-

Alan Tannenbaum (ee), Alice’s Adventures in Wonderland: An edition printed in the Nyctographic Square Alphabet devised by Lewis Carroll, Lewis Carroll Society of North America, 2005

-

Marta Macho Stadler, ‘Alicia volátil’, poesía en tres dimensiones, SINC, 7 septiembre 2012

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad

El artículo Siempre Alicia se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Un cifrado por sustitución: la ‘nictografía’

- Las emocionantes aventuras de Lovelace y Babbage

- «Mitchell y la energía en biología» por Alicia Alonso

Actúa localmente: midiendo el impacto ambiental de la siderurgia

Fuente: Arania, S.A.

Fuente: Arania, S.A.Si uno abre cualquier día un periódico económico y ojea la sección dedicada a inversiones habrá unas siglas que aparecerán con seguridad una o más veces: ESG. ESG son las siglas en inglés que corresponden a medio ambiente, impacto social y buen gobierno, y se refiere a una metodología que clasifica a las empresas en estos tres aspectos, de tal forma que un inversor de cualquier punto del planeta pueda elegir invertir en empresas que tengan el mínimo impacto medioambiental, sean igualitarias, justas y seguras para las personas que trabajan y se relacionan con ellas, y tengan establecidos y cumplan los más altos estándares de control y transparencia en su gestión.

En el mundo de empresarial de los países desarrollados se tiene claro que el futuro será ESG o no será. Muchos inversores se han convertido en activistas y, o bien promueven en aquellas empresas en las que invierten que se mejore la clasificación ESG, o directamente no invierten en empresas de ESG bajo, o ambas cosas.

Esta es una de las fuerzas impulsoras, otras serían la propia conciencia medioambiental y la reducción de costes que suponen ciclos productivos más eficientes, tras las medidas que las empresas más innovadoras están llevando a cabo para reducir su impacto sobre el entorno.

Una de las cuestiones que se plantean inmediatamente es medir. Ya sabemos que solo el que mide, sabe; el que no especula. Pero, ¿cómo medir el impacto global que tiene una actividad? No es tarea fácil, ni mucho menos. Tanto es así, que poder diseñar un sistema de medida ya es un logro científico en sí mismo. Aquí es donde entra el concepto de huella ambiental del producto.

La Huella Ambiental de Producto (HAP) de la Unión Europea es una metodología para calcular el impacto medioambiental total de los productos que salen de nuestras fábricas. Su objetivo es permitir el suministro de información fidedigna y comparable sobre los productos, promoviendo un mercado más sostenible. Los trabajos sobre la norma se remontan a 2011, momento en que se analizaron las metodologías existentes

La HAP sirve para comparar en base a varios criterios el impacto ambiental de un bien, producto industrial o servicio a lo largo de su ciclo de vida. El objetivo general es establecer líneas de actuación, para reducir su impacto ambiental teniendo en cuenta las actividades de la cadena de suministro (de la extracción de las materias primas a la gestión de los residuos finales, pasando por la producción y el uso).

Toda huella ambiental de producto se basa en unas Reglas de Categoría de Huella Ambiental de Producto (PEFCR por sus siglas en inglés): una guía técnica detallada sobre cómo realizar un estudio de este tipo en una categoría de producto concreta. Las PEFCR complementan la orientación metodológica general de la huella ambiental, proporcionando más especificaciones a nivel de producto, asegurando la reproducibilidad y coherencia de estos estudios.

La teoría está muy bien, pero cuando esto se intenta llevar a un producto tan intensivo en materiales con alto impacto en el territorio y energía como es el acero la cosa se complica y no poco. Esto es algo que sobrepasa la actuación de una sola empresa. Así, por ejemplo, es Siderex, el clúster de siderurgia del País Vasco, el que lidera HAMBEMET, un proyecto a gran escala para adecuar esa metodología ya existente para el cálculo de la HAP (y basada en la guía de la Unión Europea) a los productos hiperespecializados de empresas históricas como Arania.

Pero la HAP sola no basta. Ha de complementarse con la estimación de la huella de carbono de la actividad de la empresa en su conjunto para poder tener una idea del impacto ambiental general. Esa medición adicional se logra, por ejemplo, mediante la gestión de GdO (Garantías de Origen renovable).

¿Cómo saber el origen de la energía que se consume? Para descubrirlo se creó un convenio internacional, un acuerdo capaz de acreditar el factor ambiental en un año: las Garantías de Origen y el Etiquetado de Electricidad. Las garantías de origen renovable (GdO) son una certificación que atestigua la producción de una determinada cantidad de suministro eléctrico mediante energías renovables o de cogeneración.

Gracias a una GdO, una empresa puede proporcionar información detallada a sus clientes sobre el origen de la energía que recibe y el impacto en el entorno que supone su producción. El origen renovable se refiere a la electricidad procedente de las fuentes no fósiles: energía eólica, solar, aerotérmica, geotérmica, hidrotérmica, hidroeléctrica, biomasa…

Este es el tipo de cosas de las que se encargan los directivos de alto nivel de las empresas que pretendan seguir siendo competitivas en el futuro.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Actúa localmente: midiendo el impacto ambiental de la siderurgia se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Actúa localmente: blockchain para la cadena de suministros

- Actúa localmente: el dron espía del cambio climático

- Actúa localmente: tranvías eléctricos sin catenaria

El letargo diario de los planigalos

Ilustración: María Lezana

Ilustración: María LezanaAunque lo parecen, no son ratones. Por su aspecto, están a medio camino entre los ratones y las musarañas. Sin embargo, no tienen nada que ver ni con unos ni con otros; es más, están muy alejados. Son mamíferos marsupiales.

Son planigalos, miembros del orden Dasyuriomorphia, el mismo al que pertenece el archiconocido demonio de Tasmania, aunque éste es más grande, bastante más grande en realidad. Los ratones marsupiales son muy pequeños; son, quizás, los marsupiales más pequeños que hay. Y todos pertenecen al género Planigale, del que no se conocen más de cinco especies.

Una de ellas es Planigale gilesi, o planigalo de Giles. Como las otras especies del género, es de tamaño muy pequeño, de entre 6 y 15 g de masa corporal. Suelen encontrarse en el interior de las grietas largas (>1 m) y estrechas que surgen en los suelos arcillosos característicos de las llanuras de aluvión de los desiertos del centro de Australia. Salvo que haya inundación, se trata de lugares muy secos, pues pueden pasar meses sin que llueva. La mayor parte del tiempo la pasan dentro de las grietas, y salen de noche en busca de alimento. Son carnívoros, muy activos cuando cazan, y muy voraces.

Las especies del género Planigale despertaron el interés de los biólogos, porque pensaron que para poder vivir en esos desiertos habían de tener alguna característica especial. Pero al investigar su biología se llevaron una sorpresa con lo que encontraron o, mejor dicho, con lo que no encontraron, pues no hallaron ningún rasgo fisiológico que pudiera considerarse excepcional. La clave de su supervivencia en entornos tan secos se encuentra, al parecer, en el “letargo diario”. Se le da ese nombre a un estado caracterizado por una caída de la temperatura corporal por debajo de los 32 ºC, de duración inferior a las 24 h.

Dados su minúsculo tamaño y el hecho de que puedan desarrollar una actividad muy intensa, sus requerimientos energéticos son muy altos. Además, en las zonas que habitan hay muy poca fauna, por lo que no disponen de muchas presas a las que dar caza para comer. Por otro lado, pueden perder mucha agua a través de las vías respiratorias, y aunque pueda resultar paradójico, pierden más agua cuando baja la temperatura ambiental. Eso ocurre porque al bajar la temperatura exterior elevan su metabolismo, de manera que, gracias al calor que se genera así, contrarrestan la mayor pérdida térmica que ocurre a temperaturas bajas. Pero para elevar el metabolismo han de consumir más oxígeno y eso exige que aumente la frecuencia respiratoria. Como el agua se pierde por evaporación desde las paredes de las vías respiratorias, al aumentar la ventilación pulmonar para obtener más oxígeno, también se renueva más rápidamente el aire en contacto con los epitelios y ese aire arrastra más vapor de agua, lo que hace que el agua que recubre esos epitelios se evapore con más facilidad.

Por todo ello, mantener un alto grado de actividad de forma permanente resulta muy costoso, tanto en lo relativo al balance energético, como al balance hídrico. Sobreviven bajo esas condiciones gracias a una batería de tres elementos, dos de índole fisiológica y etológico el tercero.

Por un lado, no mantienen del todo constante la temperatura corporal cuando varía la temperatura ambiental. Por ejemplo, si la ambiental llega a valores tan bajos como 10 ºC, la corporal se reduce a 32’4 ºC, aunque, de no mediar ajuste especial alguno, se habría mantenido en 34’4 ºC, que es la temperatura normal de estos animales. De ese modo reducen el gasto energético en un 9% y, además, ahorran agua.

Por otro lado, recurren al letargo diario. Gracias a esa modalidad de letargo metabólico, ahorran mucha agua y mucha energía. Por poner un ejemplo, para una temperatura ambiental de 20 ºC, el letargo diario les permite reducir la tasa metabólica en un 79%, y la pérdida de agua en un 62%.

Por último, su comportamiento también resulta clave: buscan microclimas adecuados y, al igual que hacen los animales ectotermos, se ponen al sol cuando tienen ocasión. Al calentarse de ese modo evitan gastar la energía que requeriría la generación endógena de calor.

En resumen, estos pequeños mamíferos han desarrollado mecanismos específicos gracias a los cuales sobreviven y medran en entornos en los que escasea el agua y el alimento. Este es un caso especial, porque las condiciones ambientales son muy exigentes. El que sean marsupiales facilita las cosas; seguramente ayuda el tener una temperatura corporal inferior a la de los mamíferos placentarios, pero, sobre todo, el elemento clave que facilita la supervivencia de los planígalos en condiciones ambientales tan extremas es el letargo diario. Sin ese ahorro de agua y energía, no podrían hacer frente con éxito a condiciones tan severas.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo El letargo diario de los planigalos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El letargo del ratón

- Economía del agua en animales terrestres

- Relaciones hídricas y salinas de los animales

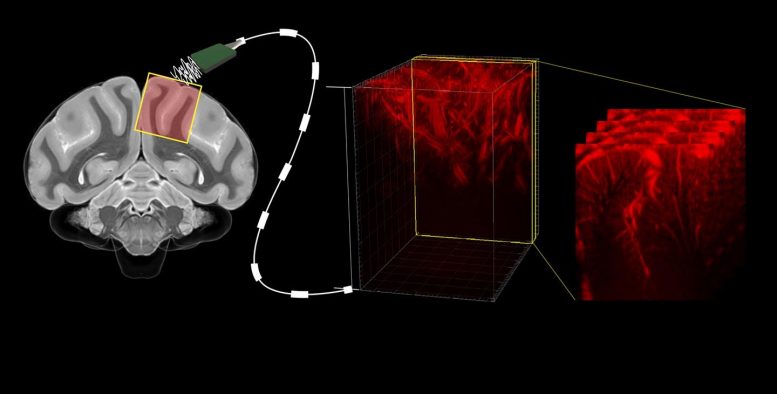

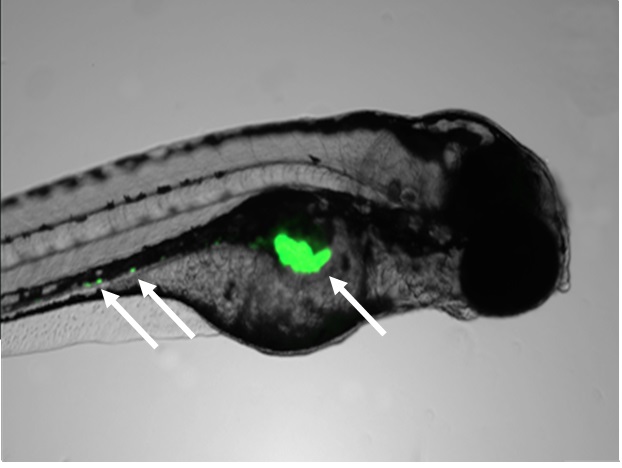

Ultrasonidos para mirar al interior del encéfalo

Se pueden anticipar los movimientos de las extremidades y la dirección de la mirada de un macaco mediante una técnica relativamente nueva que permite “visualizar” con alta precisión espacial y temporal la actividad neuronal de diferentes zonas de su encéfalo. De esto se deriva que puede utilizarse la actividad cerebral, registrada mediante esa técnica, para dar instrucciones a artefactos robóticos o máquinas en general, de manera que hagan cosas que el sujeto en cuestión no podría hacer por sí mismo. Piensen, por ejemplo, en una persona que, por sufrir una minusvalía, no puede mover sus brazos o que, simplemente, carece de ellos. El método utilizado es una técnica de neuroimagen denominada “ultrasónica funcional” (o fUS, del inglés functional UltraSound imaging).

Esta no es la primera ocasión en que se convierten instrucciones mentales, a través de una interface, en actos o movimientos de una máquina. Ya se había conseguido que un brazo robótico lleve una copa a la boca de una persona parapléjica en cuyo cerebro se habían implantado electrodos. La novedad no consiste en la capacidad para dictar órdenes desde la mente sin que intervengan las extremidades del sujeto, sino en la técnica utilizada.

Hasta ahora se han utilizado varios métodos directos para registrar la actividad neuronal en el encéfalo. La electroencefalografía (EEG) es la más antigua; detecta cambios de potencial eléctrico en el cerebro a través de electrodos colocados sobre el cráneo. No es invasiva pero tiene baja resolución espacial. Una variante de la anterior es la electrocorticografía (ECoG), que proporciona acceso directo a las señales eléctricas de las neuronas; tiene alta resolución temporal y espacial. El problema es que exige cirugía y entraña riesgos porque hay que implantar electrodos, daña los tejidos en que se insertan y el material de que están formados se acaba deteriorando con el tiempo.

También hay métodos indirectos. La resonancia magnética funcional (FMRi) es la alternativa no invasiva más utilizada en los últimos años para “visualizar” la actividad neuronal. Mide la variación local en el nivel relativo de hemoglobina combinada con oxígeno, porque ese nivel refleja el flujo sanguíneo en la zona, que depende, a su vez, del metabolismo de las neuronas. La tomografía por emisión de positrones (PET) tampoco es invasiva; se vale del uso de radioisótopos para detectar niveles de actividad metabólica mediante indicadores metabólicos o de flujo sanguíneo. El problema de estas técnicas, sobre todo de la segunda, es que no ofrecen gran resolución espacial ni temporal y los dispositivos son grandes equipos que no se pueden trasladar con facilidad; y menos aún pueden llevarse puestos.

La neuroimagen ultrasónica funcional se basa en la utilización de ultrasonidos para detectar cambios en el flujo sanguíneo que, como ya he señalado, informa del nivel de actividad metabólica de las neuronas a las que se dirige. Es superior a las anteriores en resolución temporal y de resolución espacial intermedia entre las de la EEG y la ECoG (similar a la FMRi). Además, se puede utilizar mediante dispositivos portátiles. La desventaja es que su uso requiere la retirada de un pequeño fragmento del cráneo, una especie de “ventana” al interior del encéfalo, aunque, a diferencia de los electrodos de la ECoG, el detector no penetra en el tejido nervioso ni atraviesa las membranas de tejido conjuntivo que lo protegen.

Las técnicas de neuroimagen ultrasónica son un ejemplo magnífico de una de las tecnologías actuales más prometedoras, tanto para dotar a personas discapacitadas de herramientas que les proporcionen autonomía funcional, como para, mirando a su interior, desentrañar los misterios del funcionamiento del encéfalo, la máquina de la mente.

Fuente: Norman et al (2021): Single-trial decoding of movement intentions using functional ultrasound neuroimaging. Neuron 109:1-13.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Ultrasonidos para mirar al interior del encéfalo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El gran encéfalo humano es un “encéfalo social”

- El encéfalo humano

- Tamaño del encéfalo e inteligencia

Ginés Morata – P4K 2019: La Biología del siglo XXI, la manipulación de la información genética y el futuro de la sociedad humana

Fragmentación de ADN usando un gel de agarosa. Foto: National Cancer Institute / Unsplash

Fragmentación de ADN usando un gel de agarosa. Foto: National Cancer Institute / UnsplashLas nuevas herramientas genéticas abren el camino para combatir enfermedades hasta ahora intratables, aumentar la longevidad humana o quizás incluso, para que especies humanas extintas vuelvan a la vida. Arrancando con una introducción histórica Ginés Morata nos pasea por todas estas posibilidades y lo que implican para la sociedad humana.

Ginés Morata se licenció en Ciencias Biológicas por la Universidad Complutense de Madrid donde obtuvo su doctorado en 1973. Actualmente es Profesor de Investigación del Centro de Biología Molecular Severo Ochoa del Consejo Superior de Investigaciones Científicas (CSIC) y la Universidad Autónoma de Madrid (UAM), centro que dirigió en el periodo 1990-1991. El Prof. Morata es especialista en genética del desarrollo, concretamente en el estudio de la arquitectura biológica de la mosca Drosophila melanogaster. Ha recibido numerosos galardones, entre los que cabe destacar, el Premio Nacional de Investigación Santiago Ramón y Cajal de 2002, la Medalla de Oro de Andalucía en 2003, el Premio México de Ciencia y Tecnología de 2004 y el Premio Príncipe de Asturias de Investigación Científica y Técnica de 2007.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Ginés Morata – P4K 2019: La Biología del siglo XXI, la manipulación de la información genética y el futuro de la sociedad humana se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La biología del siglo XXI, por Ginés Morata

- Sydney Brenner entrevistado por Ginés Morata

- «Las tres grandes fronteras de la biología humana» por Francisco J. Ayala

A vueltas con el índice glucémico de los alimentos

Leixuri Aguirre, Helen Carr-Ugarte, Itziar Eseberri Barace y Maitane González-Arceo

Foto: Shutterstock / marilyn barbone

Foto: Shutterstock / marilyn barbone

En nuestra dieta, el 50-60% de la energía debe ser aportado por los hidratos de carbono. Es decir, se recomienda que estos sean los macronutrientes más abundantes de la dieta, por delante de los lípidos y las proteínas.

Concretamente, el reparto se debería dar de la siguiente manera:

- Como máximo, un 10% de la energía en forma de hidratos de carbono simples o azúcares

- 40-50% de la energía en forma de hidratos de carbono complejos.

Los hidratos de carbono complejos los encontramos en cereales, pasta, pan, tubérculos, frutos secos y legumbres, mientras que los hidratos de carbono simples se encuentran en las frutas y verduras y en todo el azúcar añadido presente en los alimentos.

Más azúcar del que imaginamos

A la hora de intentar cumplir con las recomendaciones, el problema es que, por regla general, no somos conscientes de la cantidad de azúcar añadido que hay en los alimentos ultraprocesados. Además del azúcar que nosotros mismos añadimos a los alimentos que consumimos, debemos tener en cuenta el alto contenido de azúcar que podemos encontrar en productos como natillas (20 g por unidad), galletas tipo maría (1,5 g por galleta), cacao en polvo procesado (19 g por taza) o refrescos (35 g por lata), por mencionar algunos. De hecho, estudios recientes indican que consumimos hasta tres veces más azúcar que la recomendación actual de 25 gramos diarios, que no es poco.

Si se recomienda reducir el consumo de azúcar añadido (ojo, no el que aparece de forma natural en frutas o verduras), no es por capricho. Esto se debe a que es una forma eficaz de prevenir algunos problemas de salud como las caries, la obesidad, la diabetes tipo II y el hígado graso.

Un término que en los últimos años se ha puesto de moda es el índice glucémico (IG). Se trata de un indicador que clasifica a los alimentos en función del poder que tienen para aumentar la glucemia (glucosa en sangre), valorando el nivel de ese aumento y la velocidad a la que lo hace. Las personas con diabetes y los deportistas lo suelen tener más que controlado. Pero, ¿y el resto de los mortales?

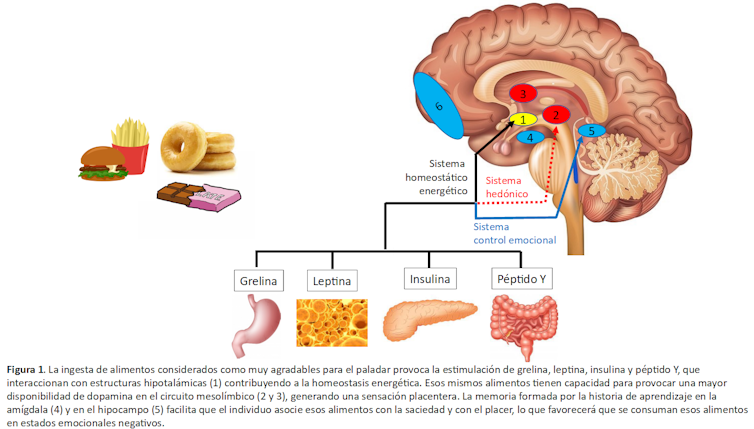

Vayamos por partes. Lo primero es entender cómo se calcula. A una persona en ayunas se le dan 50 gramos del alimento y se mide su glucemia a diferentes tiempos. El área bajo la curva (AUC, siglas del término anglosajón area under the curve) de la gráfica resultante se compara con la que se crea tras la ingesta de 50 gramos de glucosa (Figura 1). Multiplicando ese valor por 100, se obtiene un valor más fácil de interpretar, ya que va de 0 a 100. A este último valor es al que se denomina IG.

Figura 1. Gráfica representativa de las curvas de glucemia tras la ingesta de glucosa (referencia), un alimento de índice glucémico bajo y otro de índice glucémico alto.

Figura 1. Gráfica representativa de las curvas de glucemia tras la ingesta de glucosa (referencia), un alimento de índice glucémico bajo y otro de índice glucémico alto.¿Debemos evitar todos los alimentos con índice glucémico alto?

Pero entonces, ¿debemos evitar todos los alimentos de IG alto? Ni mucho menos. Lo primero que hay que tener en cuenta es que el hecho de que un alimento tenga un IG alto no significa que tenga un efecto perjudicial para nuestra salud. Lo veremos más adelante con ejemplos.

Además del IG, la cantidad de hidratos de carbono presente en la ración del alimento es fundamental. Por eso, para tener una visión más realista, surgió el concepto de carga glucémica (CG), valor resultante de multiplicar el IG por la cantidad de hidratos de carbono de la ración del alimento y dividido entre 100 (Figura 2).

Este concepto es importante, ya que aunque un alimento tenga un IG alto, puede que el pico de glucemia no sea en realidad tan pronunciado. Un ejemplo es lo que ocurre con algunas frutas: pese a que la sandía sea un alimento con IG alto, su contenido en hidratos de carbono es bajo (5 gramos por cada 100 gramos de sandía), lo que hace que, a fin de cuentas, su CG sea baja. En otras palabras, la sandía es un alimento totalmente saludable y recomendable aunque su IG sea alto.

Figura 2 Fórmulas y rangos para el cálculo del índice glucémico y la carga glucémica. AUC: área bajo la curva; HdeC: hidratos de carbono.

En general, todas las personas deberíamos cuidar la CG de los alimentos que ingerimos. Si consumimos alimentos con CG baja, mantendremos los niveles de glucosa estables durante más tiempo. Por lo tanto, la sensación de hambre tardará más en volver. Por el contrario, si consumimos un alimento con una CG alta, la glucemia se dispara. El exceso de glucosa en sangre repentino hace que el metabolismo de los lípidos de active. Por lo tanto, acumulamos grasa.

Diabéticos, deportistas y carga glucémica

Si a todos nos incumben el IG y la CG, hay dos colectivos para los que son fundamentales. Por un lado, las personas con diabetes tipo I o insulinodependientes; los diabéticos tienen que controlar que su glucemia no aumente mucho, ya que no producen insulina y tienen que dosificársela ellos mismos. Por lo tanto, les interesa consumir alimentos que tengan un IG bajo.

Por otro lado, estos cálculos resultan muy valiosos para los deportistas. Antes de hacer deporte, les interesa consumir alimentos ricos en hidratos de carbono y con IG bajo. De esta manera, la glucemia no aumenta rápidamente, y se mantiene la disponibilidad de glucosa durante más tiempo.

Esto permite que puedan seguir realizando ejercicios de alta intensidad de manera más prolongada, antes de evitar una hipoglucemia (popularmente conocida como “pájara”).

Sin embargo, durante la práctica deportiva, los deportistas suelen consumir alimentos con IG alto para evitar hipoglucemias, al igual que lo hacen después del ejercicio para recuperar rápidamente las reservas de glucosa gastadas.

Como referencia, podemos decir que el IG varía según el tipo de hidrato de carbono que consumamos. En el caso de los hidratos de carbono simples o azúcares, el IG es mayor, ya que son moléculas que se digieren rápidamente o se pueden absorber directamente. En el caso de los hidratos de carbono complejos, el IG es menor por que necesitan ser digeridos antes de ser absorbidos. Esto hace que la absorción sea más escalonada y, por tanto, se produzca un aumento de la glucemia menor.

Los azúcares, mejor con fibra

Cuando en nuestra comida, aparte de hidratos de carbono también hay grasas y proteínas, el vaciamiento gástrico es más lento. Por lo tanto, se dará una digestión más lenta que resultará en un IG menor.

Lo mismo ocurre cuando el contenido de fibra en la comida es alto. La fibra se encuentra en alimentos de origen vegetal y nuestro organismo no es capaz de digerirla. Al no digerirla, no la podemos absorber, además de ralentizar la digestión del resto de los nutrientes. Si digerimos más lentamente los hidratos de carbono, como se ha comentado previamente, los absorberemos de forma más lenta y el aumento de la glucemia será menor. Por ello, los alimentos con alto contenido en fibra, poseen IG más bajos.

Patatas y zanahorias tienen bajo contenido en amilosa, lo que hace que el índice glucémico aumente. Foto: Shutterstock / Adriana Marteva

Patatas y zanahorias tienen bajo contenido en amilosa, lo que hace que el índice glucémico aumente. Foto: Shutterstock / Adriana MartevaConfiguración de los hidratos de carbono

Los hidratos de carbono están formados por amilosa, que es lineal, y amilopectina, que es la parte ramificada y más irregular de los hidratos de carbono. La amilopectina se digiere más rápido que la amilosa. En el caso de los tubérculos (patata, boniato o zanahoria), el contenido en amilosa es bajo. Debido a ello, su IG aumenta.

Por el contrario, en el caso de las legumbres, el contenido en amilosa es mayor además de ser ricos en fibra. Por ello, son alimentos con un IG bajo.

Grado de maduración de las frutas

Según su grado de maduración, las frutas tienen un IG más alto o más bajo. Cuando la fruta está verde, el contenido de azúcares libres es menor (por eso sabe menos dulce), y su IG es también menor.

Cuando esa fruta va madurando se produce la hidrólisis (rotura) del almidón y se van liberando azucares, por lo que aumenta el IG. Evidentemente, el contenido de hidratos de carbono no varía, pero sí su disponibilidad y su IG.

De todas formas, no hay que olvidar que la CG de las frutas suele ser baja y, por lo tanto, el consumo de fruta, ya sea verde o madura, no supone un problema.

Eso sí, consumir un zumo de naranja o la naranja entera no es lo mismo. Cuando hacemos un zumo se rompen las células y se elimina parte de la fibra, haciendo que, aunque el contenido en azúcares no varíe, sí lo haga el IG.

Cuando hacemos un zumo de naranja se rompen las células y se elimina parte de la fibra, haciendo que, aunque el contenido en azúcares no varíe, sí lo haga el Índice Glucémico. Foto: Shutterstock / Narong Khueankaew

Cuando hacemos un zumo de naranja se rompen las células y se elimina parte de la fibra, haciendo que, aunque el contenido en azúcares no varíe, sí lo haga el Índice Glucémico. Foto: Shutterstock / Narong KhueankaewCocinar los alimentos modifica el indice glucémico

Cuando cocinamos los alimentos se produce una pequeña hidrólisis de los nutrientes que, en el caso de los hidratos de carbono, supone la liberación de algunas glucosas procedentes del almidón, haciendo que el IG varíe.

Unas zanahorias crudas tienen un IG de 30 (IG bajo), mientras que, una vez cocidas, el IG sube hasta 85 (IG alto). De nuevo, cabe recordar que además del IG hay que tener en consideración la CG, y que una zanahoria no es, ni mucho menos, un alimento cuyo contenido en hidratos de carbono o IG deba preocuparnos.

Otro ejemplo en el que nuestra manera de cocinar los alimentos modifica el IG es la duración del cocinado. Si cocemos la pasta lo que los italianos llaman “al dente”, el IG es de 40 (IG bajo), mientras que si la cocemos mucho sube hasta 55 (IG medio).

Si, una vez entendido que el concepto de IG es más complejo de lo que parece a simple vista, decidimos utilizarlo, conviene tener presente que no lo es todo. Es decir, también hay que tener en cuenta la cantidad de azúcares de los alimentos o la ración de alimento que consumimos. Además, en ningún caso hay que pensar que el punto de maduración de la fruta o el cocinado de los alimentos sea un factor determinante a tener en cuenta a la hora de configurar nuestra dieta.![]()

Sobre las autoras: Leixuri Aguirre, Helen Carr-Ugarte, Itziar Eseberri Barace y Maitane González-Arceo son profesoras e investigadoras de la UPV/EHU

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo A vueltas con el índice glucémico de los alimentos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cómo conservar mejor los alimentos con una iluminación inteligente

- El azúcar oculto en los alimentos

- Resveratrol y pteroestilbeno en el control epigenético de la acumulación de grasa corporal

¿Puede el virus SARS-CoV-2 integrarse en nuestro genoma?

Guillermo Peris

Virus SARS-CoV-2 (resaltado en amarillo) emergiendo de la superficie de células cultivadas en el laboratorio. Fuente: Wikimedia Commons

Virus SARS-CoV-2 (resaltado en amarillo) emergiendo de la superficie de células cultivadas en el laboratorio. Fuente: Wikimedia Commons

El pasado mes de diciembre se publicó un artículo de investigación que dio lugar a una gran polémica por sus conclusiones. En él se afirmaba haber encontrado evidencias de que el SARS-CoV-2 es capaz de integrarse en el genoma humano de los afectados por COVID-19. Según sus autores, esto explicaría que algunos infectados por este virus den positivo meses después de haber pasado la enfermedad, ya que las células de estos individuos producirían fragmentos del virus que serían detectados por una RT-PCR. Este artículo fue compartido en biorXiv, una plataforma en la que se publican investigaciones antes de pasar por un proceso de revisión por pares previo a la publicación en una revista científica. Como era de esperar, el artículo dio alas a los grupos antivacunas que lo usaron para denunciar que esta integración también podría darse con vacunas de ARN mensajero.

A principios de mayo de 2021 el artículo fue publicado online en la revista PNAS (Proceedings of the National Academy of Sciences of the United States of America, factor de impacto 9.4 en 2019) por un procedimiento no menos polémico: los socios de la National Academy of Sciences pueden enviar hasta dos artículos al año como contributed authors, en los que ellos eligen previamente a los dos revisores que evaluarán su trabajo. En este caso, el autor principal Rudolf Jaenisch siguió este camino para publicar su estudio. Además, en esta versión final intentó responder a las críticas que tuvo el artículo original en bioRxiv (y que fue rechazado por otra revista). Sin querer entrar a valorar las posibles implicaciones de esta forma sesgadas de revisión por pares (para lo que te aconsejo leer este artículo de Francis Villatoro), en este artículo quiero analizar únicamente las evidencias presentadas por los investigadores con las que pretenden respaldar su hipótesis de que el SARS-CoV-2 podría integrarse en los genomas celulares de los infectados. Para ello intentaré describir de la forma más sencilla posible los experimentos realizados y si realmente de los resultados se pueden inferir las conclusiones de este estudio.

LINE-1, el presunto compinche de SARS-CoV-2

El virus SARS-CoV-2 pertenece a la familia de los coronavirus y almacena su material genético en forma de ARN de una sola hebra (monocatenario) en el interior de una membrana formada por distintas proteínas, entre ellas la conocida como espícula o proteína S en la que se basan las vacunas de Pfizer y Moderna.

Estructura del SARS-CoV-2. Fuente: Wikimedia Commons

Estructura del SARS-CoV-2. Fuente: Wikimedia Commons

Cuando el virus infecta una célula humana utiliza la maquinaria celular del citoplasma para fabricar las proteínas necesarias para generar nuevos virus, realizar copias de su ARN y ensamblar todas estas piezas en los nuevos viriones que escaparán de la célula para seguir infectando. Durante todo este proceso, ningún componente del virus accede al núcleo celular, que es precisamente donde se encuentra el genoma en forma de ADN, así que este virus lo tendría difícil para integrarse en nuestro genoma, al menos a priori.

Ciclo de infección del SARS-CoV-2. La replicación del virus no requiere en ningún momento del acceso al interior del núcleo. Fuente: Wikimedia Commons

Ciclo de infección del SARS-CoV-2. La replicación del virus no requiere en ningún momento del acceso al interior del núcleo. Fuente: Wikimedia Commons

Pero a esta dificultad inicial hay que añadir otra: si algún fragmento del virus se las ingeniara para llegar al núcleo, como su material genético es ARN y el nuestro ADN, tampoco podría integrarse en nuestro genoma sin transformarse previamente a ADN. Excepto si el virus fuera capaz de fabricar una enzima retrotranscriptasa que convirtiera el ARN en ADN (como hacen el VIH y otros retrovirus, que sí se integran en nuestro genoma); pero, por suerte para nosotros, no tiene ningún gen que codifique este tipo de enzimas. Y, por supuesto, el genoma humano no tiene genes para realizar transcripción inversa. ¿O sí?

Ya os he hablado en otras ocasiones de los elementos móviles del ADN humano (también conocidos como retrotransposones) y de su papel en el desarrollo tumoral. Estos elementos serían secuencias de ADN capaces de «saltar» de una posición a otra del genoma, proceso durante el cual se crea una nueva copia de la secuencia en otra posición del genoma a partir de un intermedio de ARN mensajero (ARNm).

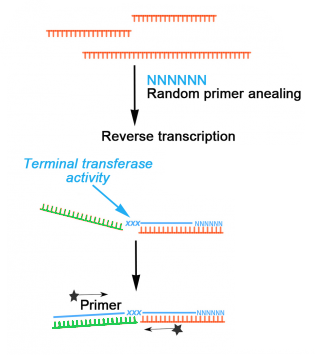

Proceso de retrotransposición de LINE-1. En una primera fase, el ADN del retrotransposón se transcribe a ARN mensajero. Este ARNm, tras una traducción a proteínas en el citoplasma, se integra en una nueva posición del genoma (imagen de elaboración propia). Fuente: Guillermo Peris Ripollés.

Proceso de retrotransposición de LINE-1. En una primera fase, el ADN del retrotransposón se transcribe a ARN mensajero. Este ARNm, tras una traducción a proteínas en el citoplasma, se integra en una nueva posición del genoma (imagen de elaboración propia). Fuente: Guillermo Peris Ripollés.

Para dar este salto, estos elementos móviles necesitan dos cosas: por un lado, una retrotranscriptasa que transcriba su ARNm a una copia de ADN; por otro, una enzima que corte el ADN en el lugar de integración para insertarlo allí. Pero justamente uno de estos elementos móviles, el conocido como LINE-1, tiene en su secuencia un gen que realiza ambas dos funciones. Y en nuestro genoma tenemos unas 500 000 copias de LINE-1, de las cuales en torno a un centenar son activas. En resumen, nuestras células sí son capaces de fabricar la enzima retrotranscriptasa que necesita el SARS-CoV-2 para integrar su ARN en nuestro genoma.

Mecanismo completo de retrotransposición de LINE-1. Fuente: Singer et al (2010)

Mecanismo completo de retrotransposición de LINE-1. Fuente: Singer et al (2010)

Pero este virus no lo va a tener fácil: en la inmensa mayoría de células de nuestro cuerpo los elementos LINE-1 están reprimidos y apenas pueden expresarse, por lo que su capacidad de fabricar enzima retrotranscriptasa es enormemente baja. Sí hay otros tipos celulares en losl que hay una mayor expresión (células tumorales, embrionarias o neuronales) pero no son relevantes en la infección de COVID-19. Además, incluso en caso de expresión de LINE-1 y fabricación de retrotranscriptasa, este elemento móvil tiene «preferencia» por integrarse a él mismo en el genoma o a otros elementos móviles (como ALU o SVA).

Así que, a priori, la posibilidad de que el SARS-CoV-2 se integre en el genoma de una célula humana infectada usando la retrotranscriptasa de LINE-1 es tremendamente baja. Por eso sorprendió el estudio de Rudolf Jaenisch en el que decía tener evidencias de integración del virus en el genoma celular humano en pacientes de COVID-19.

Análisis de células humanas in vitro

En el estudio se empieza analizando la infección por SARS-CoV-2 de células humanas in vitro (en células HEK293T, derivadas de riñón de embrión humano). Previendo que la cantidad de retrotranscriptasa procedente de LINE-1 sería pequeña, los investigadores decidieron aumentar artificialmente la cantidad de LINE-1 antes de la infección con SARS-CoV-2. Tras la infección secuenciaron y analizaron el genoma encontrando que, efectivamente, algunos fragmentos del virus se habían integrado en el ADN humano. En concreto, detectaron el gen que codifica la proteína N, pero no el de la espícula, que es el usado en las vacunas de ARNm; posiblemente porque el gen de la proteína N se encuentra en un extremo del genoma del virus. Tras encontrar las secuencias de virus en la secuenciación del genoma se comprobó experimentalmente mediante PCR que efectivamente estas secuencias se encontraban en el ADN humano. Esta validación experimental es imprescindible como evidencia.

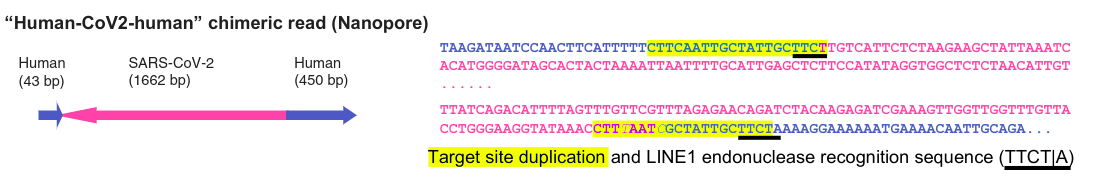

Fragmento secuenciado con Nanopore que abarca ADN humano (en azul) y del virus (en rosa). La secuencia resaltada en amarillo es una duplicación habitual cuando se integra un nuevo elemento con LINE-1. Fuente: Zhang et al (2021)

Fragmento secuenciado con Nanopore que abarca ADN humano (en azul) y del virus (en rosa). La secuencia resaltada en amarillo es una duplicación habitual cuando se integra un nuevo elemento con LINE-1. Fuente: Zhang et al (2021)Así pues, en este experimento sí encontraron fragmentos del virus integrados en el genoma humano, pero fue con células in vitro en las que se había aumentado artificialmente la cantidad de LINE-1. Estos niveles de expresión de LINE-1 son mucho mayores que los que se encuentran en una célula normal de nuestro organismo (salvo casos concretos de células tumorales o embrionarias). Esta fue una de las críticas al artículo publicado en diciembre. Por ello, en la nueva versión del artículo publicada en PNAS analizaron si había inserciones del virus en el genoma de células HEK293T en las que no se había aumentado previamente la cantidad de LINE-1 y, pese a afirmar haberlas encontrado, no informan de que las hayan validado experimentalmente. En resumen, no presentan evidencias suficientes de que el SARS-CoV-2 se integre en el genoma humano sin un aumento previo y artificial de LINE-1. Y esto, obviamente, todavía en células in vitro.

Análisis de células humanas de pacientes infectados

Con tal de comprobar si eran capaces de encontrar si el virus se había integrado en el genoma celular de pacientes con COVID-19, el equipo de investigadores usó bases de datos publicadas con secuenciaciones de ARN de personas infectadas. Es importante destacar que no tuvieron acceso a células reales sino sólo a las secuenciaciones en bases de datos, por lo que no pudieron validar sus hallazgos experimentalmente.

En estas secuenciaciones de ARN buscaron quimeras virus-humano, es decir, fragmentos de ARN en el que una parte de la secuencia fuera humana y otra del SARS-CoV-2. ¿Por qué? Si el virus se hubiera integrado en el genoma humano, al transcribirse el ADN a ARN mensajero, se hallarían fragmentos de ARN con secuencias de ambas especies.

Si el virus se integrara en el genoma humano, al transcribirse a ARNm y fragmentarse para la secuenciación se encontrarían quimeras virus-humano (figura modificada de Linheiro & Bergman (2012)).

Si el virus se integrara en el genoma humano, al transcribirse a ARNm y fragmentarse para la secuenciación se encontrarían quimeras virus-humano (figura modificada de Linheiro & Bergman (2012)).

El porcentaje de fragmentos del virus que encontraron se hallaba por debajo del 0.14 %. Según los autores, esto es coherente con una integración del virus en el ADN humano y su transcripción posterior a ARN mensajero (que es lo que detecta la secuenciación de ARN). Y aquí está una de las grandes pegas del estudio, así que vamos a intentar explicarla con calma.

El proceso de secuenciación de ADN ha avanzado enormemente desde la publicación del primer borrador del Proyecto Genoma Humano, hace ya 20 años. Actualmente podemos secuenciar el genoma de una persona (es decir, leer las más de 3 000 millones de letras de su ADN), procesarlo y analizarlo en menos de 24 horas. Pero esta técnica se ha optimizado para la lectura del ADN, no de ARN, así que cuando analizamos el conjunto de secuencias de ARN celular (el denominado transcriptoma) debemos realizar primero la conversión de ARN a ADN (denominado ADN complementario, ADNc). Ya hemos hablado de esto unos párrafos atrás, cuando comentábamos que para poder integrarse el SARS-CoV-2 en nuestro genoma necesitaba primero convertir su material genético a ARN con enzimas retrotranscriptasas. Por ello, para la secuenciación de ARN un primer paso es añadir estas enzimas a la muestra a analizar.

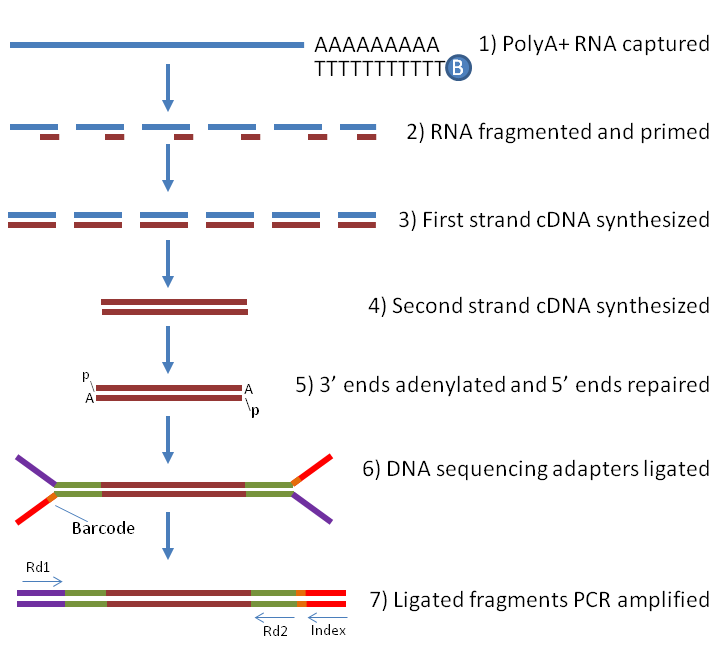

Esquema de secuenciación de ARN (RNA-seq). Las secuencias de ARN (en azul) se fragmentan y convierten a ADN (marrón) usando enzimas retrotranscriptasas. El ADN así conseguido se amplifica y secuencia. Fuente: Labome.com

Esquema de secuenciación de ARN (RNA-seq). Las secuencias de ARN (en azul) se fragmentan y convierten a ADN (marrón) usando enzimas retrotranscriptasas. El ADN así conseguido se amplifica y secuencia. Fuente: Labome.com

Tal y como se muestra en la imagen anterior, de la secuenciación se obtiene la cadena de nucleótidos de cada uno de las secuencias obtenidas al fragmentar el ARN. Hay que tener en cuenta que en este proceso se analiza todo el ARN celular, así que si hay otro tipo distinto del humano (por ejemplo, procedente de una infección vírica como SARS-CoV-2) también lo encontraremos en nuestro análisis pero, al provenir de ARN inicial distinto (el punto de partida señalado en la figura anterior como (1)) deberíamos localizarlo en fragmentos diferentes: es decir, deberíamos encontrar fragmentos de ARN relacionado con genes humanos o virus, pero no esperar encontrar fragmentos de ARN con mezclas de ambos.

El problema radica que en la técnica de secuenciación de ARN, al transformar mediante enzimas todos los fragmentos de ARN a ADNc, puede ocurrir que se «peguen» fragmentos de ARN de distintas procedencias, así que las quimeras encontradas en el estudio de Jaenisch podrían no ser más que un artefacto de la preparación de las muestras. De hecho, un estudio recientemente publicado en BiorXiv por Yan et al. (y que todavía no se ha publicado en una publicación revisada por pares) estima que en la secuenciación del ARN de una muestra de células humanas de pacientes con COVID-19 se obtienen durante el procesado de las muestras hasta un 1 % de quimeras virus-humano derivadas del propio procedimiento experimental. Es decir, las quimeras que encuentran los autores (recordemos, un 0.14 %) puede que no sean más que errores de la preparación de muestras.

Durante el proceso de transcripción inversa previo a la secuenciación puede ocurrir que se «peguen» fragmentos de ARN de distintas procedencias. En la imagen vemos cómo durante la formación del híbrido ARN-cADN se cuela un fragmento (en verde). Imagen modificada de Tang et al (2018).

Durante el proceso de transcripción inversa previo a la secuenciación puede ocurrir que se «peguen» fragmentos de ARN de distintas procedencias. En la imagen vemos cómo durante la formación del híbrido ARN-cADN se cuela un fragmento (en verde). Imagen modificada de Tang et al (2018).Tras recibir estas críticas en la versión inicial del artículo, los investigadores trataron de buscar en los datos alguna pista que reforzara su teoría de que las quimeras observadas no eran un artefacto del procedimiento experimental y provenían de una integración real del virus SARS-CoV-2 en el genoma humano. Y formularon la siguiente hipótesis: el ARN quimérico procedente de una integración en el ADN celular (que recordemos tiene dos hebras con la misma información pero en sentidos opuestos) daría lugar a quimeras también en ambos sentidos a partes iguales; mientras que si el ARN quimérico procedía de un artefacto experimental (obtenido del virus con una sola hebra en un sentido específico) las quimeras tendrían el ARN del virus en un solo sentido. Un análisis de las muestras de pacientes reveló que, como ellos esperaban, las secuencias de las quimeras tenían el ARN vírico como una mezcla de ambos sentidos.

El problema es que esta idea no es más que una hipótesis. Esta mezcla en distintos sentidos podría deberse a causas todavía no exploradas, por lo que no representa una evidencia suficiente de integración del virus en el genoma celular. Además, hay que recordar que este análisis de muestras de pacientes reales se hizo a partir de secuenciaciones obtenidas de bases de datos online, por lo que no se pudo validar experimentalmente ninguna de las inserciones detectadas.

En resumen, en el estudio de Jaenisch no se demuestra inequívocamente la presencia de integraciones del virus SARS-CoV-2 en el genoma humano, ya que los únicos casos de inserciones validadas experimentalmente se dan en células humanas in vitro en las que se ha sobreexpresado LINE-1 para aumentar la cantidad de enzima retrotranscriptasa. Es decir, reitero, no se ha encontrado experimentalmente que el virus se encuentre integrado en ningún genoma celular humano. Al menos por ahora. Porque se están mejorando las técnicas de secuenciación de ARN para evitar la aparición de quimeras; en el artículo de Yan et al. anteriormente citado ya se propone un método experimental que evita el enriquecimiento de quimeras durante la secuenciación de ARN.

Conclusión

¿Significa esto que es absolutamente imposible que el SARS-CoV-2 se integre en una célula infectada? No, ni mucho menos. El elemento LINE-1, muy de vez en cuando, integra en el genoma celular secuencias de ARNm de cualquier tipo que encuentre en el citoplasma. Y también muy muy muy de vez en cuando lo hace en células germinales, las que dan lugar a espermatozoides y óvulos, las que transmiten esa inserción a su descendencia. Justamente por eso, tenemos nuestro genoma plagado de pseudogenes, copias de fragmentos de genes en una posición distinta a su localización original. Y si pueden integrar muy muy muy de vez en cuando cualquier ARN mensajero, ¿por qué iba a ser distinto con el ARN del SARS-CoV-2? Este artículo polémico demuestra que, en las líneas celulares y sobreexpresando LINE-1, el mecanismo de integración es posible. Estoy convencido de que que se acabarán confirmando integraciones de SARS-CoV-2 tarde o temprano. Pero esa no es la pregunta que nos debemos hacer. Lo que nos interesa es si es relevante, si va afectar a muchas personas (con lo que, como apuntan los autores, podría dar positivos en PCR de personas sanas) o va a ser completamente irrelevante. En mi opinión, no creo que este fenómeno sea excesivamente relevante, pero mientras no se investigue no lo sabremos.

En cuanto al uso que hacen los negacionistas de este artículo, no hagamos caso y no les demos más voz. Así que cuando podáis, vacunaos.

Referencias

- Zhang L, Richards A, Khalil A, Wogram E, Ma H, Young RA, Jaenisch R. SARS-CoV-2 RNA reverse-transcribed and integrated into the human genome. bioRxiv [Preprint], 2020. doi: 10.1101/2020.12.12.422516.

- Zhang L, Richards A, Barrasa M, Hughes SH, Young RA, Jaenisch R. Reverse-transcribed SARS-CoV-2 RNA can integrate into the genome of cultured human cells and can be expressed in patient-derived tissues. Proceedings of the National Academy of Sciences, 118(21), 2021. doi: 10.1073/pnas.2105968118

- Yan B, Chakravorty S, Mirabelli C, Wang L, Trujillo-Ochoa JL, Chauss D, Kumar D, Lionaki MS, Olson MR, Wobus CE, Afzali B, Kazemian M. Host-virus chimeric events in SARS-CoV2 infected cells are infrequent and artifactual. bioRxiv 2021.02.17.431704; doi: 10.1101/2021.02.17.431704

- Cohen J. Further evidence supports controversial claim that SARS-CoV-2 genes can integrate with human DNA. Science, May, 6, 2021. doi: 10.1126/science.abj3287

Sobre el autor: Guillermo Peris es doctor en química cuántica, profesor del Departamento de Lenguajes y Sistemas Informáticos de la Universitat Jaume I e investigador de GENYO (Centro Pfizer – Universidad de Granada – Junta de Andalucía de Genómica e Investigación Oncológica).

El artículo ¿Puede el virus SARS-CoV-2 integrarse en nuestro genoma? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿En manos de quién ponemos nuestro genoma?

- Conseguir ver, y quizás ayudar a entender, al SARS-CoV-2 usando electrones y mucho frío

- Relación entre genoma y las formas graves de COVID-19

Calcular el área contando puntos

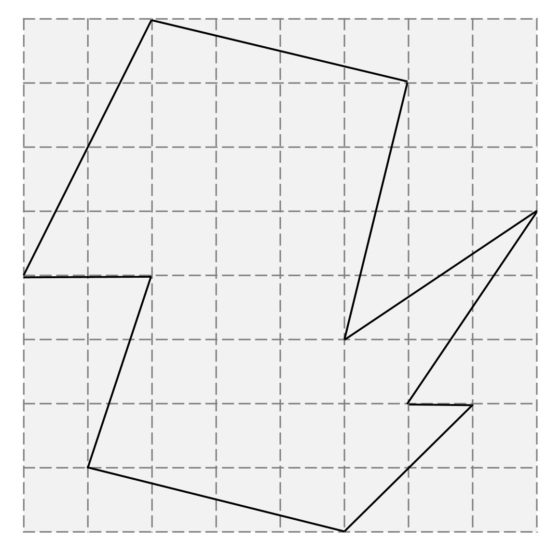

En más de una ocasión hemos hablado en esta sección del Cuaderno de Cultura Científica, Matemoción, de la belleza de algunos resultados matemáticos y de sus demostraciones. En esta entrada vamos a centrar nuestra atención en uno de esos hermosos resultados matemáticos, en concreto, perteneciente al área de la geometría, el teorema de Pick, que permite calcular el área de una cierta región sin más que contar una serie de puntos.

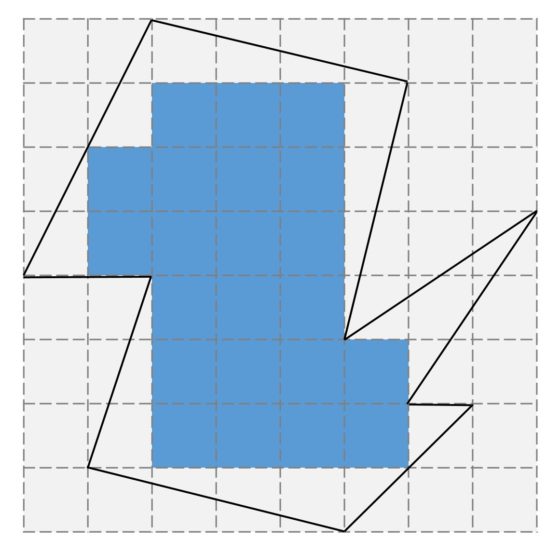

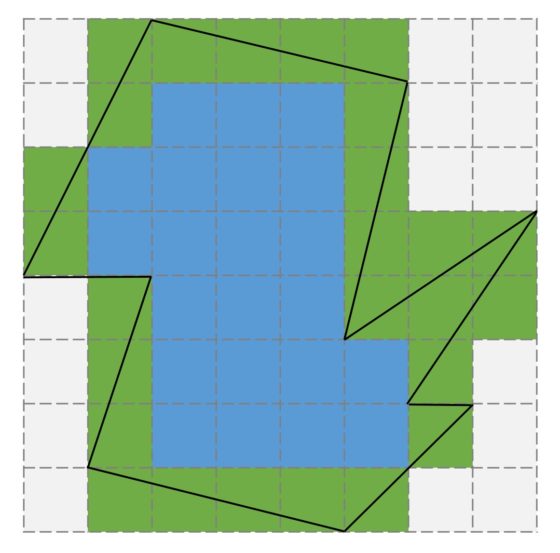

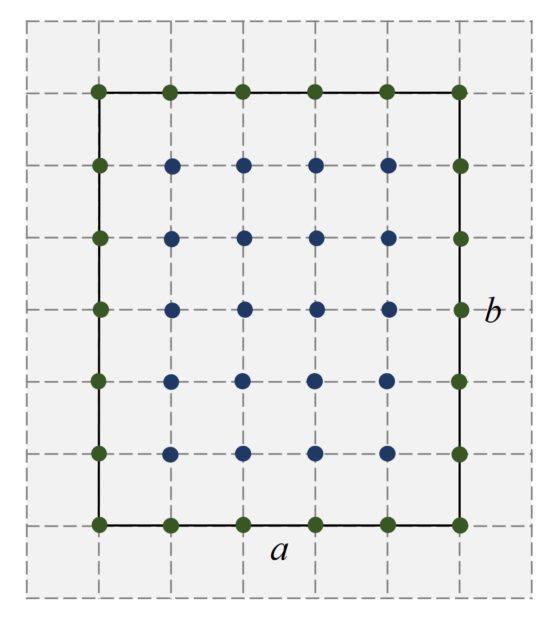

Imaginemos que queremos calcular el área de una región como la anterior. Un razonamiento rápido que podemos hacer es el siguiente. Contando los cuadrados de la retícula que están dentro de la región sabemos que su superficie va a ser mayor que el área de los 22 cuadrados interiores, es decir, mayor que 22 unidades cuadradas (si los cuadrados de la retícula son de un metro de lado, la región tendría más de 22 metros cuadrados), como se ve en la siguiente imagen.

Por otra parte, contando los cuadrados de la retícula que encierran a nuestra región sabemos que la superficie de la misma va a ser menor que 48 unidades cuadradas.

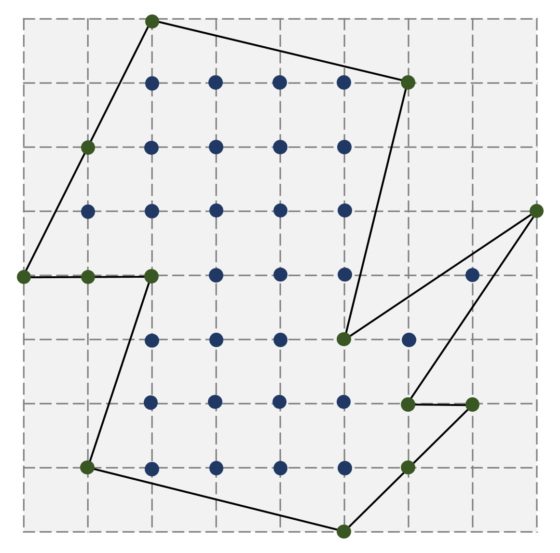

Pero, ¿cuál es el área exacta de esa región? Lo curioso de la respuesta a esta cuestión es que se puede calcular simplemente contando puntos. Miremos a la siguiente imagen. En ella hemos pintado los puntos que son vértices del retículo (las intersecciones de las líneas horizontales y verticales) que están en la frontera de nuestra región (los puntos verdes, B = 13) y los puntos que están en el interior de la misma (los puntos azules, I = 29).

El resultado del que vamos a hablar en esta entrada, el teorema de Pick, nos dice que el área de esa región es igual a

A = I + B/2 – 1 = 29 + 13/2 – 1 = 34,5 u.c.

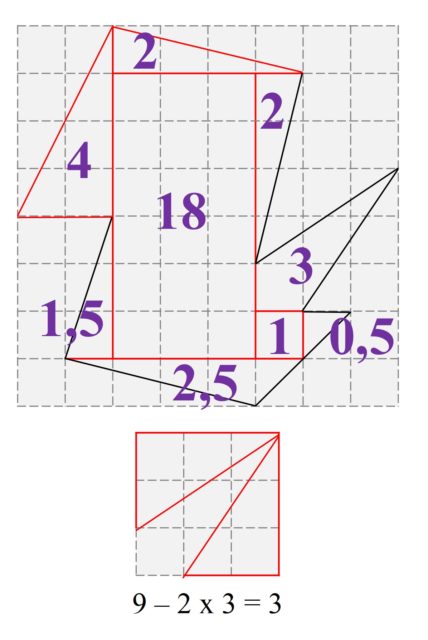

Veamos, con un poco de geometría básica, es decir, utilizando simplemente que el área de un rectángulo es base por altura y que la de un triángulo es base por altura dividido entre dos, que es así. Como vemos en la siguiente imagen, en la que se ha descompuesto la región en rectángulos y triángulos, el área es efectivamente 34,5 unidades cuadradas.

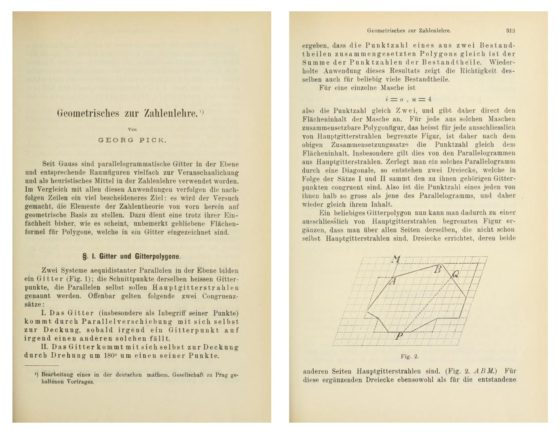

Pero vayamos con el teorema de Pick. Este bello y curioso resultado geométrico se debe al matemático austriaco Georg Alexander Pick (1859-1942) –matemático judío que introdujo a Albert Einstein en la geometría del cálculo tensorial que este necesitaba para la teoría de la relatividad y que murió en el campo de concentración de Theresienstadt– quien lo publicó en 1899 en la revista Sitzungsberichte des deutschen naturwissenschaftlich-medicinischen Vereines für Böhmen «Lotos» in Prag. (Neue Folge) bajo el título Geometrisches zur Zahlenlehre (algo así como Resultados geométricos para la teoría de números). Aunque el resultado empezó a llamar la atención después de que fuese recogido en la edición de 1969, en inglés, del libro de divulgación matemática Mathematical Snapshots (publicado originalmente en polaco en 1938) del matemático polaco Hugo Steinhaus (1887-1972). Desde entonces se ha convertido en un resultado geométrico muy conocido, del que se han publicado diferentes demostraciones.

Dos de las páginas del artículo Geometrisches zur Zahlenlehre publicado en 1899 por el matemático austriaco Georg A. Pick

Dos de las páginas del artículo Geometrisches zur Zahlenlehre publicado en 1899 por el matemático austriaco Georg A. Pick

El teorema de Pick es sorprendente ya que nos permite calcular el área de una cierta región simplemente contando puntos, de la frontera y del interior, sin tener en cuenta otras cuestiones más directamente conectadas con la geometría de la región. El enunciado de este resultado es el siguiente.

Teorema de Pick: Sea P un polígono reticular y simple, entonces el área de la región encerrada por el polígono es igual a

A = I + B/2 – 1,

donde I son los puntos del retículo que están en el interior del polígono y B son los puntos del retículo que están en la frontera, es decir, en el polígono.

Antes de nada, vamos a explicar brevemente los conceptos que aparecen en este resultado. Un polígono reticular es un polígono trazado sobre una retícula, como en nuestro ejemplo, de forma que los vértices del polígono están sobre los vértices del retículo (como ya hemos comentado, los puntos intersección de las líneas horizontales y verticales de la retícula).

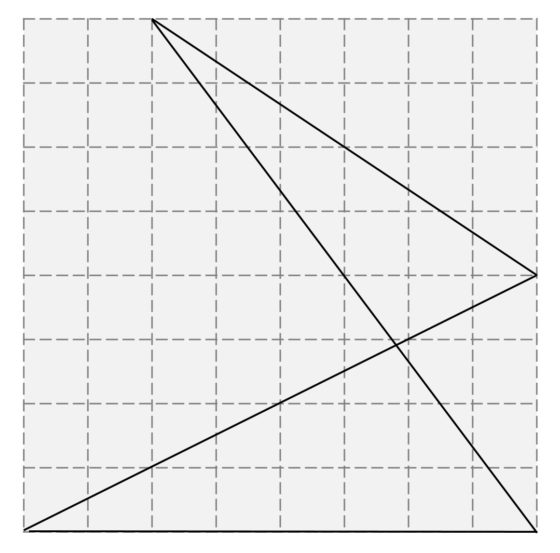

Por otra parte, un polígono reticular es simple si su frontera –los lados del polígono– no se intersecan entre sí. Para los polígonos reticulares no simples, como el del siguiente cuadrilátero de la imagen, no se verifica el resultado de Pick.

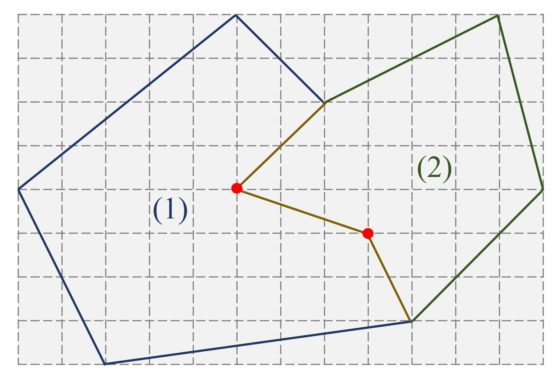

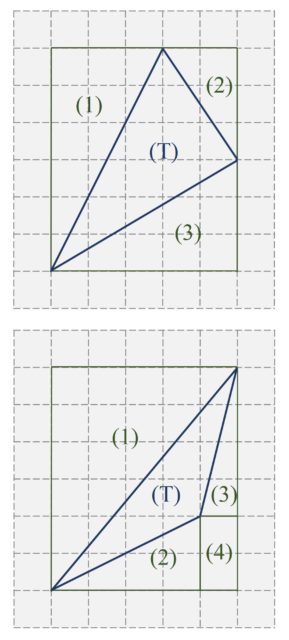

A continuación, veamos una idea de la demostración. El primer paso es observar que la fórmula del teorema de Pick, I + B/2 – 1, es aditiva, es decir, que si tenemos una región S cuya frontera es un polígono reticular simple y esta región es la unión de dos regiones más pequeñas –S es la unión de S1 y S2– cuyas fronteras son polinomios reticulares simples que verifican la fórmula de Pick, entonces también se verifica la fórmula para la región grande, unión de las regiones 1 y 2.

En la siguiente imagen tenemos un ejemplo de una región S que es unión de las regiones más pequeñas S1 y S2.

Además, hemos asumido que la fórmula del teorema de Pick se verifica para las regiones pequeñas S1 y S2,

A1 = I1 + B1/2 – 1,

A2 = I2 + B2/2 – 1,

veamos entonces que también se verifica para la región S, unión de las dos anteriores.

Para empezar, el conjunto de los puntos interiores de la región grande S está formado por los puntos interiores de las regiones pequeñas S1 y S2, más los puntos que están en la frontera poligonal común de las dos regiones S1 y S2, y que no están en la frontera poligonal de S (los puntos rojos de la imagen). Por lo tanto, la cantidad de puntos interiores de S es igual a

I = I1 + I2 + K,

donde K es la cantidad de esos puntos que están en la frontera poligonal común de las dos regiones S1 y S2, pero que no están en la frontera poligonal de S.

Respecto a los puntos que están en la frontera poligonal de la región S, son los puntos de la frontera poligonal de cada una de las dos S1 y S2, menos los K puntos que están en la frontera común. Aunque hay que tener cuidado de no contar dos veces los dos puntos que están en la frontera S1 y S2, pero también en la de S. Por lo tanto,

B = B1 – K + B2 – K – 2 = B1 + B2 – 2K – 2.

Ahora computemos la fórmula del teorema de Pick para la región S,

I + B/2 – 1 = (I1 + I2 + K) + (B1 + B2 – 2K – 2)/2 – 1,

que trivialmente es igual a

(I1 + B1/2 – 1) + (I2 + B2/2 – 1) = A1 + A2,

es decir, el área A de la región S.

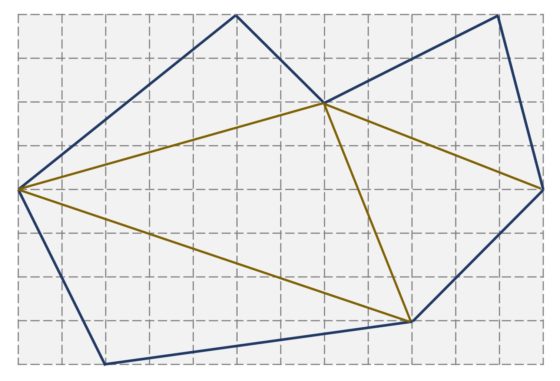

El siguiente paso de la demostración para probar el teorema de Pick es que cada región cuya frontera es un polígono reticular simple se puede descomponer en triángulos (reticulares). Este resultado se puede probar por inducción sobre el número de vértices del polígono simple (considerando una diagonal interior del polígono).

Teniendo en cuenta los dos pasos anteriores, bastará probar que el teorema de Pick es verdadero para los triángulos reticulares, ya que si el resultado es cierto para los triángulos y todo polígono simple se puede dividir en triángulos, por la propiedad aditiva de la fórmula de Pick se concluye.

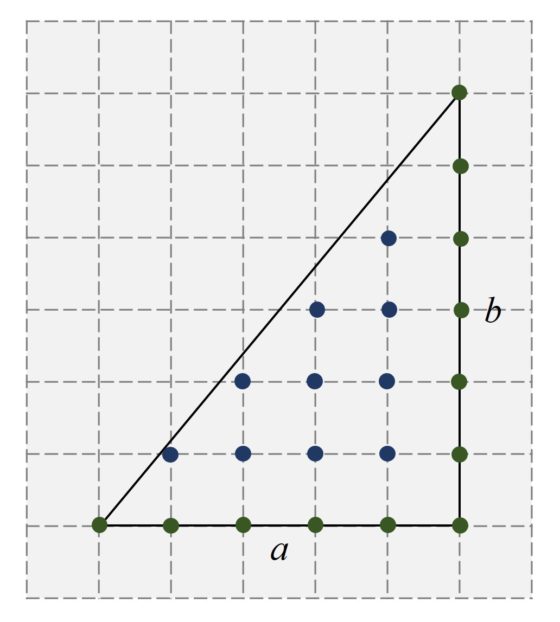

Veamos, por lo tanto, que la fórmula de Pick se cumple para los triángulos reticulares. Para empezar, consideremos un rectángulo, como el de la imagen, entonces la fórmula se cumple trivialmente. Si el rectángulo (reticular) tiene lados de longitudes a y b, entonces el número de puntos de la frontera es B = 4 + 2(a – 1) + 2(b – 1) = 2 (a + b) y el número de puntos del interior es I = (a – 1) x (b – 1) = ab – a – b + 1, luego

I + B/2 – 1 = ab,

el área A del rectángulo de lados a y b.

De aquí se va a deducir que también es verdad para triángulos rectángulos. Para lo cual se pueden considerar tres casos posibles: i) el cuadrado, ii) rectángulo con a y b son pares, y iii) rectángulo con al menos uno de los lados, a y b, impares. Por ejemplo, para este último caso, que es el que se corresponde con la siguiente imagen, se tiene que B = a + b + 1 e I = (ab – a – b + 1) / 2, para los que se comprueba que

I + B/2 – 1 = ab/2,

el área A del triángulo rectángulo de lados a y b.

Finalmente, habría que demostrar que la fórmula de Pick es válida para cualquier triángulo reticular. Para probarlo se empieza inscribiendo el triángulo en una zona rectangular, quedándonos una de las siguientes situaciones.

Ahora, que la fórmula de Pick se verifica para estos triángulos es una consecuencia de la propiedad aditiva de la fórmula y de que la misma se cumpla para los rectángulos y los triángulos rectángulos. Por ejemplo, para el primer caso, como la fórmula de Pick se cumple para el rectángulo en el que está inscrito nuestro triángulo, así como para los tres triángulos rectángulos de la imagen, entonces, por la propiedad aditiva de la fórmula de Pick, se tiene que cumplir también para la región que falta del rectángulo, que no es otra que la dada por nuestro triángulo inicial. Y de forma similar se actuaría para el segundo caso.

En consecuencia, ha quedado demostrado el teorema de Pick, puesto que toda región cuya frontera es un polígono reticular simple puede descomponerse en triángulos reticulares, para los cuales se cumple el teorema de Pick, deduciéndose el resultado para el polígono reticular inicial por la propiedad aditiva de la fórmula de Pick.

Ancestral Retro Mirage (Yakutsk, Rusia, 2019), del pintor, escultor y diseñador español Okuda San Miguel, en cuya obra tienen una importancia destacada las triangulaciones de color. Imagen de la página web de Okuda San Miguel

Ancestral Retro Mirage (Yakutsk, Rusia, 2019), del pintor, escultor y diseñador español Okuda San Miguel, en cuya obra tienen una importancia destacada las triangulaciones de color. Imagen de la página web de Okuda San Miguel

Existen varias demostraciones del teorema de Pick, algunas muy interesantes y hermosas, como las basadas en la fórmula de Euler o en el peso del polígono definido a través de los ángulos del mismo, pero de ellas ya hablaremos en otra ocasión.

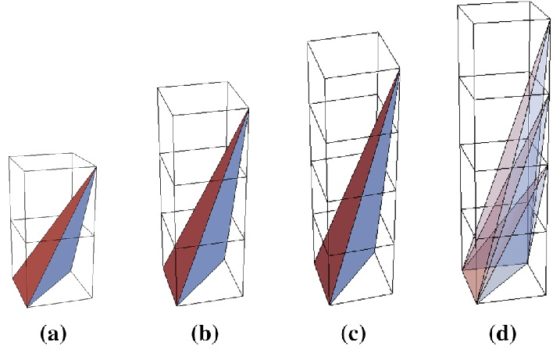

Vamos a terminar esta entrada cuestionándonos si el resultado será cierto para el volumen de una región tridimensional similar, es decir, encerrada en un poliedro reticular. En 1957 el matemático británico John Reeve demostró, con el llamado tetraedro de Reeve, que no es posible un resultado análogo.

El tetratedro de Reeve es un tetraedro del espacio coordenado tridimensional cuyos vértices están en los puntos de coordenadas (0, 0, 0), (1, 0, 0), (0, 1, 0) y (0, 0, r), para r un número natural, como se muestra en la imagen (para r = 2, 3, 4).

Tetraedro de Reeve. Imagen del artículo de Alexaner Belyaev y P. A. Falloye, Counting Parallel Segments: New Variants of Pick’s Area Theorem, The Mathematical Intelligencer 41 (4), 2019

Tetraedro de Reeve. Imagen del artículo de Alexaner Belyaev y P. A. Falloye, Counting Parallel Segments: New Variants of Pick’s Area Theorem, The Mathematical Intelligencer 41 (4), 2019

El volumen de estos tetraedros es r/6, es decir, varía con los diferentes valores de r. Sin embargo, todos estos tetraedros no tienen puntos interiores y tienen siempre cuatro puntos en su frontera, el tetraedro. Por lo tanto, no es posible un teorema de Pick ya que la cantidad de puntos interiores y frontera de esta familia de tetraedros reticulares no varía, pero sí el volumen de los mismos.

Bibliografía

1.- Martin Aigner, Günter M. Ziegler, El libro de las demostraciones, Nivola, 2005.

2.- Keith Ball, Strange Curves, Counting Rabbits and other Mathematical Explorations, Princeton University Press, 2003.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Calcular el área contando puntos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El triángulo de Pascal para calcular tangentes

- Área = perímetro