Ecolocalización, la capacidad de ver a través del sonido

Murciélago Myotis myotis (Carlos González Revelles). PRINUM

¡Apaga la radio que no puedo aparcar!, ¿verdad que os ha pasado?. Es curiosos como el sentido del oído puede afectar directamente nuestras capacidades cognitivas e impedir que desarrollemos tareas de manera eficiente.

No obstante, no se trata de algo exclusivo de los humanos. Una investigación liderada por la Universidad de Exeter (Reino Unido) se centró en observar el comportamiento de los peces limpiadores, aquellos que retiran parásitos a otros peces (conocidos como ‘clientes’), cuando se les expone al ruido de las lanchas a motor.

Según su estudio, publicado en la revista Scientific Reports, mientras se les expone a este sonido los peces limpiadores son más propensos a ‘engañar’, mordisqueando la capa mucosa protectora de sus clientes en lugar de limpiarlos de parásitos. Por su parte, los clientes son más propensos a estarse quietos y dejar que esto suceda.

Aquí en España, Investigadores del Museo Nacional de Ciencias Naturales (MNCN-CSIC) pudieron comprobar cómo afecta la contaminación acústica del aeropuerto de Madrid al comportamiento de las poblaciones de carboneros comunes, Parus major. Con el ruido provocado por los aviones, las aves prolongan su estado de vigilancia en detrimento de su alimentación. En definitiva, los resultados muestran cómo las aves se sobreponen al ruido adaptando sus conductas.

Según los investigadores, “al no oír, los carboneros compensan esa pérdida aumentando la vigilancia visual”. Con esta investigación se registró cómo el tiempo de vigilancia visual de los carboneros comunes se dispara al despegar los aviones, al mismo tiempo que la actividad alimenticia se ve relegada ante este estado de alerta.

Un GPS en el oído

Y es que el sentido del oído todavía guarda algunos secretos. La posibilidad de desarrollar la ecolocalización es uno de ellos. No es ni más ni menos que un proceso que consiste en emitir un sonido que rebota al encontrar un obstáculo y analizar el eco recibido. Involucra la producción, elaboración, recepción y audición de los pulsos ultrasónicos para detectar obstáculos invisibles o rastrear presas y ha evolucionado por separado en diferentes grupos de murciélagos y cetáceos como los delfines.

Se trata de un sistema que permite a los animales que lo poseen medir la distancia hasta los objetos y es uno de los ejemplos más conocidos de evolución convergente, es decir, un desarrollo de rasgos similares en diferentes especies.

De hecho, un trabajo llevado a cabo en la Universidad Queen Mary de Londres con murciélagos y delfines, cuya ecolocación evolucionó independientemente, encontró patrones genéticos convergentes en casi 200 regiones genómicas diferentes concentrados en varios genes auditivos, o lo que es lo mismo, siendo especies totalmente diferentes cuentan con similitudes genéticas algo que los científicos creen que podría ser la punta del iceberg: “Cuando los genomas de más especies se secuencien y estudien, podremos ver otros casos notables de adaptaciones convergentes impulsados por cambios genéticos idénticos”.

Por otro lado, como si de un superpoder se tratase, se sabe que algunas personas invidentes tienen la capacidad de detectar la posición de algunos objetos mediante ese mismo sistema pero es que yendo un paso más allá, científicos de la Universidad Ludwig Maximilian, de Munich, han publicado un estudio en el Journal of Neuroscience, donde se recoge que los videntes también pueden conseguirlo, aunque su cerebro lo procese de un modo diferente.

Concretamente, estos científicos contaron con la colaboración de 12 personas (solo una de ellas era ciega) a las que introdujo en una habitación acolchada que impedía que se generara ningún tipo de eco. Una vez allí se les reproducían una serie de sonidos concretos y se les repetía, como si de ecos artificiales se tratase; asociando cada sonido a un tamaño de habitación diferente.

Posteriormente se les introducía en una máquina de resonancia magnética al mismo tiempo que se les conectaba a una reproducción virtual de un edificio cercano, con el objetivo de que si producían cualquier sonido, recibirían el eco a través de unos auriculares, como si realmente se encontraran en el interior del edificio.

Se podían dar dos tipos de ecolocalización: activa, si ellos mismos generaban el sonido a través de un chasquido de su lengua, o pasiva, si se aprovechaban del eco de un ruido externo, en este caso producido por la propia máquina.

Gracias a las clases previas que habían recibido, todos ellos acertaron con bastante precisión el tamaño de la habitación, aunque los resultados eran mucho mejores cuando eran ellos los que producían el sonido con sus lenguas.

El dato más llamativo fue que se detectaron diferencias entre las áreas del cerebro que procesaron la información de los individuos videntes y del ciego. En el caso de los primeros, fue la corteza motora, encargada de procesar el movimiento, la que se activó durante el procesamiento del eco, mientras que en el ciego se activó la corteza visual; que, lógicamente, normalmente se encuentra inactiva en personas de su condición.

Unos datos que ponen de manifiesto que aunque el cerebro se adapte a las condiciones de manera diferente, todos podemos desarrollar esa habilidad y es posible que, con el entrenamiento suficiente, cualquier otra que nos propongamos.

Este post ha sido realizado por Mariajo Moreno (@Mariajo_Moreno) y es una colaboración de Naukas.com con la Cátedra de Cultura Científica de la UPV/EHU.

Referencias científicas y más información:

Joe Parker, Georgia Tsagkogeorga,, James A. Cotton, Yuan Liu, Paolo Provero, Elia Stupkay Stephen J. Rossiter. ‘Genome-wide signatures of convergent evolution in echolocating mammals’ Nature, 4 de septiembre de 2013. doi:10.1038/nature12511

Klett-Mingo, J.I., Pavón, I., y Gil, D. (2016) ‘Great tits, Parus major, increase vigilance time and reduce feeding effort during peaks of aircraft noise’ Animal Behaviour, DOI: 10.1016/j.anbehav.2016.02.021

Virginia L. Flanagin, Sven Schörnich, Michael Schranner, Nadine Hummel, Ludwig Wallmeier, Magnus Wahlberg, Thomas Stephan and Lutz Wiegrebe. ‘Human exploration of enclosed spaces through echolocation’ Journal of Neuroscience 10 January 2017, 1566-12; DOI: https://doi.org/10.1523/JNEUROSCI.1566-12.2016

El artículo Ecolocalización, la capacidad de ver a través del sonido se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La física del sonido orquestal

- Las tres dimensiones del sonido

- Un viaje a través del sistema circulatorio humano

Alaitz Etxabide: “Ikertzaile bat aunitz mugitu behar da”

Hala, Material Berriztagarrien Ingeniaritza Masterra egin zuen, eta amaierako lana berriro Biomaten egin zuen, eta, tesia egiteko aukera sortu zitzaionean, ez zuen zalantzarik izan haiekin jarraitzeko. Hiru urte eta erdi eman ditu tesia egiten, eta duela gutxi aurkeztu du. Pozik badago ere, aitortzen du tesia egitea ez dela erreza, besteak beste, presio eta lehia handia baitago epe mugatu batean lanak argitaratzeko, atzerrian egonaldiak egiteko, biltzar-zientifikoetara joateko, diru-laguntzak lortzeko… “Azkenean, ikertzaile bat aunitz mugitu behar da, gai jakin bat ikertzeaz gain”.

Irudia: Alaitz Etxabide Etxeberria, ingeniari kimikoa.

Horrek harritu egin zuen. Hala ere, tesian zehar “hagitz kontent” ibili dela dio: gaiagatik, lankideengatik, giroagatik… Eta emaitzak ere oso onak izan dira: “Aplikazio desberdinetara zabaldu dugu. Hasieran, elikagaiak ontziratzeko material bat ikertzea zen asmoa, baina gero ikusi genuen ikertutako gelatinak aplikazio aunitz izan zitzakeela medikuntzan”. Beste talde batzuekin harremanetan jarri ziren, eta, elkarlanean, medikuntzarako material aproposa garatu dute.

Ingurumenaren mesedetanGaratutako materialek medikuntzan aplikazioa izateak asko gogobetetzen du Etxabide, baina garrantzi handia ematen dio baita ingurumenean kalterik ez eragiteri ere: “Guztiz biodegradagarriak dira, eta azken fasean, konpost-fasean, ez dute inolako eragin kaltegarririk. Hortaz, badugu irtenbide bat plastikoek sortzen duten arazoa gainditzeko”.

Irtenbidea izanda industriak horren alde apusturik ez egiteak “amorrua” ematen dio Etxabideri: “Nik laborategian egin dut lan, baina erabili ditudan teknikak industrian jada badaude, ez dute inbertsio handirik egin behar. Zer gertatzen da? Lege-aldetik ez dutela presiorik horrelako aldaketa egiteko, eta ez dutela inongo interesik”. Edonola ere, ez du etsitzen: “Nik uste dut, pixkanaka bada ere, aldaketa gertatuko dela”.

Oraingoz, iruditzen zaio industrian ematen ari diren pausoak ez direla nahikoak ez egokiak benetan aldatzeko. “Adibidez, lehengai berriztagarriak erabiltzen ari dira, baina ez dira biodegradagarriak; orduan, arazoa ez da konpontzen. Biopolietilenoa, esaterako, artotik lortzen dute, baina geroko produktua ez da biodegradagarria. Eta horren inguruan ez da informaziorik ematen. Jendeak botatzen ditu plastikoak birziklatzera, baina ez daki zati handi bat ezin dela birziklatu”.

Hasitako bidean jarraitzea gustatuko litzaioke eta ez du atzerrira bidaiatzeko aterik ixten. Doktorego-tesia egiten ari zela, Bordeleko Unibertsitatean (Frantzia) eta Newcastleko Unibertsitatean (Erresuma Batua) egonaldiak egin zituen. “Han ikasi nuen munduko toki ezberdinetik etorritako jende batekin batera lan egiten, beste kultura batzuk ezagutu nituen, eta hori aberasgarria da bai lanerako bai norberarentzako”.

Bukatzeko, euskarak ere zientzian lekua izan behar duela eta baduela aldarrikatu du Etxabidek. Hala, lan handia eman zion arren, euskaraz idatzi zuen tesia, eta euskara erabili du bere lana azaltzeko bai biltzarretan (Ikergazte, Materialen Zientzia eta Teknologia), bai aldizkaritan (Ekaia).

Fitxa biografikoa:Alaitz Etxabide Etxeberriak (Lesaka, 1990) Industria Kimikaren Ingeniaritza Gradua eta Material Berriztagarrien Ingeniaritza Masterra ikasi ditu UPV/EHUn, eta toki berean aurkeztu du nazioarteko tesia: “Saretze erreakzioaren kontrola proteinazko filmen eta biokonpositeen propietateak egokitzeko”. 16 artikulu zientifiko argitaratu ditu; haietako bi euskaraz, Ekaia aldizkarian. Biltzarretan ere euskaraz zein ingelesez aritzeko aukera izan du. 2016an, PhD ikasle zela, hitzaldi onenaren saria jaso zuen, Elsevier aldizkariaren eskutik.

———————————————————————————-

Egileaz: Ana Galarraga Aiestaran (@Anagalarraga1) zientzia-komunikatzailea da eta Elhuyar Zientzia eta Teknologia aldizkariko erredaktorea.

———————————————————————————-

Elhuyar Zientzia eta Teknologia aldizkariarekin lankidetzan egindako atala.

The post Alaitz Etxabide: “Ikertzaile bat aunitz mugitu behar da” appeared first on Zientzia Kaiera.

“Conócete a ti mismo” no solo es un consejo estúpido, es realmente peligroso

Bence Nanay

Detalle de “Madame Jeantaud au miroir” de Edgar Degas (aprox. 1875). Cortesía de Wikipedia

Hay una frase que es igualmente probable que encuentres en un texto filosófico serio como en el libro de autoayuda más extravagante: “¡Conócete a ti mismo!” La frase tiene un pedigrí filosófico serio: en la época de Sócrates, era más o menos sabiduría tradicional (aparentemente cincelada en la explanada del Templo de Apolo en Delfos) aunque una variante de la frase se remonta al Antiguo Egipto. Y desde entonces, la mayoría de los filósofos han tenido algo que decir al respecto.

Pero “¡Conócete a ti mismo!” también tiene el atractivo de la autoayuda. ¿Tu objetivo es aceptarte a ti mismo? Bueno, necesitas conocerte primero. ¿O es tomar buenas decisiones, las decisiones que son adecuadas para ti? De nuevo, esto sería difícil a menos que te conocieras a ti mismo. El problema es que nada de esto se basa en una imagen realista del yo y de cómo tomamos decisiones. Todo este asunto de “conocerse a sí mismo” no es tan simple como parece. De hecho, podría ser un serio embrollo filosófico, por no decir un mal consejo.

Tomemos un ejemplo cotidiano. Vas a la cafetería de la esquina y pides un expreso. ¿Por qué? ¿Solo un capricho momentáneo? ¿Por probar algo nuevo? ¿Quizás sabes que la dueña es italiana y que te juzgaría si pidieses un capuchino después de las 11 de la mañana? ¿O simplemente eres una persona de expresos?

Sospecho que la última de estas opciones es la que refleja mejor tus elecciones. Haces gran parte de lo que haces porque crees que encaja con el tipo de persona que crees que eres. Pides tortilla con cebolla porque eres un tipo de persona de tortilla con cebolla. Es parte de lo que eres. Y esto se aplica a muchas de nuestras elecciones diarias. Vas a la sección de filosofía de la librería y a la sección de comercio justo del supermercado porque eres un filósofo que se preocupa por la justicia global, y eso es lo que hacen los filósofos que se preocupan por la justicia global.

Todos tenemos ideas bastante estables sobre qué tipo de personas somos. Y eso es lo mejor: no tenemos que pensar demasiado al pedir el café todas las mañanas. Estas ideas sobre qué tipo de persona somos también pueden ir acompañadas de ideas sobre qué tipo de persona no somos, no voy a comprar en Lidl*, no soy ese tipo de persona. (Esta forma de pensar acerca de uno mismo podría derivar fácilmente en moralizar nuestras preferencias, pero no abramos esa lata de gusanos aquí).

Sin embargo, existe un importante problema con esta disposición mental: las personas cambian. Hay períodos tumultuosos en los que cambiamos drásticamente, en los períodos de amor romántico, por ejemplo, o de divorcio o de tener hijos. A menudo somos conscientes de estos cambios. Después de haber tenido hijos, probablemente te hayas dado cuenta de que de repente te has convertido en una persona madrugadora.

Pero la mayoría de los cambios ocurren de forma gradual y por debajo del radar. Se comprenden bien algunos mecanismos de estos cambios, como el “mero efecto de exposición“: cuanto más estás expuesto a algo, más fácil es que te guste. Otro, más problemático, es que cuanto más se frustra tu deseo de algo, más fácil es que te desagrade. Estos cambios ocurren gradualmente, a menudo sin que notemos nada.

El problema es este: si cambiamos mientras nuestra imagen de nosotros mismos permanece igual, habrá un profundo abismo entre quiénes somos y quiénes pensamos que somos. Y esto lleva al conflicto.

Para empeorar las cosas, somos excepcionalmente buenos descartando incluso la posibilidad de que podamos cambiar. Los psicólogos le han dado a este fenómeno un nombre elegante: “la ilusión del final de la historia”. Todos pensamos que quienes somos ahora es el producto terminado: seremos iguales en cinco, 10 o 20 años. Pero, como descubrieron estos psicólogos, esto es completamente delirante: nuestras preferencias y nuestros valores serán muy diferentes en un futuro no muy lejano.

¿Por qué es esto un gran problema? Puede estar bien cuando se trata de pedir el expreso. Tal vez ahora prefieras casi mejor el capuchino, pero piensas que eres una persona de café expreso, por lo que sigues pidiendo expreso. Así que estás disfrutando de tu bebida matutina un poco menos; nada demasiado importante.

Pero lo que es cierto del expreso es cierto de otras preferencias y valores en la vida. Tal vez solías disfrutar realmente filosofando, pero ya no lo haces. Pero como ser filósofo es una característica tan estable de tu autoimagen, sigues haciéndolo. Hay una gran diferencia entre lo que te gusta y lo que haces. Lo que haces no está dictado por lo que te gusta, sino por el tipo de persona que crees que eres.

El verdadero perjuicio de esta situación no es solo que pasas gran parte de tu tiempo haciendo algo que no te gusta especialmente (y que a menudo te desagrada positivamente). En cambio, es que a la mente humana no le gustan las contradicciones flagrantes de este tipo. Hace todo lo posible para ocultar esta contradicción: un fenómeno conocido como disonancia cognitiva.

Ocultar una gran contradicción entre lo que nos gusta y lo que hacemos requiere un gran esfuerzo mental y esto deja poca energía para hacer cualquier otra cosa. Y si te queda poca energía mental, es mucho más difícil apagar el televisor o resistirse a pasar media hora mirando Facebook o Instagram.

¡Conócete a ti mismo!’, ¿verdad? Si tomamos en serio la importancia del cambio en nuestras vidas, esto simplemente no es una opción. Podrías saber lo que piensas de ti en este momento. Pero lo que piensas de ti es muy diferente de lo que eres y lo que realmente te gusta. Y en un par de días o semanas, todo esto podría cambiar de todos modos.

Conocerse a sí mismo es un obstáculo para reconocer y hacer las paces con valores constantemente cambiantes. Si sabes que eres tal y tal tipo de persona, esto limita considerablemente tu libertad. Puede ser que hayas sido la que elegió ser una persona de expreso o una persona que dona a la caridad, pero una vez que estas características se incorporan a tu propia imagen, tienes muy poco que decir en qué dirección va tu vida. Cualquier cambio sería o censurado o llevaría a una disonancia cognitiva. Como escribió André Gide en Autumn Leaves (1950): “Una oruga que busca conocerse a sí misma nunca se convertirá en mariposa”.

![]() Sobre el autor: Bence Nanay es catedrático de filosofía en la Universidad de Amberes (Bélgica) y Senior Research Associate de la Universidad de Cambridge (Reino Unido).

Sobre el autor: Bence Nanay es catedrático de filosofía en la Universidad de Amberes (Bélgica) y Senior Research Associate de la Universidad de Cambridge (Reino Unido).

Texto traducido y adaptado por César Tomé López a partir del original publicado por Aeon el 16 de octubre de 2017 bajo una licencia Creative Commons (CC BY-ND 4.0).

Nota del traductor:

[*] “Costco” en el original. “Lidl” podría ser un equivalente en Europa continental.![]()

El artículo “Conócete a ti mismo” no solo es un consejo estúpido, es realmente peligroso se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Te tocó ayer la lotería? Da lo mismo, eres la persona más rica del mundo

- El crimen más estúpido

- El entrenamiento mental solo sirve para entretenerse un rato

Las mujeres poderosas se pintan los labios

Cleopatra se pintaba los labios con rojo rejalgar. En la época victoriana el pintalabios estaba repudiado, representaba la «inmoralidad femenina». Las sufragistas emplearon el pintalabios rojo como símbolo de la emancipación femenina. En la actualidad, pintarse los labios forma parte de una campaña de rechazo a las políticas machistas de Trump, e incluso es el estandarte de una nueva ola del feminismo.

Movimientos sociales con los labios pintados

El pintalabios ha estado vinculado a momentos sociales importantes como símbolo de protesta o de fortaleza de la mujer. En 1912, el movimiento sufragista utilizó el pintalabios rojo como símbolo de la emancipación femenina y de lucha en sus marchas por Nueva York.

Durante la Segunda Guerra Mundial, Elisabeth Arden creó un tono para las Fuerzas Armadas estadounidenses y Helena Rubinstein lanzó el color Regimental Red. El Gobierno de Estados Unidos puso en marcha una campaña bajo el lema Beauty as Duty («La belleza como deber»), que animaba a las mujeres a no descuidar su imagen para dar una apariencia de normalidad a pesar del conflicto bélico.

Unos de los labios más famosos del cine fueron los de Clara Bow, quien aparecía con ellos pintados en las películas de cine mudo de los años veinte. El pintalabios era un recurso para potenciar los labios de las actrices en las películas en blanco y negro. Su uso en el cine ayudó a popularizarlo, convirtiéndolo en un símbolo de cultura pop. El uso de pintalabios se normalizó en los años treinta, cuando comenzaron a comercializarse en los salones de belleza de Helena Rubinstein y Elisabeth Arden. Desde ese momento comienza a entenderse el pintalabios como un símbolo de la sexualidad adulta, sentido que se potenciará en la década de los 50 con estrellas del cine como Marilyn Monroe.

A partir de los años 70, el pintalabios dejó de ser algo exclusivo de las mujeres. La cultura punk tuvo mucho que ver. La subcultura gótica, con la música industrial y el post-punk, pusieron color a los labios de algunos hombres que se han convertido en iconos, como Robert Smith o Marilyn Manson.

La historia del pintalabios tiene su ciencia

La primera prueba arqueológica del uso de maquillajes se encontró en el Antiguo Egipto. Los ojos se delineaban con polvos de grafito (kohl), con mineral pirolusita o con negro de humo, que fabricaban quemando maderas resinosas. Los labios se pintaban con pigmentos de colores rojizos y violáceos mezclados con cera o grasas, a semejanza de las pinturas que se empleaban en arte. La mayoría de esos pigmentos eran de origen mineral, como piedras de colores molidas de ocre rojo y rejalgar.

A lo largo de la historia, las tendencias de maquillaje fueron variando. Tanto los colores como los aglutinantes empleados guardaban similitud con las técnicas pictóricas del momento.

La barra de labios que conocemos actualmente es un invento reciente. Los primeros pintalabios se vendían en pequeños botes o envueltos en papel y se aplicaban con pincel. A comienzos del siglo XX, en 1910, la marca Guerlain empezó a fabricar rudimentarias barras de labios. Las aristócratas francesas lo compraban envuelto en frágiles tubos de cartón. Posteriormente, en 1915, en la Socovill Manufacturing Company se fabricaron unos de los primeros tubos metálicos en los que se insertarían las barras de labios. Así fue más fácil comercializarlas y convertirlas en un producto más asequible. El primer pintalabios de esas características que se comercializó en España fue el Milady de la compañía Puig en 1922. En 1923, James Bruce Mason Jr inventó el sistema giratorio que permite subir y bajar la barra de labios, convirtiéndolo en el objeto fácil de aplicar y transportar que hoy conocemos.

El lápiz labial contiene una variedad de ceras, aceites, pigmentos y emolientes. La cera le da al lápiz labial su forma y facilidad de aplicación. Entre las ceras se encuentran cera de abeja, la cera de carnauba, que es un exudado de los poros de las hojas de palmeras de cera brasileñas, y la cera de candelilla, que se obtiene de la planta de candelilla propia de México.

Los aceites y las grasas que se utilizan en la barra de labios como emolientes incluyen aceite de oliva, manteca de cacao, lanolina, vaselina y aceite de ricino, que forma una película dura y brillante cuando se seca después de la aplicación.

En los últimos años, se han agregado al lápiz labial ingredientes hidratantes, vitaminas antioxidantes, humectantes y filtros solares, entre otros, con el fin de mantener los labios hidratados y protegidos.

Las barras de labios con acabado mate tienen mayor proporción de ceras y pigmentos que de emolientes, es decir, tienen más textura que brillo. Las de acabado cremoso guardan mayor equilibrio entre brillo y textura. Los gloss tienen alto brillo y poco pigmento. Los destellos de algunos pintalabios provienen de partículas de mica o sílice. Y los lápices labiales de larga duración contienen aceite de silicona, que sella el color.

El pintalabios como índice económico

El pintalabios se utiliza como medidor de consumo. En los años 40, Leonar Lauder, presidente de Estée Lauder, acuñó la expresión lipstick index (índice del pintalabios) para demostrar cómo en tiempos de crisis las ventas del rouge aumentan estrepitosamente. Durante la Gran Depresión, las ventas de lápices de labios aumentaron un 25%. Este índice también sirvió para describir el aumento de las ventas de cosméticos durante la recesión de principios de la década de 2000. Lauder hizo la afirmación de que las ventas de lápiz labial podrían ser un indicador económico, en el sentido de que las compras de cosméticos -en especial los lápices labiales- tienden a estar inversamente relacionados con la salud económica. La conjetura era que las mujeres sustituyen el lápiz labial por compras más caras, como vestidos y zapatos, en tiempos de dificultades económicas.

Sin embargo, el lipstick index ha sido desacreditado como indicador económico. El aumento de las ventas de cosméticos en 2001 se ha atribuido a un mayor interés en las marcas de cosméticos diseñadas por celebridades y no tanto a la recesión.

El esmalte de uñas, en la década de 2010, con el auge del nail art como moda, sobre todo en Japón y Reino Unido, ha reemplazado al lápiz labial. Podríamos empezar a hablar de nail polish index.

Feministas con los labios pintados de rosa

El llamado feminismo de tercera ola o de tercera generación comenzó a surgir en los años ochenta y noventa, en respuesta a un fracaso percibido por las feministas de la segunda ola. La primera ola del feminismo se enfocaba principalmente en la superación de los obstáculos legales a la igualdad (sufragio femenino, derechos de propiedad, etc.), la segunda ola tenía una amplia variedad de temas, como la desigualdad de facto, la sexualidad, la familia, el lugar de trabajo y quizá de forma más controvertida, los derechos en la reproducción. El feminismo de la segunda ola empoderó a muchas mujeres en los años sesenta y setenta, pero también generó una reacción violenta en algunas regiones, estimulando estereotipos sobre feministas, feminismo y lo que es ser feminista. Las feministas de la segunda ola, como reacción al paternalismo y cosificación de la mujer, señalaron al pintalabios como uno de los iconos de sometimiento al patriarcado.

Una parte del movimiento feminista actual de la tercera ola es el lipstick feminism (feminismo de pintalabios). Este feminismo lo encarnan mujeres tan populares como Madonna o Beyoncé a través del llamado «girl power». Este tipo de feminismo es en gran parte una reivindicación de la libertad femenina, en cuanto a independencia, poderío y no censura de la sexualidad. El pintalabios, así como otros adornos que se asocian al «cliché femenino», se utiliza como estandarte del empoderamiento de la mujer.

En el siglo XIX, la reina Victoria declaró públicamente que el maquillaje era descortés. Para ella el uso del pintalabios era característico de las mujeres «inmorales» y de las prostitutas. La palidez se puso de moda durante casi un siglo. También por eso el pintalabios se recupera como símbolo.

El feminismo del pintalabios es un tema que genera controversia. Algunos ven que las muestras de poder sexual en realidad siguen ahondando en un sistema patriarcal que cosifica el cuerpo femenino. En cambio, otros argumentan que están tomando el control de su sexualidad. Que las mujeres son libres para llevar faldas, escotes y maquillaje.

A principios de 2017, un pintalabios se convirtió en el símbolo de rechazo hacia las políticas de Donald Trump que atentan contra los derechos de la mujer. Tras la «Marcha de las Mujeres» en Washington y el movimiento de los «gorros rosas», ahora la protesta se hace visible con un lápiz de labios rosa.

Katie Sones, una universitaria californiana ha lanzado la marca Lipslut (que se traduciría como labios de zorra), que forma parte de la campaña «The Fuck Trump» (el jodido Trump), «un movimiento para dar poder a las mujeres y a las futuras generaciones». El 50% del total recaudado se destinará a la entidad benéfica relacionada con los derechos de la mujer que los clientes elijan por voto popular.

La historia del pintalabios es una historia de ciencia, de música, de política. Pero sobre todo es una historia que nos habla del poder de las mujeres.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo Las mujeres poderosas se pintan los labios se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La menor influencia de las mujeres en Internet

- La gestión de la salud y seguridad en el trabajo de las mujeres

- El altruismo en las mujeres se ve recompensado

Erraldoi abisalak

Juan Ignacio Pérez eta Miren Bego Urrutia Janaria

Juan Ignacio Pérez eta Miren Bego Urrutia Janaria ———————————————————————————————————–

Der Rote «Gorria» zientzia-fikziozko eleberri bat da. Bernhard Kegel biologo alemaniarra da idazlea. Eleberriaren literatura-kalitatea, apalegia izan gabe ere, ez da beste munduko gauza. Ondo idatzita dago, hori bai, eta, gainera, bistakoa da idazlea zientzialaria dela eta idazten duenaz badakiela. «Technothriller» kategorian sailkatu den eleberri horren El rojo izenez argitaratutako itzulpeneko pasartea (141. or.) da honako hau:«Noizean behin, larruazal leun eta garbi haien gainetik pasatzen zuen mihia. Baina bakarrik itxura fresko eta osasungarria zuten animalietan, nazka ikaragarria ematen baitzion. Ehunek amoniakoa ote zeukaten jakin nahi zuen: animaliek amoniako usainik ez zutenez, eta berak laborategirik ez zuenez, gustu-zentzumenera jo behar zuen egiaztatzeko. Haien ehunetan amoniako asko duten txibiek flota dezakete, grabitatearen eraginpean egongo ez balira bezala; txibia handiek ere ―txibia erraldoiek barne― flota dezakete horri esker. Jon Deaver-ek erakutsi zion amarrua, baina erakutsi aurretik, bakarrik gourmet eta zefalopodomanoei gomendatzeko modukoa zela esan zion, eta barregura sarkastiko bat azaldu zuen aldi berean. Orain Hermann-ek bazekien bere adiskide australiarrak zer adierazi nahi zion.»

Bideoa: Japoneko Toyama badian 2015eko abenduan ikusitako txibia erraldoia. (Grabazioa: AP – Associated Press)Eleberriko pasarteak ederki azaltzen du txibia erraldoien ezaugarri bitxi hori. Izan ere, Asturiaseko kostaldeko uretan harrapatu dituzten txibiei buruz horixe azpimarratu izan dute egunkarietako kroniketan, amoniako asko eta oso haragi gogorra dutela. Jakina, txibia erraldoiak jateko egokiak ote diren izaten da egunkariek aipatzen duten kontua, eta jateko modukoak ez izateko bi horiek dira ematen diren arrazoiak. Gizakiok ezin ditzakegu jan, ez, baina zeroiek ez dute jateko inolako eragozpenik; izan ere, kaxaloteen harrapakinak dira txibia erraldoiak [1].

Architeuthis generoan sartu dituzte orain arte aurkitu diren txibia erraldoi guztiak. Zortzi espezie deskribatu dira, baina litekeena da egiazko kopurua txikiagoa izatea. Izenak berak dioenez, tamaina handikoak dira, ornogabe handienak, zalantzarik gabe. Eme handienak 13 metro luze dira hegal kaudalaren puntatik bi garro luzeenetako puntetara, eta 10 metroko luzera dute ar handienek. Garroak kenduta, 5 metro dute luzean, gutxi gorabehera. Gutxi da animalia hauei buruz dakiguna; izan ere, bizirik eta haien medioan zebiltzan Architeuthis generoko txibien lehen argazkiak 2004 urtean atera zituzten eta 2006ko abenduan egin zieten lehen filmaketa.

Irudia: Txibia erraldoia.

Txibien artean eta, oro har, ornogabeen artean ere, luzeena da Architeuthis. Ez da, baina, masa handiena duena. Masari erreparatuz gero, txibia kolosala da ezagutzen den ornogabe – eta txibia – handiena. Izen zientifikoa Mesonychoteuthis hamiltoni du, eta kolosal horri buruz txibia erraldoiaz baino gutxiago dakigu. Izan ere, oso banako gutxi harrapatu izan dira. Txibia kolosal handiena, 2007ko otsailean harrapatu zuten Zeelanda Berriko uretan. Ia 500 kg-ko pisua zuen eta 10 metroko luzera. Hala ere, adituek uste dute 12-14 metroko luzera dutela espezie honetako banako handienek.

Bai txibia erraldoiak, bai kolosalak ere, biak bizi dira ozeanoetako ur abisaletan. Ehunetan duten amoniakoari esker, uraren dentsitate berbera lortzen dute, eta horrek flotatzeko ahalmen handia ematen die. Harrapariak dira, baina, aldi berean, baita harrapakinak ere. Lehen esan bezala, kaxaloteen harrapakinak dira. Izan ere, kaxaloteen urdailetan aurkituriko aztarnak oso garrantzitsuak izan dira ur sakonetako zefalopodo horien ezaugarri anatomikoak ezagutzeko.

Bi txibia-espezie horiek gigantismo abisal edo ur sakonetako gigantismo izenez ezagutzen den gertaera baten adibide ezin hobeak dira. Ur sakonetan bizi diren ornogabe asko eta asko oso handiak dira, sakonera txikiko uretan bizi diren beren taldeetako kide hurbilenak baino askoz ere handiagoak. Isopodo erraldoia (Bathynomus giganteus), txangurru japoniarra (Macrocheira kaempferi), sardinzarren erregea (Regalecus glesne), zazpi besoko olagarroa (Haliphron atlanticus) eta beste txibia zenbait dira gigantismo abisal horren beste adibideak.

Ur sakonetako gigantismoaren zergatia azaltzeko bi hipotesi nagusi erabili dira: bizi-zikloen teoriaren araberakoa da bata, eta oinarri metabolikokoa bestea. Lehen hipotesiaren arabera, baliabideak urriak direnean eta banako handienak bizirik irauteko probabilitatea banako txikienena baino handiagoa denean, hazkunde somatikoari ematen zaio lehentasuna eta, beraz, atzeratu egiten da ugaltzea. Banako helduen tamaina handia izaten da horren ondorioz, oso handia zenbait kasutan. Metabolismoaren eta tamainaren artean dagoen erlazioan du oinarria bigarren hipotesiak. Horren arabera, handia izateak abantaila nabarmenak ditu baliabideak oso urriak diren tokietan, energetikoki animalia handiak txikiak baino askoz ere eraginkorragoak baitira. Gogora ezazu, irakurle, «Elefantea eta basasagua» izenburuko atalean idatzi duguna; hantxe azaldu dugu metabolismoaren eta tamainaren artean dagoen erlazioa.

Oharrak:

[1] Kaxaloteen harrapakin nagusiak ez diren arren, askotan esaten edo idazten denaren aurka. Izan ere, oso gutxi dira zeroien urdailetan aurkituriko txibia erraldoien aztarnak.

—————————————————–

Egileez: Juan Ignacio Pérez Iglesias (@Uhandrea) eta Miren Bego Urrutia Biologian doktoreak dira eta UPV/EHUko Animalien Fisiologiako irakasleak.

—————————————————–

Artikulua UPV/EHUren ZIO (Zientzia irakurle ororentzat) bildumako Animalien aferak liburutik jaso du.

The post Erraldoi abisalak appeared first on Zientzia Kaiera.

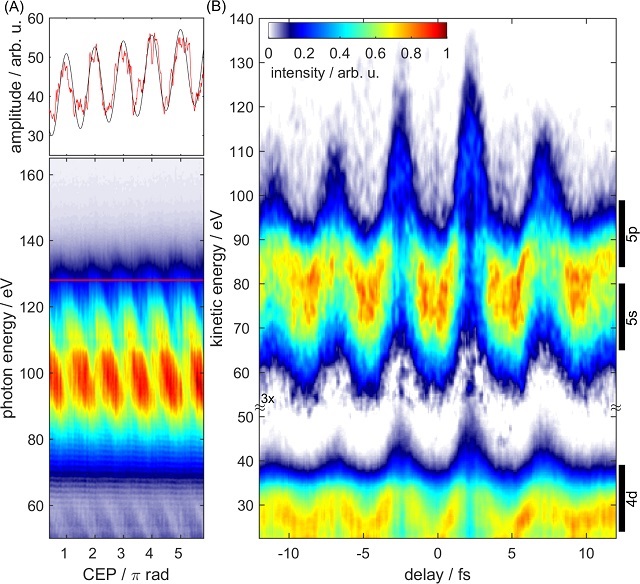

El pulso láser más corto

Las moléculas están en continuo movimiento. No solo de traslación, como cuando un camión hormigonera se desplaza a una obra, también existen movimientos de vibración, como el que en la hormigonera producen el motor o las irregularidades de la carretera y de rotación, como el que efectúa la cuba de hormigón. Al igual que en la hormigonera, todos los movimiento se dan a la vez. Pero, a diferencia de ésta, en la que todos los movimientos se producen en la escala de segundos, en las moléculas la escala es muchísimo menor.

Las moléculas rotan en el rango de picosegundos (10-12 s), sus átomos vibran en el rango de femtosegundos (10-15 s) y los electrones se mueven en el rango de attosegundos (10-18 s). Esto significa que, si queremos estudiar las moléculas y sus transformaciones, necesitamos señales que operen en estos rangos de tiempo, algo en absoluto trivial.

Un equipo de investigadores del Instituto Politécnico Federal de Zúrich (Suiza) encabezado por Thomas Gaumnitz ha logrado generar registrado con una duración de tan solo 43 attosegundos. Dicho de otra manera, este pulso de láser es el evento controlado más corto que jamás haya sido creado por humanos. Este pulso láser puede permitir observar con gran detalle cómo se mueven los electrones dentro de una molécula o cómo se forman los enlaces químicos.

Pero, ¿cuál es la ventaja de poder observar los pasos de las reacciones química con una resolución aún mayor? El ojo humano, por ejemplo, es muy eficiente cuando se trata de convertir fotones en señales nerviosas. En la rodopsina, un pigmento visual en la retina, la molécula fotosensible retinal se predispone de tal manera que su estructura puede cambiar extremadamente rápido mediante la absorción de un solo fotón. Esto permite que podamos ver incluso con poca luz. Una reacción mucho más lenta haría imposible la visión, porque la energía del fotón se convertiría en calor en solo unos pocos picosegundos. Esta eficiencia es algo que aún no tenemos en muchos sistemas industriales.

La espectroscopía en el rango de attosegundos podría contribuir al desarrollo de células solares más eficientes, ya que ahora sería posible por primera vez seguir el proceso desde la excitación por la luz solar hasta la generación de electricidad paso a paso. Una comprensión detallada de la vía de transferencia de carga podría ayudar a optimizar la eficiencia de la próxima generación de elementos fotosensibles.

La espectroscopía láser de attosegundos no solo sirve para observar. Las reacciones químicas también pueden ser manipuladas directamente: el uso de un pulso láser puede alterar el curso de una reacción; incluso los enlaces químicos se pueden romper al detener el cambio de carga en una determinada ubicación de la molécula. Intervenciones específicas como estas en reacciones químicas no han sido posibles hasta ahora, ya que nunca se había alcanzado la escala de tiempo del movimiento de electrones en las moléculas.

Si los químicos de síntesis tenían mucho de cirujano-barbero hace tan solo 50 años, esta herramienta una vez desarrollada los terminará de convertir en microcirujanos moleculares de alta precisión. ¡Quién sabe lo que lograrán entonces!

Referencia:

Thomas Gaumnitz et al (2017) Streaking of 43-attosecond soft-X-ray pulses generated by a passively CEP-stable mid-infrared driver Optical Express doi: 10.1364/OE.25.027506

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo El pulso láser más corto se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cómo fabricar hielo extraterrestre y verlo molécula a molécula

- Cómo conseguir que la superhidrofobia dure

- El demonio de Maxwell

El problema de la plantación de árboles en filas (2)

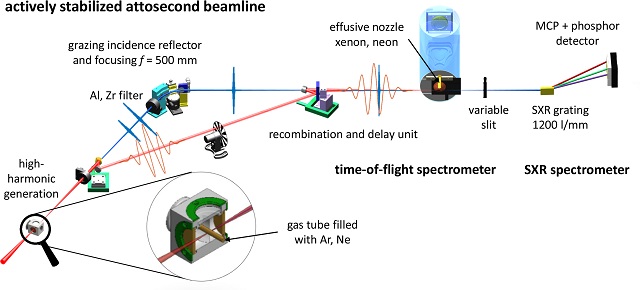

Mi anterior entrada en el Cuaderno de Cultura Científica, El problema de la plantación de árboles en filas, terminaba con dos problemas de ingenio propuestos por el experto inglés en matemática recreativa Henry E. Dudeney (1857-1930), en su libro Amusements in mathematics –Diversiones matemáticas- (1917). Uno de ellos era el conocido como Rompecabezas de Newton.

Rompecabezas de Newton: plantar 9 árboles de forma que formen 10 filas con 3 árboles en cada fila.

Os animo a quienes estáis leyendo esta entrada a que intentéis resolver el rompecabezas de Newton, antes de mirar la solución que mostraré más adelante.

Caricatura, realizada por Gerardo Basabe de Viñaspre, del matemático inglés Sir Isaac Newton (1642-1727), a quien se le atribuye la autoría del anterior juego de ingenio, perteneciente a la exposición El rostro humano de las matemáticas, de la Real Sociedad Matemática Española

Este problema de ingenio está relacionado con la familia de problemas de ingenio llamados de plantación de árboles en filas o problemas de puntos y líneas. La formulación general de estos problemas es la siguiente.

Problema: ¿Cómo pueden distribuirse n puntos en el plano (o quizás, n árboles en un huerto) formando filas, cada una de las cuales contiene exactamente k puntos (respectivamente, árboles), con el objetivo de obtener el mayor número de filas posibles? ¿Y cuál ese mayor número de filas posibles para cada n y k, que denotamos r(n,k)?

El matemático inglés James J. Sylvester (1814-1897) estuvo trabajando en este problema, para el caso clásico de filas formadas por tres árboles, es decir, el caso k = 3, desde la década de 1860 hasta su muerte. El problema de la línea de Sylvester del que hablamos en la anterior entrada formaba parte de esta investigación.

El problema general de determinar la mayor número de filas r(n, k) para n puntos y k puntos por fila no se ha resuelto todavía. Se ha obtenido la solución para algunos casos particulares y también algunas cotas inferiores para r(n, k). Por ejemplo, el propio Sylvester demostró la siguiente cota inferior:

![]()

x

es el número entero más grande que es menor o igual que x, por ejemplo,

5,2

= 5; ó

–3,2

= – 4.

Cuando k = 2 el problema es trivial, ya que cada par de puntos de los n dados forman una recta, luego el máximo número de rectas posibles es el número combinatorio “n sobre 2”, es decir, las formas de elegir dos objetos de un conjunto de n,

![]()

Para el caso clásico de filas de tres árboles, k = 3, la cuestión se complica ya mucho. Como comentaba Martin Gardner en su artículo Problemas de plantación de árboles, del libro Viajes en el tiempo y otras perplejidades matemáticas, este problema está relacionado con diferentes teorías matemáticas, como teoría del diseño, triples de Kirkman-Steiner, geometrías finitas, funciones elípticas de Weierstrass, curvas cúbicas, planos proyectivos, códigos de corrección de errores y muchas otras.

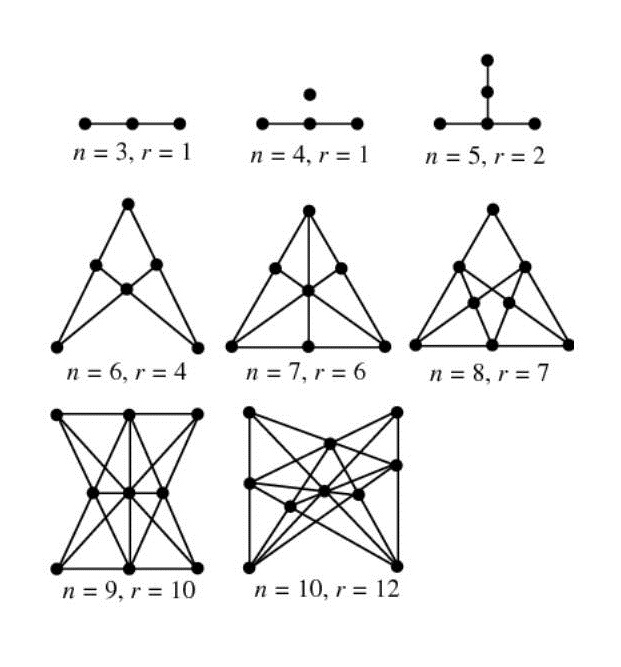

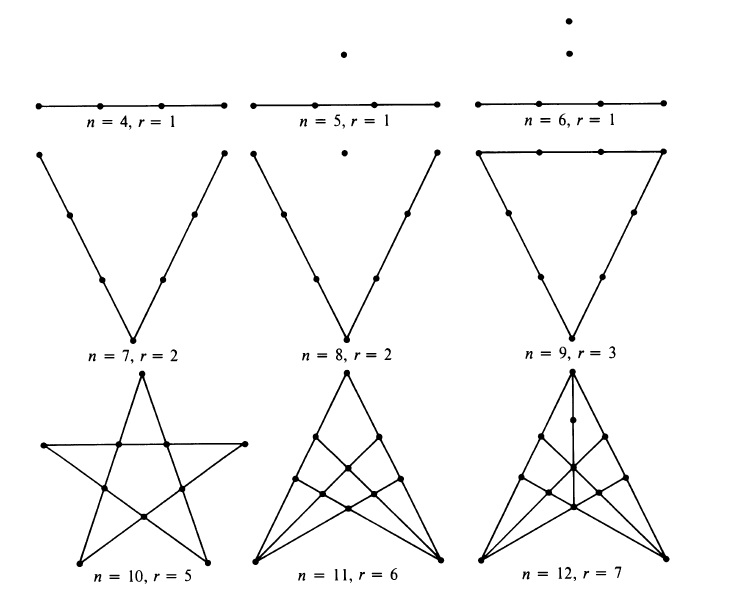

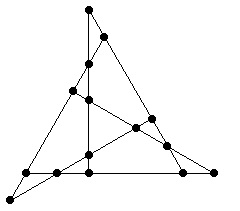

En la siguiente imagen vemos soluciones para un número bajo de puntos, es decir, distribuciones maximales de puntos (resp. árboles) en filas de tres puntos (resp. árboles) para una cantidad de puntos entre 3 y 10, muchos de los cuales aparecen en libros clásicos de problemas de ingenio.

En concreto, el diagrama para el caso de 9 puntos (abajo a la izquierda) es la solución al rompecabezas de Newton.

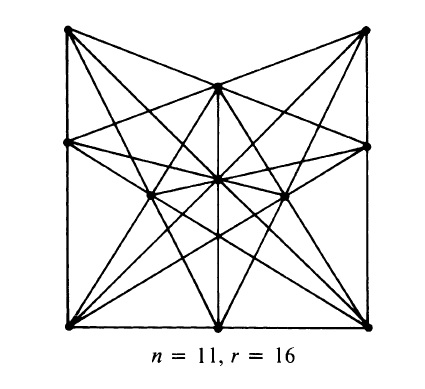

El diagrama que resuelve el caso de once puntos, es decir, la distribución maximal de 11 puntos, que permite obtener 16 rectas, es la solución del otro problema de ingenio de Henry E. Dudeney (1857-1930), de su libro Amusements in mathematics –Diversiones matemáticas-, que propusimos en la anterior entrada del Cuaderno de Cultura Científica, El problema de la plantación de árboles en filas.

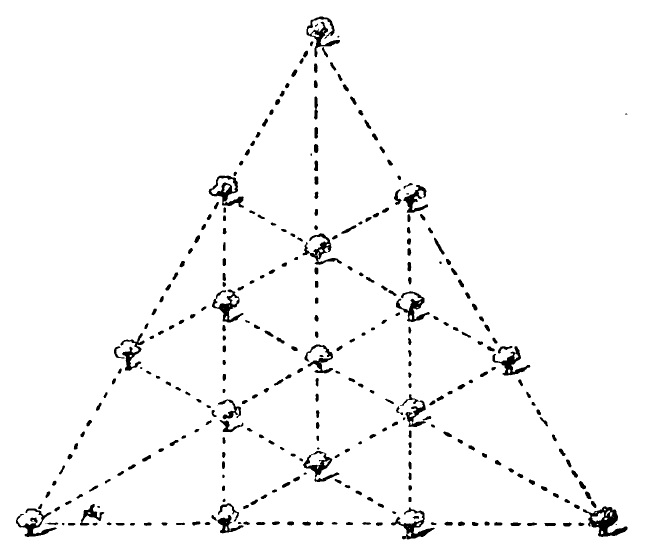

Turcos y rusos (versión de N. J. A. Sloane): Durante una batalla de la Primera Guerra Mundial, 11 soldados turcos fueron rodeados por 16 soldados rusos. Cada ruso disparó una vez y cada bala pasó exactamente por la cabeza de tres turcos. ¿Cómo estaban colocados los soldados turcos?

Es el siguiente diagrama:

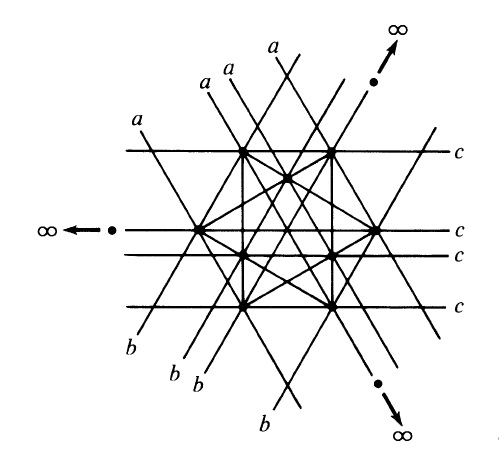

El ingeniero Robert H. Macmillan (1921-2015) que era un apasionado de la matemática recreativa, y colaborador habitual de la revista The mathematical Gazette anunció en esta revista en 1946 que se podía obtener una distribución de 12 puntos que permitía obtener 19 rectas. Después Stefan A. Burr, Branko Grunbaum, N. J. A. Sloane, en su artículo The Orchand Problem –el problema del huerto- (1974) demostraron que 19 era maximal, es decir, r(12, 3) = 19. A continuación mostramos la distribución maximal que aparece en el artículo de Burr, Grunbaum y Sloane. Esta distribución simétrica se ha realizado sobre el plano proyectivo, es decir, con puntos del infinito, de hecho, tres de los puntos están en el infinito y una de las rectas es la recta del infinito. Esta solución se puede trasladar al plano normal (euclídeo), pero no es tan sencilla de visualizar, por eso mostramos aquí la del plano proyectivo.

Aprovechemos para recordar que el plano proyectivo es una estructura geométrica que extiende el concepto de plano euclídeo ordinario. En el plano euclídeo dos rectas se intersecan en un punto o son paralelas. El plano proyectivo puede pensarse como el plano euclídeo al que se le añaden “puntos del infinito”, donde se intersecan las rectas paralelas. Por lo tanto, en el plano proyectivo cualesquiera dos rectas se cortan y lo hacen en un único punto. Además, todos los puntos del infinito forman la “recta del infinito”.

Stefan A. Burr, Branko Grunbaum, N. J. A. Sloane también obtuvieron en su artículo una nueva cota inferior para r(n, k), en concreto:

![]()

Así, por ejemplo, para las siguientes cantidades de puntos n = 13, 14, 15 y 16, se sabe que la cantidad de rectas, con tres puntos, maximal es mayor, o igual, que 22, 26, 31 y 35, respectivamente.

Recientemente, los matemáticos inglés Ben Green y australiano Terence Tao, han demostrado que la cota inferior para r(n, k) de Burr, Grunbaum y Sloane es también una cota superior, para valores suficientemente grandes de n, y por lo tanto, es el valor exacto de r(n, k), para dichos valores suficientemente grandes de n.

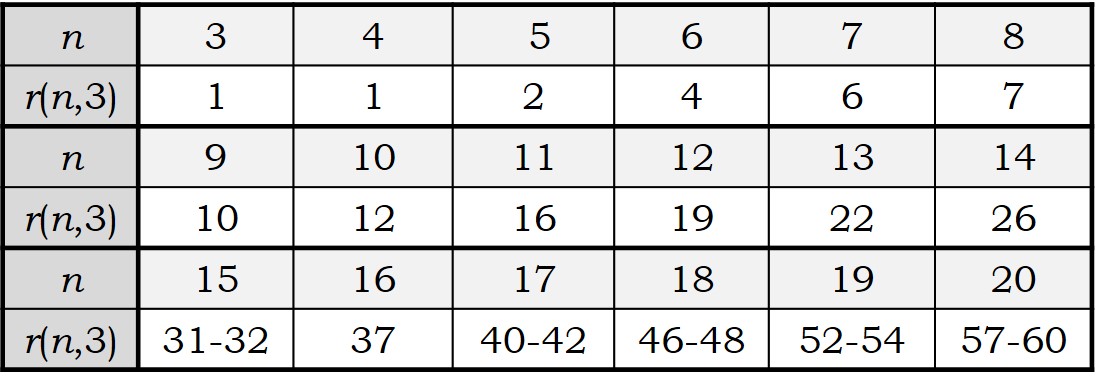

Los números r(n, 3) forman una sucesión de números enteros que aparece en la Enciclopedia On-line de Sucesiones de Números Enteros (The On-Line Encyclopedia of Integer Sequences) como la sucesión A003035.

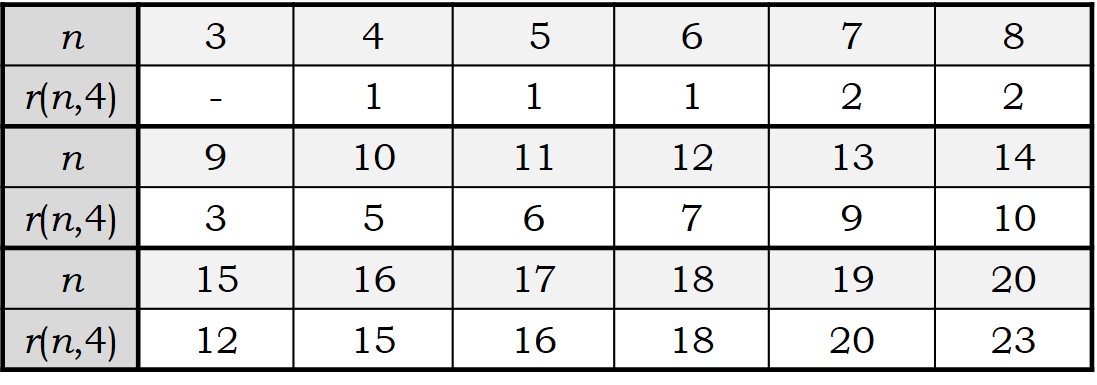

Los valores que se conocen de r(n, k), para n menor o igual que 20 son los siguientes:

Si aumentamos el número de puntos (o árboles) por línea a cuatro, k = 4, el problema de la plantación de árboles por filas, que ya era complicado para el caso clásico de 3 puntos por fila, se complica más aún.

En la actualidad se ha conseguido calcular el valor de r(n, 4) para n entre 4 y 20.

La sucesión de números r(n, 4) es la sucesión A006065 [https://oeis.org/A006065] en la Enciclopedia On-line de Sucesiones de Números Enteros (The On-Line Encyclopedia of Integer Sequences).

Los diseños maximales para valores bajos de n pueden verse en la siguiente ilustración del artículo de Martin Gardner, Problemas de plantación de árboles.

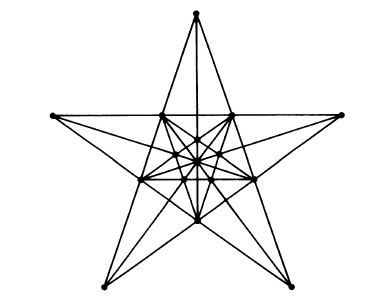

Este tipo de cuestiones han sido utilizadas por muchos expertos en matemática recreativa, como el mencionado Dudeney o el americano Sam Loyd (1841-1911), para crear problemas de ingenio. Por ejemplo, la solución óptima para 16 árboles (n = 16) fue utilizada por Dudeney en el “acertijo del Labrador” de su libro Los acertijos de Canterbury (RBA, 2007).

El acertijo del Labrador: El labrador, de quien Chaucer señaló, “Un verdadero trabajador y muy bueno era él, que vivía en paz y caridad perfectas”, se quejó de que los acertijos no eran para mentes simples como la de él, pero mostraría a los buenos peregrinos, si así lo deseaban, uno sobre el que había escuchado discutir a ciertas personas inteligentes de su vecindario: “El señor de la mansión en la región de Sussex de la que provengo tiene una plantación de dieciséis buenos robles, y están dispuestos de tal forma que hacen doce filas con cuatro árboles cada una. Una vez un hombre de gran sabiduría que iba de paso por esa zona, dijo que los dieciséis árboles podían haber sido plantados de manera que formaran quince filas rectas con cuatro árboles en cada una de ellas. ¿Podéis demostrarme cómo esto puede ser? Muchos han dudado de que sea posible de realizar.” La ilustración muestra una de las varias maneras de formar las doce filas. ¿Cómo podemos formar quince?

La solución a este acertijo es precisamente el diseño maximal de 16 puntos, con el que se forman 15 líneas rectas, con cuatro puntos en cada recta, que es un diseño simétrico hermoso y sugerente. Por lo tanto, r(16, 4) = 15.

Mucho más difícil aún es el problema para líneas que contengan 5 árboles, es decir, k = 5. En la actualidad se conocen los valores de r(n, 5), para n entre 5 y 20, en concreto, los valores son 1, 1, 1, 1, 2, 2, 2, 3, 3, 4, 6, 6, 7, 9, 10 y 11. Para los primeros n (hasta 13) las estructuras maximales son triviales, una recta de cinco puntos, dos rectas de cinco puntos con un vértice común o un triángulo.

La solución maximal para n = 15 es la siguiente.

Como Martin Gardner comenta, la solución maximal simétrica para 16 puntos, formando filas con 4 puntos, que hemos visto arriba, recuerda a la estructura de flor de la Hoya carnosa o flor de cera, que se muestra en la siguiente imagen.

Hoya carnosa o flor de cera

Bibliografía

1.- Miodrag S. Petkovic, Famous puzzles of Great Mathematicians, AMS, 2009.

2.- John Jackson, Rational Amusement for Winter Evenings, Longman, Hurst, Rees, Orme and Brown, 1821.

3.- Henry E. Dudeney, El misterio del muelle (Diversiones matemáticas III), Biblioteca Desafíos Matemáticos, RBA, 2008.

4.- Martin Gardner, Viajes en el tiempo y otras perplejidades matemáticas, Biblioteca Desafíos Matemáticos, RBA, 2007.

5.- Orchard-Planting Problem, Wolfram MathWorld.

6.- Stefan A. Burr, Branko Grunbaum, N. J. A. Sloane, The Orchand Problem, Geometriae Dedicata 2 (4), 1974, pp. 397-424.

7.- Ben Green, Terence Tao, On sets defining few ordinary lines, Discrete and Computational Geometry 50 (2), 2013, pp. 409–468.

8.- 3.- Henry E. Dudeney, Los acertijos de Canterbury, Biblioteca Desafíos Matemáticos, RBA, 2007.

9.- Tree Planting Problems, de Erich Friedman.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo El problema de la plantación de árboles en filas (2) se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El problema de la plantación de árboles en filas

- El problema de Malfatti

- El problema matemático de las cartas extraviadas

Oskolez osatutako termometroa, ezbaian

1. irudia: Ozeanoak eguzkitik datorren energia gordetzeko gai dira eta mundu osoko klima zehazteko garrantzi handia dute. (Irudia: Juanma Gallego)

Ozeanoek garrantzi handia dute kliman. Lurraren bi herenak hartzen dituzte ur masa zabalek. Datu horrek soilik agerian uzten du lur-sisteman ozeanoek duten garrantzia. Baina harago doa kontua. Izan ere, uraren ezaugarri fisiko eta kimikoak direla eta, ozeanoek eragin nabarmena dute klima globalaren nondik-norakoak zehazterakoan. Ura bero-metagailu bikaina da, hain zuzen, bertara heltzen den bero gehiena ur molekulak lotzen dituzten hidrogeno loturak apurtzeko erabiltzen baita.

Bestalde, planetan dauden 1.360 milioi kilometro kubo urek Eguzkitik datorren energiaren erdia baino gehiago xurgatzen dutela kalkulatzen da. Energia honen banaketan, gainera, funtsezko rola dute ere urek. Hala, ozeanoek ekuatorearen inguruan jasotzen den energia munduan zehar barreiatzen dute, itsasoetako ur-lasterren bitartez. Gugandik gertuko adibidera joanda, ezaguna da Golkoko ur-lasterrak Europako erdialdean eta iparraldean duen eragina. Ipar Atlantikora heltzen denean, ur-laster horrek Frantzian, Erresuma Batuan, Norvegian edota Islandian dagoen klima beharko lukeena baino epelagoa bihurtzen du. Horregatik, Ozeano Atlantikoaren beste aldean, antzeko latitudetan dauden Ipar Amerikako kostaldeak askoz hotzagoak dira.

Berotegi efektuaren eragile nagusi den karbono dioxidoa ere bertan gordetzen da, hein handi batean. Horregatik, klimatologoek arreta handiarekin ikertzen dute ozeanoek kliman duten eragina, eta, batez ere, etorkizunean izango duten rola. Klima globalak izango duen portaera argitzen saiatzeko ere antzinako klima ereduak ikertzen dituzte.

Hainbat estrategia darabiltzate horretarako. Besteak beste, aintziretako sedimentuak, izotzetik erauzitako haize burbuilak edota fosilak ikertzen dituzte. Baina azken metodo honetan arazo bat dagoela ohartarazi berri dute zenbait zientzialarik. Eta atera duten ondorioa ez da lasaitzeko modukoa. Antzinako ozeanoak orain arte uste zena baino askoz hotzagoak ziren, eta, ondorioz, gaur egun izaten ari den klima aldaketak ez omen du parekorik azken 100 miloi urteetan. Orain arte, paleoklimatologoek uste izan dute duela 100 miloi urteko ozeanoak oraingoak baino 15 gradu beroagoak zirela, batez bestean.

Nature Commnications aldizkarian eman dute ikerketaren berri Frantziako eta Suitzako ikertzaileek. Egileek azaltzen dutenez, azken 50 hamarkadetan oinarritzat hartu den kontzeptu bat okerra izan daiteke. Oinarri hori foraminiferoetan aurkitutako isotopo batean datza. Edo zetzan, orain mahai gainean jarri duten hipotesia baieztatzen bada, bederen.

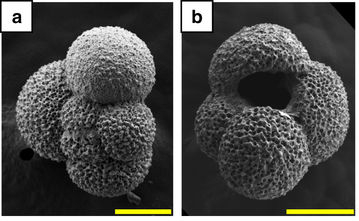

Foraminiferoak uretan bizi diren eta oskola nimiñoak sortzen dituzten protistak dira. Oskola horiei esker, aspaldi bizi ziren izakien aztarnak mundu osoko sedimentuetan gordeta mantendu dira, eta, horregatik, zientzialarientzat benetako harribitxiak dira. Erakutsi ohi zuen umore finaz lagunduta, Lynn Margulis biologo ospetsuak zioen foraminiferoen bila ibiltzen zirela bai bera bezalako txoriburuak… zein petrolioa aurkitu nahi zutenak ere. Urre beltza non dagoen jakiteko erabiltzeaz gain, besteren artean, iraganean ozeanoetan zeuden tenperaturak igartzeko erabili izan dira foraminiferoak. Oskola horietan gordeta mantendu den oxigeno-18 isotopoaren arabera kalkulatu dira tenperatura horiek. Animalia hauek bizi izan ziren garaietan, inguruko uraren tenperaturaren araberakoa omen da oskoletan mantendu den isotopoaren kopurua.

2. irudia: Foraminiferoak ozeanoetako paleotenperaturak kalkulatzeko erabiltzen dira. (Irudia: Nature Communications)

Baina ikerketa berri hau plazaratu duten zientzialariek diote isotopo hori ez dela iraunkorra eta, ondorioz, antzinako termometro gisa duten balioa hutsaren hurrengoa izan daitekeela. “Arrazoia badugu, gure ikerketa honek hamarkadatan zehar egin den ikerketa paleoklimatikoa” aldatzen duela esan du Lausanneko Unibertsitateko (Suitza) ikerlari Anders Meibonek, prentsa ohar batean.

Termometro natural horien fidagarritasuna frogatzeko, oxigeno-18 isotopoa baino ez duen uretan sartu dituzte foraminiferoak. NanoSIMS izeneko masa espektrometro baten bitartez, oskoletan zenbat oxigeno-18 sartzen den zenbatu dute. Egiaztatu dutenez, isotopoa erraz sar daiteke oskoletan, ageriko aldaketak eragin gabe. Ondorioz, isotopo hori milioika urtez aldatu gabe berdin mantendu izanaren ideia alboratu dute zientzialari hauek.

Gakoa berroreka izeneko prozesu batean datza. Egin duten interpretazioaren arabera, azken 100 milioi urte hauetan ez da egon tenperaturen beherakada gradual bat eta oskoletan gordeta dagoen isotopoaren kopurua sedimentazio prozesuan gertatutako aldaketei zor zaio. Sedimentazio hori gertatzean tenperaturek 20-30 gradu igotzen omen dira eta, ozeanoetako tenperatura islatu beharrean, fosilek une horretan jasandako tenperaturen gorakadaren isla erakutsiko lukete.

Denboran zehar oso ondo mantendu diren fosilak badirudite ere, errealitatea bestelakoa dela esan du CNRS Frantziako Zientzia Ikerketarako Gunean lan egiten duen Sylvain Bernard zientzialariak.

Ordenagailu bidezko simulazioetan ikusi dute ozeanoetako tenperaturak uste baino hotzagoak izan litezkeela eta orain ozeanoetan izaten ari den tenperaturen gorakadak parekorik ez duela azken 100 milioi urteetan. Ondorioz, antzinako klimak zehazteko erabiltzen diren ereduetan sedimentazio prozesuetan izandako beroketa horiek kontuan hartu behar direla diote.

Maibomek azaldu du ideia hori: “Ozeanoetako paleotenperaturak berrikusteko, orain berroreka hori tentu handiz kalkulatu behar dugu, denbora asko egon baikara hori kontutan hartu gabe”. Zentzu horretan, beste motatako itsas organismoak ikertu behar direla diote, denbora geologikoan zehar sedimentuetan gertatutakoa argitu ahal izateko.

Erreferentzia bibliografikoa:

Bernard S. et al. Burial-induced oxygen-isotope re-equilibration of fossil foraminifera explains ocean paleotemperature paradoxes, Nature Communications, 26 October 2017. DOI:10.1038/s41467-017-01225-9

———————————————————————————-

Egileaz: Juanma Gallego (@juanmagallego) zientzia kazetaria da.

———————————————————————————-

The post Oskolez osatutako termometroa, ezbaian appeared first on Zientzia Kaiera.

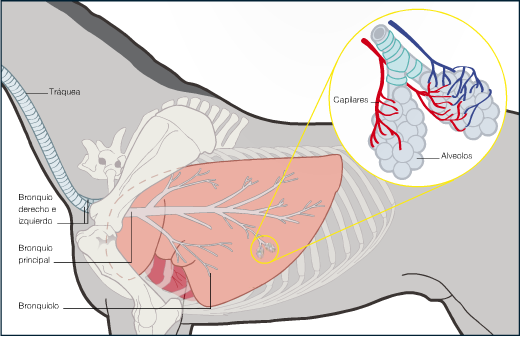

Sistemas respiratorios: el pulmón de los mamíferos

El sistema respiratorio de los mamíferos se parece poco al de las aves. Sus pulmones no están organizados como una batería de bronquios en paralelo, como el de aquellas, sino que son invaginaciones, como si fuesen bolsas hacia dentro. El aire entra por los orificios nasales, pasa por la faringe -vía que comparten los sistemas respiratorio y digestivo- y de la faringe pasa a la tráquea. El epitelio traqueal tiene dos tipos celulares. Unas células secretan mucus y las otras tienen unos cilios que baten hacia el exterior; de esa forma expulsan las partículas de polvo e impurezas que penetran por la nariz en el sistema, protegiendo así el epitelio respiratorio. La tráquea se divide en dos bronquios, cada uno de los cuales penetra en un pulmón. Los bronquios se ramifican en bronquiolos cada vez más finos de forma muy similar a como surgen las ramas de un árbol. Los primeros son los bronquiolos terminales; esos dan lugar a los bronquiolos respiratorios, que son cada vez más finos y cortos, hasta que el último llega a un alveolo.

En la mayor parte de los mamíferos la tráquea y los bronquiolos de mayor calibre son bastante rígidos, y su estructura se sostiene gracias a una serie de anillos cartilaginosos. Conforme se van subdividiendo pierden la protección cartilaginosa y sus paredes pasan a estar provistas de musculatura lisa. Esa musculatura está inervada por el sistema nervioso autónomo y es sensible a ciertas hormonas y sustancias químicas de origen local. De esa forma se controla el grado de apertura de los bronquiolos y, por lo tanto, el flujo de aire a los alveolos.

Los pulmones se encuentran en el interior del denominado saco pleural, un saco cerrado de doble pared que separa al pulmón del resto de estructuras presentes en la caja torácica. Las dos láminas de la pleura están en contacto una con la otra; casi no hay espacio entre ambas. Producen un fluido intrapleural que lubrifica las superficies de ambas capas cuando se desliza una sobre la otra con los movimientos respiratorios.

Los alveolos son las estructuras respiratorias básicas de los pulmones de mamíferos. Tienen forma esférica o próxima a la de una esfera y tienen unos poros, denominados poros de Kohn, que conectan alveolos adyacentes y permiten el flujo de aire entre ellos; ese intercambio se denomina ventilación colateral. La anatomía alveolar minimiza la distancia de difusión (se pueden consultar los límites a la difusión de gases en virtud de la ley de Fick aquí). La pared que envuelve a cada alveolo está formada por una sola capa de células muy planas –células alveolares o neumocitos de tipo I- y la pared de los capilares también está formada por una sola capa de células. De esa manera, la distancia que ha de recorrer el oxígeno del aire respirado desde la luz del alveolo hasta los capilares sanguíneos que irrigan el espacio intersticial no supera los 0,25 µm; es una distancia de difusión ínfima. La red de capilares que cubre los alveolos es tan densa que se podría decir que una fina película de sangre los envuelve. Además de las células planas antes citadas, en el epitelio hallan acomodo unas pocas células alveolares o neumocitos de tipo II, cuyo cometido es el de secretar un surfactante pulmonar, complejo de fosfolipoproteinas que facilita la expansión del pulmón. Los alveolos carecen de musculatura, por lo que no hay intervención pulmonar en el inflado y desinflado del pulmón. Son los cambios en las dimensiones del tórax, que se producen como consecuencia de los movimientos de inspiración y espiración, los que producen la succión del aire desde el exterior y su posterior expulsión. Un tercer tipo celular presente en los alveolos –en este caso en la luz- son los macrófagos para la defensa frente a microorganismos.

Además de minimizar la distancia de difusión, la anatomía pulmonar también maximiza la superficie disponible para el intercambio de gases. Cada pulmón tiene del orden de 350 millones de alveolos; o sea, son 700 millones en total. Y la superficie interna de todos esos alveolos viene a ser de 70 m2, el equivalente a una pista de tenis. Merece la pena señalar que si los pulmones fuesen bolsas simples sin la estructura alveolar interna, la superficie total sería del orden de 0,01 m2. La diferencia, a la vista está, es abismal.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Sistemas respiratorios: el pulmón de los mamíferos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Sistemas respiratorios: peces capaces de respirar en aire y anfibios

- Sistemas respiratorios: los pulmones de reptiles y aves

- Sistemas respiratorios: invertebrados terrestres

La paradoja de la reversibilidad

A fines del siglo XIX, un pequeño pero influyente grupo de científicos comenzó a cuestionar los supuestos filosóficos básicos de la mecánica newtoniana. Incluso cuestionaron la idea misma de átomo. El físico austríaco Ernst Mach, figura muy influyente, argumentaba que las teorías científicas no deberían depender de asumir la existencia de cosas (como los átomos) que no podían observarse directamente. Era cuestión de tiempo que estos científicos se dedicasen a esgrimir argumentos con los que poner en cuestión la teoría cinética. Asumiendo que la segunda ley era la piedra de toque definitiva emplearon especialmente dos aparentes contradicciones que se conocen como la paradoja de la reversibilidad (o de Lochsmidt) y la paradoja de la recurrencia. Según ellos, estas dos paradojas demostraban la incompatibilidad entre la segunda ley y la teoría cinética.

La paradoja de la reversibilidad

Fueron dos defensores de la hipótesis atómica, como se conocía entonces, William Thomson (Lord Kelvin) en 1874 y Josef Loschmidt en 1876, los que descubrieron la paradoja de la reversibilidad. No se consideró como una objeción seria a la teoría cinética hasta veinte años después. La paradoja se basa en el simple hecho de que las leyes del movimiento de Newton son reversibles en el tiempo.

Por ejemplo, si vemos un vídeo de una pelota que rebota, es fácil saber si la cinta de video se está moviendo hacia delante o hacia atrás: sabemos que las colisiones de la pelota con el suelo son inelásticas y que la pelota sube menos cada vez que rebota. Sin embargo, si la pelota hiciera rebotes perfectamente elásticos, subiría a la misma altura después de cada rebote. En este caso no podríamos decir el vídeo va hacia adelante o hacia atrás.

En la teoría cinética, se supone que las moléculas producen colisiones perfectamente elásticas. Imaginemos que se pudiese hacer un vídeo de moléculas de gas colisionando elásticamente de acuerdo con esta suposición. Al visionar este vídeo, no habría forma de saber si va hacia adelante o hacia atrás. En cualquier caso mostraría secuencias válidas de colisiones. Pero aquí está la paradoja: consideremos vídeos de interacciones que involucren objetos grandes, que contienen muchas moléculas. Podemos decir de inmediato la diferencia entre la dirección de tiempo hacia adelante (verdadera) y hacia atrás (imposible). Por ejemplo, una bombilla rota no se reconstruye en la vida real, aunque un vídeo que se ejecute hacia atrás puede hacer que parezca que lo hace. Y esto contradice un principio básico de las leyes de Newton.

En efecto, la teoría cinética se basa en leyes de movimiento que suponen que los movimientos son reversibles para cada interacción molecular individual. ¿Cómo, entonces, puede explicar la existencia de procesos irreversibles a gran escala, que involucran muchas colisiones moleculares? La existencia de procesos así parece indicar que el tiempo fluye en una dirección definida, es decir, del pasado al futuro. Esto contradice la posibilidad, implícita en las leyes del movimiento de Newton, de que, cuando se trata de observar fenómenos físicos, no importa si pensamos que el tiempo fluye hacia adelante o hacia atrás. Thomson lo expresó de esta manera:

Si […] el movimiento de cada partícula de materia en el Universo se invertiese precisamente en cualquier instante, el curso de la naturaleza daría simplemente marcha atrás para siempre. La burbuja de espuma que estalla al pie de una cascada se reformaría y descendería al agua; los movimientos térmicos reconcentrarían su energía y arrojarían la masa hacia arriba por la cascada en gotas que se transforman en una columna cerrada de agua ascendente. El calor generado por la fricción de los sólidos y disipado por conducción, y radiación por absorción, volvería nuevamente al lugar de contacto y arrojaría el cuerpo en movimiento contra la fuerza a la que había cedido previamente. . . . Pero los fenómenos reales de la vida trascienden infinitamente la ciencia humana; y la especulación con respecto a las consecuencias de su reversión imaginaria es completamente improductiva.

El mismo Thomson, y más tarde Boltzmann, utilizaron la probabilidad estadística para explicar por qué no observamos tales reversiones a gran escala. Hay un número casi infinito de posibles disposiciones desordenadas de moléculas de agua en la caída de una cascada. Solo un número extremadamente pequeño de estas disposiciones conduciría al proceso descrito por Kelvin. Las reversiones de este tipo son posibles en principio pero, a todos los efectos prácticos, la naturaleza estadística de la segunda ley los hace imposibles.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo La paradoja de la reversibilidad se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Otras predicciones del modelo cinético. Movimiento browniano

- La ley del gas ideal a partir del modelo cinético

- Los antecedentes de la teoría cinética

Elikaduraz jabetzeko aplikazioa

Norberaren elikadura osasuntsua den edo ez ezagutzeko aplikazioa da Elika. Elikaduraren kontrola egiteko elikagaien erregistroa baliatzen du aplikazioak eta baita gomendatutako dieta osasuntsuarekin alderatzeko aukera eskaini.

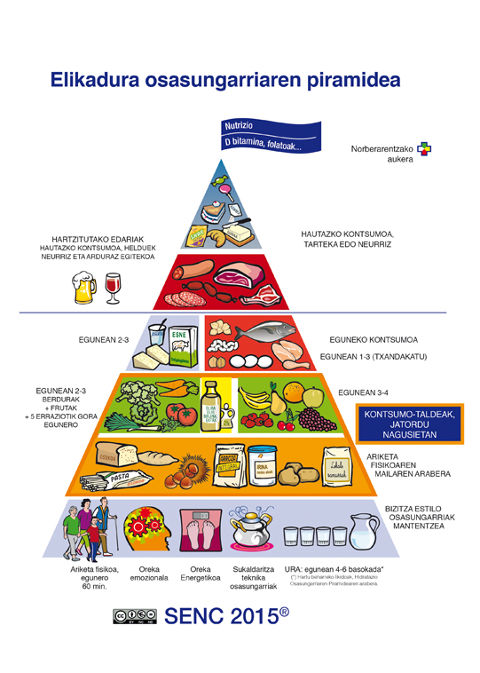

SENCek gomendatutako errazioetan oinarritzen da aplikazioaren dieta osasuntsua, gehiengo zabal batentzako erabilgarria dena. Elikagaien oreka pertsona guztientzat da berdina. Kantitateak aldatzen direla, baina elikagaiaen banaketa berbera dela azaldu du Bittor Rodriguez elikagaien teknologoak.

1. irudia: SENCek 2016an argitaratutako elikadura piramidea.

Nutrizio eta Bromatologia Saileko ikertaldeak garatutako elikadura erregistroan dago oinarrituta aplikazioa. Norberak kontsumitzen dituen elikagaiak aplikazioan erregistratzen dira eta, honela bi gauza lortzen dira:

- Jabekuntza. Dietaren erregistroa egitearekin batera, erabiltzaileak kontsumitzen dituen elikagaien kontzientzia hartzen du. Bittor Rodriguezek esaten duen moduan: “Askotan esaten da ‘denetarik jaten dut nik’, baina erregistroa egiterakoan horrela ez dela ikusten da”.

- Alderaketa. Bakoitzaren dieta eta dieta osasuntsua zuzenean alderatzeko aukera eskaintzen du aplikazioak, hutsuneak topatu eta zuzendu ahal izateko.

Dieta osasuntsua bultzatzeko helburua ere badu aplikazioak. Hartara, janari prozesatuak ezin dira erregistratu aplikazioan, nahita ez dira jasotzen. Janari prozesatu gabeen kontsumoa bultzatu nahi da honela: kontsumitutako elikagaiak aplikazioan erregistratzerik ez badago, prozesatu gabeko elikagaiak kontsumitzea sustatuko duelakoan.

Euskal Herriko Unibertsitateko Elikadura eta Gizentasuna Ikerketa Taldearekin (CIBERobn ISCIII) eta Dietetikako eta Nutrizioko Espainiako Elkarte Zientifikoa (SEDYN) erakunde zientifikoak garatutako aplikazioa da, Gasteizko Udalaren eta Elika erakunde publikoaren laguntzarekin.

Android nahiz iOS sistemadun mugikorretarako dago eskuragarri aplikazioa, erabat dohainik deskargatu daiteke bai Play Storen bai Apple Storen.

Norberaren elikadura osasuntsua den ala ez ezagutzeko modu erraza da aplikazioa. Hautaketa-pantaila sinple baten bidez egunero kontsumitutako elikagaien erregistroa eraman eta eguneko txosten bat sortzen du aplikazioak. Bertan, dieta osasungarri eta orekatu batekin alderatzen du eta hobetzeko gomendioak eskainitzen ditu. Zazpi egunean behin, gainera, asteko txostena sortzen du.

.Ez da, hala ere, elikaduraren harira egin den ekimen bakarra. Elikadura osasungarriaren aldeko ekimenak aurkeztu du Eusko Jaurlaritzak, elikadura osasungarria denon eskura izateko helburua duena. Horretarako, bost ildo estrategiko eta 18 prestatu dira. Proiektuen artean aplikazio baten garapena dago: “Elikadura osasungarriaren liga”. Gazteen artean ohitura osasungarriak sustatzeko app ludiko-pedagogikoa da. Lehia sanoa sustatzen duen sailkapena baliatuta, fruta eta barazki kontsumoa handitzea da helburua, jolas eta sari sistema baten bidez gazteak bizimodu osasungarrira atxikitzeko.

———————————————————————–

Egileaz: Ziortza Guezuraga kazetaria eta UPV/EHUko Kultura Zientifikoko Katedraren kolaboratzailea da.

——————————————————————

The post Elikaduraz jabetzeko aplikazioa appeared first on Zientzia Kaiera.

Keats vs Feynman, mejor vídeo de divulgación “On zientzia”

“Keats vs. Feynman” de Patxi Razkin es el vídeo ganador del premio al mejor vídeo de divulgación de la 7ª edición de los premios On Zientzia. En menos de 4 minutos explora esa dimensión de la belleza desconocida para aquellos que renuncian a saber algo de ciencia.

Ya está en marcha la 8ª edición de On zientzia.

¿Tienes una idea genial para explicar un concepto científico en un vídeo? ¿Quieres ver tu trabajo emitido en televisión? La Fundación Elhuyar y el Donostia International Physics Center (DIPC) han organizado la octava edición de On zientzia, un concurso de divulgación científica y tecnológica enmarcado en el programa Teknopolis, de ETB. Este certamen pretende impulsar la producción de vídeos cortos y originales que ayuden a popularizar el conocimiento científico.

On zientzia tendrá tres categorías. El mejor vídeo de divulgación recibirá un premio de 3.000 euros. Para impulsar la producción de piezas en euskera, existe un premio de 2.000 euros reservado a la mejor propuesta realizada en ese idioma. Por último, con el objetivo de impulsar la participación de los estudiantes de ESO y Bachillerato, hay un premio dotado con 1.000 euros para el mejor vídeo realizado por menores de 18 años.

Los vídeos han de tener una duración inferior a los 5 minutos, se pueden realizar en euskera, castellano o inglés y el tema es libre. Deben ser contenidos originales, no comerciales, que no se hayan emitido por televisión y que no hayan resultado premiados en otros concursos. El jurado valorará la capacidad divulgativa y el interés de los vídeos más que la excelencia técnica.

Las bases las encuentras aquí. Puedes participar desde ya hasta el 25 de abril de 2018.

Edición realizada por César Tomé López

El artículo Keats vs Feynman, mejor vídeo de divulgación “On zientzia” se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- On Zientzia, un concurso para divulgadores audiovisuales

- Vídeo ganador del premio especial del jurado de Ciencia Clip: “Nanotecnología”

- OnZientzia: Cogeneración

El altruismo en las mujeres se ve recompensado

Al parecer, el comportamiento generoso o altruista es más frecuente en las mujeres que en los hombres. Y esa diferencia está relacionada con diferentes niveles de actividad de sus respectivos sistemas de recompensa en respuesta a uno u otro tipo de comportamiento, altruista o egoísta. En otras palabras, el comportamiento altruista suele resultar más grato a las mujeres que lo practican, mientras que ocurre lo propio a los hombres cuando se comportan de forma egoísta. Este es el resumen de una serie de experimentos a cargo de Alexander Soutschek y colaboradores, de la Universidad de Zurich, cuyos resultados se han publicado recientemente en la revista Nature Human Behaviour.

El sistema de recompensa es un conjunto de estructuras encefálicas responsables de la cognición ligada a las recompensas. Incluye el aprendizaje asociativo, la generación de incentivos o motivación (como el deseo, por ejemplo, o el gusto por ciertas cosas) y las emociones positivas, como el placer. Es por ello el responsable de que experimentemos sensaciones placenteras cuando satisfacemos necesidades fisiológicas esenciales para nuestra supervivencia y reproducción, cuando hacemos cosas que nos gustan o cuando consumimos sustancias a las que nos hemos hecho adictos.

Los investigadores diseñaron una serie de experimentos en los que redujeron con un fármaco la actividad de las vías dopaminérgicas1 del sistema de recompensa, tanto en hombres como en mujeres. Lo que observaron es que al reducir la sensibilidad de las vía dopaminérgicas en mujeres, estas reducían su comportamiento prosocial; en otras palabras, ante la disyuntiva de comportarse de forma generosa o de forma egoísta, tendía a disminuir el comportamiento generoso en beneficio del egoísta. Y en los hombres ocurría lo contrario: al ser tratados para reducir la actividad de las vías dopaminérgicas, se reducía la tendencia al comportamiento egoísta en beneficio de las decisiones generosas.

Esas observaciones confirman, por un lado, que hay diferencias entre hombres y mujeres en su tendencia a comportarse de forma generosa o egoísta. Las mujeres, como se ha dicho, tienden a tener comportamientos y actitudes prosociales (generosidad, altruismo, aversión a la desigualdad), mientras que los hombres, por comparación, tienden a comportarse de forma más egoísta. Y por otro lado, el hecho de que los circuitos de recompensa respondan en cada caso a uno u otro tipo de comportamiento quiere decir que la toma de decisiones de unas y de otros tiende a guiarse por incentivos o motivaciones opuestas. Este elemento es muy importante de cara a los estudios sobre toma de decisiones sociales, pues deberán tener en cuenta el sexo de los individuos que intervengan como objetos experimentales.

Por último, conviene advertir de que las diferencias observadas en este trabajo no tienen por qué ser innatas o debidas a una determinada arquitectura neuronal prefijada en virtud del sexo. Precisamente, dado que la actividad dopaminérgica participa en el aprendizaje asociativo ligado a recompensas y que codifica el valor aprendido de acciones o estímulos, el procesamiento de las recompensas puede ser el resultado de la educación o de las expectativas culturales. En otras palabras, los resultados aquí reseñados no implican que las diferencias documentadas sean independientes de los estereotipos propios de cada sexo. De hecho, esos estereotipos podrían funcionar como profecías autocumplidas y dar lugar a estas diferencias. Así, si desde la infancia temprana las mujeres perciben actitudes más favorables hacia ellas en respuesta a comportamientos prosociales, ello bien puede conducir a interiorizar esos comportamientos como normas culturales, lo que provocaría que el comportamiento prosocial les resulte más valioso. Todo ello, por supuesto, por comparación con los hombres.

Fuente: A. Soutschek, C. J. Burke, R. Schreiber, S. C. Weber, I. I. Karipidis, J. Ten Velden, B. Weber, H. Haker, T. Kalenscher y P. n. Tober (2017): The dopaminergic reward system underpins gender differences in social preferences. Nature Human Behaviour doi: 10.1038/s41562-017-0226-y

Nota:

1 Se refiere a vías cuyo neurotransmisor es la dopamina. En el sistema de recompensa hay circuitos con otros neurotransmisores, además de la dopamina, como GABA y glutamato.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo El altruismo en las mujeres se ve recompensado se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La menor influencia de las mujeres en Internet

- La unidad de selección en la evolución y el origen del altruismo (8): Selección de parentesco y altruismo recíproco

- La unidad de selección en la evolución y el origen del altruismo (5): Mayr y Gould, dos evolucionistas frente al gen egoísta

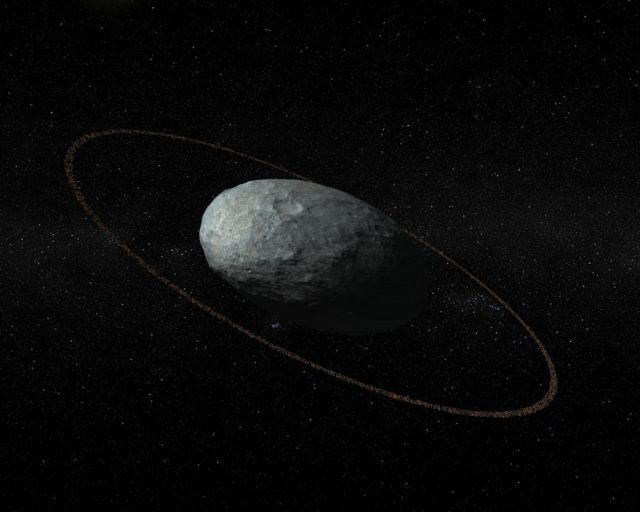

Haumea planeta ñimiñoak eraztuna du

1. irudia: Haumearen eta bere eraztunaren kontzepzio artistikoa, proportzioak gordeta. (Instituto de Astrofísica de Andalucía, IAA-CSICren irudia)

Neptunoren orbitatik haratago izotzez eta arrokaz osaturiko objektu gerriko bat dago, Kuiper. Besteren artean, lau planeta ñimiño daude han: Pluton, Eris, Makemake eta Haumea. Azken hau da guztien artean ezezagunena. Mundu mailako kanpaina egin da planeta behatzeko, haren ezaugarri fisiko nagusiak zehazteko asmoz. Izar estaltze bati esker zehaztu ahal izan dira gerriko transneptunotarreko Haumea planeta ñimiñoaren ezaugarri fisiko nagusiak.

Haumearen inguruan eraztun bat dagoela jakitea izan da ikerketaren aurkikuntza interesgarri eta ustekabekoenetako bat. Duela gutxira arte, planeta erraldoien inguruan bakarrik ezagutzen ziren eraztunak. Eraztun trinkoak aurkitu ziren orain dela oso gutxi zentauroak deituriko objektuen familiakoak bi gorputz txikitan (Chariklo, 2014. urtean eta Chiron 2015. urtean bi ikerketa taldek aurkitu zuten MIT eta Alikanteko Unibertsitateak).

Eguzkiaren inguruan biratzen da Haumea, 248 urte behar dituen orbita eliptikoan eta 3,9 orduan osatzen du errotazioa, Eguzki Sistema osoko ehun kilometrotik gorako beste edozein gorputzek baino askoz ere azkarrago. Abiadura dela eta, deformatu eta errugbi baloi baten antzeko forma elipsoidala hartzen du planetak. Alderdirik luzeenean Haumeak 2.320 kilometro inguru neurtzen duela (ia-ia Plutonek bezainbeste), baina ez daukala Plutonen antzeko atmosfera globalik jakin da egindako behaketari esker. Haumearen eraztuna ekuatore planoan dago eta 3:1eko erresonantzia du planetaren errotazioarekiko, hau da, planeta hiru aldiz biratzen den denboran eraztuna osatzen duten partikula izoztuek bira bat ematen diote planetari.

Ikerketa konplexuaOso zaila da objektu transneptunotarrak ikertzea: txiki-txikiak direlako, ia distirarik ez daukatelako eta oso-oso urrun daudelako. Oso eraginkorra baina korapilatsua den metodoa dago: izar estaltzeak aztertzea. Objektuak hondoko izarren aurretik igarotzen direneko aldiari behatzean datza izar estalketa (eklipse txiki moduko bat).

Objektuaren ezaugarri fisiko nagusiak identifika daitezke (tamaina, forma, dentsitatea) modu honetan. Eris eta Makemake planeta txikiekin ere erabili izan da eta baita emaitza bikainak lortu ere.

2017ko urtarrilaren 21ean Haumea izar baten aurretik igaroko zela aurreikusi zen eta, hartara, Europako hamar behatokitako hamabi teleskopiok fenomenoari behatu zioten. Zehaztasun handiarekin berritu ahal izan dira Haumea planeta ñimiñoaren forma eta tamaina. Emaitza harrigarria lortu da, gainera, uste zena baino dezente handiagoa baita eta ez da uste zen bezain islatzailea. Horretaz gain, pentsatzen zena baino askoz ere dentsitate txikiagoa du.

Planetaren inguruan eraztun bat dagoela aurkitzea izan da, aurkikuntza nagusia. Hainbat arrazoi posible daude eraztuna nola sortu zen azaltzeko. Beste objektu batekin talka egitearen ondorioz sortu izana edo Haumearen errotazio bizkorrak gainazaleko material zati bat askatu zuelako sortu izana, esaterako. Objektu transneptunotar baten inguruan eraztun bat aurkitzen den aurreneko aldia da eta Eguzki Sisteman nola beste planeta sistema batzuetan uste zena baino eraztun gehiago egon litezkeela erakusten du.

Iturria: UPV/EHUko prentsa bulegoa: Haumeak, Plutonen kideetako bitxienak, eraztuna du

Erreferentzia bibliografikoa

J. L. Ortiz, Santos-Sanz et al.. The size, shape, density and ring of the dwarf planet Haumea from a stellar occultation”.. Nature, (2017). DOI: 10.1038/nature24051.

The post Haumea planeta ñimiñoak eraztuna du appeared first on Zientzia Kaiera.

La comida en la basura

Más de 40 kg de alimentos perfectamente consumibles encontrados en la basura de hogares neozelandeses en un muestreo realizado en 2014 por Love Food Hate Waste NZ. El hogar promedio neozelandés tira el doble al año. Fuente