La evolución en mosaico de «Homo sapiens»

El estudio del genoma de nuestros parientes más cercanos, los neandertales y los denisovanos, ha abierto nuevas vías de investigación para comprender mejor nuestra historia evolutiva. Un estudio liderado por la Universidad de Barcelona ha estimado cuándo surgieron algunas de las variantes genéticas que caracterizan a nuestra especie a partir del análisis de mutaciones que son muy frecuentes en las poblaciones humanas modernas, pero no en estas otras especies de humanos arcaicos. Los resultados aportan nuevos indicios de la evolución en mosaico para nuestra especie. Además, muestran dos momentos en los que se concentran las mutaciones: uno temprano, de hace alrededor de 40.000 años, asociado al crecimiento de la población de Homo sapiens y su salida de África, y otro más antiguo, de hace más de 100.000 años, relacionado con la etapa en la que más tipos de Homo sapiens había en África.

«La comprensión de la historia profunda de nuestra especie es cada vez más completa. Aun así, es difícil determinar cuándo surgieron las variantes genéticas que nos distinguen de otras especies humanas. En este estudio hemos colocado variantes específicas de nuestra especie en una línea cronológica. Así, hemos descubierto de qué manera se concentran estas variantes en el tiempo, lo que ha reflejado eventos como el punto de divergencia del Homo sapiens respecto a otras especies humanas hace cerca de 100.000 años», explica Alejandro Andirkó, primer autor de este artículo, que ha surgido de su tesis doctoral en la UB.

Imagen: Rob Mulally / UnsplashPredominio de variaciones relacionadas con la conducta y la anatomía facial

Imagen: Rob Mulally / UnsplashPredominio de variaciones relacionadas con la conducta y la anatomía facial

Los resultados de la investigación también muestran diferencias entre periodos evolutivos. En concreto, han constatado el predominio de variaciones genéticas relacionadas con la conducta y la estructura anatómica facial —características clave en la diferenciación de nuestra especie respecto al resto de las humanas— hace más de 300.000 años, una datación que coincide con la evidencia fósil y arqueológica disponible. «Hemos descubierto conjuntos de variantes genéticas que afectarían a la evolución de la cara y que hemos datado entre los 300.000 y los 500.000 años, justo el período anterior a la datación de los fósiles más tempranos de nuestra especie, como los descubiertos en el yacimiento arqueológico de Jebel Irhoud, en Marruecos», destaca Alejandro Andirkó.

Los investigadores también han analizado las variantes relacionadas con el cerebro, al que consideran el órgano que mejor puede ayudar a explicar las características clave del rico repertorio de comportamientos asociados con el Homo sapiens. En concreto, han datado variantes que se han relacionado con el volumen cerebral del cerebelo, el cuerpo calloso y otras estructuras en estudios médicos con humanos actuales. «Hemos descubierto que los tejidos cerebrales tienen un perfil de expresión genómica particular en distintos momentos de nuestra historia; es decir, ciertos genes relacionados con el desarrollo neuronal se expresaban más en ciertos momentos», resalta el investigador.

Reforzada la hipótesis de la evolución en mosaicoEstos resultados se complementan con una idea que es dominante en la antropología evolutiva hoy en día: que la historia de las especies humanas no es lineal, sino que distintas ramas de nuestro árbol evolutivo convivieron y muchas veces se cruzaron. «La amplitud del rango de diversidad de humanos en el pasado ha sorprendido a los antropólogos. Incluso dentro de los Homo sapiens existen fósiles, como los que he comentado antes de Jebel Irhoud, que debido a sus rasgos se llegó a pensar que pertenecían a otra especie. Por eso decimos que el ser humano ha vivido una evolución en mosaico», detalla Andirkó.

«Nuestros resultados —continúa el investigador— ofrecen una imagen de cómo cambió nuestra genética que se ajusta a esa idea, ya que no hemos encontrado evidencia de cambios evolutivos que dependieran de una mutación clave o de un puñado de ellas», subraya.

La metodología para llevar a cabo este estudio se ha basado en un método de estimación genealógica de edad de variantes (genealogical estimation of variant age) desarrollado por investigadores de la Universidad de Oxford. A partir de esta estimación, se ha aplicado una herramienta de aprendizaje automático para predecir qué genes han cambiado más en ciertos períodos y en qué tejidos estos genes pueden haber tenido un impacto mayor. En concreto, han utilizado ExPecto, una herramienta de aprendizaje profundo que usa una red convolucional —un tipo de modelo computacional— para predecir niveles de expresión de un gen y su función desde una secuencia de ADN.

«Como no existen datos sobre la expresión genómica de variantes en el pasado, esta herramienta es una aproximación a un problema que no se había podido responder hasta ahora. Aunque la predicción por aprendizaje automático es cada vez más común en el mundo clínico, que sepamos, no se había intentado usar para predecir las consecuencias de cambios genómicos a lo largo del tiempo», subraya Andirkó.

La importancia de la fase perinatal en el desarrollo del cerebro de nuestra especieEn un estudio previo, el mismo equipo de la UB, junto con el investigador Raül Gómez Buisán, también había utilizado la información genómica de los humanos arcaicos. Se trata de una investigación en la que analizaron los desiertos genómicos, regiones del genoma de nuestra especie donde no hay fragmentos genéticos de neandertales o denisovanos, y que, además, han sido sometidas a presión positiva en nuestra especie, es decir, que han acumulado más mutaciones de lo esperado por evolución neutral. Los investigadores estudiaron la expresión de genes —qué proteínas codifican para llevar a cabo diferentes funciones— hallados en estas regiones desérticas a lo largo del desarrollo del cerebro, desde fases prenatales hasta la etapa adulta, y cubriendo dieciséis estructuras cerebrales. Los resultados mostraron diferencias en la expresión génica del cerebelo, el cuerpo estriado y el tálamo. «Estos resultados ponen el foco en la relevancia de estructuras del cerebro más allá de la neocorteza, la cual ha sido tradicionalmente predominante en la investigación de la evolución del cerebro humano», explica Juan Moriano.

Además, las diferencias más notorias entre estructuras cerebrales se encontraron en las etapas prenatales. «Estas conclusiones suman nuevos indicios a la hipótesis de una trayectoria del desarrollo del cerebro específico de nuestra especie que tiene lugar en etapas perinatales —el período que comprende desde la semana 22 de gestación hasta las primeras cuatro semanas de vida neonatal—, lo que daría lugar a una forma más globular de la cabeza en los humanos modernos, en contraste con la forma más alargada en neandertales», concluye Juan Moriano.

Referencia:

Andirkó, A.; Moriano, J.; Vitriolo, A.; Kuhlwilm, M.; Testa, G., y Boeckx, C. (2022) Temporal mapping of derived high-frequency variants supports the mosaic nature of the evolution of Homo sapiens Scientific Reports doi: 10.1038/s41598-022-13589-0

Para saber más:

¿Qué factores han impulsado la evolución cognitiva en el linaje humano?

Edición realizada por César Tomé López a partir de materiales suministrados por la Universidad de Barcelona

El artículo La evolución en mosaico de «Homo sapiens» se ha escrito en Cuaderno de Cultura Científica.

Qué es y qué no es inteligencia artificial

Victor Etxebarria Ecenarro

Detalle de «Ragazza de Trieste» de Joseph Ayerle. Muestra la imagen del rostro de la actriz Ornella Mutti tratada por una «inteligencia artificial» que ha sido entrenada para reproducir el estilo y las técnicas pictóricas que empleó Rafaello Sanzio (Rafael) (1483-1520) en su obra «La Fornarina» (1518/19). Fuente: Wikimedia Commons

Detalle de «Ragazza de Trieste» de Joseph Ayerle. Muestra la imagen del rostro de la actriz Ornella Mutti tratada por una «inteligencia artificial» que ha sido entrenada para reproducir el estilo y las técnicas pictóricas que empleó Rafaello Sanzio (Rafael) (1483-1520) en su obra «La Fornarina» (1518/19). Fuente: Wikimedia CommonsEn los últimos años el término inteligencia artificial y todo lo que tiene que ver con ello está adquiriendo un gran protagonismo y sobredimensionamiento. La expresión inteligencia artificial está siendo abusada y utilizada de forma básicamente incorrecta diariamente y en múltiples ámbitos cotidianos, desde el político al empresarial.

¿Existen realmente máquinas inteligentes, similares a las personas? Si respondemos a esta pregunta con cierto rigor, desde las bases de las ciencias fundamentales que soportan los pilares de este área –matemáticas y física–, la respuesta es que no. Y muchos científicos conjeturan y argumentan seriamente que probablemente nunca existirán.

Computar no es lo mismo que pensarPartamos de las áreas de conocimiento adyacentes a las matemáticas y la física que se expandieron desde los años 30 y 40 del siglo XX, como la ciencia de la computación, la electrónica, la automática o el propio área de inteligencia artificial. En el año 1937 vieron la luz dos publicaciones científicas de enorme importancia: la primera, Sobre los números computables, con una aplicación al Entscheidungsproblem del matemático Alan Turing, y la segunda, Análisis simbólico de relés y circuitos de conmutación, del matemático e ingeniero electrónico Claude Shannon. Estos trabajos fundaron la forma inicial de crear máquinas electrónicas capaces de computar, manejar información y manipular símbolos mediante programación algorítmica.Sin embargo, la inteligencia artificial, entendida como aquella que pretende replicar capacidades intelectuales similares a animales o personas (llamada inteligencia general o inteligencia fuerte) no se ha demostrado en absoluto. Esto es: no hay evidencia ni matemática, ni física, ni se conoce la existencia de ningún prototipo equivalente a las capacidades pensantes de un cerebro humano.

Decisión vs. elección

En 1966 el matemático y profesor de Ciencias de la Computación en el Instituto Tecnológico de Massachusetts (MIT) Joseph Weizenbaum creó en su laboratorio un programa llamado ELIZA capaz de realizar procesamiento de lenguaje natural.

Esta sencilla herramienta reconocía palabras clave en las frases del usuario para elegir una frase modelo de su base de datos con la que contestar.

ELIZA era capaz de entablar una conversación con seres humanos simulando a una psicóloga empática. Weizenbaum modeló su estilo de conversación como preguntas abiertas para animar a los pacientes a comunicarse más eficazmente con la terapeuta, y le sorprendió que su programa fuera tomado en serio por muchos usuarios.

A la vista de que gran número de admiradores consideraron el programa como verdadero precursor de las máquinas pensantes, el propio autor se vio obligado a dejar claro que consideraba esta interpretación totalmente errónea e intentó vehementemente corregir en sus intervenciones posteriores estas ideas.

Entre otros muchos escritos, Weizenbaum publicó en 1976 el libro El poder informático y la razón humana: del juicio al cálculo. Con él trataba de explicar al público en general su trabajo y sus consecuencias desde la filosofía de la ciencia, sin incluir turbadoras fórmulas matemáticas en el texto.

En el libro, el autor distingue entre las capacidades de los computadores y el razonamiento humano, y establece una distinción crucial entre decidir y elegir. Lo mismo que en la automática la decisión y control de un proceso industrial se implementa con un circuito o un computador como controlador programado de dicho proceso, Weizenbaum explica que decidir es una actividad computacional, algo que en última instancia puede programarse y, sin embargo, la elección es el producto del juicio, no del cálculo.

El papel de la mecánica cuánticaEn 1989, el físico, matemático y Premio Nobel en el año 2020 Roger Penrose publicó su influyente libro La nueva mente del emperador en el que demuestra que el pensamiento humano no es básicamente algorítmico.

A caballo entre las matemáticas, la filosofía de la ciencia y la física, el texto incorpora tanto demostraciones matemáticas como ilustradas discusiones de los famosos exámenes de inteligencia (como el test de Turing y el experimento de la habitación china). Además conjetura la posible necesidad de las leyes de la mecánica cuántica para poder explicar correctamente nuestras mentes.

La obra fue devastadora para la tradicional inteligencia artificial fuerte. Inspiró contestaciones de múltiples autores en diversas áreas de conocimiento, pero sus tesis no pudieron ser refutadas convincentemente.

Penrose avanzó aún más en sus ideas con el segundo de sus libros sobre la conciencia humana, publicado en 1994: Las sombras de la mente. En él incluye una propuesta detallada sobre cómo podrían implementarse esos procesos cuánticos en el cerebro.

Las nuevas conjeturas, en colaboración con la biología y la neurociencia médica sugeridas por Penrose, incluyen en particular el citoesqueleto de las neuronas. En concreto los microtúbulos, importantes componentes del citoesqueleto, son lugares plausibles para el procesamiento cuántico y, en última instancia, para la conciencia.

Estas ideas pueden perfectamente ser incorrectas, tal y como el propio Penrose argumenta. Muchos investigadores multidisciplinares en estos campos intentaron refutar parte de estas propuestas, pero actualmente siguen en vigor.

Sin inteligencia artificial a la vistaDesde un punto de vista global, sabemos que se han estudiado múltiples enfoques desde hace décadas para tratar de expandir la inteligencia artificial. Las redes neuronales, los sistemas expertos, la lógica fuzzy y en los últimos tiempos el deep learning y el big data han dado lugar a útiles herramientas para resolver problemas con fines específicos.

Estas herramientas pueden ser impresionantes, pero debemos tener muy claro que no nos hemos acercado al desarrollo de la inteligencia artificial general. La llamada inteligencia débil (o inteligencia estrecha) corresponde con las aplicaciones que hoy tenemos, pero las afirmaciones exageradas sobre sus éxitos, de hecho, dañan la reputación de la inteligencia artificial como ciencia.

En más de ochenta años de investigación en este área no se ha producido ninguna prueba firme de niveles humanos de inteligencia artificial general. Sabemos que los circuitos artificiales son incapaces de modelar los sistemas nerviosos incluso de los invertebrados más simples. Aún con computadores muy rápidos y con enormes bases de datos, confiar en que el razonamiento, la inteligencia y la conciencia surjan de alguna manera simplemente aumentando más y más la complejidad no parece más que un camino sin salida.

Las herramientas informáticas son muy útiles, pero aunque una máquina gane a los ajedrecistas profesionales o sea capaz de proponer un recurso legal buscando jurisprudencia en su gran base de datos, no es una máquina pensante. Es importante no banalizar, diferenciar entre herramientas tecnológicas y entes inteligentes, así como dejar a la ciencia seguir trabajando con rigor en esta apasionante materia.![]()

Sobre el autor: Victor Etxebarria Ecenarro es Catedrático de Ingeniería de Sistemas y Automática en la Universidad del País Vasco (UPV/EHU)

Este artículo fue publicado originalmente en The Conversation. Artículo original.

Para saber más:

Máquinas inteligentes (II): Inteligencia artificial y robótica

En el control de la inteligencia artificial nos jugamos el futuro

El séptimo ángel

El artículo Qué es y qué no es inteligencia artificial se ha escrito en Cuaderno de Cultura Científica.

CienciaClip 2021 – ¿Qué pasaría si el permafrost se derritiera en 24h?

Ciencia Clip es un concurso de vídeos divulgativos de ciencia diseñados, producidos y protagonizados por estudiantes de Educación Secundaria.

El objetivo del concurso es fomentar el interés por la ciencia y la tecnología. Y ofrecer a los concursantes una oportunidad para ejercitar su creatividad y habilidades comunicativas usando herramientas que proporciona internet.

Ciencia Clip es una iniciativa de la Cátedra de Cultura Científica de la UPV/EHU y en la que colaboran Euskampus Fundazioa, Naukas, Scenio y Big Van.

Los ganadores de la edición 2022 se anunciarán en la página web del concurso a principios de septiembre. La entrega premios y el anuncio del vídeo ganador del premio especial se realizarán durante el evento Naukas Bilbao. En la edición de 2021 resultó ganador en la categoría de 3º y 4º de la ESO Irene León, de Barcelona, con este vídeo:

Edición realizada por César Tomé López

El artículo CienciaClip 2021 – ¿Qué pasaría si el permafrost se derritiera en 24h? se ha escrito en Cuaderno de Cultura Científica.

Redes neuronales convolucionales para optimizar aerogeneradores

Una investigación de la Escuela de Ingeniería de Vitoria-Gasteiz de la UPV/EHU ha empleado redes neuronales convolucionales para predecir características del flujo de aire en los perfiles aerodinámicos de aerogeneradores de gran potencia, y ha demostrado que los dispositivos de control de flujo pueden ser estudiados mediante estas redes neuronales, con errores aceptables y una reducción del tiempo computacional en cuatro órdenes de magnitud.

Detalle de una turbina eólica del parque eólico Badaia, en Álava. Fuente: Wikimedia Commons

Detalle de una turbina eólica del parque eólico Badaia, en Álava. Fuente: Wikimedia CommonsLa energía eólica se ha convertido en una importante fuente de generación de electricidad dentro de un modelo energético más limpio y sostenible. Sin embargo, es necesario mejorar el rendimiento de los aerogeneradores para poder competir con los recursos energéticos convencionales. Para contribuir esta mejora se implementan dispositivos de control de flujo en los perfiles aerodinámicos, con objeto de incrementar la eficiencia aerodinámica de los rotores de los aerogeneradores: “Así, con el mismo aerogenerador se pueden producir más megavatios, el coste del megavatio hora se reduce, y eso trasladado, por ejemplo, a una turbina eólica situada en el mar (que son enormes), resulta que el coste de implementación es ínfimo, pero la mejora aerodinámica puede rondar hasta el 8 o 10%”, explica Unai Fernández Gámiz, profesor del Departamento de Ingeniería Nuclear y Mecánica de Fluidos de la UPV/EHU.

Las simulaciones de dinámica de fluidos computacional (CFD, de su nombre en inglés) son el método más popular utilizado para analizar este tipo de dispositivos: “Se trata de un software que simula el movimiento de los fluidos, que necesita una gran capacidad computacional, es decir, computadores muy potentes y mucho tiempo de computación”, explica Fernández Gámiz.

En los últimos años, con el crecimiento de la Inteligencia Artificial, la predicción de las características del flujo mediante redes neuronales es cada vez más popular; en esta línea, el alumno de la UPV/EHU Koldo Portal Porras ha desarrollado una red neuronal convolucional (CNN, de su nombre en inglés) que determina una serie de parámetros utilizados para el control de flujo de las turbinas eólicas. Los resultados se han publicado en Scientific Reports. Estos resultados muestran que la CNN es capaz de predecir con precisión las principales características del flujo alrededor del dispositivo, con errores muy tolerables, incluidos los coeficientes aerodinámicos, tanto los valores como su tendencia.

“En comparación con las simulaciones CFD, el uso de las CNNs reduce el tiempo computacional en cuatro órdenes de magnitud”, afirma el investigador Portal Porras. “Se han conseguido resultados rápidos, casi inmediatos, con un error de entre un 5 o un 6 %, en algunos casos. Un error bastante asumible para una industria que busca fundamentalmente resultados rápidos”, añade Fernández Gámiz.

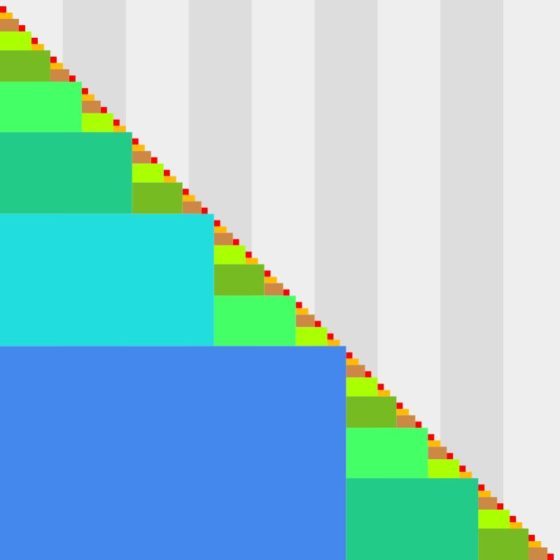

Comparativa de los resultados obtenidos por CFD y CNN. Fuente: UPV/EHU

Comparativa de los resultados obtenidos por CFD y CNN. Fuente: UPV/EHU“Primero hemos lanzado las simulaciones en CFD con dos dispositivos de control de flujo diferentes (microtabs rotativos y Gurney flaps), y de ahí obtenemos los datos de salida, que tomamos como reales y que utilizamos para entrenar la red neuronal convolucional —explica Portal Porras—. Lo que hacemos es meter como entrada la geometría y como salida los resultados obtenidos con CFD. De esta manera la red se entrena, y después si le metemos otra geometría, con los resultados que tenía anteriores, es capaz de predecir los nuevos campos de velocidad y de presión”.

En opinión de Fernández Gámiz, Portal Porras ha conseguido “una herramienta rápida, flexible y barata. Para aplicar este tipo de redes realmente no se necesita grandes ordenadores, ni clústeres informáticos, etc. Y, además, hemos conseguido una herramienta flexible, porque es aplicable a cualquier perfil aerodinámico, a todo tipo de sistemas de dispositivos e incluso a otro tipo de geometrías”.

Portal Porras afirma que la red sirve para todo tipo de aerogeneradores, “pero los datos de entrenamiento que hemos metido eran de un perfil aerodinámico concreto. Por tanto, si metes otro perfil aerodinámico habría que hacer todo el proceso de entrenamiento, o sea, meter los datos de entrada y salida del otro aerogenerador”.

Ambos investigadores coinciden en la importancia de la inteligencia artificial: “Es un paso fundamental si queremos que nuestro entorno industrial sea competitivo. Si no entramos en temas de inteligencia artificial, no vamos a avanzar en competitividad en los mercados internacionales”.

Referencia:

Koldo Portal Porras, Unai Fernández Gámiz, Ekaitz Zulueta, Alejandro Ballesteros Coll, Asier Zulueta (2022) CNN based flow control device modelling on aerodynamic airfoils Scientific Reports doi: 10.1038/s41598-022-12157-w

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Redes neuronales convolucionales para optimizar aerogeneradores se ha escrito en Cuaderno de Cultura Científica.

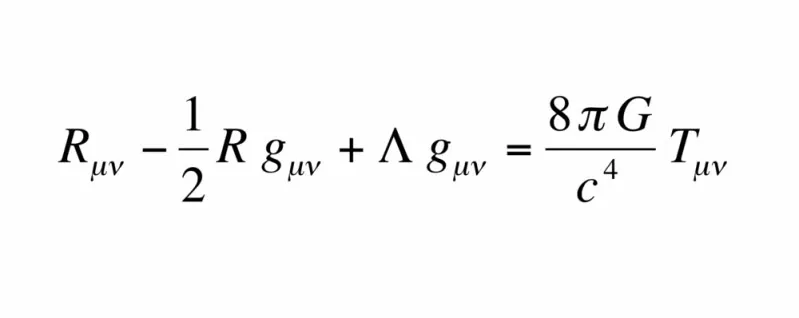

Simulación experimental de una teoría gauge distinta del electromagnetismo

En la física actual, nuestra comprensión del mundo se basa en las teorías de gauge: modelos matemáticos de la física teórica que describen las interacciones entre las partículas elementales (como los electrones o los quarks) y explican de forma cuántica tres de las fuerzas fundamentales de la naturaleza: electromagnética, débil y fuerte. La cuarta, la gravedad, se describe con la teoría de la relatividad general de Einstein, que es una teoría de gauge clásica ya que aún no disponemos de otra que unifique la mecánica cuántica con la gravedad.

Las teorías gauge pueden utilizarse asimismo para explicar el comportamiento exótico de los electrones en ciertos materiales cuánticos, o los códigos de corrección de errores que necesitarán los futuros ordenadores cuánticos para funcionar de forma fiable. Por ello, estas teorías son esenciales para entender la física moderna.

Para comprenderlas mejor, una posibilidad es utilizar sistemas cuánticos. Esta estrategia recibe el nombre de simulación cuántica y constituye un tipo especial de computación cuántica. Fue propuesta por primera vez por el físico estadounidense Richard Feynman en los años 80, más de quince años después de recibir el Premio Nobel de Física por su trabajo teórico sobre las teorías de gauge.

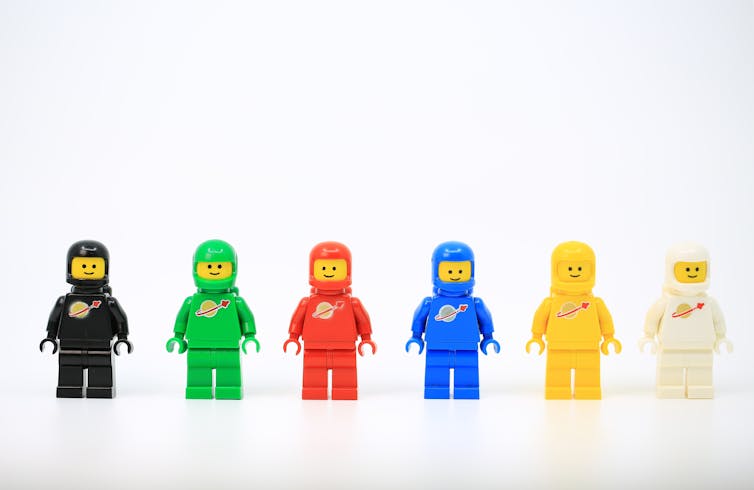

La simulación cuántica puede entenderse como un juego de LEGO cuántico en el que los físicos experimentales dan realidad a modelos teóricos abstractos. Los construyen en el laboratorio ‘pieza cuántica a pieza cuántica’, utilizando para ello sistemas cuánticos muy bien controlados, como átomos o iones ultrafríos.

Tras montar un prototipo de este “juego” cuántico para un modelo concreto, los investigadores pueden medir con gran precisión sus propiedades en el laboratorio y utilizar sus resultados para comprender mejor la teoría que imita. Durante la última década, este tipo de simulación se ha explotado intensamente para investigar materiales cuánticos.

Sin embargo, “jugar” al LEGO cuántico con las teorías gauge es fundamentalmente más difícil, y hasta ahora sólo se había logrado investigar de ese modo la fuerza electromagnética.

Pero ahora, investigadores experimentales del Instituto de Ciencias Fotónicas (ICFO) y la Universidad Autónoma de Barcelona (UAB) han podido simular por primera vez una teoría gauge distinta del electromagnetismo, utilizando para ello átomos ultrafríos. El equipo se propuso realizar en el laboratorio una teoría gauge que se enmarca dentro de la clase de teorías de gauge topológicas, diferente de la clase de teorías gauge dinámicas a las que pertenece el electromagnetismo. Los resultados se publican en Nature.

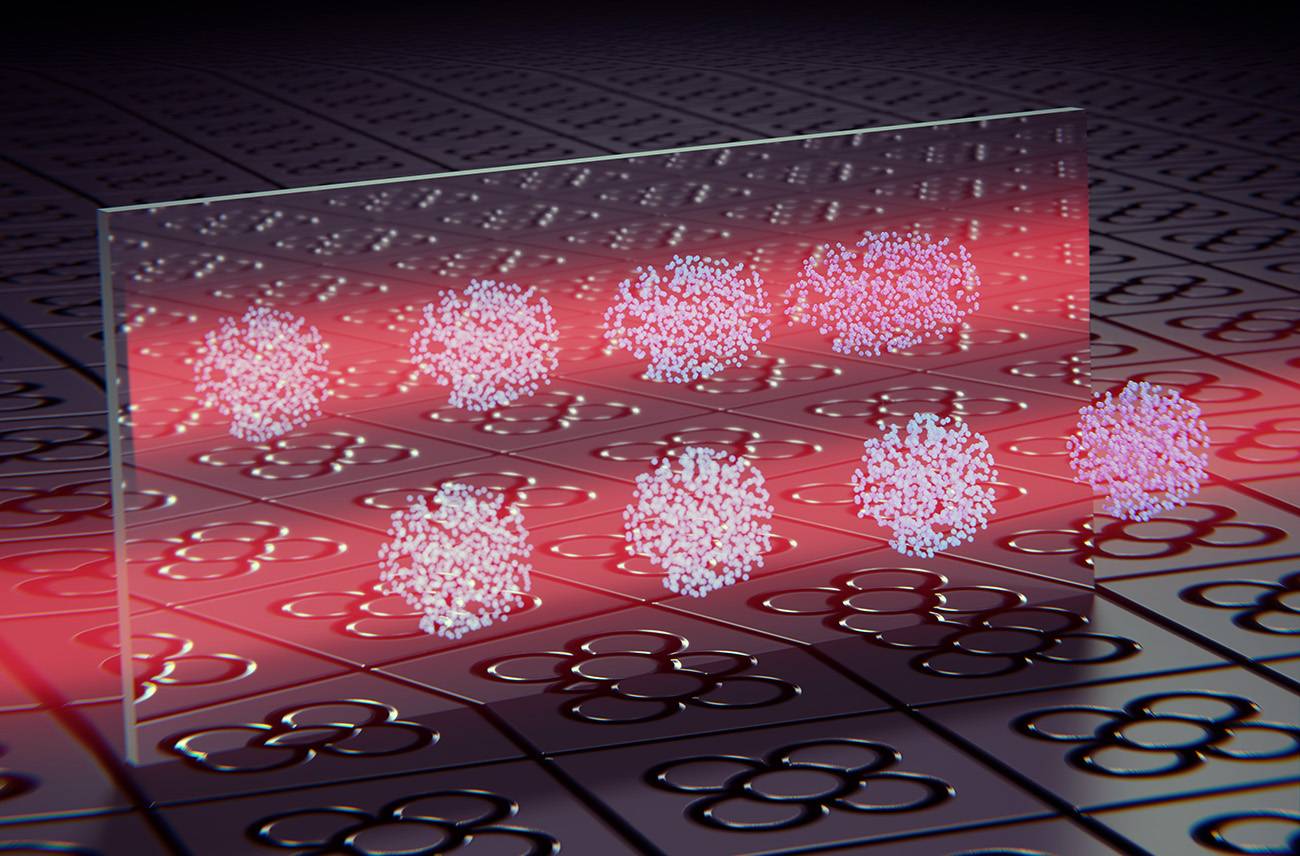

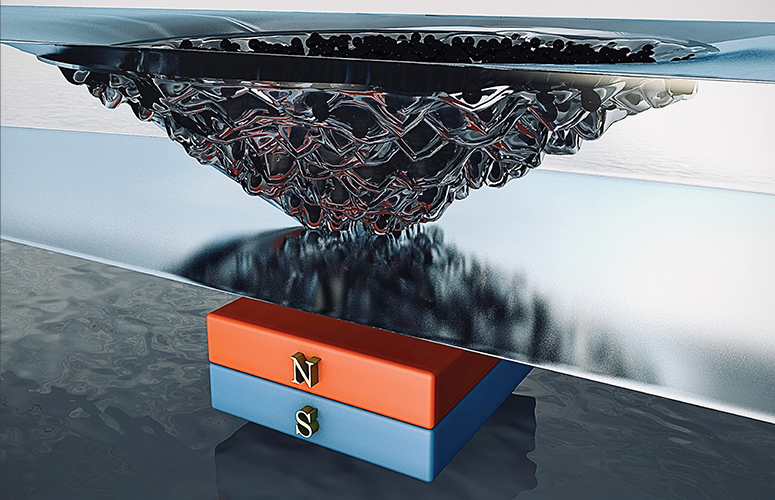

Representación artística de las interacciones quirales en una nube ultrafría de átomos “vestidos con luz”, la cual se comporta de forma diferente a su imagen en el espejo. Estas interacciones son la prueba irrefutable de la realización de una teoría topológica de gauge. / ICFO/Scixel

Representación artística de las interacciones quirales en una nube ultrafría de átomos “vestidos con luz”, la cual se comporta de forma diferente a su imagen en el espejo. Estas interacciones son la prueba irrefutable de la realización de una teoría topológica de gauge. / ICFO/ScixelEn el lenguaje de la teoría gauge, la fuerza electromagnética entre dos electrones surge cuando intercambian un fotón: una partícula de luz que puede propagarse también en ausencia de materia. Sin embargo, en los materiales cuánticos bidimensionales sometidos a campos magnéticos intensos, los fotones intercambiados por los electrones se comportan como si fueran extremadamente pesados y sólo pueden moverse mientras estén unidos a la materia.

Esto da a los electrones propiedades muy peculiares: sólo pueden fluir a través de los bordes del material, en una dirección que está fijada por la orientación del campo magnético, y su carga se vuelve aparentemente fraccionaria. Este comportamiento se conoce como efecto Hall cuántico fraccionario, y se describe mediante la teoría de gauge de Chern-Simons (el nombre de los matemáticos que desarrollaron uno de sus elementos clave).

El comportamiento de los electrones en el borde del material también se describe por una teoría gauge, que recibe el nombre de BF quiral, propuesta en los años 90, pero que nadie la había realizado en el laboratorio hasta que los investigadores del ICFO y la UAB la sacaron del congelador.

Mil millonésimas de grado por encima del cero absolutoPara dar realidad a esta teoría gauge topológica y simularla en su experimento, el equipo utilizó una nube de átomos enfriados a temperaturas de unas mil millonésimas de grado por encima del cero absoluto. Como especie atómica eligieron el potasio, porque uno de sus isótopos tiene dos estados que interactúan con distinta fuerza y pueden utilizarse como piezas cuánticas para construir un modelo gauge BF quiral.

A continuación, aplicaron luz láser para combinar los dos estados en uno nuevo. Esta técnica, denominada “vestir los átomos con luz”, hizo que los átomos adquirieran interacciones peculiares cuya fuerza y signo dependían de la velocidad de la nube.

Por último, crearon una guía de ondas óptica que restringía el movimiento de los átomos a una línea, y utilizaron láseres adicionales para golpear la nube de forma que se moviese a diferentes velocidades a lo largo de la guía de ondas.

En condiciones normales, al dejar evolucionar libremente los átomos en la guía de onda óptica, la nube de potasio se debería haber empezado a expandir inmediatamente. Sin embargo, la “luz de vestido” modificó completamente el comportamiento de los átomos, como los investigadores vieron al tomar imágenes de la nube en el laboratorio.

Como explica Ramón Ramos, investigador del ICFO, “en nuestro sistema, cuando los átomos se mueven hacia la derecha, sus interacciones son atractivas y anulan el comportamiento de los átomos que intentan expandirse. Así que lo que se ve en realidad es que la forma de la nube sigue siendo la misma. En términos técnicos, realizamos un solitón. Pero, si los átomos se mueven hacia la izquierda, estos átomos se expanden como un gas normal”.

El hecho de que los átomos se comporten de forma diferente al moverse en direcciones opuestas demuestra que el sistema es quiral, es decir, diferente de su imagen en el espejo. “Cuando observamos por primera vez el efecto de las interacciones quirales en nuestra nube atómica, no intentábamos simular una teoría gauge. Pero los datos eran tan bonitos e intrigantes que pensamos que necesitábamos entender mejor lo que estaba pasando. Cambiaron por completo los planes de investigación del equipo”, reconoce Leticia Tarruell, investigadora principal del estudio.

Traducir la teoría al lenguaje experimentalEl equipo entendió rápidamente que sus observaciones estaban relacionadas con un artículo teórico publicado diez años antes, que proponía utilizar un montaje casi idéntico para estudiar un tipo modificado de electromagnetismo. Sin embargo, los resultados del experimento eran diferentes de los esperados.

Como recuerda Craig Chisholm, al principio “los resultados que obteníamos no parecían coincidir en absoluto con los de la teoría. El reto era comprender en qué régimen había que estar para ver realmente el efecto correcto (el procedente del lugar adecuado) y eliminar los procedentes de lugares equivocados”.

Para el equipo experimental, el significado del electromagnetismo modificado que se mencionaba en el artículo tampoco estaba muy claro. Citaba artículos de física matemática de los años 90, que explicaban de forma mucho más detallada el modelo y lo conectaban con las teorías gauge utilizadas para describir el efecto Hall cuántico fraccionario.

Sin embargo, como dice Tarruell, “para físicos atómicos experimentales como nosotros, el contenido de esos artículos era muy difícil de entender, porque estaban escritos en un lenguaje de física matemática completamente diferente al nuestro. Era realmente frustrante saber que la respuesta a nuestras preguntas estaba ahí, ¡pero no éramos capaces de entenderla! Fue entonces cuando decidimos pedir ayuda a un físico teórico”.

Según Alessio Celi (UAB), que trabajó durante muchos años en física teórica de altas energías y gravedad antes de pasarse a la simulación cuántica, leer los artículos originales sobre teorías gauge fue relativamente fácil. Al mismo tiempo, pudo discutir con el equipo del ICFO y comprender el régimen en el que se podían realizar los experimentos y sus retos. Tras varios intentos fallidos, les propuso un modelo que explicaba adecuadamente los resultados observados en el laboratorio.

Como detalla, “el principal problema que teníamos era entrar en el marco adecuado. Una vez entendimos dónde buscar, el problema se volvió fácil de resolver”. Sorprendentemente, existía un régimen de parámetros en el que este modelo era exactamente la teoría de gauge topológica propuesta 30 años antes para describir los bordes de los materiales de Hall cuántico fraccionario.

“Creo que este proyecto nos muestra el interés de las colaboraciones interdisciplinarias. Combinar métodos experimentales de física de ultrabajas temperaturas e ideas teóricas de física de altas energías ha hecho de todos nosotros mejores físicos. Y hemos logrado la primera simulación cuántica de una teoría de gauge topológica”, concluye Tarruell.

Ahora, el equipo se prepara a explorar las nuevas líneas de investigación abiertas por este proyecto. Su objetivo es intentar extender los experimentos y la teoría de una línea a un plano, lo que les permitiría observar el efecto Hall cuántico fraccionario sin necesidad de un material cuántico. De esa forma, podrían crear de forma muy controlada cuasipartículas exóticas, llamadas anyones, que en el futuro podrían utilizarse para formas más robustas de computación cuántica.

Referencia:

Anika Frölian, Craig S. Chisholm, Elettra Neri, Cesar R. Cabrera, Ramón Ramos, Alessio Celi & Leticia Terruell (2022) Realizing a 1D topological gauge theory in an optically dressed BEC Nature doi: 10.1038/s41586-022-04943-3

Para saber más:

Einstein y el condensado de Bose-Einstein

De la simetría y su rotura (I)(II)(III)

Este texto apareció originalmente en SINC.

El artículo Simulación experimental de una teoría gauge distinta del electromagnetismo se ha escrito en Cuaderno de Cultura Científica.

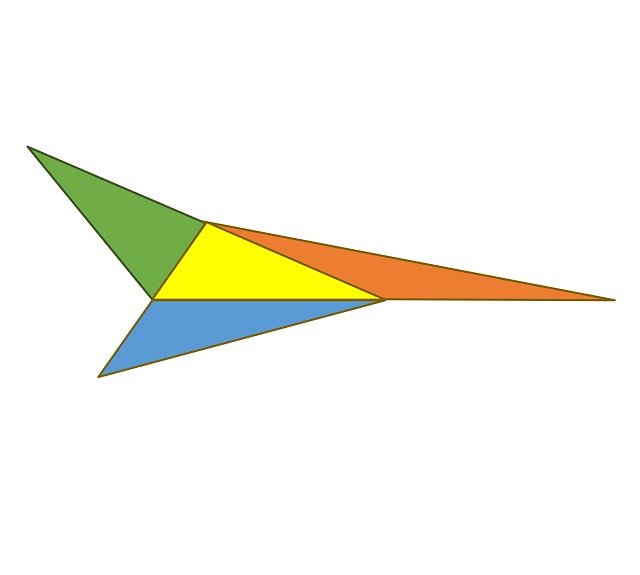

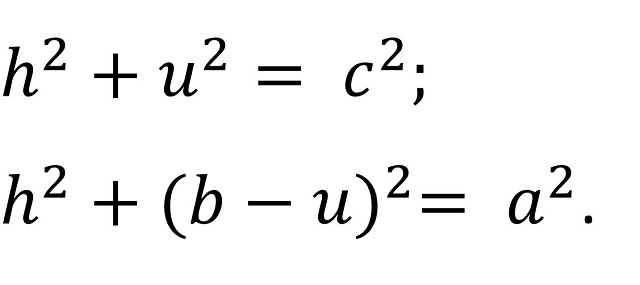

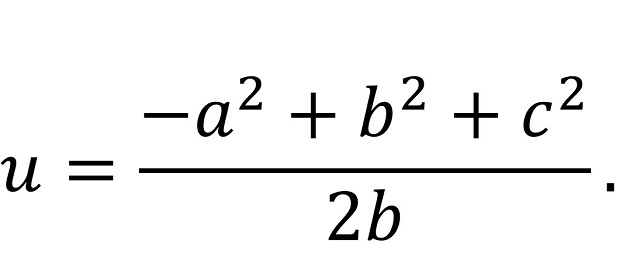

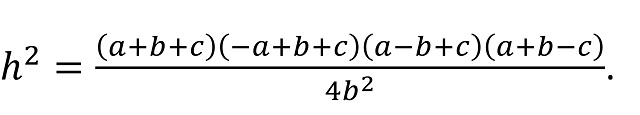

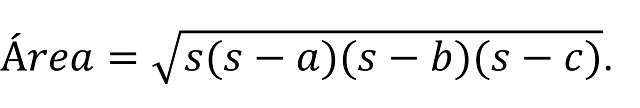

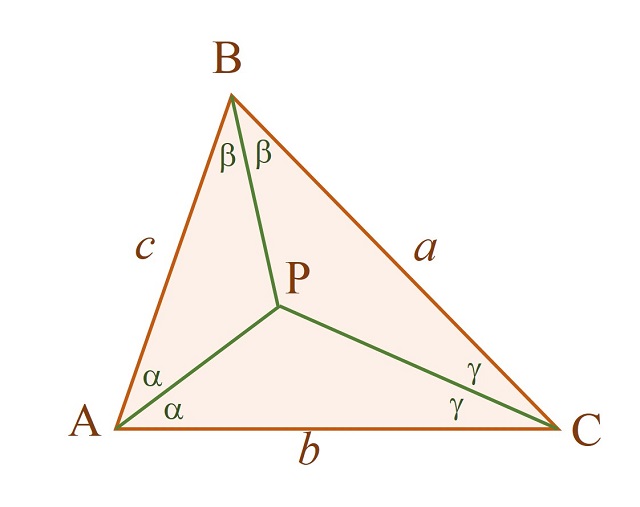

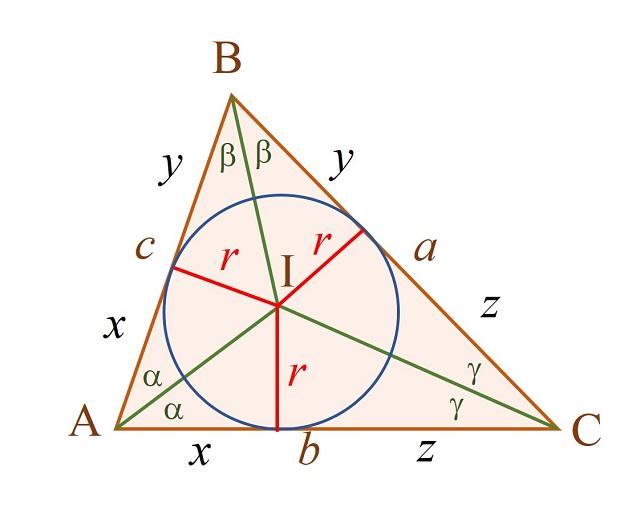

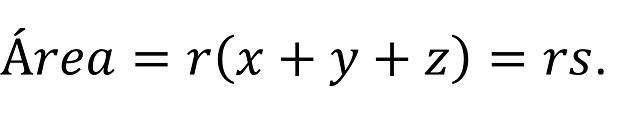

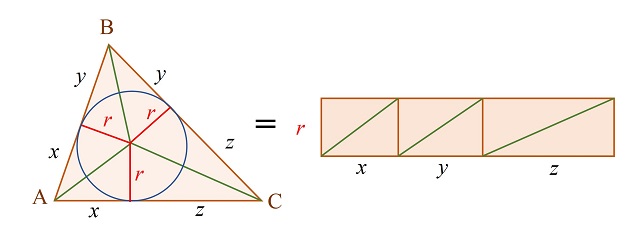

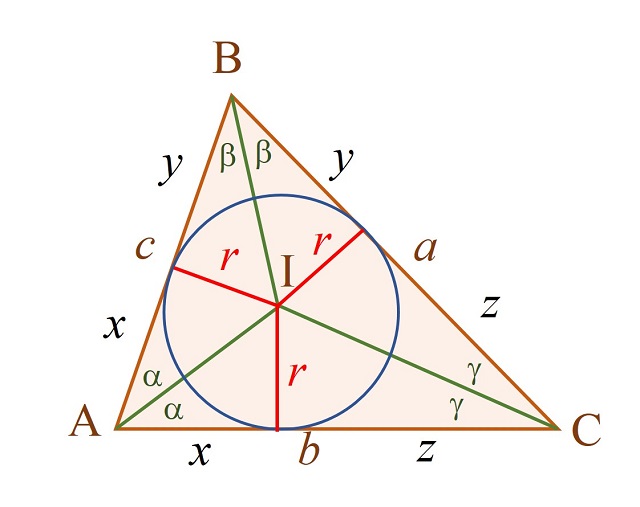

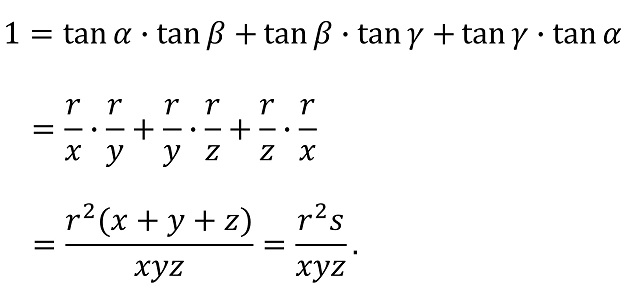

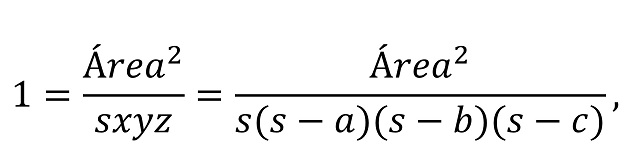

Teoremas geométricos sin palabras: Snover

Con esta entrada damos por terminada la serie estival de demostraciones sin palabras de interesantes y hermosos resultados geométricos, que hemos dedicado al clásico teorema de Viviani (en la entrada Teoremas geométricos sin palabras: Viviani ), al moderno, con sabor a clásico, teorema de la circunferencia de Conway (en la entrada Teoremas geométricos sin palabras: Conway) y a la fórmula de Herón para el área de un triángulo (Teoremas geométricos sin palabras: Herón), y la vamos a dedicar, como en el caso de las anteriores entradas, a un resultado geométrico sobre triángulos, pero en este caso se trata de un sencillo resultado que no tiene nombre (aunque podríamos denominarlo “teorema de Snover”, como explicaremos más adelante), pero que me parece curioso, interesante y con una demostración sin palabras simple y elegante.

Pero antes, vayamos a la resolución del problema sobre cuadrados inscritos y circunscritos a una circunferencia que dejamos planteado en la anterior entrada.

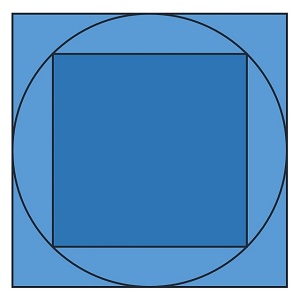

Cuadrados inscrito y circunscrito a una circunferenciaEl problema que planteamos en la anterior entrada para ser resuelto con un razonamiento visual era el siguiente.

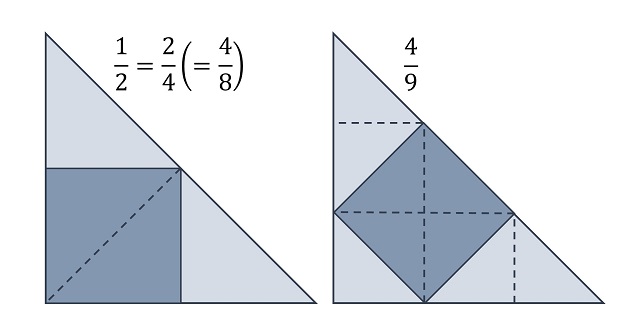

Problema (Cuadrados inscrito y circunscrito a una circunferencia): ¿Cuál es la proporción de las áreas de los cuadrados inscrito y circunscrito a una misma circunferencia?

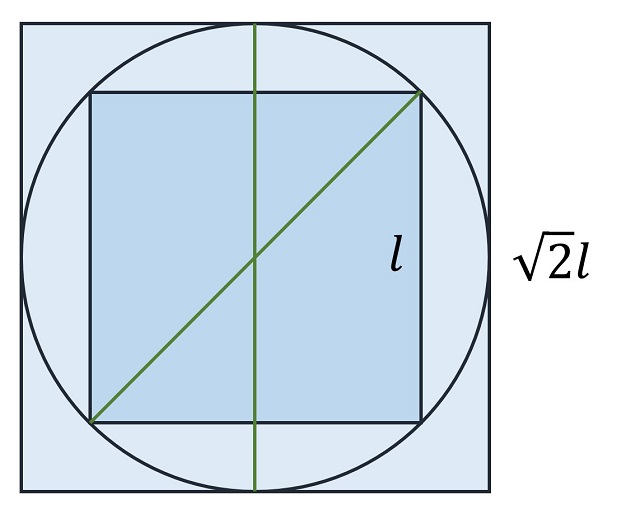

La solución es bastante simple, el cuadrado inscrito tiene la mitad de área que el cuadrado circunscrito, o al revés, el área del cuadrado circunscrito es el doble que la del inscrito. Como se muestra en la siguiente imagen, la diagonal del cuadrado inscrito a la circunferencia es igual al lado del cuadrado circunscrito, lo cual es suficiente para obtener la solución al problema.

Descubrí este resultado en el segundo de los libros de la serie de demostraciones sin palabras del matemático Roger B. Nelsen: Proofs Without Words II: More Exercises in Visual Thinking (MAA, 2001). Nelsen lo presentó bajo el título “Cuatro triángulos con la misma área” y mencionó al matemático Steven L. Snover como su autor (a través de una comunicación privada), motivo por el que hemos aprovechado para denominarle, en esta entrada, teorema de Snover.

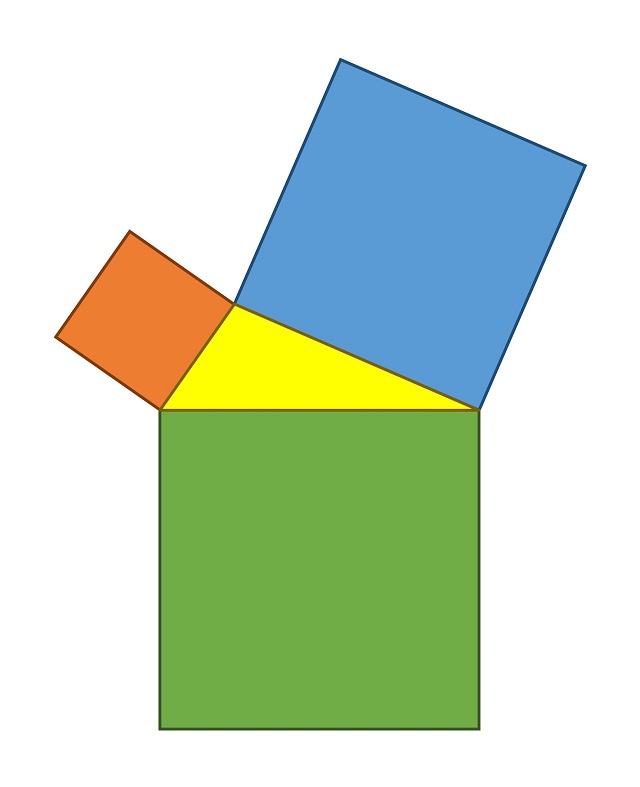

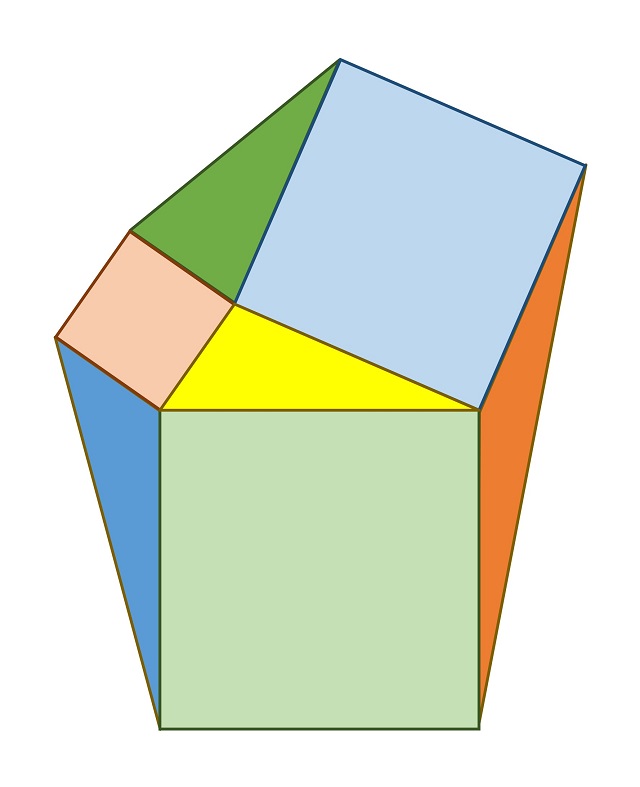

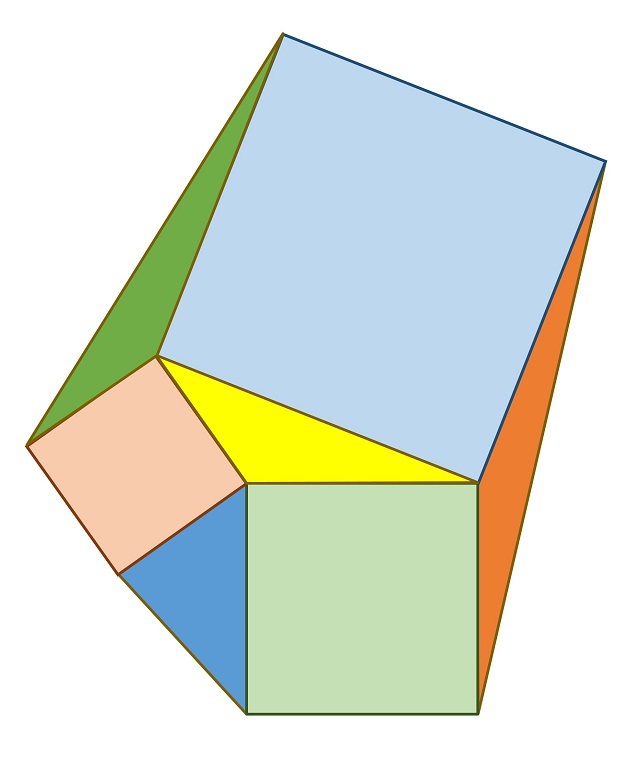

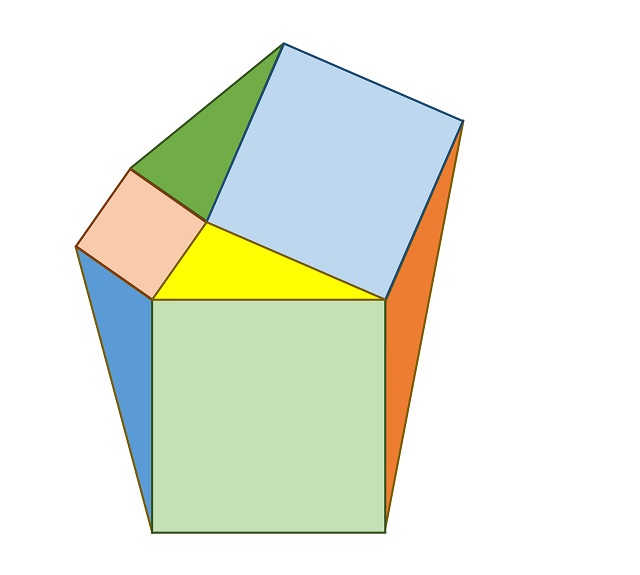

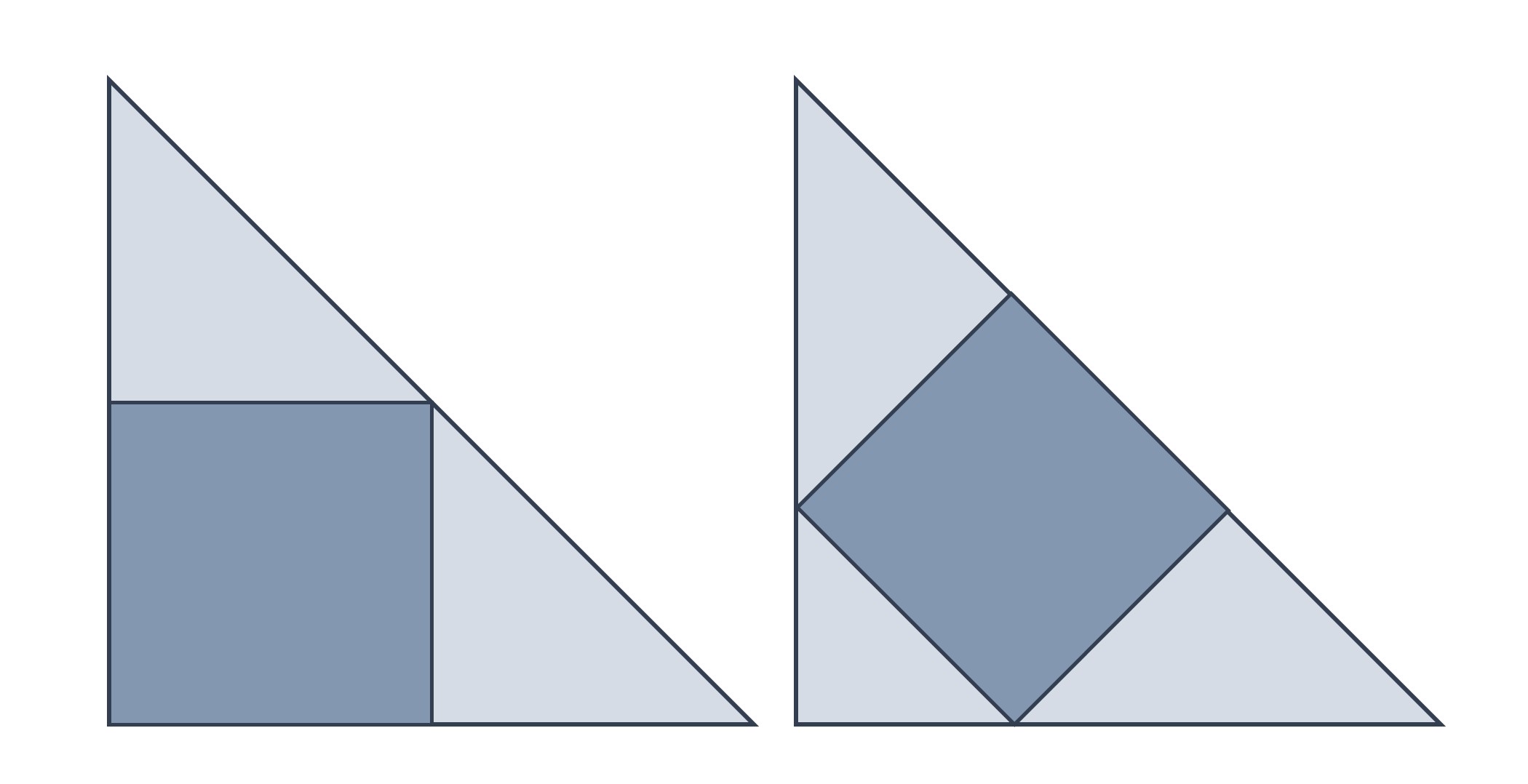

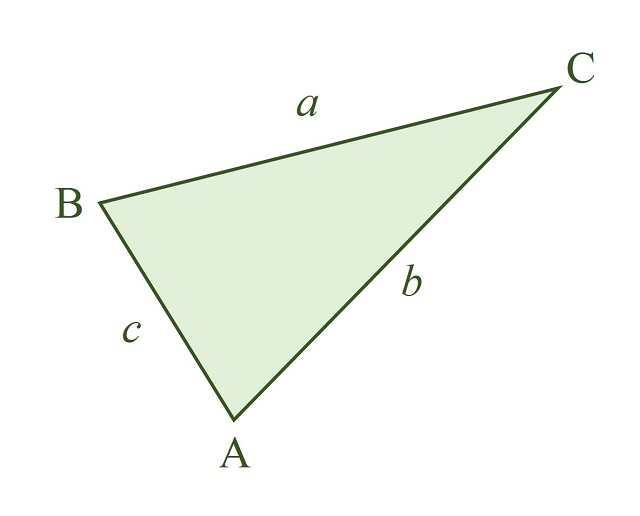

Veamos en qué consiste este resultado geométrico que bien podía haber estado incluido en la gran obra de la matemática griega, y universal, Los Elementos, del matemático griego Euclides de Alejandría (aprox. 325 – 265 a.n.e.). Se parte de un triángulo cualquiera y se trazan tres cuadrados, cada uno de ellos de lado igual a uno de los lados del triángulo y apoyado en el mismo, como se muestra en la siguiente imagen.

Esta primera construcción nos recuerda a la construcción del diagrama básico del teorema de Pitágoras (véanse las entradas Pitágoras sin palabras y Paseando entre árboles de Pitágoras), pero ahora partimos de un triángulo cualquiera, no necesariamente un triángulo rectángulo.

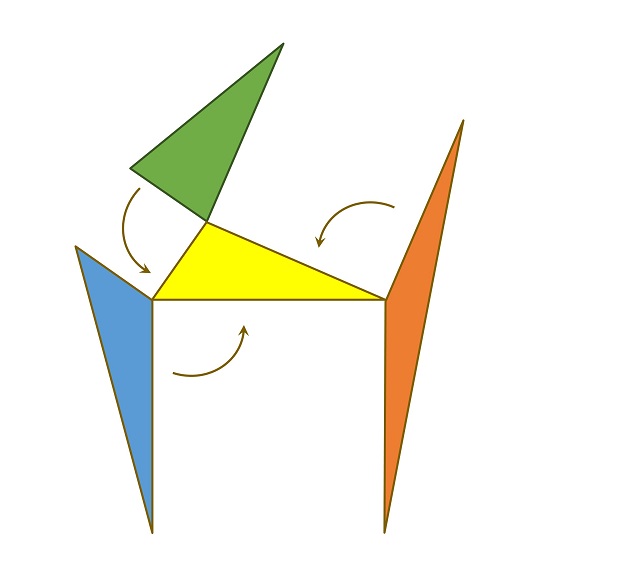

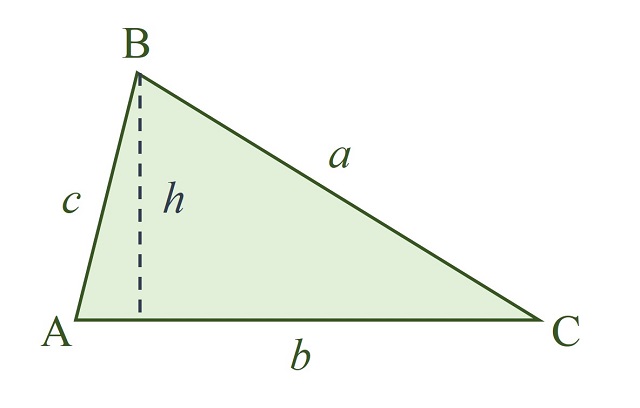

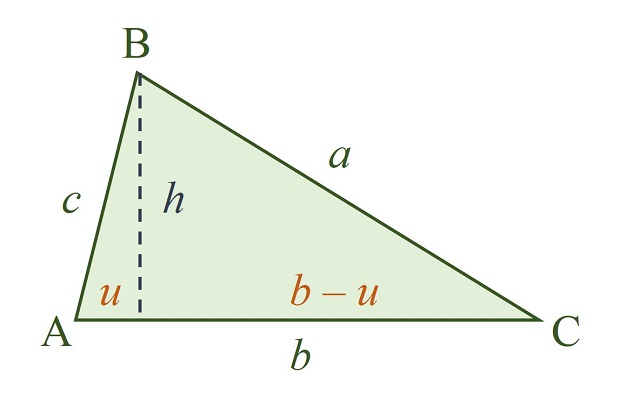

El siguiente paso consiste en trazar los tres triángulos formados por un vértice del triángulo y los vértices externos de los cuadrados construidos apoyados en dicho vértice, como se muestra en la imagen: triángulos azul, verde y marrón.

El resultado geométrico consiste en que esos tres nuevos triángulos que se han construido (azul, verde y marrón) tienen la misma área que el triángulo original (amarillo).

Teorema (de Snover): Dado un triángulo cualquiera, para cada lado del mismo se construye un cuadrado de lado igual al lado del triángulo y apoyado en el mismo. Entonces, los tres triángulos formados, cada uno de ellos, por un vértice del triángulo y los vértices externos de los cuadrados construidos apoyados en dicho vértice, tienen la misma área que el triángulo original.

El resultado es verdadero independientemente de la forma del triángulo, ya sea equilátero (todos los lados iguales), isósceles (dos lados iguales y uno diferente), escaleno (los tres lados diferentes), acutángulo (todos los ángulos agudos, es decir, entre 0 y 90 grados), rectángulo (con un ángulo de 90 grados) u obtusángulo (con un ángulo obtuso, es decir, mayor de 90 grados). Da igual como sea el triángulo original, los tres nuevos triángulos tendrán su misma área.

Demostración sin palabrasLa demostración es muy sencilla y se basa en que cada uno de esos tres triángulos tiene la misma base y la misma altura (alguna de las tres opciones que existen para base y altura del triángulo) que el triángulo original, luego como el área de un triángulo es igual a la base por la altura dividido por dos, se concluye el resultado.

Veamos el argumento visual para el primer triángulo dibujado en esta entrada.

Espero que hayáis disfrutado de esta miniserie de cuatro entradas dedicadas a demostraciones sin palabras de interesantes y hermosos resultados geométricos sobre triángulos. Seguro que en el futuro volveremos con más hermosas demostraciones sin palabras.

Bibliografía:

1.- Roger B. Nelsen, Proofs without Words: Exercises in Visual Thinking, Mathematical Association of America, 1997.

2.- Roger B. Nelsen, Proofs Without Words II: More Exercises in Visual Thinking, Mathematical Association of America, 2001.

3.- Claudi Alsina y Roger B. Nelsen, Charming Proofs, A Journey Into Elegant Mathematics, Mathematical Association of America, 2010.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Teoremas geométricos sin palabras: Snover se ha escrito en Cuaderno de Cultura Científica.

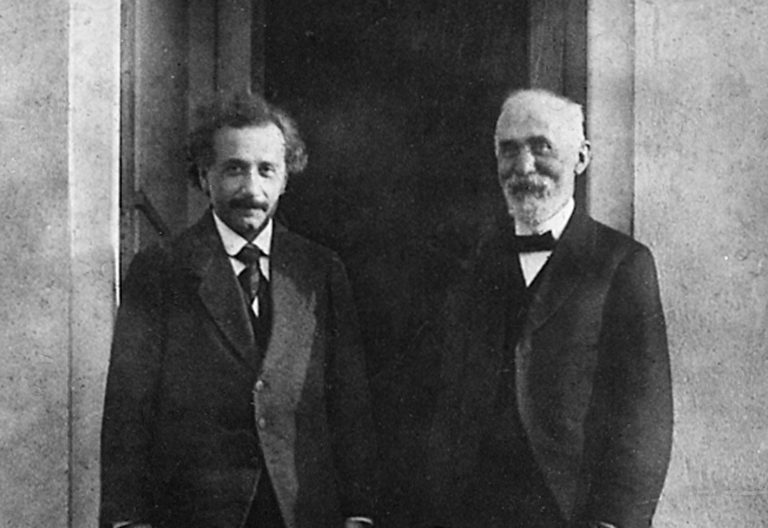

Einstein y Hendrik Lorentz

Semanas antes de su muerte Einstein dijo que el físico holandés Hendrik Lorentz era uno de los pocos científicos que verdaderamente admiraba, y que lo consideraba como un precursor de su propio trabajo. En efecto, muchos de sus contemporáneos vieron a Lorentz casi como el cocreador de la teoría especial de la relatividad, llegando a sugerir que Lorentz y Einstein deberían haber compartido un premio Nobel por su descubrimiento. Realmente, la obra de Einstein suponía una ruptura real con la de Lorentz pero, a pesar de ello, ambos investigadores estaban estrechamente interrelacionados y eran buenos amigos. Einstein veía a Lorentz casi como a una figura paterna.

Einstein y Hendrik Lorentz fotografiados en 1921 por Paul Ehrenfest en la puerta de su casa. Fuente: Wikimedia Commons

Einstein y Hendrik Lorentz fotografiados en 1921 por Paul Ehrenfest en la puerta de su casa. Fuente: Wikimedia CommonsLorentz se crió en Holanda, y durante sus estudios universitarios se sintió atraído por la teoría electromagnética de Maxwell. Su tesis doctoral versó sobre la reflexión y la refracción de la luz, y continuó estudiando la luz cuando se convirtió en catedrático de física matemática de la Universidad de Leiden en 1878. Su interés inicial estuvo en el éter, el medio indetectable que se suponía que empleaban las ondas de luz para viajar. Inicialmente Lorentz fue un firme creyente en la existencia del éter, llegando a rechazar por incorrectos los primeros resultados experimentales de Michelson, en los que no se encontraba la sustancia.

Pero para finales del siglo XIX, cuando el trabajo continuado de Michelson en colaboración con Morley seguía arrojando resultados negativos, Lorentz comenzó a preocuparse. Sus artículos científicos empezaron a mostrar intentos para modificar la teoría de la luz de manera que explicase los resultados del experimento de Michelson-Morley. La hipótesis que Lorentz creó proponía que a las altísimas velocidades a las que viajaba la luz, el espacio y el tiempo se contraían, compensando de esta manera el movimiento a través del éter, haciendo la longitud y el tiempo del viaje de la luz, y por tanto su velocidad, idénticos. Las ecuaciones que Lorentz creó para mostrar cómo cambiaban la longitud y el tiempo se conocen hoy día como las transformaciones de Lorentz.

Einstein admiraba el trabajo de Lorentz desde su época de estudiante y fue a través de él como Einstein se enteró de que había una crisis en la ciencia de la luz. Einstein siempre atribuyó su temprana fascinación por el electromagnetismo a la lectura de Lorentz; sin embargo, Einstein fue capaz de llevar el trabajo de Lorentz un paso más allá. En qué consistía este paso lo explicó admirablemente Lorentz en su Teoría de los electrones de 1915: “Mi principal fallo [para descubrir la teoría de la relatividad] fue aferrarme a la idea de que sólo la variable t puede ser considerada como el verdadero tiempo, y que mi tiempo local…debe ser considerado sólo como una cantidad matemática auxiliar”. En otras palabras, Lorentz incluía en sus ecuaciones dos conceptos de tiempo (uno para un observador externo y otro para el marco de referencia en el que la luz estaba viajando), pero asumía que esto era sólo un artificio matemático, no que el tiempo mismo era realmente diferente para ambos marcos de referencia. Einstein se atrevió a afirmar que las matemáticas no es que funcionasen “en principio”, sino que eran la representación precisa de lo que ocurría en realidad. El tiempo y el espacio eran de hecho diferentes para observadores diferentes. Esta idea es lo que permitió a Einstein dar el salto a la teoría especial de la relatividad, un salto que Lorentz no dio.

Lorentz, el puente entre dos paradigmasLa duda permanece sobre si Lorentz llegó a admitir completamente alguna vez la nueva teoría de Einstein. Si bien Lorentz era un innovador, un pensador adelantado a su tiempo (incluso antes de que se descubriese el electrón el ya había lanzado la hipótesis, ¡en los años 90 del siglo XIX!, de que la luz se formaba cuando oscilaba la carga eléctrica en un átomo; ganó el premio Nobel en 1902 por la formulación matemática del electrón) su pensamiento se movía en el marco de la física clásica. Se sentía cómodo en el mundo de la mecánica newtoniana, el electromagnetismo de Maxwell, y la forma en el que una causa llevaba limpiamente a un efecto de manera macroscópicamente observable. Max Born, décadas después de la muerte de Lorentz, escribió que él era de la opinión de que “Lorentz nunca se convirtió en un relativista, y sólo le regalaba la oreja a Einstein de vez en cuando para evitar discusiones”.

Lorentz también hizo públicas algunas reservas acerca de las teorías de Einstein acerca de los cuantos de luz: no estaba dispuesto a admitir que la luz estuviese constituida por partículas. Lorentz ciertamente estaba de acuerdo con que las nuevas teorías atómicas que decían que la energía no es continua, sino que viene en paquetes o cuantos como Planck había sugerido, parecían funcionar muy bien, pero no admitiría que esto pudiese aplicarse a la luz. Este “sí pero no” ilustra perfectamente la posición de Lorentz en la historia de la física, ya que se ubicó exactamente entre la física clásica y la nueva que se estaba creando. Vio la necesidad de cambio y comprendió que la nueva dinámica tenía mucho sentido, pero no podía aceptar que las extrañas ideas que acompañaban a la mecánica cuántica pudiesen ser correctas. Una posición similar a la que Einstein terminaría adoptando, pero éste aceptaría mucho más de la nueva física.

Equidistante como estaba entre la nueva y la vieja física, Lorentz fue el moderador perfecto para la primera Conferencia Solvay celebrada en 1911. Dedicada a la física atómica, la conferencia reunió a los más grandes físicos del momento para discutir los conflictos entre las teorías newtonianas y las nuevas. Lorentz mantuvo la paz admirablemente entre las distintas facciones, ya que podía ver el valor de ambos puntos de vista. En su discurso de apertura dijo: “En este estado de la cuestión se nos apareció como un maravilloso rayo de luz la bella hipótesis de los elementos [cuantos] de energía que fue expuesta primero por Planck y extendida después por Einstein…Nos ha abierto vistas maravillosas, incluso aquellos, que la consideran con cierta suspicacia, deben admitir su importancia y provecho”.

Independientemente de sus posiciones científicas, Einstein y Lorentz sentían el uno por el otro una admiración extrema. Einstein repetía a menudo que Lorentz era la persona más completa que había conocido en su vida y llegó a escribir a su amigo Johann Laub en 1909: “Le admiro [a Lorentz] como no admiro a nadie, diría que le quiero”.

Einstein respetaba tanto a Lorentz que estuvo a punto de sucederle en su puesto en Leiden cuando se retiró en 1911. Einstein, que ya había aceptado un puesto en Zúrich (un puesto que el prefería), parece que se hubiera ido a Leiden a poco que Lorentz hubiese insistido. Cuando rechazó la oferta escribió a Lorentz tras la Conferencia Solvay. “Le escribo esta carta con un corazón apesadumbrado, como alguien que ha cometido una injusticia con su padre…Si hubiese sabido que me quería [para el puesto] habría ido”.

En 1916, ese “padre” acudió para dar ánimos a un Einstein a punto de publicar su teoría general de la relatividad. Einstein había publicado primeras versiones de la teoría en 1915 y Lorentz era uno de los científicos que intentaban seguir su línea de razonamientos. Conforme la comprensión del propio Einstein aumentaba, y Lorentz comenzaba a ver exactamente lo que Einstein estaba intentando conseguir, alabó al joven investigador y le dijo que había llegado el momento de escribir la teoría completa de la forma más sencilla posible para el beneficio de toda la comunidad científica. Este parece haber sido uno de los factores importantes que llevaron a Einstein a publicar finalmente tanto el artículo en Annalen der Physik como un panfleto de cincuenta páginas que resumía y explicaba la teoría general de la relatividad.

Hendrik Lorentz murió en 1928 y Einstein, en representación de la Academia Prusiana de Ciencias, viajó a Holanda para el funeral. En su elogio dijo: “Estoy ante la tumba del hombre más noble y sabio de nuestros tiempos. Su genio lideró el camino desde el trabajo de Maxwell a los logros de la física contemporánea….Su trabajo y su ejemplo continuarán vivos como una inspiración”.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Una versión anterior de este artículo se publicó en Experientia Docet el 1 de noviembre de 2009.

El artículo Einstein y Hendrik Lorentz se ha escrito en Cuaderno de Cultura Científica.

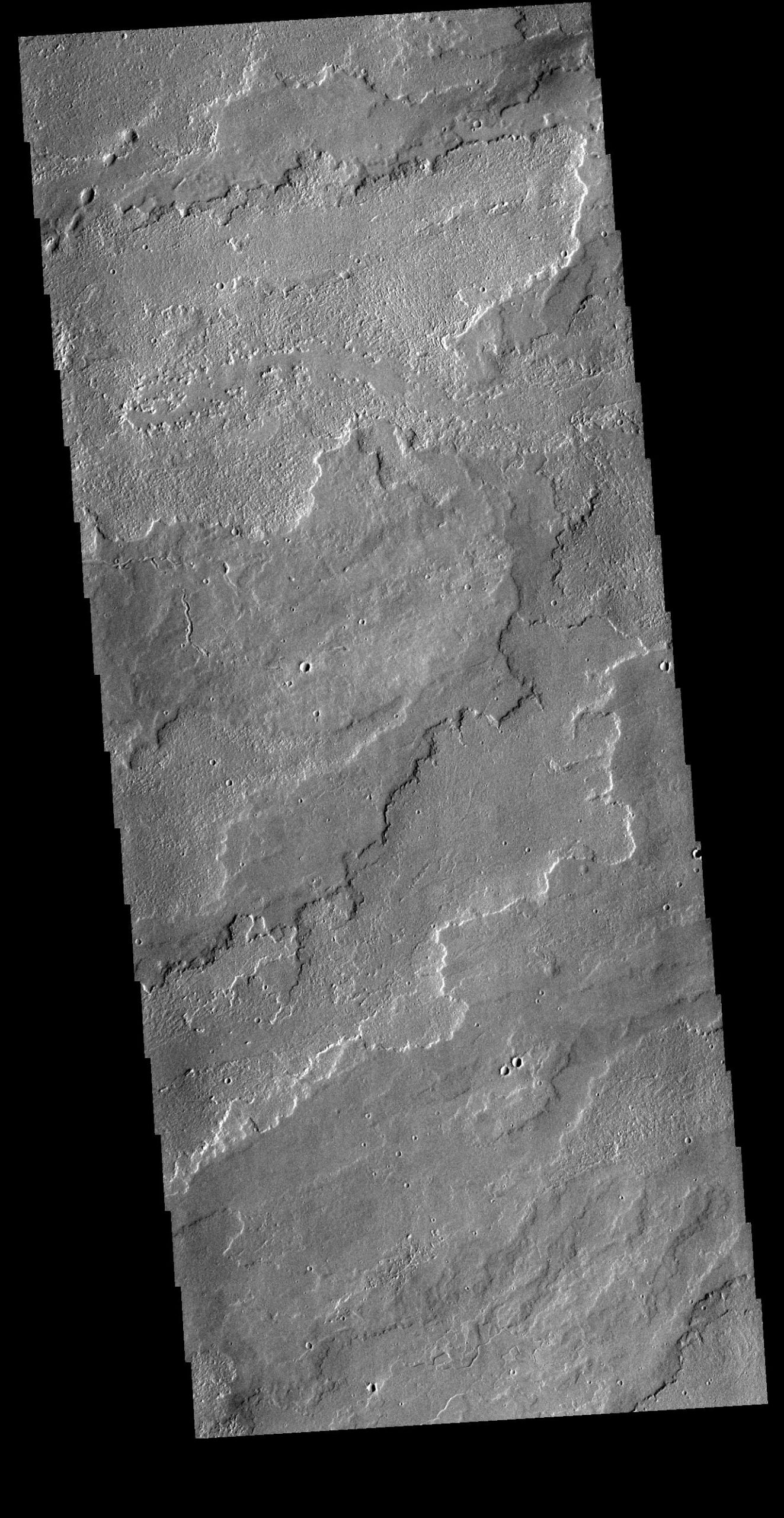

¿Qué nos dice el dióxido de silicio sobre las erupciones en Marte?

A día de hoy sabemos todavía muy poco sobre la historia de las erupciones volcánicas en Marte y sobre qué tipos de vulcanismo se dieron cuando Marte era todavía era un planeta mucho más activo -a nivel interno- que en la actualidad.

De hecho, podríamos decir que incluso tenemos una importante incertidumbre en cuanto al grado de actividad actual del planeta y si todavía sería posible la ocurrencia de erupciones volcánicas en determinados lugares de Marte. Este es el caso de Cerberus Fossae donde, según las dataciones de Horvath et al. (2021), podría haber habido algún tipo de erupción en los últimos ~50.000 años, lo que, junto a la actividad sísmica registrada por la misión InSight en la zona (Kedar et al. (2021)), hace de este lugar un sitio muy interesante para seguir estudiando la dinámica actual del planeta rojo.

Pero, ¿Cómo fueron las erupciones del pasado? ¿Fueron erupciones explosivas y violentas o por el contrario solo hubo erupciones muy efusivas y tranquilas? ¿O quizás coexistieron ambos modelos eruptivos? Anteriormente se pensaba que si no todas, la mayoría de las erupciones en Marte habían sido con una composición basáltica y tranquilas y que las rocas ígneas -aquellas formadas por el enfriamiento del magma- era un grupo de rocas poco diverso en el planeta rojo, por lo menos las volcánicas, a diferencia de la Tierra donde si hay un gran abanico composicional fruto de distintos procesos de evolución de los magmas.

Largas coladas de lava en Marte observadas por la Mars Odyssey. Obsérvese la longitud de estas, que no aparecen ni completas en la imagen debido a la distancia recorrida por la lava. Imagen cortesía de NASA/JPL-Caltech/ASU.

Largas coladas de lava en Marte observadas por la Mars Odyssey. Obsérvese la longitud de estas, que no aparecen ni completas en la imagen debido a la distancia recorrida por la lava. Imagen cortesía de NASA/JPL-Caltech/ASU.Pero, antes de poder resolver esta duda, tenemos que salvar ciertos obstáculos: la mayor parte de Marte la hemos observado desde su órbita y no desde su superficie, y la capa de polvo rojo ubicua que le da ese color tan característico al planeta, a veces hace palidecer las señales químicas de los distintos minerales. Si a esto le sumamos la erosión que lentamente va eliminando como si fuese una goma de borrar algunas partes de su relieve, se hace muy complicado el identificar los procesos volcánicos, especialmente los que pasaron hace mucho más tiempo.

De ahí la importancia de poder llegar a la superficie con misiones robóticas -de momento- tomar muestras, analizarlas in situ, y si es posible, devolverlas a la Tierra para que con mejores instrumentos analíticos podamos descifrar los detalles de la historia del planeta. Pero a pesar de todos los hándicaps que supone la exploración de otro planeta, a veces se hacen hallazgos en los lugares más insospechados.

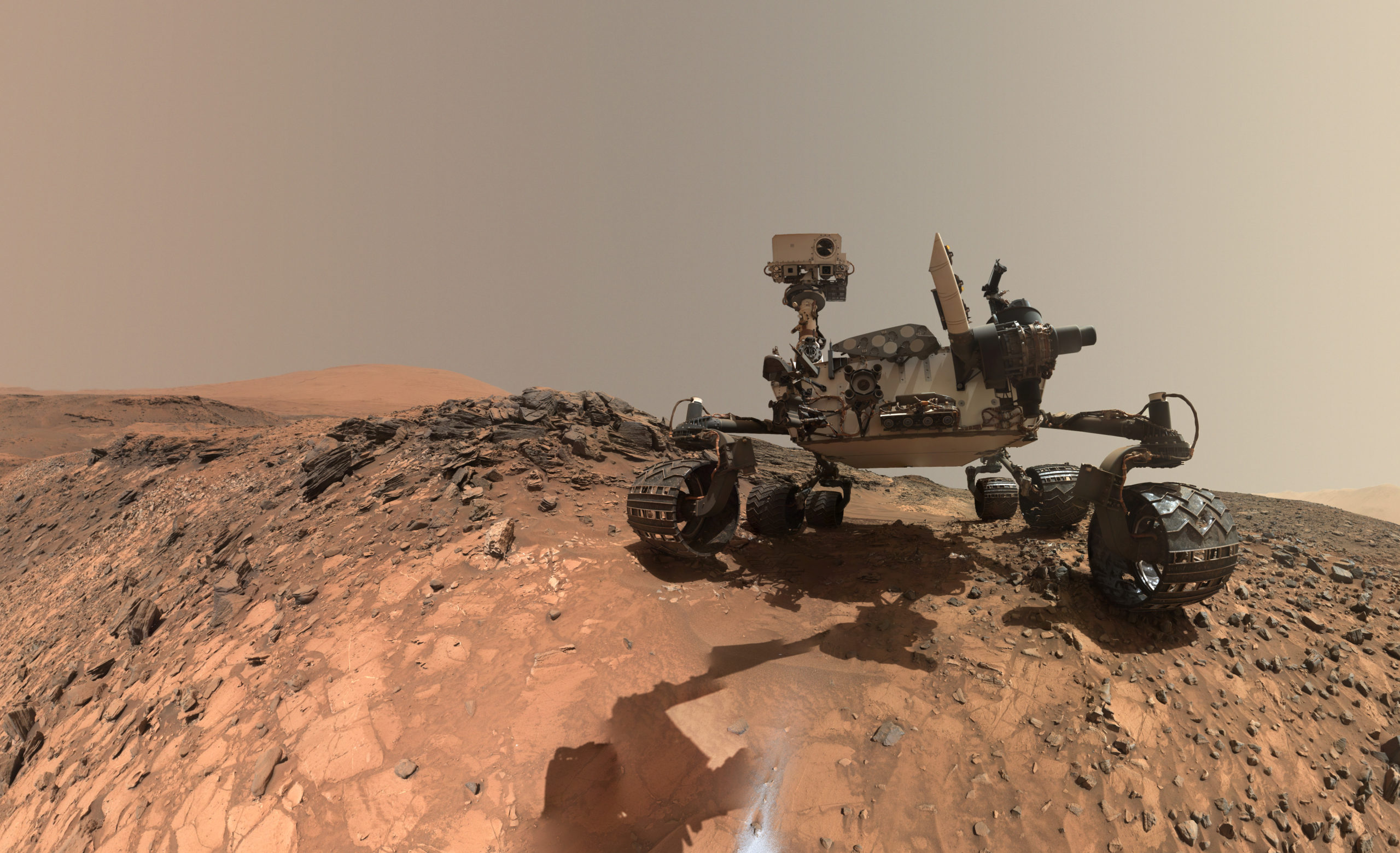

Aparece tridimita, un polimorfo del dióxido de silicioY esta historia nos obliga a remontarnos al año 2015, cuando el rover Curiosity, que se encuentra en el interior del cráter Gale de Marte, toma una muestra de una roca llamada Bucksin y detecta en ella tridimita, un polimorfo del dióxido de silicio, como el cuarzo. Los polimorfos son minerales que, con una misma composición química, tienen distintas estructuras cristalinas, algo que en ocasiones responde a las condiciones donde se ha formado el propio mineral.

El rover Curiosity se toma un selfie justo después de tomar la muestra de Bucksin, el 5 de agosto de 2015. Aunque no se ve el agujero, en la zona inferior central de la imagen se ve una mancha de color gris que destaca sobre el rojo: son los restos de la perforación de esta roca. Imagen cortesía de NASA/JPL-Caltech/MSSS.

El rover Curiosity se toma un selfie justo después de tomar la muestra de Bucksin, el 5 de agosto de 2015. Aunque no se ve el agujero, en la zona inferior central de la imagen se ve una mancha de color gris que destaca sobre el rojo: son los restos de la perforación de esta roca. Imagen cortesía de NASA/JPL-Caltech/MSSS.La tridimita se suele formar a altas temperaturas y bajas presiones, y en nuestro planeta suele estar asociada al vulcanismo explosivo, pero también podría formarse de otras maneras… como en el interior de lagos donde hay capas de agua muy ricas en sílice o incluso por fenómenos hidrotermales. Y sabemos que el interior del cráter Gale, al menos la parte inferior, representa una antigua cuenca lacustre donde con el paso del tiempo fueron acumulándose sedimentos, lo que hizo la interpretación de la tridimita fuese un verdadero reto.

Además, la tridimita podía también haber llegado fruto de la erosión de rocas de fuera del cráter y llevada hasta su interior por los ríos que desembocaban en este. El depósito de la tridimita en los sedimentos a partir de la erosión de otras rocas se pudo descartar, ya que este mineral aparecía y desaparecía bruscamente en los sedimentos analizados, y de haber sido traídos por los ríos, se esperaría una fuente más continua y con cierta gradualidad en su aparición y desaparición, no mostrando un cambio tan sumamente brusco.

También cristobalita, otro polimorfoAcompañando a la tridimita, los científicos encontraron también cristobalita, otro de los polimorfos del dióxido de silicio, que se forma a temperaturas superiores a la de la tridimita, lo que ponía a los científicos entre la espada y la pared… ¿se habrían formado estos minerales realmente a partir de la actividad volcánica?

Para poder resolver el puzle, se pusieron a analizar en que contextos geológicos de nuestro planeta y en que porcentajes aparecían estos minerales y por supuesto, junto a que otros minerales aparecían, para ver si finalmente encajaban las piezas.

Según el último estudio publicado por Payré et al. (2022), parece que la explicación más plausible requiere de erupciones volcánicas para explicar estos dos minerales: Hace unos 3.000 millones de años -aproximadamente- el magma que había en la cámara magmática, valga la redundancia, de un volcán marciano estaba cambiando su composición por un proceso que conocemos en geología como cristalización fraccional.

Este proceso hace que los magmas vayan evolucionando con el tiempo, ya que cambios en la presión y temperatura pueden hacer que unos minerales vayan formándose y segregándose del magma, provocando que la composición del magma restante vaya cambiando, porque al formarse estos minerales “retiran” los elementos que los forman.

Esto a su vez provoca que ciertos elementos puedan concentrarse en el magma, como el silicio, y que de ocurrir una erupción puede dar lugar a la formación de minerales como la tridimita y la cristobalita.

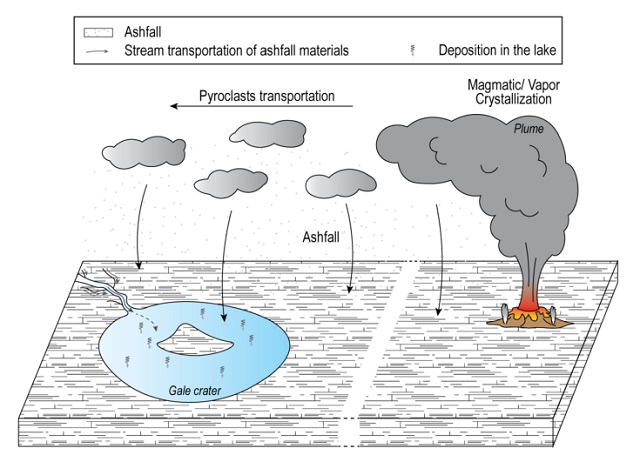

¿Y si hubo una erupción cómo llegaron estos minerales hasta el cráter? Los autores mencionan que una erupción de este tipo podría haber generado nubes de ceniza y piroclastos que se habrían desplazado grandes distancias, y que al caer se depositarían, acabando por formar parte del registro sedimentario… pero, ¿qué volcán podría haber sido el causante de esta erupción?

Modelo del mecanismo de transporte de la ceniza hasta el cráter Gale. Imagen cortesía de Payré et al. (2022)

Modelo del mecanismo de transporte de la ceniza hasta el cráter Gale. Imagen cortesía de Payré et al. (2022)Pues lo cierto es que es muy difícil encontrar cual habría sido el responsable, ya que no solo nos queda identificar todos los posibles volcanes marcianos -de algunos nos queda tan poco que a veces los confundimos con cráteres-, lo que junto con no poder establecer dataciones absolutas que nos permitan restringir el intervalo de edades de cada erupción, lo hace, por el momento, una labor muy difícil.

Pero sin duda, este estudio es muy interesante porque pone de manifiesto que fueron posibles otro tipo de erupciones en Marte y que fue un planeta con una mayor diversidad de procesos volcánicos de lo que cabría esperar, por lo que de nuevo se nos abre una nueva ventana para conocer mejor nuestro vecindario planetario.

Referencias:

1. Kedar S, Panning MP, Smrekar SE, et al. Analyzing Low Frequency Seismic Events at Cerberus Fossae as Long Period Volcanic Quakes. J Geophys Res Planets. 2021;126(4):1-28. doi:10.1029/2020JE006518

2. Morrisa R V., Vanimanb DT, Blakec DF, et al. Silicic volcanism on Mars evidenced by tridymite in high-SiO2 sedimentary rock at Gale crater. Proc Natl Acad Sci U S A. 2016;113(26):7071-7076. doi:10.1073/pnas.1607098113

3. Payré V, Siebach KL, Thorpe MT, Antoshechkina P, Rampe EB. Tridymite in a lacustrine mudstone in Gale Crater , Mars : Evidence for an explosive silicic eruption during the Hesperian. Earth Planet Sci Lett. 2022;594:117694. doi:10.1016/j.epsl.2022.117694

4. Horvath DG, Moitra P, Hamilton CW, Craddock RA, Andrews-Hanna JC. Evidence for geologically recent explosive volcanism in Elysium Planitia, Mars. Icarus. 2021;365:114499. doi:10.1016/j.icarus.2021.114499

Sobre el autor: Nahúm Méndez Chazarra es geólogo planetario y divulgador científico.

El artículo ¿Qué nos dice el dióxido de silicio sobre las erupciones en Marte? se ha escrito en Cuaderno de Cultura Científica.

Cuentos de otro tiempo, y de este

Ilustración de Warwick Goble para una edición de «La bella y la bestia» de 1913. Fuente: Wikimedia Commons

Ilustración de Warwick Goble para una edición de «La bella y la bestia» de 1913. Fuente: Wikimedia CommonsEs muy posible que algunos de los cuentos populares más conocidos hundan sus raíces en la prehistoria. Han llegado a esa conclusión utilizando métodos estadísticos y computacionales que, en biología, se suelen usar para reconstruir la historia evolutiva de las especies y su procedencia de otras, anteriores.

Los análisis biológicos se basan en la comparación de las secuencias genéticas de las especies –o linajes– cuya historia se desea trazar. La información genética se transmite de generación en generación pero, en ocasiones, la cadena de ADN sufre mutaciones al replicarse y surgen nuevos linajes, por ramificaciones sucesivas del original. Con la evolución y ramificación de las lenguas se hacen análisis similares, solo que, en vez de genes, lo que se transmite son palabras. Los cambios que sufren las palabras a lo largo del tiempo propician la aparición de nuevas lenguas por ramificación de aquellas de las que proceden. Las diferencias en el momento presente entre palabras que comparten origen se utilizan como criterio para reconstruir la evolución de las lenguas.

En la investigación que nos ocupa utilizaron como referencia el árbol filogenético (la “genealogía”) de las lenguas indoeuropeas y estudiaron la presencia en cincuenta de esas lenguas de los 275 “cuentos de magia” del catálogo internacional Aarne Thompson Uther, en el que se recogen más de 2000 cuentos procedentes de más de 200 sociedades. “Hansel y Gretel” y “La bella y la bestia”, por ejemplo, son dos de esos cuentos. De los 275 descartaron 199, porque era muy probable que hubiesen sido transmitidos horizontalmente, de una sociedad a otra próxima; tenían así suficiente garantía de que los 76 restantes se habían transmitido de forma vertical, de una generación a la siguiente, dentro de una misma sociedad. “Hansel y Gretel”, por ejemplo, no pasó la criba. Sí lo hizo “La bella y la bestia”.

Calcularon después la probabilidad de que cada uno de los cuentos estuviera presente en la época en que se produjeron las ramificaciones que dieron lugar a grandes subfamilias lingüísticas. Esa probabilidad depende de la presencia en las lenguas contemporáneas de las narraciones en cuestión, teniendo en cuenta también la posición de esas lenguas en el árbol filogenético. De los 76 cuentos, a catorce –“La bella y la bestia”, entre ellos– se les estimó una probabilidad igual o superior al 50% de haber existido en la lengua de la que proceden las célticas, romances, germánicas y eslavas, y pudo haber nacido hace unos 6800 años. De esos catorce, a cuatro cuentos se les calculó una probabilidad igual o superior al 50% de haber sido creados en el origen de las lenguas indoeuropeas –en la base del árbol–, hace algo más de 7000 años.

El cuento con la probabilidad más alta (87%) de haber existido en esa época tan remota es “El herrero y el diablo”, una historia cuyo eco resuena en “Fausto”. Que un cuento de hace 7000 años incluya la figura del herrero no debe extrañar. Las primeras evidencias de fundición tienen una antigüedad de unos 8000 años y proceden de Catalhöyük, Anatolia. Hay más restos de actividades de fundición de cobre durante el VI milenio a.e.c. en la misma Anatolia y en el actual Kurdistán, zonas ricas en ese mineral.

Que ciertos cuentos tengan un origen tan antiguo indica, por un lado, que dan cuenta de situaciones o circunstancias vitales que cumplen una función educativa importante en los grupos humanos que los transmiten. Por otra parte, que lo hacen de forma que explotan características de nuestra cognición que facilitan su transmisión fiel. Son historias ejemplarizantes; también son narraciones ejemplares.

Fuente: da Silva, S.G., and Tehrani, J.J. (2016). Comparative phylogenetic analyses uncover the ancient roots of Indo-European folktales. R. Soc. Open Sci. 3, 150645. doi: 10.1098/rsos.150645

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Cuentos de otro tiempo, y de este se ha escrito en Cuaderno de Cultura Científica.

CienciaClip 2021 – La ciencia detrás de la bomba atómica

Ciencia Clip es un concurso de vídeos divulgativos de ciencia diseñados, producidos y protagonizados por estudiantes de Educación Secundaria.

El objetivo del concurso es fomentar el interés por la ciencia y la tecnología. Y ofrecer a los concursantes una oportunidad para ejercitar su creatividad y habilidades comunicativas usando herramientas que proporciona internet.

Ciencia Clip es una iniciativa de la Cátedra de Cultura Científica de la UPV/EHU y en la que colaboran Euskampus Fundazioa, Naukas, Scenio y Big Van.

Los ganadores de la edición 2022 se anunciarán en la página web del concurso a principios de septiembre. La entrega premios y el anuncio del vídeo ganador del premio especial se realizarán durante el evento Naukas Bilbao. En la edición de 2021 resultó ganador en la categoría de 1º y 2º de la ESO Iván Sánchez, de Madrid, con este vídeo:

Edición realizada por César Tomé López

El artículo CienciaClip 2021 – La ciencia detrás de la bomba atómica se ha escrito en Cuaderno de Cultura Científica.

La simetría de figuras abstractas y la adquisición de la gramática en bebés

El grupo de investigación Gogo Elebiduna de la UPV/EHU está especializado en psicolingüística. Sus investigaciones se centran en cómo se adquiere, representa y organiza la facultad del lenguaje en el cerebro, y cuáles son las características universales de la representación y el procesamiento del lenguaje.

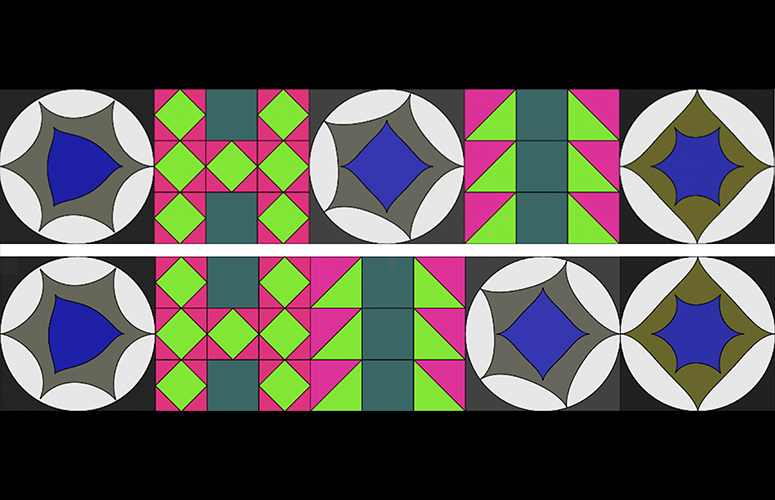

La investigadora Ikerbasque del grupo Irene de la Cruz-Pavía ha participado en un estudio en el que se ha investigado la capacidad de los bebés de 7 meses para percibir la simetría estructural en patrones visuales abstractos de tipo mosaico. Esta investigación se llevó a cabo en la Universidad de París. “Hemos examinado los patrones de mirada espontánea de casi 100 bebés ante secuencias de tipo mosaico con estructuras simétricas y asimétricas”, explica la investigadora.

Estos mosaicos estaban compuestos por baldosas cuadradas de dos categorías (A y B) que diferían en su paleta de color y su forma interna. Estas baldosas se ordenaban creando mosaicos con estructuras simétricas (p. ej. ABA, ABABA) o asimétricas (p. ej. AAB, AABBA). En el estudio se ha podido constatar que los bebés “discriminaron los mosaicos estructuralmente simétricos de los asimétricos, y que la longitud de la secuencia (3 o 5 baldosas) o el nivel de simetría no modulaban significativamente su comportamiento”. Estos resultados sugieren que los bebés detectan rápidamente la simetría estructural en patrones visuales complejos: “Los bebés de 7 meses tienen una capacidad robusta y automática de detectar que una estructura es simétrica. Esta habilidad coincide con las encontradas en estudios que hemos realizado con otros estímulos tales como la lengua de signos, o el habla, demostrando que los bebés son simplemente muy buenos en detectar estructuras y regularidades”, afirma la investigadora del Departamento de Lingüística y Estudios Vascos de la UPV/EHU.

La habilidad de los bebés para extraer estructura y reglas“La gramática de una lengua es el conjunto de estructuras y reglas de una lengua. Quiero entender hasta qué punto las habilidades de los bebés para extraer estructuras, y detectar regularidades y aprender reglas, son específicas del lenguaje o si en cambio se encuentran en otras áreas —señala la investigadora Ikerbasque—. Hemos hecho este estudio con información que es visual pero que no es lenguaje. Con estos mosaicos, hemos podido ver la habilidad que tienen los bebés para extraer estructura de distintos medios”.

Este estudio les permite entender mejor “cuáles son las habilidades fundamentales de esos bebés, que les van a permitir empezar primero con ciertas partes más accesibles de la gramática e ir poco a poco construyendo hasta tener una cosa tan compleja como es la gramática de una lengua. Lo que nosotros queremos entender es cuáles son las habilidades fundamentales que tienen los bebés para detectar estructura”.

“Tenemos muchas más preguntas que responder —concluye—. En este estudio hemos podido determinar que los bebés son capaces de detectar estructuras espontáneamente y rápidamente. Ahora queremos entender cuándo empieza esta habilidad, y entender hasta qué grado de detalle analizan esa estructura y qué aspectos de los mosaicos les permiten detectar su estructura (la forma, el color, ambos…)”.

Referencia:

Irene de la Cruz-Pavía, Gesche Westphal-Fitch, W. Tecumseh Fitch, Judit Gervain (2022) Seven-month-old infants detect symmetrical structures in multi-featured abstract visual patterns PLOS ONE DOI: 10.1371/journal.pone.0266938

Para saber más:

Cuando los bebés comienzan a combinar gesto y habla

Las habilidades matemáticas de los bebés

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo La simetría de figuras abstractas y la adquisición de la gramática en bebés se ha escrito en Cuaderno de Cultura Científica.

Reflejando el sol

Estos días de verano con intenso calor, cada vez que me subo a mi coche, completamente negro, después de tenerlo aparcado en la calle varias horas, me acuerdo de un efecto muy poco conocido, pero realmente importante para el cambio climático. Recuerdos que también me vinieron a principios de agosto, cuando me puse pantalones cortos por primera vez este año y me percaté de que el tono de piel de mis pernas le hacía honor a mi nombre, tanto que parecían incluso despedir un brillo propio. Me estoy refiriendo al efecto albedo.

De manera resumida, el albedo se refiere a la cantidad de radiación que es capaz de reflejar una superficie con respecto al total de energía que incide sobre ella. Es una propiedad que no tiene dimensiones y su valor se expresa dentro de un rango comprendido entre 0 y 1 o en su versión porcentual entre 0 y 100%, de tal manera que las superficies que reflejan poca energía (es decir, que absorben casi toda la radiación que incide sobre ellas) tendrán un albedo muy bajo, con valores cercanos a 0, mientras que las superficies que reflejan la mayoría de la radiación que les llega tendrán valores de albedo altos, próximos a 1 o al 100%.

Albedo, en latín, blancuraAlbedo es una palabra que procede de la raíz latina albus, que significa blanco. Esto ya nos da una pista de la característica física de las superficies que principalmente determina el valor del albedo de las mismas, el color. En concreto, las superficies de colores más claros tienen un valor de albedo más alto, ya que apenas absorben la radiación que incide sobre ellas, reflejando la mayoría de esa energía, mientras que las de colores más oscuros tienen un albedo muy bajo puesto que tienen una mayor capacidad de absorción de dicha radiación.

Valores promedio de albedo de diferentes superficies terrestres. Infografía: Johns Hopkins University

Valores promedio de albedo de diferentes superficies terrestres. Infografía: Johns Hopkins UniversityA escala planetaria, la Tierra recibe radiación directamente del Sol y, como cualquier superficie, es capaz de absorber parte de esa energía y reflejar, enviando de nuevo al espacio, la otra parte de la misma. De esta manera, el planeta tiene un valor promedio aproximado de albedo de 0.3, es decir, que refleja prácticamente el 30% de la radiación solar, absorbiendo el 70% restante.

Pero, como he dicho, esto es un promedio. Hay superficies en la Tierra de colores más oscuros, como ciertas rocas de tonalidades casi negras, frondosas masas boscosas verdes oscuras o grandes zonas oceánicas profundas de coloración azul grisácea que presentan bajos valores de albedo al absorber mayor radiación solar y, por tanto, se calientan más fácilmente. Pero otras partes de nuestro planeta tienen colores claros, incluso blancos, tales como las áreas heladas cercanas a los polos. Aquí, se refleja casi toda la radiación, por lo que el albedo es muy alto, provocando que la temperatura sea también más baja en estas zonas. Esta diferenciación en el albedo de nuestro planeta es uno de los principales mecanismos que controla la circulación atmosférica y el intercambio de calor entre las áreas ecuatoriales y las polares. Es decir, que el albedo influye directamente en el clima que tenemos en la Tierra.

Pero las actividades humanas también pueden influir en esta propiedad física de las superficies y, por tanto, provocar variaciones o alteraciones del clima a una escala temporal que nos afecta de manera directa. Una de las acciones más directas ha sido alterar el color de la nieve, que se verá reflejado en el color que tendrá el hielo acumulado en zonas de altas latitudes. Parece complicado hacer eso, pero nada más lejos de la realidad.

Desgraciadamente, ahora estamos viendo como cae ceniza de color oscuro en muchas partes de la Península Ibérica debido a los incendios forestales que azotan nuestros montes. Pues lo mismo provocamos con la quema incontrolada de carbón que tuvo lugar hace unos siglos y que todavía se mantiene en ciertas partes de nuestro planeta. Esa ceniza presente en la atmósfera es capaz de teñir la nieve de colores más oscuros que, al depositarse como capas de hielo en latitudes altas, tendrá un valor de albedo inferior al de la nieve más pura, aumentando su absorción de radiación solar y su temperatura, generando a su vez un incremento en su velocidad de fusión. Y cuando este hielo se funde, se generan masas de agua entre las capas heladas, agua que también tiene un menor albedo que el hielo blanquecino y que, nuevamente, contribuye a un aumento de su fusión. Es decir, vamos rompiendo la termorregulación atmosférica y provocamos un incremento en la velocidad de desaparición de las masas heladas polares.

Valores de albedo a lo largo de nuestro planeta en el año 2005. Imagen: Earth Observatory / NASA

Valores de albedo a lo largo de nuestro planeta en el año 2005. Imagen: Earth Observatory / NASAComo os he comentado, el efecto albedo es uno de los factores que determinan el clima en la Tierra, pero ni mucho menos es el único. El cambio climático es un concepto muy complejo donde interfieren un montón de variables que, encima, están interrelacionadas entre sí. El problema ante el que nos enfrentamos actualmente es que, cualquier alteración provocada por la actividad humana en alguno de ellos provoca una respuesta climática que, en muchas ocasiones, no podemos prevenir, ya que no tenemos referentes o análogos en el registro geológico. Aunque a veces intentamos comparar nuestras acciones con los efectos producidos por grandes volcanes explosivos, pero tampoco podemos asegurar que la respuesta climática sea similar.

Además, ahora seguro que entendéis por qué cuando os encontráis con profesionales de la Geología en el campo generalmente llevamos gafas de sol, aunque esté nublado. No es para parecer más guay, es que las rocas de colores claros tienen un albedo alto y no queremos que el reflejo nos deslumbre mientras estamos trabajando.

Para saber más:

Ártico y Antártico se calientan a la vez

Certezas e incertidumbres sobre el cambio climático

Sobre la autora: Blanca María Martínez es doctora en geología, investigadora de la Sociedad de Ciencias Aranzadi y colaboradora externa del departamento de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU

El artículo Reflejando el sol se ha escrito en Cuaderno de Cultura Científica.

La sucesión de Fibonacci, el teorema de Zeckendorf y un poemario magistral

En la anotación La magia del teorema de Zeckendorf hablábamos de un truco de magia realizado con diez cartas y que se basaba en una propiedad matemática relacionada con la teoría aditiva de númerosi. Esa propiedad se conoce como el teorema de Zeckendorf, y afirma que:

Todo entero positivo se escribe, de manera única, como suma de números de Fibonacci no consecutivos. A esa escritura única se le llama la descomposición de Zeckendorf del número en cuestión.

Teorema de Zeckendorf representado para los 89 primeros números naturales. Los colores corresponden a los números de Fibonacci 55, 34, 21, 13, 8, 5, 3, 2 y 1. Las bandas verticales de fondo tienen una anchura de 10. Fuente: Wikimedia Commons.

Teorema de Zeckendorf representado para los 89 primeros números naturales. Los colores corresponden a los números de Fibonacci 55, 34, 21, 13, 8, 5, 3, 2 y 1. Las bandas verticales de fondo tienen una anchura de 10. Fuente: Wikimedia Commons.

Este teorema lleva el nombre del matemático amateur Édouard Zeckendorf (1901-1983) e involucra a los números definidos por la sucesión de Fibonacci, serie que comienza con el 0 y el 1, y cada término se obtiene al sumar los dos anteriores: 0, 1, 1, 2, 3, 5, 8, 13, 21, 34, 55, 89, 144, …

Para que quede más claro, vamos a calcular la descomposición de Zeckendorf del número 100. Para ello tomamos el mayor número de Fibonacci que es menor o igual que 100, que es el 89. Se hace la diferencia 100 – 89 = 11 y se procede del mismo modo. El mayor número de Fibonacci que es menor o igual que 11 es 8; se hace la diferencia 11 – 8 = 3, que ya es un número de Fibonacci, con lo que la descomposición de Zeckendorf de 100 es: 100 = 89 + 8 + 3.

Es cierto que hay otras descomposiciones de 100 como sumas de números de Fibonacciii, pero solo la anterior consta de números de Fibonacci no consecutivos. La demostración de este teorema, tanto la existencia como la unicidad de la descomposición, puede hacerse por recurrencia.

Poesía “a la Zeckendorf”En 1979, el matemático y miembro del grupo OuLiPo (Ouvroir de Littérature Potentielle) Paul Braffort (1923-2018) rindió homenaje al teorema de Zeckendorf a través del poemario Mes hypertropes. Vingt-et-un moins un poèmes à programme (Mis hipertropos. Veintiún menos un poemas con programa).

Portada de Mes hypertropes. Fuente: paulbraffort.net

Portada de Mes hypertropes. Fuente: paulbraffort.net

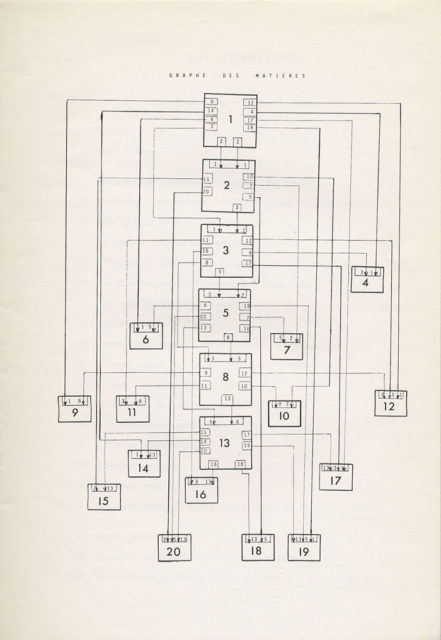

Se trata de una serie de veinte poemas cuya estructura interna se rige por este teorema matemático: el poema n tiene en cuenta los poemas correspondientes a la descomposición de Zeckendorf de ese número n. Por ejemplo, como el número 12 se escribe como 8 + 3 + 1 según el teorema de Zeckendorf, esto indica que el poema número 12 comparte algunos contenidos de los poemas 1, 3 y 8 de Mes hypertropes. Esta restricción oulipiana obliga a Braffort a construir marcos que permitan estas conexiones entre algunos de los poemas de la serie.

Los números 1, 2, 3, 5, 8 y 13 son su propia descomposición de Zeckendorf, así que Braffort relaciona estos poemas con los dos números de Fibonacci que lo generan. Por ejemplo, como 8 = 3 + 5, el poema 8 comparte contenido con el 3 y el 5. Eso significa que solo el primer poema L’explication préalable ou la raison des rimes (La explicación previa o el motivo de las rimas) no se ve influenciado por ninguno de la serie.

Tras el índice, el autor explica brevemente cómo se estructura el textoiii:

Los poemas que van a leer se han diseñado respetando el “principio de Roubaudiv” que se enuncia de este modo:

-

Solo se utilizará una estructura matemática como restricción clave de una obra literaria si se incluyen uno o varios teoremas relacionados con esta estructura.

Nuestra “estructura” es aquí la de la sucesión de Fibonacci, sucesión de números naturales donde todo elemento es la suma de los dos que le preceden: 1, 2, 3, 5, 8, 13, etc.

El teorema es el de Zeckendorf que permite representar todo entero natural como la suma de un cierto número de elementos de la sucesión de Fibonacci. Así, 9 = 8 + 1, 20 = 13 + 5 + 2, etc. Esto permite asociar a la sucesión de los veinte primeros enteros un grafo de dependencias que se reproduce a continuación.

La transferencia de la estructura matemática a la restricción literaria es de orden semántico: el contenido del poema en la posición n depende del contenido de los poemas cuyo puesto forma la representación “de Zeckendorf” de n.

Así, el poema número 20 depende del contenido de los poemas en la posición 13, 5 y 2. Observemos que una tal restricción, puramente semántica, lleva también a definir restricciones prosódicas.

Por supuesto, hemos añadido al sistema anterior algunas restricciones suplementarias que el lector descifrará sin esfuerzo.

Grafo de Mes hypertropes. Fuente: paulbraffort.net

Grafo de Mes hypertropes. Fuente: paulbraffort.net

Si entendéis francés, os recomiendo la lectura de este texto. Como la mayoría de los textos escritos bajo restricción oulipiana, se descubren los detalles tras varias lecturas, mirando en cada una de ellas diferentes aspectos del contenido o de la estructura. Además, Braffort incorpora en su poemario conceptos y personajes matemáticos. Es una auténtica delicia, un juego, un reto, un rompecabezas extraordinario que enlaza las matemáticas y la literatura.

Referencias

-

Maths and poetry, Futility Closet, 11 de enero de 2015.

-

Édouard Zeckendorf (1972). Représentation des nombres naturels par une somme de nombres de Fibonacci ou de nombres de Lucas. Bull. Soc. R. Sci. Liège 41: 179-182.

-

Paul Braffort (1979).Mes hypertropes. La Bibliothèque oulipienne vol. I, no. 9, Seghers

Notas:

iLa parte de la teoría de números que estudia conjuntos de enteros y su comportamiento bajo la suma.

iiPor ejemplo, 100 = 55 + 34 + 8 + 2 + 1 o 100 = 89 + 8 + 2 + 1.

iiiTraducido por la autora.

iv Se refiere a Jacques Roubaud (1932), matemático y miembro del grupo OuLiPo.

–

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad

El artículo La sucesión de Fibonacci, el teorema de Zeckendorf y un poemario magistral se ha escrito en Cuaderno de Cultura Científica.

Einstein y la belleza matemática

Einstein sometía a sus propias teorías, y a las de los demás, a un sencillo test de verosimilitud: ¿había belleza en su formulación matemática?